Périphériques technologiques

Périphériques technologiques

IA

IA

La cybersécurité sera révolutionnée par les opérations d'apprentissage automatique

La cybersécurité sera révolutionnée par les opérations d'apprentissage automatique

La cybersécurité sera révolutionnée par les opérations d'apprentissage automatique

Machine Learning Operations (MLOps) fait référence aux pratiques et outils utilisés pour simplifier le déploiement, la gestion et la surveillance des modèles d'apprentissage automatique dans les environnements de production.

Bien que MLOps soit généralement associé aux workflows de science des données et d'apprentissage automatique, son intégration à la cybersécurité apporte de nouvelles capacités pour détecter et répondre aux menaces en temps réel. Il s’agit de simplifier le déploiement et la gestion des modèles d’apprentissage automatique, permettant aux organisations d’obtenir des informations à partir de grandes quantités de données et d’améliorer leur posture de sécurité globale.

Définition du MLOps

MLOps est un domaine relativement nouveau qui combine l'apprentissage automatique et l'ingénierie logicielle. Il se concentre sur le développement et le déploiement de services d’apprentissage automatique de manière plus efficace et automatisée. Cela permet aux organisations d’accélérer l’utilisation du machine learning dans leurs programmes de sécurité, d’améliorer les temps de détection et de réponse et, à terme, de réduire les risques.

Collaboration

MLOps nécessite une collaboration entre les data scientists, les développeurs et les équipes opérationnelles. Ensemble, ils gèrent l'intégralité du cycle de vie du machine learning, de la préparation des données au déploiement du modèle.

Automation

L'automatisation est au cœur de MLOps. En automatisant la formation, le déploiement et la gestion des modèles, les organisations peuvent déployer des modèles plus rapidement et réduire les erreurs

Évolutivité

MLOps aide les organisations à faire évoluer l'application de l'apprentissage automatique au sein de plusieurs équipes et projets, facilitant ainsi la gestion et la maintenance des modèles d'apprentissage automatique

L'utilisation de MLOps dans le domaine de la cybersécurité présente de nombreux avantages

MLOps permet aux organisations de détecter les menaces et d'y répondre plus rapidement et avec plus de précision que jamais, ce qui pourrait potentiellement changer la donne en matière de cybersécurité. Les modèles d’apprentissage automatique peuvent aider les organisations à détecter les cybermenaces et à y répondre plus rapidement et avec plus de précision que les méthodes traditionnelles. De plus, les outils MLOps peuvent aider les organisations à gérer et à maintenir des modèles d'apprentissage automatique à grande échelle, améliorant ainsi leur posture de sécurité globale.

L'utilisation des MLOps en cybersécurité présente plusieurs avantages :

- Des temps de détection et de réponse plus rapides : les MLOps permettent aux organisations de détecter et de répondre aux menaces plus rapidement et avec plus de précision que les méthodes traditionnelles.

- Amélioration de la précision : les modèles d'apprentissage automatique peuvent analyser de grandes quantités de données et identifier des modèles difficiles, voire impossibles à détecter pour les humains.

- Améliorer l'efficacité : en automatisant les processus d'apprentissage automatique, MLOps aide les organisations à accélérer la mise sur le marché de nouveaux modèles et à réduire les coûts associés aux processus manuels.

Voici quelques exemples concrets :

- Une société de technologie financière sud-africaine utilise MLOps pour détecter et se défendre contre la fraude bancaire en ligne

- Un fournisseur de solutions de sécurité cloud utilise MLOps pour identifier et contenir les menaces de sécurité basées sur le cloud

- United Les agences gouvernementales des États utilisent MLOps pour la détection des menaces de sécurité dans les aéroports.

Défis lors de l'intégration du MLOps dans la cybersécurité

Bien que le MLOps offre de nombreux avantages, il reste encore de nombreux défis à relever lors de son intégration dans les pratiques de cybersécurité d'une organisation :

- Manque d'expertise : formation et embauche de data scientists et de machines L'apprentissage des ingénieurs peut s'avérer difficile, en particulier pour les organisations aux budgets limités.

- Qualité des données : les modèles d'apprentissage automatique s'appuient sur de grandes quantités de données pour détecter avec précision les menaces. Garantir la qualité de ces données peut s’avérer difficile, en particulier lorsqu’il s’agit de sources de données non structurées.

- Transparence des modèles : la complexité des modèles d'apprentissage automatique peut rendre l'interprétation et la transparence des modèles difficiles, ce qui rend difficile l'identification des faux positifs et négatifs et la responsabilisation du modèle.

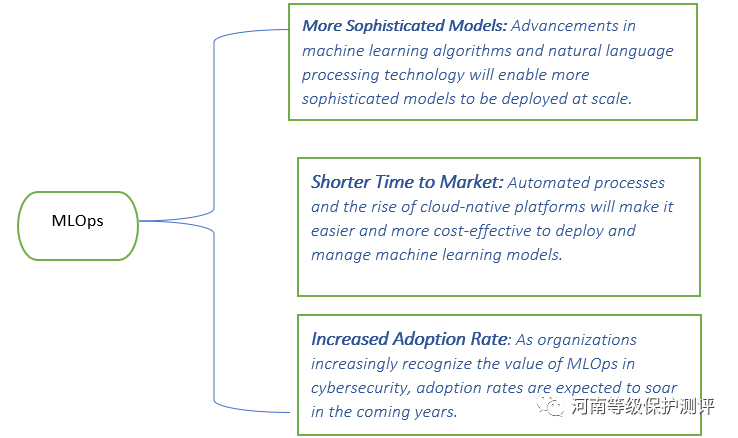

MLOps et l'avenir de la cybersécurité

Le rôle des MLOps dans la cybersécurité continuera de croître dans les années à venir. À mesure que la technologie d’apprentissage automatique progresse et que les organisations sont de plus en plus axées sur les données, les MLOps devraient devenir un élément important de la boîte à outils de cybersécurité de chaque organisation.

Dans le monde réel de la cybersécurité, les MLOps devraient évoluer à mesure que de nouveaux concepts et méthodologies sont développés pour améliorer la détection des menaces, la réponse aux incidents et les opérations de sécurité globales. Voici quelques futurs concepts MLOps spécifiques à la cybersécurité

Systèmes de sécurité adaptatifs et auto-apprenants

Les concepts MLOps du futur se concentreront sur le développement de systèmes de sécurité adaptatifs et auto-apprenants pour faire face à l'évolution des menaces. Ces systèmes exploiteront la technologie d'apprentissage continu pour mettre à jour leurs modèles en temps réel en fonction des nouvelles informations sur les menaces et des nouveaux modèles d'attaque afin de se défendre de manière proactive et de répondre rapidement aux cybermenaces émergentes. la communauté de sécurité des vulnérabilités ou des méthodes d’attaque inconnues. Les futurs concepts MLOps exploreront des algorithmes et des techniques avancés d’apprentissage automatique pour détecter et atténuer les menaces du jour zéro. En analysant le trafic réseau, le comportement du système et la détection des anomalies, les modèles d'apprentissage automatique peuvent identifier des modèles inconnus et des activités suspectes associées aux attaques zero-day

Détection des anomalies basée sur le comportement

MLOps continuera d'améliorer et de faire progresser la technologie de détection des anomalies basée sur le comportement. Les modèles d'apprentissage automatique seront formés pour comprendre les modèles normaux de comportement des utilisateurs et du système et identifier les écarts pouvant indiquer une activité malveillante. Ces modèles seront intégrés aux systèmes de sécurité pour fournir des alertes et des réponses en temps réel aux comportements anormaux.

Chasse aux menaces et défense basée sur le renseignement

MLOps exploitera une technologie avancée de chasse aux menaces pour rechercher de manière proactive les menaces et les vulnérabilités potentielles au sein du réseau et des systèmes d'une organisation. Les modèles d'apprentissage automatique analyseront de grandes quantités de données, notamment les fichiers journaux, le trafic réseau et les flux de renseignements sur les menaces, pour identifier les menaces cachées, les activités suspectes et les vecteurs d'attaque potentiels.

Analyse des renseignements sur les menaces en temps réel

MLOps se concentrera sur l'amélioration des capacités d'analyse des renseignements sur les menaces en tirant parti des modèles d'apprentissage automatique. Ces modèles traiteront et analyseront les données de renseignement sur les menaces en temps réel provenant de diverses sources, notamment les renseignements open source, la surveillance du dark web et les sources de sécurité. En intégrant ces modèles dans les systèmes de sécurité, les organisations peuvent identifier et répondre plus efficacement aux menaces émergentes.

Mécanismes de défense adaptatifs et résilients

Les futurs concepts de MLOps se concentreront sur le développement de mécanismes de défense adaptatifs et résilients capables d'ajuster dynamiquement les contrôles de sécurité sur la base de renseignements sur les menaces en temps réel. Les modèles d'apprentissage automatique surveilleront et analyseront en permanence les événements de sécurité, les vulnérabilités du système et les modèles d'attaque pour optimiser les configurations de sécurité, déployer des politiques et répondre aux menaces en temps réel.

Analyse améliorée du comportement des utilisateurs et des entités (UEBA)

Les systèmes UEBA utilisent des modèles d'apprentissage automatique pour détecter et répondre aux comportements anormaux des utilisateurs et des entités qui peuvent indiquer une menace interne ou une compromission de compte. Les futurs concepts MLOps se concentreront sur l'amélioration de la précision et de l'efficacité des systèmes UEBA grâce à des algorithmes avancés d'apprentissage automatique, une ingénierie de fonctionnalités améliorée et une intégration avec d'autres systèmes de sécurité pour permettre une détection et une réponse complètes aux menaces.

Ceux-ci dans MLOps Le concept Future of Cybersecurity vise à renforcer défenses contre les cybermenaces complexes et en constante évolution, permettant aux organisations de détecter, répondre et atténuer les incidents de sécurité de manière plus proactive et efficace.

Le rôle important de l'apprentissage automatique

MLOps est un cadre puissant qui peut améliorer considérablement les défenses de cybersécurité. En tirant parti de la puissance des modèles d’apprentissage automatique, les organisations peuvent améliorer la détection des menaces, la surveillance en temps réel, l’analyse des logiciels malveillants et l’analyse du comportement des utilisateurs. Les MLOps permettent aux équipes de sécurité de répondre rapidement aux menaces émergentes, de réduire la probabilité de violations de données et de minimiser l'impact des cyberattaques.

À mesure que le paysage de la cybersécurité continue d'évoluer, l'intégration des MLOps jouera un rôle essentiel dans la protection de notre écosystème numérique.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Cet article vous amènera à comprendre SHAP : explication du modèle pour l'apprentissage automatique

Jun 01, 2024 am 10:58 AM

Cet article vous amènera à comprendre SHAP : explication du modèle pour l'apprentissage automatique

Jun 01, 2024 am 10:58 AM

Dans les domaines de l’apprentissage automatique et de la science des données, l’interprétabilité des modèles a toujours été au centre des préoccupations des chercheurs et des praticiens. Avec l'application généralisée de modèles complexes tels que l'apprentissage profond et les méthodes d'ensemble, la compréhension du processus décisionnel du modèle est devenue particulièrement importante. Explainable AI|XAI contribue à renforcer la confiance dans les modèles d'apprentissage automatique en augmentant la transparence du modèle. L'amélioration de la transparence des modèles peut être obtenue grâce à des méthodes telles que l'utilisation généralisée de plusieurs modèles complexes, ainsi que les processus décisionnels utilisés pour expliquer les modèles. Ces méthodes incluent l'analyse de l'importance des caractéristiques, l'estimation de l'intervalle de prédiction du modèle, les algorithmes d'interprétabilité locale, etc. L'analyse de l'importance des fonctionnalités peut expliquer le processus de prise de décision du modèle en évaluant le degré d'influence du modèle sur les fonctionnalités d'entrée. Estimation de l’intervalle de prédiction du modèle

Identifier le surapprentissage et le sous-apprentissage grâce à des courbes d'apprentissage

Apr 29, 2024 pm 06:50 PM

Identifier le surapprentissage et le sous-apprentissage grâce à des courbes d'apprentissage

Apr 29, 2024 pm 06:50 PM

Cet article présentera comment identifier efficacement le surajustement et le sous-apprentissage dans les modèles d'apprentissage automatique grâce à des courbes d'apprentissage. Sous-ajustement et surajustement 1. Surajustement Si un modèle est surentraîné sur les données de sorte qu'il en tire du bruit, alors on dit que le modèle est en surajustement. Un modèle surajusté apprend chaque exemple si parfaitement qu'il classera mal un exemple inédit/inédit. Pour un modèle surajusté, nous obtiendrons un score d'ensemble d'entraînement parfait/presque parfait et un score d'ensemble/test de validation épouvantable. Légèrement modifié : "Cause du surajustement : utilisez un modèle complexe pour résoudre un problème simple et extraire le bruit des données. Parce qu'un petit ensemble de données en tant qu'ensemble d'entraînement peut ne pas représenter la représentation correcte de toutes les données."

L'évolution de l'intelligence artificielle dans l'exploration spatiale et l'ingénierie des établissements humains

Apr 29, 2024 pm 03:25 PM

L'évolution de l'intelligence artificielle dans l'exploration spatiale et l'ingénierie des établissements humains

Apr 29, 2024 pm 03:25 PM

Dans les années 1950, l’intelligence artificielle (IA) est née. C’est à ce moment-là que les chercheurs ont découvert que les machines pouvaient effectuer des tâches similaires à celles des humains, comme penser. Plus tard, dans les années 1960, le Département américain de la Défense a financé l’intelligence artificielle et créé des laboratoires pour poursuivre son développement. Les chercheurs trouvent des applications à l’intelligence artificielle dans de nombreux domaines, comme l’exploration spatiale et la survie dans des environnements extrêmes. L'exploration spatiale est l'étude de l'univers, qui couvre l'ensemble de l'univers au-delà de la terre. L’espace est classé comme environnement extrême car ses conditions sont différentes de celles de la Terre. Pour survivre dans l’espace, de nombreux facteurs doivent être pris en compte et des précautions doivent être prises. Les scientifiques et les chercheurs pensent qu'explorer l'espace et comprendre l'état actuel de tout peut aider à comprendre le fonctionnement de l'univers et à se préparer à d'éventuelles crises environnementales.

Implémentation d'algorithmes d'apprentissage automatique en C++ : défis et solutions courants

Jun 03, 2024 pm 01:25 PM

Implémentation d'algorithmes d'apprentissage automatique en C++ : défis et solutions courants

Jun 03, 2024 pm 01:25 PM

Les défis courants rencontrés par les algorithmes d'apprentissage automatique en C++ incluent la gestion de la mémoire, le multithread, l'optimisation des performances et la maintenabilité. Les solutions incluent l'utilisation de pointeurs intelligents, de bibliothèques de threads modernes, d'instructions SIMD et de bibliothèques tierces, ainsi que le respect des directives de style de codage et l'utilisation d'outils d'automatisation. Des cas pratiques montrent comment utiliser la bibliothèque Eigen pour implémenter des algorithmes de régression linéaire, gérer efficacement la mémoire et utiliser des opérations matricielles hautes performances.

IA explicable : Expliquer les modèles IA/ML complexes

Jun 03, 2024 pm 10:08 PM

IA explicable : Expliquer les modèles IA/ML complexes

Jun 03, 2024 pm 10:08 PM

Traducteur | Revu par Li Rui | Chonglou Les modèles d'intelligence artificielle (IA) et d'apprentissage automatique (ML) deviennent aujourd'hui de plus en plus complexes, et le résultat produit par ces modèles est une boîte noire – impossible à expliquer aux parties prenantes. L'IA explicable (XAI) vise à résoudre ce problème en permettant aux parties prenantes de comprendre comment fonctionnent ces modèles, en s'assurant qu'elles comprennent comment ces modèles prennent réellement des décisions et en garantissant la transparence des systèmes d'IA, la confiance et la responsabilité pour résoudre ce problème. Cet article explore diverses techniques d'intelligence artificielle explicable (XAI) pour illustrer leurs principes sous-jacents. Plusieurs raisons pour lesquelles l’IA explicable est cruciale Confiance et transparence : pour que les systèmes d’IA soient largement acceptés et fiables, les utilisateurs doivent comprendre comment les décisions sont prises

Cinq écoles d'apprentissage automatique que vous ne connaissez pas

Jun 05, 2024 pm 08:51 PM

Cinq écoles d'apprentissage automatique que vous ne connaissez pas

Jun 05, 2024 pm 08:51 PM

L'apprentissage automatique est une branche importante de l'intelligence artificielle qui donne aux ordinateurs la possibilité d'apprendre à partir de données et d'améliorer leurs capacités sans être explicitement programmés. L'apprentissage automatique a un large éventail d'applications dans divers domaines, de la reconnaissance d'images et du traitement du langage naturel aux systèmes de recommandation et à la détection des fraudes, et il change notre façon de vivre. Il existe de nombreuses méthodes et théories différentes dans le domaine de l'apprentissage automatique, parmi lesquelles les cinq méthodes les plus influentes sont appelées les « Cinq écoles d'apprentissage automatique ». Les cinq grandes écoles sont l’école symbolique, l’école connexionniste, l’école évolutionniste, l’école bayésienne et l’école analogique. 1. Le symbolisme, également connu sous le nom de symbolisme, met l'accent sur l'utilisation de symboles pour le raisonnement logique et l'expression des connaissances. Cette école de pensée estime que l'apprentissage est un processus de déduction inversée, à travers les connaissances existantes.

Flash Attention est-il stable ? Meta et Harvard ont constaté que les écarts de poids de leur modèle fluctuaient de plusieurs ordres de grandeur.

May 30, 2024 pm 01:24 PM

Flash Attention est-il stable ? Meta et Harvard ont constaté que les écarts de poids de leur modèle fluctuaient de plusieurs ordres de grandeur.

May 30, 2024 pm 01:24 PM

MetaFAIR s'est associé à Harvard pour fournir un nouveau cadre de recherche permettant d'optimiser le biais de données généré lors de l'apprentissage automatique à grande échelle. On sait que la formation de grands modèles de langage prend souvent des mois et utilise des centaines, voire des milliers de GPU. En prenant comme exemple le modèle LLaMA270B, sa formation nécessite un total de 1 720 320 heures GPU. La formation de grands modèles présente des défis systémiques uniques en raison de l’ampleur et de la complexité de ces charges de travail. Récemment, de nombreuses institutions ont signalé une instabilité dans le processus de formation lors de la formation des modèles d'IA générative SOTA. Elles apparaissent généralement sous la forme de pics de pertes. Par exemple, le modèle PaLM de Google a connu jusqu'à 20 pics de pertes au cours du processus de formation. Le biais numérique est à l'origine de cette imprécision de la formation,

Apprentissage automatique en C++ : un guide pour la mise en œuvre d'algorithmes d'apprentissage automatique courants en C++

Jun 03, 2024 pm 07:33 PM

Apprentissage automatique en C++ : un guide pour la mise en œuvre d'algorithmes d'apprentissage automatique courants en C++

Jun 03, 2024 pm 07:33 PM

En C++, la mise en œuvre d'algorithmes d'apprentissage automatique comprend : Régression linéaire : utilisée pour prédire des variables continues. Les étapes comprennent le chargement des données, le calcul des poids et des biais, la mise à jour des paramètres et la prédiction. Régression logistique : utilisée pour prédire des variables discrètes. Le processus est similaire à la régression linéaire, mais utilise la fonction sigmoïde pour la prédiction. Machine à vecteurs de support : un puissant algorithme de classification et de régression qui implique le calcul de vecteurs de support et la prédiction d'étiquettes.