Périphériques technologiques

Périphériques technologiques

Industrie informatique

Industrie informatique

Alibaba Cloud a annoncé qu'il ouvrirait le modèle Qwen-14B de 14 milliards de paramètres de Tongyi Qianwen et son modèle de dialogue, qui seront gratuits pour un usage commercial.

Alibaba Cloud a annoncé qu'il ouvrirait le modèle Qwen-14B de 14 milliards de paramètres de Tongyi Qianwen et son modèle de dialogue, qui seront gratuits pour un usage commercial.

Alibaba Cloud a annoncé qu'il ouvrirait le modèle Qwen-14B de 14 milliards de paramètres de Tongyi Qianwen et son modèle de dialogue, qui seront gratuits pour un usage commercial.

Alibaba Cloud a annoncé aujourd'hui un projet open source appelé Qwen-14B, qui comprend un modèle paramétrique et un modèle de conversation. Ce projet open source permet une utilisation commerciale gratuite

Déclaration de ce site : Alibaba Cloud a déjà open source un modèle de paramètres Qwen-7B d'une valeur de 7 milliards, et le volume de téléchargement a dépassé 1 million de fois en plus d'un mois

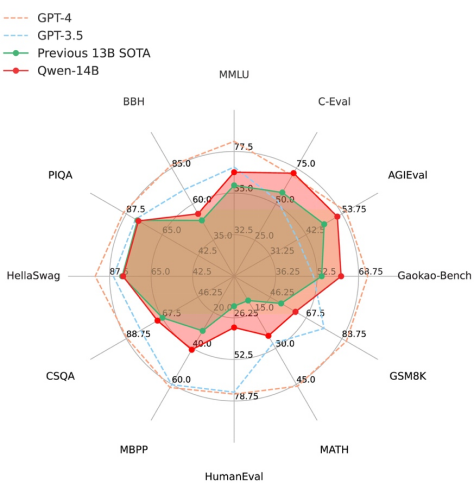

À en juger par les données fournies par Alibaba Cloud, Qwen-14B surpasse les modèles de même taille dans plusieurs évaluations faisant autorité, et certains indicateurs sont même proches de Llama2-70B.

Selon les rapports, Qwen-14B est un modèle open source hautes performances prenant en charge plusieurs langues. Ses données d'entraînement globales dépassent 3 000 milliards de jetons, ont des capacités de raisonnement, de cognition, de planification et de mémoire plus fortes, et prennent en charge une longueur maximale de fenêtre de contexte de 8 000

En revanche, Qwen-14B-Chat est basé sur le modèle de base Le modèle de dialogue obtenu grâce SFT raffiné peut apporter un contenu plus précis, plus conforme aux préférences humaines, et élargit également l'imagination et la richesse de la création de contenu.

À partir d'aujourd'hui, les utilisateurs peuvent télécharger directement des modèles depuis la communauté Alibaba Moda, et peuvent également accéder et appeler Qwen-14B et Qwen-14B-Chat via la plateforme Alibaba Cloud Lingji.

Zhou Jingren, CTO d'Alibaba Cloud, a déclaré qu'Alibaba Cloud continuera à adopter l'open source et l'ouverture et à promouvoir la construction du grand écosystème modèle chinois. Alibaba Cloud croit fermement au pouvoir de l'open source et prend la tête des grands modèles open source auto-développés, dans l'espoir d'apporter plus rapidement la technologie des grands modèles aux petites et moyennes entreprises et aux développeurs individuels.

Adresse de l'expérience d'espace de création de code zéro modèle :

https://modelscope.cn/stud/qwen/Qwen-14B-Chat-Demo

Configuration et installation de l'environnement

python version 3.8 et supérieure

-

Pytorch version 1.12 et supérieure, version 2.0 et supérieure recommandée

Il est recommandé d'utiliser CUDA 11.4 et supérieure (les utilisateurs de GPU doivent considérer cette option)

Étapes d'utilisation

Remarque : Exécuter sous la configuration de l'environnement de PAI-DSW (vous pouvez utiliser une seule carte pour exécuter, la mémoire vidéo minimale requise est de 11 Go)

Lien du modèle Qwen-14B-Chat :

https://modelscope.cn/models/qwen/Qwen -14B-Chat

Lien modèle Qwen-14B :

https://modelscope.cn/models/qwen/Qwen-14B

Lien modèle Qwen-14B-Chat-Int4 :

https://www .modelscope.cn/models/qwen/Qwen-14B-Chat-Int4

La communauté prend en charge le téléchargement direct du repo du modèle :

from modelscope.hub.snapshot_download import snapshot_download<br>model_dir = snapshot_download('qwen/Qwen-14B-Chat', 'v1.0.0')

Déclaration publicitaire : Saut externe liens (y compris, mais sans s'y limiter, les hyperliens) contenus dans l'article, code QR, mot de passe, etc.), utilisés pour transmettre plus d'informations et gagner du temps de sélection. Les résultats sont uniquement à titre de référence. Tous les articles de ce site incluent cette déclaration.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Alibaba Cloud a annoncé que la conférence Yunqi 2024 se tiendra à Hangzhou du 19 au 21 septembre. Application gratuite pour des billets gratuits.

Aug 07, 2024 pm 07:12 PM

Alibaba Cloud a annoncé que la conférence Yunqi 2024 se tiendra à Hangzhou du 19 au 21 septembre. Application gratuite pour des billets gratuits.

Aug 07, 2024 pm 07:12 PM

Selon les informations de ce site Web du 5 août, Alibaba Cloud a annoncé que la conférence Yunqi 2024 se tiendrait dans la ville de Yunqi, à Hangzhou, du 19 au 21 septembre. Il y aura un forum principal de trois jours, 400 sous-forums et sujets parallèles. ainsi que près de quatre Dix mille mètres carrés de surface d'exposition. La conférence Yunqi est gratuite et ouverte au public. Désormais, le public peut demander des billets gratuits via le site officiel de la conférence Yunqi. Un billet forfait de 5 000 yuans peut être acheté. Le site Web des billets est joint sur ce site Web. https://yunqi.aliyun.com/2024/ticket-list Selon certaines informations, la conférence Yunqi a débuté en 2009 et a été initialement nommée le premier forum de développement de sites Web en Chine en 2011, elle est devenue la conférence des développeurs Alibaba Cloud en 2015. , elle a été officiellement rebaptisée « Conférence Yunqi » et a continué à progresser avec succès

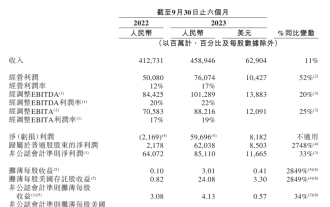

Le rapport financier semestriel d'Alibaba pour l'exercice 2024 montre que les revenus ont atteint 458,946 milliards de yuans, soit une augmentation de 11 % sur un an, et que le bénéfice net attribuable à la société mère a augmenté de 2 748 % sur un an.

Jan 04, 2024 pm 06:44 PM

Le rapport financier semestriel d'Alibaba pour l'exercice 2024 montre que les revenus ont atteint 458,946 milliards de yuans, soit une augmentation de 11 % sur un an, et que le bénéfice net attribuable à la société mère a augmenté de 2 748 % sur un an.

Jan 04, 2024 pm 06:44 PM

Selon les informations de ce site du 23 décembre, Alibaba a annoncé son rapport intermédiaire pour l'exercice 2024 (six mois se terminant le 30 septembre 2023), réalisant un chiffre d'affaires de 458,946 milliards de yuans, soit une augmentation de 11 % sur un an ; 76,074 milliards de yuans, soit une augmentation de 52 % sur un an ; le bénéfice net attribuable aux sociétés mères était de 62,038 milliards de yuans, soit une augmentation de 2 748 % sur un an ; le bénéfice dilué par action était de 3,01 yuans, sur un an ; -augmentation annuelle de 2849%. Ce site a remarqué que les revenus du groupe Taotian ont augmenté de 8 % d'une année sur l'autre. Les activités à l'étranger d'Alibaba International Digital Business Group ont enregistré de solides performances, avec des revenus en hausse de 47 %. Le chiffre d'affaires du groupe Cainiao a augmenté de 29 %. Le chiffre d'affaires de Local Living Group a augmenté de 22 %. Le chiffre d'affaires de Dawen Entertainment Group a augmenté de 21 % pour le semestre clos le 30 septembre 2023, Cainiao

Où puis-je trouver l'identifiant Alibaba ?

Mar 08, 2024 pm 09:49 PM

Où puis-je trouver l'identifiant Alibaba ?

Mar 08, 2024 pm 09:49 PM

Dans le logiciel Alibaba, une fois que vous avez enregistré un compte avec succès, le système vous attribuera un identifiant unique, qui servira d'identité sur la plateforme. Mais pour de nombreux utilisateurs, ils souhaitent interroger leur identifiant, mais ne savent pas comment le faire. Ensuite, l'éditeur de ce site Web vous présentera ci-dessous une introduction détaillée aux étapes de la stratégie, j'espère que cela pourra vous aider ! Où puis-je trouver la réponse à l'identifiant Alibaba : [Alibaba]-[Mon]. 1. Ouvrez d'abord le logiciel Alibaba. Après avoir accédé à la page d'accueil, nous devons cliquer sur [Mon] dans le coin inférieur droit. 2. Ensuite, après avoir accédé à la page Mon, nous pouvons voir [id] en haut de la page ; L'ID est-il le même que Taobao ID et Taobao ID sont différents, mais les deux

La DAMO Academy annonce les questions finales du test du concours mondial de mathématiques Alibaba 2024 : cinq pistes, résultats en août

Jun 23, 2024 pm 06:36 PM

La DAMO Academy annonce les questions finales du test du concours mondial de mathématiques Alibaba 2024 : cinq pistes, résultats en août

Jun 23, 2024 pm 06:36 PM

Selon les informations de ce site du 23 juin, ce site a appris du compte public DAMO WeChat qu'à minuit le 22 juin, heure de Pékin, la finale du concours mondial de mathématiques Alibaba 2024 s'est officiellement terminée. Plus de 800 candidats venus de 17 pays et régions du monde ont été présélectionnés pour la finale de cette année. Ensuite, il entrera dans la phase de notation indépendante du groupe d'experts. La notation comprend une évaluation préliminaire, un contre-interrogatoire, une vérification finale et d'autres processus. Dans les cinq filières finales, 1 médaille d'or, 2 médailles d'argent, 4 médailles de bronze et 10 prix d'excellence seront décernés en fonction des résultats. Au total, 85 gagnants seront annoncés en août. L'Alibaba Damo Academy a également annoncé les sujets de la finale de mathématiques. Les finales sont divisées en cinq domaines, à savoir : 1. Algèbre et théorie des nombres ; 2. Géométrie et topologie ; 3. Analyse et équations ; 4. Combinaison et probabilité ; et calcul.

Le siège mondial d'Alibaba à Hangzhou a été mis en service le 10 mai

May 07, 2024 pm 02:43 PM

Le siège mondial d'Alibaba à Hangzhou a été mis en service le 10 mai

May 07, 2024 pm 02:43 PM

Ce site Web a rapporté le 7 mai que le 10 mai, le siège mondial d'Alibaba (Xixi Area C) situé dans la future ville des sciences et technologies de Hangzhou sera officiellement mis en service et le parc scientifique et technologique d'Alibaba Beijing Chaoyang sera également ouvert. Cela représente le nombre d'immeubles de bureaux du siège d'Alibaba dans le monde, qui atteint quatre. ▲Siège mondial d'Alibaba (zone C, Xixi) Le 10 mai est également le 20e « Jour d'Alibaba » d'Alibaba. Ce jour-là chaque année, l'entreprise organisera des célébrations et deux nouveaux parcs seront ouverts aux parents, amis et anciens élèves d'Alibaba. Xixi Area C est actuellement le plus grand parc indépendant d’Alibaba et peut accueillir 30 000 personnes pour le travail de bureau. ▲Alibaba Beijing Chaoyang Science and Technology Park Le siège mondial d'Alibaba est situé dans la future ville scientifique et technologique de Hangzhou, au nord de Wenyi West Road et à l'est de Gaojiao Road, avec une superficie totale de construction de 984 500 mètres carrés, dont

Comment payer avec WeChat sur Alibaba_Comment payer avec WeChat sur Alibaba 1688

Mar 20, 2024 pm 05:51 PM

Comment payer avec WeChat sur Alibaba_Comment payer avec WeChat sur Alibaba 1688

Mar 20, 2024 pm 05:51 PM

Alibaba 1688 est un site Web d'achat et de vente en gros, et les articles y sont beaucoup moins chers que Taobao. Alors, comment Alibaba utilise-t-il le paiement WeChat ? L'éditeur a compilé du contenu pertinent à partager avec vous. Les amis dans le besoin peuvent venir y jeter un œil. Comment Alibaba utilise-t-il WeChat pour payer ? Réponse : Le paiement WeChat ne peut pas être utilisé pour le moment ; allez dans [Alipay, paiement échelonné], caissier] peut être sélectionné ;

Comment retourner des marchandises sur Alibaba

Mar 02, 2024 am 08:16 AM

Comment retourner des marchandises sur Alibaba

Mar 02, 2024 am 08:16 AM

Dans le logiciel Alibaba, de nombreux utilisateurs choisissent de faire leurs achats en ligne. Cependant, il arrive parfois que des retours soient nécessaires, mais de nombreux utilisateurs ne savent toujours pas comment mettre en œuvre les retours et les remboursements sur Alibaba. L'éditeur de ce site expliquera donc les étapes en détail ci-dessous. Pour les utilisateurs qui souhaitent en savoir plus, veuillez continuer à lire ci-dessous ! Comment retourner des marchandises sur Alibaba ? Réponse : [Alibaba]-[Mon]-[Ma commande]-[Plus]-[Demander un remboursement]-[Étape suivante]-[Demander un remboursement]. Étapes spécifiques : 1. Ouvrez d'abord le logiciel Alibaba, et après être entré dans la page d'accueil, nous cliquons sur [Mon] dans le coin inférieur droit. 2. Ensuite, dans la page Ma, nous cliquons sur la fonction [Ma commande] ; à ma commande

Entrée de connexion à la version Web d'Alibaba

Mar 02, 2024 am 09:52 AM

Entrée de connexion à la version Web d'Alibaba

Mar 02, 2024 am 09:52 AM

Alibaba propose un grand nombre de produits, offrant aux utilisateurs une multitude d’options d’achat. Pour les utilisateurs habitués à utiliser des ordinateurs pour faire leurs achats, la version Web d'Alibaba sera plus pratique. Alors, où se trouve l’entrée de connexion pour la version Web d’Alibaba ? Ci-dessous, l'éditeur de ce site vous proposera le portail de connexion de la version web d'Alibaba. Les utilisateurs qui souhaitent en savoir plus peuvent venir me suivre pour le découvrir ! Réponse de connexion à la version Web d'Alibaba : Version Web d'Alibaba : https://p4psearch.1688.com/1 Nous pouvons voir de nombreux types de produits différents sur la page de la version Web d'Alibaba 2. Ensuite, nous pouvons également voir les produits chauds à bas prix en temps réel ; -liste de ventes, livraison gratuite en temps réel des produits les plus vendus ; comment se connecter à la version Web d'Alibaba via le site Web ;