Périphériques technologiques

Périphériques technologiques

IA

IA

Parvenant à une « conduite autonome » sans piles, l'Université de Washington développe un robot avec une autonomie illimitée

Parvenant à une « conduite autonome » sans piles, l'Université de Washington développe un robot avec une autonomie illimitée

Parvenant à une « conduite autonome » sans piles, l'Université de Washington développe un robot avec une autonomie illimitée

Une « voiture » capable de rouler toute seule sans batterie est apparue.

Il collectera même automatiquement de l'énergie pour continuer à courir, sans aucune angoisse kilométrique (problème manuel).

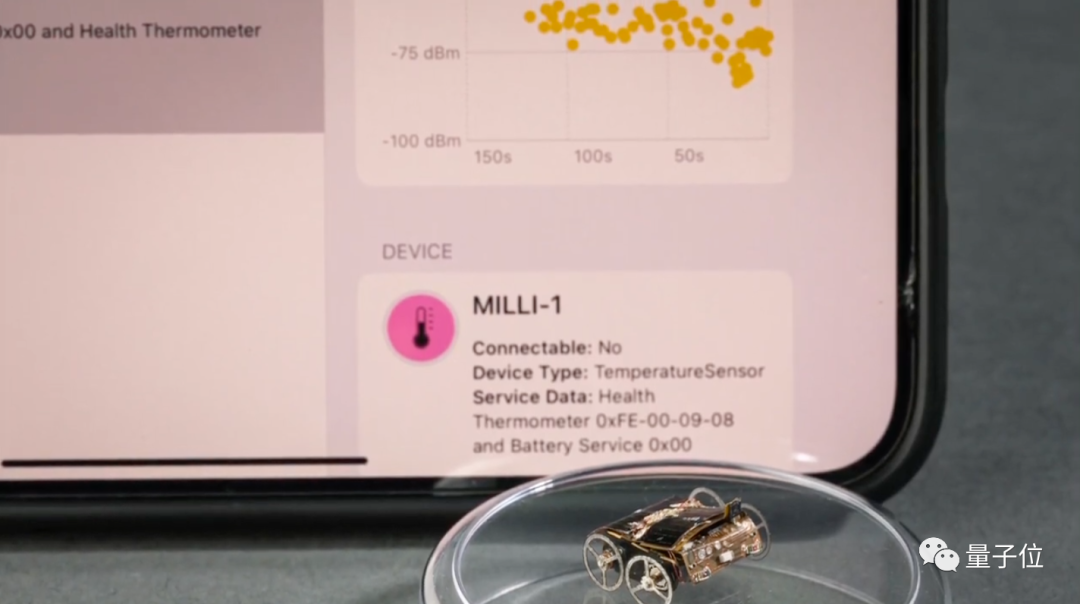

Oui, un si petit robot dépend en fait de la lumière et des ondes radio pour son alimentation. Son nom est MilliMobile, de l'Université de Washington.

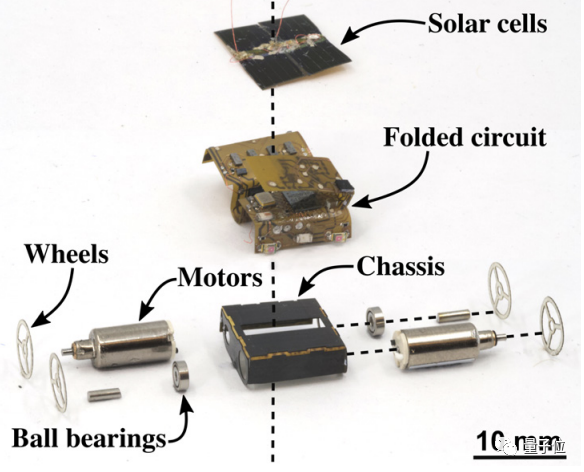

Bien qu'il soit aussi gros qu'un ongle et pèse à peu près le même poids qu'un raisin sec, il peut facilement transporter un équipement 3 fois son propre poids

et peut non seulement rouler sur des routes en ciment, mais aussi se déplacer librement sur des "chemins de terre ruraux". ".

Le contenu à réécrire est : △Source de l'image : Université de Washington

Le premier robot autonome sans batterie

Les petits robots équipés de capteurs sont souvent utilisés pour effectuer des tâches industrielles telles que la détection de fuites de gaz et le suivi entreposage. Mais le gros problème auquel il est confronté est que les piles jetables limitent non seulement la durée de vie du robot, mais ne sont pas non plus très respectueuses de l'environnement.

Les chercheurs recherchent des alternatives, comme attacher les capteurs directement aux insectes

Ce qui doit être réécrit est : △Source de l'image : Université de Washington

Cependant, les chercheurs de l'Université de Washington croient clairement que les méthodes passées Pas assez contrôlable. Ils ont proposé une nouvelle idée, qui consiste à utiliser un « mouvement intermittent » pour piloter le robot

Pour parler simplement, d'une part, il s'agit de réduire la taille et le poids du robot afin qu'il puisse fonctionner à une puissance extrêmement faible ( 57 microns sous le carrelage).

Les chercheurs ont également mené une autre expérience dans laquelle ils ont installé des condensateurs à film sur MilliMobile pour stocker l'énergie de la lumière du soleil et des ondes radio. Lorsque l'énergie stockée dans le condensateur atteint un certain seuil, le moteur peut être entraîné pour générer une courte impulsion de mouvement, provoquant le démarrage du robot.

En voyant cela, vous vous posez peut-être une question : est-ce bien cela ? Ce robot peut-il vraiment fonctionner ?

Les chercheurs ont vraiment réussi l'expérience : même par temps nuageux, MilliMobile peut parcourir une distance de 10 mètres en une heure -

La vitesse n'est effectivement pas rapide, mais les chercheurs ont dit que tant qu'il peut utiliser ce continu le fonctionnement rapide peut apporter de nouvelles capacités robotiques dans des zones où il était difficile d’obtenir des données en déployant des capteurs dans le passé.

Comme mentionné précédemment, bien que MilliMobile soit de petite taille, il possède des fonctions très complètes, dont les suivantes :

- 4 photodiodes, utilisées pour détecter l'intensité lumineuse dans 4 directions, permettant au robot de trouver indépendamment des sources de lumière pour le chargement

- Capteur de température et d'humidité

- Accéléromètre

- Capteur magnétique

- Capteur de gaz

- Micro caméra

- Puce de communication sans fil

De cette façon, MilliMobile dispose de diverses capacités de détection et peut détecter le terrain pour une conduite autonome.

Vous pouvez allumer la source de lumière par vous-même pour vous recharger

Il peut compléter un échantillonnage spatial riche et créer une vue plus détaillée de l'environnement.

En optimisant le protocole de transmission synchrone au niveau logiciel, les données peuvent également être transmises dans un rayon de 200 mètres.

Pour résumer brièvement, on peut dire que MilliMobile a atteint l'autonomie en termes d'alimentation électrique, de contrôle et de communication.

Une critique d'un site Web technologique disait : Ce projet a le goût de la science-fiction amené à la réalité

Qu'en pensez-vous ?

Lien de référence :

[1]https://www.washington.edu/news/2023/09/27/millimobile-battery-free-autonomous-self-driving-robot-solar/.

[2] Adresse papier : https://homes.cs.washington.edu/~vsiyer/Papers/millimobile-compressed.pdf.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Pourquoi le Gaussian Splatting est-il si populaire dans la conduite autonome que le NeRF commence à être abandonné ?

Jan 17, 2024 pm 02:57 PM

Pourquoi le Gaussian Splatting est-il si populaire dans la conduite autonome que le NeRF commence à être abandonné ?

Jan 17, 2024 pm 02:57 PM

Écrit ci-dessus et compréhension personnelle de l'auteur Le Gaussiansplatting tridimensionnel (3DGS) est une technologie transformatrice qui a émergé dans les domaines des champs de rayonnement explicites et de l'infographie ces dernières années. Cette méthode innovante se caractérise par l’utilisation de millions de gaussiennes 3D, ce qui est très différent de la méthode du champ de rayonnement neuronal (NeRF), qui utilise principalement un modèle implicite basé sur les coordonnées pour mapper les coordonnées spatiales aux valeurs des pixels. Avec sa représentation explicite de scènes et ses algorithmes de rendu différenciables, 3DGS garantit non seulement des capacités de rendu en temps réel, mais introduit également un niveau de contrôle et d'édition de scène sans précédent. Cela positionne 3DGS comme un révolutionnaire potentiel pour la reconstruction et la représentation 3D de nouvelle génération. À cette fin, nous fournissons pour la première fois un aperçu systématique des derniers développements et préoccupations dans le domaine du 3DGS.

Comment résoudre le problème de la longue traîne dans les scénarios de conduite autonome ?

Jun 02, 2024 pm 02:44 PM

Comment résoudre le problème de la longue traîne dans les scénarios de conduite autonome ?

Jun 02, 2024 pm 02:44 PM

Hier, lors de l'entretien, on m'a demandé si j'avais posé des questions à longue traîne, j'ai donc pensé faire un bref résumé. Le problème à longue traîne de la conduite autonome fait référence aux cas extrêmes dans les véhicules autonomes, c'est-à-dire à des scénarios possibles avec une faible probabilité d'occurrence. Le problème perçu de la longue traîne est l’une des principales raisons limitant actuellement le domaine de conception opérationnelle des véhicules autonomes intelligents à véhicule unique. L'architecture sous-jacente et la plupart des problèmes techniques de la conduite autonome ont été résolus, et les 5 % restants des problèmes à longue traîne sont progressivement devenus la clé pour restreindre le développement de la conduite autonome. Ces problèmes incluent une variété de scénarios fragmentés, de situations extrêmes et de comportements humains imprévisibles. La « longue traîne » des scénarios limites dans la conduite autonome fait référence aux cas limites dans les véhicules autonomes (VA). Les cas limites sont des scénarios possibles avec une faible probabilité d'occurrence. ces événements rares

Choisir une caméra ou un lidar ? Une étude récente sur la détection robuste d'objets 3D

Jan 26, 2024 am 11:18 AM

Choisir une caméra ou un lidar ? Une étude récente sur la détection robuste d'objets 3D

Jan 26, 2024 am 11:18 AM

0. Écrit à l'avant&& Compréhension personnelle que les systèmes de conduite autonome s'appuient sur des technologies avancées de perception, de prise de décision et de contrôle, en utilisant divers capteurs (tels que caméras, lidar, radar, etc.) pour percevoir l'environnement et en utilisant des algorithmes et des modèles pour une analyse et une prise de décision en temps réel. Cela permet aux véhicules de reconnaître les panneaux de signalisation, de détecter et de suivre d'autres véhicules, de prédire le comportement des piétons, etc., permettant ainsi de fonctionner en toute sécurité et de s'adapter à des environnements de circulation complexes. Cette technologie attire actuellement une grande attention et est considérée comme un domaine de développement important pour l'avenir des transports. . un. Mais ce qui rend la conduite autonome difficile, c'est de trouver comment faire comprendre à la voiture ce qui se passe autour d'elle. Cela nécessite que l'algorithme de détection d'objets tridimensionnels du système de conduite autonome puisse percevoir et décrire avec précision les objets dans l'environnement, y compris leur emplacement,

Cet article vous suffit pour en savoir plus sur la conduite autonome et la prédiction de trajectoire !

Feb 28, 2024 pm 07:20 PM

Cet article vous suffit pour en savoir plus sur la conduite autonome et la prédiction de trajectoire !

Feb 28, 2024 pm 07:20 PM

La prédiction de trajectoire joue un rôle important dans la conduite autonome. La prédiction de trajectoire de conduite autonome fait référence à la prédiction de la trajectoire de conduite future du véhicule en analysant diverses données pendant le processus de conduite du véhicule. En tant que module central de la conduite autonome, la qualité de la prédiction de trajectoire est cruciale pour le contrôle de la planification en aval. La tâche de prédiction de trajectoire dispose d'une riche pile technologique et nécessite une connaissance de la perception dynamique/statique de la conduite autonome, des cartes de haute précision, des lignes de voie, des compétences en architecture de réseau neuronal (CNN&GNN&Transformer), etc. Il est très difficile de démarrer ! De nombreux fans espèrent se lancer dans la prédiction de trajectoire le plus tôt possible et éviter les pièges. Aujourd'hui, je vais faire le point sur quelques problèmes courants et des méthodes d'apprentissage introductives pour la prédiction de trajectoire ! Connaissances introductives 1. Existe-t-il un ordre d'entrée pour les épreuves de prévisualisation ? R : Regardez d’abord l’enquête, p

L'Ameca deuxième génération est là ! Il peut communiquer couramment avec le public, ses expressions faciales sont plus réalistes et il peut parler des dizaines de langues.

Mar 04, 2024 am 09:10 AM

L'Ameca deuxième génération est là ! Il peut communiquer couramment avec le public, ses expressions faciales sont plus réalistes et il peut parler des dizaines de langues.

Mar 04, 2024 am 09:10 AM

Le robot humanoïde Ameca est passé à la deuxième génération ! Récemment, lors de la Conférence mondiale sur les communications mobiles MWC2024, le robot le plus avancé au monde, Ameca, est à nouveau apparu. Autour du site, Ameca a attiré un grand nombre de spectateurs. Avec la bénédiction de GPT-4, Ameca peut répondre à divers problèmes en temps réel. "Allons danser." Lorsqu'on lui a demandé si elle avait des émotions, Ameca a répondu avec une série d'expressions faciales très réalistes. Il y a quelques jours à peine, EngineeredArts, la société britannique de robotique derrière Ameca, vient de présenter les derniers résultats de développement de l'équipe. Dans la vidéo, le robot Ameca a des capacités visuelles et peut voir et décrire toute la pièce et des objets spécifiques. Le plus étonnant, c'est qu'elle peut aussi

SIMPL : un benchmark de prédiction de mouvement multi-agents simple et efficace pour la conduite autonome

Feb 20, 2024 am 11:48 AM

SIMPL : un benchmark de prédiction de mouvement multi-agents simple et efficace pour la conduite autonome

Feb 20, 2024 am 11:48 AM

Titre original : SIMPL : ASimpleandEfficientMulti-agentMotionPredictionBaselineforAutonomousDriving Lien article : https://arxiv.org/pdf/2402.02519.pdf Lien code : https://github.com/HKUST-Aerial-Robotics/SIMPL Affiliation de l'auteur : Université des sciences de Hong Kong et technologie Idée DJI Paper : cet article propose une base de référence de prédiction de mouvement (SIMPL) simple et efficace pour les véhicules autonomes. Par rapport au cent agent traditionnel

NuScenes dernier SOTA SparseAD : les requêtes clairsemées contribuent à une conduite autonome efficace de bout en bout !

Apr 17, 2024 pm 06:22 PM

NuScenes dernier SOTA SparseAD : les requêtes clairsemées contribuent à une conduite autonome efficace de bout en bout !

Apr 17, 2024 pm 06:22 PM

Écrit à l'avant et point de départ Le paradigme de bout en bout utilise un cadre unifié pour réaliser plusieurs tâches dans les systèmes de conduite autonome. Malgré la simplicité et la clarté de ce paradigme, les performances des méthodes de conduite autonome de bout en bout sur les sous-tâches sont encore loin derrière les méthodes à tâche unique. Dans le même temps, les fonctionnalités de vue à vol d'oiseau (BEV) denses, largement utilisées dans les méthodes de bout en bout précédentes, rendent difficile l'adaptation à davantage de modalités ou de tâches. Un paradigme de conduite autonome de bout en bout (SparseAD) centré sur la recherche clairsemée est proposé ici, dans lequel la recherche clairsemée représente entièrement l'ensemble du scénario de conduite, y compris l'espace, le temps et les tâches, sans aucune représentation BEV dense. Plus précisément, une architecture clairsemée unifiée est conçue pour la connaissance des tâches, notamment la détection, le suivi et la cartographie en ligne. De plus, lourd

Comment l'IA peut-elle rendre les robots plus autonomes et adaptables ?

Jun 03, 2024 pm 07:18 PM

Comment l'IA peut-elle rendre les robots plus autonomes et adaptables ?

Jun 03, 2024 pm 07:18 PM

Dans le domaine de la technologie de l’automatisation industrielle, il existe deux points chauds récents qu’il est difficile d’ignorer : l’intelligence artificielle (IA) et Nvidia. Ne changez pas le sens du contenu original, affinez le contenu, réécrivez le contenu, ne continuez pas : « Non seulement cela, les deux sont étroitement liés, car Nvidia ne se limite pas à son unité de traitement graphique d'origine (GPU ), il étend son GPU. La technologie s'étend au domaine des jumeaux numériques et est étroitement liée aux technologies émergentes d'IA "Récemment, NVIDIA a conclu une coopération avec de nombreuses entreprises industrielles, notamment des sociétés d'automatisation industrielle de premier plan telles qu'Aveva, Rockwell Automation, Siemens. et Schneider Electric, ainsi que Teradyne Robotics et ses sociétés MiR et Universal Robots. Récemment, Nvidiahascoll