Périphériques technologiques

Périphériques technologiques

Industrie informatique

Industrie informatique

Meta envisage de licencier des membres du département Metaverse Reality Labs, la nouvelle sort

Meta envisage de licencier des membres du département Metaverse Reality Labs, la nouvelle sort

Meta envisage de licencier des membres du département Metaverse Reality Labs, la nouvelle sort

Selon les rapports de Reuters, Meta envisage de licencier l'équipe de développement de puces (FAST) de Reality Labs, un département lié au métaverse.

Selon deux personnes proches du dossier, les employés de Meta ont reçu des avis de licenciement sur le forum interne. Lieu de travail. Il est dit que Meta publiera la notification de la société concernant son statut final tôt mercredi matin, heure locale. Un porte-parole de Meta a refusé de commenter.

Selon les informations publiques, le département FAST de Meta compte environ 600 employés. Le département a travaillé dur pour développer des puces personnalisées afin de fournir aux appareils Meta des fonctionnalités uniques et d'améliorer les performances pour les différencier des autres appareils VR/AR

Cependant, malgré les efforts de Meta, ils n'ont pas été en mesure de produire une puce capable de rivaliser avec les produits externes sont en concurrence avec les puces, leurs appareils utilisent donc toujours des puces Qualcomm

Meta a utilisé la puce Qualcomm Snapdragon XR2 Gen 2 dans le Quest 3 sorti la semaine dernière, équipé de 8 Go de mémoire. Meta a déclaré que les performances graphiques du Quest 3 sont deux fois supérieures à celles du Quest 2, et même meilleures que celles du Quest Pro équipé de la puce XR2+ de génération précédente.

La version 128 Go du Quest 3 est au prix de 499,99 $ US (environ 3655 RMB), tandis que la version 512 Go au prix de 649,99 $ US (environ 4 751 RMB)

Selon des personnes proches du dossier, la société développe également des lunettes de réalité augmentée qui sont plus difficiles, plus petites et ressemblent davantage à des lunettes ordinaires. comme montre intelligente associée

Selon une personne proche du dossier, la première version de ce produit devrait être achevée l'année prochaine, bien que Meta ne prévoit pas initialement de le lancer largement auprès des consommateurs

Déclaration publicitaire : liens de saut externes contenus dans l'article (y compris, mais sans s'y limiter, les hyperliens, les codes QR, les mots de passe, etc.), utilisé pour transmettre plus d'informations et gagner du temps de sélection. Les résultats sont uniquement à titre de référence. Tous les articles de ce site incluent cette déclaration.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

1393

1393

52

52

1207

1207

24

24

La puce de 1 nm est-elle fabriquée en Chine ou aux États-Unis ?

Nov 06, 2023 pm 01:30 PM

La puce de 1 nm est-elle fabriquée en Chine ou aux États-Unis ?

Nov 06, 2023 pm 01:30 PM

On ne sait pas exactement qui a fabriqué la puce de 1 nm. Du point de vue de la recherche et du développement, la puce de 1 nm a été développée conjointement par Taiwan, la Chine et les États-Unis. Du point de vue de la production de masse, cette technologie n’est pas encore pleinement réalisée. Le principal responsable de cette recherche est le Dr Zhu Jiadi du MIT, un scientifique chinois. Le Dr Zhu Jiadi a déclaré que la recherche en est encore à ses débuts et qu'elle est encore loin d'une production de masse.

Première en Chine : Changxin Memory lance la puce mémoire DRAM LPDDR5

Nov 28, 2023 pm 09:29 PM

Première en Chine : Changxin Memory lance la puce mémoire DRAM LPDDR5

Nov 28, 2023 pm 09:29 PM

Nouvelles de ce site le 28 novembre. Selon le site officiel de Changxin Memory, Changxin Memory a lancé la dernière puce mémoire LPDDR5DRAM. Il s'agit de la première marque nationale à lancer des produits LPDDR5 développés et produits de manière indépendante. Elle n'a réalisé aucune percée sur le marché national. marché et a également rendu la présentation des produits de Changxin Storage sur le marché des terminaux mobiles plus diversifiée. Ce site Web a remarqué que les produits de la série Changxin Memory LPDDR5 incluent des particules LPDDR5 de 12 Go, des puces 12GBLPDDR5 emballées par POP et des puces 6GBLPDDR5 emballées par DSC. La puce 12GBLPDDR5 a été vérifiée sur les modèles des principaux fabricants de téléphones mobiles nationaux tels que Xiaomi et Transsion. LPDDR5 est un produit lancé par Changxin Memory pour le marché des appareils mobiles de milieu à haut de gamme.

Un nouveau casque VR Meta Quest 3S abordable apparaît sur FCC, suggérant un lancement imminent

Sep 04, 2024 am 06:51 AM

Un nouveau casque VR Meta Quest 3S abordable apparaît sur FCC, suggérant un lancement imminent

Sep 04, 2024 am 06:51 AM

L'événement Meta Connect 2024 est prévu du 25 au 26 septembre et lors de cet événement, la société devrait dévoiler un nouveau casque de réalité virtuelle abordable. Selon la rumeur, il s'agirait du Meta Quest 3S, le casque VR serait apparemment apparu sur la liste FCC. Cela suggère

Le premier modèle open source à dépasser le niveau GPT4o ! Llama 3.1 fuite : 405 milliards de paramètres, liens de téléchargement et cartes de modèles sont disponibles

Jul 23, 2024 pm 08:51 PM

Le premier modèle open source à dépasser le niveau GPT4o ! Llama 3.1 fuite : 405 milliards de paramètres, liens de téléchargement et cartes de modèles sont disponibles

Jul 23, 2024 pm 08:51 PM

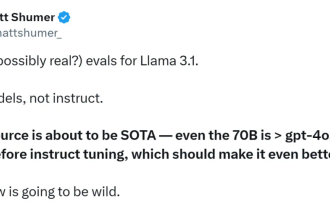

Préparez votre GPU ! Llama3.1 est finalement apparu, mais la source n'est pas officielle de Meta. Aujourd'hui, la nouvelle divulguée du nouveau grand modèle Llama est devenue virale sur Reddit. En plus du modèle de base, elle comprend également des résultats de référence de 8B, 70B et le paramètre maximum de 405B. La figure ci-dessous montre les résultats de comparaison de chaque version de Llama3.1 avec OpenAIGPT-4o et Llama38B/70B. On peut voir que même la version 70B dépasse GPT-4o sur plusieurs benchmarks. Source de l'image : https://x.com/mattshumer_/status/1815444612414087294 Évidemment, version 3.1 de 8B et 70

Il est rapporté que les clients d'emballages avancés de TSMC recherchent de manière significative les commandes et que la capacité de production mensuelle devrait augmenter de 120 % l'année prochaine.

Nov 13, 2023 pm 12:29 PM

Il est rapporté que les clients d'emballages avancés de TSMC recherchent de manière significative les commandes et que la capacité de production mensuelle devrait augmenter de 120 % l'année prochaine.

Nov 13, 2023 pm 12:29 PM

Ce site Web a rapporté le 13 novembre que, selon le Taiwan Economic Daily, la demande de packaging avancé CoWoS de TSMC est sur le point d'exploser. Outre NVIDIA, qui a confirmé l'expansion de ses commandes en octobre, des clients importants tels qu'Apple, AMD, Broadcom et Marvell. ont également récemment poursuivi leurs commandes de manière significative. Selon les rapports, TSMC travaille dur pour accélérer l'expansion de la capacité de production d'emballages avancés de CoWoS afin de répondre aux besoins des cinq principaux clients mentionnés ci-dessus. La capacité de production mensuelle de l'année prochaine devrait augmenter d'environ 20 % par rapport à l'objectif initial pour atteindre 35 000 pièces. Les analystes ont déclaré que les cinq principaux clients de TSMC ont passé des commandes importantes, ce qui montre que les applications d'intelligence artificielle sont devenues très populaires et que les principaux fabricants s'y intéressent. puces d'intelligence artificielle. La demande a considérablement augmenté. Les enquêtes sur ce site ont révélé que la technologie d'emballage avancée CoWoS actuelle est principalement divisée en trois types - CoWos-S.

Six façons rapides de découvrir le nouveau Llama 3 !

Apr 19, 2024 pm 12:16 PM

Six façons rapides de découvrir le nouveau Llama 3 !

Apr 19, 2024 pm 12:16 PM

Hier soir, Meta a publié les modèles Llama38B et 70B. Le modèle optimisé pour les instructions Llama3 est affiné et optimisé pour les cas d'utilisation de dialogue/chat et surpasse de nombreux modèles de chat open source existants dans les benchmarks courants. Par exemple, Gemma7B et Mistral7B. Le modèle Llama+3 améliore les données et l'échelle et atteint de nouveaux sommets. Il a été formé sur plus de 15 000 jetons de données sur deux clusters GPU 24 000 personnalisés récemment publiés par Meta. Cet ensemble de données de formation est 7 fois plus grand que Llama2 et contient 4 fois plus de code. Cela porte la capacité du modèle Llama au niveau le plus élevé actuel, qui prend en charge des longueurs de texte supérieures à 8 Ko, soit le double de celle de Llama2. sous

Le modèle le plus puissant Llama 3.1 405B est officiellement lancé, Zuckerberg : l'Open source mène une nouvelle ère

Jul 24, 2024 pm 08:23 PM

Le modèle le plus puissant Llama 3.1 405B est officiellement lancé, Zuckerberg : l'Open source mène une nouvelle ère

Jul 24, 2024 pm 08:23 PM

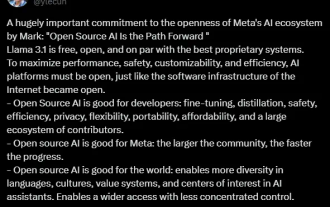

Tout à l'heure, le très attendu Llama 3.1 est officiellement sorti ! Meta a officiellement déclaré que "l'open source mène une nouvelle ère". Sur le blog officiel, Meta a déclaré : « Jusqu'à aujourd'hui, les grands modèles de langage open source étaient pour la plupart à la traîne des modèles fermés en termes de fonctionnalités et de performances. Nous inaugurons désormais une nouvelle ère dirigée par l'open source. Nous avons rendu public MetaLlama3.1405B. , qui, selon nous, est le modèle de base open source le plus grand et le plus puissant au monde, à ce jour, le nombre total de téléchargements de toutes les versions de Llama a dépassé les 300 millions de fois, et nous venons de commencer, le fondateur et PDG de Meta, Zuckerberg. article long "OpenSourceAIIsthePathForward",

Llama3 arrive soudainement ! La communauté open source est à nouveau en ébullition : l'ère de l'accès gratuit aux modèles de niveau GPT4 est arrivée

Apr 19, 2024 pm 12:43 PM

Llama3 arrive soudainement ! La communauté open source est à nouveau en ébullition : l'ère de l'accès gratuit aux modèles de niveau GPT4 est arrivée

Apr 19, 2024 pm 12:43 PM

Llama3 est là ! Tout à l'heure, le site officiel de Meta a été mis à jour et le responsable a annoncé les versions de Llama à 38 milliards et 70 milliards de paramètres. Et c'est un SOTA open source après son lancement : les métadonnées officielles montrent que les versions Llama38B et 70B surpassent tous les adversaires dans leurs échelles de paramètres respectives. Le modèle 8B surpasse Gemma7B et Mistral7BInstruct sur de nombreux benchmarks tels que MMLU, GPQA et HumanEval. Le modèle 70B a surpassé le populaire poulet frit Claude3Sonnet et a fait des allers-retours avec le GeminiPro1.5 de Google. Dès que le lien Huggingface est sorti, la communauté open source est redevenue enthousiasmée. Les étudiants aveugles aux yeux perçants ont également découvert immédiatement