Périphériques technologiques

Périphériques technologiques

IA

IA

Recherche expérimentale sur la fusion radar-caméra sur des ensembles de données sous BEV

Recherche expérimentale sur la fusion radar-caméra sur des ensembles de données sous BEV

Recherche expérimentale sur la fusion radar-caméra sur des ensembles de données sous BEV

Titre original : Étude expérimentale multi-ensembles de données sur la fusion radar-caméra en vue à vol d'oiseau

Lien papier : https://arxiv.org/pdf/2309.15465.pdf

Affiliation de l'auteur : Opel Automobile GmbH Rheinland-Pfalzische Technische Universitat Kaiserslautern- Centre de recherche allemand Landau pour l'intelligence artificielle

Idée de thèse :

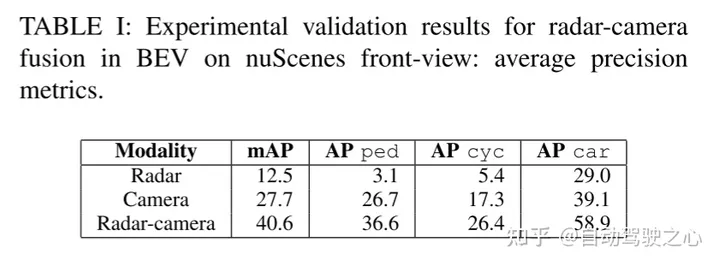

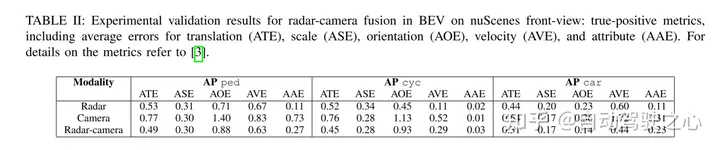

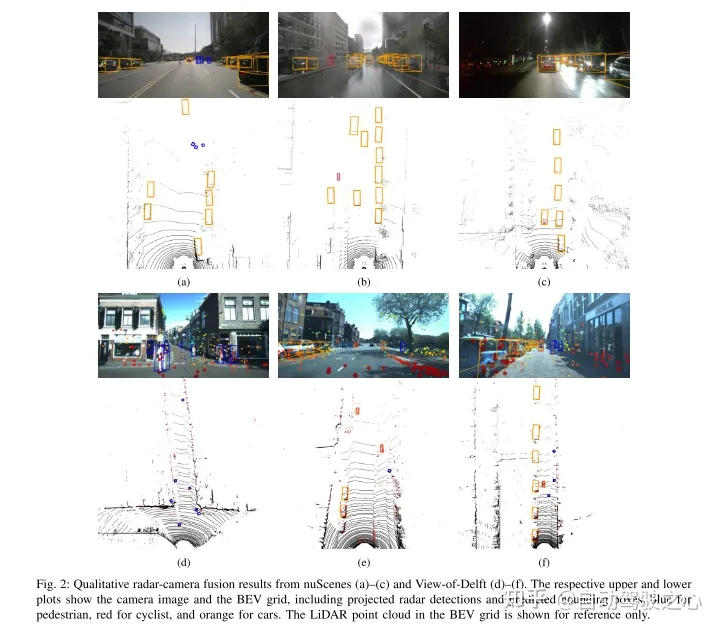

En exploitant les informations complémentaires des capteurs, les systèmes de fusion de radars à ondes millimétriques et de caméras ont le potentiel de fournir des capacités de conduite très robustes et autonomes pour les systèmes avancés d'aide à la conduite et Fonctions de conduite autonome. Système de détection fiable. Les progrès récents dans la détection d'objets par caméra offrent de nouvelles possibilités de fusion de radars à ondes millimétriques et de caméras, qui peuvent exploiter des cartes de caractéristiques à vol d'oiseau pour la fusion. Cette étude propose un réseau de fusion nouveau et flexible et évalue ses performances sur deux ensembles de données (nuScenes et View-of-Delft). Les résultats expérimentaux montrent que bien que la branche caméra nécessite des données de formation volumineuses et diversifiées, la branche radar à ondes millimétriques bénéficie davantage du radar à ondes millimétriques hautes performances. Grâce à l'apprentissage par transfert, cette étude améliore les performances de la caméra sur des ensembles de données plus petits. Les résultats de la recherche montrent en outre que la méthode de fusion du radar à ondes millimétriques et de la caméra est nettement meilleure que la méthode de base utilisant uniquement une caméra ou un radar à ondes millimétriques.

Conception du réseau :

Récemment, une tendance dans la détection de cibles 3D consiste à intégrer les caractéristiques des images Convertir en une représentation commune Bird's Eye View (BEV). Cette représentation fournit une architecture de fusion flexible qui peut être fusionnée entre plusieurs caméras ou à l'aide de capteurs télémétriques. Dans ce travail, nous étendons la méthode BEVFusion initialement utilisée pour la fusion de caméras laser à la fusion de caméras radar à ondes millimétriques. Nous avons formé et évalué notre méthode de fusion proposée à l'aide d'un ensemble de données radar à ondes millimétriques sélectionné. Dans plusieurs expériences, nous discutons des avantages et des inconvénients de chaque ensemble de données. Enfin, nous appliquons l'apprentissage par transfert pour obtenir de nouvelles améliorations.

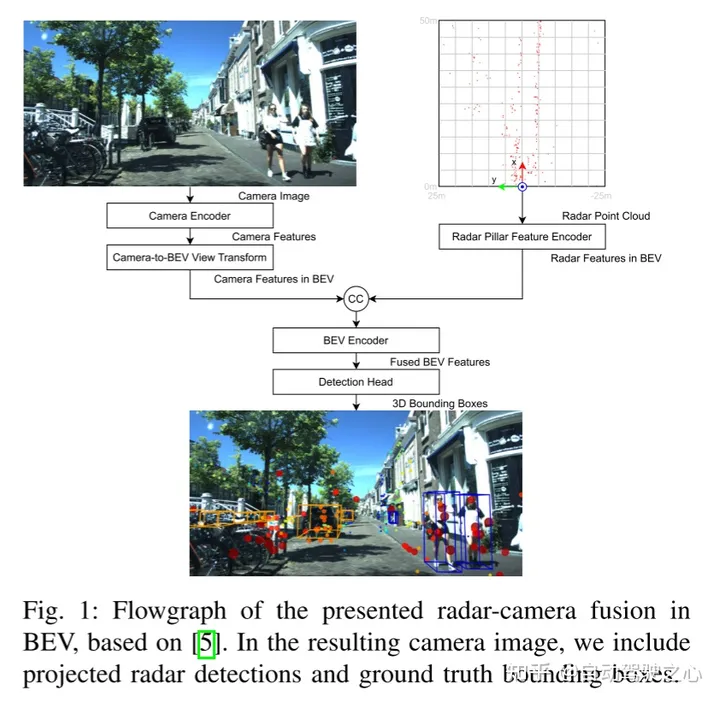

Voici ce qui doit être réécrit : La figure 1 montre l'organigramme de fusion radar-caméra à ondes millimétriques BEV basé sur BEVFusion. Dans l'image de caméra générée, nous incluons les résultats de détection du radar à ondes millimétriques projetées et de la véritable boîte englobante

Cet article suit l'architecture de fusion de BEVFusion. La figure 1 montre l'aperçu du réseau de fusion radar-caméra à ondes millimétriques dans BEV dans cet article. Notez que la fusion se produit lorsque les signatures de la caméra et du radar à ondes millimétriques sont connectées au BEV. Ci-dessous, cet article fournit plus de détails pour chaque bloc.

Le contenu qui doit être réécrit est : A. Encodeur de caméra et transformation de caméra en vue BEV

L'encodeur de caméra et la transformation de vue adoptent l'idée de [15], qui est un cadre flexible qui peut extraire une caméra externe arbitraire et les fonctionnalités Image BEV des paramètres internes. Tout d’abord, les caractéristiques sont extraites de chaque image à l’aide d’un réseau Tiny-Swin Transformer. Ensuite, cet article utilise les étapes Lift et Splat de [14] pour convertir les caractéristiques de l'image dans le plan BEV. À cette fin, la prédiction de profondeur dense est suivie d'un bloc basé sur des règles dans lequel les entités sont converties en pseudo-nuages de points, rastérisées et accumulées dans une grille BEV.

Encodeur de caractéristiques de colonne radar

Le but de ce bloc est d'encoder le nuage de points radar à ondes millimétriques en caractéristiques BEV sur la même grille que les caractéristiques d'image BEV. À cette fin, cet article utilise la technologie de codage de caractéristiques de pilier de [16] pour pixelliser le nuage de points en voxels infiniment élevés, ce qu'on appelle le pilier.

Le contenu qui doit être réécrit est : C. Encodeur BEV

Semblable à [5], les fonctionnalités BEV des radars et des caméras à ondes millimétriques sont obtenues grâce à la fusion en cascade. Les caractéristiques fusionnées sont traitées par un codeur convolutionnel BEV commun afin que le réseau puisse prendre en compte le désalignement spatial et exploiter la synergie entre les différentes modalités

Tête de détection D

Cet article utilise la tête de détection CenterPoint pour prédire le centre de l'objet de chaque classe de chaleur. carte. D'autres têtes de régression prédisent la taille, la rotation et la hauteur des objets, ainsi que les propriétés de vitesse et de classe des nuScenes. La carte thermique est entraînée à l'aide de la perte de focalisation gaussienne et le reste des têtes de détection sont entraînés à l'aide de la perte L1

Résultats expérimentaux :

Citation :

Stäcker, L., Heidenreich, P., Rambach, J. et Stricker, D. (2023). "Une étude expérimentale multi-ensembles de données de la fusion radar-caméra vue à vol d'oiseau" .ArXiv./abs/2309.15465

Le contenu qui doit être réécrit est : Lien original ;

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

1359

1359

52

52

Utilisez ddrescue pour récupérer des données sous Linux

Mar 20, 2024 pm 01:37 PM

Utilisez ddrescue pour récupérer des données sous Linux

Mar 20, 2024 pm 01:37 PM

DDREASE est un outil permettant de récupérer des données à partir de périphériques de fichiers ou de blocs tels que des disques durs, des SSD, des disques RAM, des CD, des DVD et des périphériques de stockage USB. Il copie les données d'un périphérique bloc à un autre, laissant derrière lui les blocs corrompus et ne déplaçant que les bons blocs. ddreasue est un puissant outil de récupération entièrement automatisé car il ne nécessite aucune interruption pendant les opérations de récupération. De plus, grâce au fichier map ddasue, il peut être arrêté et repris à tout moment. Les autres fonctionnalités clés de DDREASE sont les suivantes : Il n'écrase pas les données récupérées mais comble les lacunes en cas de récupération itérative. Cependant, il peut être tronqué si l'outil est invité à le faire explicitement. Récupérer les données de plusieurs fichiers ou blocs en un seul

Open source! Au-delà de ZoeDepth ! DepthFM : estimation rapide et précise de la profondeur monoculaire !

Apr 03, 2024 pm 12:04 PM

Open source! Au-delà de ZoeDepth ! DepthFM : estimation rapide et précise de la profondeur monoculaire !

Apr 03, 2024 pm 12:04 PM

0. À quoi sert cet article ? Nous proposons DepthFM : un modèle d'estimation de profondeur monoculaire génératif de pointe, polyvalent et rapide. En plus des tâches traditionnelles d'estimation de la profondeur, DepthFM démontre également des capacités de pointe dans les tâches en aval telles que l'inpainting en profondeur. DepthFM est efficace et peut synthétiser des cartes de profondeur en quelques étapes d'inférence. Lisons ce travail ensemble ~ 1. Titre des informations sur l'article : DepthFM : FastMonocularDepthEstimationwithFlowMatching Auteur : MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Comment résoudre le problème de la longue traîne dans les scénarios de conduite autonome ?

Jun 02, 2024 pm 02:44 PM

Comment résoudre le problème de la longue traîne dans les scénarios de conduite autonome ?

Jun 02, 2024 pm 02:44 PM

Hier, lors de l'entretien, on m'a demandé si j'avais posé des questions à longue traîne, j'ai donc pensé faire un bref résumé. Le problème à longue traîne de la conduite autonome fait référence aux cas extrêmes dans les véhicules autonomes, c'est-à-dire à des scénarios possibles avec une faible probabilité d'occurrence. Le problème perçu de la longue traîne est l’une des principales raisons limitant actuellement le domaine de conception opérationnelle des véhicules autonomes intelligents à véhicule unique. L'architecture sous-jacente et la plupart des problèmes techniques de la conduite autonome ont été résolus, et les 5 % restants des problèmes à longue traîne sont progressivement devenus la clé pour restreindre le développement de la conduite autonome. Ces problèmes incluent une variété de scénarios fragmentés, de situations extrêmes et de comportements humains imprévisibles. La « longue traîne » des scénarios limites dans la conduite autonome fait référence aux cas limites dans les véhicules autonomes (VA). Les cas limites sont des scénarios possibles avec une faible probabilité d'occurrence. ces événements rares

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Les performances de JAX, promu par Google, ont dépassé celles de Pytorch et TensorFlow lors de récents tests de référence, se classant au premier rang sur 7 indicateurs. Et le test n’a pas été fait sur le TPU présentant les meilleures performances JAX. Bien que parmi les développeurs, Pytorch soit toujours plus populaire que Tensorflow. Mais à l’avenir, des modèles plus volumineux seront peut-être formés et exécutés sur la base de la plate-forme JAX. Modèles Récemment, l'équipe Keras a comparé trois backends (TensorFlow, JAX, PyTorch) avec l'implémentation native de PyTorch et Keras2 avec TensorFlow. Premièrement, ils sélectionnent un ensemble de

Vitesse Internet lente des données cellulaires sur iPhone : correctifs

May 03, 2024 pm 09:01 PM

Vitesse Internet lente des données cellulaires sur iPhone : correctifs

May 03, 2024 pm 09:01 PM

Vous êtes confronté à un décalage et à une connexion de données mobile lente sur iPhone ? En règle générale, la puissance de l'Internet cellulaire sur votre téléphone dépend de plusieurs facteurs tels que la région, le type de réseau cellulaire, le type d'itinérance, etc. Vous pouvez prendre certaines mesures pour obtenir une connexion Internet cellulaire plus rapide et plus fiable. Correctif 1 – Forcer le redémarrage de l'iPhone Parfois, le redémarrage forcé de votre appareil réinitialise simplement beaucoup de choses, y compris la connexion cellulaire. Étape 1 – Appuyez simplement une fois sur la touche d’augmentation du volume et relâchez-la. Ensuite, appuyez sur la touche de réduction du volume et relâchez-la à nouveau. Étape 2 – La partie suivante du processus consiste à maintenir le bouton sur le côté droit. Laissez l'iPhone finir de redémarrer. Activez les données cellulaires et vérifiez la vitesse du réseau. Vérifiez à nouveau Correctif 2 – Changer le mode de données Bien que la 5G offre de meilleures vitesses de réseau, elle fonctionne mieux lorsque le signal est plus faible

La vitalité de la super intelligence s'éveille ! Mais avec l'arrivée de l'IA qui se met à jour automatiquement, les mères n'ont plus à se soucier des goulots d'étranglement des données.

Apr 29, 2024 pm 06:55 PM

La vitalité de la super intelligence s'éveille ! Mais avec l'arrivée de l'IA qui se met à jour automatiquement, les mères n'ont plus à se soucier des goulots d'étranglement des données.

Apr 29, 2024 pm 06:55 PM

Je pleure à mort. Le monde construit à la folie de grands modèles. Les données sur Internet ne suffisent pas du tout. Le modèle de formation ressemble à « The Hunger Games », et les chercheurs en IA du monde entier se demandent comment nourrir ces personnes avides de données. Ce problème est particulièrement important dans les tâches multimodales. À une époque où rien ne pouvait être fait, une équipe de start-up du département de l'Université Renmin de Chine a utilisé son propre nouveau modèle pour devenir la première en Chine à faire de « l'auto-alimentation des données générées par le modèle » une réalité. De plus, il s’agit d’une approche à deux volets, du côté compréhension et du côté génération, les deux côtés peuvent générer de nouvelles données multimodales de haute qualité et fournir un retour de données au modèle lui-même. Qu'est-ce qu'un modèle ? Awaker 1.0, un grand modèle multimodal qui vient d'apparaître sur le Forum Zhongguancun. Qui est l'équipe ? Moteur Sophon. Fondé par Gao Yizhao, doctorant à la Hillhouse School of Artificial Intelligence de l’Université Renmin.

L'US Air Force présente son premier avion de combat IA de grande envergure ! Le ministre a personnellement effectué l'essai routier sans intervenir pendant tout le processus, et 100 000 lignes de code ont été testées 21 fois.

May 07, 2024 pm 05:00 PM

L'US Air Force présente son premier avion de combat IA de grande envergure ! Le ministre a personnellement effectué l'essai routier sans intervenir pendant tout le processus, et 100 000 lignes de code ont été testées 21 fois.

May 07, 2024 pm 05:00 PM

Récemment, le milieu militaire a été submergé par la nouvelle : les avions de combat militaires américains peuvent désormais mener des combats aériens entièrement automatiques grâce à l'IA. Oui, tout récemment, l’avion de combat IA de l’armée américaine a été rendu public pour la première fois, dévoilant ainsi son mystère. Le nom complet de ce chasseur est Variable Stability Simulator Test Aircraft (VISTA). Il a été personnellement piloté par le secrétaire de l'US Air Force pour simuler une bataille aérienne en tête-à-tête. Le 2 mai, le secrétaire de l'US Air Force, Frank Kendall, a décollé à bord d'un X-62AVISTA à la base aérienne d'Edwards. Notez que pendant le vol d'une heure, toutes les actions de vol ont été effectuées de manière autonome par l'IA ! Kendall a déclaré : "Au cours des dernières décennies, nous avons réfléchi au potentiel illimité du combat air-air autonome, mais cela a toujours semblé hors de portée." Mais maintenant,

NuScenes dernier SOTA SparseAD : les requêtes clairsemées contribuent à une conduite autonome efficace de bout en bout !

Apr 17, 2024 pm 06:22 PM

NuScenes dernier SOTA SparseAD : les requêtes clairsemées contribuent à une conduite autonome efficace de bout en bout !

Apr 17, 2024 pm 06:22 PM

Écrit à l'avant et point de départ Le paradigme de bout en bout utilise un cadre unifié pour réaliser plusieurs tâches dans les systèmes de conduite autonome. Malgré la simplicité et la clarté de ce paradigme, les performances des méthodes de conduite autonome de bout en bout sur les sous-tâches sont encore loin derrière les méthodes à tâche unique. Dans le même temps, les fonctionnalités de vue à vol d'oiseau (BEV) denses, largement utilisées dans les méthodes de bout en bout précédentes, rendent difficile l'adaptation à davantage de modalités ou de tâches. Un paradigme de conduite autonome de bout en bout (SparseAD) centré sur la recherche clairsemée est proposé ici, dans lequel la recherche clairsemée représente entièrement l'ensemble du scénario de conduite, y compris l'espace, le temps et les tâches, sans aucune représentation BEV dense. Plus précisément, une architecture clairsemée unifiée est conçue pour la connaissance des tâches, notamment la détection, le suivi et la cartographie en ligne. De plus, lourd