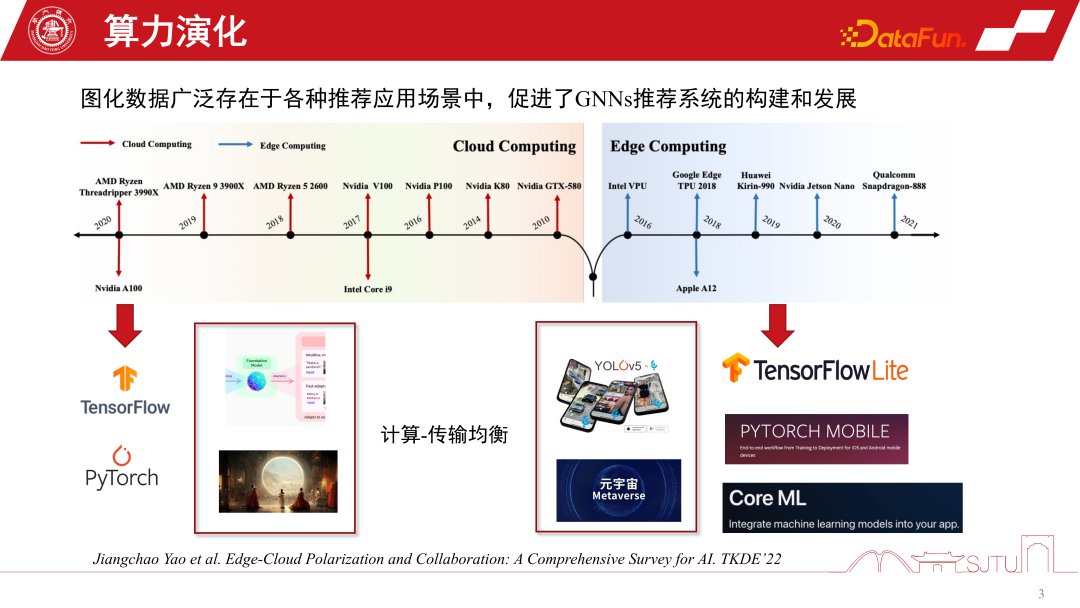

Au cours des 20 dernières années, les formes informatiques ont constamment évolué. Avant 2010, le cloud computing était particulièrement populaire, alors que les autres formes informatiques étaient relativement faibles. Avec le développement rapide de la puissance de calcul matérielle et l’introduction des puces end-side, l’informatique de pointe est devenue particulièrement importante. Les deux principales formes informatiques actuelles ont façonné le développement de l'IA dans deux directions polarisées. D'une part, dans le cadre de l'architecture du cloud computing, nous pouvons utiliser les capacités de cluster à très grande échelle pour former des modèles d'IA à grande échelle, tels que le Foundation Model. ou certains modèles génératifs. D'un autre côté, avec le développement de l'informatique de pointe, nous pouvons également déployer des modèles d'IA côté terminal pour fournir des services plus légers, comme l'exécution de diverses tâches de reconnaissance côté terminal. Parallèlement, avec le développement du métaverse, les calculs de nombreux modèles seront relégués au second plan. La question centrale que ces deux formes d’informatique veulent donc concilier est celle de l’équilibre entre informatique et transmission, suivie du développement polarisé de l’intelligence artificielle.

Quelles opportunités ces deux formes informatiques apportent-elles au système de recommandation des GNN ?

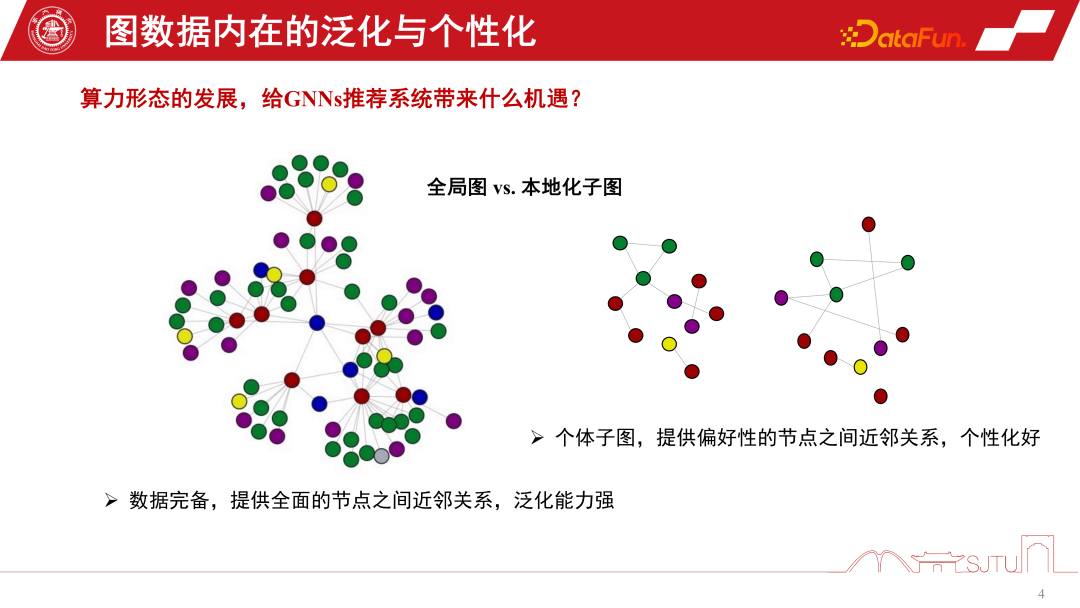

La perspective de Duanyun peut être comparée à la perspective d’une image globale et d’un sous-graphe localisé. Dans le système de recommandation des GNN, le sous-graphe global est un sous-graphe global qui est continuellement collecté à partir de nombreux sous-graphes au niveau des nœuds. Son avantage est que les données sont complètes et peuvent fournir une relation relativement complète entre les nœuds. Ce type de biais inductif peut être plus universel. Il résume les règles de divers nœuds et extrait le biais inductif, il a donc une forte capacité de généralisation. Le sous-graphe localisé n'est pas nécessairement particulièrement complet, mais son avantage est qu'il peut décrire avec précision l'évolution du comportement d'un individu sur le sous-graphe et permettre l'établissement de relations de nœuds personnalisées. La relation entre le terminal et le cloud ressemble donc un peu à un sous-graphe global et un sous-graphe localisé. Le cloud computing peut fournir une puissante puissance de calcul centralisée pour fournir des services, tandis que le terminal peut fournir certains services personnalisés de données

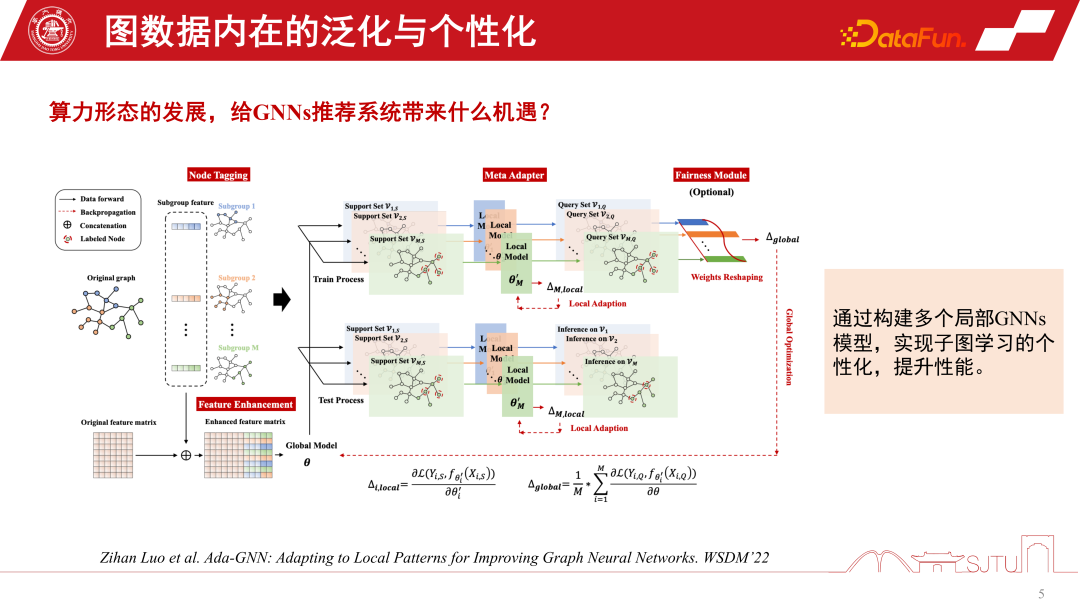

Nous pouvons combiner les avantages des graphiques globaux et des sous-graphes localisés pour mieux améliorer les performances du modèle. Une étude publiée dans WSDM2022. cette année, j'ai exploré cela. Il propose un modèle Ada-GNN (Adapting to Local Patterns for enhancement Graph Neural Networks), qui possède une modélisation de graphe complet pour le graphe global, et construit également des modèles locaux à l'aide de sous-graphes pour effectuer une certaine adaptation. L’essence d’une telle adaptation est de permettre au modèle qui combine le modèle global et le modèle local de percevoir les règles du graphe local de manière plus raffinée et d’améliorer les performances d’apprentissage personnalisé.

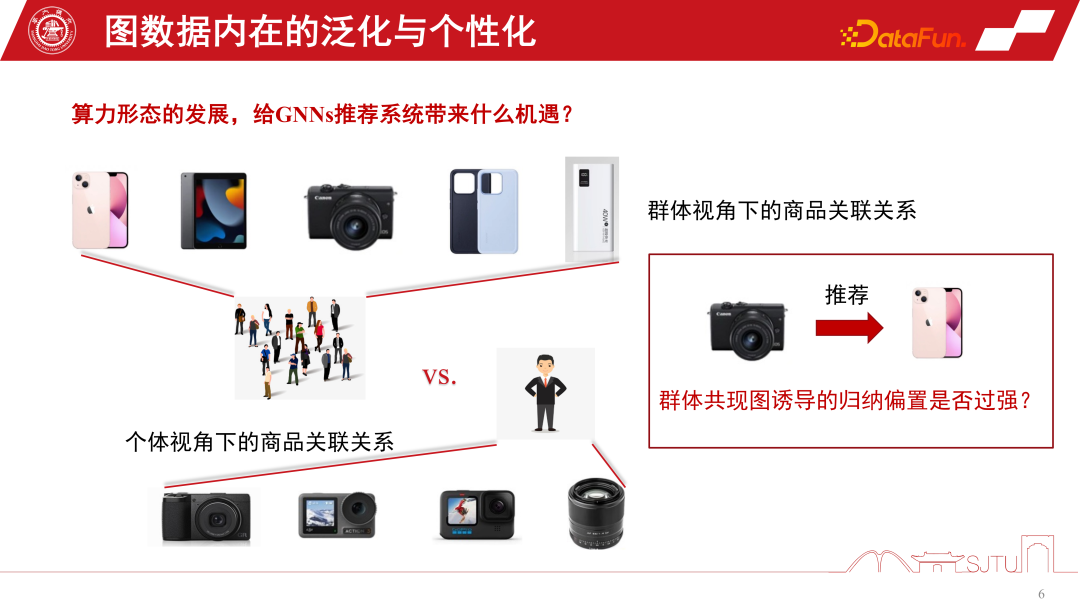

Maintenant, nous utilisons un exemple spécifique pour expliquer pourquoi nous devrions prêter attention aux sous-graphes. Dans le système de recommandation du commerce électronique, il existe un groupe de passionnés du numérique qui peuvent décrire la relation entre les produits numériques, tels que les téléphones mobiles, les tablettes, les appareils photo et les périphériques de téléphonie mobile. Une fois qu'il a cliqué sur l'une des caméras, un biais inductif a été induit. Une carte de biais inductif induite par la carte de contribution du groupe peut nous inciter à recommander ce type de téléphone portable, mais si l'on revient au point de vue individuel, s'il est passionné de photographie et porte une attention particulière aux produits photographiques, cela entraînera parfois le paradoxe montré ci-dessous. Le biais inductif induit par la carte de contribution de groupe est-il trop fort pour certains groupes, notamment ce groupe de queue ? C'est ce que l'on appelle souvent l'effet Matthew ?

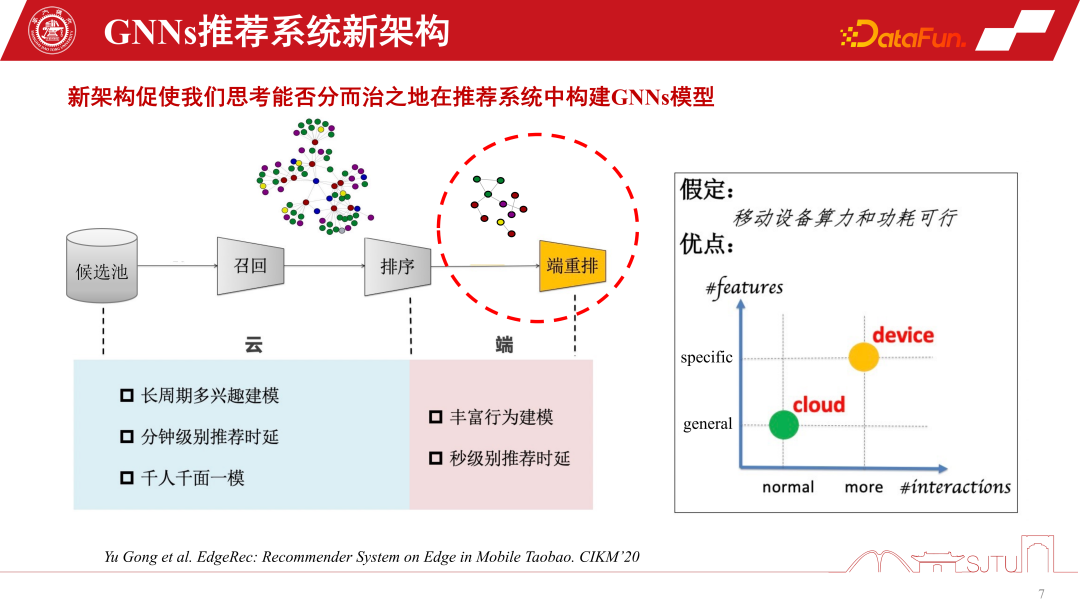

De manière générale, les formes informatiques polarisées existantes peuvent remodeler notre modélisation des systèmes de recommandation GNN. Les systèmes de recommandation traditionnels rappellent les produits ou les éléments du pool de candidats, perçoivent la relation entre eux via la modélisation GNN, puis classent et recommandent les utilisateurs. Cependant, grâce à la prise en charge de l'informatique de pointe, nous pouvons déployer des modèles de personnalisation du côté final pour percevoir une personnalisation plus fine grâce à l'apprentissage sur les sous-graphes. Bien entendu, cette nouvelle architecture de système de recommandation pour la collaboration appareil-cloud repose sur l'hypothèse que la puissance de calcul et la consommation d'énergie de l'appareil sont réalisables. Mais la situation réelle est que la surcharge de puissance de calcul d'un petit modèle n'est pas importante. Si vous le compressez à un ou deux mégaoctets et placez la surcharge de calcul sur un smartphone existant, il ne consommera pas réellement plus de puissance de calcul qu'une application de jeu. et une grande énergie électrique. Par conséquent, avec le développement ultérieur de l'informatique de pointe et l'amélioration des performances des appareils finaux, il offre de plus grandes possibilités pour davantage de modélisation de GNN du côté final

Si nous voulons mettre le modèle GNN à la fin, alors le La puissance de calcul finale et la capacité de stockage doivent être prises en compte. Nous avons également mentionné la compression de modèle plus tôt. Si vous souhaitez que le modèle GNN soit plus efficace du côté de l'appareil, si vous y placez un modèle GNN relativement volumineux, vous devez effectuer une compression de modèle. Les méthodes traditionnelles de compression, d'élagage et de quantification des modèles peuvent être utilisées sur les modèles GNN existants, mais elles entraîneront des pertes de performances dans les systèmes de recommandation. Dans ce scénario, nous ne pouvons pas sacrifier les performances pour créer un modèle côté périphérique. Ainsi, même si l'élagage et la quantification sont utiles, ils ont un effet limité.

Une autre méthode de compression de modèle utile est la distillation. Même s’il ne peut être réduit que de plusieurs fois, le coût est similaire. Une étude récente publiée dans KDD porte sur la distillation des GNN. Dans les GNN, la distillation de la modélisation graphique des données est confrontée à un défi : les mesures de distance sont facilement définies dans l'espace logit, mais dans l'espace des caractéristiques latentes, en particulier les mesures de distance couche par couche entre les GNN des enseignants et les GNN des étudiants. À cet égard, cette recherche sur KDD fournit une solution pour parvenir à une conception apprenable en apprenant une métrique par génération contradictoire

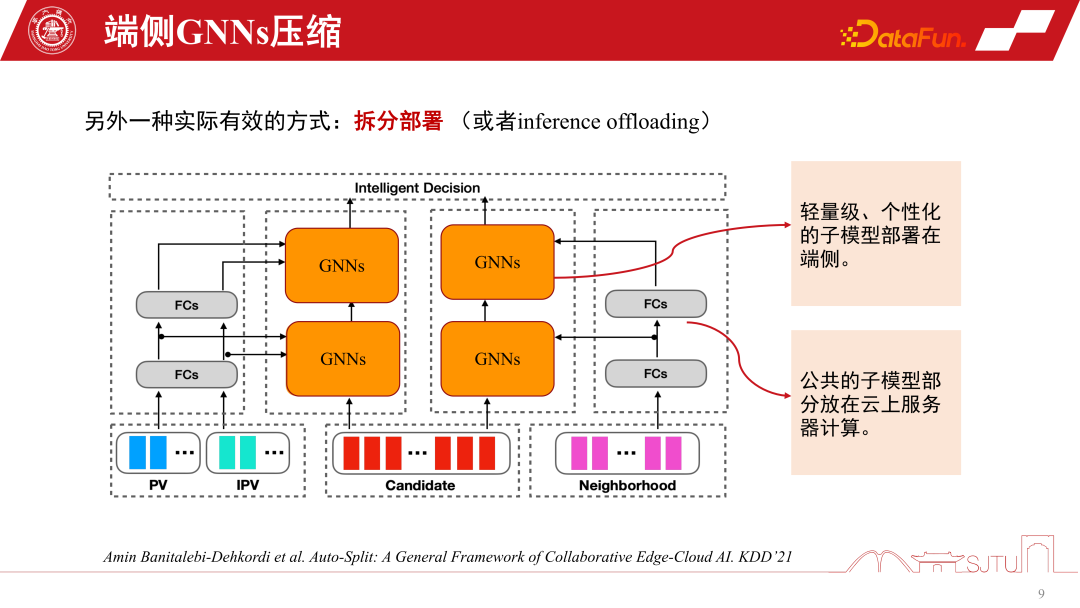

Dans le système de recommandation des GNN, en plus de la technologie de compression de modèle mentionnée précédemment, le sous-déploiement de désassemblage est un sous-déploiement spécifique et technique très utile. Il est étroitement lié à l'architecture du modèle du système de recommandation des GNN, car la couche inférieure des GNN est l'incorporation d'éléments du produit, et après plusieurs couches de transformation non linéaire du MLP, la stratégie d'agrégation des GNN sera utilisée

Une fois qu'un modèle est formé, il y a un avantage naturel. La couche de base est entièrement partagée et seule la couche GNN peut être personnalisée. Pour la personnalisation ici, on peut diviser le modèle en deux parties et mettre la partie publique du modèle dans le cloud. La puissance de calcul étant suffisante, la partie personnalisée peut être déployée sur le terminal. De cette façon, il suffit de stocker le GNN du noyau intermédiaire dans le terminal. Dans les systèmes de recommandation actuels, cette approche peut réduire considérablement la surcharge de stockage de l'ensemble du modèle. Nous avons pratiqué les scénarios d'Alibaba. Après le déploiement fractionné, le modèle peut atteindre le niveau KB. Ensuite, grâce à une quantification simple des bits du modèle, le modèle peut être rendu très petit et il n'y a presque pas de surcharge particulièrement importante lorsqu'il est placé sur le terminal. Bien entendu, il s’agit d’une méthode fractionnée basée sur l’expérience. L'un des travaux récents de Huawei publiés sur KDD est la division automatique du modèle, qui peut détecter les performances de l'équipement terminal et diviser automatiquement ce modèle. Bien sûr, s'ils sont appliqués aux GNN, une certaine refonte peut être nécessaire

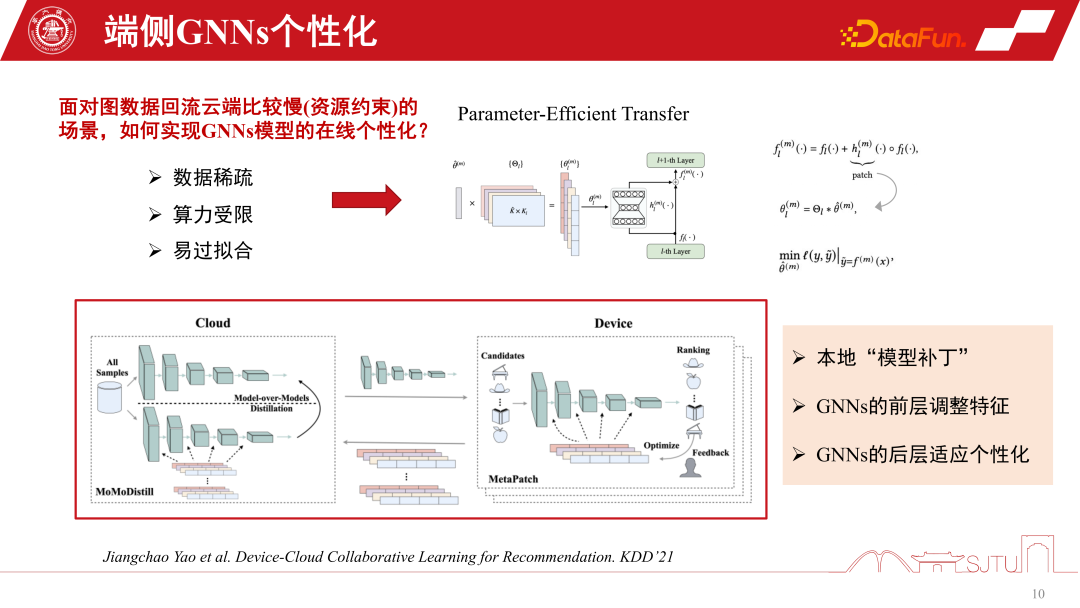

Lors du déploiement de modèles dans certains scénarios sérieux de transfert de distribution, nos modèles pré-entraînés sont déjà relativement anciens avant d'être déployés du côté final. En effet, la fréquence des données graphiques réelles renvoyées vers le cloud pour la formation est relativement lente, et cela peut parfois prendre une semaine. Le principal goulot d'étranglement ici est les contraintes de ressources

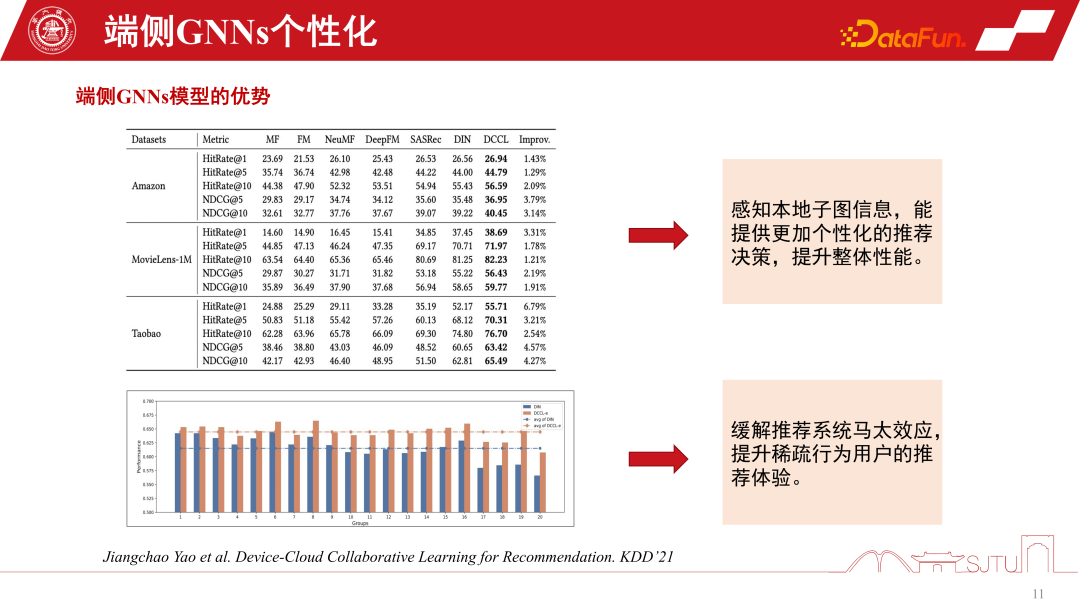

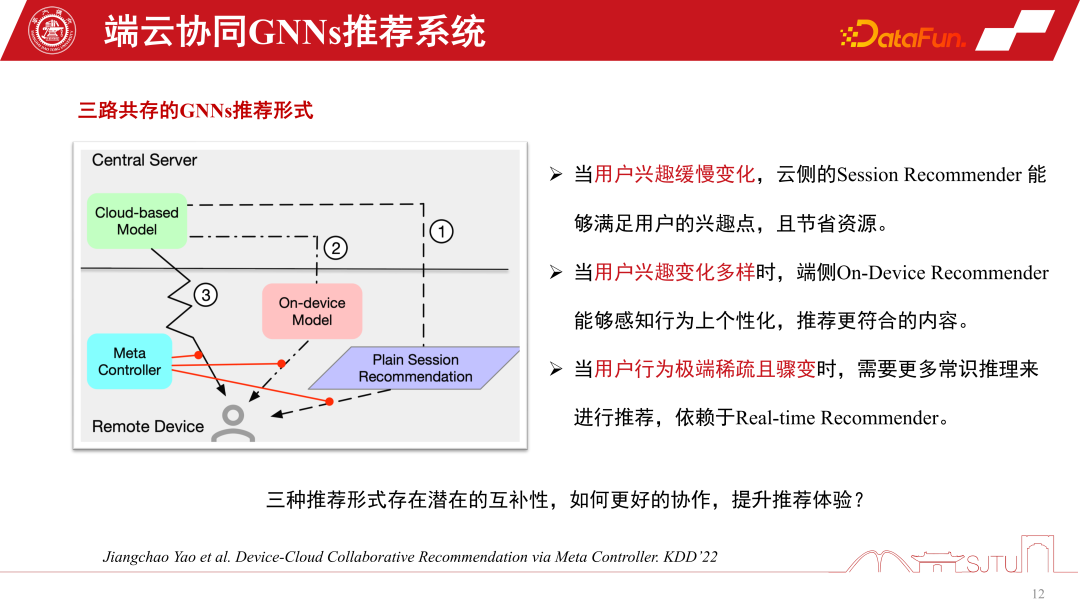

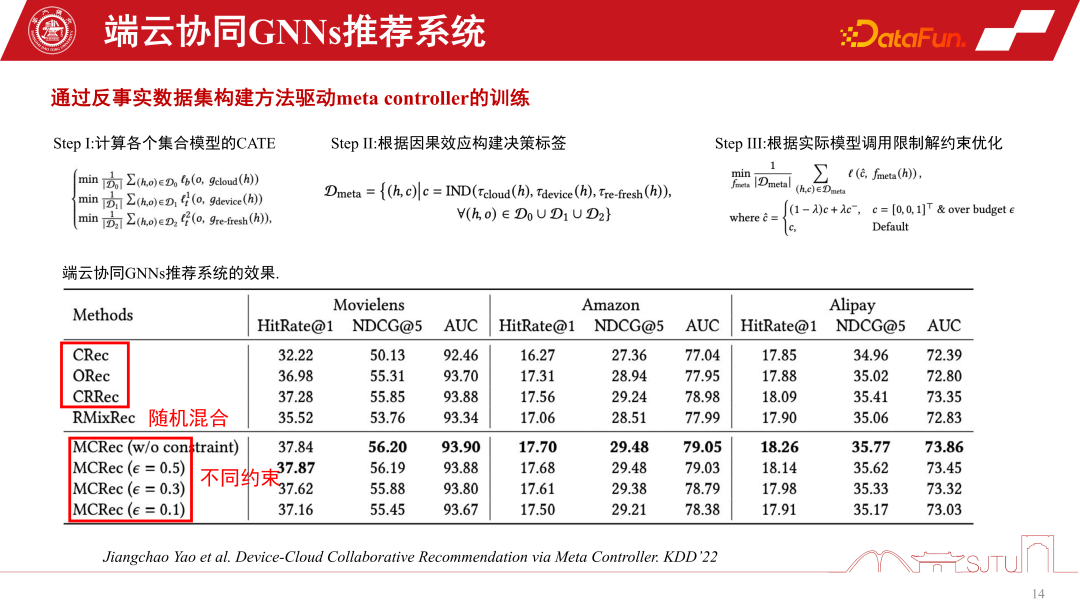

, même si ce type de recherche ne se produit pas. le goulot d'étranglement rencontrera dans la pratique le problème des modèles terminaux obsolètes. À mesure que le domaine change, les données changent, le modèle n'est plus applicable et les performances diminuent. À l’heure actuelle, la personnalisation en ligne du modèle GNN est nécessaire, mais la personnalisation finale sera confrontée au défi de la puissance de calcul et de la surcharge de stockage.Un autre défi est la rareté des données. Étant donné que les données finales ne comportent que des nœuds individuels, leur rareté est également un défi de taille. Une approche relativement efficace dans les recherches récentes est le transfert efficace des paramètres, qui consiste à appliquer certains correctifs de modèle entre les couches. Il peut être comparé à un réseau résiduel, mais les correctifs sont appris au cours de l'apprentissage. Grâce à un mécanisme de drapeau, il peut être allumé lorsqu'il est utilisé et éteint lorsqu'il n'est pas utilisé, il peut être dégradé au modèle de base d'origine, qui est à la fois sûr et efficace. Il s'agit d'une approche plus pratique et efficace, publiée sur KDD2021, qui permet de réaliser une personnalisation en ligne des modèles GNN. La chose la plus importante est que nous avons découvert grâce à une telle pratique qu'en détectant les informations du sous-graphe de ce modèle local, les performances globales peuvent effectivement être améliorées de manière constante. Cela atténue également l’effet Matthieu. Dans les systèmes de recommandation, les utilisateurs tail sont toujours confrontés au problème de l'effet Matthew sur les données graphiques. Cependant, si nous adoptons une approche de modélisation diviser pour régner et personnalisons les sous-graphiques, nous pouvons améliorer l'expérience de recommandation pour les utilisateurs ayant des comportements clairsemés. Surtout pour la foule de queue, l'amélioration des performances sera plus significative Dans le système de recommandation GNN, l'un est le modèle GNN de service côté cloud Il existe également un petit modèle de GNN côté extrémité. Il existe trois formes de mise en œuvre des services du système de recommandation GNN. La première est la recommandation de session, qui est une recommandation de session par lots courante dans les systèmes de recommandation pour réduire les coûts. Autrement dit, les recommandations par lots sont faites en même temps et obligent les utilisateurs à parcourir de nombreux produits avant. la recommandation sera à nouveau déclenchée. La seconde consiste à n’en recommander qu’un à la fois dans les cas extrêmes. Le troisième type est le modèle personnalisé de bout en bout que nous avons mentionné. Chacune de ces trois méthodes de système de recommandation a ses propres avantages. Lorsque les intérêts des utilisateurs changent lentement, nous n'avons besoin que du côté cloud pour le percevoir avec précision, il suffit donc du modèle côté cloud pour faire des recommandations de session. Lorsque les intérêts des utilisateurs changent de plus en plus diversement, la recommandation personnalisée des sous-graphiques de fin peut relativement améliorer les performances de recommandation. Dans les situations où le comportement des utilisateurs devient soudainement très clairsemé, les recommandations s'appuient davantage sur un raisonnement de bon sens. Afin de coordonner ces trois comportements de recommandation, un méta-coordinateur - Meta Controller peut être créé pour coordonner le système de recommandation des GNN. l’ensemble de données, car nous ne savons pas comment gérer ces modèles et comment prendre des décisions. Il ne s’agit donc que d’un mécanisme de raisonnement contrefactuel. Bien que nous ne disposions pas d’un tel ensemble de données, nous disposons d’un ensemble de données à canal unique et nous construisons des modèles proxy par évaluation pour évaluer leurs effets causals. Si l’effet causal est relativement important, alors les avantages d’une telle décision seront relativement importants et des pseudo-étiquettes, c’est-à-dire des ensembles de données contrefactuelles, pourront être construites. Les étapes spécifiques sont les suivantes : Il existe trois modèles D0, D1 et D2 dans un seul canal en apprenant le modèle causal d'un agent, en estimant ses effets causals pour construire une étiquette de décision et en construisant un contrefactuel. ensemble de données pour former l’élément Coordinateur. Enfin, nous pouvons prouver que ce méta-coordinateur présente une amélioration stable des performances par rapport à chaque modèle monocanal. Elle présente des avantages significatifs par rapport aux heuristiques aléatoires. Nous pouvons ainsi construire un système de recommandation pour la collaboration appareil-cloud. 4. Problèmes de sécurité du système de recommandation GNN côté appareil Enfin, discutons des problèmes de sécurité du système de recommandation GNN côté appareil. Une fois que le système de recommandation GNN collaboratif appareil-cloud sera ouvert à l’utilisation, il sera inévitablement confronté à des problèmes dans l’environnement ouvert. Étant donné que le modèle doit être personnalisé pour l'apprentissage, il y aura certains risques d'attaques, telles que des attaques d'évasion, des attaques d'empoisonnement, des attaques de porte dérobée, etc., qui peuvent finalement exposer le système de recommandation à d'énormes risques de sécurité Pilote de puissance de calcul sous-jacent Il a indiqué l'orientation du système de recommandation GNN collaboratif dans le cloud actuel, mais il en est encore aux premiers stades de développement et présente des problèmes potentiels, tels que des problèmes de sécurité. il reste encore beaucoup à faire dans le domaine de la modélisation de modèles personnalisés. A1 : La sous-image n'est pas distribuée, elle est en réalité agrégée. Le premier point est que les sous-images sont distribuées de manière accompagnante. Par exemple, lorsque nous recommandons un produit, il contiendra naturellement les informations d'attribut du produit. Ici, l'émission qui l'accompagne présente le même niveau de frais généraux que les attributs. En fait, les frais généraux ne sont pas très élevés. Parce qu'il ne fournit pas une vue d'ensemble complète, mais seulement quelques sous-graphes voisins, tout au plus, les sous-graphes voisins de second ordre sont encore très petits. Le deuxième point est que certains sous-graphiques à la fin sont automatiquement construits sur la base d'une certaine cooccurrence et de clics basés sur les commentaires du comportement de l'utilisateur. Il s'agit donc d'une forme d'agrégation à double extrémité et le coût global n'est pas particulièrement important.

3. Mise en œuvre d'un système de recommandation GNN collaboratif appareil-cloud

5. Séance de questions et réponses

Q1 : Lors de la construction d'un modèle de graphique à la fin, le trafic des sous-graphes sera-t-il trop réparti ?

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Que dois-je faire si le fichier chm ne peut pas être ouvert ?

Que dois-je faire si le fichier chm ne peut pas être ouvert ?

Étapes WeChat

Étapes WeChat

Utilisation de base de FTP

Utilisation de base de FTP

ps supprimer la zone sélectionnée

ps supprimer la zone sélectionnée

Tri des tableaux JS : méthode sort()

Tri des tableaux JS : méthode sort()

Que signifie l'URL ?

Que signifie l'URL ?

Comment définir la transparence de la couleur de la police HTML

Comment définir la transparence de la couleur de la police HTML

Méthode d'ouverture de l'autorisation de portée

Méthode d'ouverture de l'autorisation de portée

exigences de configuration matérielle du serveur Web

exigences de configuration matérielle du serveur Web