Périphériques technologiques

Périphériques technologiques

IA

IA

Problème d'estimation de la pose humaine en vision par ordinateur

Problème d'estimation de la pose humaine en vision par ordinateur

Problème d'estimation de la pose humaine en vision par ordinateur

Le problème de l'estimation de la pose humaine en vision par ordinateur nécessite des exemples de code spécifiques

L'estimation de la pose humaine est une direction de recherche importante dans le domaine de la vision par ordinateur. Son objectif est d'obtenir avec précision les informations de pose du corps humain, y compris les articulations. positions, à partir d'images ou de vidéos, angle d'articulation, etc. L'estimation de la pose humaine a de nombreuses applications dans de nombreux domaines d'application, tels que la capture de mouvement, l'interaction homme-machine, la réalité virtuelle, etc. Cet article présentera les principes de base de l'estimation de la pose humaine et fournira des exemples de code spécifiques.

Le principe de base de l'estimation de la posture humaine est de déduire la posture du corps humain en analysant les points clés du corps humain dans l'image (tels que la tête, les épaules, les mains, les pieds, etc.). Pour atteindre cet objectif, nous pouvons utiliser des modèles d'apprentissage profond tels que le réseau de neurones convolutifs (CNN) ou le réseau de neurones récurrents (RNN).

Ce qui suit est un exemple de code qui utilise la bibliothèque open source OpenPose pour implémenter l'estimation de la pose humaine :

import cv2

import numpy as np

from openpose import OpenPose

# 加载OpenPose模型

openpose = OpenPose("path/to/openpose/models")

# 加载图像

image = cv2.imread("path/to/image.jpg")

# 运行OpenPose模型

poses = openpose.detect(image)

# 显示姿态估计结果

for pose in poses:

# 绘制骨骼连接

image = openpose.draw_skeleton(image, pose)

# 绘制关节点

image = openpose.draw_keypoints(image, pose)

# 显示图像

cv2.imshow("Pose Estimation", image)

cv2.waitKey(0)

cv2.destroyAllWindows()Dans l'exemple de code ci-dessus, nous importons d'abord les bibliothèques nécessaires, puis chargeons le modèle OpenPose et chargeons l'image à estimer. Ensuite, nous exécutons le modèle OpenPose pour détecter les poses, et le résultat renvoyé est une liste contenant plusieurs poses. Enfin, nous utilisons la fonction de dessin fournie par OpenPose pour dessiner les résultats de l'estimation de pose et afficher l'image.

Il convient de noter que l'exemple de code ci-dessus est uniquement à des fins de démonstration. En fait, réaliser une estimation de la posture humaine nécessite des processus de pré-traitement, de post-traitement et d'ajustement des paramètres plus complexes. De plus, OpenPose est une bibliothèque open source qui offre plus de fonctionnalités et d'options aux utilisateurs.

En bref, l'estimation de la pose humaine est un problème important dans le domaine de la vision par ordinateur, qui déduit la pose du corps humain en analysant les points clés de l'image. Cet article fournit un exemple de code pour implémenter l'estimation de la posture humaine à l'aide de la bibliothèque open source OpenPose. Les lecteurs peuvent mener une recherche et un développement plus approfondis en fonction de leurs propres besoins.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

1393

1393

52

52

1207

1207

24

24

Au-delà d'ORB-SLAM3 ! SL-SLAM : les scènes de faible luminosité, de gigue importante et de texture faible sont toutes gérées

May 30, 2024 am 09:35 AM

Au-delà d'ORB-SLAM3 ! SL-SLAM : les scènes de faible luminosité, de gigue importante et de texture faible sont toutes gérées

May 30, 2024 am 09:35 AM

Écrit précédemment, nous discutons aujourd'hui de la manière dont la technologie d'apprentissage profond peut améliorer les performances du SLAM (localisation et cartographie simultanées) basé sur la vision dans des environnements complexes. En combinant des méthodes d'extraction de caractéristiques approfondies et de correspondance de profondeur, nous introduisons ici un système SLAM visuel hybride polyvalent conçu pour améliorer l'adaptation dans des scénarios difficiles tels que des conditions de faible luminosité, un éclairage dynamique, des zones faiblement texturées et une gigue importante. Notre système prend en charge plusieurs modes, notamment les configurations étendues monoculaire, stéréo, monoculaire-inertielle et stéréo-inertielle. En outre, il analyse également comment combiner le SLAM visuel avec des méthodes d’apprentissage profond pour inspirer d’autres recherches. Grâce à des expériences approfondies sur des ensembles de données publiques et des données auto-échantillonnées, nous démontrons la supériorité du SL-SLAM en termes de précision de positionnement et de robustesse du suivi.

Qu'est-ce que le NeRF ? La reconstruction 3D basée sur NeRF est-elle basée sur des voxels ?

Oct 16, 2023 am 11:33 AM

Qu'est-ce que le NeRF ? La reconstruction 3D basée sur NeRF est-elle basée sur des voxels ?

Oct 16, 2023 am 11:33 AM

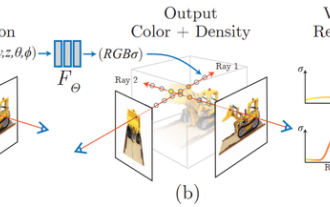

1 Introduction Les champs de rayonnement neuronal (NeRF) constituent un paradigme relativement nouveau dans le domaine de l'apprentissage profond et de la vision par ordinateur. Cette technologie a été introduite dans l'article ECCV2020 « NeRF : Representing Scenes as Neural Radiation Fields for View Synthesis » (qui a remporté le prix du meilleur article) et est depuis devenue extrêmement populaire, avec près de 800 citations à ce jour [1 ]. Cette approche marque un changement radical dans la manière traditionnelle dont l’apprentissage automatique traite les données 3D. Représentation de la scène du champ de rayonnement neuronal et processus de rendu différenciable : compositer des images en échantillonnant des coordonnées 5D (position et direction de visualisation) le long des rayons de la caméra ; introduire ces positions dans un MLP pour produire des densités de couleur et volumétriques et composer ces valeurs à l'aide de techniques de rendu volumétrique ; ; la fonction de rendu est différentiable, elle peut donc être transmise

La première reconstruction purement visuelle et statique de la conduite autonome

Jun 02, 2024 pm 03:24 PM

La première reconstruction purement visuelle et statique de la conduite autonome

Jun 02, 2024 pm 03:24 PM

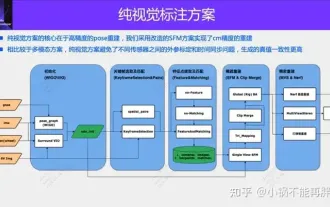

Une solution d'annotation purement visuelle utilise principalement la vision ainsi que certaines données du GPS, de l'IMU et des capteurs de vitesse de roue pour l'annotation dynamique. Bien entendu, pour les scénarios de production de masse, il n’est pas nécessaire qu’il s’agisse d’une vision pure. Certains véhicules produits en série seront équipés de capteurs comme le radar à semi-conducteurs (AT128). Si nous créons une boucle fermée de données dans la perspective d'une production de masse et utilisons tous ces capteurs, nous pouvons résoudre efficacement le problème de l'étiquetage des objets dynamiques. Mais notre plan ne prévoit pas de radar à semi-conducteurs. Par conséquent, nous présenterons cette solution d’étiquetage de production de masse la plus courante. Le cœur d’une solution d’annotation purement visuelle réside dans la reconstruction de pose de haute précision. Nous utilisons le schéma de reconstruction de pose de Structure from Motion (SFM) pour garantir la précision de la reconstruction. Mais passe

Le repérage des nuages de points est incontournable pour la vision 3D ! Comprendre toutes les solutions et défis courants dans un seul article

Apr 02, 2024 am 11:31 AM

Le repérage des nuages de points est incontournable pour la vision 3D ! Comprendre toutes les solutions et défis courants dans un seul article

Apr 02, 2024 am 11:31 AM

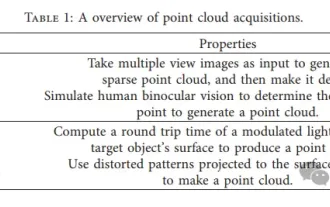

Le nuage de points, en tant qu'ensemble de points, devrait entraîner un changement dans l'acquisition et la génération d'informations de surface tridimensionnelles (3D) sur des objets grâce à la reconstruction 3D, à l'inspection industrielle et au fonctionnement de robots. Le processus le plus difficile mais essentiel est l'enregistrement des nuages de points, c'est-à-dire l'obtention d'une transformation spatiale qui aligne et fait correspondre deux nuages de points obtenus dans deux coordonnées différentes. Cette revue présente un aperçu et les principes de base de l'enregistrement des nuages de points, classe et compare systématiquement diverses méthodes et résout les problèmes techniques existant dans l'enregistrement des nuages de points, en essayant de fournir aux chercheurs universitaires en dehors du domaine et aux ingénieurs des conseils et faciliter les discussions sur une vision unifiée. pour l'enregistrement des nuages de points. La méthode générale d'acquisition de nuages de points est divisée en méthodes actives et passives. Le nuage de points acquis activement par le capteur est la méthode active, et le nuage de points est reconstruit ultérieurement.

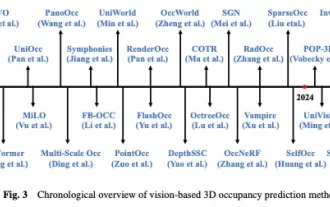

Jetez un œil au passé et au présent de l'Occ et de la conduite autonome ! La première revue résume de manière exhaustive les trois thèmes majeurs de l'amélioration des fonctionnalités/déploiement en production de masse/annotation efficace.

May 08, 2024 am 11:40 AM

Jetez un œil au passé et au présent de l'Occ et de la conduite autonome ! La première revue résume de manière exhaustive les trois thèmes majeurs de l'amélioration des fonctionnalités/déploiement en production de masse/annotation efficace.

May 08, 2024 am 11:40 AM

Écrit ci-dessus et compréhension personnelle de l'auteur Ces dernières années, la conduite autonome a reçu une attention croissante en raison de son potentiel à réduire la charge du conducteur et à améliorer la sécurité de conduite. La prédiction d'occupation tridimensionnelle basée sur la vision est une tâche de perception émergente adaptée à une enquête rentable et complète sur la sécurité de la conduite autonome. Bien que de nombreuses études aient démontré la supériorité des outils de prédiction d’occupation 3D par rapport aux tâches de perception centrée sur les objets, il existe encore des revues dédiées à ce domaine en développement rapide. Cet article présente d'abord le contexte de la prédiction d'occupation 3D basée sur la vision et discute des défis rencontrés dans cette tâche. Ensuite, nous discutons de manière approfondie de l'état actuel et des tendances de développement des méthodes actuelles de prévision d'occupation 3D sous trois aspects : l'amélioration des fonctionnalités, la convivialité du déploiement et l'efficacité de l'étiquetage. enfin

Vous pouvez jouer simplement en bougeant votre bouche ! Utilisez l'IA pour changer de personnage et attaquer les ennemis : 'Ayaka, utilisez Kamiri-ryu Frost Destruction'

May 13, 2023 pm 07:52 PM

Vous pouvez jouer simplement en bougeant votre bouche ! Utilisez l'IA pour changer de personnage et attaquer les ennemis : 'Ayaka, utilisez Kamiri-ryu Frost Destruction'

May 13, 2023 pm 07:52 PM

En ce qui concerne les jeux nationaux devenus populaires dans le monde entier au cours des deux dernières années, Genshin Impact remporte définitivement la palme. Selon le rapport d'enquête sur les revenus des jeux mobiles du premier trimestre de cette année publié en mai, "Genshin Impact" a fermement remporté la première place parmi les jeux mobiles de tirage de cartes avec un avantage absolu de 567 millions de dollars américains. Cela a également annoncé que "Genshin Impact" a été. en ligne en seulement 18 ans. Quelques mois plus tard, les revenus totaux de la seule plateforme mobile dépassaient les 3 milliards de dollars américains (environ 13 milliards de RM). Désormais, la dernière version 2.8 de l'île avant l'ouverture de Xumi est attendue depuis longtemps. Après une longue période de draft, il y a enfin de nouvelles intrigues et zones à jouer. Mais je ne sais pas combien il y a d’« Empereurs du Foie ». Maintenant que l’île a été entièrement explorée, l’herbe a recommencé à pousser. Il y a un total de 182 coffres au trésor + 1 boîte Mora (non incluse). Il n'y a pas lieu de s'inquiéter de la période des herbes longues. La zone Genshin Impact ne manque jamais de travail. Non, pendant les hautes herbes

AAAI2024 : Far3D - Idée innovante pour atteindre directement la détection visuelle de cibles 3D à 150 m

Dec 15, 2023 pm 01:54 PM

AAAI2024 : Far3D - Idée innovante pour atteindre directement la détection visuelle de cibles 3D à 150 m

Dec 15, 2023 pm 01:54 PM

Récemment, j'ai lu une dernière recherche sur la perception visuelle pure de l'environnement sur Arxiv. Cette recherche est basée sur la série de méthodes PETR et se concentre sur la résolution du problème de perception visuelle pure de la détection de cibles à longue distance, étendant la plage de perception à 150 mètres. Les méthodes et les résultats de cet article ont une grande valeur de référence pour nous, j'ai donc essayé de l'interpréter Titre original : Far3D : Expanding the Horizon for Surround-view3DObject Detection Lien de l'article : https://arxiv.org/abs/2308.09616 Affiliation de l'auteur. :Institut de technologie de Pékin et tâche technologique Megvii Contexte Détection d'objets 3D pour comprendre la conduite autonome

Yan Shuicheng a pris les commandes et a établi la forme ultime du « grand modèle visuel multimodal universel » ! Compréhension/génération/segmentation/édition unifiée

Apr 25, 2024 pm 08:04 PM

Yan Shuicheng a pris les commandes et a établi la forme ultime du « grand modèle visuel multimodal universel » ! Compréhension/génération/segmentation/édition unifiée

Apr 25, 2024 pm 08:04 PM

Récemment, l'équipe du professeur Yan Shuicheng a publié conjointement et open source le grand modèle de langage visuel multimodal universel au niveau des pixels de Vitron. Page d'accueil du projet et démo : https://vitron-llm.github.io/ Lien papier : https://is.gd/aGu0VV Code open source : https://github.com/SkyworkAI/Vitron Il s'agit d'un outil robuste vision générale Le grand modèle multimodal prend en charge une série de tâches visuelles allant de la compréhension visuelle à la génération visuelle, du niveau bas au niveau élevé. Il résout le problème de séparation des modèles image/vidéo qui tourmente depuis longtemps l'industrie des modèles de langage à grande échelle. et fournit une image statique unifiée complète. Comprendre, générer, segmenter et éditer du contenu vidéo dynamique.