Périphériques technologiques

Périphériques technologiques

IA

IA

Problèmes de conception de récompense dans l'apprentissage par renforcement

Problèmes de conception de récompense dans l'apprentissage par renforcement

Problèmes de conception de récompense dans l'apprentissage par renforcement

Les problèmes de conception de récompenses dans l'apprentissage par renforcement nécessitent des exemples de code spécifiques

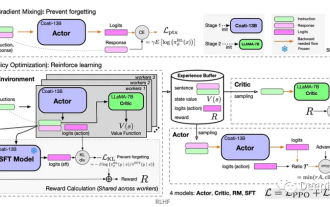

L'apprentissage par renforcement est une méthode d'apprentissage automatique dont l'objectif est d'apprendre à prendre des mesures qui maximisent les récompenses cumulées grâce à l'interaction avec l'environnement. Dans l’apprentissage par renforcement, la récompense joue un rôle crucial. Elle constitue un signal dans le processus d’apprentissage de l’agent et sert à guider son comportement. Cependant, la conception des récompenses est un problème difficile, et une conception raisonnable des récompenses peut grandement affecter les performances des algorithmes d’apprentissage par renforcement.

Dans l'apprentissage par renforcement, les récompenses peuvent être considérées comme un pont de communication entre l'agent et l'environnement, qui peut indiquer à l'agent si l'action en cours est bonne ou mauvaise. De manière générale, les récompenses peuvent être divisées en deux types : les récompenses clairsemées et les récompenses denses. Les récompenses clairsemées font référence à des récompenses accordées à quelques moments précis de la tâche, tandis que les récompenses denses ont des signaux de récompense à chaque instant. Les récompenses denses permettent à l'agent d'apprendre plus facilement la bonne stratégie d'action que les récompenses rares, car elles fournissent plus d'informations en retour. Cependant, les récompenses rares sont plus courantes dans les tâches du monde réel, ce qui pose des défis dans la conception des récompenses.

L'objectif de la conception des récompenses est de fournir à l'agent le signal de retour le plus précis possible afin qu'il puisse apprendre la meilleure stratégie rapidement et efficacement. Dans la plupart des cas, nous souhaitons une fonction de récompense qui donne une récompense élevée lorsque l’agent atteint un objectif prédéterminé, et une faible récompense ou pénalité lorsque l’agent prend une mauvaise décision. Cependant, concevoir une fonction de récompense raisonnable n’est pas une tâche facile.

Pour résoudre le problème de conception des récompenses, une approche courante consiste à utiliser des démonstrations basées sur des experts humains pour guider l’apprentissage de l’agent. Dans ce cas, l’expert humain fournit à l’agent une série d’échantillons de séquences d’actions et leurs récompenses. L’agent apprend de ces échantillons pour se familiariser avec la tâche et améliore progressivement sa stratégie lors des interactions ultérieures. Cette méthode peut résoudre efficacement le problème de conception des récompenses, mais elle augmente également les coûts de main-d'œuvre et l'échantillon de l'expert peut ne pas être tout à fait correct.

Une autre approche consiste à utiliser l'apprentissage par renforcement inverse (Inverse Reinforcement Learning) pour résoudre le problème de conception des récompenses. L'apprentissage par renforcement inverse est une méthode permettant de dériver une fonction de récompense à partir du comportement observé. Elle suppose que l'agent tente de maximiser une fonction de récompense potentielle au cours du processus d'apprentissage. En dérivant inversement cette fonction de récompense potentielle à partir du comportement observé, les agents peuvent recevoir davantage. des signaux de récompense précis. L'idée centrale de l'apprentissage par renforcement inverse est d'interpréter le comportement observé comme une stratégie optimale et de guider l'apprentissage de l'agent en déduisant la fonction de récompense correspondant à cette stratégie optimale.

Ce qui suit est un exemple de code simple d'apprentissage par renforcement inverse, démontrant comment déduire la fonction de récompense à partir du comportement observé :

import numpy as np

def inverse_reinforcement_learning(expert_trajectories):

# 计算状态特征向量的均值

feature_mean = np.mean(expert_trajectories, axis=0)

# 构建状态特征矩阵

feature_matrix = np.zeros((len(expert_trajectories), len(feature_mean)))

for i in range(len(expert_trajectories)):

feature_matrix[i] = expert_trajectories[i] - feature_mean

# 使用最小二乘法求解奖励函数的权重向量

weights = np.linalg.lstsq(feature_matrix, np.ones((len(expert_trajectories),)))[0]

return weights

# 生成示例轨迹数据

expert_trajectories = np.array([[1, 1], [1, 2], [2, 1], [2, 2]])

# 使用逆强化学习得到奖励函数的权重向量

weights = inverse_reinforcement_learning(expert_trajectories)

print("奖励函数的权重向量:", weights)Le code ci-dessus utilise la méthode des moindres carrés pour résoudre le vecteur de poids de la fonction de récompense. peut être utilisé pour calculer la récompense de n’importe quel vecteur de caractéristiques d’état. Grâce à l'apprentissage par renforcement inverse, une fonction de récompense raisonnable peut être apprise à partir d'échantillons de données pour guider le processus d'apprentissage de l'agent.

En résumé, la conception des récompenses est une question importante et difficile dans l'apprentissage par renforcement. Une conception raisonnable des récompenses peut grandement affecter les performances des algorithmes d’apprentissage par renforcement. En tirant parti de méthodes telles que les démonstrations basées sur des experts humains ou l’apprentissage par renforcement inverse, le problème de conception des récompenses peut être résolu et l’agent peut recevoir des signaux de récompense précis pour guider son processus d’apprentissage.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Problèmes de conception des fonctions de récompense dans l'apprentissage par renforcement

Oct 09, 2023 am 11:58 AM

Problèmes de conception des fonctions de récompense dans l'apprentissage par renforcement

Oct 09, 2023 am 11:58 AM

Problèmes de conception de fonctions de récompense dans l'apprentissage par renforcement Introduction L'apprentissage par renforcement est une méthode qui apprend des stratégies optimales grâce à l'interaction entre un agent et l'environnement. Dans l’apprentissage par renforcement, la conception de la fonction de récompense est cruciale pour l’effet d’apprentissage de l’agent. Cet article explorera les problèmes de conception des fonctions de récompense dans l'apprentissage par renforcement et fournira des exemples de code spécifiques. Le rôle de la fonction de récompense et de la fonction de récompense cible constituent une partie importante de l'apprentissage par renforcement et sont utilisés pour évaluer la valeur de récompense obtenue par l'agent dans un certain état. Sa conception aide à guider l'agent pour maximiser la fatigue à long terme en choisissant les actions optimales.

Apprentissage par renforcement Deep Q-learning utilisant la simulation de bras robotique de Panda-Gym

Oct 31, 2023 pm 05:57 PM

Apprentissage par renforcement Deep Q-learning utilisant la simulation de bras robotique de Panda-Gym

Oct 31, 2023 pm 05:57 PM

L'apprentissage par renforcement (RL) est une méthode d'apprentissage automatique qui permet à un agent d'apprendre comment se comporter dans son environnement par essais et erreurs. Les agents sont récompensés ou punis pour avoir pris des mesures qui conduisent aux résultats souhaités. Au fil du temps, l'agent apprend à prendre des mesures qui maximisent la récompense attendue. Les agents RL sont généralement formés à l'aide d'un processus de décision markovien (MDP), un cadre mathématique pour modéliser des problèmes de décision séquentielle. Le MDP se compose de quatre parties : État : un ensemble d'états possibles de l'environnement. Action : un ensemble d'actions qu'un agent peut entreprendre. Fonction de transition : fonction qui prédit la probabilité de transition vers un nouvel état en fonction de l'état et de l'action actuels. Fonction de récompense : fonction qui attribue une récompense à l'agent pour chaque conversion. L'objectif de l'agent est d'apprendre une fonction politique,

Technologie d'apprentissage par renforcement profond en C++

Aug 21, 2023 pm 11:33 PM

Technologie d'apprentissage par renforcement profond en C++

Aug 21, 2023 pm 11:33 PM

La technologie d'apprentissage par renforcement profond est une branche de l'intelligence artificielle qui a beaucoup retenu l'attention. Elle a remporté de nombreux concours internationaux et est également largement utilisée dans les assistants personnels, la conduite autonome, l'intelligence des jeux et d'autres domaines. Dans le processus de réalisation d’un apprentissage par renforcement profond, le C++, en tant que langage de programmation efficace et excellent, est particulièrement important lorsque les ressources matérielles sont limitées. L’apprentissage par renforcement profond, comme son nom l’indique, combine les technologies des deux domaines de l’apprentissage profond et de l’apprentissage par renforcement. Pour comprendre simplement, l'apprentissage profond fait référence à l'apprentissage de fonctionnalités à partir de données et à la prise de décisions en créant un réseau neuronal multicouche.

Résoudre le problème « erreur : redéfinition de la classe 'ClassName' » qui apparaît dans le code C++

Aug 25, 2023 pm 06:01 PM

Résoudre le problème « erreur : redéfinition de la classe 'ClassName' » qui apparaît dans le code C++

Aug 25, 2023 pm 06:01 PM

Résolvez le problème « erreur : redéfinition de la classe 'ClassName » dans le code C++. Dans la programmation C++, nous rencontrons souvent diverses erreurs de compilation. L'une des erreurs courantes est "error: redefinitionofclass 'ClassName'" (erreur de redéfinition de la classe 'ClassName'). Cette erreur se produit généralement lorsque la même classe est définie plusieurs fois. Cet article sera

Problèmes d'évaluation de l'effet de clustering dans les algorithmes de clustering

Oct 10, 2023 pm 01:12 PM

Problèmes d'évaluation de l'effet de clustering dans les algorithmes de clustering

Oct 10, 2023 pm 01:12 PM

Le problème d'évaluation de l'effet de clustering dans l'algorithme de clustering nécessite des exemples de code spécifiques. Le clustering est une méthode d'apprentissage non supervisée qui regroupe des échantillons similaires dans une seule catégorie en regroupant les données. Dans les algorithmes de clustering, la manière d’évaluer l’effet du clustering est une question importante. Cet article présentera plusieurs indicateurs d'évaluation de l'effet de clustering couramment utilisés et donnera des exemples de code correspondants. 1. Indice d'évaluation de l'effet de clustering Coefficient Silhouette Le coefficient Silhouette évalue l'effet de clustering en calculant la proximité de l'échantillon et le degré de séparation des autres clusters.

Apprenez à diagnostiquer les problèmes courants de l'iPhone

Dec 03, 2023 am 08:15 AM

Apprenez à diagnostiquer les problèmes courants de l'iPhone

Dec 03, 2023 am 08:15 AM

Connu pour ses performances puissantes et ses fonctionnalités polyvalentes, l’iPhone n’est pas à l’abri de contretemps ou de difficultés techniques occasionnelles, un trait commun aux appareils électroniques complexes. Rencontrer des problèmes avec votre iPhone peut être frustrant, mais aucune alarme n'est généralement nécessaire. Dans ce guide complet, nous visons à démystifier certains des défis les plus fréquemment rencontrés associés à l’utilisation de l’iPhone. Notre approche étape par étape est conçue pour vous aider à résoudre ces problèmes courants, en vous proposant des solutions pratiques et des conseils de dépannage pour remettre votre équipement en parfait état de fonctionnement. Que vous soyez confronté à un problème ou à un problème plus complexe, cet article peut vous aider à les résoudre efficacement. Conseils de dépannage généraux Avant de passer aux étapes de dépannage spécifiques, voici quelques conseils utiles

Comment résoudre le problème selon lequel jQuery ne peut pas obtenir la valeur de l'élément de formulaire

Feb 19, 2024 pm 02:01 PM

Comment résoudre le problème selon lequel jQuery ne peut pas obtenir la valeur de l'élément de formulaire

Feb 19, 2024 pm 02:01 PM

Pour résoudre le problème selon lequel jQuery.val() ne peut pas être utilisé, des exemples de code spécifiques sont requis. Pour les développeurs front-end, l'utilisation de jQuery est l'une des opérations courantes. Parmi eux, utiliser la méthode .val() pour obtenir ou définir la valeur d'un élément de formulaire est une opération très courante. Cependant, dans certains cas précis, le problème de ne pas pouvoir utiliser la méthode .val() peut se poser. Cet article présentera quelques situations et solutions courantes, et fournira des exemples de code spécifiques. Description du problème Lorsque vous utilisez jQuery pour développer des pages frontales, vous rencontrerez parfois

Résoudre l'erreur PHP : problèmes rencontrés lors de l'héritage de la classe parent

Aug 17, 2023 pm 01:33 PM

Résoudre l'erreur PHP : problèmes rencontrés lors de l'héritage de la classe parent

Aug 17, 2023 pm 01:33 PM

Résolution des erreurs PHP : problèmes rencontrés lors de l'héritage des classes parentes En PHP, l'héritage est une fonctionnalité importante de la programmation orientée objet. Grâce à l'héritage, nous pouvons réutiliser le code existant, l'étendre et l'améliorer sans modifier le code d'origine. Bien que l'héritage soit largement utilisé dans le développement, vous pouvez parfois rencontrer des problèmes d'erreur lors de l'héritage d'une classe parent. Cet article se concentrera sur la résolution des problèmes courants rencontrés lors de l'héritage d'une classe parent et fournira des exemples de code correspondants. Question 1 : la classe parent est introuvable pendant le processus d'héritage de la classe parent, si le système ne le fait pas.