Périphériques technologiques

Périphériques technologiques

IA

IA

Problèmes de conception des fonctions de récompense dans l'apprentissage par renforcement

Problèmes de conception des fonctions de récompense dans l'apprentissage par renforcement

Problèmes de conception des fonctions de récompense dans l'apprentissage par renforcement

Problème de conception de fonction de récompense dans l'apprentissage par renforcement

Introduction

L'apprentissage par renforcement est une méthode d'apprentissage de stratégies optimales grâce à l'interaction entre un agent et l'environnement. Dans l’apprentissage par renforcement, la conception de la fonction de récompense est cruciale pour l’effet d’apprentissage de l’agent. Cet article explorera les problèmes de conception des fonctions de récompense dans l'apprentissage par renforcement et fournira des exemples de code spécifiques.

- Le rôle et l'objectif de la fonction de récompense

La fonction de récompense est une partie importante de l'apprentissage par renforcement et est utilisée pour évaluer la valeur de récompense obtenue par l'agent dans un certain état. Sa conception aide l'agent à maximiser les récompenses cumulées à long terme en choisissant les actions optimales.

Une bonne fonction de récompense doit avoir les deux objectifs suivants :

(1) Fournir suffisamment d'informations pour permettre à l'agent d'apprendre la stratégie optimale ;

(2) Guider l'agent pour éviter les actions inefficaces et nuisibles grâce à un comportement de rétroaction de récompense approprié.

- Défis dans la conception de la fonction de récompense

La conception de la fonction de récompense peut être confrontée aux défis suivants :

(1) La rareté : dans certains cas, le signal de récompense de l'environnement peut être clairsemé, ce qui rend le processus d'apprentissage lent ou instable.

(2) Trompeur : des signaux de récompense incorrects ou insuffisants peuvent amener l'agent à apprendre la mauvaise stratégie.

(3) Haute dimensionnalité : Dans des environnements complexes avec un grand nombre d'états et d'actions, il devient plus difficile de concevoir des fonctions de récompense.

(4) Conflit d'objectifs : différents objectifs peuvent entraîner des conflits dans la conception de la fonction de récompense, comme l'équilibre entre les objectifs à court terme et à long terme. - Méthodes de conception de fonctions de récompense

Pour surmonter les défis liés à la conception de fonctions de récompense, les méthodes suivantes peuvent être utilisées :

(1) Conception manuelle : Concevez manuellement la fonction de récompense en fonction des connaissances et de l'expérience préalables. Cette approche fonctionne généralement pour des problèmes simples mais peut s'avérer difficile pour des problèmes complexes.

(2) Ingénierie des récompenses : Améliorer les performances de la fonction de récompense en introduisant des récompenses ou des pénalités auxiliaires. Par exemple, des récompenses ou des pénalités supplémentaires peuvent être appliquées à certains états ou actions pour mieux guider l’apprentissage des agents.

(3) Fonction de récompense adaptative : utilisez un algorithme adaptatif pour ajuster dynamiquement la fonction de récompense. Cette méthode peut modifier le poids de la fonction de récompense au fil du temps pour s'adapter aux besoins d'apprentissage des différentes étapes.

- Exemples de code spécifiques

Ce qui suit est un exemple de code utilisant le cadre d'apprentissage par renforcement profond TensorFlow et Keras, montrant comment la fonction de récompense est conçue :

import numpy as np

from tensorflow import keras

# 定义强化学习智能体的奖励函数

def reward_function(state, action):

# 根据当前状态和动作计算奖励值

reward = 0

# 添加奖励和惩罚条件

if state == 0 and action == 0:

reward += 1

elif state == 1 and action == 1:

reward -= 1

return reward

# 定义强化学习智能体的神经网络模型

def create_model():

model = keras.Sequential([

keras.layers.Dense(64, activation='relu', input_shape=(2,)),

keras.layers.Dense(64, activation='relu'),

keras.layers.Dense(1)

])

model.compile(optimizer='adam', loss='mean_squared_error')

return model

# 训练智能体

def train_agent():

model = create_model()

# 智能体的训练过程

for episode in range(num_episodes):

state = initial_state

# 智能体根据当前策略选择动作

action = model.predict(state)

# 获得当前状态下的奖励值

reward = reward_function(state, action)

# 更新模型的权重

model.fit(state, reward)Dans le code ci-dessus, nous concevons la fonction de récompense en définissant la fonction récompense_fonction. , dans Lors de la formation d'un agent, la valeur de la récompense est calculée en fonction de l'état et des actions actuels. Dans le même temps, nous utilisons la fonction create_model pour créer un modèle de réseau neuronal pour former l'agent, et utilisons la fonction model.predict pour sélectionner des actions en fonction de la stratégie actuelle.

Conclusion

La conception des fonctions de récompense dans l'apprentissage par renforcement est un problème important et difficile. Une fonction de récompense correctement conçue peut guider efficacement l’agent dans l’apprentissage de la stratégie optimale. En discutant du rôle et des objectifs de la fonction de récompense, des défis de conception et des exemples de code spécifiques, cet article espère fournir aux lecteurs des références et une inspiration pour la conception de fonctions de récompense dans l'apprentissage par renforcement.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Problèmes de conception des fonctions de récompense dans l'apprentissage par renforcement

Oct 09, 2023 am 11:58 AM

Problèmes de conception des fonctions de récompense dans l'apprentissage par renforcement

Oct 09, 2023 am 11:58 AM

Problèmes de conception de fonctions de récompense dans l'apprentissage par renforcement Introduction L'apprentissage par renforcement est une méthode qui apprend des stratégies optimales grâce à l'interaction entre un agent et l'environnement. Dans l’apprentissage par renforcement, la conception de la fonction de récompense est cruciale pour l’effet d’apprentissage de l’agent. Cet article explorera les problèmes de conception des fonctions de récompense dans l'apprentissage par renforcement et fournira des exemples de code spécifiques. Le rôle de la fonction de récompense et de la fonction de récompense cible constituent une partie importante de l'apprentissage par renforcement et sont utilisés pour évaluer la valeur de récompense obtenue par l'agent dans un certain état. Sa conception aide à guider l'agent pour maximiser la fatigue à long terme en choisissant les actions optimales.

Apprentissage par renforcement Deep Q-learning utilisant la simulation de bras robotique de Panda-Gym

Oct 31, 2023 pm 05:57 PM

Apprentissage par renforcement Deep Q-learning utilisant la simulation de bras robotique de Panda-Gym

Oct 31, 2023 pm 05:57 PM

L'apprentissage par renforcement (RL) est une méthode d'apprentissage automatique qui permet à un agent d'apprendre comment se comporter dans son environnement par essais et erreurs. Les agents sont récompensés ou punis pour avoir pris des mesures qui conduisent aux résultats souhaités. Au fil du temps, l'agent apprend à prendre des mesures qui maximisent la récompense attendue. Les agents RL sont généralement formés à l'aide d'un processus de décision markovien (MDP), un cadre mathématique pour modéliser des problèmes de décision séquentielle. Le MDP se compose de quatre parties : État : un ensemble d'états possibles de l'environnement. Action : un ensemble d'actions qu'un agent peut entreprendre. Fonction de transition : fonction qui prédit la probabilité de transition vers un nouvel état en fonction de l'état et de l'action actuels. Fonction de récompense : fonction qui attribue une récompense à l'agent pour chaque conversion. L'objectif de l'agent est d'apprendre une fonction politique,

Technologie d'apprentissage par renforcement profond en C++

Aug 21, 2023 pm 11:33 PM

Technologie d'apprentissage par renforcement profond en C++

Aug 21, 2023 pm 11:33 PM

La technologie d'apprentissage par renforcement profond est une branche de l'intelligence artificielle qui a beaucoup retenu l'attention. Elle a remporté de nombreux concours internationaux et est également largement utilisée dans les assistants personnels, la conduite autonome, l'intelligence des jeux et d'autres domaines. Dans le processus de réalisation d’un apprentissage par renforcement profond, le C++, en tant que langage de programmation efficace et excellent, est particulièrement important lorsque les ressources matérielles sont limitées. L’apprentissage par renforcement profond, comme son nom l’indique, combine les technologies des deux domaines de l’apprentissage profond et de l’apprentissage par renforcement. Pour comprendre simplement, l'apprentissage profond fait référence à l'apprentissage de fonctionnalités à partir de données et à la prise de décisions en créant un réseau neuronal multicouche.

Une autre révolution dans l'apprentissage par renforcement ! DeepMind propose une « distillation d'algorithmes » : un transformateur d'apprentissage par renforcement pré-entraîné explorable

Apr 12, 2023 pm 06:58 PM

Une autre révolution dans l'apprentissage par renforcement ! DeepMind propose une « distillation d'algorithmes » : un transformateur d'apprentissage par renforcement pré-entraîné explorable

Apr 12, 2023 pm 06:58 PM

Transformer peut être considéré comme l'architecture de réseau neuronal la plus puissante pour les tâches de modélisation de séquence actuelles, et le modèle Transformer pré-entraîné peut utiliser des invites comme conditions ou un apprentissage en contexte pour s'adapter à différentes tâches en aval. La capacité de généralisation des modèles Transformer pré-entraînés à grande échelle a été vérifiée dans plusieurs domaines, tels que la complétion de texte, la compréhension du langage, la génération d'images, etc. Depuis l’année dernière, des travaux pertinents ont prouvé qu’en traitant l’apprentissage par renforcement hors ligne (RL hors ligne) comme un problème de prédiction de séquence, le modèle peut apprendre des politiques à partir de données hors ligne. Mais les approches actuelles soit apprennent les politiques à partir de données qui ne contiennent pas d'apprentissage

Comment utiliser le langage Go pour mener des recherches sur l'apprentissage par renforcement profond ?

Jun 10, 2023 pm 02:15 PM

Comment utiliser le langage Go pour mener des recherches sur l'apprentissage par renforcement profond ?

Jun 10, 2023 pm 02:15 PM

L'apprentissage par renforcement profond (DeepReinforcementLearning) est une technologie avancée qui combine l'apprentissage en profondeur et l'apprentissage par renforcement. Elle est largement utilisée dans la reconnaissance vocale, la reconnaissance d'images, le traitement du langage naturel et d'autres domaines. En tant que langage de programmation rapide, efficace et fiable, le langage Go peut apporter une aide à la recherche sur l’apprentissage par renforcement profond. Cet article expliquera comment utiliser le langage Go pour mener des recherches sur l'apprentissage par renforcement profond. 1. Installez le langage Go et les bibliothèques associées et commencez à utiliser le langage Go pour un apprentissage par renforcement en profondeur.

Contrôler un bras robotique à double articulation à l'aide de l'algorithme d'apprentissage par renforcement DDPG d'Actor-Critic

May 12, 2023 pm 09:55 PM

Contrôler un bras robotique à double articulation à l'aide de l'algorithme d'apprentissage par renforcement DDPG d'Actor-Critic

May 12, 2023 pm 09:55 PM

Dans cet article, nous présenterons la formation d'agents intelligents pour contrôler un bras robotique à double articulation dans l'environnement Reacher, un programme de simulation basé sur Unity développé à l'aide de la boîte à outils UnityML-Agents. Notre objectif est d'atteindre la position cible avec une grande précision, nous pouvons donc utiliser ici l'algorithme de pointe DeepDeterministicPolicyGradient (DDPG) conçu pour les espaces d'état et d'action continus. Applications du monde réel Les bras robotisés jouent un rôle essentiel dans les opérations de fabrication, de production, d'exploration spatiale et de recherche et de sauvetage. Il est très important de contrôler le bras du robot avec une grande précision et flexibilité. En employant des techniques d’apprentissage par renforcement, ces systèmes robotiques peuvent être en mesure d’apprendre et d’ajuster leur comportement en temps réel.

Comment utiliser l'apprentissage par renforcement pour améliorer la fidélisation des utilisateurs de Kuaishou ?

May 07, 2023 pm 06:31 PM

Comment utiliser l'apprentissage par renforcement pour améliorer la fidélisation des utilisateurs de Kuaishou ?

May 07, 2023 pm 06:31 PM

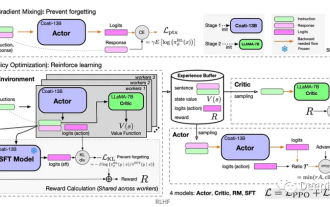

L'objectif principal du système de recommandation de vidéos courtes est de stimuler la croissance des DAU en améliorant la fidélisation des utilisateurs. Par conséquent, la rétention est l’un des principaux indicateurs d’optimisation commerciale de chaque APP. Cependant, la rétention est un retour à long terme après de multiples interactions entre les utilisateurs et le système, et il est difficile de la décomposer en un seul élément ou une seule liste. Par conséquent, il est difficile d'optimiser directement la rétention en utilisant les méthodes traditionnelles par points et par listes. des modèles sages. Les méthodes d'apprentissage par renforcement (RL) optimisent les récompenses à long terme en interagissant avec l'environnement et conviennent pour optimiser directement la fidélisation des utilisateurs. Ce travail modélise le problème d'optimisation de la rétention comme un processus de décision de Markov (MDP) avec une granularité de requête à horizon infini. Chaque fois que l'utilisateur demande au système de recommandation de décider d'une action, il est utilisé pour agréger plusieurs estimations de feedback à court terme (durée de surveillance,

Apprenez à assembler un circuit imprimé en 20 minutes ! Le framework SERL open source a un taux de réussite de contrôle de précision de 100 % et est trois fois plus rapide que les humains.

Feb 21, 2024 pm 03:31 PM

Apprenez à assembler un circuit imprimé en 20 minutes ! Le framework SERL open source a un taux de réussite de contrôle de précision de 100 % et est trois fois plus rapide que les humains.

Feb 21, 2024 pm 03:31 PM

Désormais, les robots peuvent apprendre des tâches de contrôle de précision en usine. Ces dernières années, des progrès significatifs ont été réalisés dans le domaine des technologies d'apprentissage par renforcement des robots, comme la marche des quadrupèdes, la préhension, la manipulation adroite, etc., mais la plupart d'entre eux se limitent à la phase de démonstration en laboratoire. L’application généralisée de la technologie d’apprentissage par renforcement robotique aux environnements de production réels se heurte encore à de nombreux défis, ce qui limite dans une certaine mesure sa portée d’application dans des scénarios réels. Dans le processus d'application pratique de la technologie d'apprentissage par renforcement, il est nécessaire de surmonter plusieurs problèmes complexes, notamment la configuration du mécanisme de récompense, la réinitialisation de l'environnement, l'amélioration de l'efficacité des échantillons et la garantie de la sécurité des actions. Les experts du secteur soulignent que la résolution des nombreux problèmes liés à la mise en œuvre réelle de la technologie d’apprentissage par renforcement est aussi importante que l’innovation continue de l’algorithme lui-même. Face à ce défi, des chercheurs de l'Université de Californie à Berkeley, de l'Université de Stanford, de l'Université de Washington et