Périphériques technologiques

Périphériques technologiques

IA

IA

Le risque que l'IA devienne incontrôlable augmente : le poids du modèle ouvert déclenche une méta-protestation

Le risque que l'IA devienne incontrôlable augmente : le poids du modèle ouvert déclenche une méta-protestation

Le risque que l'IA devienne incontrôlable augmente : le poids du modèle ouvert déclenche une méta-protestation

Editeurs : Du Wei, Xiaozhou

L'IA, en particulier l'open source et la source fermée à l'ère des grands modèles, présente des avantages et des inconvénients. L'important est de savoir comment faire du bon travail en l'utilisant.

Les gens ont toujours été divisés sur le choix entre l'open source et le fermé dans le domaine de l'IA. Cependant, à l'ère des grands modèles, la puissante force de l'open source a discrètement émergé. Selon un document interne de Google précédemment divulgué, autour de modèles open source tels que LLaMA de Meta, l’ensemble de la communauté construit rapidement des modèles similaires à OpenAI et aux capacités de grands modèles de Google.

Il ne fait aucun doute que Meta est le noyau absolu du monde open source, avec des efforts continus en matière d'open source tels que la récente sortie de Llama 2. Cependant, tout ce qui est bon sera détruit par le vent. Récemment, Meta a eu des « problèmes » à cause de l'open source.

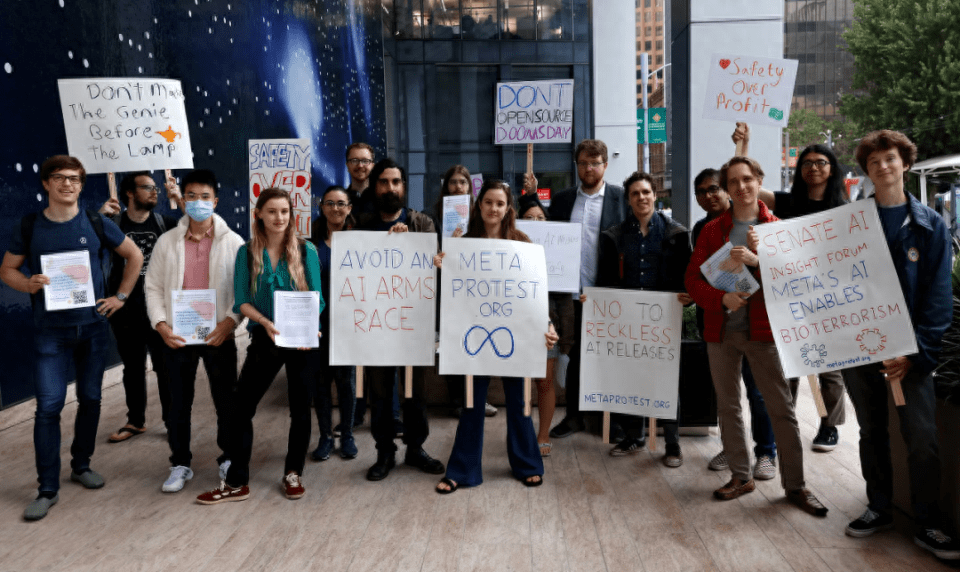

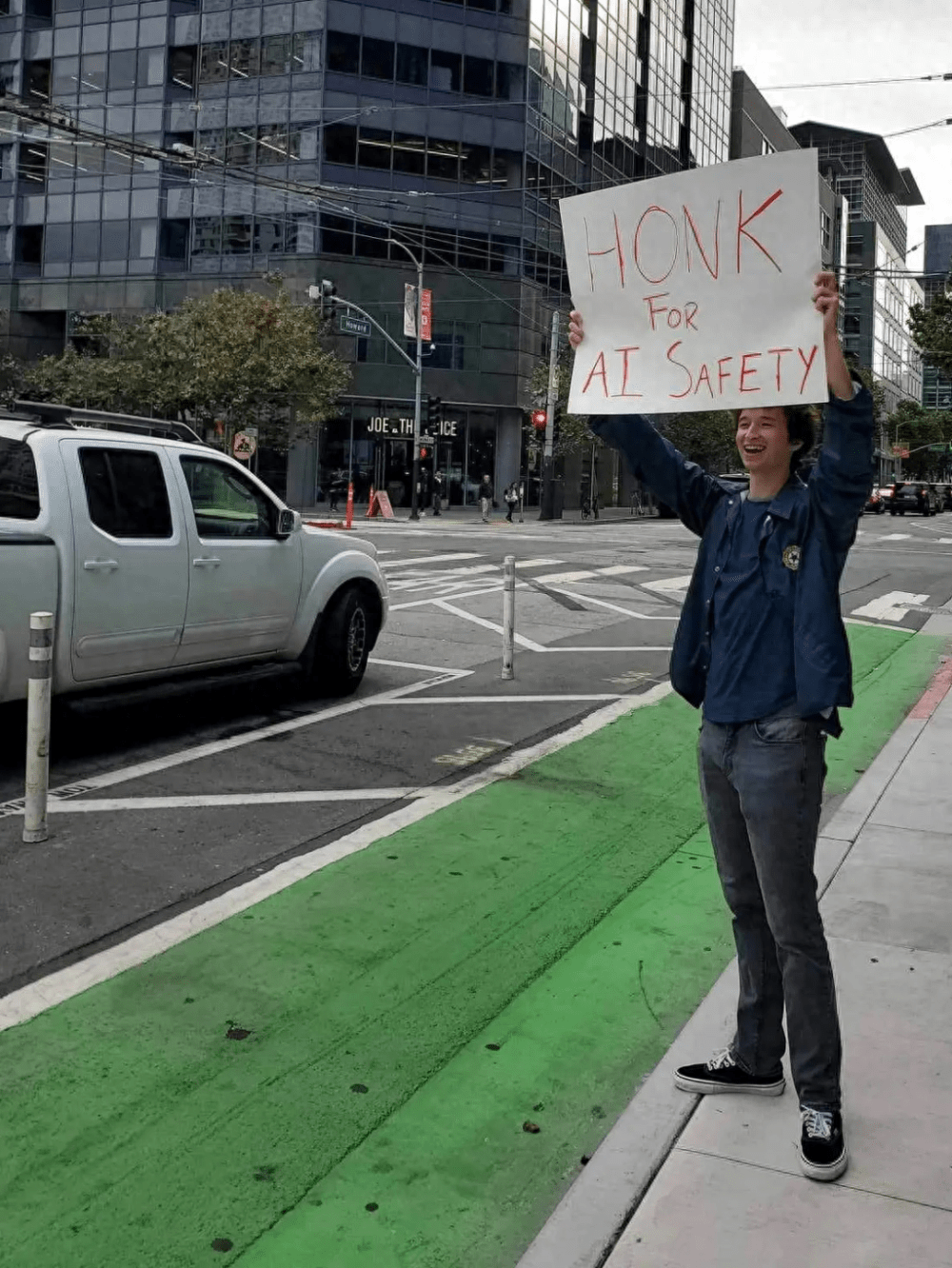

Devant les bureaux de Meta à San Francisco, un groupe de manifestants brandissant des pancartes s’est rassemblé pour protester contre la stratégie de Meta consistant à publier publiquement des modèles d’IA, affirmant que ces modèles publiés provoquaient la « prolifération irréversible » de technologies potentiellement dangereuses. Certains manifestants ont même comparé les grands modèles sortis par Meta à des « armes de destruction massive »

Ces manifestants se qualifient de « citoyens concernés » et sont menés par Holly Elmore. Selon LinkedIn, elle est une défenseure indépendante du mouvement AI Pause.

Le contenu qui doit être réécrit est : Source de l'image : MISHA GUREVICH

Si un modèle s'avère dangereux, elle a noté que l'API peut être arrêtée. Par exemple, des entreprises comme Google et OpenAI autorisent uniquement les utilisateurs à accéder à de grands modèles via API

En revanche, la série de modèles open source LLaMA de Meta met les poids des modèles à la disposition du public, permettant à toute personne disposant du matériel et de l'expertise appropriés de reproduire et de modifier le modèle elle-même. Une fois les poids des modèles publiés, la société d'édition n'a plus aucun contrôle sur la manière dont l'IA est utilisée

De l’avis de Holly Elmore, publier les poids des modèles est une stratégie dangereuse, n’importe qui peut modifier le modèle et ces modèles ne peuvent pas être annulés. "Plus le modèle est puissant, plus cette stratégie devient dangereuse."

Par rapport aux modèles open source, les grands modèles accessibles via les API disposent souvent de diverses fonctionnalités de sécurité, telles que le filtrage des réponses ou une formation spécifique pour empêcher la sortie de réponses dangereuses ou gênantes

Si les poids du modèle sont libérés, il devient beaucoup plus facile de recycler le modèle pour qu'il saute par-dessus ces « garde-corps ». Cela rend plus possible l’utilisation de ces modèles open source pour créer des logiciels de phishing et mener des attaques réseau.

Le contenu qui doit être réécrit est : Source de l'image : MISHA GUREVICH

Elle pense qu'une partie du problème avec la sécurité des modèles réside dans le fait que les mesures de sécurité actuellement prises ne sont pas suffisantes, il faut donc trouver de meilleurs moyens d'assurer la sécurité des modèles

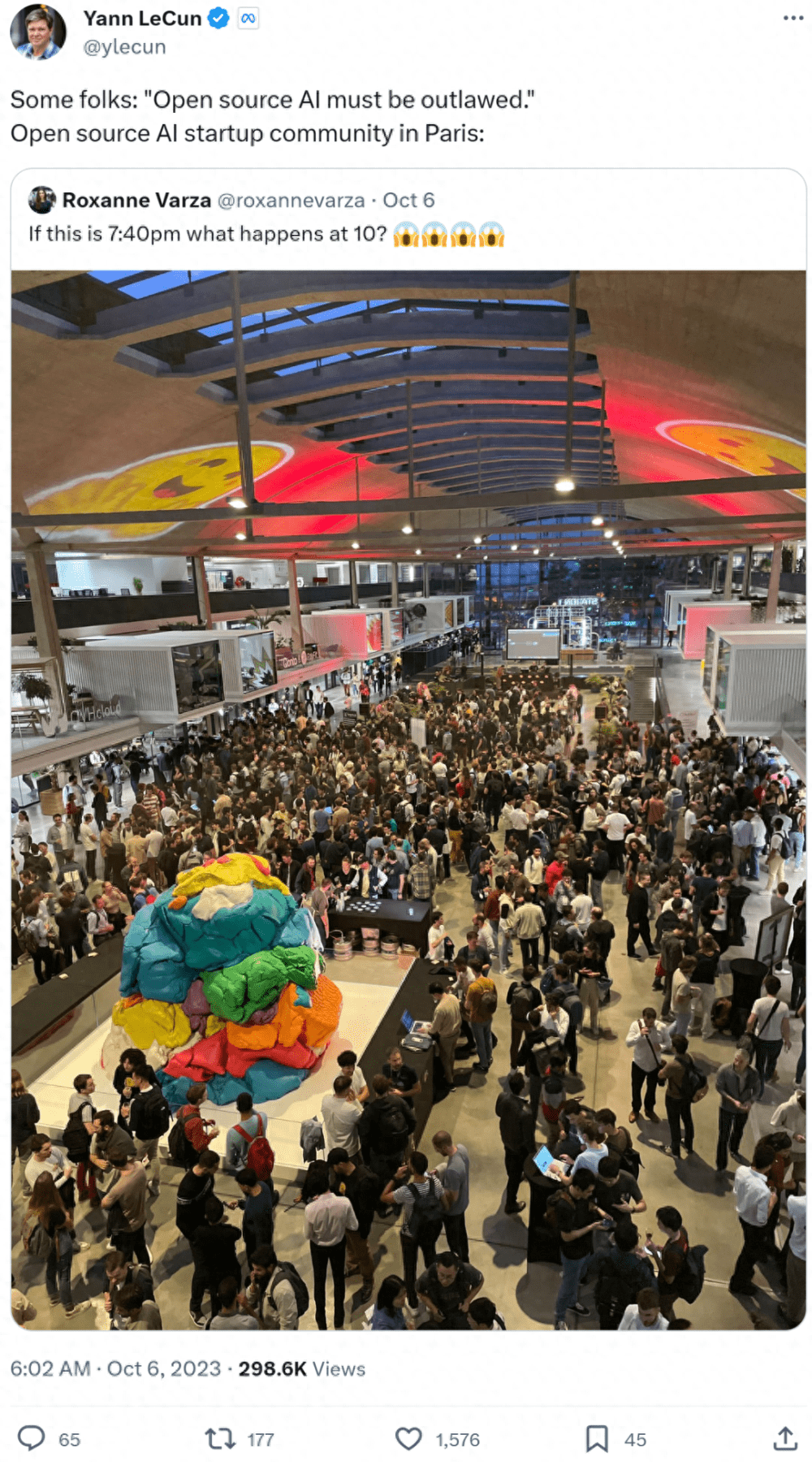

Actuellement, Meta n'a fait aucun commentaire à ce sujet. Cependant, Yann LeCun, scientifique en chef de l'IA chez Meta, semble avoir répondu à la déclaration selon laquelle « l'IA open source doit être interdite » et a montré la communauté florissante des startups de l'IA open source à Paris

De nombreuses personnes ont des opinions différentes et pensent qu’une stratégie ouverte pour le développement de l’IA est le seul moyen de garantir la confiance dans la technologie, ce qui est différent du point de vue de Holly Elmore

Certains internautes ont déclaré que l'open source présente des avantages et des inconvénients. Il peut permettre aux gens d'acquérir une plus grande transparence et d'améliorer l'innovation, mais il sera également confronté au risque d'utilisation abusive (comme le code) par des acteurs malveillants.

Comme prévu, OpenAI a de nouveau été ridiculisé, certains disant "il devrait revenir à l'open source

".

Beaucoup de gens s'inquiètent de l'open source

Peter S. Park, chercheur postdoctoral en sécurité de l'intelligence artificielle au MIT, a déclaré que la diffusion généralisée de modèles d'intelligence artificielle avancés à l'avenir pourrait causer de nombreux problèmes car il est fondamentalement impossible d'empêcher complètement l'abus des modèles d'intelligence artificielle

Cependant, Stella Biderman, directrice exécutive d'EleutherAI, une organisation de recherche sur l'intelligence artificielle à but non lucratif, a déclaré : « Jusqu'à présent, il existe peu de preuves que les modèles open source aient causé un préjudice spécifique. L'API fera l'affaire pour résoudre le problème de sécurité."

Biderman estime : "Les éléments de base de la construction d'un LLM ont été divulgués dans des documents de recherche gratuits que tout le monde peut lire pour développer ses propres modèles."

Elle a en outre souligné : « Si les entreprises encouragent la confidentialité des détails des modèles, cela pourrait avoir de graves conséquences négatives sur la transparence de la recherche sur le terrain, la sensibilisation du public et le développement scientifique, en particulier pour les chercheurs indépendants. »Bien que tout le monde discute déjà de l'impact de l'open source, il n'est toujours pas clair si la méthode de Meta est vraiment suffisamment ouverte et si elle peut tirer parti de l'open source.

Stefano Maffulli, directeur exécutif de l'Open Source Initiative (OSI), a déclaré : « Le concept d'intelligence artificielle open source n'a pas encore été clairement défini. Différentes organisations utilisent le terme pour désigner différentes choses, indiquant différents degrés d'accès public. trucs", ce qui peut dérouter les gens. "

Maffulli a souligné que pour les logiciels open source, la question clé est de savoir si le code source est accessible au public et peut être utilisé à n'importe quelle fin. Cependant, la reproduction d'un modèle d'IA peut nécessiter le partage de données d'entraînement, de méthodes de collecte de données, de logiciels d'entraînement, de poids de modèle, de code d'inférence, etc. Parmi eux, le problème le plus important est que les données de formation peuvent impliquer des problèmes de confidentialité et de droits d'auteur

Maffulli a souligné que pour les logiciels open source, la question clé est de savoir si le code source est accessible au public et peut être utilisé à n'importe quelle fin. Cependant, la reproduction d'un modèle d'IA peut nécessiter le partage de données d'entraînement, de méthodes de collecte de données, de logiciels d'entraînement, de poids de modèle, de code d'inférence, etc. Parmi eux, le problème le plus important est que les données de formation peuvent impliquer des problèmes de confidentialité et de droits d'auteur

OSI travaille sur une définition précise de « l’IA open source » depuis l’année dernière et devrait publier une première version dans les semaines à venir. Quoi qu’il en soit, il estime que l’open source est crucial pour le développement de l’IA. "Si l'IA n'est pas open source, nous ne pouvons pas avoir une IA fiable et responsable", a-t-il déclaré

À l'avenir, les différences entre l'open source et le fermé continueront, mais l'open source est imparable.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

1393

1393

52

52

1205

1205

24

24

Un nouveau casque VR Meta Quest 3S abordable apparaît sur FCC, suggérant un lancement imminent

Sep 04, 2024 am 06:51 AM

Un nouveau casque VR Meta Quest 3S abordable apparaît sur FCC, suggérant un lancement imminent

Sep 04, 2024 am 06:51 AM

L'événement Meta Connect 2024 est prévu du 25 au 26 septembre et lors de cet événement, la société devrait dévoiler un nouveau casque de réalité virtuelle abordable. Selon la rumeur, il s'agirait du Meta Quest 3S, le casque VR serait apparemment apparu sur la liste FCC. Cela suggère

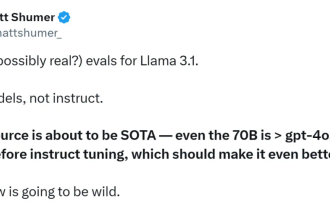

Le premier modèle open source à dépasser le niveau GPT4o ! Llama 3.1 fuite : 405 milliards de paramètres, liens de téléchargement et cartes de modèles sont disponibles

Jul 23, 2024 pm 08:51 PM

Le premier modèle open source à dépasser le niveau GPT4o ! Llama 3.1 fuite : 405 milliards de paramètres, liens de téléchargement et cartes de modèles sont disponibles

Jul 23, 2024 pm 08:51 PM

Préparez votre GPU ! Llama3.1 est finalement apparu, mais la source n'est pas officielle de Meta. Aujourd'hui, la nouvelle divulguée du nouveau grand modèle Llama est devenue virale sur Reddit. En plus du modèle de base, elle comprend également des résultats de référence de 8B, 70B et le paramètre maximum de 405B. La figure ci-dessous montre les résultats de comparaison de chaque version de Llama3.1 avec OpenAIGPT-4o et Llama38B/70B. On peut voir que même la version 70B dépasse GPT-4o sur plusieurs benchmarks. Source de l'image : https://x.com/mattshumer_/status/1815444612414087294 Évidemment, version 3.1 de 8B et 70

Six façons rapides de découvrir le nouveau Llama 3 !

Apr 19, 2024 pm 12:16 PM

Six façons rapides de découvrir le nouveau Llama 3 !

Apr 19, 2024 pm 12:16 PM

Hier soir, Meta a publié les modèles Llama38B et 70B. Le modèle optimisé pour les instructions Llama3 est affiné et optimisé pour les cas d'utilisation de dialogue/chat et surpasse de nombreux modèles de chat open source existants dans les benchmarks courants. Par exemple, Gemma7B et Mistral7B. Le modèle Llama+3 améliore les données et l'échelle et atteint de nouveaux sommets. Il a été formé sur plus de 15 000 jetons de données sur deux clusters GPU 24 000 personnalisés récemment publiés par Meta. Cet ensemble de données de formation est 7 fois plus grand que Llama2 et contient 4 fois plus de code. Cela porte la capacité du modèle Llama au niveau le plus élevé actuel, qui prend en charge des longueurs de texte supérieures à 8 Ko, soit le double de celle de Llama2. sous

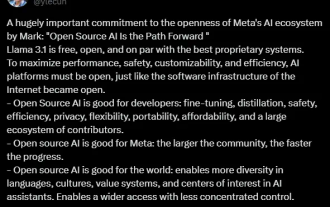

Le modèle le plus puissant Llama 3.1 405B est officiellement lancé, Zuckerberg : l'Open source mène une nouvelle ère

Jul 24, 2024 pm 08:23 PM

Le modèle le plus puissant Llama 3.1 405B est officiellement lancé, Zuckerberg : l'Open source mène une nouvelle ère

Jul 24, 2024 pm 08:23 PM

Tout à l'heure, le très attendu Llama 3.1 est officiellement sorti ! Meta a officiellement déclaré que "l'open source mène une nouvelle ère". Sur le blog officiel, Meta a déclaré : « Jusqu'à aujourd'hui, les grands modèles de langage open source étaient pour la plupart à la traîne des modèles fermés en termes de fonctionnalités et de performances. Nous inaugurons désormais une nouvelle ère dirigée par l'open source. Nous avons rendu public MetaLlama3.1405B. , qui, selon nous, est le modèle de base open source le plus grand et le plus puissant au monde, à ce jour, le nombre total de téléchargements de toutes les versions de Llama a dépassé les 300 millions de fois, et nous venons de commencer, le fondateur et PDG de Meta, Zuckerberg. article long "OpenSourceAIIsthePathForward",

Llama3 arrive soudainement ! La communauté open source est à nouveau en ébullition : l'ère de l'accès gratuit aux modèles de niveau GPT4 est arrivée

Apr 19, 2024 pm 12:43 PM

Llama3 arrive soudainement ! La communauté open source est à nouveau en ébullition : l'ère de l'accès gratuit aux modèles de niveau GPT4 est arrivée

Apr 19, 2024 pm 12:43 PM

Llama3 est là ! Tout à l'heure, le site officiel de Meta a été mis à jour et le responsable a annoncé les versions de Llama à 38 milliards et 70 milliards de paramètres. Et c'est un SOTA open source après son lancement : les métadonnées officielles montrent que les versions Llama38B et 70B surpassent tous les adversaires dans leurs échelles de paramètres respectives. Le modèle 8B surpasse Gemma7B et Mistral7BInstruct sur de nombreux benchmarks tels que MMLU, GPQA et HumanEval. Le modèle 70B a surpassé le populaire poulet frit Claude3Sonnet et a fait des allers-retours avec le GeminiPro1.5 de Google. Dès que le lien Huggingface est sorti, la communauté open source est redevenue enthousiasmée. Les étudiants aveugles aux yeux perçants ont également découvert immédiatement

Que signifie MÉTA ?

Mar 05, 2024 pm 12:18 PM

Que signifie MÉTA ?

Mar 05, 2024 pm 12:18 PM

META fait généralement référence à un monde virtuel ou à une plateforme appelée Metaverse. Le métaverse est un monde virtuel construit par des humains à l’aide de la technologie numérique qui reflète ou transcende le monde réel et peut interagir avec le monde réel. C’est un espace de vie numérique doté d’un nouveau système social.

Un analyste discute du prix de lancement du casque VR Meta Quest 3S

Aug 27, 2024 pm 09:35 PM

Un analyste discute du prix de lancement du casque VR Meta Quest 3S

Aug 27, 2024 pm 09:35 PM

Plus d'un an s'est écoulé depuis la sortie initiale du Quest 3 par Meta (499,99 $ sur Amazon). Depuis lors, Apple a commercialisé le Vision Pro, considérablement plus cher, tandis que Byte Dance a dévoilé le Pico 4 Ultra en Chine. Cependant, il y a

Il est prévu qu'en 2024, Meta envisage de lancer un prototype révolutionnaire de lunettes AR appelé 'Orion'.

Jan 04, 2024 pm 09:35 PM

Il est prévu qu'en 2024, Meta envisage de lancer un prototype révolutionnaire de lunettes AR appelé 'Orion'.

Jan 04, 2024 pm 09:35 PM

Selon les informations du 24 décembre, Meta, une entreprise technologique ayant une énorme influence dans l'industrie des médias sociaux, place désormais ses fortes attentes sur les lunettes de réalité augmentée (RA), une technologie considérée comme la plate-forme informatique de nouvelle génération. Récemment, le directeur technique de Meta, Andrew Bosworth, a révélé dans une interview que la société devrait lancer un prototype avancé de lunettes AR nommé « Orion » en 2024. Depuis longtemps, Meta investit dans la technologie AR autant que dans d’autres domaines. Ils ont investi d’énormes sommes d’argent, s’élevant à des milliards de dollars, dans le but de créer un produit révolutionnaire comparable à l’iPhone. Bien qu'ils aient annoncé l'année dernière la fin des projets de production de masse des lunettes Orion,