Périphériques technologiques

Périphériques technologiques

Industrie informatique

Industrie informatique

Nvidia prévoit de lancer la nouvelle génération de GPU Blackwell B100 au deuxième trimestre de l'année prochaine, en utilisant la mémoire HBM3E

Nvidia prévoit de lancer la nouvelle génération de GPU Blackwell B100 au deuxième trimestre de l'année prochaine, en utilisant la mémoire HBM3E

Nvidia prévoit de lancer la nouvelle génération de GPU Blackwell B100 au deuxième trimestre de l'année prochaine, en utilisant la mémoire HBM3E

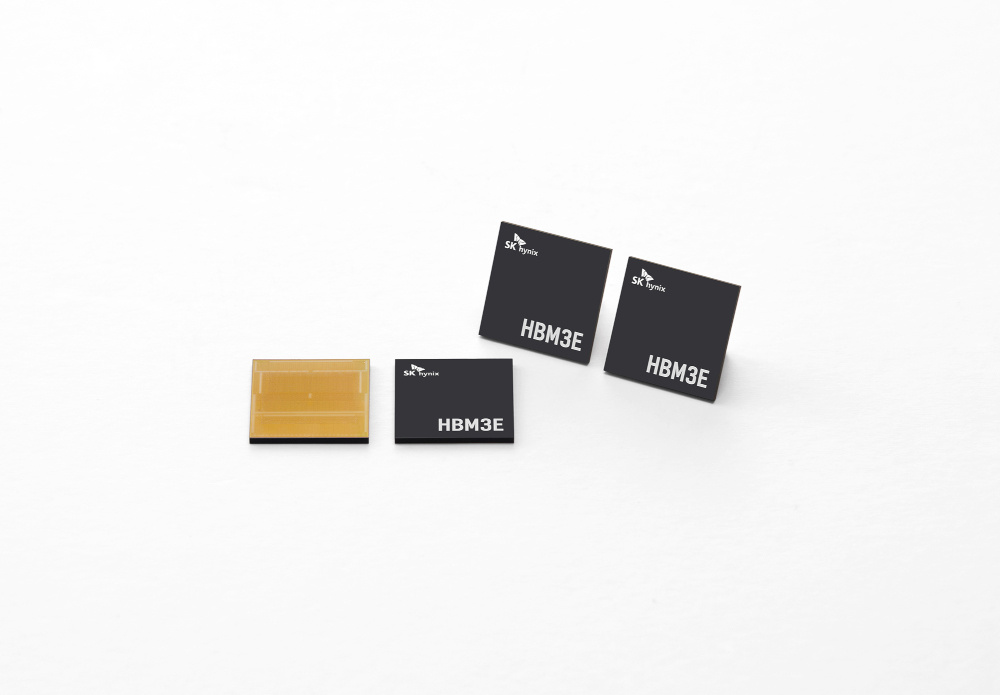

Selon les informations de ce site, SK Hynix a annoncé en août de cette année avoir développé avec succès la mémoire HBM3E la plus performante au monde et prévoit de démarrer la production de masse au premier semestre de l'année prochaine. Actuellement, la société a fourni des échantillons aux clients pour vérifier les performances

Selon MT.co.kr, SK Hynix fournira exclusivement la mémoire à large bande passante de cinquième génération HBM3E à NVIDIA suite au produit de quatrième génération HBM3. Elle devrait consolider davantage sa position en tant qu’entreprise de semi-conducteurs pour l’IA.

Selon les nouvelles de l'industrie des semi-conducteurs du 15, SK Hynix fournira à NVIDIA une mémoire HBM3E qui répond aux exigences de qualité de production de masse au début de l'année prochaine et effectuera les tests de qualification finaux.

Un dirigeant de l'industrie des semi-conducteurs a déclaré : "Sans HBM3E, NVIDIA ne peut pas vendre du B100" et "Une fois que la qualité répond aux exigences, le contrat n'est qu'une question de temps." HBM3E sera utilisé dans le cadre des plans de NVIDIA pour lancer le GPU phare Blackwell de nouvelle génération, le B100, vers le deuxième trimestre de l'année prochaine. Les prévisions du marché sont que le B100 changera davantage la donne en matière d’IA que la spécification la plus élevée actuelle de Nvidia, le H100.

Note sur ce site : Blackwell est David Blackwell, un académicien de la National Academy of Sciences. Il a été le premier académicien noir de la National Academy of Sciences et le premier professeur noir titulaire de l'Université de Californie à Berkeley. maladie le 8 juillet 2010, à l'âge de 91 ans.

Il convient de mentionner que NVIDIA occupe actuellement plus de 90 % du marché des processeurs graphiques d'intelligence artificielle (GPU AI) ; et dans le domaine du stockage, SK Hynix a occupé plus de la moitié de la mémoire mondiale à large bande passante (HBM) ) part de marché et a complètement monopolisé le marché des produits DRAM de grande capacité tels que 128 Go DDR5

Il convient de mentionner que NVIDIA occupe actuellement plus de 90 % du marché des processeurs graphiques d'intelligence artificielle (GPU AI) ; et dans le domaine du stockage, SK Hynix a occupé plus de la moitié de la mémoire mondiale à large bande passante (HBM) ) part de marché et a complètement monopolisé le marché des produits DRAM de grande capacité tels que 128 Go DDR5 Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Des sources affirment que le rendement de la mémoire DRAM 3D empilée à cinq couches de SK Hynix a atteint 56,1 %

Jun 24, 2024 pm 01:52 PM

Des sources affirment que le rendement de la mémoire DRAM 3D empilée à cinq couches de SK Hynix a atteint 56,1 %

Jun 24, 2024 pm 01:52 PM

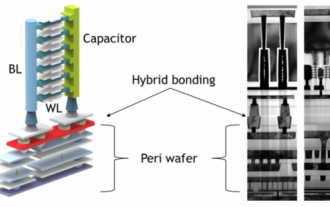

Selon des informations publiées sur ce site Web le 24 juin, le média coréen BusinessKorea a rapporté que des initiés de l'industrie avaient révélé que SK Hynix avait publié le dernier document de recherche sur la technologie DRAM 3D lors du sommet VLSI 2024 qui s'est tenu à Hawaï, aux États-Unis, du 16 au 20 juin. Dans cet article, SK Hynix rapporte que le rendement de sa mémoire DRAM 3D empilée à cinq couches a atteint 56,1 % et que la DRAM 3D de l'expérience présente des caractéristiques similaires à la DRAM 2D actuelle. Selon les rapports, contrairement à la DRAM traditionnelle, qui dispose les cellules de mémoire horizontalement, la DRAM 3D empile les cellules verticalement pour obtenir une densité plus élevée dans le même espace. Cependant, SK hynix

NVIDIA lance la fonction RTX HDR : les jeux non pris en charge utilisent des filtres AI pour obtenir de superbes effets visuels HDR

Feb 24, 2024 pm 06:37 PM

NVIDIA lance la fonction RTX HDR : les jeux non pris en charge utilisent des filtres AI pour obtenir de superbes effets visuels HDR

Feb 24, 2024 pm 06:37 PM

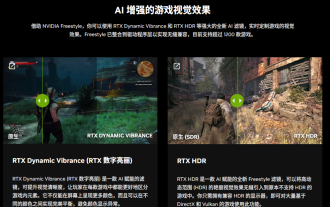

Selon les informations de ce site Web du 23 février, NVIDIA a mis à jour et lancé hier soir l'application NVIDIA, offrant aux joueurs un nouveau centre de contrôle GPU unifié, permettant aux joueurs de capturer des moments merveilleux grâce au puissant outil d'enregistrement fourni par le flotteur du jeu. fenêtre. Dans cette mise à jour, NVIDIA a également introduit la fonction RTXHDR. L'introduction officielle est jointe à ce site : RTXHDR est un nouveau filtre Freestyle basé sur l'IA qui peut introduire de manière transparente les superbes effets visuels de la plage dynamique élevée (HDR) dans les jeux qui ne le font pas. prend en charge à l'origine le HDR. Tout ce dont vous avez besoin est un moniteur compatible HDR pour utiliser cette fonctionnalité avec une large gamme de jeux basés sur DirectX et Vulkan. Une fois que le lecteur a activé la fonction RTXHDR, le jeu fonctionnera même s'il ne prend pas en charge la HD.

Des sources affirment que Samsung Electronics et SK Hynix commercialiseront de la mémoire mobile empilée après 2026

Sep 03, 2024 pm 02:15 PM

Des sources affirment que Samsung Electronics et SK Hynix commercialiseront de la mémoire mobile empilée après 2026

Sep 03, 2024 pm 02:15 PM

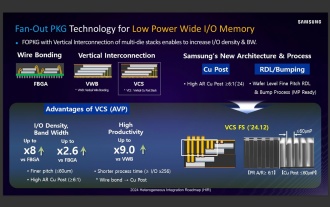

Selon des informations publiées sur ce site Web le 3 septembre, le média coréen etnews a rapporté hier (heure locale) que les produits de mémoire mobile à structure empilée « de type HBM » de Samsung Electronics et SK Hynix seraient commercialisés après 2026. Des sources ont indiqué que les deux géants coréens de la mémoire considèrent la mémoire mobile empilée comme une source importante de revenus futurs et prévoient d'étendre la « mémoire de type HBM » aux smartphones, tablettes et ordinateurs portables afin de fournir de la puissance à l'IA finale. Selon des rapports précédents sur ce site, le produit de Samsung Electronics s'appelle LPWide I/O memory, et SK Hynix appelle cette technologie VFO. Les deux sociétés ont utilisé à peu près la même voie technique, à savoir combiner emballage en sortance et canaux verticaux. La mémoire LPWide I/O de Samsung Electronics a une largeur de 512 bits.

Le modèle de dialogue NVIDIA ChatQA a évolué vers la version 2.0, avec la longueur du contexte mentionnée à 128 Ko

Jul 26, 2024 am 08:40 AM

Le modèle de dialogue NVIDIA ChatQA a évolué vers la version 2.0, avec la longueur du contexte mentionnée à 128 Ko

Jul 26, 2024 am 08:40 AM

La communauté ouverte LLM est une époque où une centaine de fleurs fleurissent et s'affrontent. Vous pouvez voir Llama-3-70B-Instruct, QWen2-72B-Instruct, Nemotron-4-340B-Instruct, Mixtral-8x22BInstruct-v0.1 et bien d'autres. excellents interprètes. Cependant, par rapport aux grands modèles propriétaires représentés par le GPT-4-Turbo, les modèles ouverts présentent encore des lacunes importantes dans de nombreux domaines. En plus des modèles généraux, certains modèles ouverts spécialisés dans des domaines clés ont été développés, tels que DeepSeek-Coder-V2 pour la programmation et les mathématiques, et InternVL pour les tâches de langage visuel.

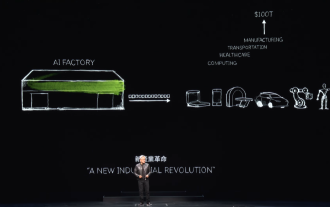

« AI Factory » favorisera la refonte de l'ensemble de la pile logicielle, et NVIDIA fournit des conteneurs Llama3 NIM que les utilisateurs peuvent déployer

Jun 08, 2024 pm 07:25 PM

« AI Factory » favorisera la refonte de l'ensemble de la pile logicielle, et NVIDIA fournit des conteneurs Llama3 NIM que les utilisateurs peuvent déployer

Jun 08, 2024 pm 07:25 PM

Selon les informations de ce site le 2 juin, lors du discours d'ouverture du Huang Renxun 2024 Taipei Computex, Huang Renxun a présenté que l'intelligence artificielle générative favoriserait la refonte de l'ensemble de la pile logicielle et a démontré ses microservices cloud natifs NIM (Nvidia Inference Microservices). . Nvidia estime que « l'usine IA » déclenchera une nouvelle révolution industrielle : en prenant comme exemple l'industrie du logiciel lancée par Microsoft, Huang Renxun estime que l'intelligence artificielle générative favorisera sa refonte complète. Pour faciliter le déploiement de services d'IA par les entreprises de toutes tailles, NVIDIA a lancé les microservices cloud natifs NIM (Nvidia Inference Microservices) en mars de cette année. NIM+ est une suite de microservices cloud natifs optimisés pour réduire les délais de commercialisation

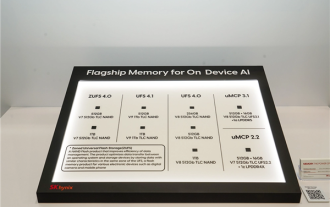

Hynix est le premier à présenter la mémoire flash UFS 4.1 : basée sur les particules V9 TLC NAND

Aug 09, 2024 pm 03:33 PM

Hynix est le premier à présenter la mémoire flash UFS 4.1 : basée sur les particules V9 TLC NAND

Aug 09, 2024 pm 03:33 PM

Selon les informations du 9 août, lors du sommet FMS2024, SK Hynix a présenté ses derniers produits de stockage, notamment la mémoire flash universelle UFS4.1 dont les spécifications n'ont pas encore été officiellement publiées. Selon le site officiel de la JEDEC Solid State Technology Association, la dernière spécification UFS actuellement annoncée est UFS4.0 en août 2022. Sa vitesse d'interface théorique atteint 46,4 Gbit/s. On s'attend à ce qu'UFS4.1 améliore encore la transmission. taux. 1. Hynix a présenté des produits de mémoire flash à usage général de 512 Go et 1 ToBUFS4.1, basés sur une mémoire flash V91TbTLCNAND à 321 couches. SK Hynix a également présenté des particules de 3,2 GbpsV92TbQLC et 3,6 GbpsV9H1TbTLC. Hynix présente un modèle basé sur V7

Après de multiples transformations et coopération avec le géant de l'IA Nvidia, pourquoi Vanar Chain a-t-il augmenté de 4,6 fois en 30 jours ?

Mar 14, 2024 pm 05:31 PM

Après de multiples transformations et coopération avec le géant de l'IA Nvidia, pourquoi Vanar Chain a-t-il augmenté de 4,6 fois en 30 jours ?

Mar 14, 2024 pm 05:31 PM

Récemment, la blockchain Layer1 VanarChain a attiré l'attention du marché en raison de son taux de croissance élevé et de sa coopération avec le géant de l'IA NVIDIA. Derrière la popularité de VanarChain, en plus de subir de multiples transformations de marque, des concepts populaires tels que les jeux principaux, le métaverse et l'IA ont également valu au projet beaucoup de popularité et de sujets. Avant sa transformation, Vanar, anciennement TerraVirtua, a été fondée en 2018 en tant que plate-forme prenant en charge les abonnements payants, fournissant du contenu de réalité virtuelle (VR) et de réalité augmentée (AR) et acceptant les paiements en crypto-monnaie. La plateforme a été créée par les cofondateurs Gary Bracey et Jawad Ashraf, Gary Bracey possédant une vaste expérience dans la production et le développement de jeux vidéo.

L'ordinateur pour lequel j'ai dépensé 300 yuans a fonctionné avec succès grâce au grand modèle local

Apr 12, 2024 am 08:07 AM

L'ordinateur pour lequel j'ai dépensé 300 yuans a fonctionné avec succès grâce au grand modèle local

Apr 12, 2024 am 08:07 AM

Si 2023 est reconnue comme la première année de l’IA, alors 2024 sera probablement une année clé pour la vulgarisation des grands modèles d’IA. Au cours de l'année écoulée, un grand nombre de grands modèles d'IA et un grand nombre d'applications d'IA ont vu le jour. Des fabricants tels que Meta et Google ont également commencé à lancer au public leurs propres grands modèles en ligne/locals, similaires à « l'intelligence artificielle de l'IA ». " C'est hors de portée. Le concept est soudainement venu aux gens. De nos jours, les gens sont de plus en plus exposés à l'intelligence artificielle dans leur vie. Si vous regardez attentivement, vous constaterez que presque toutes les différentes applications d'IA auxquelles vous avez accès sont déployées sur le « cloud ». Si vous souhaitez construire un appareil capable d'exécuter de grands modèles localement, alors le matériel est un tout nouvel AIPC au prix de plus de 5 000 yuans.