Périphériques technologiques

Périphériques technologiques

IA

IA

Le langage, le démantèlement de robots, le MIT et d'autres utilisent GPT-4 pour générer automatiquement des tâches de simulation et les migrer vers le monde réel

Le langage, le démantèlement de robots, le MIT et d'autres utilisent GPT-4 pour générer automatiquement des tâches de simulation et les migrer vers le monde réel

Le langage, le démantèlement de robots, le MIT et d'autres utilisent GPT-4 pour générer automatiquement des tâches de simulation et les migrer vers le monde réel

Dans le domaine de la robotique, la mise en œuvre de stratégies robotiques universelles nécessite une grande quantité de données, et la collecte de ces données dans le monde réel prend du temps et est laborieuse. Bien que la simulation constitue une solution économique pour générer différents volumes de données au niveau de la scène et de l'instance, la diversité croissante des tâches dans les environnements simulés reste confrontée à des défis en raison de la grande quantité de main d'œuvre requise (en particulier pour les tâches complexes). Il en résulte des références de simulation artificielle typiques ne contenant généralement que des dizaines à des centaines de tâches.

Comment le résoudre ? Ces dernières années, les grands modèles de langage ont continué à faire des progrès significatifs dans le traitement du langage naturel et la génération de code pour diverses tâches. De même, le LLM a été appliqué à plusieurs aspects de la robotique, notamment les interfaces utilisateur, la planification des tâches et des mouvements, le résumé du journal du robot, la conception des coûts et des récompenses, révélant de solides capacités dans les tâches basées sur la physique et dans la génération de code.

Dans une étude récente, des chercheurs du MIT CSAIL, de l'Université Jiao Tong de Shanghai et d'autres institutions ont exploré plus en détail si le LLM pouvait être utilisé pour créer diverses tâches de simulation et explorer davantage leurs capacités.

Plus précisément, les chercheurs ont proposé un cadre GenSim basé sur LLM, qui fournit un mécanisme automatisé pour concevoir et vérifier la disposition des actifs des tâches et la progression des tâches. Plus important encore, les tâches générées présentent une grande diversité, favorisant la généralisation des stratégies robotiques au niveau des tâches. De plus, sur le plan conceptuel, avec GenSim, les capacités de raisonnement et de codage de LLM sont affinées en stratégies verbales-visuelles-action grâce à la synthèse intermédiaire de données simulées.

Adresse papier : https://arxiv.org/pdf/2310.01361.pdf

Le framework GenSim se compose des trois parties suivantes :

- Tâches et mécanismes d'invite pour les correspondances implémentation du code ;

- Deuxièmement, une bibliothèque de tâches qui met en cache les codes d'instructions de haute qualité précédemment générés pour la vérification et le réglage fin du modèle de langage, et les renvoie sous la forme d'un ensemble complet de données de tâches

- Enfin, l'utilisation d'un langage ; pipeline de formation politique multitâche optimisé qui génère des données pour améliorer la généralisation au niveau des tâches.

Le framework fonctionne selon deux modes différents en même temps. Parmi eux, dans le cadre d'un objectif, l'utilisateur a une tâche spécifique ou souhaite concevoir un parcours de tâches. À l’heure actuelle, GenSim adopte une approche descendante, prenant les tâches attendues en entrée et générant de manière itérative des tâches associées pour atteindre les objectifs attendus. Dans un environnement exploratoire, en cas de manque de connaissance préalable de la tâche cible, GenSim explore progressivement le contenu au-delà des tâches existantes et établit une stratégie de base indépendante de la tâche.

Dans la figure 1 ci-dessous, le chercheur a initialisé une bibliothèque de tâches contenant 10 tâches organisées manuellement, a utilisé GenSim pour l'étendre et générer plus de 100 tâches.

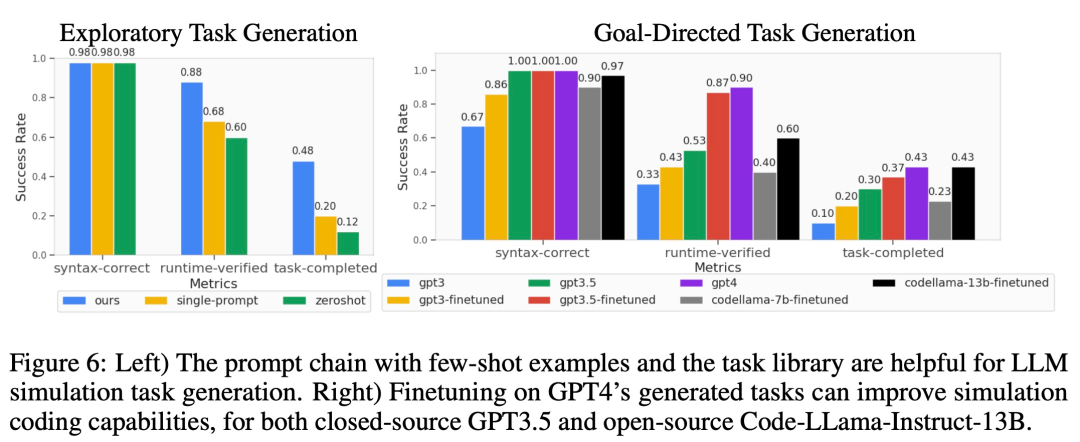

Les chercheurs ont également proposé plusieurs métriques personnalisées pour mesurer progressivement la qualité des tâches de simulation générées, et ont évalué plusieurs LLM dans des contextes exploratoires et orientés vers des objectifs. Pour la bibliothèque de tâches générée par GPT-4, ils ont effectué un réglage fin supervisé sur des LLM tels que GPT-3.5 et Code-Llama, améliorant ainsi les performances de génération de tâches de LLM. Dans le même temps, la réalisabilité des tâches est mesurée quantitativement grâce à une formation stratégique, et des statistiques de tâches de différents attributs et des comparaisons de codes entre différents modèles sont fournies.

De plus, les chercheurs ont également formé des stratégies de robots multitâches qui se sont bien généralisées sur toutes les tâches de génération et ont amélioré les performances zéro par rapport aux modèles formés uniquement sur les performances de généralisation humaine. Une formation conjointe avec la tâche de génération GPT-4 peut améliorer les performances de généralisation de 50 % et transférer environ 40 % des tâches zéro-shot vers de nouvelles tâches dans les simulations.

Enfin, les chercheurs ont également envisagé le transfert de la simulation au réel, montrant que la pré-formation sur différentes tâches de simulation peut améliorer de 25 % la capacité de généralisation dans le monde réel.

En résumé, les politiques formées sur les tâches générées par différents LLM parviennent à une meilleure généralisation au niveau des tâches à de nouvelles tâches, soulignant le potentiel d'étendre les tâches simulées via LLM pour former les politiques de base.

Shubham Saboo, directeur de la gestion des produits chez Tenstorrent AI, a fait l'éloge de cette recherche. Il a déclaré qu'il s'agissait d'une recherche révolutionnaire sur GPT-4 combinée à des robots, utilisant un LLM tel que GPT-4 pour générer une série de tâches robotiques simulées. sur pilote automatique, faisant de l'apprentissage sans tir et de l'adaptation des robots au monde réel une réalité.

Introduction à la méthode

Comme le montre la figure 2 ci-dessous, le framework GenSim génère des environnements de simulation, des tâches et des démonstrations via la synthèse de programmes. Le pipeline GenSim démarre à partir du créateur de la tâche et la chaîne d'invites s'exécute en deux modes, le mode orienté vers un objectif et le mode exploratoire, en fonction de la tâche cible. La bibliothèque de tâches de GenSim est un composant en mémoire utilisé pour stocker des tâches de haute qualité générées précédemment. Les tâches stockées dans la bibliothèque de tâches peuvent être utilisées pour la formation aux politiques multitâches ou pour affiner le LLM.

Créateur de tâches

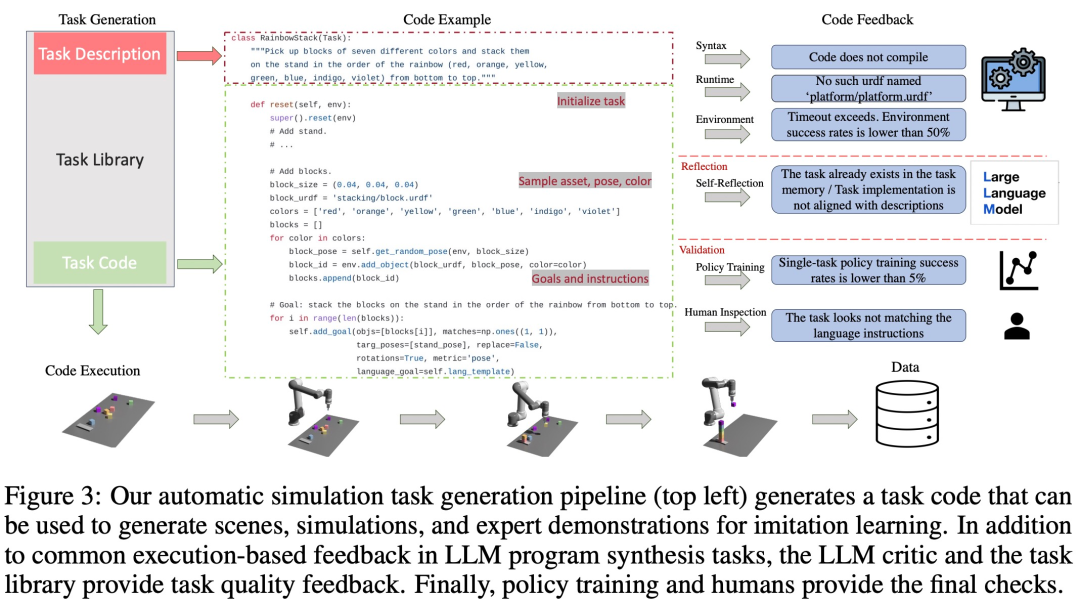

Comme le montre la figure 3 ci-dessous, la chaîne de langage générera d'abord la description de la tâche, puis générera l'implémentation associée. La description de la tâche comprend le nom de la tâche, les ressources et le résumé de la tâche. Cette étude utilise quelques exemples d'invites dans le pipeline pour générer du code.

Bibliothèque de tâches

La bibliothèque de tâches du framework GenSim stocke les tâches générées par le créateur de tâches pour générer de meilleures nouvelles tâches et former des stratégies multitâches. La bibliothèque de tâches est initialisée en fonction des tâches issues de benchmarks créés manuellement.

La bibliothèque de tâches fournit au créateur de la tâche la description de la tâche précédente comme condition pour la phase de génération de description, et le code précédent pour la phase de génération de code, et invite le créateur de la tâche à sélectionner la tâche de référence dans la bibliothèque de tâches comme l'exemple de tâche d'écriture d'une nouvelle tâche. Une fois la mise en œuvre de la tâche terminée et tous les tests réussis, LLM est invité à « réfléchir » à la nouvelle tâche et à la bibliothèque de tâches, et à prendre une décision globale quant à savoir si la tâche nouvellement générée doit être ajoutée à la bibliothèque.

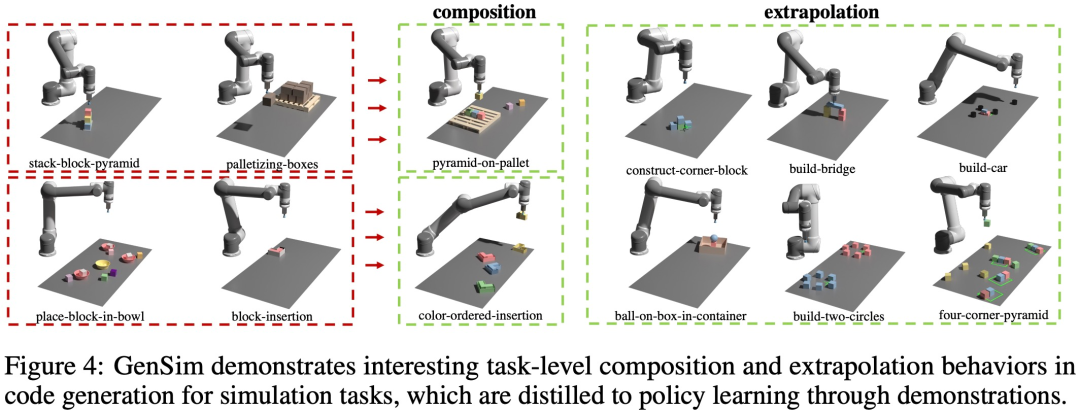

Comme le montre la figure 4 ci-dessous, l'étude a également observé que GenSim présente un comportement intéressant de combinaison et d'extrapolation au niveau des tâches :

Comme le montre la figure 5 ci-dessous, cette étude considère le programme comme une représentation efficace de la tâche et des données de démonstration associées (Figure 5). Il est possible de définir l'espace d'intégration entre les tâches, et son indice de distance est sensible à. divers facteurs liés à la perception (tels que la pose et la forme de l'objet) sont plus robustes.

Expériences et résultats

Cette étude valide le cadre GenSim par des expériences, ciblant les questions spécifiques suivantes : (1) Quelle est l'efficacité du LLM dans la conception et la mise en œuvre de tâches de simulation ? GenSim peut-il améliorer les performances du LLM dans la génération de tâches ? (2) La formation sur les tâches générées par LLM peut-elle améliorer la capacité de généralisation des politiques ? La formation politique bénéficierait-elle davantage si elle lui confiait davantage de tâches de génération ? (3) La pré-formation sur les tâches de simulation générées par LLM est-elle bénéfique pour le déploiement de politiques robotiques dans le monde réel ?

Cette étude valide le cadre GenSim par des expériences, ciblant les questions spécifiques suivantes : (1) Quelle est l'efficacité du LLM dans la conception et la mise en œuvre de tâches de simulation ? GenSim peut-il améliorer les performances du LLM dans la génération de tâches ? (2) La formation sur les tâches générées par LLM peut-elle améliorer la capacité de généralisation des politiques ? La formation politique bénéficierait-elle davantage si elle lui confiait davantage de tâches de génération ? (3) La pré-formation sur les tâches de simulation générées par LLM est-elle bénéfique pour le déploiement de politiques robotiques dans le monde réel ?

Évaluer la capacité de généralisation des tâches de simulation de robot LLM

Comme le montre la figure 6 ci-dessous, pour la génération de tâches en mode exploration et en mode orienté objectif, la chaîne d'invites en deux étapes de quelques échantillons et d'une bibliothèque de tâches peut améliorer efficacement le taux de réussite de la génération de code.

Généralisation au niveau des tâches

Optimisation de la stratégie en quelques étapes pour les tâches associées. Comme on peut l'observer sur le côté gauche de la figure 7 ci-dessous, la formation conjointe des tâches générées par LLM peut améliorer les performances de la politique sur la tâche CLIPort d'origine de plus de 50 %, en particulier dans les situations de faibles données (telles que 5 démos). Généralisation de la politique Zero-shot aux tâches invisibles. Comme le montre la figure 7, en pré-entraînant sur davantage de tâches générées par LLM, notre modèle peut mieux se généraliser aux tâches du benchmark Ravens d'origine. Au milieu à droite de la figure 7, les chercheurs se sont également pré-entraînés sur 5 tâches sur différentes sources de tâches, y compris des tâches écrites manuellement, des LLM à source fermée et des LLM affinés à source ouverte, et ont observé un niveau de tâche zéro similaire. généralisation. Adapter le modèle pré-entraîné au monde réel Les chercheurs ont transféré les stratégies entraînées dans l'environnement simulé à l'environnement réel. Les résultats sont présentés dans le tableau 1 ci-dessous. Le modèle pré-entraîné sur 70 tâches générées par GPT-4 a mené 10 expériences sur 9 tâches et a atteint un taux de réussite moyen de 68,8 %, ce qui est meilleur que la pré-entraînement sur la tâche CLIPort uniquement. Par rapport au modèle de base, il s'est amélioré de plus de 25 %, et par rapport au modèle pré-entraîné sur seulement 50 tâches, il s'est amélioré de 15 %. Les chercheurs ont également observé que la pré-formation sur différentes tâches de simulation améliorait la robustesse des tâches complexes à long terme. Par exemple, les modèles pré-entraînés GPT-4 affichent des performances plus robustes sur les tâches de construction réelles. Expérience d'ablation Taux de réussite de l'entraînement par simulation. Dans le tableau 2 ci-dessous, les chercheurs démontrent les taux de réussite de la formation politique à tâche unique et multitâche sur un sous-ensemble de tâches générées avec 200 démos. Pour la formation aux politiques sur les tâches de génération GPT-4, son taux de réussite moyen des tâches est de 75,8 % pour les tâches uniques et de 74,1 % pour les tâches multiples. Générer des statistiques de tâches. Dans la figure 9 (a) ci-dessous, le chercheur montre les statistiques de tâches de différentes caractéristiques des 120 tâches générées par LLM. Il existe un équilibre intéressant entre les couleurs, les actifs, les actions et le nombre d'instances générées par le modèle LLM. Par exemple, le code généré contient de nombreuses scènes avec plus de 7 instances d'objet, ainsi que de nombreuses actions primitives de sélection et de placement et des actifs tels que des blocs. Comparaison de génération de code. Dans la figure 9 (b) ci-dessous, les chercheurs évaluent qualitativement les cas d'échec dans les expériences descendantes de GPT-4 et Code Llama. Veuillez vous référer au document original pour plus de détails techniques.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

Utilisez ddrescue pour récupérer des données sous Linux

Mar 20, 2024 pm 01:37 PM

Utilisez ddrescue pour récupérer des données sous Linux

Mar 20, 2024 pm 01:37 PM

DDREASE est un outil permettant de récupérer des données à partir de périphériques de fichiers ou de blocs tels que des disques durs, des SSD, des disques RAM, des CD, des DVD et des périphériques de stockage USB. Il copie les données d'un périphérique bloc à un autre, laissant derrière lui les blocs corrompus et ne déplaçant que les bons blocs. ddreasue est un puissant outil de récupération entièrement automatisé car il ne nécessite aucune interruption pendant les opérations de récupération. De plus, grâce au fichier map ddasue, il peut être arrêté et repris à tout moment. Les autres fonctionnalités clés de DDREASE sont les suivantes : Il n'écrase pas les données récupérées mais comble les lacunes en cas de récupération itérative. Cependant, il peut être tronqué si l'outil est invité à le faire explicitement. Récupérer les données de plusieurs fichiers ou blocs en un seul

Open source! Au-delà de ZoeDepth ! DepthFM : estimation rapide et précise de la profondeur monoculaire !

Apr 03, 2024 pm 12:04 PM

Open source! Au-delà de ZoeDepth ! DepthFM : estimation rapide et précise de la profondeur monoculaire !

Apr 03, 2024 pm 12:04 PM

0. À quoi sert cet article ? Nous proposons DepthFM : un modèle d'estimation de profondeur monoculaire génératif de pointe, polyvalent et rapide. En plus des tâches traditionnelles d'estimation de la profondeur, DepthFM démontre également des capacités de pointe dans les tâches en aval telles que l'inpainting en profondeur. DepthFM est efficace et peut synthétiser des cartes de profondeur en quelques étapes d'inférence. Lisons ce travail ensemble ~ 1. Titre des informations sur l'article : DepthFM : FastMonocularDepthEstimationwithFlowMatching Auteur : MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas entre officiellement dans l’ère des robots électriques ! Hier, l'Atlas hydraulique s'est retiré "en larmes" de la scène de l'histoire. Aujourd'hui, Boston Dynamics a annoncé que l'Atlas électrique était au travail. Il semble que dans le domaine des robots humanoïdes commerciaux, Boston Dynamics soit déterminé à concurrencer Tesla. Après la sortie de la nouvelle vidéo, elle a déjà été visionnée par plus d’un million de personnes en seulement dix heures. Les personnes âgées partent et de nouveaux rôles apparaissent. C'est une nécessité historique. Il ne fait aucun doute que cette année est l’année explosive des robots humanoïdes. Les internautes ont commenté : Les progrès des robots ont fait ressembler la cérémonie d'ouverture de cette année à des êtres humains, et le degré de liberté est bien plus grand que celui des humains. Mais n'est-ce vraiment pas un film d'horreur ? Au début de la vidéo, Atlas est allongé calmement sur le sol, apparemment sur le dos. Ce qui suit est à couper le souffle

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Les performances de JAX, promu par Google, ont dépassé celles de Pytorch et TensorFlow lors de récents tests de référence, se classant au premier rang sur 7 indicateurs. Et le test n’a pas été fait sur le TPU présentant les meilleures performances JAX. Bien que parmi les développeurs, Pytorch soit toujours plus populaire que Tensorflow. Mais à l’avenir, des modèles plus volumineux seront peut-être formés et exécutés sur la base de la plate-forme JAX. Modèles Récemment, l'équipe Keras a comparé trois backends (TensorFlow, JAX, PyTorch) avec l'implémentation native de PyTorch et Keras2 avec TensorFlow. Premièrement, ils sélectionnent un ensemble de

La vitalité de la super intelligence s'éveille ! Mais avec l'arrivée de l'IA qui se met à jour automatiquement, les mères n'ont plus à se soucier des goulots d'étranglement des données.

Apr 29, 2024 pm 06:55 PM

La vitalité de la super intelligence s'éveille ! Mais avec l'arrivée de l'IA qui se met à jour automatiquement, les mères n'ont plus à se soucier des goulots d'étranglement des données.

Apr 29, 2024 pm 06:55 PM

Je pleure à mort. Le monde construit à la folie de grands modèles. Les données sur Internet ne suffisent pas du tout. Le modèle de formation ressemble à « The Hunger Games », et les chercheurs en IA du monde entier se demandent comment nourrir ces personnes avides de données. Ce problème est particulièrement important dans les tâches multimodales. À une époque où rien ne pouvait être fait, une équipe de start-up du département de l'Université Renmin de Chine a utilisé son propre nouveau modèle pour devenir la première en Chine à faire de « l'auto-alimentation des données générées par le modèle » une réalité. De plus, il s’agit d’une approche à deux volets, du côté compréhension et du côté génération, les deux côtés peuvent générer de nouvelles données multimodales de haute qualité et fournir un retour de données au modèle lui-même. Qu'est-ce qu'un modèle ? Awaker 1.0, un grand modèle multimodal qui vient d'apparaître sur le Forum Zhongguancun. Qui est l'équipe ? Moteur Sophon. Fondé par Gao Yizhao, doctorant à la Hillhouse School of Artificial Intelligence de l’Université Renmin.

Vitesse Internet lente des données cellulaires sur iPhone : correctifs

May 03, 2024 pm 09:01 PM

Vitesse Internet lente des données cellulaires sur iPhone : correctifs

May 03, 2024 pm 09:01 PM

Vous êtes confronté à un décalage et à une connexion de données mobile lente sur iPhone ? En règle générale, la puissance de l'Internet cellulaire sur votre téléphone dépend de plusieurs facteurs tels que la région, le type de réseau cellulaire, le type d'itinérance, etc. Vous pouvez prendre certaines mesures pour obtenir une connexion Internet cellulaire plus rapide et plus fiable. Correctif 1 – Forcer le redémarrage de l'iPhone Parfois, le redémarrage forcé de votre appareil réinitialise simplement beaucoup de choses, y compris la connexion cellulaire. Étape 1 – Appuyez simplement une fois sur la touche d’augmentation du volume et relâchez-la. Ensuite, appuyez sur la touche de réduction du volume et relâchez-la à nouveau. Étape 2 – La partie suivante du processus consiste à maintenir le bouton sur le côté droit. Laissez l'iPhone finir de redémarrer. Activez les données cellulaires et vérifiez la vitesse du réseau. Vérifiez à nouveau Correctif 2 – Changer le mode de données Bien que la 5G offre de meilleures vitesses de réseau, elle fonctionne mieux lorsque le signal est plus faible

La version Kuaishou de Sora 'Ke Ling' est ouverte aux tests : génère plus de 120 s de vidéo, comprend mieux la physique et peut modéliser avec précision des mouvements complexes

Jun 11, 2024 am 09:51 AM

La version Kuaishou de Sora 'Ke Ling' est ouverte aux tests : génère plus de 120 s de vidéo, comprend mieux la physique et peut modéliser avec précision des mouvements complexes

Jun 11, 2024 am 09:51 AM

Quoi? Zootopie est-elle concrétisée par l’IA domestique ? Avec la vidéo est exposé un nouveau modèle de génération vidéo domestique à grande échelle appelé « Keling ». Sora utilise une voie technique similaire et combine un certain nombre d'innovations technologiques auto-développées pour produire des vidéos qui comportent non seulement des mouvements larges et raisonnables, mais qui simulent également les caractéristiques du monde physique et possèdent de fortes capacités de combinaison conceptuelle et d'imagination. Selon les données, Keling prend en charge la génération de vidéos ultra-longues allant jusqu'à 2 minutes à 30 ips, avec des résolutions allant jusqu'à 1080p, et prend en charge plusieurs formats d'image. Un autre point important est que Keling n'est pas une démo ou une démonstration de résultats vidéo publiée par le laboratoire, mais une application au niveau produit lancée par Kuaishou, un acteur leader dans le domaine de la vidéo courte. De plus, l'objectif principal est d'être pragmatique, de ne pas faire de chèques en blanc et de se mettre en ligne dès sa sortie. Le grand modèle de Ke Ling est déjà sorti à Kuaiying.

L'US Air Force présente son premier avion de combat IA de grande envergure ! Le ministre a personnellement effectué l'essai routier sans intervenir pendant tout le processus, et 100 000 lignes de code ont été testées 21 fois.

May 07, 2024 pm 05:00 PM

L'US Air Force présente son premier avion de combat IA de grande envergure ! Le ministre a personnellement effectué l'essai routier sans intervenir pendant tout le processus, et 100 000 lignes de code ont été testées 21 fois.

May 07, 2024 pm 05:00 PM

Récemment, le milieu militaire a été submergé par la nouvelle : les avions de combat militaires américains peuvent désormais mener des combats aériens entièrement automatiques grâce à l'IA. Oui, tout récemment, l’avion de combat IA de l’armée américaine a été rendu public pour la première fois, dévoilant ainsi son mystère. Le nom complet de ce chasseur est Variable Stability Simulator Test Aircraft (VISTA). Il a été personnellement piloté par le secrétaire de l'US Air Force pour simuler une bataille aérienne en tête-à-tête. Le 2 mai, le secrétaire de l'US Air Force, Frank Kendall, a décollé à bord d'un X-62AVISTA à la base aérienne d'Edwards. Notez que pendant le vol d'une heure, toutes les actions de vol ont été effectuées de manière autonome par l'IA ! Kendall a déclaré : "Au cours des dernières décennies, nous avons réfléchi au potentiel illimité du combat air-air autonome, mais cela a toujours semblé hors de portée." Mais maintenant,