Périphériques technologiques

Périphériques technologiques

IA

IA

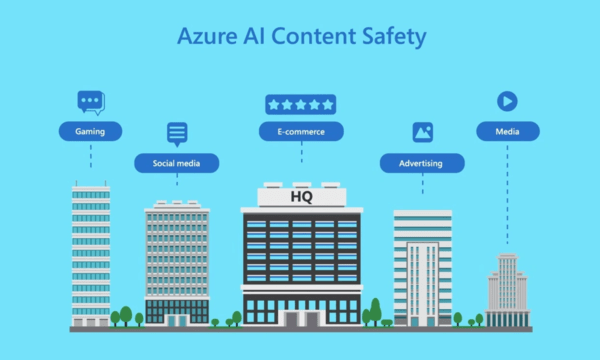

Microsoft lance un outil de modération de contenu IA appelé Azure AI Content Safety

Microsoft lance un outil de modération de contenu IA appelé Azure AI Content Safety

Microsoft lance un outil de modération de contenu IA appelé Azure AI Content Safety

[CNMO News] Après plusieurs mois de tests, Microsoft a récemment officiellement publié l'outil de révision de contenu AI Azure AI Content Safety. Il est rapporté que ce produit est un outil de modération de contenu qu'il a commencé à tester en mai de cette année. Il contient une série de modèles d'IA entraînés qui peuvent détecter le contenu négatif lié aux préjugés, à la haine, à la violence, etc. dans les images ou les textes, et peuvent le faire. comprendre et détecter Contient des images ou du texte en huit langues.

De plus, l'outil de modération attribue un score de gravité au contenu signalé et guide les évaluateurs humains sur le contenu qui nécessite une action. Initialement, cet outil d'audit était intégré au service Azure OpenAI, mais il sera désormais lancé en tant que système autonome

Mentionné dans le billet de blog officiel de Microsoft : "Cela signifie que les utilisateurs peuvent l'appliquer au contenu d'intelligence artificielle généré par des modèles open source et d'autres modèles d'entreprise, et peuvent également appeler certains contenus générés par les utilisateurs pour améliorer encore leur utilité."

Microsoft a déclaré que même si le produit s'est amélioré dans la gestion des données et du contenu et peut comprendre le contexte de manière plus équitable, il doit toujours s'appuyer sur des évaluateurs humains pour signaler les données et le contenu. Cela signifie également que la justice ultime appartient aux humains. Cependant, les évaluateurs humains peuvent ne pas être complètement neutres et prudents lors du traitement des données et du contenu en raison de préjugés personnelsCe qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

J'ai essayé le codage d'ambiance avec Cursor Ai et c'est incroyable!

Mar 20, 2025 pm 03:34 PM

J'ai essayé le codage d'ambiance avec Cursor Ai et c'est incroyable!

Mar 20, 2025 pm 03:34 PM

Le codage des ambiances est de remodeler le monde du développement de logiciels en nous permettant de créer des applications en utilisant le langage naturel au lieu de lignes de code sans fin. Inspirée par des visionnaires comme Andrej Karpathy, cette approche innovante permet de dev

Top 5 Genai Lunets de février 2025: GPT-4.5, Grok-3 et plus!

Mar 22, 2025 am 10:58 AM

Top 5 Genai Lunets de février 2025: GPT-4.5, Grok-3 et plus!

Mar 22, 2025 am 10:58 AM

Février 2025 a été un autre mois qui change la donne pour une IA générative, nous apportant certaines des mises à niveau des modèles les plus attendues et de nouvelles fonctionnalités révolutionnaires. De Xai's Grok 3 et Anthropic's Claude 3.7 Sonnet, à Openai's G

Comment utiliser YOLO V12 pour la détection d'objets?

Mar 22, 2025 am 11:07 AM

Comment utiliser YOLO V12 pour la détection d'objets?

Mar 22, 2025 am 11:07 AM

Yolo (vous ne regardez qu'une seule fois) a été un cadre de détection d'objets en temps réel de premier plan, chaque itération améliorant les versions précédentes. La dernière version Yolo V12 introduit des progrès qui améliorent considérablement la précision

Sora vs Veo 2: Laquelle crée des vidéos plus réalistes?

Mar 10, 2025 pm 12:22 PM

Sora vs Veo 2: Laquelle crée des vidéos plus réalistes?

Mar 10, 2025 pm 12:22 PM

Veo 2 de Google et Sora d'Openai: Quel générateur de vidéos AI règne en suprême? Les deux plates-formes génèrent des vidéos d'IA impressionnantes, mais leurs forces se trouvent dans différents domaines. Cette comparaison, en utilisant diverses invites, révèle quel outil répond le mieux à vos besoins. T

Google & # 039; s Gencast: Prévision météorologique avec Mini démo Gencast

Mar 16, 2025 pm 01:46 PM

Google & # 039; s Gencast: Prévision météorologique avec Mini démo Gencast

Mar 16, 2025 pm 01:46 PM

Gencast de Google Deepmind: une IA révolutionnaire pour les prévisions météorologiques Les prévisions météorologiques ont subi une transformation spectaculaire, passant des observations rudimentaires aux prédictions sophistiquées alimentées par l'IA. Gencast de Google Deepmind, un terreau

Chatgpt 4 o est-il disponible?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4 o est-il disponible?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4 est actuellement disponible et largement utilisé, démontrant des améliorations significatives dans la compréhension du contexte et la génération de réponses cohérentes par rapport à ses prédécesseurs comme Chatgpt 3.5. Les développements futurs peuvent inclure un interg plus personnalisé

Quelle IA est la meilleure que Chatgpt?

Mar 18, 2025 pm 06:05 PM

Quelle IA est la meilleure que Chatgpt?

Mar 18, 2025 pm 06:05 PM

L'article traite des modèles d'IA dépassant Chatgpt, comme Lamda, Llama et Grok, mettant en évidence leurs avantages en matière de précision, de compréhension et d'impact de l'industrie. (159 caractères)

O1 vs GPT-4O: le nouveau modèle Openai est-il meilleur que GPT-4O?

Mar 16, 2025 am 11:47 AM

O1 vs GPT-4O: le nouveau modèle Openai est-il meilleur que GPT-4O?

Mar 16, 2025 am 11:47 AM

O1'S O1: Une vague de cadeaux de 12 jours commence par leur modèle le plus puissant à ce jour L'arrivée de décembre apporte un ralentissement mondial, les flocons de neige dans certaines parties du monde, mais Openai ne fait que commencer. Sam Altman et son équipe lancent un cadeau de don de 12 jours