Périphériques technologiques

Périphériques technologiques

IA

IA

Les textes longs peuvent être lus avec une longueur de fenêtre de 4k. Chen Danqi et ses disciples se sont associés à Meta pour lancer une nouvelle méthode permettant d'améliorer la mémoire des grands modèles.

Les textes longs peuvent être lus avec une longueur de fenêtre de 4k. Chen Danqi et ses disciples se sont associés à Meta pour lancer une nouvelle méthode permettant d'améliorer la mémoire des grands modèles.

Les textes longs peuvent être lus avec une longueur de fenêtre de 4k. Chen Danqi et ses disciples se sont associés à Meta pour lancer une nouvelle méthode permettant d'améliorer la mémoire des grands modèles.

Un grand modèle avec seulement une longueur de fenêtre de 4k peut toujours lire de grandes sections de texte !

Une dernière réalisation d'un doctorant chinois à Princeton a réussi à « franchir » la limite de la longueur de la fenêtre des grands modèles.

Non seulement il peut répondre à diverses questions, mais l'ensemble du processus de mise en œuvre peut être entièrement complété par une invite, sans aucune formation supplémentaire.

L'équipe de recherche a créé une stratégie de mémoire arborescente appelée MemWalker, qui peut dépasser la limite de longueur de fenêtre du modèle lui-même.

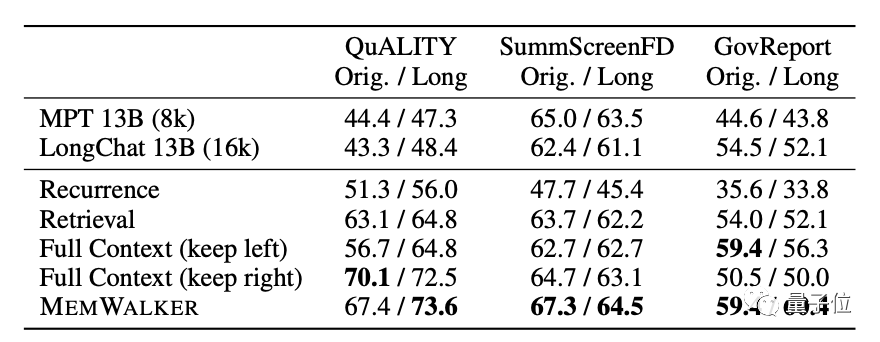

Pendant le test, le texte le plus long lu par le modèle contenait plus de 12 000 jetons, et les résultats ont été considérablement améliorés par rapport à LongChat.

Comparé au TreeIndex similaire, MemWalker peut raisonner et répondre à n'importe quelle question au lieu de simplement faire des généralisations.

MemWalker a été développé en utilisant l'idée de "diviser pour régner". Certains internautes ont commenté :

Chaque fois que nous faisons en sorte que le processus de réflexion des grands modèles ressemble davantage à celui des humains, leurs performances seront meilleures

Donc , Quelle est exactement la stratégie de mémoire arborescente et comment lire un texte long avec une longueur de fenêtre limitée ?

Si une fenêtre ne suffit pas, ouvrez-en quelques autres

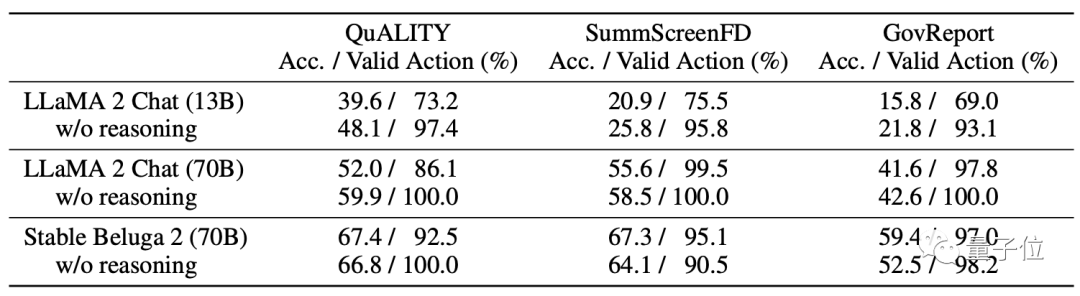

Sur le modèle, MemWalker utilise Stable Beluga 2 comme modèle de base, qui est obtenu par Llama 2-70B après réglage des commandes.

Avant de sélectionner ce modèle, les développeurs ont comparé ses performances avec celles du Llama 2 original et ont finalement opté pour celui-ci.

Tout comme le nom MemWalker, son processus de travail est comme un flux de mémoire qui marche.

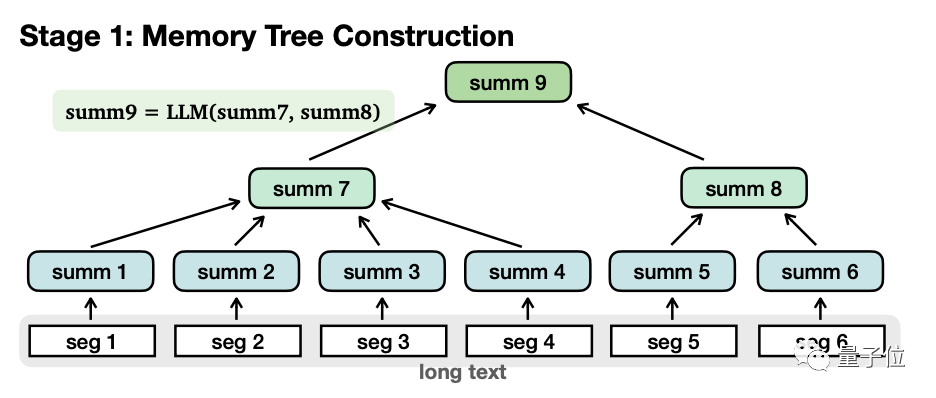

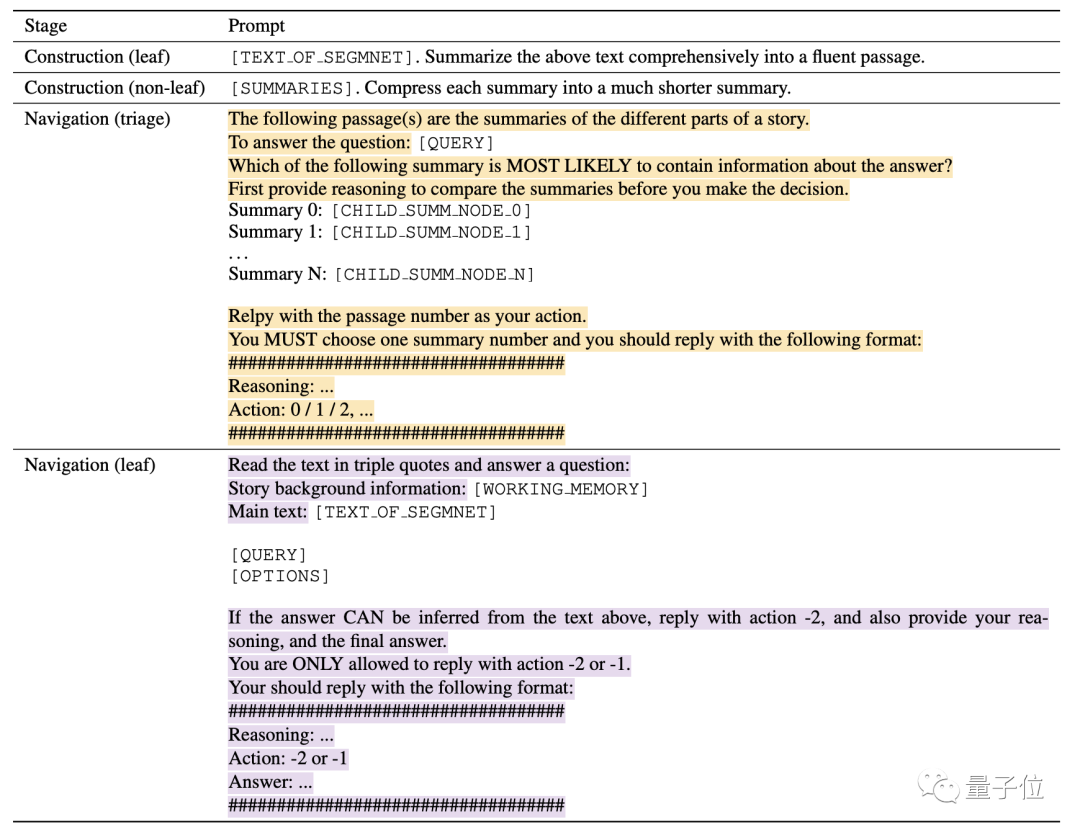

Plus précisément, il est grossièrement divisé en deux étapes : Construction de l'arbre mémoire et Récupération de navigation.

Lors de la construction d'un arbre de mémoire, le texte long sera divisé en plusieurs petits segments (seg1-6), et le grand modèle résumera chaque segment séparément et obtiendra "nœuds feuilles" (nœuds feuilles, été 1-6).

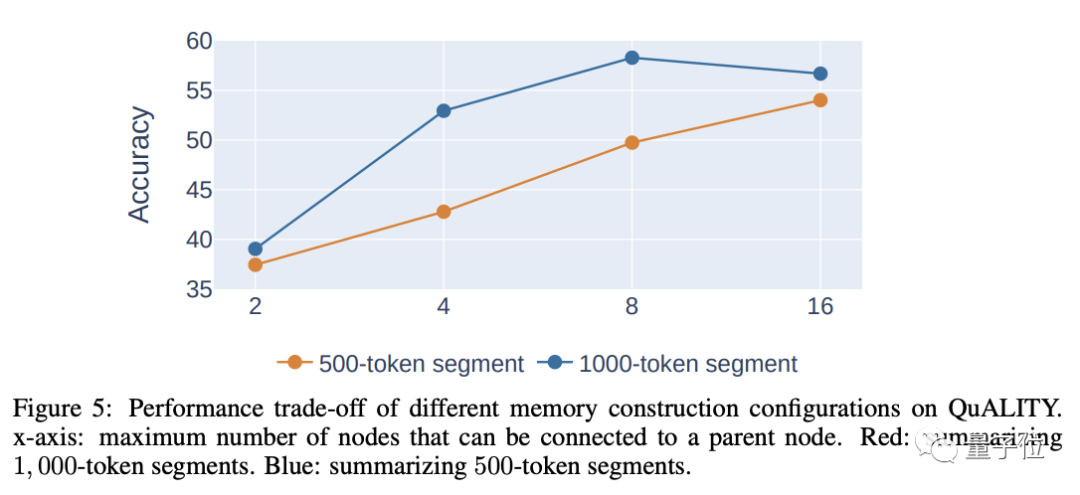

Lors de la segmentation, plus la longueur de chaque segment est longue, moins il y aura de niveaux, ce qui est bénéfique pour la récupération ultérieure. Cependant, être trop long entraînera une diminution de la précision, des considérations approfondies sont donc nécessaires pour déterminer la longueur. de chaque segment.

L'auteur estime que la longueur raisonnable de chaque paragraphe est de 500 à 2 000 jetons, et celle utilisée dans l'expérience est de 1 000 jetons.

Ensuite, le modèle résume à nouveau de manière récursive le contenu de ces nœuds feuilles pour former des "nœuds non-feuilles"(nœuds non-feuilles, summ7-8).

Une autre différence entre les deux est que les nœuds feuilles contiennent des informations originales, tandis que les nœuds non-feuilles n'ont que des informations secondaires résumées par .

Fonctionnellement, les nœuds non-feuilles sont utilisés pour naviguer et localiser les nœuds feuilles où se trouve la réponse, tandis que les nœuds feuilles sont utilisés pour raisonner sur la réponse.

Les nœuds non-feuilles peuvent avoir plusieurs niveaux, et le modèle est progressivement résumé jusqu'à ce que le « nœud racine » soit obtenu pour former une structure arborescente complète.

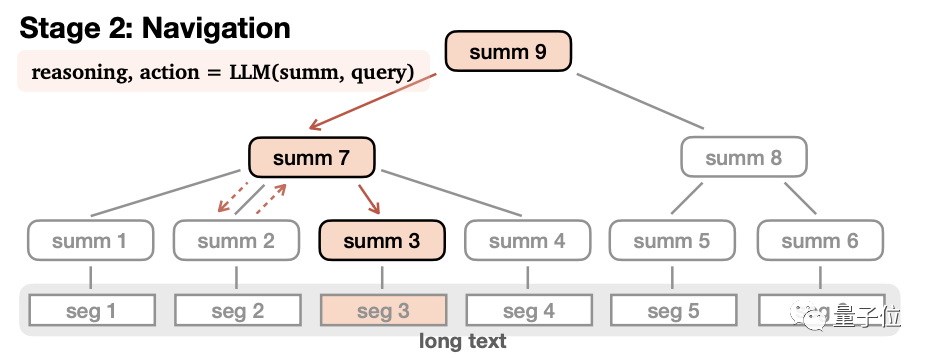

Une fois l'arborescence de mémoire établie, vous pouvez entrer dans l'étape de récupération de navigation pour générer des réponses.

Dans ce processus, le modèle part du nœud racine, lit le contenu des sous-nœuds de premier niveau un par un, puis déduit s'il doit entrer dans ce nœud ou revenir.

Après avoir décidé d'entrer dans ce nœud, répétez le processus jusqu'à ce que le nœud feuille soit lu. Si le contenu du nœud feuille est adapté, la réponse est générée, sinon elle est renvoyée. Afin de garantir l'exhaustivité de la réponse, la condition finale de ce processus n'est pas qu'un nœud feuille approprié soit trouvé, mais que le modèle pense qu'une réponse complète est obtenue ou que le nombre maximum d'étapes est atteint. Pendant le processus de navigation, si le modèle constate qu'il s'est trompé de chemin, il peut également revenir en arrière.De plus, MemWalker introduit également un mécanisme de mémoire de travail pour améliorer la précision.

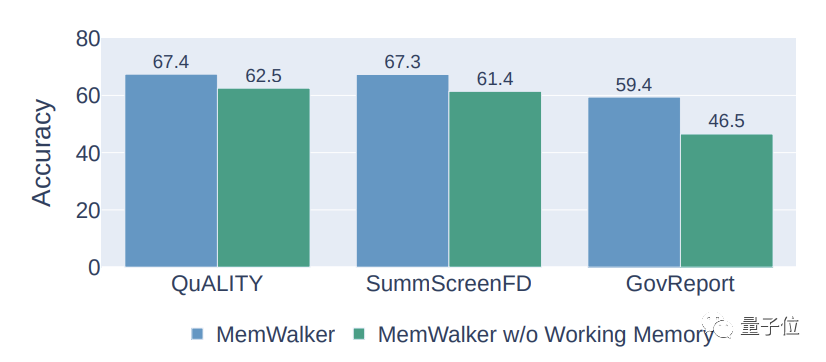

Ce mécanisme ajoutera le contenu du nœud qui a été visité au contexte du contenu actuel.

Lorsque le modèle entre dans un nouveau nœud, le contenu actuel du nœud sera ajouté à la mémoire.

Ce mécanisme permet au modèle d'utiliser le contenu des nœuds visités à chaque étape pour éviter la perte d'informations importantes.

Les résultats expérimentaux montrent que le mécanisme de mémoire de travail peut augmenter la précision de MemWalker d'environ 10 %.

De plus, le processus mentionné ci-dessus ne peut être complété qu'en s'appuyant sur des invites, et aucune formation supplémentaire n'est requise.

Théoriquement, MemWalker peut lire un texte infiniment long tant qu'il dispose de suffisamment de puissance de calcul.

Cependant, la complexité temporelle et spatiale de la construction de l'arbre de mémoire augmente de façon exponentielle à mesure que la longueur du texte augmente.

À propos de l'auteur

Le premier auteur de l'article est Howard Chen, un doctorant chinois au laboratoire de PNL de l'Université de Princeton.

Chen Danqi, ancienne élève de la classe Tsinghua Yao, est le mentor de Howard, et son rapport académique sur l'ACL cette année était également lié à la recherche.

Ce résultat a été complété par Howard lors de son stage à Meta Trois chercheurs, Ramakanth Pasunuru, Jason Weston et Asli Celikyilmaz du Meta AI Laboratory ont également participé à ce projet.

Adresse papier : https://arxiv.org/abs/2310.05029

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Traiter efficacement 7 millions d'enregistrements et créer des cartes interactives avec la technologie géospatiale. Cet article explore comment traiter efficacement plus de 7 millions d'enregistrements en utilisant Laravel et MySQL et les convertir en visualisations de cartes interactives. Exigences initiales du projet de défi: extraire des informations précieuses en utilisant 7 millions d'enregistrements dans la base de données MySQL. Beaucoup de gens considèrent d'abord les langages de programmation, mais ignorent la base de données elle-même: peut-il répondre aux besoins? La migration des données ou l'ajustement structurel est-il requis? MySQL peut-il résister à une charge de données aussi importante? Analyse préliminaire: les filtres et les propriétés clés doivent être identifiés. Après analyse, il a été constaté que seuls quelques attributs étaient liés à la solution. Nous avons vérifié la faisabilité du filtre et établi certaines restrictions pour optimiser la recherche. Recherche de cartes basée sur la ville

Comment définir le délai de Vue Axios

Apr 07, 2025 pm 10:03 PM

Comment définir le délai de Vue Axios

Apr 07, 2025 pm 10:03 PM

Afin de définir le délai d'expiration de Vue Axios, nous pouvons créer une instance AxiOS et spécifier l'option Timeout: dans les paramètres globaux: vue.prototype. $ Axios = axios.create ({timeout: 5000}); Dans une seule demande: ce. $ axios.get ('/ api / utilisateurs', {timeout: 10000}).

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Il existe de nombreuses raisons pour lesquelles la startup MySQL échoue, et elle peut être diagnostiquée en vérifiant le journal des erreurs. Les causes courantes incluent les conflits de port (vérifier l'occupation du port et la configuration de modification), les problèmes d'autorisation (vérifier le service exécutant les autorisations des utilisateurs), les erreurs de fichier de configuration (vérifier les paramètres des paramètres), la corruption du répertoire de données (restaurer les données ou reconstruire l'espace de la table), les problèmes d'espace de la table InNODB (vérifier les fichiers IBDATA1), la défaillance du chargement du plug-in (vérification du journal des erreurs). Lors de la résolution de problèmes, vous devez les analyser en fonction du journal d'erreur, trouver la cause profonde du problème et développer l'habitude de sauvegarder régulièrement les données pour prévenir et résoudre des problèmes.

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

L'article présente le fonctionnement de la base de données MySQL. Tout d'abord, vous devez installer un client MySQL, tel que MySQLWorkBench ou le client de ligne de commande. 1. Utilisez la commande MySQL-UROot-P pour vous connecter au serveur et connecter avec le mot de passe du compte racine; 2. Utilisez Createdatabase pour créer une base de données et utilisez Sélectionner une base de données; 3. Utilisez CreateTable pour créer une table, définissez des champs et des types de données; 4. Utilisez InsertInto pour insérer des données, remettre en question les données, mettre à jour les données par mise à jour et supprimer les données par Supprimer. Ce n'est qu'en maîtrisant ces étapes, en apprenant à faire face à des problèmes courants et à l'optimisation des performances de la base de données que vous pouvez utiliser efficacement MySQL.

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Ingénieur backend à distance Emploi Vacant Société: Emplacement du cercle: Bureau à distance Type d'emploi: Salaire à temps plein: 130 000 $ - 140 000 $ Description du poste Participez à la recherche et au développement des applications mobiles Circle et des fonctionnalités publiques liées à l'API couvrant l'intégralité du cycle de vie de développement logiciel. Les principales responsabilités complètent indépendamment les travaux de développement basés sur RubyOnRails et collaborent avec l'équipe frontale React / Redux / Relay. Créez les fonctionnalités de base et les améliorations des applications Web et travaillez en étroite collaboration avec les concepteurs et le leadership tout au long du processus de conception fonctionnelle. Promouvoir les processus de développement positifs et hiérarchiser la vitesse d'itération. Nécessite plus de 6 ans de backend d'applications Web complexe

Mysql peut-il renvoyer JSON

Apr 08, 2025 pm 03:09 PM

Mysql peut-il renvoyer JSON

Apr 08, 2025 pm 03:09 PM

MySQL peut renvoyer les données JSON. La fonction JSON_Extract extrait les valeurs de champ. Pour les requêtes complexes, envisagez d'utiliser la clause pour filtrer les données JSON, mais faites attention à son impact sur les performances. Le support de MySQL pour JSON augmente constamment, et il est recommandé de faire attention aux dernières versions et fonctionnalités.

Comprendre les propriétés acides: les piliers d'une base de données fiable

Apr 08, 2025 pm 06:33 PM

Comprendre les propriétés acides: les piliers d'une base de données fiable

Apr 08, 2025 pm 06:33 PM

Une explication détaillée des attributs d'acide de base de données Les attributs acides sont un ensemble de règles pour garantir la fiabilité et la cohérence des transactions de base de données. Ils définissent comment les systèmes de bases de données gérent les transactions et garantissent l'intégrité et la précision des données même en cas de plantages système, d'interruptions d'alimentation ou de plusieurs utilisateurs d'accès simultanément. Présentation de l'attribut acide Atomicité: une transaction est considérée comme une unité indivisible. Toute pièce échoue, la transaction entière est reculée et la base de données ne conserve aucune modification. Par exemple, si un transfert bancaire est déduit d'un compte mais pas augmenté à un autre, toute l'opération est révoquée. BeginTransaction; UpdateAccountSsetBalance = Balance-100Wh

La clé principale de MySQL peut être nul

Apr 08, 2025 pm 03:03 PM

La clé principale de MySQL peut être nul

Apr 08, 2025 pm 03:03 PM

La clé primaire MySQL ne peut pas être vide car la clé principale est un attribut de clé qui identifie de manière unique chaque ligne dans la base de données. Si la clé primaire peut être vide, l'enregistrement ne peut pas être identifié de manière unique, ce qui entraînera une confusion des données. Lorsque vous utilisez des colonnes entières ou des UUIdes auto-incrémentales comme clés principales, vous devez considérer des facteurs tels que l'efficacité et l'occupation de l'espace et choisir une solution appropriée.