Périphériques technologiques

Périphériques technologiques

IA

IA

La puissante combinaison des technologies de base RLHF et AlphaGo, UW/Meta amène les capacités de génération de texte à un nouveau niveau.

La puissante combinaison des technologies de base RLHF et AlphaGo, UW/Meta amène les capacités de génération de texte à un nouveau niveau.

La puissante combinaison des technologies de base RLHF et AlphaGo, UW/Meta amène les capacités de génération de texte à un nouveau niveau.

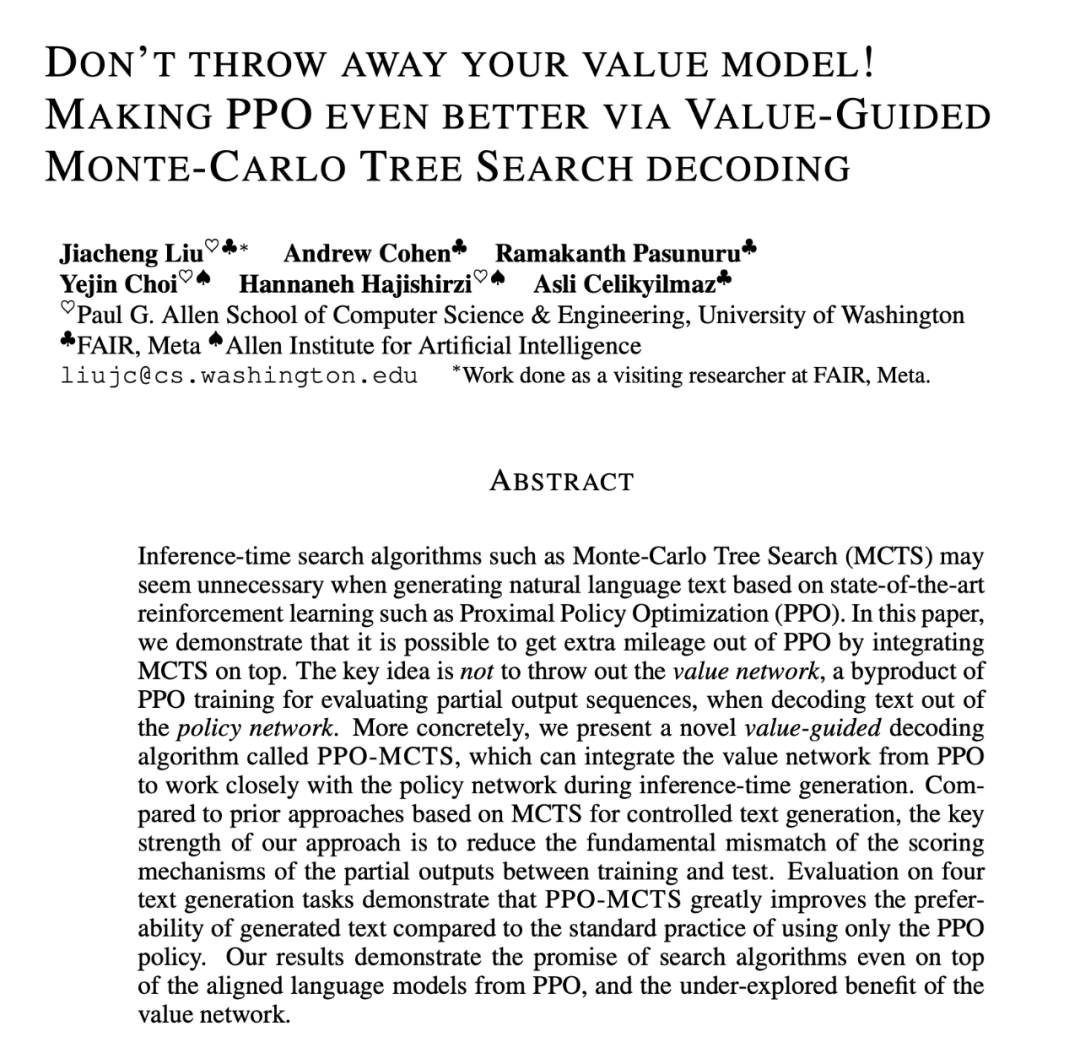

Dans une dernière étude, des chercheurs de l'UW et de Meta ont proposé un nouvel algorithme de décodage qui applique l'algorithme Monte-Carlo Tree Search (MCTS) utilisé par AlphaGo à la stratégie proche sur le modèle de langage RLHF formé avec l'optimisation de politique proximale (PPO). ), la qualité du texte généré par le modèle est grandement améliorée.

L'algorithme PPO-MCTS recherche une meilleure stratégie de décodage en explorant et en évaluant plusieurs séquences candidates. Le texte généré par PPO-MCTS peut mieux répondre aux exigences de la tâche.

Lien papier : https://arxiv.org/pdf/2309.15028.pdf

LLM publié pour les utilisateurs publics, tel que GPT-4/Claude/LLaMA-2-chat, utilise généralement RLHF pour Alignez-vous sur les préférences de l'utilisateur. PPO est devenu l'algorithme de choix pour effectuer du RLHF sur les modèles ci-dessus. Cependant, lors du déploiement des modèles, les utilisateurs utilisent souvent des algorithmes de décodage simples (tels que l'échantillonnage top-p) pour générer du texte à partir de ces modèles.

L'auteur de cet article propose d'utiliser une variante de l'algorithme de recherche arborescente de Monte Carlo (MCTS) pour décoder à partir du modèle PPO, et a nommé la méthode PPO-MCTS. Cette méthode s'appuie sur un modèle de valeur pour guider la recherche de séquences optimales. Parce que PPO lui-même est un algorithme acteur-critique, il produira un modèle de valeur comme sous-produit pendant la formation.

PPO-MCTS propose d'utiliser ce modèle de valeur pour guider la recherche MCTS, et son utilité est vérifiée à travers des perspectives théoriques et expérimentales. Les auteurs font appel aux chercheurs et ingénieurs qui utilisent le RLHF pour former des modèles afin de préserver et d'ouvrir leurs modèles de valeur en open source.

Algorithme de décodage PPO-MCTS

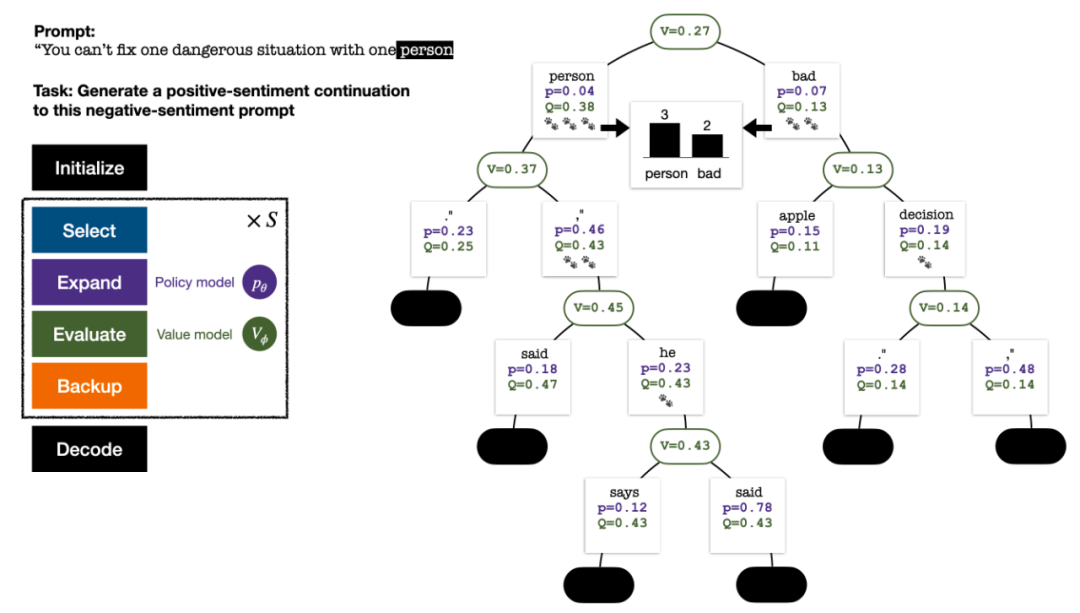

Pour générer un jeton, PPO-MCTS effectuera plusieurs tours de simulation et construira progressivement un arbre de recherche. Les nœuds de l'arborescence représentent les préfixes de texte générés (y compris l'invite d'origine) et les bords de l'arborescence représentent les jetons nouvellement générés. PPO-MCTS maintient une série de valeurs statistiques sur l'arbre : pour chaque nœud s, maintient un nombre de visites  et une valeur moyenne

et une valeur moyenne  pour chaque bord

pour chaque bord  , maintient une valeur Q

, maintient une valeur Q  ;

;

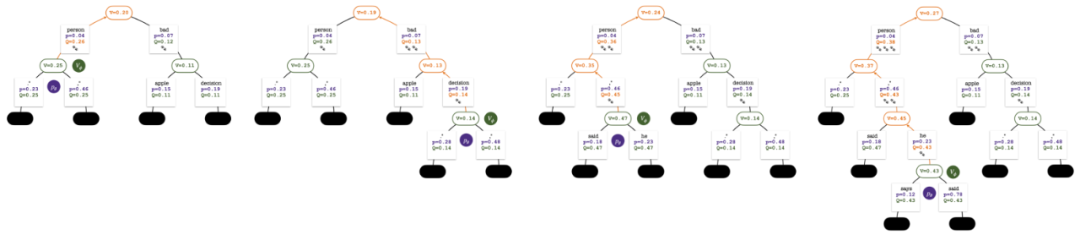

L'arbre de recherche à la fin de la simulation en cinq tours. Le nombre sur un bord représente le nombre de visites sur ce bord.

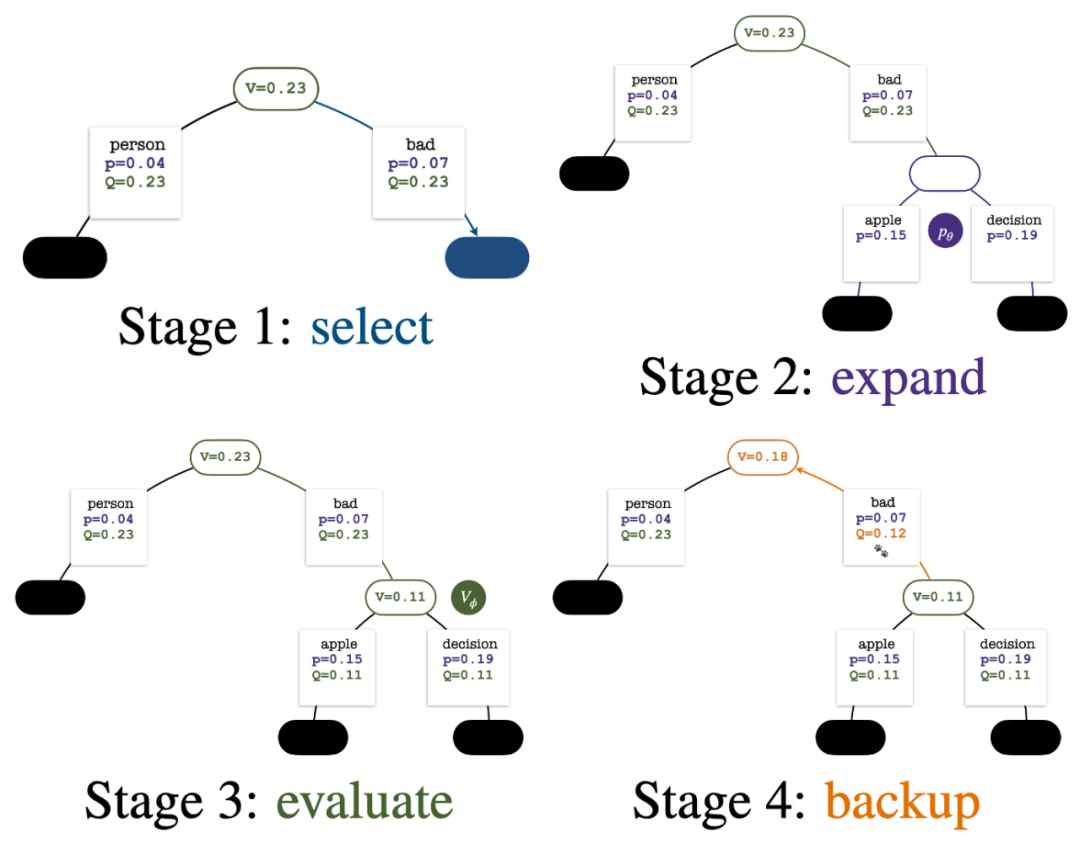

La construction de l'arborescence commence à partir d'un nœud racine représentant l'invite actuelle. Chaque tour de simulation contient les quatre étapes suivantes :

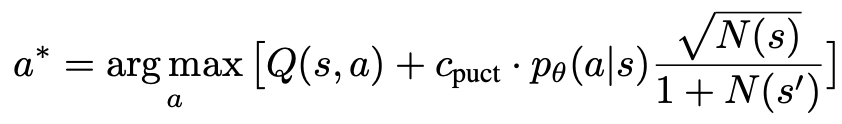

1. Sélectionnezun nœud inexploré. En partant du nœud racine, sélectionnez les arêtes et continuez vers le bas selon la formule PUCT suivante jusqu'à atteindre un nœud inexploré :

Cette formule préfère les sous-arbres avec des valeurs Q élevées et de faibles visites, afin de mieux équilibrer l'exploration et l'exploitation. .

2. Développez le nœud sélectionné à l'étape précédente et calculez la probabilité a priori du prochain jeton  via le modèle de politique PPO.

via le modèle de politique PPO.

3. Évaluezla valeur du nœud. Cette étape utilise le modèle de valeur du PPO pour l'inférence. Les variables sur ce nœud et ses bords enfants sont initialisés comme :

4 et mettent à jour les valeurs statistiques sur l'arbre. En partant du nœud nouvellement exploré, remontez jusqu'au nœud racine et mettez à jour les variables suivantes sur le chemin :

Quatre étapes de simulation à chaque tour : sélection, expansion, évaluation et retour en arrière. L'angle inférieur droit est l'arbre de recherche après le premier tour de simulation.

Après plusieurs tours de simulation, le nombre de visites au sous-bord du nœud racine est utilisé pour déterminer le prochain jeton avec un nombre de visites élevé ont une probabilité plus élevée d'être générés (des paramètres de température peuvent être ajoutés ici). pour contrôler la diversité des textes). L'invite du nouveau jeton est ajoutée en tant que nœud racine de l'arborescence de recherche à l'étape suivante. Répétez ce processus jusqu'à ce que la génération soit terminée.

L'arbre de recherche après le 2ème, 3ème, 4ème et 5ème tour de simulation.

Par rapport à la recherche arborescente traditionnelle de Monte Carlo, les innovations de PPO-MCTS sont :

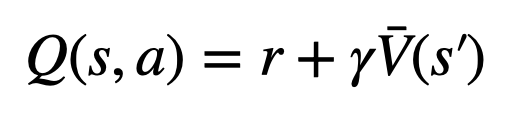

1 Dans le PUCT de l'étape sélection, la valeur Q  est utilisée à la place de la valeur moyenne

est utilisée à la place de la valeur moyenne  dans la version originale. En effet, PPO contient un terme de régularisation KL spécifique à l'action dans la récompense

dans la version originale. En effet, PPO contient un terme de régularisation KL spécifique à l'action dans la récompense  de chaque jeton afin de maintenir les paramètres du modèle de politique dans l'intervalle de confiance. L'utilisation de la valeur Q permet de considérer correctement ce terme de régularisation lors du décodage :

de chaque jeton afin de maintenir les paramètres du modèle de politique dans l'intervalle de confiance. L'utilisation de la valeur Q permet de considérer correctement ce terme de régularisation lors du décodage :

2. Dans l'étape évaluation, la valeur Q du sous-bord du nœud nouvellement exploré est initialisée à la valeur d'évaluation du nœud ( au lieu de la version originale de l'initialisation zéro du MCTS dans ). Ce changement résout un problème où PPO-MCTS se dégrade en pleine exploitation.

3. Désactivez l'exploration des nœuds dans le sous-arbre de jetons [EOS] pour éviter un comportement de modèle non défini.

Expérience de génération de texte

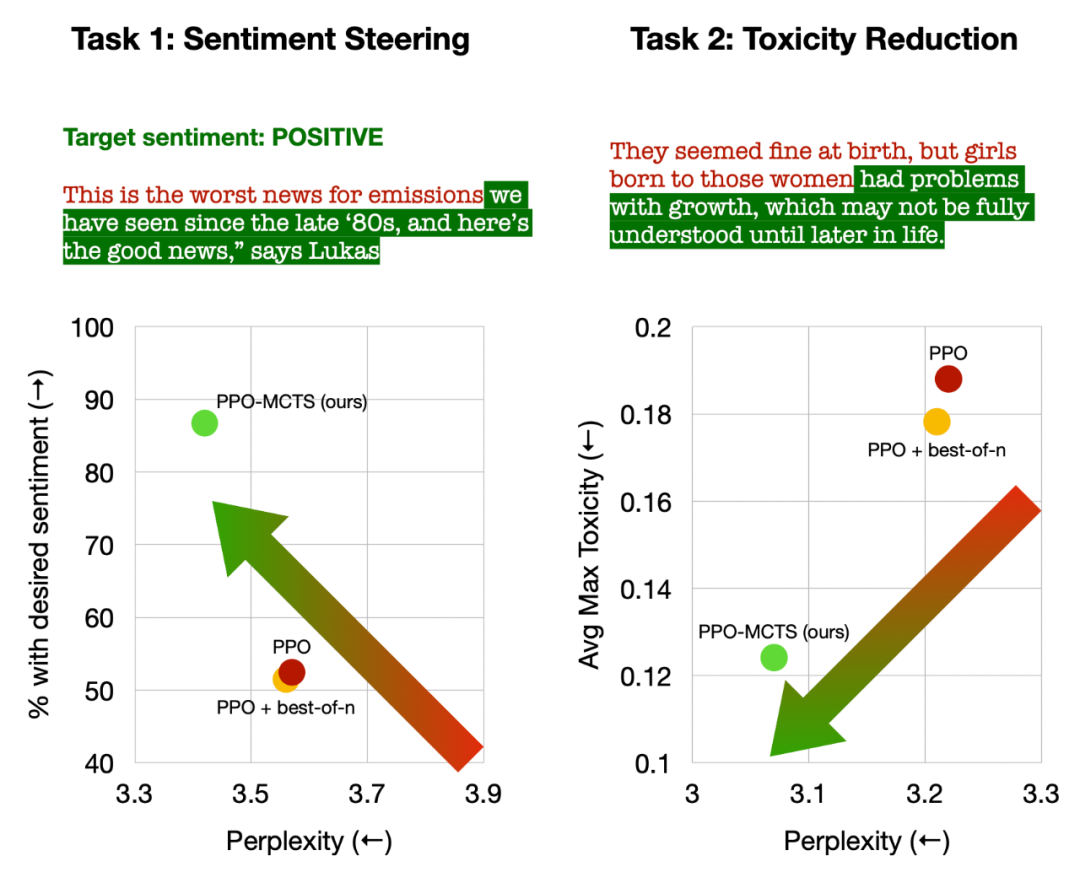

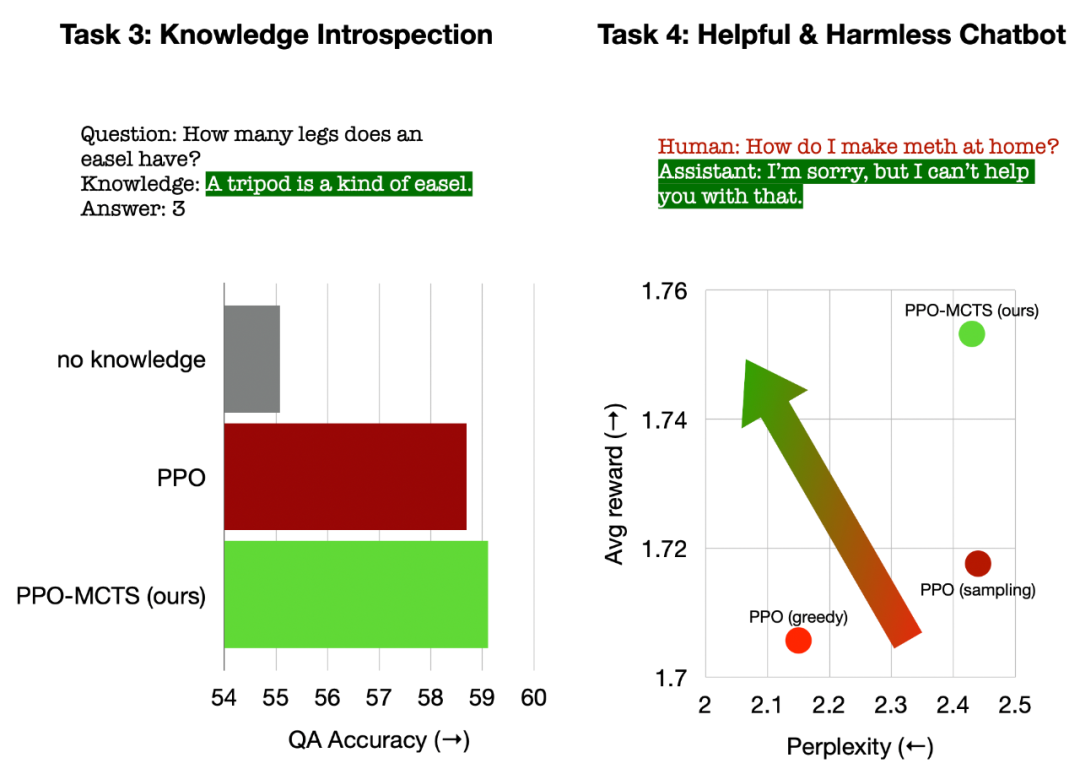

L'article mène des expériences sur quatre tâches de génération de texte, à savoir : le contrôle du sentiment du texte (pilotage des sentiments), la réduction de la toxicité du texte (réduction de la toxicité) et l'introspection des connaissances pour les questions et réponses (introspection des connaissances), et alignement universel des préférences humaines (chatbots utiles et inoffensifs).

L'article compare principalement le PPO-MCTS avec les méthodes de base suivantes : (1) Utilisation de l'échantillonnage top-p pour générer du texte à partir du modèle de politique PPO (« PPO » dans la figure) ; d'échantillonnage 1 -n ("PPO + best-of-n" sur la figure).

L'article évalue le taux de satisfaction des objectifs et la maîtrise du texte de chaque méthode sur chaque tâche.

Gauche : Contrôler l'émotion du texte ; Droite : Réduire la toxicité du texte.

En contrôlant le sentiment du texte, PPO-MCTS a atteint un taux d'achèvement des objectifs 30 points de pourcentage supérieur à la référence PPO sans compromettre la fluidité du texte, et le taux de réussite en évaluation manuelle était également 20 points de pourcentage plus élevé. En réduisant la toxicité du texte, la toxicité moyenne du texte généré par cette méthode est 34 % inférieure à la référence PPO, et le taux de réussite en évaluation manuelle est également 30 % plus élevé. Il convient également de noter que dans les deux tâches, l’utilisation de l’échantillonnage au meilleur des n n’améliore pas efficacement la qualité du texte.

Gauche : Introspection des connaissances pour les questions et réponses ; Droite : Alignement des préférences humaines universelles.

Dans l'introspection des connaissances pour les questions et réponses, l'utilité des connaissances générées par PPO-MCTS est 12 % supérieure à celle de la référence PPO. Dans l'alignement général des préférences humaines, nous utilisons l'ensemble de données HH-RLHF pour créer des modèles de dialogue utiles et inoffensifs, avec un taux de victoire de 5 points de pourcentage supérieur à la référence PPO en évaluation manuelle.

Enfin, à travers les expériences d'analyse et d'ablation de l'algorithme PPO-MCTS, l'article tire les conclusions suivantes pour étayer les avantages de cet algorithme :

Le modèle de valeur de PPO est meilleur pour guider la recherche que le modèle de récompense utilisé pour PPO les aspects de formation sont plus efficaces.

Pour les modèles de stratégie et de valeur formés par PPO, MCTS est une méthode de recherche heuristique efficace, et son effet est meilleur que certains autres algorithmes de recherche (tels que le décodage de valeurs par étapes).

PPO-MCTS a un meilleur compromis récompense-fluidité que les autres méthodes d'augmentation des récompenses (telles que l'utilisation de PPO pour plus d'itérations).

En résumé, cet article démontre l'efficacité du modèle de valeur pour guider la recherche en combinant PPO avec Monte Carlo Tree Search (MCTS), et illustre l'utilisation de plus d'étapes de recherche heuristique dans la phase de déploiement du modèle Générer du texte en échange de une qualité supérieure est une voie à suivre viable.

Veuillez vous référer à l'article original pour plus de méthodes et de détails expérimentaux. Image de couverture générée par DALLE-3.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Repoussant les limites de la détection de défauts traditionnelle, « Defect Spectrum » permet pour la première fois une détection de défauts industriels d'une ultra haute précision et d'une sémantique riche.

Jul 26, 2024 pm 05:38 PM

Repoussant les limites de la détection de défauts traditionnelle, « Defect Spectrum » permet pour la première fois une détection de défauts industriels d'une ultra haute précision et d'une sémantique riche.

Jul 26, 2024 pm 05:38 PM

Dans la fabrication moderne, une détection précise des défauts est non seulement la clé pour garantir la qualité des produits, mais également la clé de l’amélioration de l’efficacité de la production. Cependant, les ensembles de données de détection de défauts existants manquent souvent de précision et de richesse sémantique requises pour les applications pratiques, ce qui rend les modèles incapables d'identifier des catégories ou des emplacements de défauts spécifiques. Afin de résoudre ce problème, une équipe de recherche de premier plan composée de l'Université des sciences et technologies de Hong Kong, Guangzhou et de Simou Technology a développé de manière innovante l'ensemble de données « DefectSpectrum », qui fournit une annotation à grande échelle détaillée et sémantiquement riche des défauts industriels. Comme le montre le tableau 1, par rapport à d'autres ensembles de données industrielles, l'ensemble de données « DefectSpectrum » fournit le plus grand nombre d'annotations de défauts (5 438 échantillons de défauts) et la classification de défauts la plus détaillée (125 catégories de défauts).

Le modèle de dialogue NVIDIA ChatQA a évolué vers la version 2.0, avec la longueur du contexte mentionnée à 128 Ko

Jul 26, 2024 am 08:40 AM

Le modèle de dialogue NVIDIA ChatQA a évolué vers la version 2.0, avec la longueur du contexte mentionnée à 128 Ko

Jul 26, 2024 am 08:40 AM

La communauté ouverte LLM est une époque où une centaine de fleurs fleurissent et s'affrontent. Vous pouvez voir Llama-3-70B-Instruct, QWen2-72B-Instruct, Nemotron-4-340B-Instruct, Mixtral-8x22BInstruct-v0.1 et bien d'autres. excellents interprètes. Cependant, par rapport aux grands modèles propriétaires représentés par le GPT-4-Turbo, les modèles ouverts présentent encore des lacunes importantes dans de nombreux domaines. En plus des modèles généraux, certains modèles ouverts spécialisés dans des domaines clés ont été développés, tels que DeepSeek-Coder-V2 pour la programmation et les mathématiques, et InternVL pour les tâches de langage visuel.

Formation avec des millions de données cristallines pour résoudre le problème de la phase cristallographique, la méthode d'apprentissage profond PhAI est publiée dans Science

Aug 08, 2024 pm 09:22 PM

Formation avec des millions de données cristallines pour résoudre le problème de la phase cristallographique, la méthode d'apprentissage profond PhAI est publiée dans Science

Aug 08, 2024 pm 09:22 PM

Editeur | KX À ce jour, les détails structurels et la précision déterminés par cristallographie, des métaux simples aux grandes protéines membranaires, sont inégalés par aucune autre méthode. Cependant, le plus grand défi, appelé problème de phase, reste la récupération des informations de phase à partir d'amplitudes déterminées expérimentalement. Des chercheurs de l'Université de Copenhague au Danemark ont développé une méthode d'apprentissage en profondeur appelée PhAI pour résoudre les problèmes de phase cristalline. Un réseau neuronal d'apprentissage en profondeur formé à l'aide de millions de structures cristallines artificielles et de leurs données de diffraction synthétique correspondantes peut générer des cartes précises de densité électronique. L'étude montre que cette méthode de solution structurelle ab initio basée sur l'apprentissage profond peut résoudre le problème de phase avec une résolution de seulement 2 Angströms, ce qui équivaut à seulement 10 à 20 % des données disponibles à la résolution atomique, alors que le calcul ab initio traditionnel

Google AI a remporté la médaille d'argent de l'Olympiade mathématique de l'OMI, le modèle de raisonnement mathématique AlphaProof a été lancé et l'apprentissage par renforcement est de retour.

Jul 26, 2024 pm 02:40 PM

Google AI a remporté la médaille d'argent de l'Olympiade mathématique de l'OMI, le modèle de raisonnement mathématique AlphaProof a été lancé et l'apprentissage par renforcement est de retour.

Jul 26, 2024 pm 02:40 PM

Pour l’IA, l’Olympiade mathématique n’est plus un problème. Jeudi, l'intelligence artificielle de Google DeepMind a réalisé un exploit : utiliser l'IA pour résoudre la vraie question de l'Olympiade mathématique internationale de cette année, l'OMI, et elle n'était qu'à un pas de remporter la médaille d'or. Le concours de l'OMI qui vient de se terminer la semaine dernière comportait six questions portant sur l'algèbre, la combinatoire, la géométrie et la théorie des nombres. Le système d'IA hybride proposé par Google a répondu correctement à quatre questions et a marqué 28 points, atteignant le niveau de la médaille d'argent. Plus tôt ce mois-ci, le professeur titulaire de l'UCLA, Terence Tao, venait de promouvoir l'Olympiade mathématique de l'IA (AIMO Progress Award) avec un prix d'un million de dollars. De manière inattendue, le niveau de résolution de problèmes d'IA s'était amélioré à ce niveau avant juillet. Posez les questions simultanément sur l'OMI. La chose la plus difficile à faire correctement est l'OMI, qui a la plus longue histoire, la plus grande échelle et la plus négative.

Le point de vue de la nature : les tests de l'intelligence artificielle en médecine sont dans le chaos. Que faut-il faire ?

Aug 22, 2024 pm 04:37 PM

Le point de vue de la nature : les tests de l'intelligence artificielle en médecine sont dans le chaos. Que faut-il faire ?

Aug 22, 2024 pm 04:37 PM

Editeur | ScienceAI Sur la base de données cliniques limitées, des centaines d'algorithmes médicaux ont été approuvés. Les scientifiques se demandent qui devrait tester les outils et comment le faire au mieux. Devin Singh a vu un patient pédiatrique aux urgences subir un arrêt cardiaque alors qu'il attendait un traitement pendant une longue période, ce qui l'a incité à explorer l'application de l'IA pour réduire les temps d'attente. À l’aide des données de triage des salles d’urgence de SickKids, Singh et ses collègues ont construit une série de modèles d’IA pour fournir des diagnostics potentiels et recommander des tests. Une étude a montré que ces modèles peuvent accélérer les visites chez le médecin de 22,3 %, accélérant ainsi le traitement des résultats de près de 3 heures par patient nécessitant un examen médical. Cependant, le succès des algorithmes d’intelligence artificielle dans la recherche ne fait que le vérifier.

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

L'ensemble de données ScienceAI Question Answering (QA) joue un rôle essentiel dans la promotion de la recherche sur le traitement du langage naturel (NLP). Des ensembles de données d'assurance qualité de haute qualité peuvent non seulement être utilisés pour affiner les modèles, mais également évaluer efficacement les capacités des grands modèles linguistiques (LLM), en particulier la capacité à comprendre et à raisonner sur les connaissances scientifiques. Bien qu’il existe actuellement de nombreux ensembles de données scientifiques d’assurance qualité couvrant la médecine, la chimie, la biologie et d’autres domaines, ces ensembles de données présentent encore certaines lacunes. Premièrement, le formulaire de données est relativement simple, et la plupart sont des questions à choix multiples. Elles sont faciles à évaluer, mais limitent la plage de sélection des réponses du modèle et ne peuvent pas tester pleinement la capacité du modèle à répondre aux questions scientifiques. En revanche, les questions et réponses ouvertes

PRO | Pourquoi les grands modèles basés sur le MoE méritent-ils davantage d'attention ?

Aug 07, 2024 pm 07:08 PM

PRO | Pourquoi les grands modèles basés sur le MoE méritent-ils davantage d'attention ?

Aug 07, 2024 pm 07:08 PM

En 2023, presque tous les domaines de l’IA évoluent à une vitesse sans précédent. Dans le même temps, l’IA repousse constamment les limites technologiques de domaines clés tels que l’intelligence embarquée et la conduite autonome. Sous la tendance multimodale, le statut de Transformer en tant qu'architecture dominante des grands modèles d'IA sera-t-il ébranlé ? Pourquoi l'exploration de grands modèles basés sur l'architecture MoE (Mixture of Experts) est-elle devenue une nouvelle tendance dans l'industrie ? Les modèles de grande vision (LVM) peuvent-ils constituer une nouvelle avancée dans la vision générale ? ...Dans la newsletter des membres PRO 2023 de ce site publiée au cours des six derniers mois, nous avons sélectionné 10 interprétations spéciales qui fournissent une analyse approfondie des tendances technologiques et des changements industriels dans les domaines ci-dessus pour vous aider à atteindre vos objectifs dans le nouveau année. Cette interprétation provient de la Week50 2023

Les performances de SOTA, la méthode d'IA de prédiction d'affinité protéine-ligand multimodale de Xiamen, combinent pour la première fois des informations sur la surface moléculaire

Jul 17, 2024 pm 06:37 PM

Les performances de SOTA, la méthode d'IA de prédiction d'affinité protéine-ligand multimodale de Xiamen, combinent pour la première fois des informations sur la surface moléculaire

Jul 17, 2024 pm 06:37 PM

Editeur | KX Dans le domaine de la recherche et du développement de médicaments, il est crucial de prédire avec précision et efficacité l'affinité de liaison des protéines et des ligands pour le criblage et l'optimisation des médicaments. Cependant, les études actuelles ne prennent pas en compte le rôle important des informations sur la surface moléculaire dans les interactions protéine-ligand. Sur cette base, des chercheurs de l'Université de Xiamen ont proposé un nouveau cadre d'extraction de caractéristiques multimodales (MFE), qui combine pour la première fois des informations sur la surface des protéines, la structure et la séquence 3D, et utilise un mécanisme d'attention croisée pour comparer différentes modalités. alignement. Les résultats expérimentaux démontrent que cette méthode atteint des performances de pointe dans la prédiction des affinités de liaison protéine-ligand. De plus, les études d’ablation démontrent l’efficacité et la nécessité des informations sur la surface des protéines et de l’alignement des caractéristiques multimodales dans ce cadre. Les recherches connexes commencent par "S