·Le modèle de base à grande base de troisième génération ChatGLM3 vise le mode visuel GPT-4V, qui améliore la capacité de comprendre les graphiques et les textes chinois, et dispose d'un accès amélioré à la recherche. Il peut rechercher automatiquement des informations pertinentes sur Internet en fonction de questions. et fournissez des références ou des liens d’articles lorsque vous répondez. Les modèles de test final ChatGLM3-1.5B et ChatGLM3-3B prennent en charge les téléphones mobiles et les plates-formes de véhicules Vivo, Xiaomi, Samsung.

Le 27 octobre, lors de la China Computer Conference 2023, la société chinoise de grands modèles cognitifs Beijing Zhipu Huazhang Technology Co., Ltd. (ci-après dénommée « Zhipu AI ») a lancé le grand modèle de base de troisième génération ChatGLM3, qui adopte plusieurs -prédiction améliorée par étape. La méthode de formation rend la formation plus complète et a lancé ChatGLM3-1.5B et ChatGLM3-3B qui peuvent être déployés sur les téléphones mobiles, prenant en charge une variété de téléphones mobiles et de plates-formes montées sur véhicule, notamment vivo, Xiaomi et Samsung. .

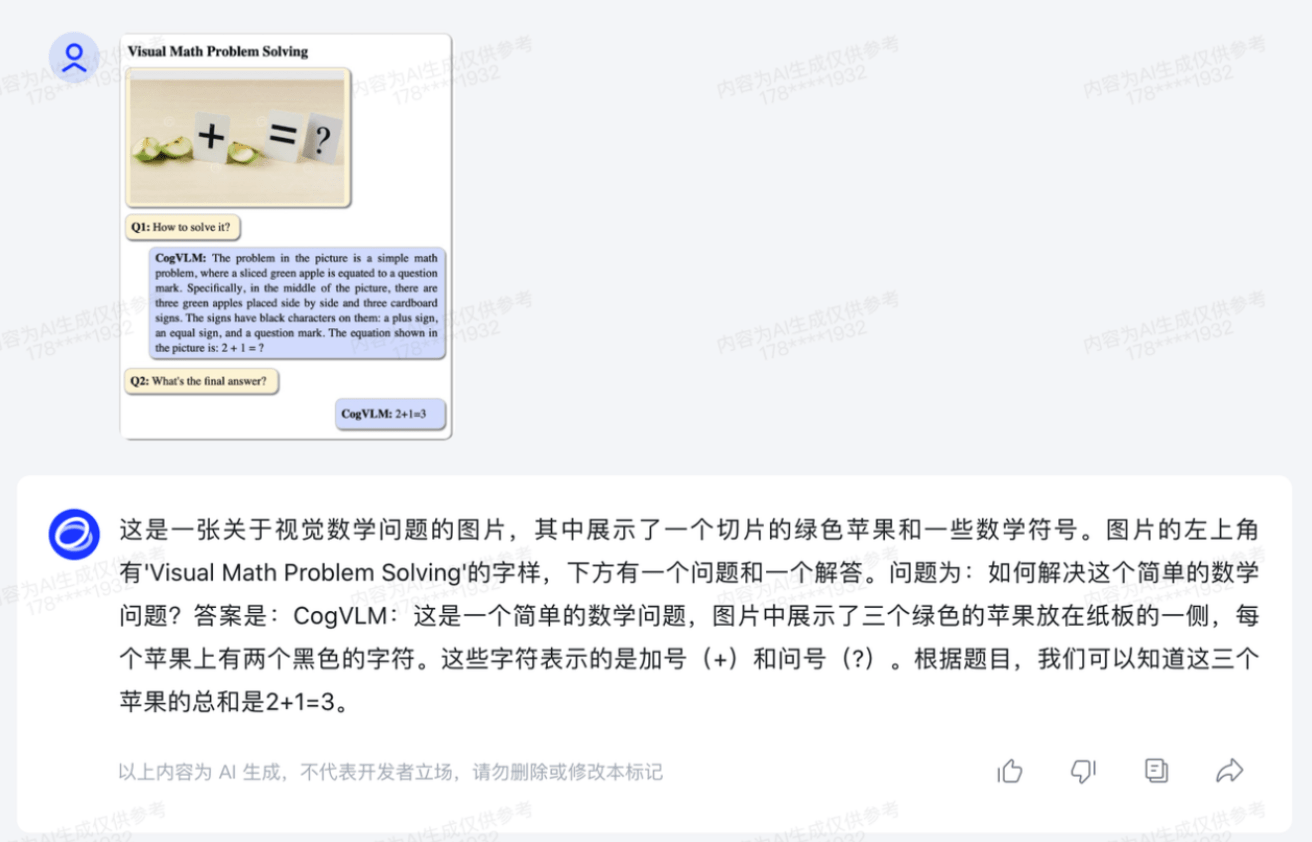

Visant le mode visuel GPT-4V, ChatGLM3 a mis en œuvre des mises à niveau itératives de plusieurs nouvelles fonctions, notamment la capacité de compréhension multimodale de CogVLM, qui a atteint SOTA (meilleures performances) sur plus de 10 ensembles de données d'évaluation d'images et de textes standards internationaux. . , État de l'art). Le modèle CogVLM améliore la compréhension des graphiques et du texte chinois, peut effectuer une détection de cible complexe et l'étiqueter pour compléter l'annotation automatique des données. Les recettes peuvent être données à partir de photos d'ingrédients et adaptées au goût de l'interlocuteur.

Les recettes sont données sur la base de photos d'ingrédients.

Zhang Peng, PDG de Zhipu AI, a déclaré à The Paper (www.thepaper.cn) que les grands modèles multimodaux ont fait de nombreux progrès concrets dans la perception interactive de la parole, de la vision et du langage naturel. -les grands modèles modaux passeront à une étape plus importante, davantage de données modales pourront être intégrées et la pré-formation multimodale conduira également à de nouvelles améliorations de l'intelligence ou des capacités cognitives des grands modèles.

Analysez le contenu de l'image.

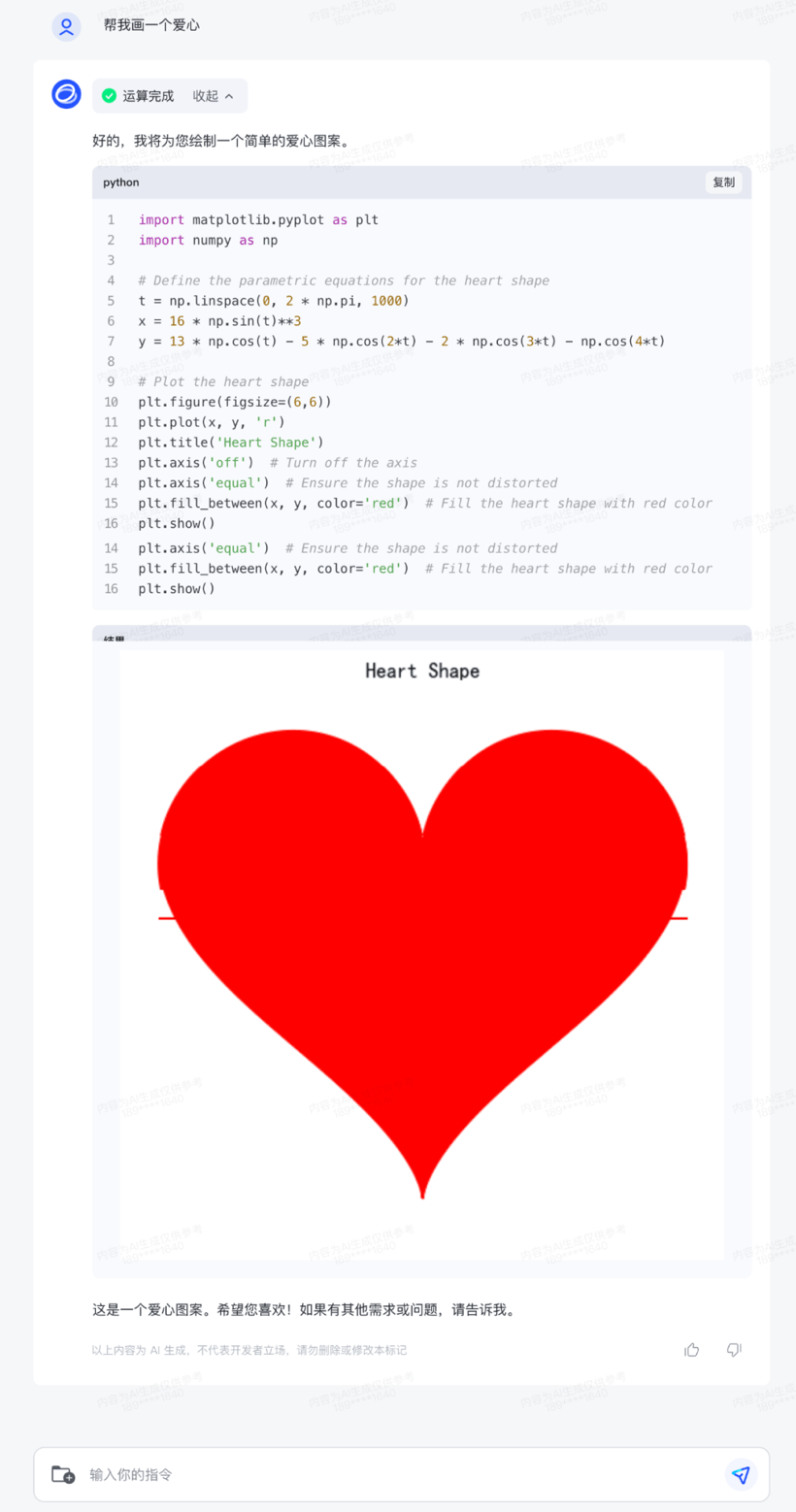

Le module d'amélioration du code de ChatGLM3, Code Interpreter, génère et exécute du code en fonction des besoins de l'utilisateur, accomplissant automatiquement des tâches complexes telles que l'analyse des données et le traitement des fichiers. La fonction « code » prend actuellement en charge le traitement d'images, les calculs mathématiques, l'analyse de données et d'autres scénarios d'utilisation.

Générez du code et exécutez-le en fonction des besoins de l'utilisateur.

Amélioration de la recherche sur le Web L'amélioration de la recherche d'accès WebGLM peut rechercher automatiquement des informations pertinentes sur Internet en fonction de questions et fournir des références ou des liens d'articles lors de la réponse.

ChatGLM3 intègre la technologie AgentTuning, active les capacités d'agent de modèle et permet aux grands modèles nationaux de prendre en charge de manière native l'invocation d'outils, l'exécution de code, les jeux, les opérations de base de données, la recherche et le raisonnement de graphiques de connaissances, les systèmes d'exploitation et d'autres scénarios.

Actuellement, ChatGLM3 a lancé les modèles de test final ChatGLM3-1.5B et ChatGLM3-3B qui peuvent être déployés sur les téléphones mobiles. Ils prennent en charge une variété de téléphones mobiles et de plates-formes montées sur véhicule, notamment Vivo, Xiaomi et Samsung. Puces CPU sur plateformes mobiles à une vitesse de 20 tokens/s.

Les modèles de test final ChatGLM3-1.5B et ChatGLM3-3B prennent en charge les téléphones mobiles et les plates-formes de véhicules Vivo, Xiaomi, Samsung.

Zhang Peng a déclaré que depuis le début de 2022, les modèles de la série GLM lancés par Zhipu AI prennent en charge la pré-formation et l'inférence à grande échelle sur les architectures Ascend, Sunway Supercomputing et Haiguang DCU. À l'heure actuelle, les produits de Zhipu AI prennent en charge plus de 10 écosystèmes matériels nationaux, et l'innovation conjointe avec les sociétés nationales de puces contribuera au développement de grands modèles natifs nationaux et de puces nationales.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Le rôle de l'attribut padding en CSS

Le rôle de l'attribut padding en CSS

Que signifie le navigateur

Que signifie le navigateur

À quel point le Dimensity 6020 est-il équivalent à Snapdragon ?

À quel point le Dimensity 6020 est-il équivalent à Snapdragon ?

Comment passer un appel sans afficher votre numéro

Comment passer un appel sans afficher votre numéro

Comment supprimer un dossier sous Linux

Comment supprimer un dossier sous Linux

plugin tencent qqmail

plugin tencent qqmail

La différence entre python et pycharm

La différence entre python et pycharm

Solution contre le virus de l'exe de dossier

Solution contre le virus de l'exe de dossier