Périphériques technologiques

Périphériques technologiques

IA

IA

GPT-4 crée un « modèle mondial », permettant au LLM d'apprendre des « mauvaises questions » et d'améliorer considérablement sa capacité de raisonnement

GPT-4 crée un « modèle mondial », permettant au LLM d'apprendre des « mauvaises questions » et d'améliorer considérablement sa capacité de raisonnement

GPT-4 crée un « modèle mondial », permettant au LLM d'apprendre des « mauvaises questions » et d'améliorer considérablement sa capacité de raisonnement

Récemment, les grands modèles de langage ont fait des percées significatives dans diverses tâches de traitement du langage naturel, en particulier dans les problèmes mathématiques qui nécessitent un raisonnement en chaîne de pensée (CoT) complexe

Par exemple, dans GSM8K, MATH, etc. Modèles propriétaires, notamment GPT -4 et PaLM-2 ont obtenu des résultats remarquables sur des ensembles de données de tâches mathématiques difficiles. À cet égard, les grands modèles open source ont encore une marge d’amélioration considérable. Pour améliorer encore les capacités d'inférence CoT des grands modèles open source pour les tâches mathématiques, une approche courante consiste à affiner ces modèles à l'aide de paires de données d'inférence question-inférence annotées/générées (données CoT) qui enseignent directement au modèle comment effectuer des tâches sur ces derniers. Effectuez l’inférence CoT pendant la tâche.

Récemment, des chercheurs de l'Université Jiaotong de Xi'an, de Microsoft et de l'Université de Pékin ont discuté d'une idée d'amélioration dans un article, qui consiste à améliorer davantage sa capacité de raisonnement grâce au processus d'apprentissage inversé (c'est-à-dire apprendre des erreurs du LLM)

Tout comme un élève qui commence à apprendre les mathématiques, il améliorera d'abord sa compréhension en étudiant les points de connaissance et les exemples du manuel. Mais en parallèle, il fait aussi des exercices pour consolider ce qu’il a appris. Lorsqu'il rencontre des difficultés ou échoue dans la résolution d'un problème, il se rend compte des erreurs qu'il a commises et apprend comment les corriger, formant ainsi un « mauvais livre de problèmes ». C'est en apprenant de ses erreurs que ses capacités de raisonnement s'améliorent encore.

Inspiré de ce processus, cet ouvrage explore comment les capacités de raisonnement d'un LLM bénéficient de la compréhension et de la correction des erreurs.

Adresse papier : https://arxiv.org/pdf/2310.20689.pdf

Plus précisément, les chercheurs ont d'abord généré des paires de données de correction d'erreur (appelées données de correction), puis ont utilisé Corriger les données pour peaufiner le LLM. Lors de la génération des données de correction : ce qui devait être réécrit, ils ont utilisé plusieurs LLM (y compris LLaMA et la famille de modèles GPT) pour collecter des chemins d'inférence inexacts (c'est-à-dire que la réponse finale était incorrecte), et ont ensuite utilisé GPT-4 comme " " Correcteur " pour générer des corrections pour ces raisonnements inexacts

Les corrections générées contiennent trois informations : (1) l'étape incorrecte dans la solution d'origine ; (2) une explication de la raison pour laquelle l'étape était incorrecte ; (3) comment corriger la solution originale pour arriver à la bonne réponse finale. Après avoir filtré les corrections avec des réponses finales incorrectes, une évaluation manuelle a montré que les données de correction présentaient une qualité suffisante pour la phase de mise au point ultérieure. Les chercheurs ont utilisé QLoRA pour affiner le LLM sur les données CoT et les données de correction, réalisant ainsi un « apprentissage à partir des erreurs » (LEMA).

La recherche montre que le LLM actuel peut utiliser une approche étape par étape pour résoudre des problèmes, mais ce processus de génération en plusieurs étapes ne signifie pas que le LLM lui-même possède de fortes capacités de raisonnement. En effet, ils ne peuvent qu'imiter le comportement superficiel du raisonnement humain sans vraiment comprendre la logique sous-jacente et les règles requises.

Ce manque de compréhension entraînera des erreurs dans le processus de raisonnement, l'aide d'un « modèle mondial » est donc nécessaire. Parce que le « modèle du monde » a a priori une conscience de la logique et des règles du monde réel. De ce point de vue, le cadre LEMA présenté dans cet article peut être considéré comme utilisant GPT-4 comme « modèle mondial » pour apprendre à des modèles plus petits à suivre ces logiques et règles, plutôt que de simplement imiter un comportement étape par étape.

Maintenant, jetons un coup d'œil aux étapes spécifiques de mise en œuvre de cette étude

Aperçu de la méthodologie

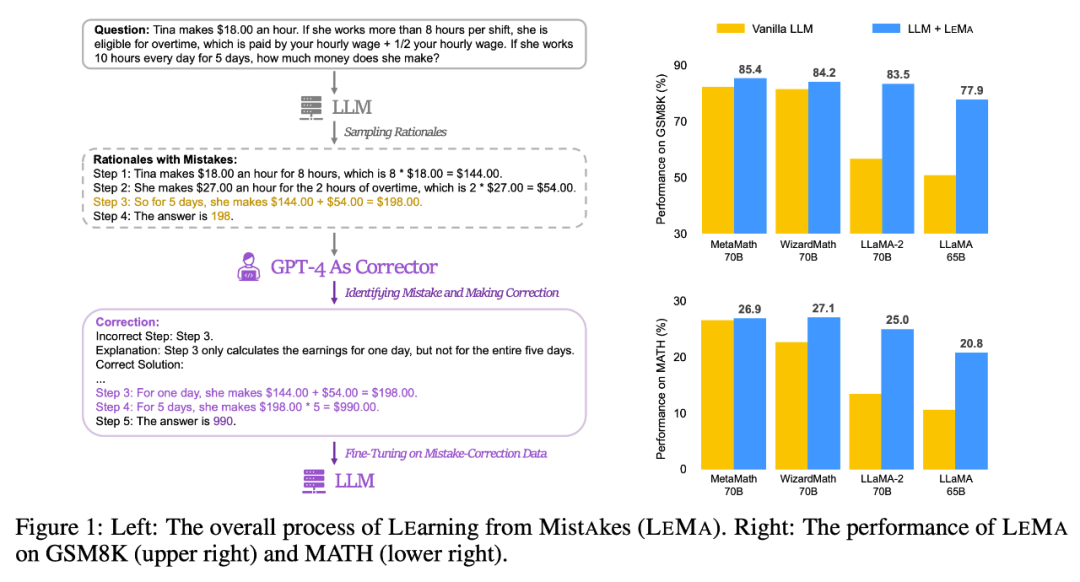

Veuillez regarder la figure 1 (à gauche) ci-dessous, qui montre le processus global de LEMA, y compris la génération de données corrigées : Obligatoire Il y a deux phases principales : la réécriture du contenu et la mise au point du LLM. La figure 1 (à droite) montre les performances de LEMA sur les ensembles de données GSM8K et MATH

Générer des données corrigées : ce qui doit être réécrit

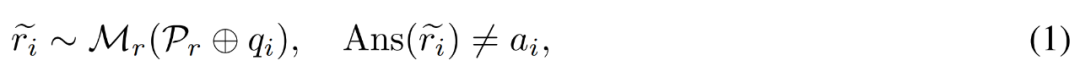

À partir d'un exemple de questions et réponses  , d'un modèle correcteur M_c et d'un modèle d'inférence M_r, le chercheur a généré des paires de données de correction d'erreur

, d'un modèle correcteur M_c et d'un modèle d'inférence M_r, le chercheur a généré des paires de données de correction d'erreur  , où

, où  représente le chemin d'inférence inexact de la question q_i et c_i représente la paire Correction de

représente le chemin d'inférence inexact de la question q_i et c_i représente la paire Correction de  .

.

Correction d'un chemin de raisonnement inexact . Le chercheur utilise d'abord le modèle d'inférence M_r pour échantillonner plusieurs chemins d'inférence pour chaque question q_i, puis retient uniquement les chemins qui ne mènent finalement pas à la bonne réponse a_i, comme le montre la formule suivante (1).

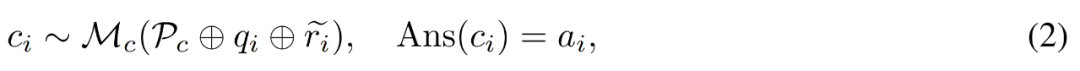

Construisez des correctifs pour les bugs. Pour la question q_i et le chemin de raisonnement inexact  , le chercheur utilise le modèle correcteur M_c pour générer une correction, puis vérifie la bonne réponse dans la correction, comme indiqué dans l'équation (2) ci-dessous.

, le chercheur utilise le modèle correcteur M_c pour générer une correction, puis vérifie la bonne réponse dans la correction, comme indiqué dans l'équation (2) ci-dessous.

P_c comprend ici quatre exemples de correction d'erreur annotés pour guider le modèle de correcteur sur le type d'informations à inclure dans les corrections générées

Plus précisément, les corrections annotées incluent les trois types d'informations suivants :

- Étape d'erreur : quelle étape du cheminement de raisonnement d'origine s'est mal passée.

- Explication : Quel type d'erreur s'est produit à cette étape ;

- Solution correcte : Comment corriger le chemin de raisonnement inexact pour mieux résoudre le problème d'origine.

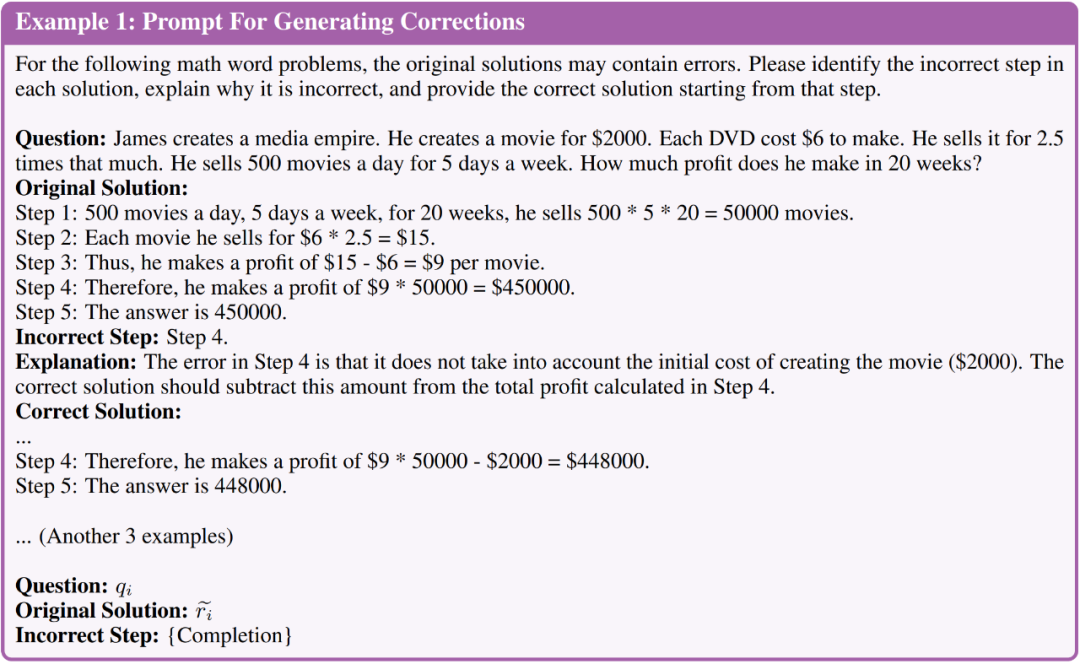

Veuillez consulter l'image ci-dessous, la figure 1 montre brièvement les invites utilisées pour générer des corrections

Générer une évaluation manuelle des corrections . Avant de générer des données plus volumineuses, nous avons d'abord évalué manuellement la qualité des corrections générées. Ils ont utilisé LLaMA-2-70B comme M_r et GPT-4 comme M_c et ont généré 50 paires de données corrigées des erreurs sur la base de l'ensemble de formation GSM8K.

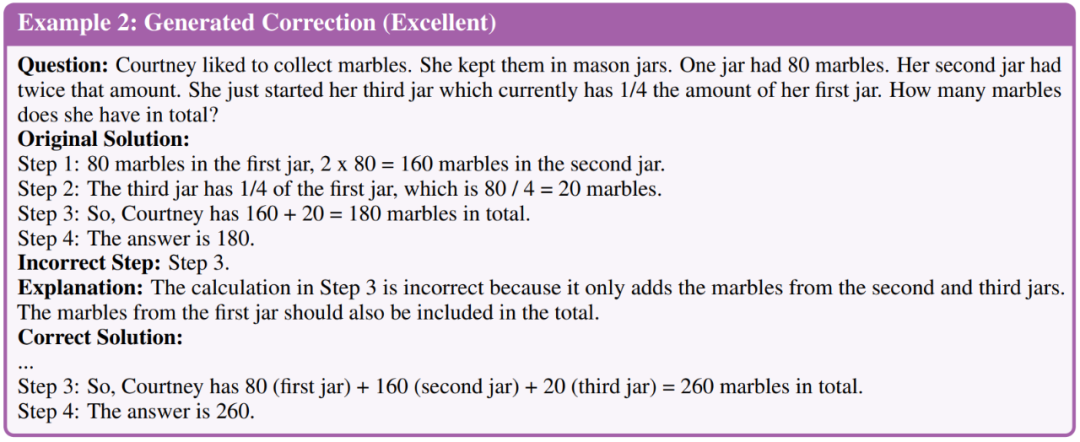

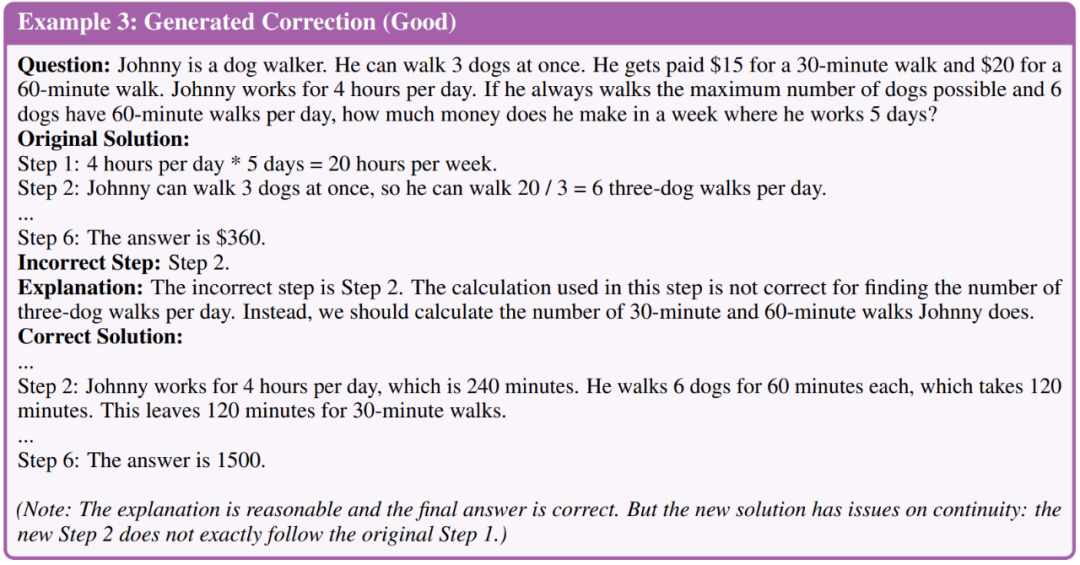

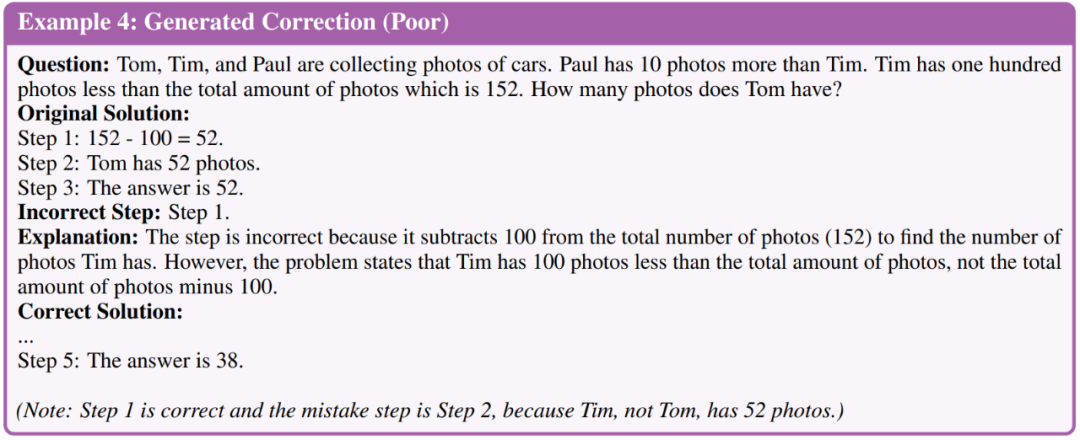

Les chercheurs ont classé les correctifs en trois niveaux de qualité : excellent, bon et mauvais. Voici un exemple de trois niveaux

Les résultats de l'évaluation ont révélé que 35 correctifs de build sur 50 ont atteint une excellente qualité, 11 étaient bons et 4 étaient médiocres. Sur la base de cette évaluation, les chercheurs ont conclu que la qualité globale des corrections générées à l’aide de GPT-4 était suffisante pour poursuivre les étapes de réglage. Par conséquent, ils ont généré des corrections à plus grande échelle et ont utilisé toutes les corrections qui ont finalement conduit à la bonne réponse au LLM qui nécessitait un réglage fin.

C'est le LLM qui nécessite d'être peaufiné

Après avoir généré des données de correction : ce qui devait être réécrit, les chercheurs ont affiné le LLM pour évaluer si les modèles pouvaient apprendre de leurs erreurs. Ils effectuent principalement des comparaisons de performances selon les deux paramètres de réglage précis suivants.

La première consiste à affiner les données de la Chaîne de pensée (CoT). Les chercheurs affinent le modèle uniquement sur les données justifiant les questions. Bien qu'il existe des données annotées dans chaque tâche, elles utilisent en outre l'augmentation des données CoT. Les chercheurs ont utilisé GPT-4 pour générer davantage de chemins de raisonnement pour chaque question de l’ensemble de formation et filtrer les chemins avec des réponses finales incorrectes. Ils exploitent l’augmentation des données CoT pour créer une base de référence de réglage fin robuste qui utilise uniquement les données CoT et facilite les études d’ablation sur la taille des données qui contrôlent le réglage fin.

La seconde est la mise au point sur les données CoT + données corrigées. En plus des données CoT, les chercheurs ont également généré des données de correction d'erreurs pour un réglage fin (c'est-à-dire LEMA). Ils ont également mené des expériences d’ablation avec une taille de données contrôlée afin de réduire l’impact des incréments sur la taille des données.

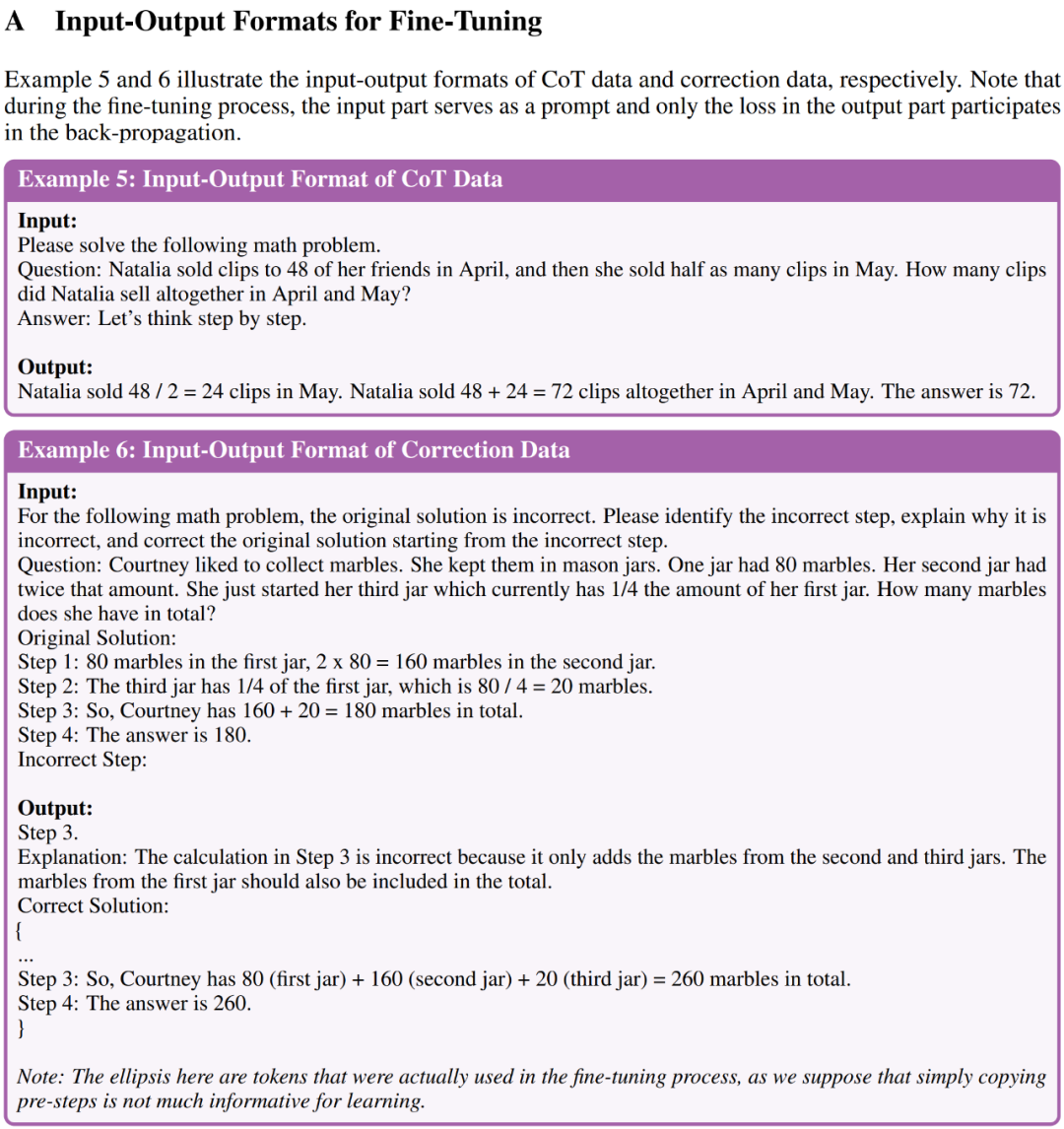

L'exemple 5 et l'exemple 6 de l'annexe A montrent respectivement le format d'entrée-sortie des données CoT et des données de correction pour un réglage fin

Résultats expérimentaux

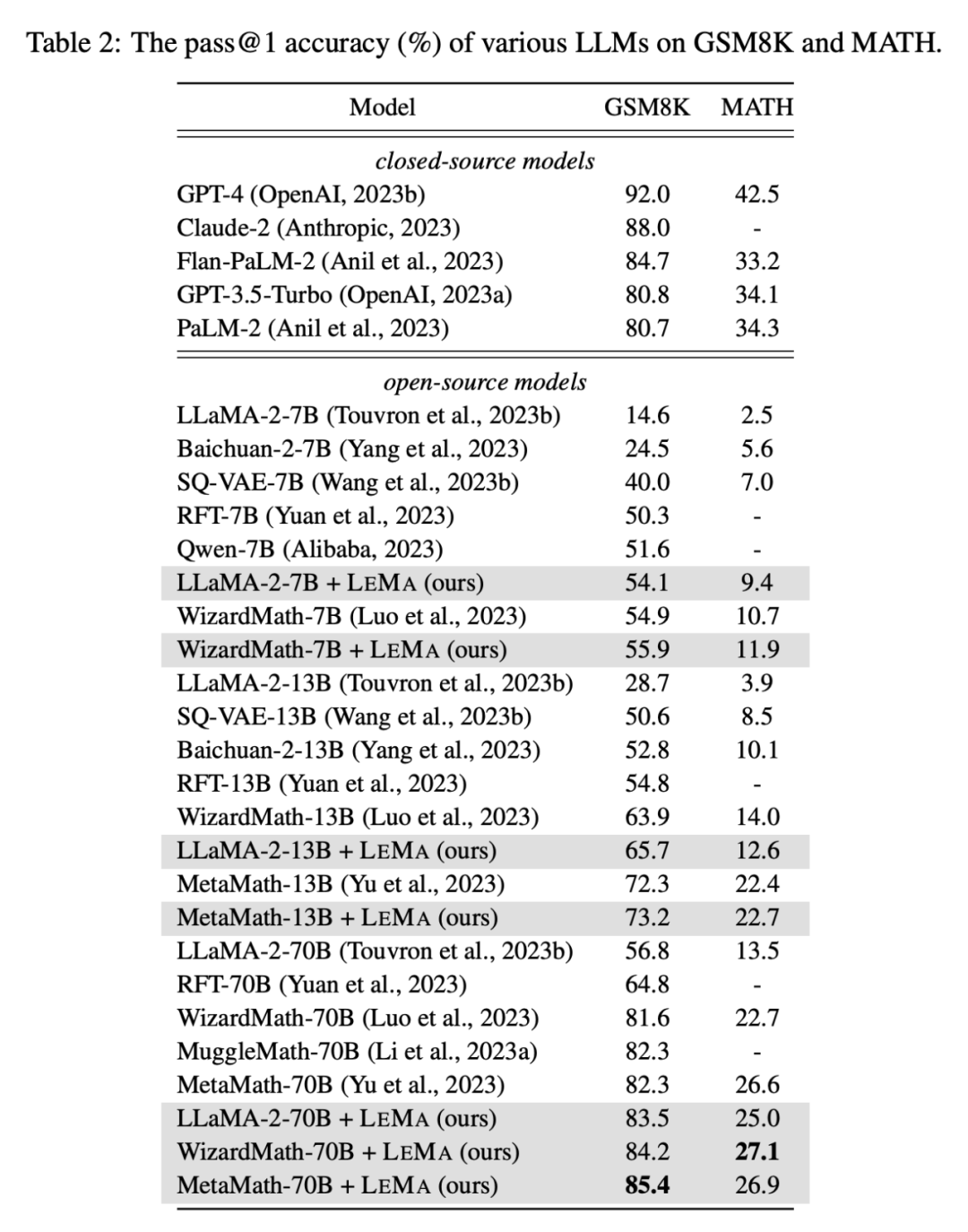

Les chercheurs ont prouvé à travers des résultats expérimentaux l'efficacité de LEMA sur cinq LLM open source et deux tâches de raisonnement mathématique difficiles

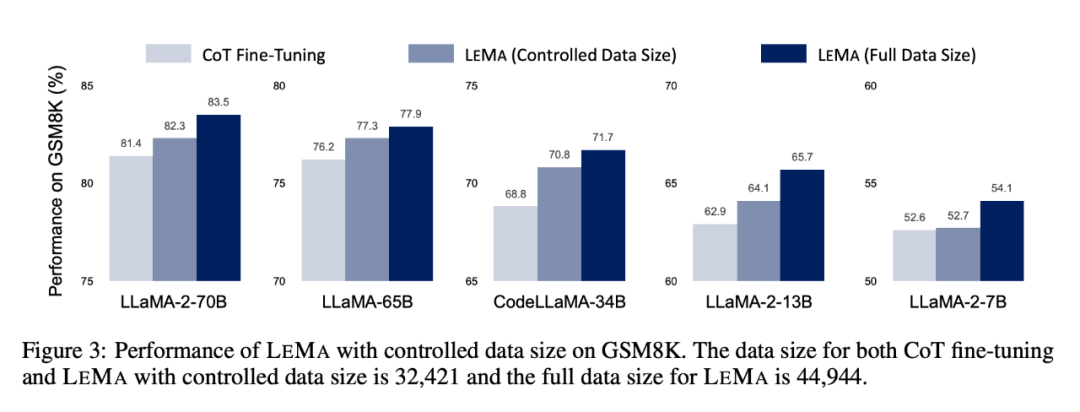

LEMA améliore constamment les performances dans une variété de LLM et de tâches, par rapport à un réglage fin uniquement sur les données CoT. Par exemple, LEMA utilisant LLaMA-2-70B a obtenu des résultats de 83,5 % et 25,0 % sur GSM8K et MATH respectivement, tandis que le réglage fin uniquement sur les données CoT a obtenu des résultats de 81,4 % et 23,6 % respectivement

De plus , LEMA est compatible avec le LLM propriétaire : LEMA avec WizardMath-70B/MetaMath-70B atteint une précision pass@1 de 84,2 %/85,4 % sur GSM8K et 27,1 %/26,9 % sur MATH. Le taux de précision pass@1 dépasse les performances SOTA atteintes par de nombreux modèles open source sur ces tâches difficiles.

Des études d'ablation ultérieures montrent que LEMA surpasse toujours le réglage fin CoT seul avec la même quantité de données. Cela suggère que les données CoT et les données corrigées ne sont pas aussi efficaces, car la combinaison des deux sources de données produit plus d'améliorations que l'utilisation d'une seule source de données. Ces résultats expérimentaux et analyses mettent en évidence le potentiel de l’apprentissage à partir des erreurs pour améliorer les capacités d’inférence LLM.

Pour plus de détails sur la recherche, veuillez vous référer à l'article original

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment vérifier la configuration de CentOS HDFS

Apr 14, 2025 pm 07:21 PM

Comment vérifier la configuration de CentOS HDFS

Apr 14, 2025 pm 07:21 PM

Guide complet pour vérifier la configuration HDFS dans les systèmes CentOS Cet article vous guidera comment vérifier efficacement la configuration et l'état de l'exécution des HDF sur les systèmes CentOS. Les étapes suivantes vous aideront à bien comprendre la configuration et le fonctionnement des HDF. Vérifiez la variable d'environnement Hadoop: Tout d'abord, assurez-vous que la variable d'environnement Hadoop est correctement définie. Dans le terminal, exécutez la commande suivante pour vérifier que Hadoop est installé et configuré correctement: HadoopVersion Check HDFS Fichier de configuration: Le fichier de configuration de base de HDFS est situé dans le répertoire / etc / hadoop / conf / le répertoire, où Core-site.xml et hdfs-site.xml sont cruciaux. utiliser

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

La commande de fermeture CENTOS est arrêtée et la syntaxe est la fermeture de [options] le temps [informations]. Les options incluent: -H Arrêtez immédiatement le système; -P éteignez l'alimentation après l'arrêt; -r redémarrer; -t temps d'attente. Les temps peuvent être spécifiés comme immédiats (maintenant), minutes (minutes) ou une heure spécifique (HH: mm). Des informations supplémentaires peuvent être affichées dans les messages système.

Quelles sont les méthodes de sauvegarde pour Gitlab sur Centos

Apr 14, 2025 pm 05:33 PM

Quelles sont les méthodes de sauvegarde pour Gitlab sur Centos

Apr 14, 2025 pm 05:33 PM

La politique de sauvegarde et de récupération de GitLab dans le système CentOS afin d'assurer la sécurité et la récupérabilité des données, Gitlab on CentOS fournit une variété de méthodes de sauvegarde. Cet article introduira plusieurs méthodes de sauvegarde courantes, paramètres de configuration et processus de récupération en détail pour vous aider à établir une stratégie complète de sauvegarde et de récupération de GitLab. 1. MANUEL BACKUP Utilisez le Gitlab-RakegitLab: Backup: Créer la commande pour exécuter la sauvegarde manuelle. Cette commande sauvegarde des informations clés telles que le référentiel Gitlab, la base de données, les utilisateurs, les groupes d'utilisateurs, les clés et les autorisations. Le fichier de sauvegarde par défaut est stocké dans le répertoire / var / opt / gitlab / backups. Vous pouvez modifier / etc / gitlab

CentOS installe MySQL

Apr 14, 2025 pm 08:09 PM

CentOS installe MySQL

Apr 14, 2025 pm 08:09 PM

L'installation de MySQL sur CENTOS implique les étapes suivantes: Ajout de la source MySQL YUM appropriée. Exécutez la commande YUM Install MySQL-Server pour installer le serveur MySQL. Utilisez la commande mysql_secure_installation pour créer des paramètres de sécurité, tels que la définition du mot de passe de l'utilisateur racine. Personnalisez le fichier de configuration MySQL selon les besoins. Écoutez les paramètres MySQL et optimisez les bases de données pour les performances.

Comment faire fonctionner la formation distribuée de Pytorch sur CentOS

Apr 14, 2025 pm 06:36 PM

Comment faire fonctionner la formation distribuée de Pytorch sur CentOS

Apr 14, 2025 pm 06:36 PM

La formation distribuée par Pytorch sur le système CentOS nécessite les étapes suivantes: Installation de Pytorch: La prémisse est que Python et PIP sont installés dans le système CentOS. Selon votre version CUDA, obtenez la commande d'installation appropriée sur le site officiel de Pytorch. Pour la formation du processeur uniquement, vous pouvez utiliser la commande suivante: pipinstalltorchtorchVisionTorChaudio Si vous avez besoin d'une prise en charge du GPU, assurez-vous que la version correspondante de CUDA et CUDNN est installée et utilise la version Pytorch correspondante pour l'installation. Configuration de l'environnement distribué: la formation distribuée nécessite généralement plusieurs machines ou des GPU multiples uniques. Lieu

Explication détaillée du principe docker

Apr 14, 2025 pm 11:57 PM

Explication détaillée du principe docker

Apr 14, 2025 pm 11:57 PM

Docker utilise les fonctionnalités du noyau Linux pour fournir un environnement de fonctionnement d'application efficace et isolé. Son principe de travail est le suivant: 1. Le miroir est utilisé comme modèle en lecture seule, qui contient tout ce dont vous avez besoin pour exécuter l'application; 2. Le Système de fichiers Union (UnionFS) empile plusieurs systèmes de fichiers, ne stockant que les différences, l'économie d'espace et l'accélération; 3. Le démon gère les miroirs et les conteneurs, et le client les utilise pour l'interaction; 4. Les espaces de noms et les CGROUP implémentent l'isolement des conteneurs et les limitations de ressources; 5. Modes de réseau multiples prennent en charge l'interconnexion du conteneur. Ce n'est qu'en comprenant ces concepts principaux que vous pouvez mieux utiliser Docker.

Comment afficher les journaux Gitlab sous Centos

Apr 14, 2025 pm 06:18 PM

Comment afficher les journaux Gitlab sous Centos

Apr 14, 2025 pm 06:18 PM

Un guide complet pour consulter les journaux GitLab sous Centos System Cet article vous guidera comment afficher divers journaux GitLab dans le système CentOS, y compris les journaux principaux, les journaux d'exception et d'autres journaux connexes. Veuillez noter que le chemin du fichier journal peut varier en fonction de la version Gitlab et de la méthode d'installation. Si le chemin suivant n'existe pas, veuillez vérifier le répertoire d'installation et les fichiers de configuration de GitLab. 1. Afficher le journal GitLab principal Utilisez la commande suivante pour afficher le fichier journal principal de l'application GitLabRails: Commande: sudocat / var / log / gitlab / gitlab-rails / production.log Cette commande affichera le produit

Comment est la prise en charge du GPU pour Pytorch sur Centos

Apr 14, 2025 pm 06:48 PM

Comment est la prise en charge du GPU pour Pytorch sur Centos

Apr 14, 2025 pm 06:48 PM

Activer l'accélération du GPU Pytorch sur le système CentOS nécessite l'installation de versions CUDA, CUDNN et GPU de Pytorch. Les étapes suivantes vous guideront tout au long du processus: CUDA et CUDNN Installation détermineront la compatibilité de la version CUDA: utilisez la commande NVIDIA-SMI pour afficher la version CUDA prise en charge par votre carte graphique NVIDIA. Par exemple, votre carte graphique MX450 peut prendre en charge CUDA11.1 ou plus. Téléchargez et installez Cudatoolkit: visitez le site officiel de Nvidiacudatoolkit et téléchargez et installez la version correspondante selon la version CUDA la plus élevée prise en charge par votre carte graphique. Installez la bibliothèque CUDNN: