Il y a quelque temps, le domaine des grands modèles open source a inauguré un nouveau modèle : "Yi" avec une taille de fenêtre contextuelle supérieure à 200 000 et capable de traiter 400 000 caractères chinois à la fois.

Président et PDG de Sinovation Ventures, Kai-fu Lee a fondé la société de grands modèles "Zero One Everything" et a construit ce grand modèle, qui comprend deux versions du Yi-6B et du Yi-34B

Selon Hugging Face Plateforme communautaire open source anglaise et liste d'évaluation chinoise C-Eval, Yi-34B a obtenu un certain nombre de reconnaissances internationales du meilleur indicateur de performance SOTA lors de son lancement, devenant ainsi le « double champion » des grands modèles open source mondiaux, battant les produits concurrents open source tels que comme LLaMA2 et Falcon.

Yi-34B est également devenu le seul modèle national à figurer avec succès en tête du classement mondial des modèles open source de Hugging Face à cette époque, et a été qualifié de "modèle open source le plus puissant au monde".

Après sa sortie, ce modèle a attiré l'attention de nombreux chercheurs et développeurs nationaux et étrangers

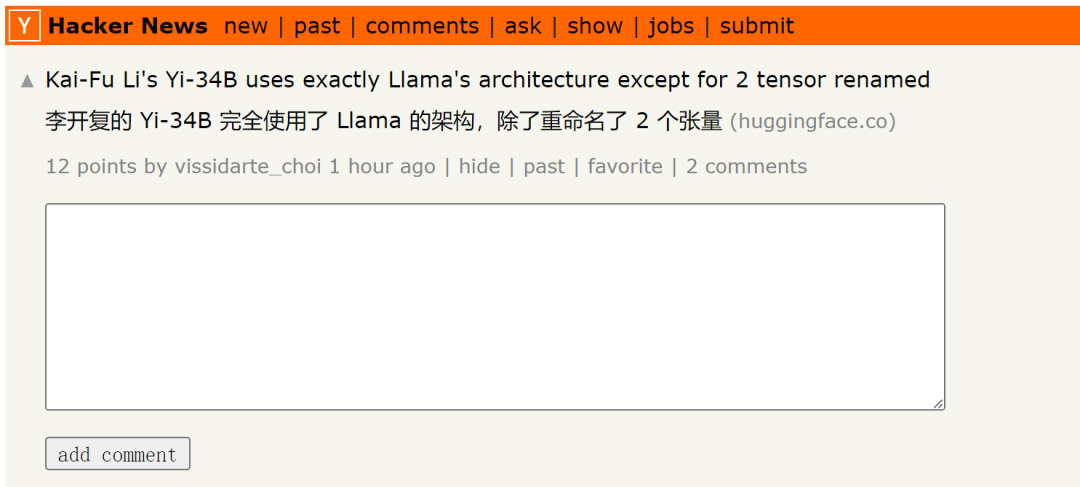

Mais récemment, certains chercheurs ont découvert que le modèle Yi-34B utilise essentiellement l'architecture LLaMA, mais vient d'être renommé Deux tenseurs.

Veuillez cliquer sur ce lien pour voir le message original : https://news.ycombinator.com/item?id=38258015

Le message mentionne également :

Le code de Yi-34B Il s'agit en fait d'une refactorisation du code LLaMA, mais ne semble pas avoir apporté de modifications substantielles. Ce modèle est évidemment une édition basée sur le fichier LLaMA original d'Apache version 2.0, mais aucune mention de LLaMA :

Comparaison des codes Yi vs LLaMA. Lien de code : https://www.diffchecker.com/bJTqkvmQ/

De plus, ces modifications de code ne sont pas soumises au projet Transformers via Pull Request, mais sont jointes sous forme de code externe en mai. être un risque de sécurité ou non pris en charge par le cadre. Le classement HuggingFace ne comparera même pas ce modèle avec une fenêtre contextuelle allant jusqu'à 200 Ko car il n'a pas de stratégie de code personnalisée.

Ils prétendent qu'il s'agit d'un modèle 32K, mais il est configuré comme un modèle 4K, il n'y a pas de configuration de mise à l'échelle RoPE et il n'y a aucune explication sur la façon de mettre à l'échelle (Remarque : Zero One Thousand Things a précédemment déclaré que le modèle lui-même est entraînés sur des séquences 4K, mais dans les étapes d'inférence peuvent être étendues à 32K). Actuellement, il n’existe aucune information sur ses données de réglage fin. Ils n’ont pas non plus fourni d’instructions pour reproduire leurs tests, y compris les scores MMLU étrangement élevés.

Quiconque travaille dans le domaine de l’intelligence artificielle depuis un certain temps ne sera pas aveugle à cela. Est-ce une fausse publicité ? Violation de licence ? Était-ce réellement une triche sur le benchmark ? Qui s'en soucie? Nous pourrions changer un journal, ou dans ce cas, prendre tout l'argent du capital-risque. Au moins Yi est au dessus de la norme, car c'est un modèle de base, et les performances sont vraiment bonnes

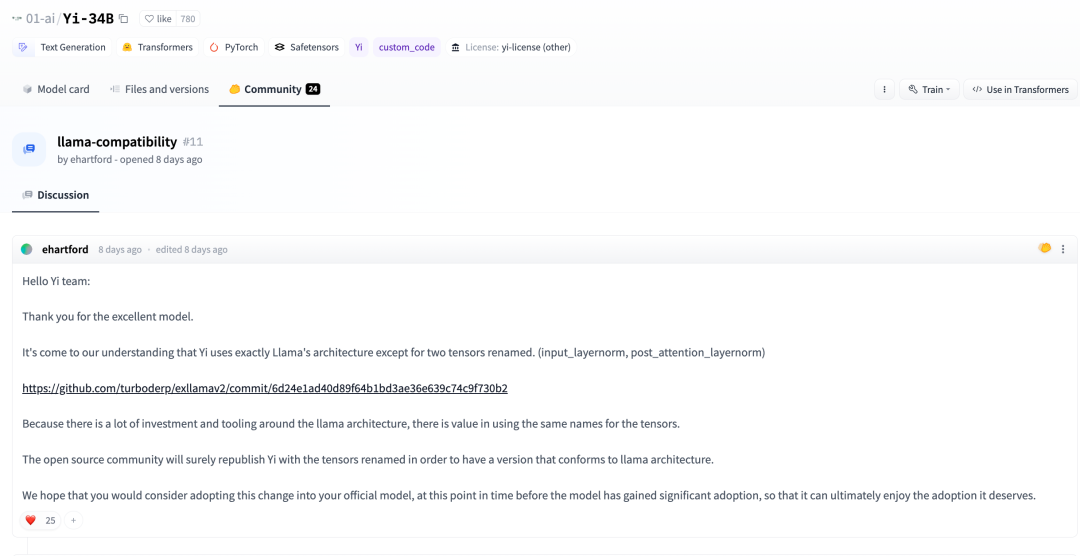

Il y a quelques jours, dans la communauté Huggingface, un développeur a également souligné :

Selon notre compréhension, en plus pour renommer les deux tenseurs en plus, Yi adopte complètement l'architecture LLaMA. (input_layernorm, post_attention_layernorm)

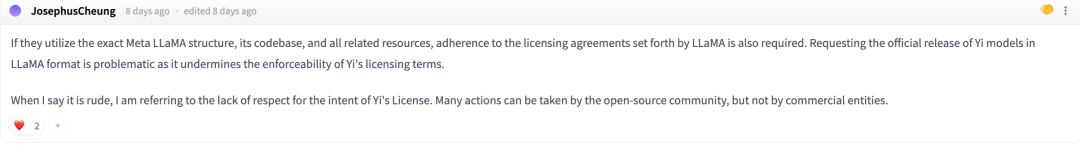

Au cours de la discussion, certains internautes ont déclaré : S'ils souhaitent utiliser l'architecture, la bibliothèque de codes et d'autres ressources connexes de Meta LLaMA avec précision, ils doivent se conformer au contrat de licence stipulé par LLaMA

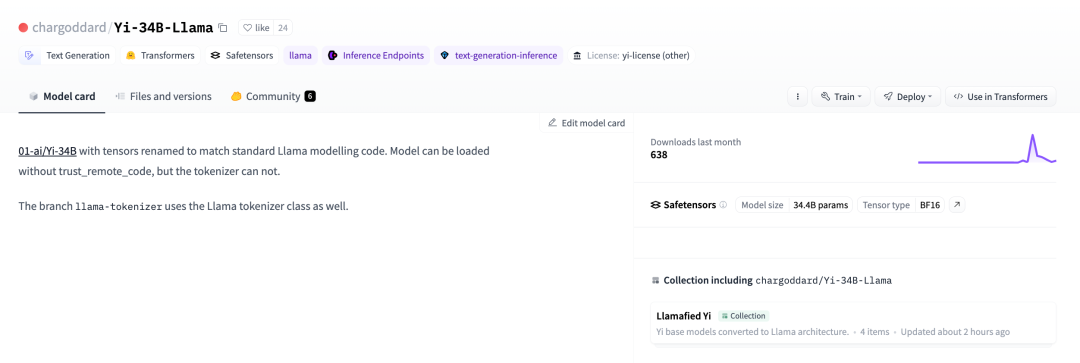

Afin de respecter la licence open source de LLaMA, un développeur a décidé de changer son nom et de le republier sur huggingface

01-ai/Yi-34B, les tenseurs ont été renommés pour correspondre au modèle LLaMA standard code. Liens connexes : https://huggingface.co/chargoddard/Yi-34B-LLaMA

01-ai/Yi-34B, les tenseurs ont été renommés pour correspondre au modèle LLaMA standard code. Liens connexes : https://huggingface.co/chargoddard/Yi-34B-LLaMA

En lisant ce contenu, nous pouvons déduire que la nouvelle selon laquelle Jia Yangqing a quitté Alibaba et a démarré une entreprise a été évoquée dans son cercle d'amis il y a quelques jours

Concernant cette affaire, le cœur de la machine aussi exprimé Zéro Mille Choses ont été vérifiées. Lingyiwu a répondu :

GPT est une architecture mature reconnue dans l'industrie, et LLaMA a fait un résumé sur GPT. La conception structurelle du grand modèle de R&D de Zero One Thousand Things est basée sur la structure mature de GPT, s'appuyant sur des résultats publics de haut niveau dans l'industrie. Dans le même temps, l'équipe de Zero One Thousand Things a effectué beaucoup de travail. sur la compréhension du modèle et de la formation. C'est la première fois que nous publions d'excellents résultats sur l'une des fondations. Dans le même temps, Zero One Thousand Things continue également d'explorer des avancées essentielles au niveau de la structure du modèle.

La structure du modèle n'est qu'une partie de la formation du modèle. Le modèle open source de Yi se concentre sur d'autres aspects, tels que l'ingénierie des données, les méthodes de formation, les compétences de baby-sitting (surveillance du processus de formation), les paramètres d'hyperparamètres, les méthodes d'évaluation, la compréhension approfondie de la nature des indicateurs d'évaluation et la profondeur de la recherche sur les principes de capacités de généralisation des modèles, les meilleures capacités d'IA Infra de l'industrie, etc., de nombreux travaux de recherche, de développement et de fondation ont été investis. Ces tâches jouent souvent un rôle et une valeur plus importants que la structure de base. Un wagon en phase de pré-entraînement des grands modèles.

Au cours du processus de réalisation d'un grand nombre d'expériences de formation, nous avons renommé le code en fonction des besoins de l'exécution expérimentale. Nous attachons une grande importance aux retours de la communauté open source et avons mis à jour le code pour mieux s'intégrer dans l'écosystème Transformer

Nous sommes très reconnaissants des retours de la communauté. Nous venons de débuter dans la communauté open source et espérons travailler. avec tout le monde pour créer une communauté prospère. Open source facile Nous ferons de notre mieux pour continuer à progresser

.Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Comment s'inscrire sur Matcha Exchange

Comment s'inscrire sur Matcha Exchange

Numéro de téléphone mobile virtuel pour recevoir le code de vérification

Numéro de téléphone mobile virtuel pour recevoir le code de vérification

Introduction au contenu principal du travail des ingénieurs front-end

Introduction au contenu principal du travail des ingénieurs front-end

Utilisation de la liste déroulante

Utilisation de la liste déroulante

Comment ouvrir un fichier zip

Comment ouvrir un fichier zip

Tutoriel du portefeuille Eou web3

Tutoriel du portefeuille Eou web3

Comment exprimer la valeur de la largeur en CSS

Comment exprimer la valeur de la largeur en CSS

Tutoriel de configuration du mot de passe de démarrage de Windows 10

Tutoriel de configuration du mot de passe de démarrage de Windows 10