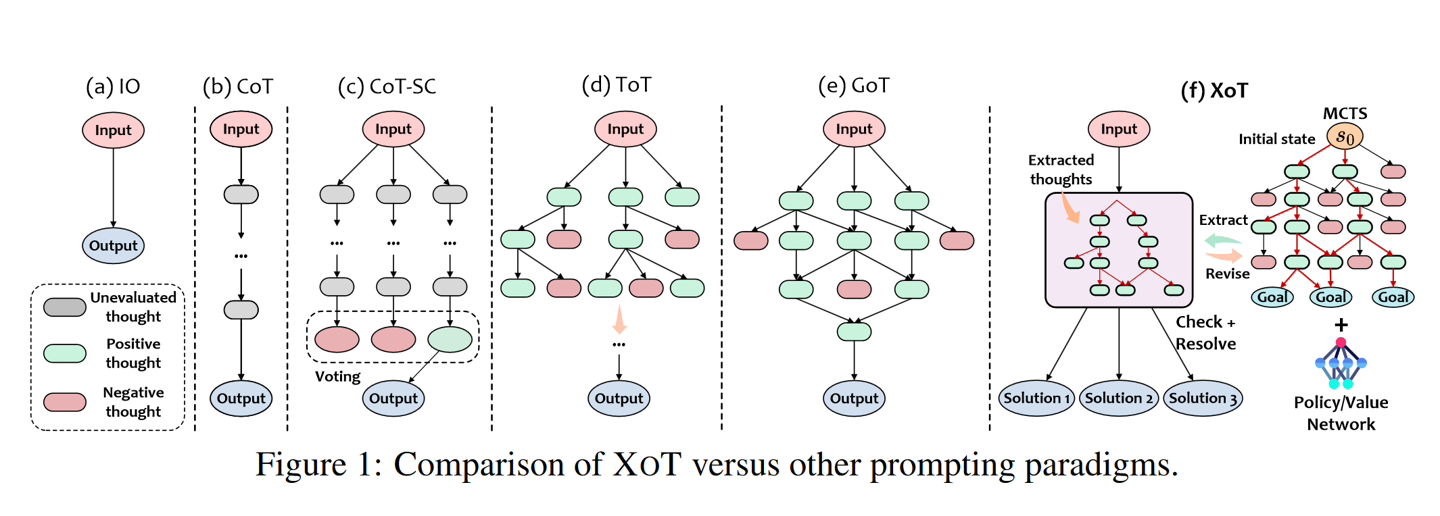

Le 15 novembre, Microsoft a récemment lancé une méthode appelée "Everything of Thought" (XOT), inspirée d'AlphaZero de Google DeepMind, utilise des réseaux neuronaux compacts pour améliorer les capacités de raisonnement des modèles d'IA.

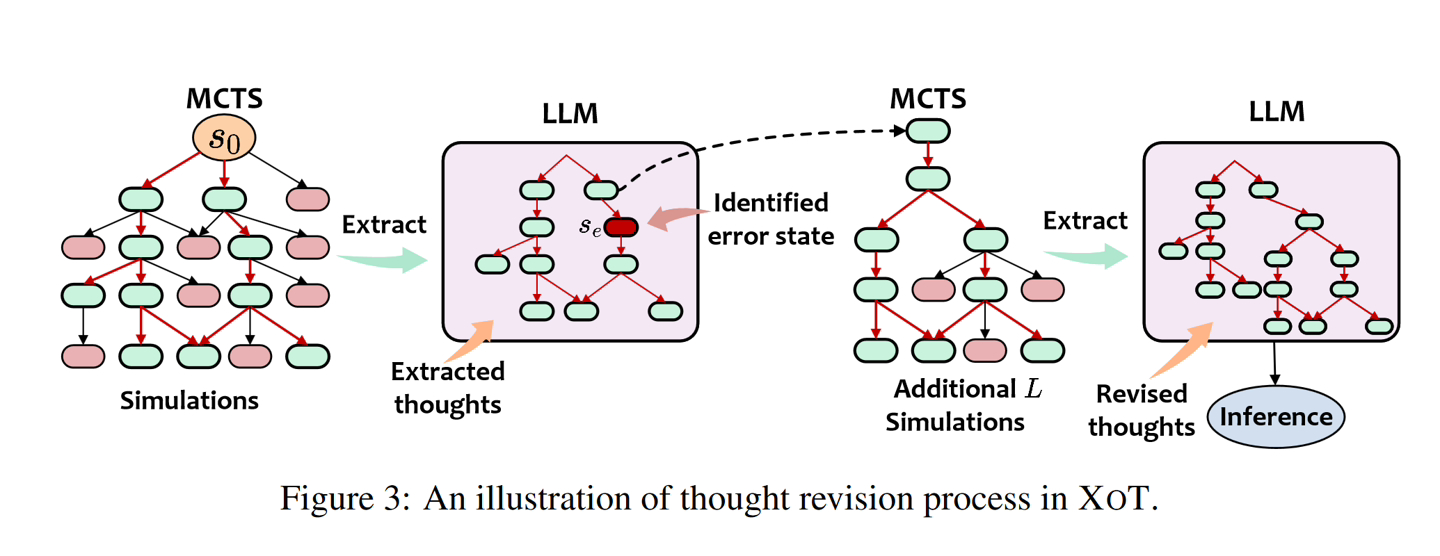

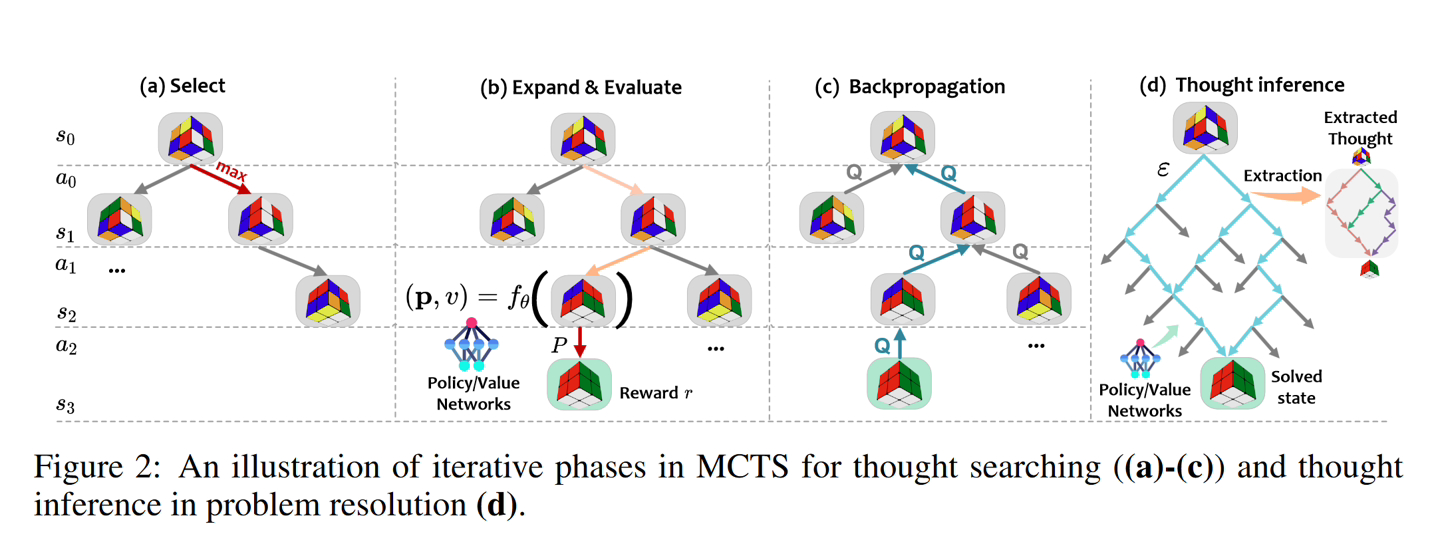

Microsoft a coopéré avec l'Institut de technologie de Géorgie et l'Université normale de Chine orientale pour développer cet algorithme, qui intègre les capacités d'apprentissage par renforcement (apprentissage par renforcement) et de recherche d'arbres de Monte Carlo (MCTS) pour fonctionner dans des environnements complexes. environnements décisionnels pour améliorer encore l’efficacité de la résolution des problèmes.

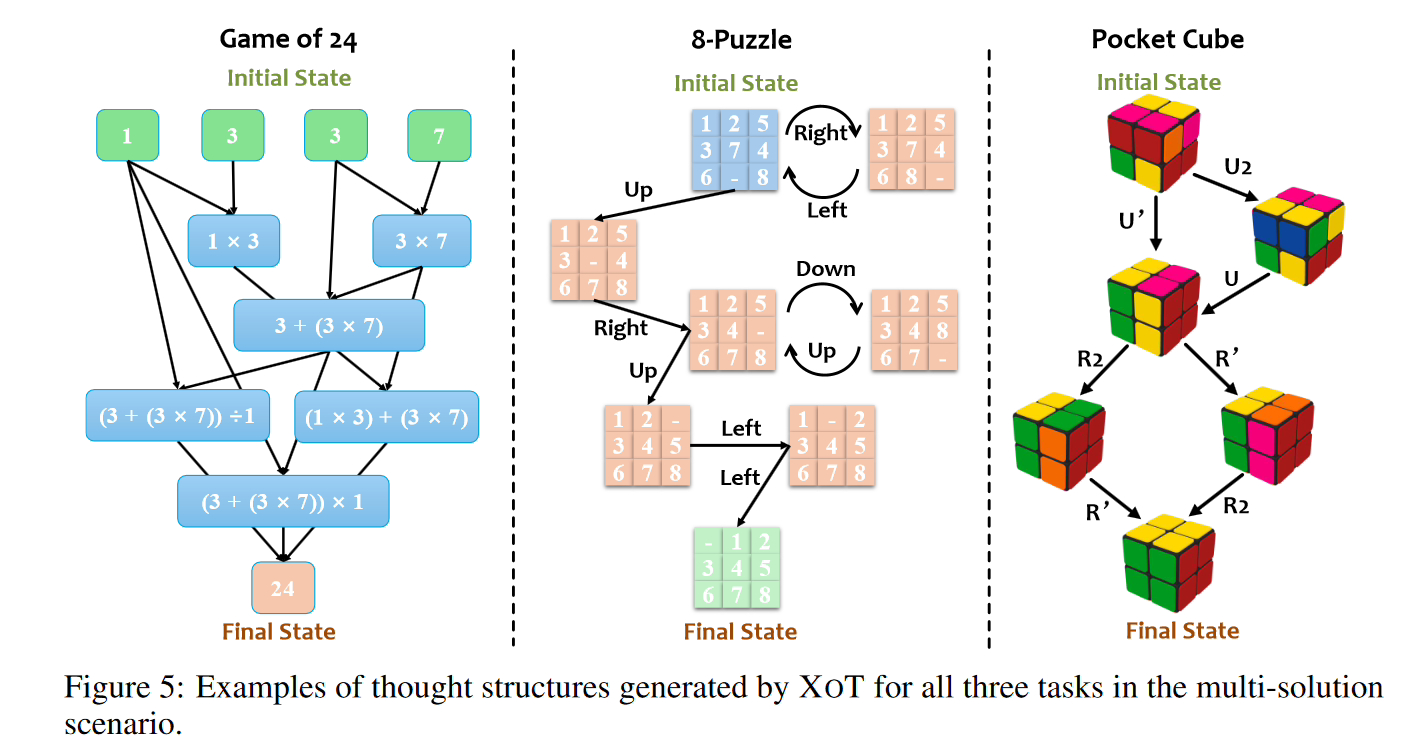

Note de ce site : L'équipe de recherche de Microsoft a déclaré que la méthode XOT peut étendre le modèle de langage sur des problèmes inconnus et s'est considérablement améliorée lors des tests rigoureux de Game of 24, 8-Puzzle et Pocket Cube. Les résultats montrent que XOT est nettement meilleur que les autres méthodes et résout même le problème de l'échec des autres méthodes. Cependant, XOT n'atteint pas une fiabilité à 100 %

Le framework XOT comprend les étapes clés suivantes :

Ce site Web joint ici l'adresse du papier [PDF], les utilisateurs intéressés peuvent la lire en profondeur.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Solution à l'échec de la connexion entre wsus et le serveur Microsoft

Solution à l'échec de la connexion entre wsus et le serveur Microsoft

Qu'est-ce que la programmation de socket

Qu'est-ce que la programmation de socket

Que comprennent les plateformes de commerce électronique ?

Que comprennent les plateformes de commerce électronique ?

insérer dans la sélection

insérer dans la sélection

Comment exprimer la valeur de la largeur en CSS

Comment exprimer la valeur de la largeur en CSS

La différence entre l'API de repos et l'API

La différence entre l'API de repos et l'API

Comment lire la base de données en HTML

Comment lire la base de données en HTML

L'Apple Store ne peut pas se connecter

L'Apple Store ne peut pas se connecter