Périphériques technologiques

Périphériques technologiques

IA

IA

La carte graphique NVIDIA RTX accélère l'inférence de l'IA de 5 fois ! RTX PC gère facilement les grands modèles localement

La carte graphique NVIDIA RTX accélère l'inférence de l'IA de 5 fois ! RTX PC gère facilement les grands modèles localement

La carte graphique NVIDIA RTX accélère l'inférence de l'IA de 5 fois ! RTX PC gère facilement les grands modèles localement

Lors de la conférence technologique mondiale Microsoft Iginte, Microsoft a publié une série de nouveaux modèles d'optimisation et de ressources d'outils de développement liés à l'IA, dans le but d'aider les développeurs à utiliser pleinement les performances du matériel et à élargir les domaines d'application de l'IA

Surtout pour NVIDIA, qui occupe actuellement une position dominante absolue dans le domaine de l'IA, Microsoft a cette fois envoyé un gros cadeau, Qu'il s'agisse de l'interface de packaging TensorRT-LLM pour l'API OpenAI Chat ou de l'amélioration des performances du pilote RTX DirectML pour Llama 2, ainsi que d'autres modèles de langage étendus (LLM) populaires, peuvent obtenir une meilleure accélération et une meilleure application sur le matériel NVIDIA.

Parmi eux, TensorRT-LLM est une bibliothèque utilisée pour accélérer l'inférence LLM, ce qui peut considérablement améliorer les performances d'inférence de l'IA. Elle est constamment mise à jour pour prendre en charge de plus en plus de modèles de langage, et elle est également open source.

NVIDIA a publié TensorRT-LLM pour la plate-forme Windows en octobre. Pour les ordinateurs de bureau et les ordinateurs portables équipés de cartes graphiques GPU de la série RTX 30/40, tant que la mémoire graphique atteint 8 Go ou plus, il sera plus facile d'effectuer des charges de travail d'IA exigeantes

Maintenant, Tensor RT-LLM pour Windows peut être compatible avec l'API de chat populaire d'OpenAI via une nouvelle interface de packaging, de sorte que diverses applications associées peuvent être exécutées directement localement sans avoir besoin de se connecter au cloud, ce qui est propice à la rétention sur PC. Données privées et propriétaires pour éviter les fuites de confidentialité.

Tant qu'il s'agit d'un grand modèle de langage optimisé par TensorRT-LLM, il peut être utilisé avec cette interface de package, notamment Llama 2, Mistral, NV LLM, etc.

Pour les développeurs, il n'y a pas besoin de réécriture et de portage fastidieux du code Modifiez simplement une ou deux lignes de code et l'application d'IA peut être exécutée rapidement localement.

↑↑↑Plug-in de code Microsoft Visual Studio basé sur TensorRT-LLM - Assistant de codage Continue.dev

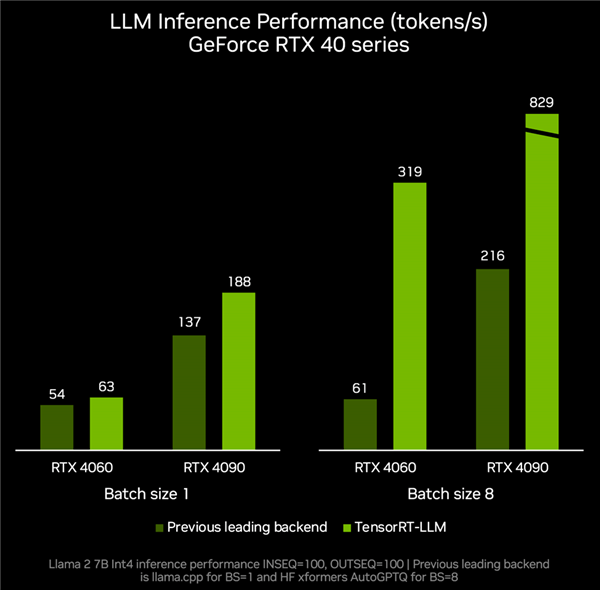

TensorRT-LLM v0.6.0 sera mis à jour à la fin de ce mois, ce qui améliorera jusqu'à 5 fois les performances d'inférence sur le GPU RTX et prendra en charge des LLM plus populaires, y compris le nouveau paramètre de 7 milliards Mistral, The 8 milliard de paramètres Nemotron-3 permet aux ordinateurs de bureau et portables d'exécuter LLM localement à tout moment, rapidement et avec précision.

Selon les données de mesure réelles, la carte graphique RTX 4060 associée à TenroRT-LLM, les performances d'inférence peuvent atteindre 319 jetons par seconde, soit 4,2 fois plus rapides que les 61 jetons par seconde des autres backends.

RTX 4090 peut accélérer de jetons par seconde à 829 jetons par seconde, soit une augmentation de 2,8 fois.

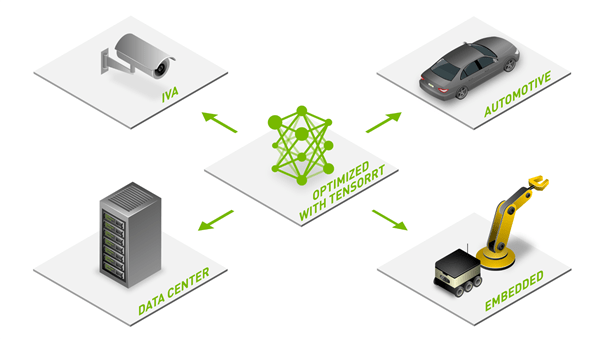

Avec ses puissantes performances matérielles, son riche écosystème de développement et son large éventail de scénarios d'application, NVIDIA RTX devient un assistant indispensable et puissant pour l'IA locale. Dans le même temps, avec l'enrichissement continu de l'optimisation, des modèles et des ressources, la popularité des fonctions d'IA sur des centaines de millions de PC RTX s'accélère également

Actuellement, plus de 400 partenaires ont publié des applications et des jeux d'IA prenant en charge l'accélération GPU RTX. À mesure que la facilité d'utilisation des modèles continue de s'améliorer, je pense que de plus en plus de fonctions AIGC apparaîtront sur la plate-forme PC Windows.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

J'ai essayé le codage d'ambiance avec Cursor Ai et c'est incroyable!

Mar 20, 2025 pm 03:34 PM

J'ai essayé le codage d'ambiance avec Cursor Ai et c'est incroyable!

Mar 20, 2025 pm 03:34 PM

Le codage des ambiances est de remodeler le monde du développement de logiciels en nous permettant de créer des applications en utilisant le langage naturel au lieu de lignes de code sans fin. Inspirée par des visionnaires comme Andrej Karpathy, cette approche innovante permet de dev

Top 5 Genai Lunets de février 2025: GPT-4.5, Grok-3 et plus!

Mar 22, 2025 am 10:58 AM

Top 5 Genai Lunets de février 2025: GPT-4.5, Grok-3 et plus!

Mar 22, 2025 am 10:58 AM

Février 2025 a été un autre mois qui change la donne pour une IA générative, nous apportant certaines des mises à niveau des modèles les plus attendues et de nouvelles fonctionnalités révolutionnaires. De Xai's Grok 3 et Anthropic's Claude 3.7 Sonnet, à Openai's G

Comment utiliser YOLO V12 pour la détection d'objets?

Mar 22, 2025 am 11:07 AM

Comment utiliser YOLO V12 pour la détection d'objets?

Mar 22, 2025 am 11:07 AM

Yolo (vous ne regardez qu'une seule fois) a été un cadre de détection d'objets en temps réel de premier plan, chaque itération améliorant les versions précédentes. La dernière version Yolo V12 introduit des progrès qui améliorent considérablement la précision

Meilleurs générateurs d'art AI (gratuit & amp; payé) pour des projets créatifs

Apr 02, 2025 pm 06:10 PM

Meilleurs générateurs d'art AI (gratuit & amp; payé) pour des projets créatifs

Apr 02, 2025 pm 06:10 PM

L'article passe en revue les meilleurs générateurs d'art AI, discutant de leurs fonctionnalités, de leur aptitude aux projets créatifs et de la valeur. Il met en évidence MidJourney comme la meilleure valeur pour les professionnels et recommande Dall-E 2 pour un art personnalisable de haute qualité.

Chatgpt 4 o est-il disponible?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4 o est-il disponible?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4 est actuellement disponible et largement utilisé, démontrant des améliorations significatives dans la compréhension du contexte et la génération de réponses cohérentes par rapport à ses prédécesseurs comme Chatgpt 3.5. Les développements futurs peuvent inclure un interg plus personnalisé

Quelle IA est la meilleure que Chatgpt?

Mar 18, 2025 pm 06:05 PM

Quelle IA est la meilleure que Chatgpt?

Mar 18, 2025 pm 06:05 PM

L'article traite des modèles d'IA dépassant Chatgpt, comme Lamda, Llama et Grok, mettant en évidence leurs avantages en matière de précision, de compréhension et d'impact de l'industrie. (159 caractères)

Comment utiliser Mistral OCR pour votre prochain modèle de chiffon

Mar 21, 2025 am 11:11 AM

Comment utiliser Mistral OCR pour votre prochain modèle de chiffon

Mar 21, 2025 am 11:11 AM

Mistral OCR: révolutionner la génération de la récupération avec une compréhension du document multimodal Les systèmes de génération (RAG) (RAG) de la récupération ont considérablement avancé les capacités d'IA, permettant à de vastes magasins de données pour une responsabilité plus éclairée

Assistants d'écriture de l'IA pour augmenter votre création de contenu

Apr 02, 2025 pm 06:11 PM

Assistants d'écriture de l'IA pour augmenter votre création de contenu

Apr 02, 2025 pm 06:11 PM

L'article traite des meilleurs assistants d'écriture d'IA comme Grammarly, Jasper, Copy.ai, WireSonic et Rytr, en se concentrant sur leurs fonctionnalités uniques pour la création de contenu. Il soutient que Jasper excelle dans l'optimisation du référencement, tandis que les outils d'IA aident à maintenir le ton