développement back-end

développement back-end

Golang

Golang

Conseils de développement Golang : Comment optimiser les performances du code

Conseils de développement Golang : Comment optimiser les performances du code

Conseils de développement Golang : Comment optimiser les performances du code

Dans le développement Golang, l'optimisation des performances du code est un enjeu très important. L'optimisation des performances du code peut considérablement améliorer l'efficacité de fonctionnement du programme, réduire le gaspillage de ressources et améliorer l'expérience utilisateur. Ci-dessous, nous présenterons quelques méthodes pour optimiser les performances du code Golang.

- Choisissez des structures de données plus efficaces

Dans le développement Golang, le choix de la structure de données a un grand impact sur les performances du code. Si des structures de données inappropriées sont utilisées, la vitesse d'exécution du programme deviendra relativement lente. Par conséquent, lors du choix d’une structure de données, vous devez la choisir en fonction des caractéristiques du code. Dans le développement réel, les structures de données efficaces courantes incluent la carte, la tranche, etc.

- Utiliser le traitement simultané

Golang est un langage de programmation simultané, donc pendant le développement, utiliser pleinement le traitement simultané est un moyen important d'améliorer les performances du code. L'utilisation de goroutine pour le traitement simultané peut permettre au programme d'utiliser les ressources informatiques plus efficacement, améliorant ainsi les performances du programme.

- Réduire l'allocation de mémoire et le garbage collection

Dans Golang, l'allocation de mémoire et le garbage collection affectent les performances du programme. Par conséquent, lors de l'écriture de code, vous devez réduire le nombre d'allocations de mémoire et de garbage collection et éviter les allocations de mémoire et les garbage collection fréquentes. La technologie des pools d’objets peut être utilisée pour réduire le nombre d’allocations de mémoire et de garbage collection.

- Réduire les appels de fonction

Dans Golang, les appels de fonction prendront un certain temps. Par conséquent, lors de l'écriture de code, vous devez essayer de réduire le nombre d'appels de fonction et d'utiliser directement des variables au lieu d'appels de fonction pour améliorer les performances du code.

- Utilisez des algorithmes appropriés

Dans le développement Golang, le choix de l'algorithme approprié est également un moyen important d'améliorer les performances du code. Le choix d'un algorithme approprié en fonction des caractéristiques du problème peut rendre le programme plus efficace, accélérant ainsi la vitesse d'exécution du programme.

- Optimiser les opérations d'E/S

Dans le développement Golang, les opérations d'E/S sont également un facteur important affectant les performances du programme. Par conséquent, lorsque vous effectuez des opérations d'E/S, essayez d'utiliser des méthodes asynchrones pour les opérations de lecture et d'écriture afin d'améliorer les performances du programme.

- Écrire du code efficace

Enfin, écrire du code efficace est également un point clé dans l'optimisation des performances du code. L'écriture de code efficace peut accélérer l'exécution du programme et réduire l'empreinte mémoire du programme, améliorant ainsi ses performances. Lors de l'écriture du code, vous devez faire attention à la lisibilité et à la flexibilité du code, et écrire un code concis et efficace.

En bref, l'optimisation des performances du code est une tâche très importante dans le développement de Golang. Choisir des structures de données efficaces, tirer parti du traitement simultané, réduire l'allocation de mémoire et le garbage collection, réduire les appels de fonction, utiliser des algorithmes appropriés, optimiser les opérations d'E/S et écrire du code efficace peuvent tous nous aider à améliorer les performances de notre code, améliorant ainsi l'expérience utilisateur. Utilisez l'expérience.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

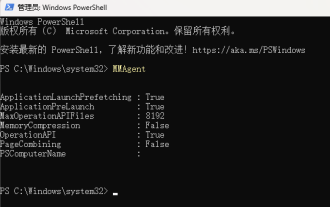

Optimisation importante de la mémoire, que dois-je faire si l'ordinateur passe à une vitesse de mémoire de 16 Go/32 Go et qu'il n'y a aucun changement ?

Jun 18, 2024 pm 06:51 PM

Optimisation importante de la mémoire, que dois-je faire si l'ordinateur passe à une vitesse de mémoire de 16 Go/32 Go et qu'il n'y a aucun changement ?

Jun 18, 2024 pm 06:51 PM

Pour les disques durs mécaniques ou les disques SSD SATA, vous ressentirez l'augmentation de la vitesse d'exécution du logiciel. S'il s'agit d'un disque dur NVME, vous ne la ressentirez peut-être pas. 1. Importez le registre sur le bureau et créez un nouveau document texte, copiez et collez le contenu suivant, enregistrez-le sous 1.reg, puis cliquez avec le bouton droit pour fusionner et redémarrer l'ordinateur. WindowsRegistryEditorVersion5.00[HKEY_LOCAL_MACHINE\SYSTEM\CurrentControlSet\Control\SessionManager\MemoryManagement]"DisablePagingExecutive"=d

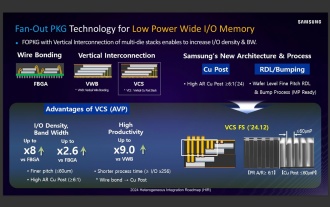

Des sources affirment que Samsung Electronics et SK Hynix commercialiseront de la mémoire mobile empilée après 2026

Sep 03, 2024 pm 02:15 PM

Des sources affirment que Samsung Electronics et SK Hynix commercialiseront de la mémoire mobile empilée après 2026

Sep 03, 2024 pm 02:15 PM

Selon des informations publiées sur ce site Web le 3 septembre, le média coréen etnews a rapporté hier (heure locale) que les produits de mémoire mobile à structure empilée « de type HBM » de Samsung Electronics et SK Hynix seraient commercialisés après 2026. Des sources ont indiqué que les deux géants coréens de la mémoire considèrent la mémoire mobile empilée comme une source importante de revenus futurs et prévoient d'étendre la « mémoire de type HBM » aux smartphones, tablettes et ordinateurs portables afin de fournir de la puissance à l'IA finale. Selon des rapports précédents sur ce site, le produit de Samsung Electronics s'appelle LPWide I/O memory, et SK Hynix appelle cette technologie VFO. Les deux sociétés ont utilisé à peu près la même voie technique, à savoir combiner emballage en sortance et canaux verticaux. La mémoire LPWide I/O de Samsung Electronics a une largeur de 512 bits.

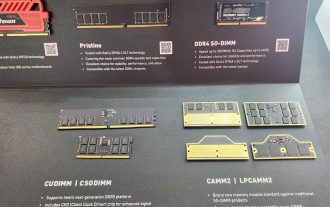

Kingbang lance une nouvelle mémoire DDR5 8600, disponible en CAMM2, LPCAMM2 et modèles standards

Jun 08, 2024 pm 01:35 PM

Kingbang lance une nouvelle mémoire DDR5 8600, disponible en CAMM2, LPCAMM2 et modèles standards

Jun 08, 2024 pm 01:35 PM

Selon les informations de ce site le 7 juin, GEIL a lancé sa dernière solution DDR5 au Salon international de l'informatique de Taipei 2024 et a proposé les versions SO-DIMM, CUDIMM, CSODIMM, CAMM2 et LPCAMM2. ▲ Source de l'image : Wccftech Comme le montre l'image, la mémoire CAMM2/LPCAMM2 présentée par Jinbang adopte un design très compact, peut fournir une capacité maximale de 128 Go et une vitesse allant jusqu'à 8533 MT/s. Certains de ces produits peuvent même l'être. stable sur la plateforme AMDAM5 Overclocké à 9000MT/s sans aucun refroidissement auxiliaire. Selon les rapports, la mémoire de la série Polaris RGBDDR5 2024 de Jinbang peut fournir jusqu'à 8 400

Comparaison des performances de différents frameworks Java

Jun 05, 2024 pm 07:14 PM

Comparaison des performances de différents frameworks Java

Jun 05, 2024 pm 07:14 PM

Comparaison des performances de différents frameworks Java : Traitement des requêtes API REST : Vert.x est le meilleur, avec un taux de requêtes de 2 fois SpringBoot et 3 fois Dropwizard. Requête de base de données : HibernateORM de SpringBoot est meilleur que l'ORM de Vert.x et Dropwizard. Opérations de mise en cache : le client Hazelcast de Vert.x est supérieur aux mécanismes de mise en cache de SpringBoot et Dropwizard. Cadre approprié : choisissez en fonction des exigences de l'application. Vert.x convient aux services Web hautes performances, SpringBoot convient aux applications gourmandes en données et Dropwizard convient à l'architecture de microservices.

Les spécifications des mémoires DDR5 MRDIMM et LPDDR6 CAMM sont prêtes à être lancées, JEDEC publie des détails techniques clés

Jul 23, 2024 pm 02:25 PM

Les spécifications des mémoires DDR5 MRDIMM et LPDDR6 CAMM sont prêtes à être lancées, JEDEC publie des détails techniques clés

Jul 23, 2024 pm 02:25 PM

Selon les informations de ce site Web du 23 juillet, la JEDEC Solid State Technology Association, l'organisme de normalisation de la microélectronique, a annoncé le 22, heure locale, que les spécifications techniques des mémoires DDR5MRDIMM et LPDDR6CAMM seraient bientôt officiellement lancées et a présenté les détails clés de ces deux souvenirs. Le « MR » dans DDR5MRDIMM signifie MultiplexedRank, ce qui signifie que la mémoire prend en charge deux rangs ou plus et peut combiner et transmettre plusieurs signaux de données sur un seul canal sans connexion physique supplémentaire. La connexion peut effectivement augmenter la bande passante. JEDEC a prévu plusieurs générations de mémoire DDR5MRDIMM, dans le but d'augmenter à terme sa bande passante à 12,8 Gbit/s, contre 6,4 Gbit/s actuellement pour la mémoire DDR5RDIMM.

Galerie de photos de la mémoire Lexar God of War Wings ARES RGB DDR5 8000 : Les ailes blanches colorées prennent en charge le RVB

Jun 25, 2024 pm 01:51 PM

Galerie de photos de la mémoire Lexar God of War Wings ARES RGB DDR5 8000 : Les ailes blanches colorées prennent en charge le RVB

Jun 25, 2024 pm 01:51 PM

Alors que les prix des mémoires phares UHF telles que 7 600 MT/s et 8 000 MT/s sont généralement élevés, Lexar a pris des mesures et a lancé une nouvelle série de mémoires appelée Ares Wings ARES RGB DDR5, avec 7 600 C36 et 8 000 C38 disponibles en deux spécifications. Les ensembles de 16 Go*2 coûtent respectivement 1 299 yuans et 1 499 yuans, ce qui est très rentable. Ce site s'est procuré la version 8000 C38 de Wings of War, et vous apportera ses photos du déballage. L'emballage de la mémoire Lexar Wings ARES RGB DDR5 est bien conçu, utilisant des couleurs noir et rouge accrocheuses avec une impression colorée. Il y a un &quo exclusif dans le coin supérieur gauche de l'emballage.

Longsys affiche la mémoire de l'ordinateur portable FORESEE LPCAMM2 : jusqu'à 64 Go, 7 500 MT/s

Jun 05, 2024 pm 02:22 PM

Longsys affiche la mémoire de l'ordinateur portable FORESEE LPCAMM2 : jusqu'à 64 Go, 7 500 MT/s

Jun 05, 2024 pm 02:22 PM

Selon les informations de ce site Web du 16 mai, Longsys, la société mère de la marque Lexar, a annoncé qu'elle présenterait une nouvelle forme de mémoire - FORESEELPCAMM2 au CFMS2024. FORESEELPCAMM2 est équipé de particules LPDDR5/5x, est compatible avec les conceptions 315ball et 496ball, prend en charge des fréquences de 7 500 MT/s et plus et propose des options de capacité de produit de 16 Go, 32 Go et 64 Go. En termes de technologie de produit, FORESEELPCAMM2 adopte une nouvelle architecture de conception pour conditionner directement 4 particules de mémoire x32LPDDR5/5x sur le connecteur de compression, réalisant un bus mémoire de 128 bits sur un seul module de mémoire, offrant un conditionnement plus efficace que les modules de mémoire standard.

Comment optimiser les performances des programmes multi-thread en C++ ?

Jun 05, 2024 pm 02:04 PM

Comment optimiser les performances des programmes multi-thread en C++ ?

Jun 05, 2024 pm 02:04 PM

Les techniques efficaces pour optimiser les performances multithread C++ incluent la limitation du nombre de threads pour éviter les conflits de ressources. Utilisez des verrous mutex légers pour réduire les conflits. Optimisez la portée du verrou et minimisez le temps d’attente. Utilisez des structures de données sans verrouillage pour améliorer la simultanéité. Évitez les attentes occupées et informez les threads de la disponibilité des ressources via des événements.