Edge Intelligence est une technologie émergente qui combine l'intelligence artificielle (IA) et l'informatique de pointe. Les applications traditionnelles d'intelligence artificielle s'appuient généralement sur des centres de cloud computing pour le traitement des données et la prise de décision, mais cette approche présente des problèmes de latence et de bande passante du réseau.

Edge Intelligence est un concept technologique émergent qui fait référence à l'intégration d'algorithmes et de modèles d'intelligence artificielle (IA). temps de traitement et d'analyse des données sur les appareils IoT déployés à proximité des sources de données et sur leurs nœuds de réseau à proximité. Au cours des dernières années, le développement rapide de l’IA a donné naissance à de nombreuses applications et solutions innovantes. Cependant, à mesure que l’échelle et la complexité des modèles d’IA continuent d’augmenter, l’architecture de cloud computing traditionnelle est confrontée à une série de défis, tels qu’une latence élevée, la congestion du réseau et des problèmes de confidentialité des données. Afin de relever ces défis, la combinaison de l’informatique de pointe et de l’intelligence artificielle a émergé, formant le concept d’intelligence de pointe. L'intelligence de pointe ne déplace pas seulement la formation et l'inférence des modèles d'IA vers des appareils de pointe plus proches des utilisateurs, tels que les smartphones, les capteurs, les routeurs, les caméras de surveillance, etc. En effectuant un traitement des données en temps réel sur ces appareils de pointe, en répondant et en analysant rapidement les données et en prenant des décisions localement, cela évite les retards et les risques de sécurité liés à l'envoi de toutes les données vers le cloud pour traitement, apportant ainsi de nombreuses nouvelles fonctionnalités aux applications d'IA Chance. .

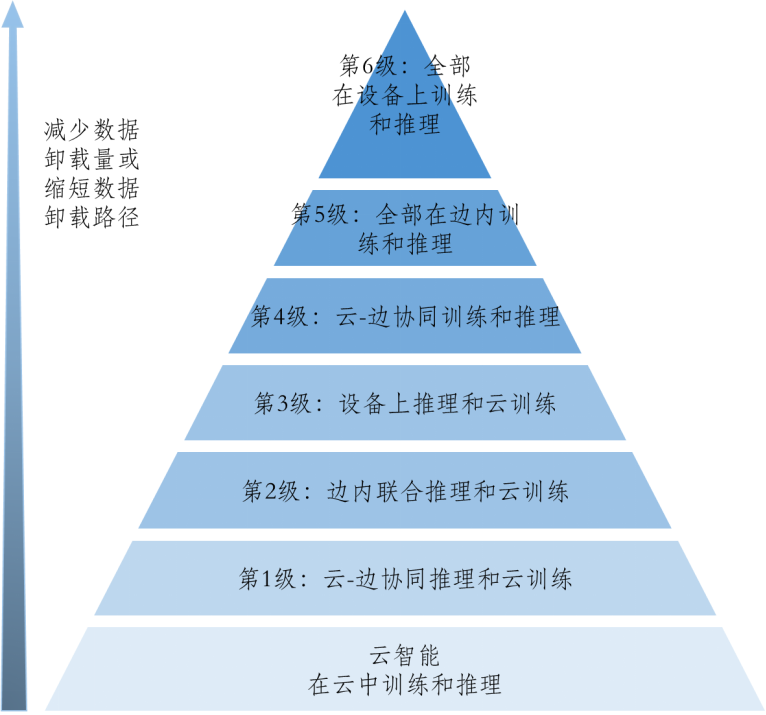

Concernant la portée et l'évaluation de l'intelligence de pointe, les recherches existantes estiment que l'intelligence de pointe est l'utilisation des données et des ressources disponibles dans les appareils finaux, les nœuds de périphérie et les hiérarchies des centres de données cloud pour optimiser la formation et le développement global du réseau neuronal profond. modèles (DNN). Cela signifie que l'intelligence de pointe ne doit pas nécessairement être formée ou déduite à la périphérie, mais peut réaliser le travail collaboratif du cloud, de la périphérie et du terminal grâce au déchargement des données. Selon le nombre et la longueur du chemin de déchargement des données, l'intelligence de pointe est divisée en six niveaux

Au détriment de l'augmentation de la latence de calcul et de la consommation d'énergie, à mesure que le niveau d'intelligence de pointe augmente, le nombre de déchargements de données et La longueur du chemin sera réduite, réduisant ainsi le délai de transmission du déchargement des données, augmentant la confidentialité des données et réduisant les coûts de bande passante du réseau.

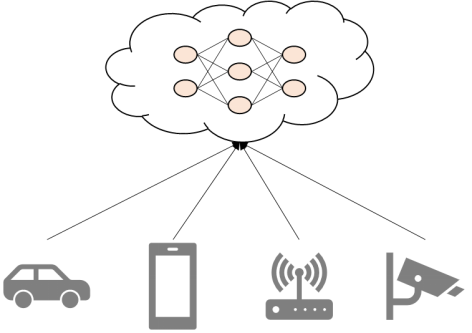

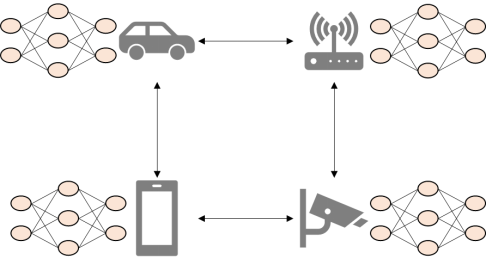

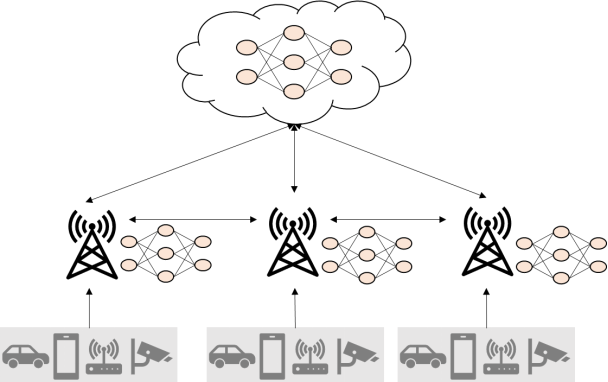

L'architecture de formation des réseaux neuronaux profonds distribués en périphérie peut être divisée en trois modes : centralisé, distribué, hybride (collaboration cloud-edge)

➪ Centralisé : Le modèle DNN est formé dans le centre de données cloud. Les données utilisées pour la formation sont générées et collectées à partir de terminaux distribués (tels que les téléphones mobiles, les voitures et les caméras de surveillance). Le centre de données utilisera ces données pour la formation DNN. Les systèmes basés sur une architecture centralisée peuvent être identifiés comme niveau 1, niveau 2 ou niveau 3 en matière d'intelligence de pointe, en fonction de la méthode de raisonnement spécifique adoptée par le système.

➪ Distribué : Chaque nœud informatique entraîne localement son propre modèle DNN en utilisant des données locales et enregistre des informations privées localement. Obtenez un modèle DNN global en partageant les mises à jour de formation locales. Dans ce mode, le modèle DNN global peut être entraîné sans l'intervention du centre de données cloud, correspondant au cinquième niveau d'intelligence de pointe.

➪ Hybride (collaboration cloud-edge-device) : Combinant centralisé et distribué, les serveurs Edge peuvent former des modèles DNN via des mises à jour distribuées, ou utiliser des centres de données cloud pour centraliser la formation. Correspond aux niveaux 4 et 5 en intelligence de pointe.

Actuellement, les méthodes de formation des modèles d'intelligence de pointe sont principalement évaluées à travers six indicateurs de performance clés : perte de formation, convergence, confidentialité, coût de communication, retard et efficacité énergétique.

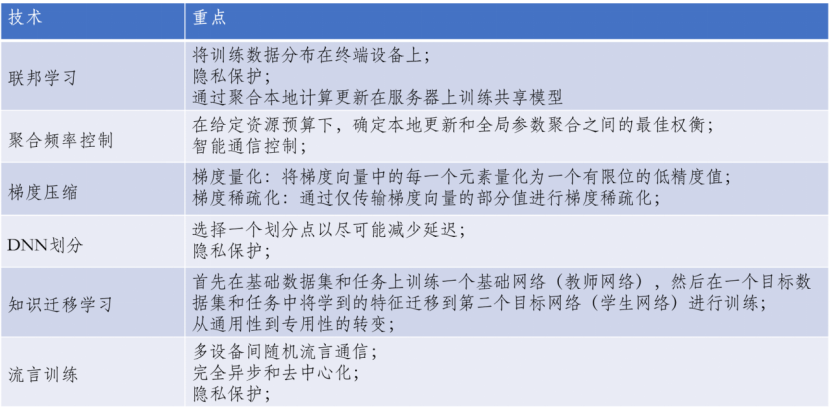

Les technologies prises en charge par la formation du modèle Edge Intelligence sont les suivantes :

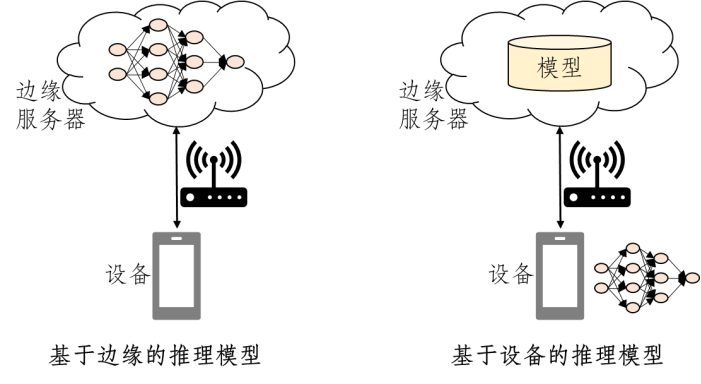

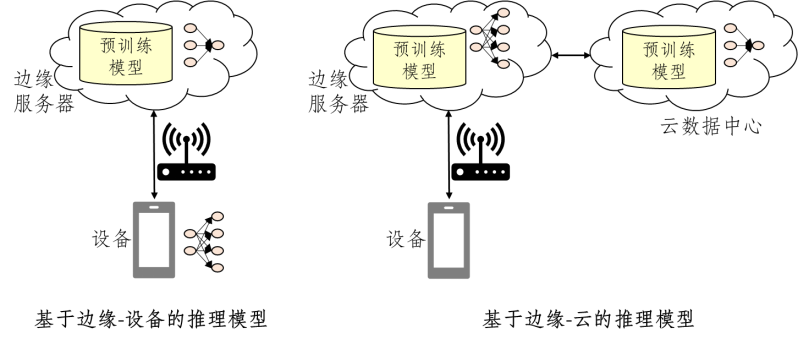

Déploiement de services Edge Intelligence de haute qualité, en plus de réaliser la distribution de données approfondies modèles d'apprentissage La formation nécessite également une mise en œuvre efficace de l'inférence de modèle à la périphérie. Le modèle d'inférence de l'intelligence de pointe est divisé en quatre modes : basé sur la périphérie, basé sur l'appareil, périphérique de périphérie et cloud de périphérie.

➪ Modèle d'inférence basé sur Edge : L'appareil est en mode Edge, reçoit les données d'entrée, puis les envoie au serveur Edge. Le serveur Edge termine l'inférence du modèle DNN et renvoie les résultats de prédiction à l'appareil. Les performances d'inférence dépendent de la bande passante réseau entre l'appareil et le serveur Edge.

➪ Modèle d'inférence basé sur l'appareil : L'appareil mobile obtient le modèle DNN du serveur Edge et termine l'inférence du modèle localement. Pendant le processus d'inférence, l'appareil mobile communique en continu. avec le serveur Edge, l'appareil mobile doit donc disposer de ressources telles que le CPU, le GPU et la RAM.

➪ Modèle d'inférence basé sur le périphérique Edge : L'appareil est en mode périphérique Edge. L'appareil divise d'abord le modèle DNN en plusieurs en fonction de facteurs tels que la bande passante du réseau et les ressources de l'appareil. , et chargez la partie du serveur Edge ; puis exécutez le modèle DNN sur des couches spécifiques et envoyez les données intermédiaires au serveur Edge. Le serveur Edge exécutera les couches restantes et enverra les résultats de prédiction à l'appareil.

➪ Modèle d'inférence basé sur Edge-cloud : L'appareil est en mode Edge-cloud et l'appareil est responsable de la collecte des données d'entrée et de l'exécution du modèle DNN de manière collaborative via la périphérie du cloud.

Les performances de l'inférence du modèle Edge Intelligence sont principalement évaluées à travers six indicateurs : latence, précision, efficacité énergétique, confidentialité, coût de communication et utilisation de la mémoire.

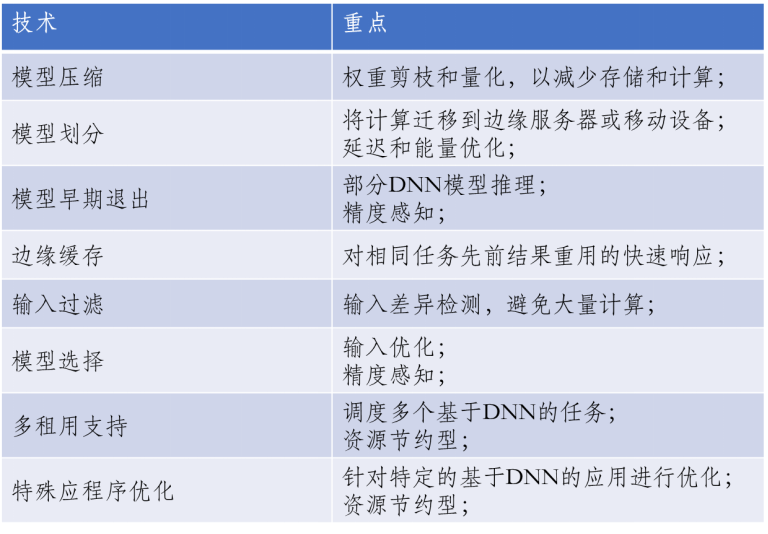

Les technologies prises en charge par la formation du modèle Edge Intelligence sont les suivantes :

En tant que domaine technologique émergent, l'intelligence de pointe a de larges perspectives Orientations de recherche et potentiel de développement. Sur la base des caractéristiques techniques et des scénarios d'application de l'intelligence de pointe, la recherche pourra être menée à l'avenir sous les aspects suivants :

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Application de l'intelligence artificielle dans la vie

Application de l'intelligence artificielle dans la vie

Quel est le concept de base de l'intelligence artificielle

Quel est le concept de base de l'intelligence artificielle

Comment utiliser l'arrondi Oracle

Comment utiliser l'arrondi Oracle

étude php

étude php

Comment définir la transparence de la couleur de la police HTML

Comment définir la transparence de la couleur de la police HTML

outils de développement php

outils de développement php

Requête blockchain du navigateur Ethereum

Requête blockchain du navigateur Ethereum

Techniques couramment utilisées par les robots d'exploration Web

Techniques couramment utilisées par les robots d'exploration Web