Périphériques technologiques

Périphériques technologiques

IA

IA

Le titre reformulé est : ByteDance et coopération entre les universités normales de Chine orientale : Exploration des capacités d'apprentissage contextuel des petits modèles.

Le titre reformulé est : ByteDance et coopération entre les universités normales de Chine orientale : Exploration des capacités d'apprentissage contextuel des petits modèles.

Le titre reformulé est : ByteDance et coopération entre les universités normales de Chine orientale : Exploration des capacités d'apprentissage contextuel des petits modèles.

Il est bien connu que les grands modèles de langage (LLM) peuvent apprendre à partir d'un petit nombre d'exemples grâce à l'apprentissage contextuel sans avoir besoin d'affiner le modèle. Actuellement, ce phénomène d’apprentissage contextuel ne peut être observé que dans de grands modèles. Par exemple, les grands modèles comme GPT-4, Llama, etc. ont montré d'excellentes performances dans de nombreux domaines, mais en raison de contraintes de ressources ou d'exigences élevées en temps réel, les grands modèles ne peuvent pas être utilisés dans de nombreux scénarios

Ensuite, régulier- modèles de taille Avez-vous cette capacité ? Afin d'explorer les capacités d'apprentissage contextuel des petits modèles, des équipes de recherche de Byte et de l'East China Normal University ont mené des recherches sur les tâches de reconnaissance de texte de scène.

À l'heure actuelle, dans les scénarios d'application réels, la reconnaissance de texte de scène est confrontée à une variété de défis : différentes scènes, disposition du texte, déformation, changements d'éclairage, écriture floue, diversité des polices, etc., il est donc difficile de former une machine qui peut faire face à tous les scénarios. Un modèle de reconnaissance de texte unifié.

Un moyen direct de résoudre ce problème consiste à collecter les données correspondantes et à affiner le modèle dans des scénarios spécifiques. Cependant, ce processus nécessite un recyclage du modèle, qui nécessite beaucoup de calculs, et nécessite de sauvegarder plusieurs pondérations du modèle pour s'adapter à différents scénarios. Si le modèle de reconnaissance de texte peut avoir des capacités d'apprentissage du contexte, lorsqu'il est confronté à de nouvelles scènes, il n'a besoin que d'une petite quantité de données annotées comme invites pour améliorer ses performances sur de nouvelles scènes, résolvant ainsi les problèmes ci-dessus. Cependant, la reconnaissance de texte de scène est une tâche sensible aux ressources, et l'utilisation d'un grand modèle comme outil de reconnaissance de texte consommera beaucoup de ressources. Grâce à des observations expérimentales préliminaires, les chercheurs ont découvert que les méthodes traditionnelles de formation de grands modèles ne conviennent pas aux tâches de reconnaissance de texte de scène.

Afin de résoudre ce problème, l'équipe de recherche de ByteDance et de l'East China Normal University a proposé un outil de reconnaissance de texte auto-évolutif, E2STR (Reconnaissance de texte de scène évolutive de l'ego). Il s'agit d'un outil de reconnaissance de texte de taille normale qui intègre des capacités d'apprentissage du contexte et peut s'adapter rapidement à différents scénarios de reconnaissance de texte sans avoir besoin de réglages précis

Lien papier : https://arxiv.org/pdf/2311.13120 .pdf

E2STR est équipé d'un mode de formation contextuelle et de raisonnement contextuel, qui atteint non seulement le niveau SOTA sur des ensembles de données conventionnels, mais peut également utiliser un modèle unique pour améliorer les performances de reconnaissance dans divers scénarios et réaliser une adaptation rapide à Nouveaux scénarios, dépassant même les performances de reconnaissance des modèles spécialisés après un réglage fin. E2STR démontre que les modèles de taille normale sont suffisants pour obtenir des capacités d'apprentissage contextuel efficaces dans les tâches de reconnaissance de texte.

Method

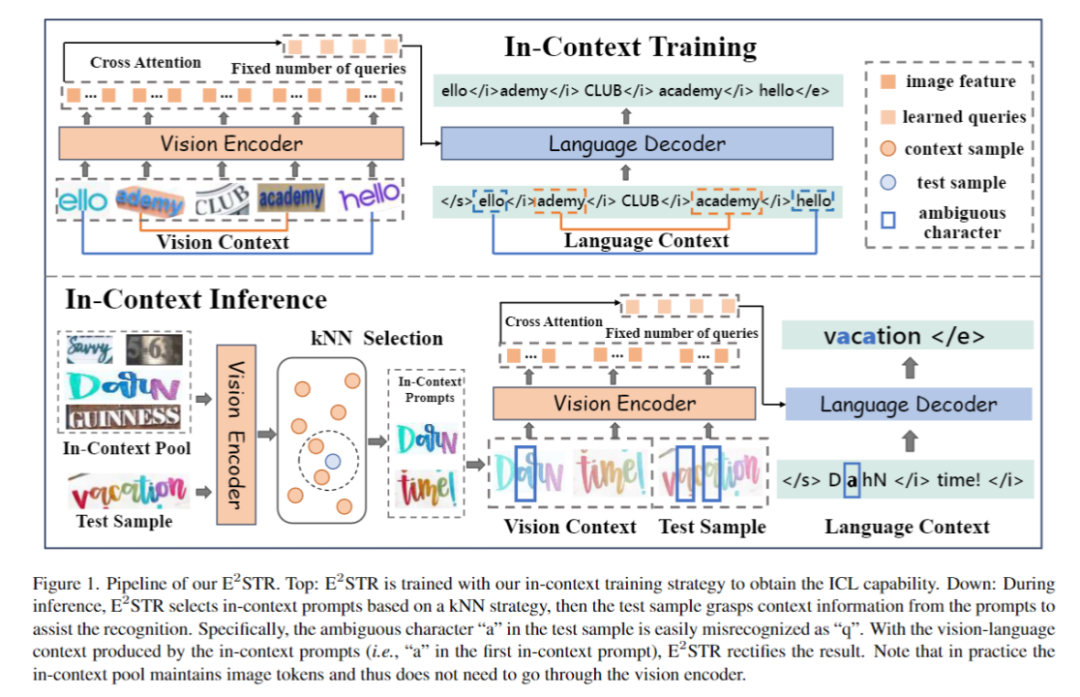

in Figure 1, le processus de formation et d'inférence de E2STR est montré

1. framework Le but de la formation de l'encodeur visuel et du décodeur de langage est d'obtenir des capacités de reconnaissance de texte :

2 Formation contextuelle

Phase de formation contextuelle E2STR sera davantage formé selon le paradigme de formation contextuelle proposé. dans l'article. À ce stade, E2STR apprendra à comprendre les liens entre différents échantillons pour acquérir des capacités de raisonnement à partir d'indices contextuels.

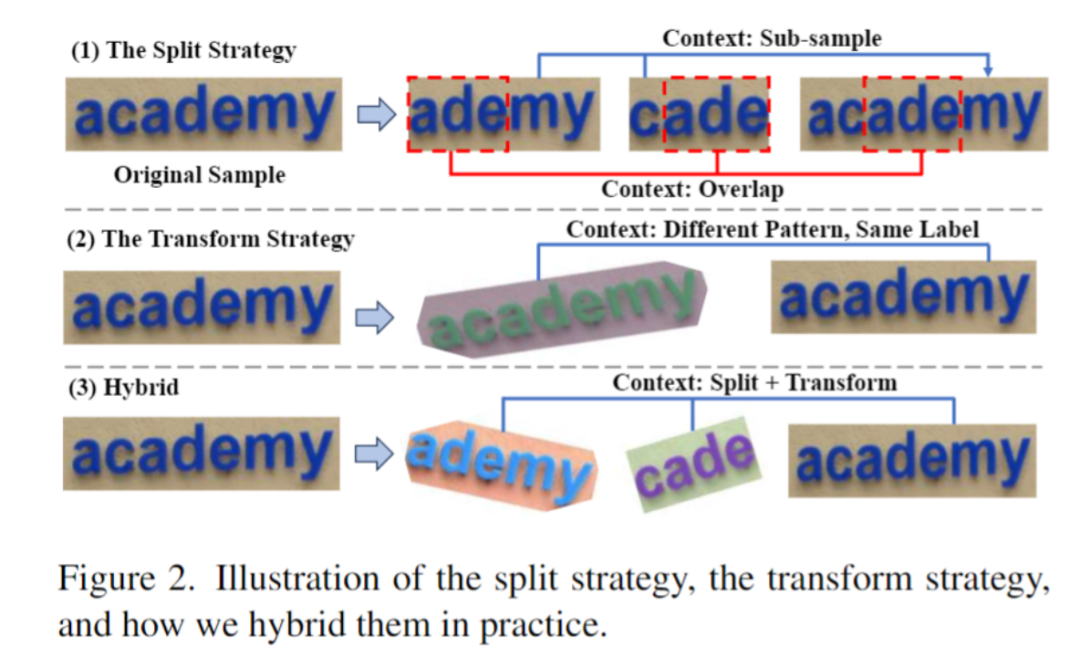

Comme le montre la figure 2, cet article propose la stratégie ST pour segmenter et transformer de manière aléatoire les données de texte de la scène pour générer un ensemble de « sous-échantillons ». Les sous-échantillons sont intrinsèquement liés visuellement et linguistiquement. Ces échantillons liés en interne sont fusionnés en une séquence, et le modèle apprend des connaissances contextuelles à partir de ces séquences sémantiquement riches, acquérant ainsi la capacité d'apprendre le contexte. Cette étape utilise également le cadre autorégressif pour l'entraînement :

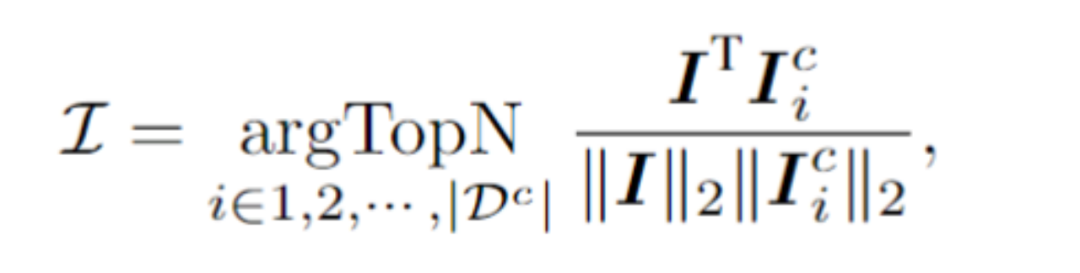

Le contenu à réécrire est : 3. Le raisonnement contextuel

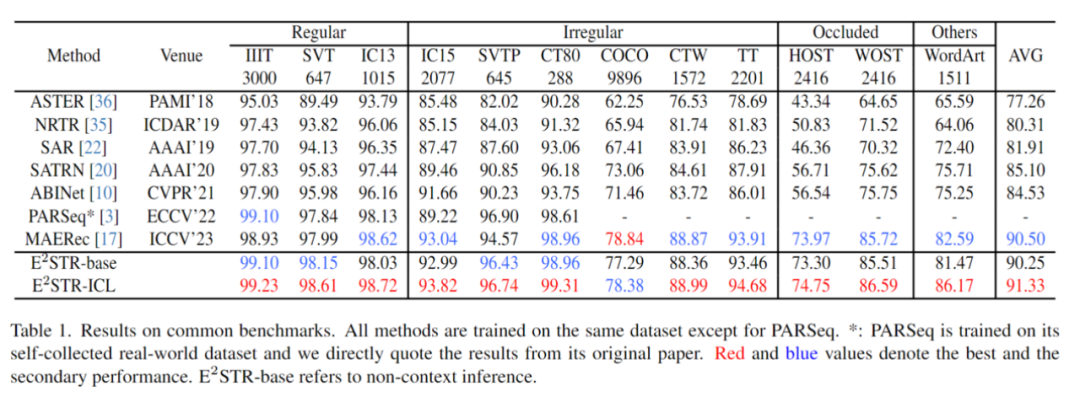

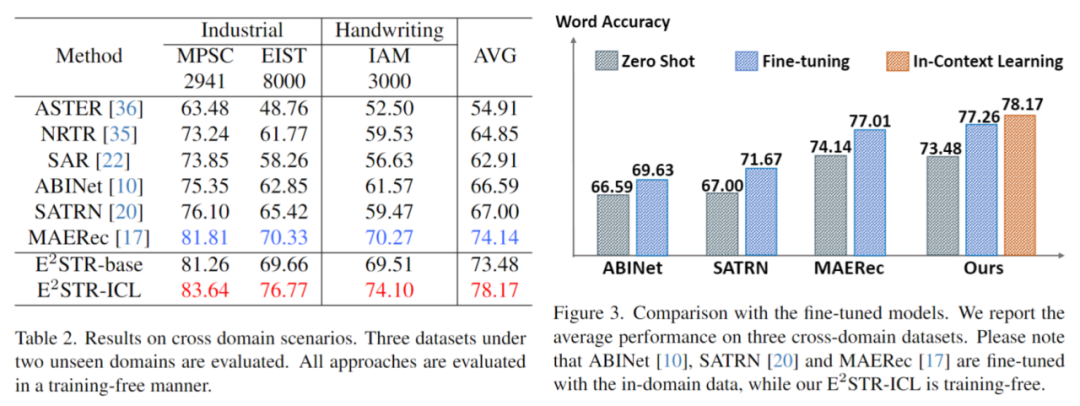

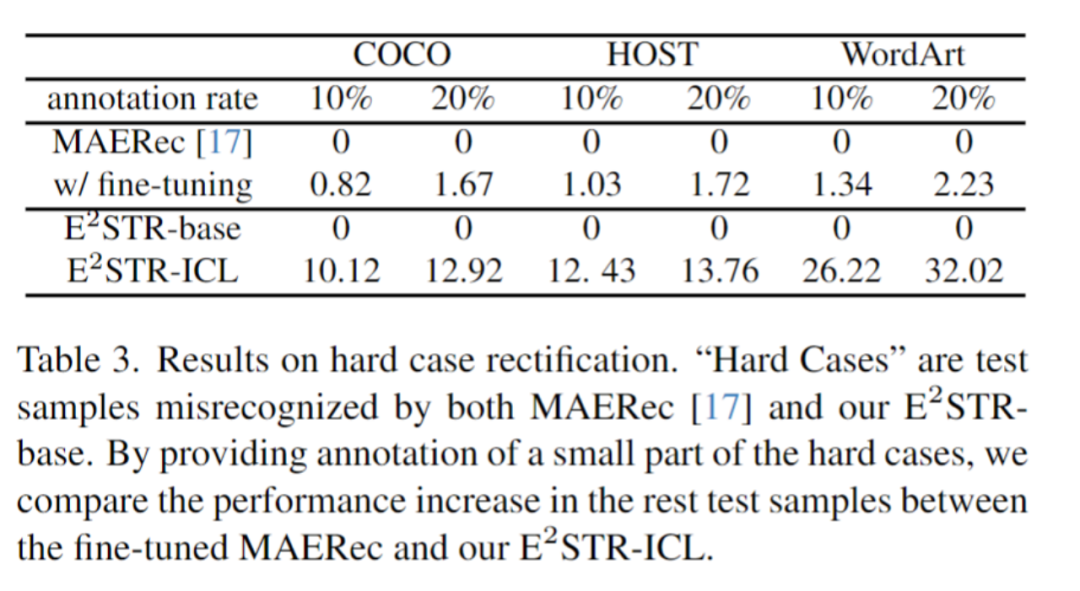

Contenu réécrit : 3. Raisonnement basé sur le contexte Pour un échantillon de test, le framework sélectionnera N échantillons dans le pool de signaux contextuels qui ont la plus grande similitude avec l'échantillon de test dans l'espace visuel latent. Plus précisément, cet article calcule l'intégration d'image I en faisant la moyenne du regroupement sur la séquence de jetons visuels. Ensuite, les N premiers échantillons présentant la similarité cosinusoïdale la plus élevée entre les incorporations d'images et I sont sélectionnés dans le pool de contexte, formant ainsi des indices contextuels. Une fois les indices contextuels et les échantillons de test assemblés et introduits dans le modèle, E2STR apprendra de nouvelles connaissances à partir des indices contextuels sans formation, améliorant ainsi la précision de reconnaissance des échantillons de test. Il est important de noter que le pool de repères contextuels ne conserve que les jetons émis par l'encodeur visuel, ce qui rend le processus de sélection des repères contextuels très efficace. De plus, étant donné que le pool d'indices contextuels est petit et que E2STR peut effectuer des inférences sans formation, la charge de calcul supplémentaire est également minimisée Les expériences sont principalement menées sous trois aspects : la reconnaissance de texte traditionnelle, respectivement -reconnaissance de scène de domaine et correction d'échantillons difficiles 1. Ensemble de données traditionnel Sélectionnez au hasard quelques échantillons (1 000, 0,025 % du nombre d'échantillons dans l'ensemble d'entraînement) dans l'ensemble d'entraînement pour former un pool d'invites de contexte, le test a été effectué sur 12 ensembles de tests de reconnaissance de texte de scène courants, et les résultats sont les suivants : On peut constater qu'E2STR s'est encore amélioré par rapport à l'ensemble de données traditionnel où les performances de reconnaissance sont presque saturé, dépassant les performances du modèle SOTA . Le contenu qui doit être réécrit est : 2. Scénario inter-domaines Dans le scénario inter-domaines, chaque ensemble de tests ne fournit que 100 échantillons de formation dans le domaine. Les résultats de comparaison entre aucune formation. et le réglage fin sont les suivants, E2STR dépasse même les résultats de réglage fin de la méthode SOTA. Le contenu qui doit être réécrit est le suivant : 3. Modifier les échantillons difficiles Les chercheurs ont collecté un lot d'échantillons difficiles et ont fourni 10 % à 20 % d'annotations pour ces échantillons par rapport à E2STR. Les résultats de la méthode d'apprentissage du contexte sans formation et de la méthode d'apprentissage de réglage fin de la méthode SOTA sont les suivants : Par rapport à la méthode de réglage fin, E2STR-ICL réduit considérablement le taux d'erreur des échantillons difficiles E2STR prouve qu'en utilisant des stratégies de formation et d'inférence appropriées, les petits modèles peuvent également avoir des capacités d'apprentissage en contexte similaires à celles du LLM. Dans certaines tâches nécessitant de fortes exigences en temps réel, de petits modèles peuvent également être utilisés pour s'adapter rapidement à de nouveaux scénarios. Plus important encore, cette méthode consistant à utiliser un modèle unique pour parvenir à une adaptation rapide à de nouveaux scénarios rapproche un peu plus de la construction d’un petit modèle unifié et efficace.

Expériences

Future Outlook

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Open source! Au-delà de ZoeDepth ! DepthFM : estimation rapide et précise de la profondeur monoculaire !

Apr 03, 2024 pm 12:04 PM

Open source! Au-delà de ZoeDepth ! DepthFM : estimation rapide et précise de la profondeur monoculaire !

Apr 03, 2024 pm 12:04 PM

0. À quoi sert cet article ? Nous proposons DepthFM : un modèle d'estimation de profondeur monoculaire génératif de pointe, polyvalent et rapide. En plus des tâches traditionnelles d'estimation de la profondeur, DepthFM démontre également des capacités de pointe dans les tâches en aval telles que l'inpainting en profondeur. DepthFM est efficace et peut synthétiser des cartes de profondeur en quelques étapes d'inférence. Lisons ce travail ensemble ~ 1. Titre des informations sur l'article : DepthFM : FastMonocularDepthEstimationwithFlowMatching Auteur : MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

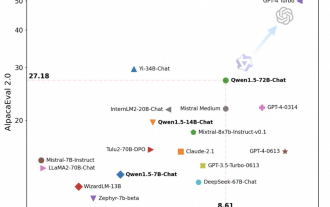

Tongyi Qianwen est à nouveau open source, Qwen1.5 propose six modèles de volume et ses performances dépassent GPT3.5

Feb 07, 2024 pm 10:15 PM

Tongyi Qianwen est à nouveau open source, Qwen1.5 propose six modèles de volume et ses performances dépassent GPT3.5

Feb 07, 2024 pm 10:15 PM

À temps pour la Fête du Printemps, la version 1.5 du modèle Tongyi Qianwen (Qwen) est en ligne. Ce matin, la nouvelle de la nouvelle version a attiré l'attention de la communauté IA. La nouvelle version du grand modèle comprend six tailles de modèle : 0,5B, 1,8B, 4B, 7B, 14B et 72B. Parmi eux, les performances de la version la plus puissante surpassent GPT3.5 et Mistral-Medium. Cette version inclut le modèle de base et le modèle Chat et fournit une prise en charge multilingue. L'équipe Tongyi Qianwen d'Alibaba a déclaré que la technologie pertinente avait également été lancée sur le site officiel de Tongyi Qianwen et sur l'application Tongyi Qianwen. De plus, la version actuelle de Qwen 1.5 présente également les points forts suivants : prend en charge une longueur de contexte de 32 Ko ; ouvre le point de contrôle du modèle Base+Chat ;

Abandonnez l'architecture codeur-décodeur et utilisez le modèle de diffusion pour la détection des contours avec de meilleurs résultats. L'Université nationale de technologie de la défense a proposé DiffusionEdge.

Feb 07, 2024 pm 10:12 PM

Abandonnez l'architecture codeur-décodeur et utilisez le modèle de diffusion pour la détection des contours avec de meilleurs résultats. L'Université nationale de technologie de la défense a proposé DiffusionEdge.

Feb 07, 2024 pm 10:12 PM

Les réseaux actuels de détection des contours profonds adoptent généralement une architecture d'encodeur-décodeur, qui contient des modules d'échantillonnage ascendant et descendant pour mieux extraire les fonctionnalités à plusieurs niveaux. Cependant, cette structure limite le réseau à produire des résultats de détection de contour précis et détaillés. En réponse à ce problème, un article sur AAAI2024 propose une nouvelle solution. Titre de la thèse : DiffusionEdge : DiffusionProbabilisticModelforCrispEdgeDetection Auteurs : Ye Yunfan (Université nationale de technologie de la défense), Xu Kai (Université nationale de technologie de la défense), Huang Yuxing (Université nationale de technologie de la défense), Yi Renjiao (Université nationale de technologie de la défense), Cai Zhiping (Université nationale de technologie de la défense) Lien vers l'article : https ://ar

Les grands modèles peuvent également être découpés, et Microsoft SliceGPT augmente considérablement l'efficacité de calcul de LAMA-2.

Jan 31, 2024 am 11:39 AM

Les grands modèles peuvent également être découpés, et Microsoft SliceGPT augmente considérablement l'efficacité de calcul de LAMA-2.

Jan 31, 2024 am 11:39 AM

Les grands modèles de langage (LLM) comportent généralement des milliards de paramètres et sont formés sur des milliards de jetons. Cependant, ces modèles sont très coûteux à former et à déployer. Afin de réduire les besoins de calcul, diverses techniques de compression de modèles sont souvent utilisées. Ces techniques de compression de modèles peuvent généralement être divisées en quatre catégories : distillation, décomposition tensorielle (y compris la factorisation de bas rang), élagage et quantification. Les méthodes d'élagage existent depuis un certain temps, mais beaucoup nécessitent un réglage fin de la récupération (RFT) après l'élagage pour maintenir les performances, ce qui rend l'ensemble du processus coûteux et difficile à faire évoluer. Des chercheurs de l'ETH Zurich et de Microsoft ont proposé une solution à ce problème appelée SliceGPT. L'idée principale de cette méthode est de réduire l'intégration du réseau en supprimant des lignes et des colonnes dans la matrice de pondération.

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas entre officiellement dans l’ère des robots électriques ! Hier, l'Atlas hydraulique s'est retiré "en larmes" de la scène de l'histoire. Aujourd'hui, Boston Dynamics a annoncé que l'Atlas électrique était au travail. Il semble que dans le domaine des robots humanoïdes commerciaux, Boston Dynamics soit déterminé à concurrencer Tesla. Après la sortie de la nouvelle vidéo, elle a déjà été visionnée par plus d’un million de personnes en seulement dix heures. Les personnes âgées partent et de nouveaux rôles apparaissent. C'est une nécessité historique. Il ne fait aucun doute que cette année est l’année explosive des robots humanoïdes. Les internautes ont commenté : Les progrès des robots ont fait ressembler la cérémonie d'ouverture de cette année à des êtres humains, et le degré de liberté est bien plus grand que celui des humains. Mais n'est-ce vraiment pas un film d'horreur ? Au début de la vidéo, Atlas est allongé calmement sur le sol, apparemment sur le dos. Ce qui suit est à couper le souffle

La version Kuaishou de Sora 'Ke Ling' est ouverte aux tests : génère plus de 120 s de vidéo, comprend mieux la physique et peut modéliser avec précision des mouvements complexes

Jun 11, 2024 am 09:51 AM

La version Kuaishou de Sora 'Ke Ling' est ouverte aux tests : génère plus de 120 s de vidéo, comprend mieux la physique et peut modéliser avec précision des mouvements complexes

Jun 11, 2024 am 09:51 AM

Quoi? Zootopie est-elle concrétisée par l’IA domestique ? Avec la vidéo est exposé un nouveau modèle de génération vidéo domestique à grande échelle appelé « Keling ». Sora utilise une voie technique similaire et combine un certain nombre d'innovations technologiques auto-développées pour produire des vidéos qui comportent non seulement des mouvements larges et raisonnables, mais qui simulent également les caractéristiques du monde physique et possèdent de fortes capacités de combinaison conceptuelle et d'imagination. Selon les données, Keling prend en charge la génération de vidéos ultra-longues allant jusqu'à 2 minutes à 30 ips, avec des résolutions allant jusqu'à 1080p, et prend en charge plusieurs formats d'image. Un autre point important est que Keling n'est pas une démo ou une démonstration de résultats vidéo publiée par le laboratoire, mais une application au niveau produit lancée par Kuaishou, un acteur leader dans le domaine de la vidéo courte. De plus, l'objectif principal est d'être pragmatique, de ne pas faire de chèques en blanc et de se mettre en ligne dès sa sortie. Le grand modèle de Ke Ling est déjà sorti à Kuaiying.

La vitalité de la super intelligence s'éveille ! Mais avec l'arrivée de l'IA qui se met à jour automatiquement, les mères n'ont plus à se soucier des goulots d'étranglement des données.

Apr 29, 2024 pm 06:55 PM

La vitalité de la super intelligence s'éveille ! Mais avec l'arrivée de l'IA qui se met à jour automatiquement, les mères n'ont plus à se soucier des goulots d'étranglement des données.

Apr 29, 2024 pm 06:55 PM

Je pleure à mort. Le monde construit à la folie de grands modèles. Les données sur Internet ne suffisent pas du tout. Le modèle de formation ressemble à « The Hunger Games », et les chercheurs en IA du monde entier se demandent comment nourrir ces personnes avides de données. Ce problème est particulièrement important dans les tâches multimodales. À une époque où rien ne pouvait être fait, une équipe de start-up du département de l'Université Renmin de Chine a utilisé son propre nouveau modèle pour devenir la première en Chine à faire de « l'auto-alimentation des données générées par le modèle » une réalité. De plus, il s’agit d’une approche à deux volets, du côté compréhension et du côté génération, les deux côtés peuvent générer de nouvelles données multimodales de haute qualité et fournir un retour de données au modèle lui-même. Qu'est-ce qu'un modèle ? Awaker 1.0, un grand modèle multimodal qui vient d'apparaître sur le Forum Zhongguancun. Qui est l'équipe ? Moteur Sophon. Fondé par Gao Yizhao, doctorant à la Hillhouse School of Artificial Intelligence de l’Université Renmin.

LLaVA-1.6, qui rattrape Gemini Pro et améliore les capacités de raisonnement et d'OCR, est trop puissant

Feb 01, 2024 pm 04:51 PM

LLaVA-1.6, qui rattrape Gemini Pro et améliore les capacités de raisonnement et d'OCR, est trop puissant

Feb 01, 2024 pm 04:51 PM

En avril de l'année dernière, des chercheurs de l'Université du Wisconsin-Madison, de Microsoft Research et de l'Université de Columbia ont publié conjointement LLaVA (Large Language and Vision Assistant). Bien que LLaVA ne soit entraîné qu'avec un petit ensemble de données d'instructions multimodales, il montre des résultats d'inférence très similaires à ceux de GPT-4 sur certains échantillons. Puis, en octobre, ils ont lancé LLaVA-1.5, qui a actualisé le SOTA en 11 tests avec de simples modifications par rapport au LLaVA original. Les résultats de cette mise à niveau sont très intéressants, apportant de nouvelles avancées dans le domaine des assistants IA multimodaux. L'équipe de recherche a annoncé le lancement de la version LLaVA-1.6, ciblant le raisonnement, l'OCR et