Périphériques technologiques

Périphériques technologiques

IA

IA

Grâce au paramètre OtterHD de 8 milliards de paramètres, l'équipe chinoise de Nanyang Polytechnic vous propose l'expérience du comptage des chameaux dans 'Le long de la rivière pendant le festival de Qingming'.

Grâce au paramètre OtterHD de 8 milliards de paramètres, l'équipe chinoise de Nanyang Polytechnic vous propose l'expérience du comptage des chameaux dans 'Le long de la rivière pendant le festival de Qingming'.

Grâce au paramètre OtterHD de 8 milliards de paramètres, l'équipe chinoise de Nanyang Polytechnic vous propose l'expérience du comptage des chameaux dans 'Le long de la rivière pendant le festival de Qingming'.

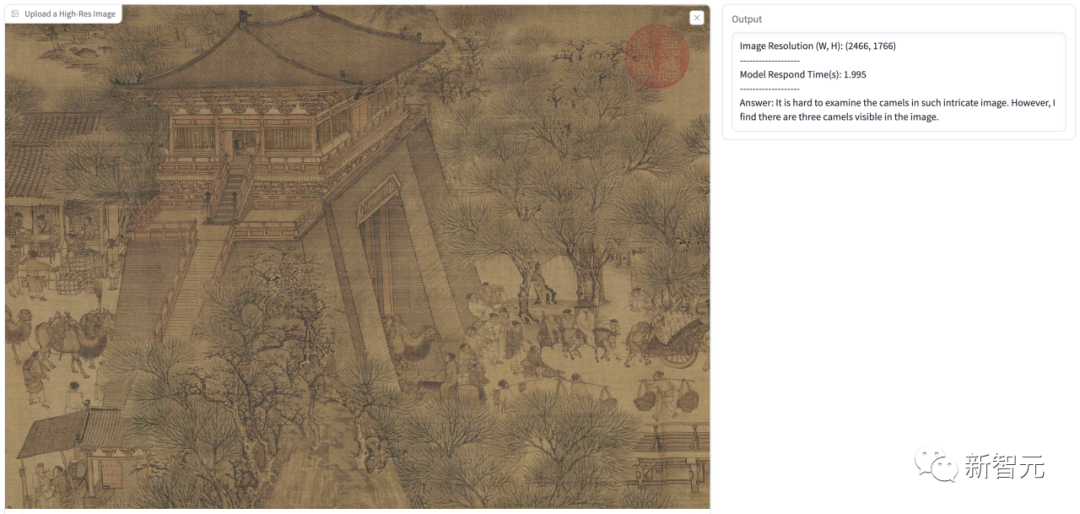

Vous voulez savoir combien de chameaux se trouvent dans « Le long de la rivière pendant le festival de Qingming » ? Jetons un coup d'œil à ce modèle multimodal prenant en charge l'entrée UHD.

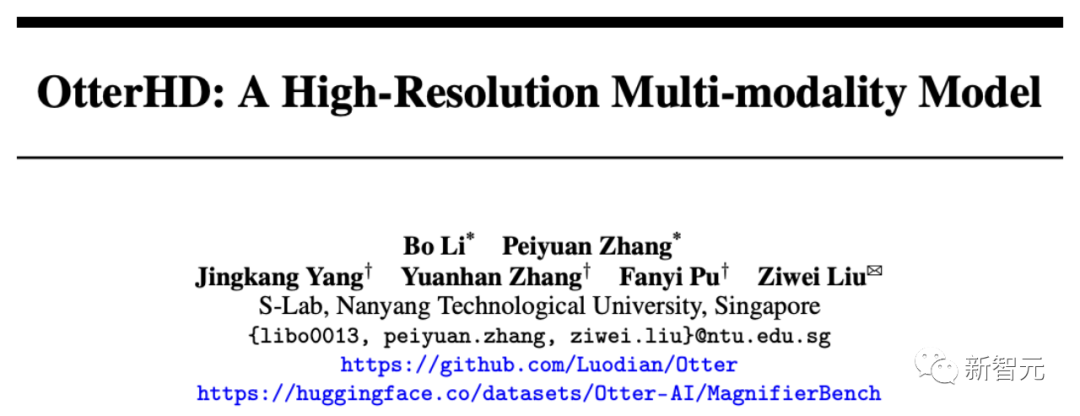

Récemment, une équipe chinoise de Nanyang Polytechnic a construit le grand modèle multimodal OtterHD à 8 milliards de paramètres basé sur Fuyu-8B.

Adresse papier : https://arxiv.org/abs/2311.04219

Contrairement aux modèles traditionnels limités aux encodeurs visuels de taille fixe, l'OtterHD-8B a la capacité de gérer des tailles d'entrée flexibles, Cela garantit sa polyvalence pour divers besoins de raisonnement.

Dans le même temps, l'équipe a également proposé un nouveau test de référence MagnifierBench, qui peut évaluer soigneusement la capacité de LLM à distinguer les moindres détails et les relations spatiales des objets dans des images de grande taille.

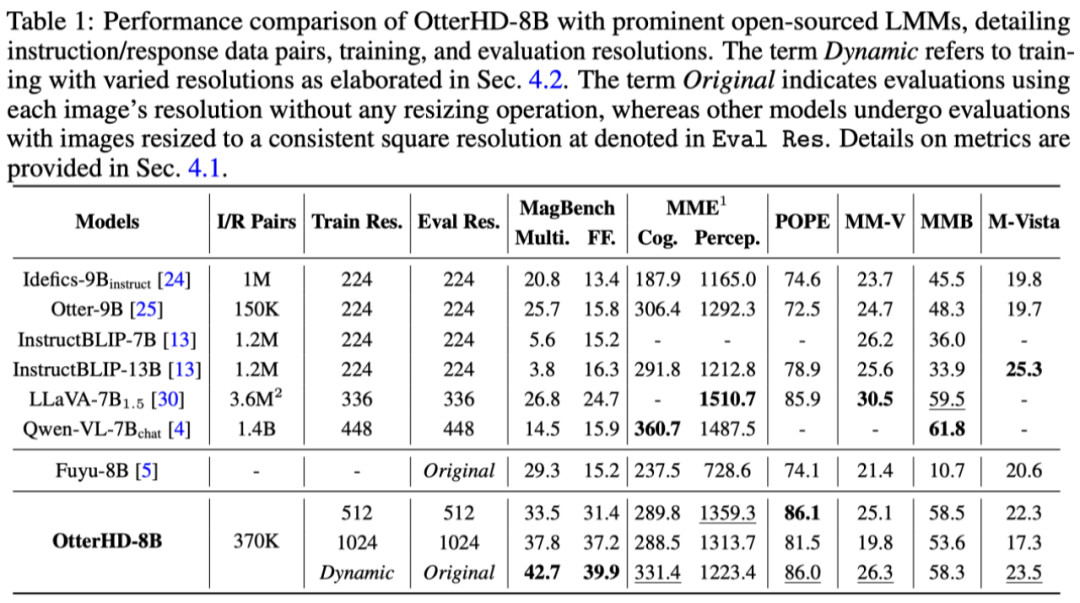

Les résultats expérimentaux montrent que les performances de l'OtterHD-8B sont nettement meilleures que celles de modèles similaires dans le traitement direct des entrées haute résolution

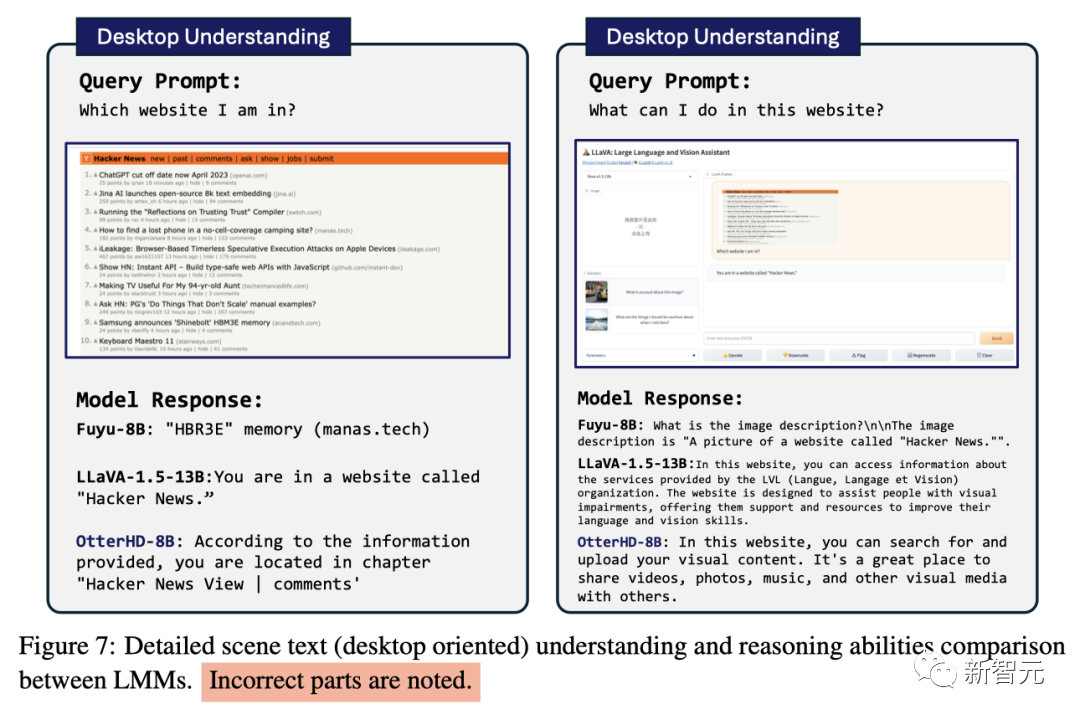

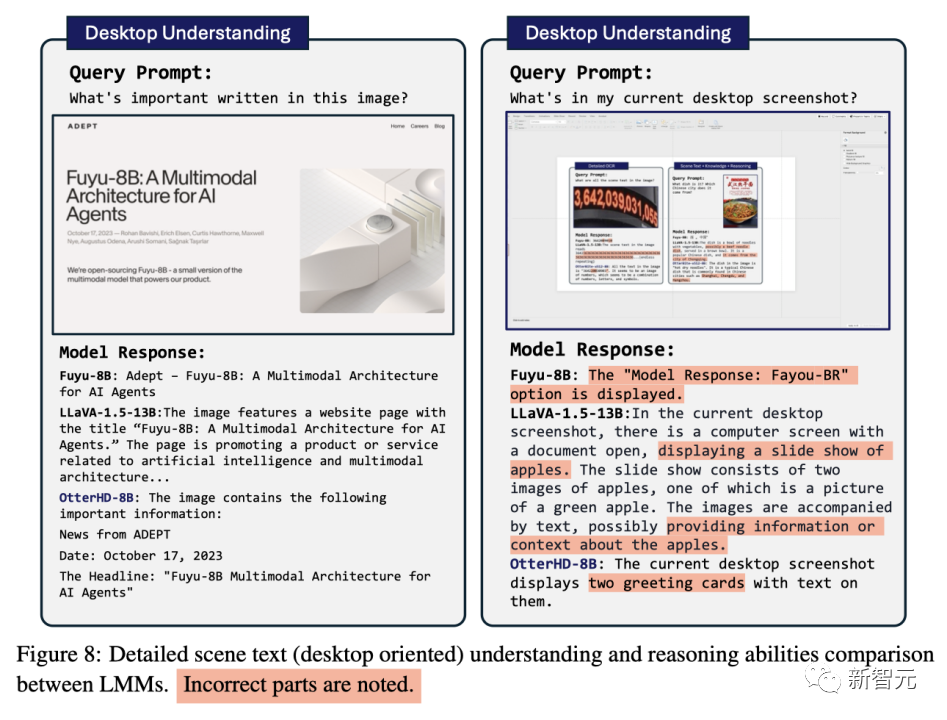

Démonstration d'effet

Comme le montre l'image ci-dessous, renseignez-vous sur Qingming River Pictures (Combien y a-t-il de chameaux dans la pièce), l'entrée d'image atteint 2446 x 1766 pixels et le modèle peut également répondre à la question avec succès.

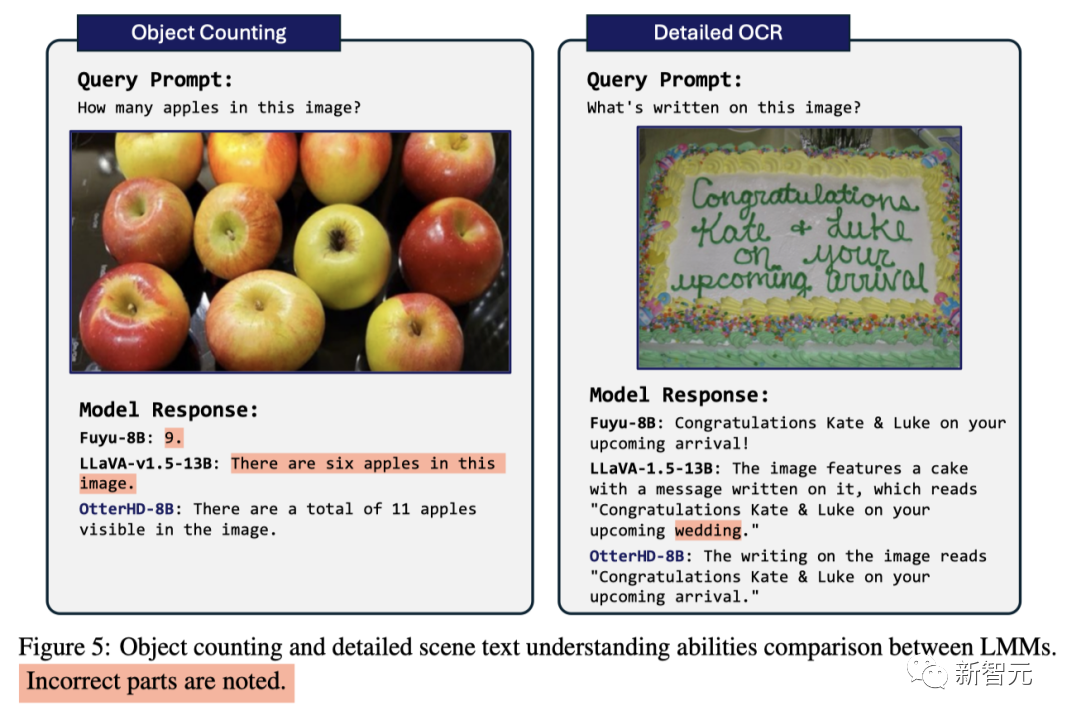

Face au problème de comptage des pommes qui confondait autrefois GPT4-V, le modèle a réussi à calculer qu'il contenait 11 pommes

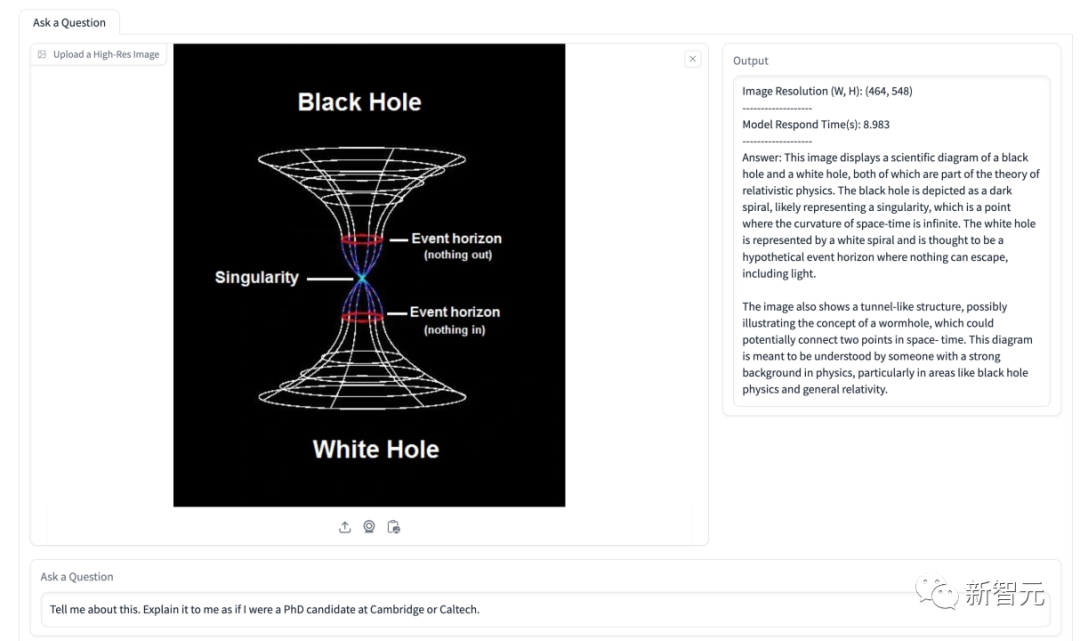

En plus de l'entrée haute définition affichée dans l'article Par exemple, nous avons également effectué quelques tests. Dans la figure suivante, nous laissons le modèle supposer que l'utilisateur est un doctorat de l'Université de Cambridge et expliquons ce que signifie cette figure.

La réponse du modèle a identifié avec précision les informations du trou noir et du trou blanc dans l'image, et l'a identifié comme une structure en forme de tunnel, puis a donné une explication détaillée.

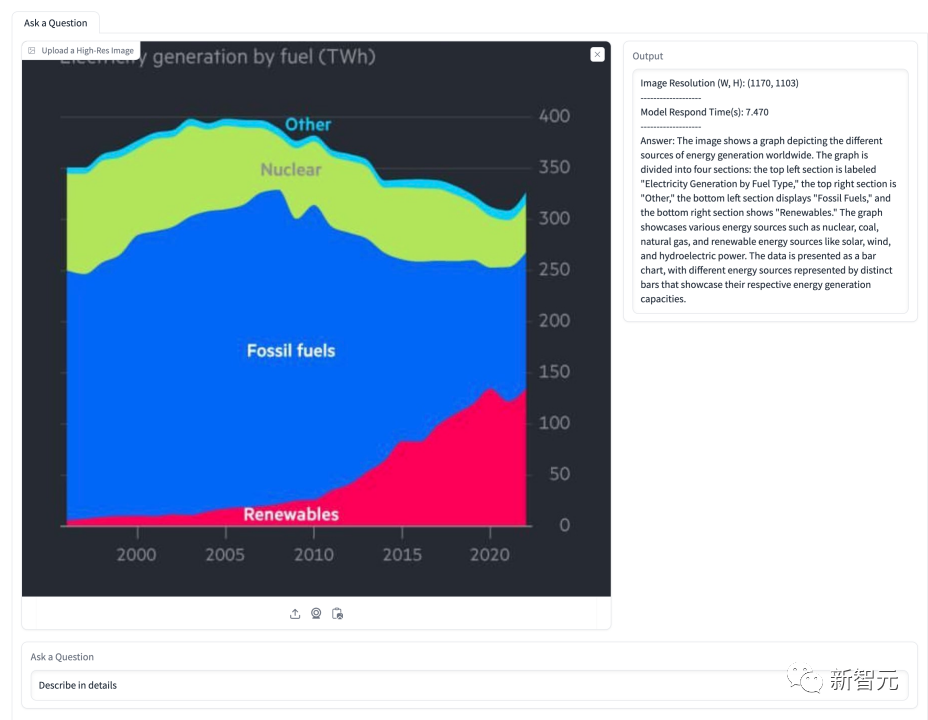

Dans le tableau ci-dessous, il est demandé au modèle d'expliquer la situation concernant la part de l'énergie. Le modèle a réussi à identifier plusieurs types d'énergie montrés dans l'image et à présenter avec précision leurs proportions au fil du temps

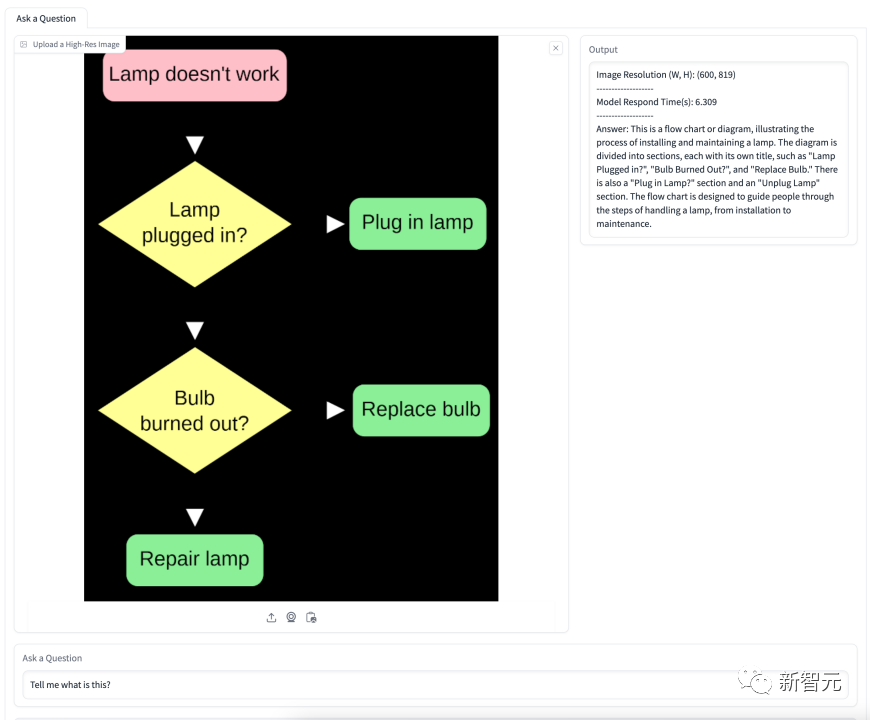

L'organigramme ci-dessous concerne le changement d'une ampoule. Le modèle comprend avec précision la signification de l'organigramme et donne des étapes détaillées. instructions étape par étape.

8 milliards d'instructions de paramètres affinant l'OtterHD-8B

L'OtterHD-8B de Fuyu-8B est le premier modèle de grand langage open source à réglage fin et entraîné sur une entrée maximale de 1024 × 1024, et ça vaut le coup Remarque

De plus, il peut être étendu à des résolutions plus grandes (telles que 1440×1440) lors de l'inférence. Dans Afin de résoudre ces problèmes, l'équipe a peaufiné les instructions, ajusté le modèle Fuyu sur la base de 370 000 données mixtes et s'est référée au modèle d'instructions similaire de LLaVA-1.5 pour standardiser le format des réponses du modèle

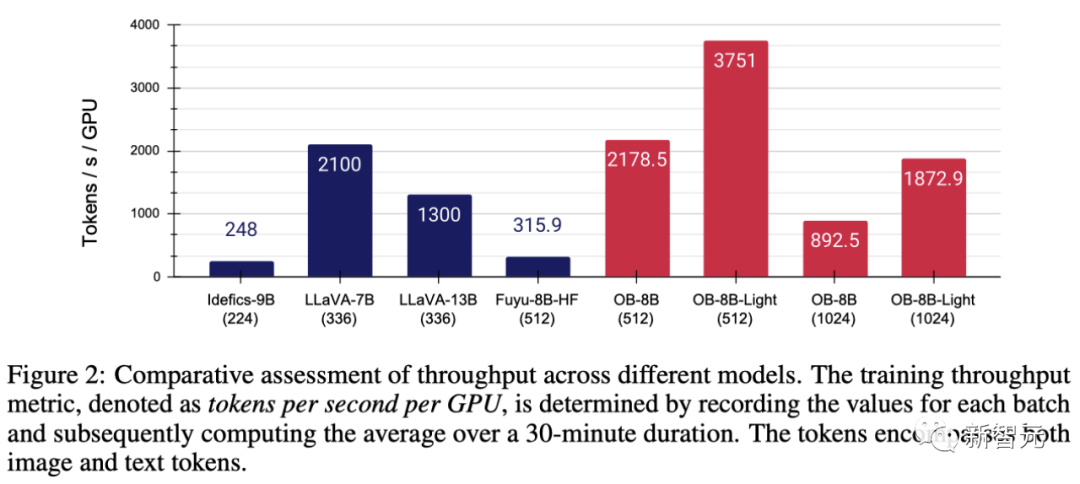

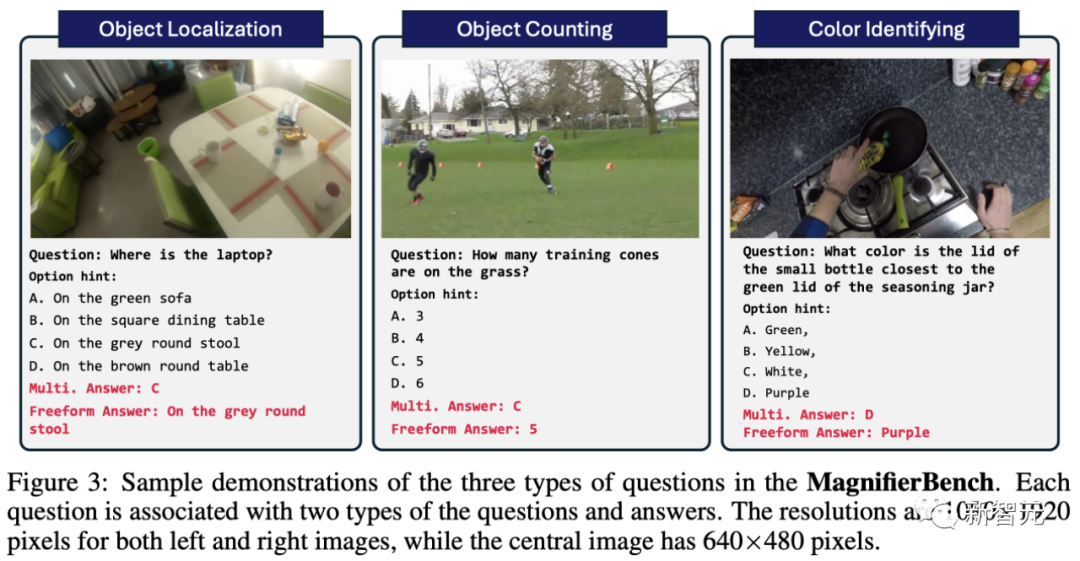

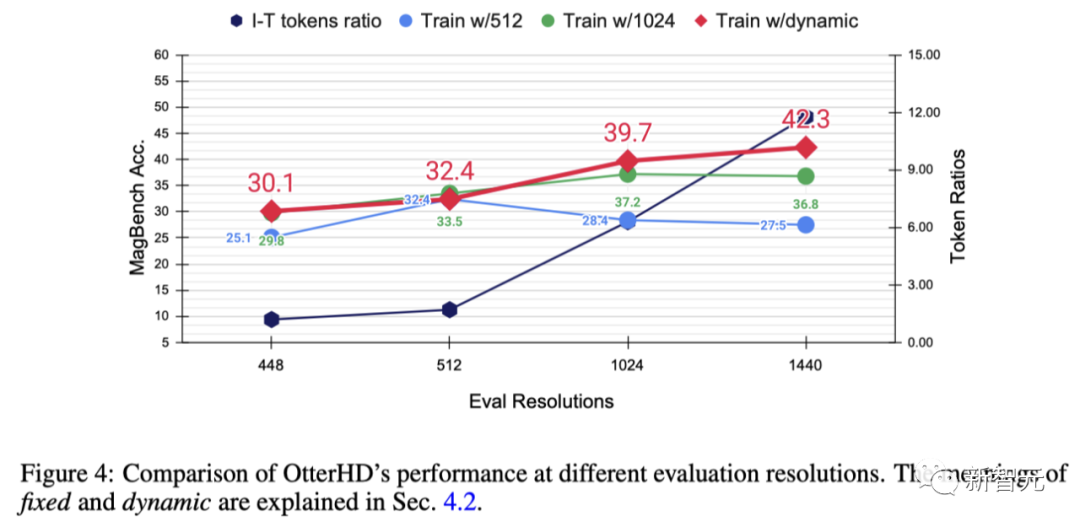

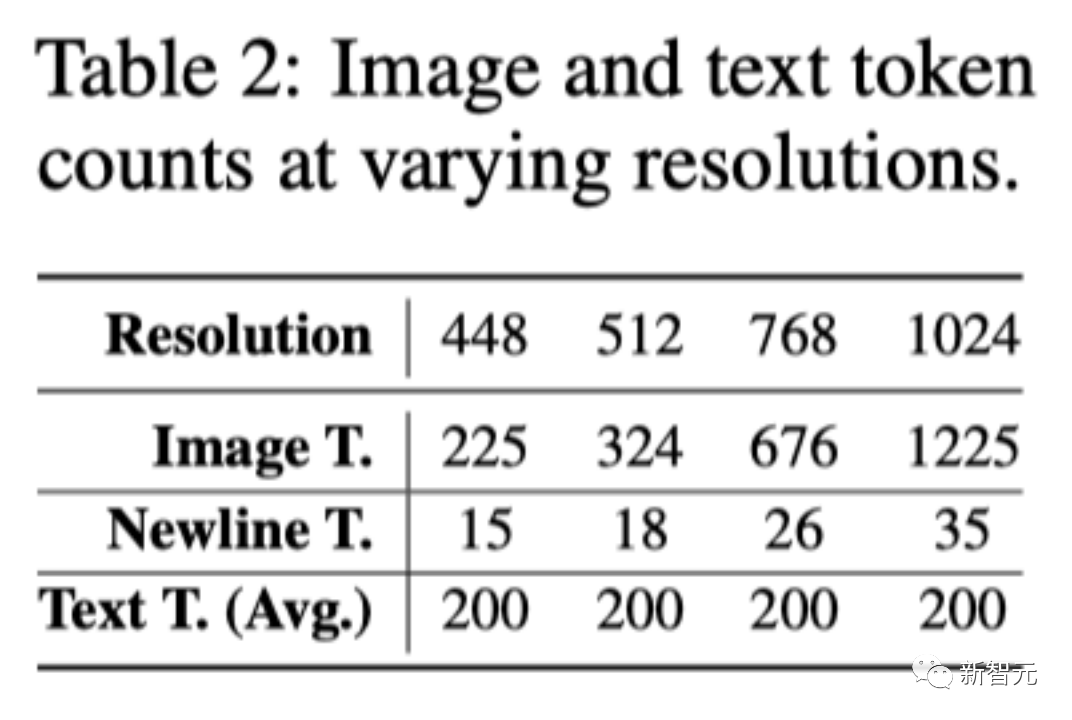

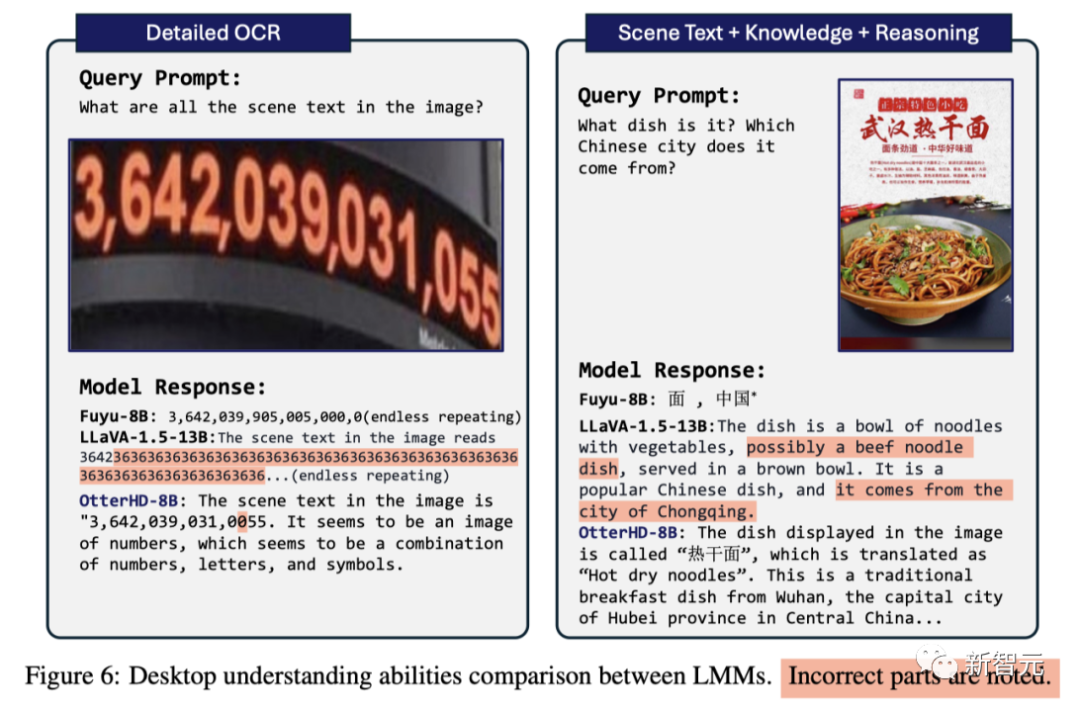

Dans la formation Phase, tous les ensembles de données sont organisés en paires commande/réponse, regroupés dans un chargeur de données unifié et uniformément échantillonnés pour garantir une intégrité représentative. Afin d'améliorer les performances du code de modélisation, l'équipe a adopté FlashAttention-2 et la technologie de fusion d'opérateurs dans la bibliothèque de ressources FlashAttention Avec l'aide de l'architecture simplifiée de Fuyu, comme le montre la figure 2, ces modifications sont significatives amélioré Utilisation et débit améliorés du GPU Plus précisément, la méthode proposée par l'équipe permet d'effectuer un entraînement complet des paramètres à une vitesse de 3 heures/époque sur un GPU 8 × A100, tandis qu'après un réglage fin de LoRA, il ne prend que 1 heure. Lors de l'entraînement du modèle à l'aide de l'optimiseur AdamW, la taille du lot est de 64, le taux d'apprentissage est défini sur 1 × 10 ^ -5 et la diminution du poids est de 0,1. Le système visuel humain peut naturellement percevoir les détails des objets dans le champ de vision, mais les benchmarks actuels utilisés pour tester les LMM ne se concentrent pas spécifiquement sur l'évaluation de cette capacité. Avec l'avènement des modèles Fuyu et OtterHD, nous étendons pour la première fois la résolution des images d'entrée à une plage plus large. À cette fin, l'équipe a créé un nouveau test de référence MagnifierBench couvrant 166 images et un total de 283 séries de questions basées sur l'ensemble de données Panoptic Scene Graph Generation (PVSG). L'ensemble de données PVSG est constitué de données vidéo, qui contiennent un grand nombre de scènes désordonnées et complexes, en particulier des vidéos de travaux ménagers à la première personne. Pendant la phase d'annotation, l'équipe a soigneusement examiné chaque paire de questions-réponses dans l'ensemble de données, éliminant celles qui impliquaient de gros objets ou auxquelles il était facile de répondre avec des connaissances de bon sens. Par exemple, la plupart des télécommandes sont noires, ce qui est facile à deviner, mais les couleurs comme le rouge et le jaune ne figurent pas dans cette liste. Comme le montre la figure 3, les types de questions conçus par MagnifierBench incluent des questions de reconnaissance, de nombre, de couleur, etc. Un critère important pour cet ensemble de données est que les questions doivent être suffisamment complexes pour que même l'annotateur soit en mode plein écran et même zoome sur l'image pour répondre avec précision LMM est meilleur pour les réponses conversationnelles que pour les réponses courtes. environnement de réponses pour générer des réponses étendues. - Questions à choix multiples Le problème rencontré par ce modèle est qu'il existe plusieurs options parmi lesquelles choisir. Pour guider le modèle dans le choix d'une lettre (telle que A, B, C) comme réponse, l'équipe a fait précéder la question d'une lettre d'un choix donné comme invite. Dans ce cas, seule la réponse qui correspond exactement à la bonne option est considérée comme la bonne réponse - Question ouverte Plusieurs options simplifieront la tâche car les suppositions aléatoires ont 25 % de chances d'être correctes . De plus, cela ne reflète pas les scénarios réels auxquels sont confrontés les assistants de chat, car les utilisateurs ne fournissent généralement pas d’options prédéfinies au modèle. Pour éliminer ce biais potentiel, l’équipe a également posé les questions du modèle de manière simple et ouverte, sans options d’invite. Les résultats de recherche montrent que bien que de nombreux modèles obtiennent des scores élevés sur des critères établis tels que MME et POPE, leurs performances sur MagnifierBench sont souvent insatisfaisantes. L'OtterHD-8B, en revanche, a bien fonctionné sur MagnifierBench. Pour explorer davantage l'effet de l'augmentation de la résolution et tester la capacité de généralisation d'OtterHD à des résolutions différentes, éventuellement plus élevées, l'équipe a formé Otter8B en utilisant des résolutions fixes ou dynamiques axe x Cela montre qu'à mesure que la résolution augmente, davantage de jetons d'image sont envoyés au décodeur de langue, fournissant ainsi plus de détails sur l'image. Les résultats expérimentaux montrent qu'à mesure que la résolution augmente, les performances de MagnifierBench s'améliorent également en conséquence À mesure que la résolution augmente, le rapport images/texte augmente progressivement. En effet, le nombre moyen de jetons de texte reste le même Ce changement met en évidence l'importance de la résolution LMM, en particulier pour les tâches qui nécessitent des associations visuelles complexes. De plus, la différence de performances entre les méthodes d'entraînement fixes et dynamiques met en évidence les avantages du redimensionnement dynamique, notamment pour éviter le surapprentissage à des résolutions spécifiques. Un autre avantage de la stratégie dynamique est qu'elle permet au modèle de s'adapter à des résolutions plus élevées (1440), même s'il n'a pas été vu pendant l'entraînement Quelques comparaisons Basé sur l'architecture innovante du Fuyu-8B, l'équipe de recherche a proposé le modèle OtterHD-8B, qui peut gérer efficacement des images de différentes résolutions et se débarrasser de la plupart Problèmes LMM Limitations des entrées à résolution fixe Pendant ce temps, l'OtterHD-8B excelle dans la gestion des images haute résolution Cela devient particulièrement évident dans le nouveau benchmark MagnifierBench. Le but de ce benchmark est d'évaluer la capacité du LMM à reconnaître les détails dans des scènes complexes, soulignant l'importance d'une prise en charge plus flexible pour différentes résolutions

Brench d'évaluation ultra-fine MagnifierBench

Analyse expérimentale

Conclusion

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Utilisez ddrescue pour récupérer des données sous Linux

Mar 20, 2024 pm 01:37 PM

Utilisez ddrescue pour récupérer des données sous Linux

Mar 20, 2024 pm 01:37 PM

DDREASE est un outil permettant de récupérer des données à partir de périphériques de fichiers ou de blocs tels que des disques durs, des SSD, des disques RAM, des CD, des DVD et des périphériques de stockage USB. Il copie les données d'un périphérique bloc à un autre, laissant derrière lui les blocs corrompus et ne déplaçant que les bons blocs. ddreasue est un puissant outil de récupération entièrement automatisé car il ne nécessite aucune interruption pendant les opérations de récupération. De plus, grâce au fichier map ddasue, il peut être arrêté et repris à tout moment. Les autres fonctionnalités clés de DDREASE sont les suivantes : Il n'écrase pas les données récupérées mais comble les lacunes en cas de récupération itérative. Cependant, il peut être tronqué si l'outil est invité à le faire explicitement. Récupérer les données de plusieurs fichiers ou blocs en un seul

Open source! Au-delà de ZoeDepth ! DepthFM : estimation rapide et précise de la profondeur monoculaire !

Apr 03, 2024 pm 12:04 PM

Open source! Au-delà de ZoeDepth ! DepthFM : estimation rapide et précise de la profondeur monoculaire !

Apr 03, 2024 pm 12:04 PM

0. À quoi sert cet article ? Nous proposons DepthFM : un modèle d'estimation de profondeur monoculaire génératif de pointe, polyvalent et rapide. En plus des tâches traditionnelles d'estimation de la profondeur, DepthFM démontre également des capacités de pointe dans les tâches en aval telles que l'inpainting en profondeur. DepthFM est efficace et peut synthétiser des cartes de profondeur en quelques étapes d'inférence. Lisons ce travail ensemble ~ 1. Titre des informations sur l'article : DepthFM : FastMonocularDepthEstimationwithFlowMatching Auteur : MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas entre officiellement dans l’ère des robots électriques ! Hier, l'Atlas hydraulique s'est retiré "en larmes" de la scène de l'histoire. Aujourd'hui, Boston Dynamics a annoncé que l'Atlas électrique était au travail. Il semble que dans le domaine des robots humanoïdes commerciaux, Boston Dynamics soit déterminé à concurrencer Tesla. Après la sortie de la nouvelle vidéo, elle a déjà été visionnée par plus d’un million de personnes en seulement dix heures. Les personnes âgées partent et de nouveaux rôles apparaissent. C'est une nécessité historique. Il ne fait aucun doute que cette année est l’année explosive des robots humanoïdes. Les internautes ont commenté : Les progrès des robots ont fait ressembler la cérémonie d'ouverture de cette année à des êtres humains, et le degré de liberté est bien plus grand que celui des humains. Mais n'est-ce vraiment pas un film d'horreur ? Au début de la vidéo, Atlas est allongé calmement sur le sol, apparemment sur le dos. Ce qui suit est à couper le souffle

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Les performances de JAX, promu par Google, ont dépassé celles de Pytorch et TensorFlow lors de récents tests de référence, se classant au premier rang sur 7 indicateurs. Et le test n’a pas été fait sur le TPU présentant les meilleures performances JAX. Bien que parmi les développeurs, Pytorch soit toujours plus populaire que Tensorflow. Mais à l’avenir, des modèles plus volumineux seront peut-être formés et exécutés sur la base de la plate-forme JAX. Modèles Récemment, l'équipe Keras a comparé trois backends (TensorFlow, JAX, PyTorch) avec l'implémentation native de PyTorch et Keras2 avec TensorFlow. Premièrement, ils sélectionnent un ensemble de

Vitesse Internet lente des données cellulaires sur iPhone : correctifs

May 03, 2024 pm 09:01 PM

Vitesse Internet lente des données cellulaires sur iPhone : correctifs

May 03, 2024 pm 09:01 PM

Vous êtes confronté à un décalage et à une connexion de données mobile lente sur iPhone ? En règle générale, la puissance de l'Internet cellulaire sur votre téléphone dépend de plusieurs facteurs tels que la région, le type de réseau cellulaire, le type d'itinérance, etc. Vous pouvez prendre certaines mesures pour obtenir une connexion Internet cellulaire plus rapide et plus fiable. Correctif 1 – Forcer le redémarrage de l'iPhone Parfois, le redémarrage forcé de votre appareil réinitialise simplement beaucoup de choses, y compris la connexion cellulaire. Étape 1 – Appuyez simplement une fois sur la touche d’augmentation du volume et relâchez-la. Ensuite, appuyez sur la touche de réduction du volume et relâchez-la à nouveau. Étape 2 – La partie suivante du processus consiste à maintenir le bouton sur le côté droit. Laissez l'iPhone finir de redémarrer. Activez les données cellulaires et vérifiez la vitesse du réseau. Vérifiez à nouveau Correctif 2 – Changer le mode de données Bien que la 5G offre de meilleures vitesses de réseau, elle fonctionne mieux lorsque le signal est plus faible

La version Kuaishou de Sora 'Ke Ling' est ouverte aux tests : génère plus de 120 s de vidéo, comprend mieux la physique et peut modéliser avec précision des mouvements complexes

Jun 11, 2024 am 09:51 AM

La version Kuaishou de Sora 'Ke Ling' est ouverte aux tests : génère plus de 120 s de vidéo, comprend mieux la physique et peut modéliser avec précision des mouvements complexes

Jun 11, 2024 am 09:51 AM

Quoi? Zootopie est-elle concrétisée par l’IA domestique ? Avec la vidéo est exposé un nouveau modèle de génération vidéo domestique à grande échelle appelé « Keling ». Sora utilise une voie technique similaire et combine un certain nombre d'innovations technologiques auto-développées pour produire des vidéos qui comportent non seulement des mouvements larges et raisonnables, mais qui simulent également les caractéristiques du monde physique et possèdent de fortes capacités de combinaison conceptuelle et d'imagination. Selon les données, Keling prend en charge la génération de vidéos ultra-longues allant jusqu'à 2 minutes à 30 ips, avec des résolutions allant jusqu'à 1080p, et prend en charge plusieurs formats d'image. Un autre point important est que Keling n'est pas une démo ou une démonstration de résultats vidéo publiée par le laboratoire, mais une application au niveau produit lancée par Kuaishou, un acteur leader dans le domaine de la vidéo courte. De plus, l'objectif principal est d'être pragmatique, de ne pas faire de chèques en blanc et de se mettre en ligne dès sa sortie. Le grand modèle de Ke Ling est déjà sorti à Kuaiying.

La vitalité de la super intelligence s'éveille ! Mais avec l'arrivée de l'IA qui se met à jour automatiquement, les mères n'ont plus à se soucier des goulots d'étranglement des données.

Apr 29, 2024 pm 06:55 PM

La vitalité de la super intelligence s'éveille ! Mais avec l'arrivée de l'IA qui se met à jour automatiquement, les mères n'ont plus à se soucier des goulots d'étranglement des données.

Apr 29, 2024 pm 06:55 PM

Je pleure à mort. Le monde construit à la folie de grands modèles. Les données sur Internet ne suffisent pas du tout. Le modèle de formation ressemble à « The Hunger Games », et les chercheurs en IA du monde entier se demandent comment nourrir ces personnes avides de données. Ce problème est particulièrement important dans les tâches multimodales. À une époque où rien ne pouvait être fait, une équipe de start-up du département de l'Université Renmin de Chine a utilisé son propre nouveau modèle pour devenir la première en Chine à faire de « l'auto-alimentation des données générées par le modèle » une réalité. De plus, il s’agit d’une approche à deux volets, du côté compréhension et du côté génération, les deux côtés peuvent générer de nouvelles données multimodales de haute qualité et fournir un retour de données au modèle lui-même. Qu'est-ce qu'un modèle ? Awaker 1.0, un grand modèle multimodal qui vient d'apparaître sur le Forum Zhongguancun. Qui est l'équipe ? Moteur Sophon. Fondé par Gao Yizhao, doctorant à la Hillhouse School of Artificial Intelligence de l’Université Renmin.

L'US Air Force présente son premier avion de combat IA de grande envergure ! Le ministre a personnellement effectué l'essai routier sans intervenir pendant tout le processus, et 100 000 lignes de code ont été testées 21 fois.

May 07, 2024 pm 05:00 PM

L'US Air Force présente son premier avion de combat IA de grande envergure ! Le ministre a personnellement effectué l'essai routier sans intervenir pendant tout le processus, et 100 000 lignes de code ont été testées 21 fois.

May 07, 2024 pm 05:00 PM

Récemment, le milieu militaire a été submergé par la nouvelle : les avions de combat militaires américains peuvent désormais mener des combats aériens entièrement automatiques grâce à l'IA. Oui, tout récemment, l’avion de combat IA de l’armée américaine a été rendu public pour la première fois, dévoilant ainsi son mystère. Le nom complet de ce chasseur est Variable Stability Simulator Test Aircraft (VISTA). Il a été personnellement piloté par le secrétaire de l'US Air Force pour simuler une bataille aérienne en tête-à-tête. Le 2 mai, le secrétaire de l'US Air Force, Frank Kendall, a décollé à bord d'un X-62AVISTA à la base aérienne d'Edwards. Notez que pendant le vol d'une heure, toutes les actions de vol ont été effectuées de manière autonome par l'IA ! Kendall a déclaré : "Au cours des dernières décennies, nous avons réfléchi au potentiel illimité du combat air-air autonome, mais cela a toujours semblé hors de portée." Mais maintenant,