Périphériques technologiques

Périphériques technologiques

IA

IA

Résumé de la collaboration entre l'Université nationale des sciences et technologies et la Première université normale : Révéler comment les réseaux tenseurs « boîte blanche » peuvent améliorer l'interprétabilité et l'efficacité de l'apprentissage automatique quantique

Résumé de la collaboration entre l'Université nationale des sciences et technologies et la Première université normale : Révéler comment les réseaux tenseurs « boîte blanche » peuvent améliorer l'interprétabilité et l'efficacité de l'apprentissage automatique quantique

Résumé de la collaboration entre l'Université nationale des sciences et technologies et la Première université normale : Révéler comment les réseaux tenseurs « boîte blanche » peuvent améliorer l'interprétabilité et l'efficacité de l'apprentissage automatique quantique

Éditeur | Ziluo

L'apprentissage automatique profond a obtenu un succès remarquable dans divers domaines de l'IA, mais atteindre à la fois une interprétabilité élevée et une efficacité élevée reste un défi de taille

Réseau Tensor, à savoir Tensor Network (TN), issu de la mécanique quantique, est un outil mathématique mature. Il a démontré des avantages uniques dans le développement de solutions efficaces d'apprentissage automatique « boîte blanche »

Récemment, Ran Shiju de la Capital Normal University et Su Gang de l'Université de l'Académie chinoise des sciences se sont inspirés de la mécanique quantique et ont examiné une méthode d'innovation basée sur le TN, apportant une solution prometteuse au défi de longue date consistant à concilier interprétabilité et efficacité dans l’apprentissage automatique profond.

D'une part, l'interprétabilité de TN ML peut être obtenue grâce à une base théorique solide basée sur l'information quantique et la physique à N corps. D’un autre côté, une expression TN puissante et des techniques informatiques avancées développées en physique quantique à N corps peuvent atteindre une efficacité élevée. Avec le développement rapide des ordinateurs quantiques, TN devrait produire dans un avenir proche de nouvelles solutions pouvant fonctionner sur du matériel quantique dans le sens de « l'IA quantique ». Inspired Machine Learning

" s'intitulait "Intelligent Computing" et a été publié le 17 novembre 2023.

Lien papier :  https://spj.science.org/doi/10.34133/icomputing.0061

https://spj.science.org/doi/10.34133/icomputing.0061

Les modèles d'apprentissage profond, en particulier les modèles de réseaux neuronaux, sont souvent appelés « boîtes noires » en raison de leur décision. Le processus de fabrication est complexe et difficile à expliquer. Les réseaux de neurones constituent actuellement le modèle d’apprentissage profond le plus puissant. Un excellent exemple de sa puissance est le GPT. Cependant, en raison du manque d'explicabilité, même GPT est confronté à de sérieux problèmes tels que la robustesse et la protection de la vie privée.

Le manque d'explicabilité de ces modèles peut conduire à un manque de confiance dans leurs prédictions et décisions, limitant ainsi leur utilisation dans des domaines importants. ApplicationLes réseaux tenseurs basés sur l'information quantique et la physique multi-corps offrent une approche « boîte blanche » du ML. Les chercheurs ont déclaré : « Les réseaux tenseurs jouent un rôle crucial dans la connexion des concepts, théories et méthodes quantiques avec le ML et dans la mise en œuvre efficace du ML basé sur les réseaux tenseurs. »Des outils mathématiques en boîte blanche « issus de la physique quantique ». La physique quantique a donné naissance à de puissants outils mathématiques de type « boîte blanche ».

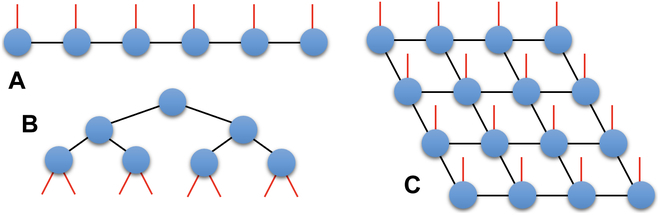

Avec le développement rapide de l'informatique classique et quantique, TN fournit de nouvelles idées pour surmonter le dilemme entre interprétabilité et efficacité. TN est défini comme la contraction de plusieurs tenseurs. Sa structure de réseau détermine la façon dont le tenseur se rétrécit.

Dans la figure 1, une représentation schématique des trois types de TN est présentée. Ces trois types sont la représentation de l'état du produit matriciel (MPS), l'arbre TN et la représentation de l'état des paires intriquées projetées (PEPS) Figure 1 : Représentation graphique de 3 types de TN : (A) MPS, (B) )Arbre TN et (C)PEPS. (Source : article)

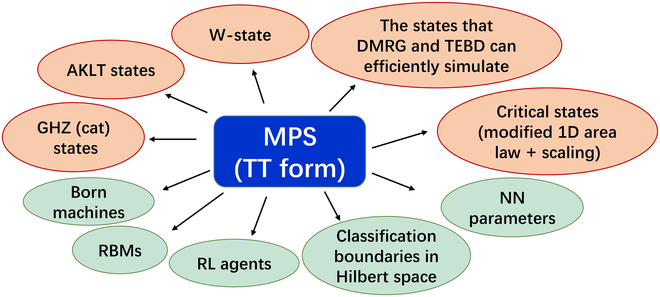

Image 2 : MPS ( Tensor Train form) peut être utilisé pour représenter ou formuler efficacement un grand nombre d’objets mathématiques. (Cité de : article)

Progrès technologiques de l'apprentissage automatique inspirés par le quantique (Progrès technologiques de l'apprentissage automatique inspirés par le quantique)

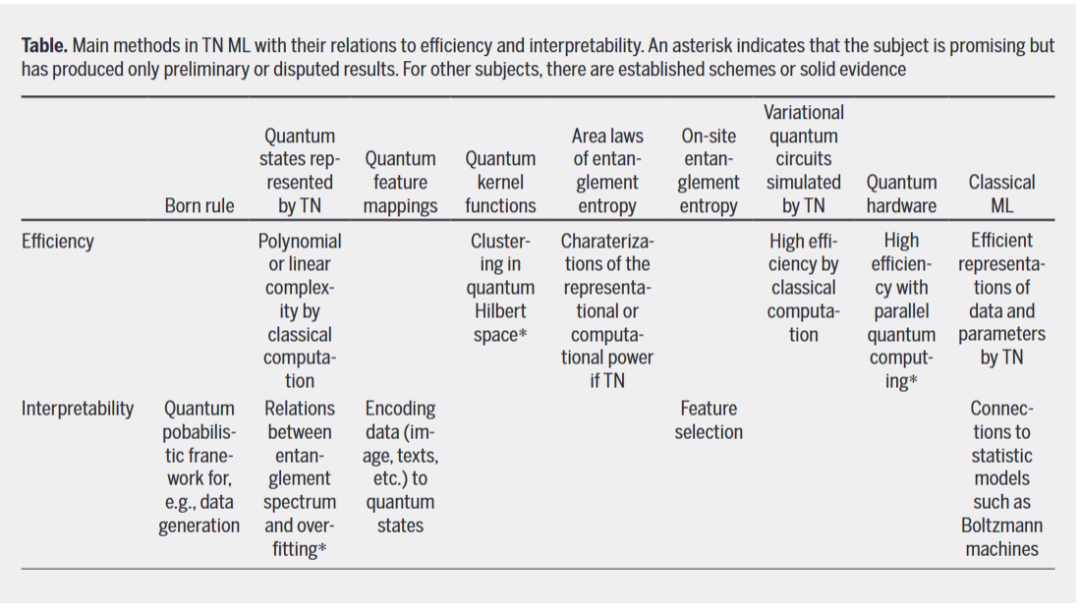

TN offre une nouvelle façon de résoudre le dilemme entre interprétabilité et efficacité dans l'apprentissage automatique, grâce à sa théorie solide et ses méthodes efficaces. Actuellement, deux axes de recherche enchevêtrés sont débattus :

- Comment la théorie quantique peut-elle servir de base mathématique à l'interprétabilité du TN ML ?

- Comment les méthodes TN de la mécanique quantique et la technologie de l'informatique quantique produisent-elles des solutions T N ML efficaces ?

Dans ce contenu, les chercheurs présentent les récents progrès encourageants du ML d'inspiration quantique du point de vue du mappage de fonctionnalités, de la modélisation et du ML basé sur l'informatique quantique, ouvrant ainsi des discussions autour de ces deux questions. Ces avancées sont étroitement liées aux avantages de l’utilisation de TN pour améliorer l’efficacité et l’interprétabilité. Ces approches de ML sont souvent qualifiées d'« inspirées du quantum » car leurs théories, modèles et méthodes proviennent ou s'inspirent de la physique quantique. Cependant, nous avons besoin de plus d'efforts pour développer un cadre système d'interprétabilité basé sur la physique quantique

Dans le tableau ci-dessous, les principales méthodes sur TN ML et leur relation avec l'efficacité et l'interprétabilité sont résumées

Réseaux techniques qui améliorent le classique Machine Learning

En tant qu'outil mathématique fondamental, les applications des réseaux de neurones en ML ne se limitent pas à celles qui suivent des interprétations probabilistes quantiques. Étant donné que TN peut être utilisé pour représenter et simuler efficacement la fonction de partition des systèmes stochastiques classiques, tels que les modèles d'Ising et Potts, la relation entre TN et les machines de Boltzmann a été largement étudiée.

TN est également utilisé pour améliorer NN et développer de nouveaux modèles ML, ignorant toute interprétation probabiliste. Réécrit en chinois : TN est également utilisé pour améliorer NN et développer de nouveaux modèles ML, quelle que soit toute interprétation probabiliste.

Sur la même base, des méthodes de compression de modèle sont proposées pour décomposer les paramètres variationnels de NN en TN ou représenter directement les paramètres variationnels sous forme de TN. Ce dernier peut ne pas nécessiter un processus de décomposition explicite, où les paramètres du réseau neuronal ne sont pas restitués aux tenseurs mais directement aux formes TT, aux opérateurs de produits matriciels ou aux TN profonds. Des fonctions d'activation non linéaires ont été ajoutées à TN pour améliorer ses performances ML, généralisant TN des modèles multilinéaires aux modèles non linéaires.

Ce qui doit être réécrit est : Conclusion

Les gens s'intéressent depuis longtemps à la résolution du dilemme entre efficacité et explicabilité dans l'intelligence artificielle (en particulier l'apprentissage automatique profond). À cet égard, nous passons en revue les progrès encourageants réalisés par TN, une méthode d'apprentissage automatique interprétable et efficace d'inspiration quantique

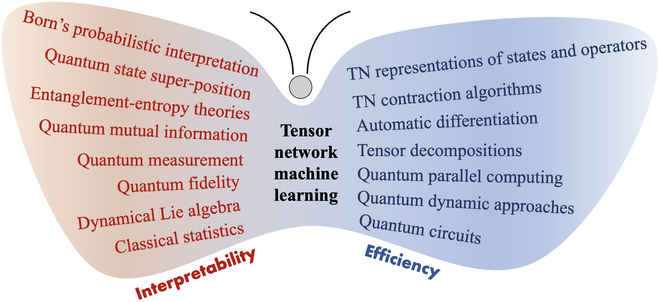

Le « papillon N ML » dans la figure 3 répertorie les réalisations de TN en termes d'avantages ML. Pour le ML d’inspiration quantique, les avantages du TN peuvent être résumés en deux aspects clés : la théorie quantique pour l’interprétabilité et les méthodes quantiques pour une efficacité améliorée. D'une part, TN nous permet d'appliquer les statistiques et la théorie quantique (par exemple, la théorie de l'intrication) pour construire des cadres probabilistes d'interprétabilité qui peuvent aller au-delà de ce qui peut être décrit par l'information classique ou la théorie statistique. D’autre part, de puissants algorithmes TN de mécanique quantique et une technologie informatique quantique considérablement améliorée permettront aux méthodes TN ML d’inspiration quantique d’être très efficaces sur les plates-formes informatiques classiques et quantiques.

Figure 3 : « TN ML butterflies » résume 2 avantages uniques : l'interprétabilité basée sur la théorie quantique (aile gauche) et l'efficacité basée sur les méthodes quantiques (aile droite). (Source : article)

En particulier, avec les récents progrès significatifs dans le domaine du GPT, il y a eu une augmentation sans précédent de la complexité des modèles et de la puissance de calcul, ce qui a apporté de nouvelles opportunités et de nouveaux défis au TN ML. Face à l'émergence de l'IA GPT, l'explicabilité devient de plus en plus précieuse, non seulement pour améliorer l'efficacité de la recherche, mais également pour permettre une meilleure application et un contrôle plus sûr.

Dans l'ère actuelle du NISQ et dans le futur réel À l'ère de l'informatique quantique, le TN est rapidement devenir un outil mathématique important pour explorer l'intelligence artificielle quantique, sous diverses perspectives telles que la théorie, le modèle, l'algorithme, les logiciels, le matériel et les applications

Contenu de référence : https://techxplore.com/news/2023 -11-tensor. -réseaux-efficacité-quantum-inspired-machine.html

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Le robot DeepMind joue au tennis de table, et son coup droit et son revers glissent dans les airs, battant complètement les débutants humains

Aug 09, 2024 pm 04:01 PM

Le robot DeepMind joue au tennis de table, et son coup droit et son revers glissent dans les airs, battant complètement les débutants humains

Aug 09, 2024 pm 04:01 PM

Mais peut-être qu’il ne pourra pas vaincre le vieil homme dans le parc ? Les Jeux Olympiques de Paris battent leur plein et le tennis de table suscite beaucoup d'intérêt. Dans le même temps, les robots ont également réalisé de nouvelles avancées dans le domaine du tennis de table. DeepMind vient tout juste de proposer le premier agent robot apprenant capable d'atteindre le niveau des joueurs amateurs humains de tennis de table de compétition. Adresse papier : https://arxiv.org/pdf/2408.03906 Quelle est la capacité du robot DeepMind à jouer au tennis de table ? Probablement à égalité avec les joueurs amateurs humains : tant en coup droit qu'en revers : l'adversaire utilise une variété de styles de jeu, et le robot peut également résister : recevoir des services avec des tours différents : Cependant, l'intensité du jeu ne semble pas aussi intense que le vieil homme dans le parc. Pour les robots, le tennis de table

La première griffe mécanique ! Yuanluobao est apparu à la World Robot Conference 2024 et a lancé le premier robot d'échecs pouvant entrer dans la maison

Aug 21, 2024 pm 07:33 PM

La première griffe mécanique ! Yuanluobao est apparu à la World Robot Conference 2024 et a lancé le premier robot d'échecs pouvant entrer dans la maison

Aug 21, 2024 pm 07:33 PM

Le 21 août, la Conférence mondiale sur les robots 2024 s'est tenue en grande pompe à Pékin. La marque de robots domestiques de SenseTime, "Yuanluobot SenseRobot", a dévoilé toute sa famille de produits et a récemment lancé le robot de jeu d'échecs Yuanluobot AI - Chess Professional Edition (ci-après dénommé "Yuanluobot SenseRobot"), devenant ainsi le premier robot d'échecs au monde pour le maison. En tant que troisième produit robot jouant aux échecs de Yuanluobo, le nouveau robot Guoxiang a subi un grand nombre de mises à niveau techniques spéciales et d'innovations en matière d'IA et de machines d'ingénierie. Pour la première fois, il a réalisé la capacité de ramasser des pièces d'échecs en trois dimensions. grâce à des griffes mécaniques sur un robot domestique et effectuer des fonctions homme-machine telles que jouer aux échecs, tout le monde joue aux échecs, réviser la notation, etc.

Claude aussi est devenu paresseux ! Internaute : apprenez à vous accorder des vacances

Sep 02, 2024 pm 01:56 PM

Claude aussi est devenu paresseux ! Internaute : apprenez à vous accorder des vacances

Sep 02, 2024 pm 01:56 PM

La rentrée scolaire est sur le point de commencer, et ce ne sont pas seulement les étudiants qui sont sur le point de commencer le nouveau semestre qui doivent prendre soin d’eux-mêmes, mais aussi les grands modèles d’IA. Il y a quelque temps, Reddit était rempli d'internautes se plaignant de la paresse de Claude. « Son niveau a beaucoup baissé, il fait souvent des pauses et même la sortie devient très courte. Au cours de la première semaine de sortie, il pouvait traduire un document complet de 4 pages à la fois, mais maintenant il ne peut même plus produire une demi-page. !" https://www.reddit.com/r/ClaudeAI/comments/1by8rw8/something_just_feels_wrong_with_claude_in_the/ dans un post intitulé "Totalement déçu par Claude", plein de

Lors de la World Robot Conference, ce robot domestique porteur de « l'espoir des futurs soins aux personnes âgées » a été entouré

Aug 22, 2024 pm 10:35 PM

Lors de la World Robot Conference, ce robot domestique porteur de « l'espoir des futurs soins aux personnes âgées » a été entouré

Aug 22, 2024 pm 10:35 PM

Lors de la World Robot Conference qui se tient à Pékin, l'exposition de robots humanoïdes est devenue le centre absolu de la scène. Sur le stand Stardust Intelligent, l'assistant robot IA S1 a réalisé trois performances majeures de dulcimer, d'arts martiaux et de calligraphie. un espace d'exposition, capable à la fois d'arts littéraires et martiaux, a attiré un grand nombre de publics professionnels et de médias. Le jeu élégant sur les cordes élastiques permet au S1 de démontrer un fonctionnement fin et un contrôle absolu avec vitesse, force et précision. CCTV News a réalisé un reportage spécial sur l'apprentissage par imitation et le contrôle intelligent derrière "Calligraphy". Le fondateur de la société, Lai Jie, a expliqué que derrière les mouvements soyeux, le côté matériel recherche le meilleur contrôle de la force et les indicateurs corporels les plus humains (vitesse, charge). etc.), mais du côté de l'IA, les données réelles de mouvement des personnes sont collectées, permettant au robot de devenir plus fort lorsqu'il rencontre une situation forte et d'apprendre à évoluer rapidement. Et agile

L'équipe de Li Feifei a proposé ReKep pour donner aux robots une intelligence spatiale et intégrer GPT-4o

Sep 03, 2024 pm 05:18 PM

L'équipe de Li Feifei a proposé ReKep pour donner aux robots une intelligence spatiale et intégrer GPT-4o

Sep 03, 2024 pm 05:18 PM

Intégration profonde de la vision et de l'apprentissage des robots. Lorsque deux mains de robot travaillent ensemble en douceur pour plier des vêtements, verser du thé et emballer des chaussures, associées au robot humanoïde 1X NEO qui a fait la une des journaux récemment, vous pouvez avoir le sentiment : nous semblons entrer dans l'ère des robots. En fait, ces mouvements soyeux sont le produit d’une technologie robotique avancée + d’une conception de cadre exquise + de grands modèles multimodaux. Nous savons que les robots utiles nécessitent souvent des interactions complexes et exquises avec l’environnement, et que l’environnement peut être représenté comme des contraintes dans les domaines spatial et temporel. Par exemple, si vous souhaitez qu'un robot verse du thé, le robot doit d'abord saisir la poignée de la théière et la maintenir verticalement sans renverser le thé, puis la déplacer doucement jusqu'à ce que l'embouchure de la théière soit alignée avec l'embouchure de la tasse. , puis inclinez la théière selon un certain angle. ce

Hongmeng Smart Travel S9 et conférence de lancement de nouveaux produits avec scénario complet, un certain nombre de nouveaux produits à succès ont été lancés ensemble

Aug 08, 2024 am 07:02 AM

Hongmeng Smart Travel S9 et conférence de lancement de nouveaux produits avec scénario complet, un certain nombre de nouveaux produits à succès ont été lancés ensemble

Aug 08, 2024 am 07:02 AM

Cet après-midi, Hongmeng Zhixing a officiellement accueilli de nouvelles marques et de nouvelles voitures. Le 6 août, Huawei a organisé la conférence de lancement de nouveaux produits Hongmeng Smart Xingxing S9 et Huawei, réunissant la berline phare intelligente panoramique Xiangjie S9, le nouveau M7Pro et Huawei novaFlip, MatePad Pro 12,2 pouces, le nouveau MatePad Air, Huawei Bisheng With de nombreux nouveaux produits intelligents tous scénarios, notamment la série d'imprimantes laser X1, FreeBuds6i, WATCHFIT3 et l'écran intelligent S5Pro, des voyages intelligents, du bureau intelligent aux vêtements intelligents, Huawei continue de construire un écosystème intelligent complet pour offrir aux consommateurs une expérience intelligente du Internet de tout. Hongmeng Zhixing : Autonomisation approfondie pour promouvoir la modernisation de l'industrie automobile intelligente Huawei s'associe à ses partenaires de l'industrie automobile chinoise pour fournir

Annonce des prix ACL 2024 : l'un des meilleurs articles sur le déchiffrement Oracle par HuaTech, GloVe Time Test Award

Aug 15, 2024 pm 04:37 PM

Annonce des prix ACL 2024 : l'un des meilleurs articles sur le déchiffrement Oracle par HuaTech, GloVe Time Test Award

Aug 15, 2024 pm 04:37 PM

Les contributeurs ont beaucoup gagné de cette conférence ACL. L'ACL2024, d'une durée de six jours, se tient à Bangkok, en Thaïlande. ACL est la plus grande conférence internationale dans le domaine de la linguistique informatique et du traitement du langage naturel. Elle est organisée par l'Association internationale pour la linguistique informatique et a lieu chaque année. L'ACL s'est toujours classée première en termes d'influence académique dans le domaine de la PNL, et c'est également une conférence recommandée par le CCF-A. La conférence ACL de cette année est la 62e et a reçu plus de 400 travaux de pointe dans le domaine de la PNL. Hier après-midi, la conférence a annoncé le meilleur article et d'autres récompenses. Cette fois, il y a 7 Best Paper Awards (deux inédits), 1 Best Theme Paper Award et 35 Outstanding Paper Awards. La conférence a également décerné 3 Resource Paper Awards (ResourceAward) et Social Impact Award (

Testé 7 artefacts de génération vidéo « de niveau Sora ». Qui a la capacité de monter sur le « Trône de fer » ?

Aug 05, 2024 pm 07:19 PM

Testé 7 artefacts de génération vidéo « de niveau Sora ». Qui a la capacité de monter sur le « Trône de fer » ?

Aug 05, 2024 pm 07:19 PM

Editeur du Machine Power Report : Yang Wen Qui peut devenir le roi du cercle vidéo de l'IA ? Dans la série télévisée américaine "Game of Thrones", il y a un "Trône de Fer". La légende raconte qu'il a été fabriqué par le dragon géant « Black Death » qui a fait fondre des milliers d'épées abandonnées par les ennemis, symbolisant l'autorité suprême. Pour s'asseoir sur cette chaise de fer, les grandes familles ont commencé à se battre et à se battre. Depuis l'émergence de Sora, un vigoureux "Game of Thrones" a été lancé dans le cercle vidéo de l'IA. Les principaux acteurs de ce jeu incluent RunwayGen-3 et Luma de l'autre côté de l'océan, ainsi que Kuaishou Keling, ByteDream, national. et Zhimo. Spectre Qingying, Vidu, PixVerseV2, etc. Aujourd'hui, nous allons évaluer et voir qui est qualifié pour siéger sur le « Trône de fer » du cercle vidéo IA. -1-Vincent Vidéo