Périphériques technologiques

Périphériques technologiques

IA

IA

La prochaine application en vogue des applications d'IA est apparue : Alibaba et ByteDance ont discrètement lancé un artefact similaire qui peut faire danser Messi facilement.

La prochaine application en vogue des applications d'IA est apparue : Alibaba et ByteDance ont discrètement lancé un artefact similaire qui peut faire danser Messi facilement.

La prochaine application en vogue des applications d'IA est apparue : Alibaba et ByteDance ont discrètement lancé un artefact similaire qui peut faire danser Messi facilement.

L'artefact de génération vidéo AI est de nouveau là. Récemment, Alibaba et ByteDance ont lancé secrètement leurs outils respectifs

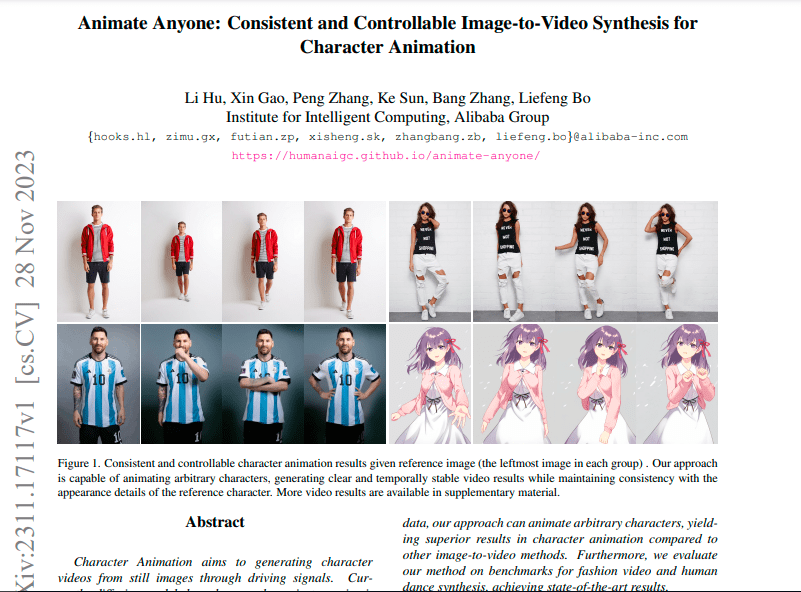

Ali a lancé Animate Anybody, un projet développé par Alibaba Intelligent Computing Research Institute. Il vous suffit de fournir une image de personnage statique (y compris une personne réelle, des personnages d'animation/de dessin animé, etc.) et certaines actions et postures (telles que danser, marcher). . Il peut être animé tout en conservant les caractéristiques détaillées du personnage (telles que les expressions faciales, les détails vestimentaires, etc.).

Tant qu'il y a une photo de Messi, on peut demander au "Roi du Football" de faire diverses poses (voir la photo ci-dessous). Selon ce principe, il est facile de faire danser Messi.

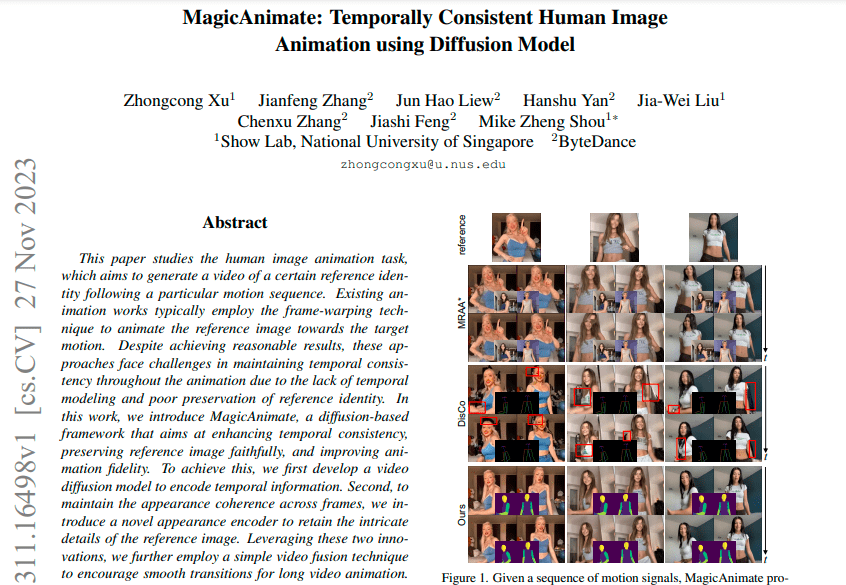

L'Université nationale de Singapour et ByteDance ont lancé conjointement Magic Animate, qui utilise également la technologie de l'IA pour transformer des images statiques en vidéos dynamiques. Byte a déclaré que sur l'ensemble de données de danse TikTok extrêmement difficile, le réalisme de la vidéo générée par Magic Animate s'est amélioré de plus de 38 % par rapport à la ligne de base la plus solide.

Dans le projet Tusheng Video, Alibaba et ByteDance ont travaillé main dans la main et ont réalisé une série d'opérations telles que la publication du papier, la divulgation du code et la divulgation de l'adresse de test presque simultanément. Le délai de publication des deux articles liés n'était qu'à un jour d'intervalle

.Un article sur les octets a été publié le 27 novembre :

Les articles liés à Ali seront publiés le 28 novembre :

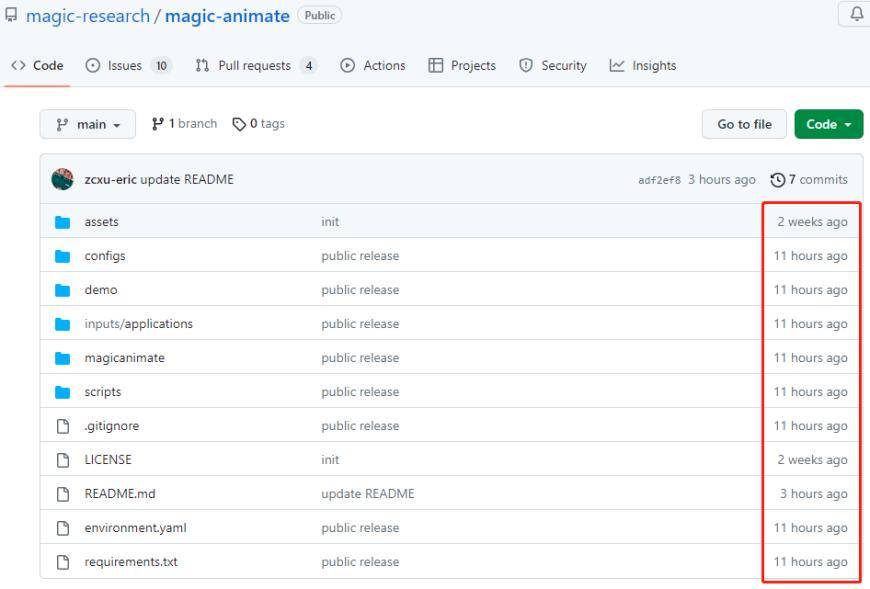

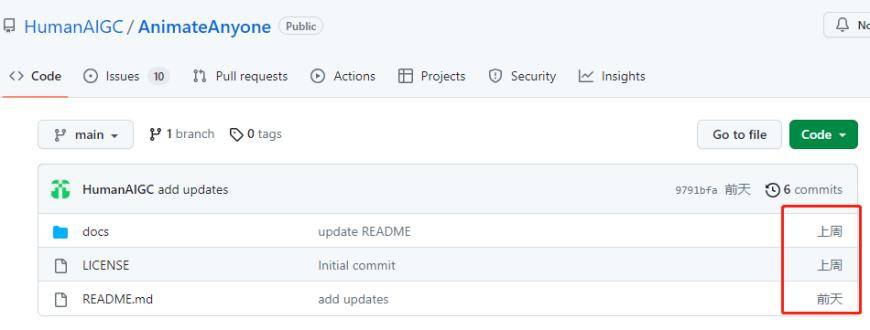

Les fichiers open source des deux sociétés sont mis à jour en permanence sur Github

Le contenu qui doit être réécrit est : le package de fichiers de projet open source de Magic Animate

Package de fichiers de projet open source Animate Anybody

Cela souligne une fois de plus le fait : La génération vidéo est un événement compétitif populaire au sein de l'AIGC, et les géants de la technologie et les entreprises vedettes y prêtent une attention particulière et y investissent activement. Il est entendu que Runway, Meta et Stable AI ont lancé les applications vidéo AI Vincent, et Adobe a récemment annoncé l'acquisition de la société de création vidéo AI Rephrase.ai.

À en juger par les vidéos d'affichage des deux sociétés ci-dessus, l'effet de génération a été considérablement amélioré, et la fluidité et le réalisme sont meilleurs qu'avant. Surmontez les défauts des applications actuelles de génération d'images/vidéo, telles que la distorsion locale, les détails flous, les mots d'invite incohérents, les différences par rapport à l'image d'origine, les images perdues et la gigue de l'écran.

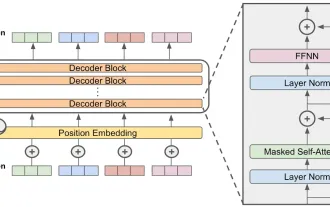

Les deux outils créent des animations de portraits temporellement cohérentes grâce à des modèles de diffusion, et leurs données d'entraînement sont sensiblement les mêmes. Stable Diffusion, utilisé par les deux, est un modèle de diffusion latente texte-image créé par des chercheurs et des ingénieurs de CompVis, Stability AI et LAION, qui a été formé à l'aide d'images 512 x 512 provenant d'un sous-ensemble de la base de données LAION-5B. LAION-5B est le plus grand ensemble de données multimodales librement accessible qui existe.

En parlant d'applications, les chercheurs d'Alibaba ont déclaré dans l'article qu'Animate Anybody, en tant que méthode de base, pourrait être étendue à diverses applications vidéo Tusheng à l'avenir. L'outil présente de nombreux scénarios d'application potentiels, tels que la vente au détail en ligne, les vidéos de divertissement et l'art. création et personnages virtuels. ByteDance a également souligné que Magic Animate a démontré de fortes capacités de généralisation et peut être appliqué à plusieurs scénarios.

Le "Saint Graal" des applications multimodales : Vincent Vidéo Vincent Video fait référence à l'application de l'analyse et du traitement multimodaux du contenu vidéo en combinant la technologie du texte et de la parole. Il associe des informations textuelles et vocales à des images vidéo pour offrir une compréhension vidéo plus riche et une expérience interactive. Vincent Video Application possède un large éventail de domaines d'application, notamment la vidéosurveillance intelligente, la réalité virtuelle, le montage vidéo et l'analyse de contenu, etc. Grâce à l'analyse du texte et de la parole, Vincent Video peut identifier et comprendre les objets, les scènes et les actions dans les vidéos, offrant ainsi aux utilisateurs des fonctions de traitement et de contrôle vidéo plus intelligentes. Dans le domaine de la vidéosurveillance intelligente, Vincent Video peut automatiquement étiqueter et classer le contenu vidéo de surveillance, améliorant ainsi l'efficacité et la précision de la surveillance. Dans le domaine de la réalité virtuelle, Vincent Video peut interagir avec les commandes vocales de l'utilisateur et l'environnement virtuel pour réaliser une expérience virtuelle plus immersive. Dans le domaine du montage vidéo et de l'analyse de contenu, Vincent Video peut aider les utilisateurs à extraire automatiquement les informations clés des vidéos et à effectuer un montage et un montage intelligents. En bref, Vincent Vidéo, véritable « Saint Graal » des applications multimodales, apporte une solution plus complète et intelligente pour la compréhension et l'interaction des contenus vidéo. Son développement apportera plus d'innovation et de commodité dans divers domaines et favorisera le progrès technologique et le développement social

La vidéo présente des avantages par rapport au texte et aux images. Elle peut mieux exprimer les informations, enrichir l'image et être dynamique. La vidéo peut combiner du texte, des images, des sons et des effets visuels, en intégrant plusieurs formes d'informations et en les présentant sur un seul média

Les outils vidéo IA disposent de fonctions produit puissantes et peuvent ouvrir des scénarios d'application plus larges. Grâce à de simples descriptions textuelles ou à d’autres opérations, les outils vidéo d’IA peuvent générer un contenu vidéo complet et de haute qualité, abaissant ainsi le seuil de création vidéo. Cela permet aux non-professionnels d'afficher avec précision du contenu à travers des vidéos, ce qui devrait améliorer l'efficacité de la production de contenu et produire plus de créativité dans divers segments de l'industrie

Song Jiaji de Guosheng Securities a précédemment souligné que la vidéo AI Wensheng est la prochaine étape pour les applications multimodales et le « Saint Graal » de l'AIGC multimodal, car la vidéo AI complète la dernière pièce du puzzle de la création d'IA multimodale. , applications en aval Le moment de l'accélération arrive également ; Shengang Securities a déclaré que l'IA vidéo est le dernier maillon dans le domaine multimodal ; Huatai Securities a déclaré que la tendance AIGC s'est progressivement déplacée des textes vincentiens et des images vincentiennes vers le domaine des vidéos vincentiennes ; Les vidéos vincentiennes présentent une difficulté de calcul élevée et des exigences élevées en matière de données soutiendront la forte demande continue de puissance de calcul de l'IA en amont.

Cependant,l'écart entre les grandes entreprises et entre les grandes entreprises et les start-up n'est pas si grand. On peut même dire qu'elles sont sur la même ligne de départ. Actuellement, Vincent Video dispose de très peu d'applications bêta publiques, seulement quelques-unes telles que Runway Gen-2, Zero Scope et Pika. Même les géants de l'intelligence artificielle de la Silicon Valley tels que Meta et Google progressent lentement sur Vincent Video. Leurs lancements respectifs de Make-A-Video et Phenaki n'ont pas encore été publiés en version bêta publique.

D'un point de vue technique, les modèles et technologies sous-jacents aux outils de génération vidéo sont toujours en cours d'optimisation. Actuellement, les modèles vidéo Vincent grand public utilisent principalement le modèle Transformer et le modèle de diffusion. Les outils de modèles de diffusion sont principalement dédiés à l'amélioration de la qualité vidéo, en surmontant les problèmes d'effets grossiers et de manque de détails. Cependant, la durée de ces vidéos est toutes inférieure à 4 secondes

D'un autre côté, bien que le modèle de diffusion fonctionne bien, son processus de formation nécessite beaucoup de mémoire et de puissance de calcul, ce qui rend seules les grandes entreprises et startups ayant reçu de gros investissements abordables au coût de la formation du modèle

Source : Conseil quotidien de l'innovation scientifique et technologique

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

1393

1393

52

52

1207

1207

24

24

Meilleurs générateurs d'art AI (gratuit & amp; payé) pour des projets créatifs

Apr 02, 2025 pm 06:10 PM

Meilleurs générateurs d'art AI (gratuit & amp; payé) pour des projets créatifs

Apr 02, 2025 pm 06:10 PM

L'article passe en revue les meilleurs générateurs d'art AI, discutant de leurs fonctionnalités, de leur aptitude aux projets créatifs et de la valeur. Il met en évidence MidJourney comme la meilleure valeur pour les professionnels et recommande Dall-E 2 pour un art personnalisable de haute qualité.

Chatgpt 4 o est-il disponible?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4 o est-il disponible?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4 est actuellement disponible et largement utilisé, démontrant des améliorations significatives dans la compréhension du contexte et la génération de réponses cohérentes par rapport à ses prédécesseurs comme Chatgpt 3.5. Les développements futurs peuvent inclure un interg plus personnalisé

Début avec Meta Llama 3.2 - Analytics Vidhya

Apr 11, 2025 pm 12:04 PM

Début avec Meta Llama 3.2 - Analytics Vidhya

Apr 11, 2025 pm 12:04 PM

META'S LLAMA 3.2: un bond en avant dans l'IA multimodal et mobile Meta a récemment dévoilé Llama 3.2, une progression importante de l'IA avec de puissantes capacités de vision et des modèles de texte légers optimisés pour les appareils mobiles. S'appuyer sur le succès o

Meilleurs chatbots AI comparés (Chatgpt, Gemini, Claude & amp; plus)

Apr 02, 2025 pm 06:09 PM

Meilleurs chatbots AI comparés (Chatgpt, Gemini, Claude & amp; plus)

Apr 02, 2025 pm 06:09 PM

L'article compare les meilleurs chatbots d'IA comme Chatgpt, Gemini et Claude, en se concentrant sur leurs fonctionnalités uniques, leurs options de personnalisation et leurs performances dans le traitement et la fiabilité du langage naturel.

Assistants d'écriture de l'IA pour augmenter votre création de contenu

Apr 02, 2025 pm 06:11 PM

Assistants d'écriture de l'IA pour augmenter votre création de contenu

Apr 02, 2025 pm 06:11 PM

L'article traite des meilleurs assistants d'écriture d'IA comme Grammarly, Jasper, Copy.ai, WireSonic et Rytr, en se concentrant sur leurs fonctionnalités uniques pour la création de contenu. Il soutient que Jasper excelle dans l'optimisation du référencement, tandis que les outils d'IA aident à maintenir le ton

Comment accéder à Falcon 3? - Analytique Vidhya

Mar 31, 2025 pm 04:41 PM

Comment accéder à Falcon 3? - Analytique Vidhya

Mar 31, 2025 pm 04:41 PM

Falcon 3: un modèle révolutionnaire de grande langue open source Falcon 3, la dernière itération de la célèbre série Falcon de LLMS, représente une progression importante de la technologie de l'IA. Développé par le Technology Innovation Institute (TII), cet ouvert

Choisir le meilleur générateur de voix d'IA: les meilleures options examinées

Apr 02, 2025 pm 06:12 PM

Choisir le meilleur générateur de voix d'IA: les meilleures options examinées

Apr 02, 2025 pm 06:12 PM

L'article examine les meilleurs générateurs de voix d'IA comme Google Cloud, Amazon Polly, Microsoft Azure, IBM Watson et Descript, en se concentrant sur leurs fonctionnalités, leur qualité vocale et leur aptitude à différents besoins.

Top 7 Système de chiffon agentique pour construire des agents d'IA

Mar 31, 2025 pm 04:25 PM

Top 7 Système de chiffon agentique pour construire des agents d'IA

Mar 31, 2025 pm 04:25 PM

2024 a été témoin d'un simple passage de l'utilisation des LLM pour la génération de contenu pour comprendre leur fonctionnement intérieur. Cette exploration a conduit à la découverte des agents de l'IA - les systèmes autonomes manipulant des tâches et des décisions avec une intervention humaine minimale. Construire