Périphériques technologiques

Périphériques technologiques

IA

IA

Microsoft lance le modèle Phi-2 de 2,7 milliards de paramètres, qui surpasse de nombreux grands modèles de langage

Microsoft lance le modèle Phi-2 de 2,7 milliards de paramètres, qui surpasse de nombreux grands modèles de langage

Microsoft lance le modèle Phi-2 de 2,7 milliards de paramètres, qui surpasse de nombreux grands modèles de langage

Microsoft a publié un modèle d'intelligence artificielle appelé Phi-2, qui a démontré des capacités extraordinaires. Ses performances sont comparables, voire supérieures, à celles des modèles plus grands et plus matures, 25 fois plus grands.

Récemment, Microsoft a annoncé dans un article de blog que Phi-2 est un modèle de langage avec 2,7 milliards de paramètres. Comparé à d'autres modèles de base, Phi-2 présente des performances avancées, en particulier dans les tests de référence complexes. Ces évaluations de tests ont développé le raisonnement, la compréhension du langage, compétences en mathématiques, en codage et en connaissances générales. Maintenant, Phi-2 a été publié via le catalogue de modèles de Microsoft Azure Artificial Intelligence Studio, ce qui signifie que les chercheurs et les développeurs peuvent l'intégrer dans des applications tierces.

Phi-2 a été fondé par le PDG de Microsoft, Satya Nadella, en 11. Il a été publié pour la première fois à la conférence Ignite en mars. La puissance du produit vient de ce que Microsoft appelle des données de « qualité manuelle » spécialement conçues pour la connaissance et qui s'appuient également sur des techniques d'analyse d'autres modèles

Phi-2 est unique dans la mesure où il a précédemment La puissance d'un modèle est souvent étroitement liée à la taille de ses paramètres. De manière générale, un modèle avec plus de paramètres signifie des capacités plus puissantes. Cependant, l'émergence de Phi-2 a modifié ce concept traditionnel

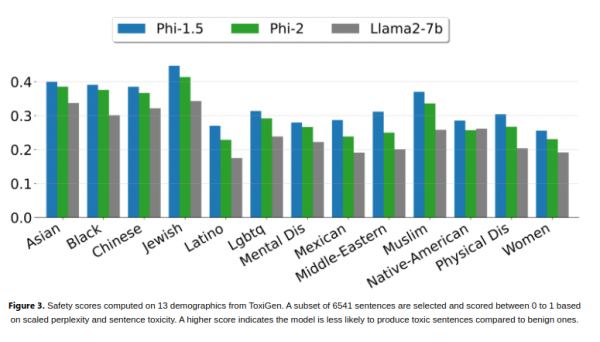

Microsoft a déclaré que Phi-2 avait démontré sa capacité à égaler, voire à surpasser, des modèles de base plus grands dans certains tests de référence. Ces benchmarks incluent le paramètre Mistral de 7 milliards de Mistral AI, le Llama 2 de 13 milliards de paramètres de Meta Platforms, et dépassant même les 70 milliards de paramètres Llama-2 dans certains benchmarks

Une déclaration surprenante peut être, ses performances dépassent même celles de Gemini Nano de Google, le plus modèle efficace de la série Gemini sortie la semaine dernière. Gemini Nano est conçu pour les tâches sur l'appareil et peut fonctionner sur les smartphones, permettant des fonctionnalités telles que le résumé de texte, la relecture avancée, la correction grammaticale et les réponses intelligentes contextuelles

Les chercheurs de Microsoft ont déclaré que les tests impliqués dans Phi-2 sont très étendus, notamment compréhension du langage, raisonnement, mathématiques, défis de codage, et plus encore.

La société affirme que la raison pour laquelle Phi-2 obtient d'aussi excellents résultats est qu'il est formé avec des données soigneusement sélectionnées au niveau des manuels, conçues pour enseigner le raisonnement, les connaissances et le bon sens, ce qui signifie qu'il peut apprendre plus avec moins d'informations. Les chercheurs de Microsoft ont également utilisé des techniques permettant d'obtenir des connaissances à partir de modèles plus petits.

Les chercheurs ont souligné qu'il convient de noter que Phi-2 est toujours capable d'atteindre de solides performances sans utiliser de techniques telles que l'apprentissage par renforcement ou l'ajustement pédagogique basé sur les commentaires humains. Ces techniques sont souvent utilisées pour améliorer le comportement des modèles d’intelligence artificielle. Bien qu'il n'utilise pas ces techniques, Phi-2 parvient toujours à réduire les biais et les contenus préjudiciables par rapport à d'autres modèles open source qui le font. La société pense que cela est dû à la personnalisation de la gestion des données. Les chercheurs de Microsoft appellent Phi-2 la dernière version de la série « Small Language Model (SLM) ». Phi-1, le premier modèle de la série et lancé pour la première fois plus tôt cette année, possède 1,3 milliard de paramètres et est optimisé pour les tâches de codage Python de base. En septembre de cette année, Microsoft a lancé Phi-1.5, un modèle avec 1,3 milliard de paramètres et formé à l'aide de nouvelles sources de données, y compris une variété de textes synthétiques générés avec une programmation en langage naturel

Microsoft a déclaré que Phi-2 Sa haute efficacité en fait un idéal plate-forme permettant aux chercheurs d'explorer des domaines tels que l'amélioration de la sécurité de l'intelligence artificielle, l'interprétabilité et le développement éthique des modèles de langage.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

Pourquoi les grands modèles linguistiques utilisent-ils SwiGLU comme fonction d'activation ?

Apr 08, 2024 pm 09:31 PM

Pourquoi les grands modèles linguistiques utilisent-ils SwiGLU comme fonction d'activation ?

Apr 08, 2024 pm 09:31 PM

Si vous avez prêté attention à l'architecture des grands modèles de langage, vous avez peut-être vu le terme « SwiGLU » dans les derniers modèles et documents de recherche. SwiGLU peut être considéré comme la fonction d'activation la plus couramment utilisée dans les grands modèles de langage. Nous la présenterons en détail dans cet article. SwiGLU est en fait une fonction d'activation proposée par Google en 2020, qui combine les caractéristiques de SWISH et de GLU. Le nom chinois complet de SwiGLU est « unité linéaire à porte bidirectionnelle ». Il optimise et combine deux fonctions d'activation, SWISH et GLU, pour améliorer la capacité d'expression non linéaire du modèle. SWISH est une fonction d'activation très courante et largement utilisée dans les grands modèles de langage, tandis que GLU a montré de bonnes performances dans les tâches de traitement du langage naturel.

La fenêtre contextuelle plein écran de Microsoft exhorte les utilisateurs de Windows 10 à se dépêcher et à passer à Windows 11

Jun 06, 2024 am 11:35 AM

La fenêtre contextuelle plein écran de Microsoft exhorte les utilisateurs de Windows 10 à se dépêcher et à passer à Windows 11

Jun 06, 2024 am 11:35 AM

Selon l'actualité du 3 juin, Microsoft envoie activement des notifications en plein écran à tous les utilisateurs de Windows 10 pour les encourager à passer au système d'exploitation Windows 11. Ce déplacement concerne les appareils dont les configurations matérielles ne prennent pas en charge le nouveau système. Depuis 2015, Windows 10 occupe près de 70 % des parts de marché, établissant ainsi sa domination en tant que système d'exploitation Windows. Cependant, la part de marché dépasse largement la part de marché de 82 %, et la part de marché dépasse largement celle de Windows 11, qui sortira en 2021. Même si Windows 11 est lancé depuis près de trois ans, sa pénétration sur le marché est encore lente. Microsoft a annoncé qu'il mettrait fin au support technique de Windows 10 après le 14 octobre 2025 afin de se concentrer davantage sur

Le réglage fin peut-il vraiment permettre au LLM d'apprendre de nouvelles choses : l'introduction de nouvelles connaissances peut amener le modèle à produire davantage d'hallucinations

Jun 11, 2024 pm 03:57 PM

Le réglage fin peut-il vraiment permettre au LLM d'apprendre de nouvelles choses : l'introduction de nouvelles connaissances peut amener le modèle à produire davantage d'hallucinations

Jun 11, 2024 pm 03:57 PM

Les grands modèles linguistiques (LLM) sont formés sur d'énormes bases de données textuelles, où ils acquièrent de grandes quantités de connaissances du monde réel. Ces connaissances sont intégrées à leurs paramètres et peuvent ensuite être utilisées en cas de besoin. La connaissance de ces modèles est « réifiée » en fin de formation. À la fin de la pré-formation, le modèle arrête effectivement d’apprendre. Alignez ou affinez le modèle pour apprendre à exploiter ces connaissances et répondre plus naturellement aux questions des utilisateurs. Mais parfois, la connaissance du modèle ne suffit pas, et bien que le modèle puisse accéder à du contenu externe via RAG, il est considéré comme bénéfique de l'adapter à de nouveaux domaines grâce à un réglage fin. Ce réglage fin est effectué à l'aide de la contribution d'annotateurs humains ou d'autres créations LLM, où le modèle rencontre des connaissances supplémentaires du monde réel et les intègre.

Microsoft publie la mise à jour cumulative Win11 août : amélioration de la sécurité, optimisation de l'écran de verrouillage, etc.

Aug 14, 2024 am 10:39 AM

Microsoft publie la mise à jour cumulative Win11 août : amélioration de la sécurité, optimisation de l'écran de verrouillage, etc.

Aug 14, 2024 am 10:39 AM

Selon les informations de ce site du 14 août, lors de la journée d'événement Patch Tuesday d'aujourd'hui, Microsoft a publié des mises à jour cumulatives pour les systèmes Windows 11, notamment la mise à jour KB5041585 pour 22H2 et 23H2 et la mise à jour KB5041592 pour 21H2. Après l'installation de l'équipement mentionné ci-dessus avec la mise à jour cumulative d'août, les changements de numéro de version attachés à ce site sont les suivants : Après l'installation de l'équipement 21H2, le numéro de version est passé à Build22000.314722H2. le numéro de version est passé à Build22621.403723H2. Après l'installation de l'équipement, le numéro de version est passé à Build22631.4037. Le contenu principal de la mise à jour KB5041585 pour Windows 1121H2 est le suivant : Amélioration : Amélioré.

Mise à niveau de Microsoft Edge : la fonction de sauvegarde automatique du mot de passe interdite ? ! Les utilisateurs ont été choqués !

Apr 19, 2024 am 08:13 AM

Mise à niveau de Microsoft Edge : la fonction de sauvegarde automatique du mot de passe interdite ? ! Les utilisateurs ont été choqués !

Apr 19, 2024 am 08:13 AM

Actualités du 18 avril : Récemment, certains utilisateurs du navigateur Microsoft Edge utilisant le canal Canary ont signalé qu'après la mise à niveau vers la dernière version, ils avaient constaté que l'option d'enregistrement automatique des mots de passe était désactivée. Après enquête, il a été constaté qu'il s'agissait d'un ajustement mineur après la mise à niveau du navigateur, plutôt que d'une suppression de fonctionnalités. Avant d'utiliser le navigateur Edge pour accéder à un site Web, les utilisateurs ont signalé que le navigateur ouvrait une fenêtre leur demandant s'ils souhaitaient enregistrer le mot de passe de connexion au site Web. Après avoir choisi d'enregistrer, Edge remplira automatiquement le numéro de compte et le mot de passe enregistrés lors de votre prochaine connexion, offrant ainsi aux utilisateurs une grande commodité. Mais la dernière mise à jour ressemble à un ajustement, modifiant les paramètres par défaut. Les utilisateurs doivent choisir d'enregistrer le mot de passe, puis activer manuellement le remplissage automatique du compte et du mot de passe enregistrés dans les paramètres.

La fonction de compression des fichiers 7z et TAR de Microsoft Win11 a été rétrogradée des versions 24H2 aux versions 23H2/22H2

Apr 28, 2024 am 09:19 AM

La fonction de compression des fichiers 7z et TAR de Microsoft Win11 a été rétrogradée des versions 24H2 aux versions 23H2/22H2

Apr 28, 2024 am 09:19 AM

Selon les informations de ce site le 27 avril, Microsoft a publié la mise à jour de la version préliminaire de Windows 11 Build 26100 sur les canaux Canary et Dev plus tôt ce mois-ci, qui devrait devenir une version RTM candidate de la mise à jour Windows 1124H2. Les principaux changements de la nouvelle version sont l'explorateur de fichiers, l'intégration de Copilot, l'édition des métadonnées des fichiers PNG, la création de fichiers compressés TAR et 7z, etc. @PhantomOfEarth a découvert que Microsoft a délégué certaines fonctions de la version 24H2 (Germanium) à la version 23H2/22H2 (Nickel), comme la création de fichiers compressés TAR et 7z. Comme le montre le schéma, Windows 11 prendra en charge la création native de TAR

Mise à jour du navigateur Microsoft Edge : ajout de la fonction 'zoomer sur l'image' pour améliorer l'expérience utilisateur

Mar 21, 2024 pm 01:40 PM

Mise à jour du navigateur Microsoft Edge : ajout de la fonction 'zoomer sur l'image' pour améliorer l'expérience utilisateur

Mar 21, 2024 pm 01:40 PM

Selon l'actualité du 21 mars, Microsoft a récemment mis à jour son navigateur Microsoft Edge et ajouté une fonction pratique « agrandir l'image ». Désormais, lorsqu'ils utilisent le navigateur Edge, les utilisateurs peuvent facilement trouver cette nouvelle fonctionnalité dans le menu contextuel en cliquant simplement avec le bouton droit sur l'image. Ce qui est plus pratique, c'est que les utilisateurs peuvent également passer le curseur sur l'image, puis double-cliquer sur la touche Ctrl pour appeler rapidement la fonction de zoom avant sur l'image. Selon la compréhension de l'éditeur, le nouveau navigateur Microsoft Edge a été testé pour les nouvelles fonctionnalités du canal Canary. La version stable du navigateur a également officiellement lancé la fonction pratique « agrandir l'image », offrant aux utilisateurs une expérience de navigation d'images plus pratique. Les médias scientifiques et technologiques étrangers y ont également prêté attention.

Explication détaillée de GQA, le mécanisme d'attention couramment utilisé dans les grands modèles, et l'implémentation du code Pytorch

Apr 03, 2024 pm 05:40 PM

Explication détaillée de GQA, le mécanisme d'attention couramment utilisé dans les grands modèles, et l'implémentation du code Pytorch

Apr 03, 2024 pm 05:40 PM

Grouped Query Attention (GroupedQueryAttention) est une méthode d'attention multi-requêtes dans les grands modèles de langage. Son objectif est d'atteindre la qualité du MHA tout en maintenant la vitesse du MQA. GroupedQueryAttention regroupe les requêtes et les requêtes au sein de chaque groupe partagent le même poids d'attention, ce qui permet de réduire la complexité de calcul et d'augmenter la vitesse d'inférence. Dans cet article, nous expliquerons l'idée de GQA et comment la traduire en code. GQA est dans le document GQA:TrainingGeneralizedMulti-QueryTransformerModelsfromMulti-HeadCheckpoint