Périphériques technologiques

Périphériques technologiques

IA

IA

He Kaiming coopère avec le MIT : un cadre simple réalise la dernière percée en matière de génération d'images inconditionnelles

He Kaiming coopère avec le MIT : un cadre simple réalise la dernière percée en matière de génération d'images inconditionnelles

He Kaiming coopère avec le MIT : un cadre simple réalise la dernière percée en matière de génération d'images inconditionnelles

Le grand patron He Yuming n'a pas encore officiellement rejoint le MIT, mais la première recherche collaborative avec le MIT est sortie :

Lui et les enseignants et étudiants du MIT ont développé un cadre de génération d'images auto-conditionnelles, appelé RCG ( Le code est open source) .

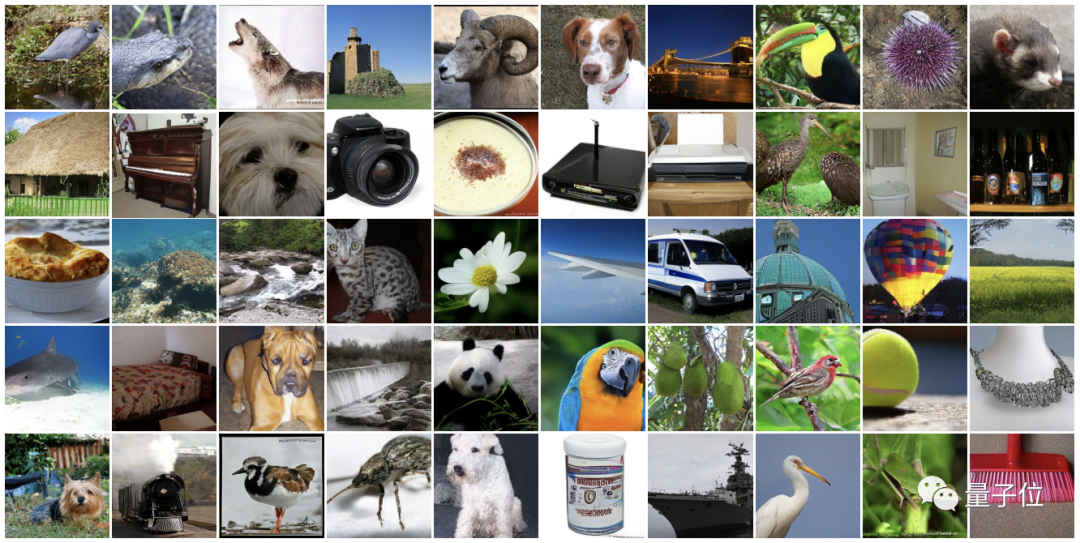

Cette structure de framework est très simple mais l'effet est exceptionnel. Elle implémente directement le nouveau SOTA de génération d'images inconditionnelles sur l'ensemble de données ImageNet-1K.

Les images qu'il génère ne nécessitent aucune annotation humaine (c'est-à-dire des mots d'invite, des étiquettes de classe, etc.) , et peuvent atteindre à la fois fidélité et diversité.

De cette façon, il améliore non seulement considérablement le niveau de génération d'images inconditionnelles, mais rivalise également avec les meilleures méthodes de génération conditionnelle actuelles.

Selon les mots de l'équipe de He Yuming :

L'écart de performance de longue date entre les tâches de génération conditionnelle et inconditionnelle a enfin été comblé en ce moment.

Alors, comment ça se passe exactement ?

Génération auto-conditionnelle similaire à l'apprentissage auto-supervisé

Tout d'abord, la génération dite inconditionnelle signifie que le modèle capture directement le contenu de génération de distribution de données sans l'aide de signaux d'entrée.

Cette méthode de formation est difficile, il y a donc toujours eu un écart de performance important avec la génération conditionnelle - tout comme l'apprentissage non supervisé ne peut pas être comparé à l'apprentissage supervisé

Tout comme l'apprentissage auto-supervisé est apparu, il a également changé cette situation

Dans le domaine de la génération inconditionnelle d’images, il existe également une méthode de génération auto-conditionnelle similaire au concept d’apprentissage auto-supervisé.

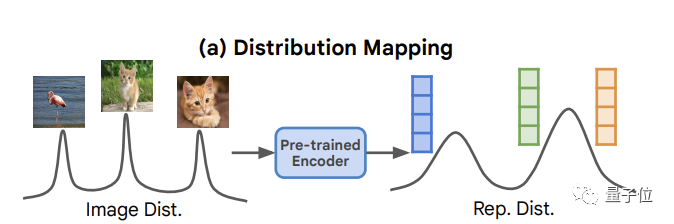

Par rapport à la génération inconditionnelle traditionnelle qui mappe simplement la distribution du bruit à la distribution de l'image, cette méthode définit principalement le processus de génération de pixels sur une distribution de représentation dérivée de la distribution des données elle-même.

Il devrait aller au-delà de la génération d'images conditionnelles et promouvoir le développement d'applications telles que la la conception moléculaire ou la découverte de médicamentsqui ne nécessitent pas d'annotation humaine (C'est pourquoi la génération d'images conditionnelles se développe si bien, nous devons également y prêter attention à la génération inconditionnelle).

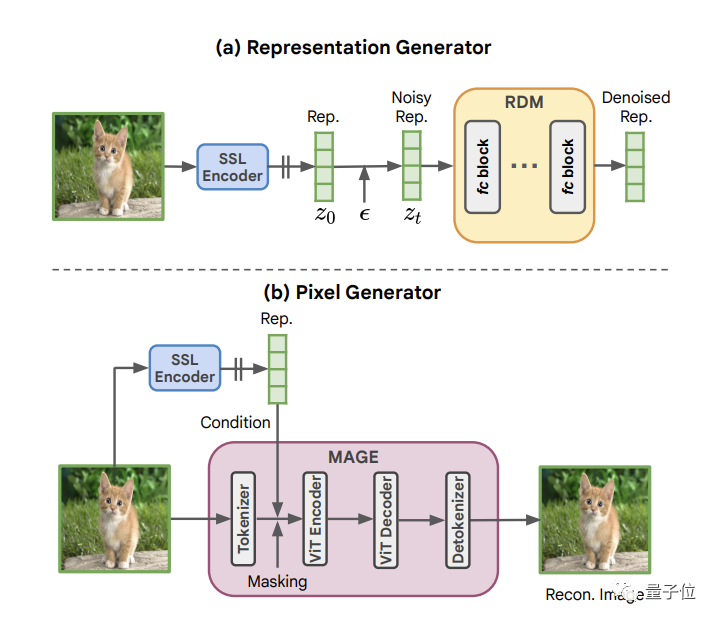

Maintenant, sur la base de ce concept de génération autoconditionnelle, l'équipe de He Kaiming a d'abord développé un modèle de diffusion de représentation RDM.

Intercepté à partir de l'image via un encodeur d'image auto-supervisé, principalement utilisé pour générer une représentation d'image auto-supervisée de basse dimension

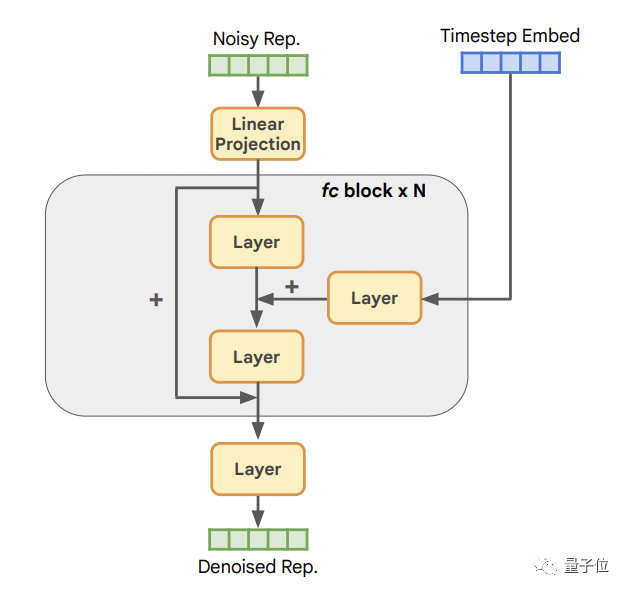

Son architecture de base est la suivante :

La première est la couche d'entrée, qui est responsable de projeter la représentation dans la dimension cachée C , suivi de N blocs entièrement connectés, et enfin d'une couche de sortie, qui est chargée de reprojeter (convertir) les caractéristiques latentes de la couche cachée dans la dimension de représentation d'origine.

Chaque couche comprend une couche LayerNorm, une couche SiLU et une couche linéaire.

Un tel RDM présente deux avantages :

L'une de ses caractéristiques est qu'il a une forte diversité, et l'autre est que la charge de calcul est faible

Après cela, l'équipe a proposé le protagoniste d'aujourd'hui avec l'aide de RDM : représente l'architecture de génération d'images conditionnelles RCG

Il s'agit d'un simple cadre de génération auto-conditionnelle composé de trois composants :

L'un est un encodeur d'image SSL , qui est utilisé pour convertir la distribution d'image en un compact représente la distribution.

L'un est le RDM, qui est utilisé pour modéliser et échantillonner cette distribution.

Le dernier est un générateur de pixels MAGE, qui sert à traiter l'image en fonction de la représentation.

MAGE fonctionne en ajoutant un masque aléatoire à l'image tokenisée et en demandant au réseau de reconstruire le jeton manquant en fonction de la représentation extraite de la même image

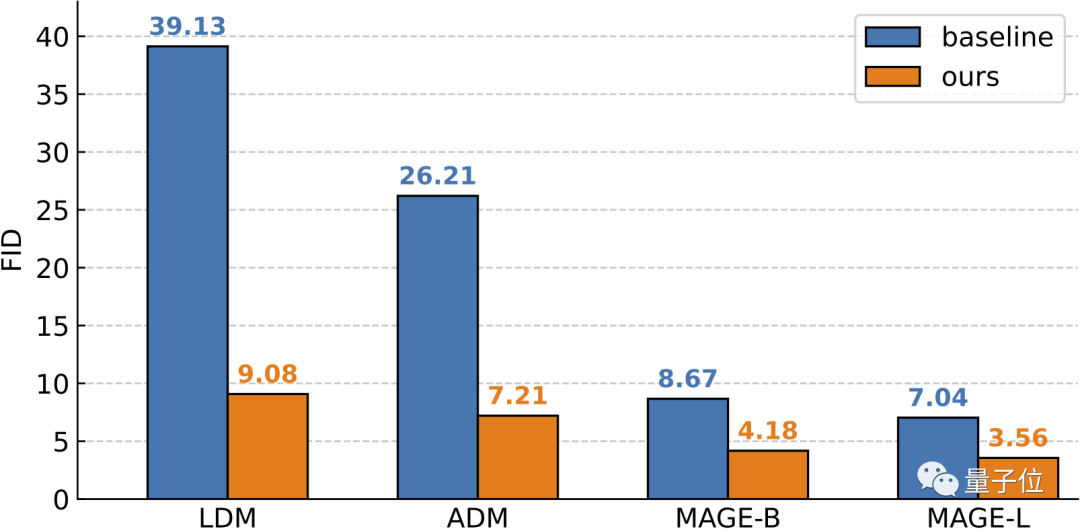

Après les tests, il a été constaté que les résultats finaux ont montré que malgré le La structure de ce cadre de génération autoconditionnelle est simple, mais son effet est très bon sur ImageNet 256×256, RCG a atteint un FID de

3,56 et un IS de 186,9 (Inception Score). En comparaison, la méthode de génération inconditionnelle la plus puissante avant elle a un score FID de 7,04 et un score IS de 123,5.

Pour RCG, non seulement il fonctionne bien en génération conditionnelle, mais il fonctionne également au même niveau, voire dépasse les modèles de référence dans ce domaine

Enfin, sans conseils de classificateur, les performances de RCG peuvent encore être améliorées à 3,31(FID) et 253.4(EST).

L'équipe a exprimé :

Ces résultats montrent que le modèle de génération d'images conditionnelles a un grand potentiel et pourrait annoncer une nouvelle ère dans ce domaine

Présentation de l'équipe

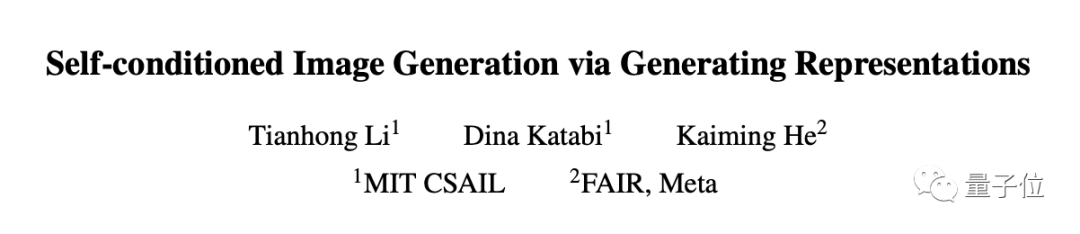

Il y a trois auteurs dans cet article :

Un. auteur Il s'agit de Li Tianhong, doctorant au MIT. Il est diplômé de la classe Yao de l'Université Tsinghua avec son diplôme de premier cycle. Son domaine de recherche est la technologie de détection intégrée multimodale. Sa page d'accueil personnelle est très intéressante, et il possède également une collection de recettes - la recherche et la cuisine sont les deux choses qui le passionnent le plus

L'autre auteur est du département de génie électrique et d'informatique du MIT. (EECS)  La professeure Dina Katabi, directrice du MIT Wireless Networks and Mobile Computing Center, est la lauréate du prix Sloan de cette année et a été élue académicien de l'Académie nationale des sciences.

La professeure Dina Katabi, directrice du MIT Wireless Networks and Mobile Computing Center, est la lauréate du prix Sloan de cette année et a été élue académicien de l'Académie nationale des sciences.

Enfin, l'auteur correspondant est He Mingming. Il retournera officiellement dans le monde universitaire l'année prochaine et quittera Meta pour rejoindre le Département de génie électrique et d'informatique du MIT, où il deviendra collègue de Dina Katabi.

Veuillez cliquer sur le lien suivant pour consulter l'article : https://arxiv.org/abs/2312.03701

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

1393

1393

52

52

1206

1206

24

24

Open source! Au-delà de ZoeDepth ! DepthFM : estimation rapide et précise de la profondeur monoculaire !

Apr 03, 2024 pm 12:04 PM

Open source! Au-delà de ZoeDepth ! DepthFM : estimation rapide et précise de la profondeur monoculaire !

Apr 03, 2024 pm 12:04 PM

0. À quoi sert cet article ? Nous proposons DepthFM : un modèle d'estimation de profondeur monoculaire génératif de pointe, polyvalent et rapide. En plus des tâches traditionnelles d'estimation de la profondeur, DepthFM démontre également des capacités de pointe dans les tâches en aval telles que l'inpainting en profondeur. DepthFM est efficace et peut synthétiser des cartes de profondeur en quelques étapes d'inférence. Lisons ce travail ensemble ~ 1. Titre des informations sur l'article : DepthFM : FastMonocularDepthEstimationwithFlowMatching Auteur : MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Imaginez un modèle d'intelligence artificielle qui non seulement a la capacité de surpasser l'informatique traditionnelle, mais qui permet également d'obtenir des performances plus efficaces à moindre coût. Ce n'est pas de la science-fiction, DeepSeek-V2[1], le modèle MoE open source le plus puissant au monde est ici. DeepSeek-V2 est un puissant mélange de modèle de langage d'experts (MoE) présentant les caractéristiques d'une formation économique et d'une inférence efficace. Il est constitué de 236B paramètres, dont 21B servent à activer chaque marqueur. Par rapport à DeepSeek67B, DeepSeek-V2 offre des performances plus élevées, tout en économisant 42,5 % des coûts de formation, en réduisant le cache KV de 93,3 % et en augmentant le débit de génération maximal à 5,76 fois. DeepSeek est une entreprise explorant l'intelligence artificielle générale

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L’IA change effectivement les mathématiques. Récemment, Tao Zhexuan, qui a prêté une attention particulière à cette question, a transmis le dernier numéro du « Bulletin de l'American Mathematical Society » (Bulletin de l'American Mathematical Society). En se concentrant sur le thème « Les machines changeront-elles les mathématiques ? », de nombreux mathématiciens ont exprimé leurs opinions. L'ensemble du processus a été plein d'étincelles, intense et passionnant. L'auteur dispose d'une équipe solide, comprenant Akshay Venkatesh, lauréat de la médaille Fields, le mathématicien chinois Zheng Lejun, l'informaticien de l'Université de New York Ernest Davis et de nombreux autres universitaires bien connus du secteur. Le monde de l’IA a radicalement changé. Vous savez, bon nombre de ces articles ont été soumis il y a un an.

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas entre officiellement dans l’ère des robots électriques ! Hier, l'Atlas hydraulique s'est retiré "en larmes" de la scène de l'histoire. Aujourd'hui, Boston Dynamics a annoncé que l'Atlas électrique était au travail. Il semble que dans le domaine des robots humanoïdes commerciaux, Boston Dynamics soit déterminé à concurrencer Tesla. Après la sortie de la nouvelle vidéo, elle a déjà été visionnée par plus d’un million de personnes en seulement dix heures. Les personnes âgées partent et de nouveaux rôles apparaissent. C'est une nécessité historique. Il ne fait aucun doute que cette année est l’année explosive des robots humanoïdes. Les internautes ont commenté : Les progrès des robots ont fait ressembler la cérémonie d'ouverture de cette année à des êtres humains, et le degré de liberté est bien plus grand que celui des humains. Mais n'est-ce vraiment pas un film d'horreur ? Au début de la vidéo, Atlas est allongé calmement sur le sol, apparemment sur le dos. Ce qui suit est à couper le souffle

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

Plus tôt ce mois-ci, des chercheurs du MIT et d'autres institutions ont proposé une alternative très prometteuse au MLP – KAN. KAN surpasse MLP en termes de précision et d’interprétabilité. Et il peut surpasser le MLP fonctionnant avec un plus grand nombre de paramètres avec un très petit nombre de paramètres. Par exemple, les auteurs ont déclaré avoir utilisé KAN pour reproduire les résultats de DeepMind avec un réseau plus petit et un degré d'automatisation plus élevé. Plus précisément, le MLP de DeepMind compte environ 300 000 paramètres, tandis que le KAN n'en compte qu'environ 200. KAN a une base mathématique solide comme MLP est basé sur le théorème d'approximation universelle, tandis que KAN est basé sur le théorème de représentation de Kolmogorov-Arnold. Comme le montre la figure ci-dessous, KAN a

La vitalité de la super intelligence s'éveille ! Mais avec l'arrivée de l'IA qui se met à jour automatiquement, les mères n'ont plus à se soucier des goulots d'étranglement des données.

Apr 29, 2024 pm 06:55 PM

La vitalité de la super intelligence s'éveille ! Mais avec l'arrivée de l'IA qui se met à jour automatiquement, les mères n'ont plus à se soucier des goulots d'étranglement des données.

Apr 29, 2024 pm 06:55 PM

Je pleure à mort. Le monde construit à la folie de grands modèles. Les données sur Internet ne suffisent pas du tout. Le modèle de formation ressemble à « The Hunger Games », et les chercheurs en IA du monde entier se demandent comment nourrir ces personnes avides de données. Ce problème est particulièrement important dans les tâches multimodales. À une époque où rien ne pouvait être fait, une équipe de start-up du département de l'Université Renmin de Chine a utilisé son propre nouveau modèle pour devenir la première en Chine à faire de « l'auto-alimentation des données générées par le modèle » une réalité. De plus, il s’agit d’une approche à deux volets, du côté compréhension et du côté génération, les deux côtés peuvent générer de nouvelles données multimodales de haute qualité et fournir un retour de données au modèle lui-même. Qu'est-ce qu'un modèle ? Awaker 1.0, un grand modèle multimodal qui vient d'apparaître sur le Forum Zhongguancun. Qui est l'équipe ? Moteur Sophon. Fondé par Gao Yizhao, doctorant à la Hillhouse School of Artificial Intelligence de l’Université Renmin.

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

La détection de cibles est un problème relativement mature dans les systèmes de conduite autonome, parmi lesquels la détection des piétons est l'un des premiers algorithmes à être déployés. Des recherches très complètes ont été menées dans la plupart des articles. Cependant, la perception de la distance à l’aide de caméras fisheye pour une vue panoramique est relativement moins étudiée. En raison de la distorsion radiale importante, la représentation standard du cadre de délimitation est difficile à mettre en œuvre dans les caméras fisheye. Pour alléger la description ci-dessus, nous explorons les conceptions étendues de boîtes englobantes, d'ellipses et de polygones généraux dans des représentations polaires/angulaires et définissons une métrique de segmentation d'instance mIOU pour analyser ces représentations. Le modèle fisheyeDetNet proposé avec une forme polygonale surpasse les autres modèles et atteint simultanément 49,5 % de mAP sur l'ensemble de données de la caméra fisheye Valeo pour la conduite autonome.

La version Kuaishou de Sora 'Ke Ling' est ouverte aux tests : génère plus de 120 s de vidéo, comprend mieux la physique et peut modéliser avec précision des mouvements complexes

Jun 11, 2024 am 09:51 AM

La version Kuaishou de Sora 'Ke Ling' est ouverte aux tests : génère plus de 120 s de vidéo, comprend mieux la physique et peut modéliser avec précision des mouvements complexes

Jun 11, 2024 am 09:51 AM

Quoi? Zootopie est-elle concrétisée par l’IA domestique ? Avec la vidéo est exposé un nouveau modèle de génération vidéo domestique à grande échelle appelé « Keling ». Sora utilise une voie technique similaire et combine un certain nombre d'innovations technologiques auto-développées pour produire des vidéos qui comportent non seulement des mouvements larges et raisonnables, mais qui simulent également les caractéristiques du monde physique et possèdent de fortes capacités de combinaison conceptuelle et d'imagination. Selon les données, Keling prend en charge la génération de vidéos ultra-longues allant jusqu'à 2 minutes à 30 ips, avec des résolutions allant jusqu'à 1080p, et prend en charge plusieurs formats d'image. Un autre point important est que Keling n'est pas une démo ou une démonstration de résultats vidéo publiée par le laboratoire, mais une application au niveau produit lancée par Kuaishou, un acteur leader dans le domaine de la vidéo courte. De plus, l'objectif principal est d'être pragmatique, de ne pas faire de chèques en blanc et de se mettre en ligne dès sa sortie. Le grand modèle de Ke Ling est déjà sorti à Kuaiying.