Périphériques technologiques

Périphériques technologiques

IA

IA

Les directives OpenAI permettent aux conseils d'administration d'empêcher les PDG de publier de nouveaux modèles pour se prémunir contre les risques liés à l'IA.

Les directives OpenAI permettent aux conseils d'administration d'empêcher les PDG de publier de nouveaux modèles pour se prémunir contre les risques liés à l'IA.

Les directives OpenAI permettent aux conseils d'administration d'empêcher les PDG de publier de nouveaux modèles pour se prémunir contre les risques liés à l'IA.

Afin d'éviter les risques énormes que l'intelligence artificielle (IA) peut entraîner, OpenAI a décidé de donner au conseil d'administration plus de pouvoir pour superviser les questions de sécurité et exercer une surveillance stricte sur le PDG Sam Altman, qui vient de remporter une bataille interne le mois dernier

OpenAI a publié lundi 18 décembre EST une série de lignes directrices visant à suivre, évaluer, prédire et prévenir les risques catastrophiques posés par des modèles d'intelligence artificielle (IA) de plus en plus puissants. OpenAI définit le « risque catastrophique » comme tout risque pouvant entraîner des pertes économiques de plusieurs centaines de milliards de dollars, ou des blessures graves ou la mort de plusieurs personnes

Le guide de 27 pages, connu sous le nom de « Readiness Framework », indique que même si la haute direction d'une entreprise, y compris le PDG ou une personne désignée par la direction, estime qu'un modèle d'IA à publier est sûr, le conseil d'administration de l'entreprise a le pouvoir de choisir de reporter la sortie de ce modèle. Cela signifie que même si le PDG d'OpenAI est responsable des décisions quotidiennes, le conseil d'administration sera conscient des risques constatés et aura le pouvoir de veto sur les décisions du PDG

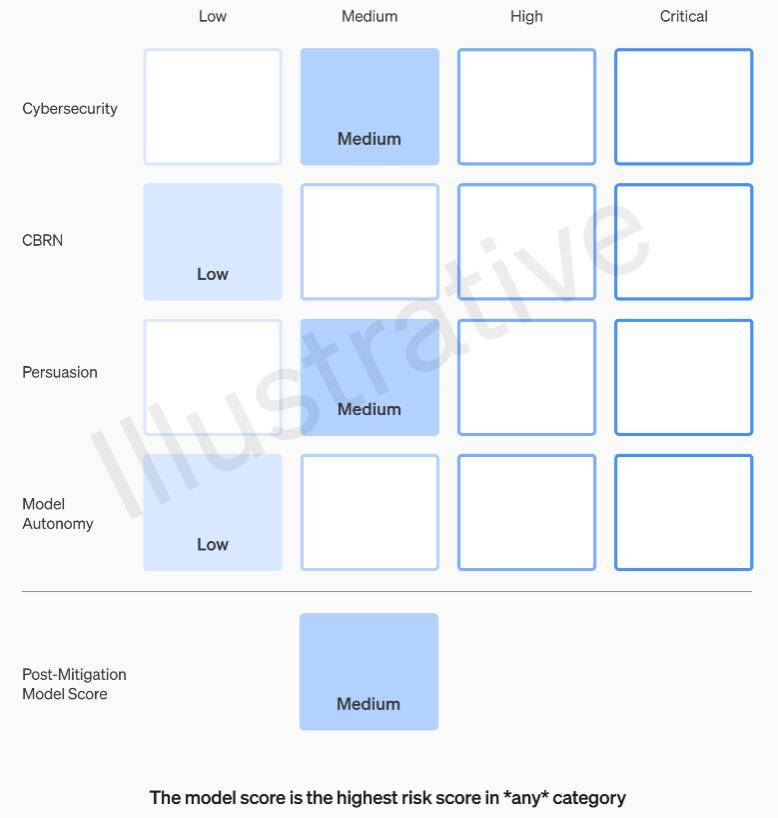

Le cadre de préparation d'OpenAI recommande d'utiliser une approche matricielle pour documenter le niveau de risque posé par les modèles d'IA de pointe dans plusieurs catégories, en plus des dispositions relatives à la direction de l'entreprise et à l'autorité du conseil d'administration. Ces risques incluent des acteurs malveillants utilisant des modèles d'IA pour créer des logiciels malveillants, lancer des attaques d'ingénierie sociale ou diffuser des informations nuisibles sur les armes nucléaires ou biologiques

Plus précisément, OpenAI fixe des seuils de risque en quatre catégories : cybersécurité, CBRN (menaces chimiques, biologiques, radiologiques, nucléaires), persuasion et autonomie du modèle. Avant et après la mise en œuvre de mesures d'atténuation des risques, OpenAI classe chaque risque en quatre niveaux : faible, moyen, élevé ou grave

OpenAI stipule que seuls les modèles d'IA classés « moyen » ou inférieurs après atténuation des risques peuvent être déployés, et seuls les modèles classés « élevé » ou inférieurs après atténuation des risques peuvent continuer à être développés si le risque ne peut pas être réduit en dessous du niveau grave. niveau, l’entreprise arrêtera de développer le modèle. OpenAI prendra également des mesures de sécurité supplémentaires pour les modèles évalués comme à haut risque ou à risque grave jusqu'à ce que le risque soit atténué

OpenAI divise les gestionnaires de problèmes de sécurité en trois équipes. L'équipe des systèmes de sécurité se concentre sur l'atténuation et la gestion des risques posés par les produits actuels tels que GPT-4. L’équipe de Super Alignement s’inquiète des problèmes qui pourraient survenir lorsque les futurs systèmes dépasseraient les capacités humaines. De plus, il existe une nouvelle équipe appelée Prepare, dirigée par Aleksander Madry, professeur au Département de génie électrique et d'informatique (EECS) du Massachusetts Institute of Technology (MIT)

Une nouvelle équipe évaluera le développement et la mise en œuvre de modèles robustes. Ils seront spécifiquement chargés de superviser les efforts techniques et les structures opérationnelles liées aux décisions de sécurité. Ils dirigeront le travail technique, examineront les limites des capacités des modèles de pointe et réaliseront des évaluations et des rapports de synthèse

Madry a déclaré que son équipe évaluerait régulièrement le niveau de risque des modèles d'intelligence artificielle les plus avancés d'OpenAI qui n'ont pas encore été publiés et soumettrait des rapports mensuels au groupe consultatif de sécurité interne (SAG) d'OpenAI. SAG analysera le travail de l'équipe de Madry et fournira des recommandations au PDG Altman et au conseil d'administration de l'entreprise

Selon le document d'orientation publié lundi, Altman et ses dirigeants peuvent décider de publier ou non un nouveau système d'IA basé sur ces rapports, mais le conseil d'administration conserve le pouvoir d'annuler leur décision

Actuellement, l’équipe de Madry ne compte que quatre personnes, mais il travaille dur pour recruter davantage de membres. Il est prévu que les membres de l'équipe atteindront 15 à 20 personnes, ce qui est similaire à l'équipe de sécurité et à l'équipe d'hyper-alignement existantes

Madry espère que d'autres sociétés d'IA évalueront les risques de leurs modèles de la même manière et pense que cela pourrait devenir un modèle de réglementation

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

1393

1393

52

52

1205

1205

24

24

Meilleurs générateurs d'art AI (gratuit & amp; payé) pour des projets créatifs

Apr 02, 2025 pm 06:10 PM

Meilleurs générateurs d'art AI (gratuit & amp; payé) pour des projets créatifs

Apr 02, 2025 pm 06:10 PM

L'article passe en revue les meilleurs générateurs d'art AI, discutant de leurs fonctionnalités, de leur aptitude aux projets créatifs et de la valeur. Il met en évidence MidJourney comme la meilleure valeur pour les professionnels et recommande Dall-E 2 pour un art personnalisable de haute qualité.

Chatgpt 4 o est-il disponible?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4 o est-il disponible?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4 est actuellement disponible et largement utilisé, démontrant des améliorations significatives dans la compréhension du contexte et la génération de réponses cohérentes par rapport à ses prédécesseurs comme Chatgpt 3.5. Les développements futurs peuvent inclure un interg plus personnalisé

Début avec Meta Llama 3.2 - Analytics Vidhya

Apr 11, 2025 pm 12:04 PM

Début avec Meta Llama 3.2 - Analytics Vidhya

Apr 11, 2025 pm 12:04 PM

META'S LLAMA 3.2: un bond en avant dans l'IA multimodal et mobile Meta a récemment dévoilé Llama 3.2, une progression importante de l'IA avec de puissantes capacités de vision et des modèles de texte légers optimisés pour les appareils mobiles. S'appuyer sur le succès o

Meilleurs chatbots AI comparés (Chatgpt, Gemini, Claude & amp; plus)

Apr 02, 2025 pm 06:09 PM

Meilleurs chatbots AI comparés (Chatgpt, Gemini, Claude & amp; plus)

Apr 02, 2025 pm 06:09 PM

L'article compare les meilleurs chatbots d'IA comme Chatgpt, Gemini et Claude, en se concentrant sur leurs fonctionnalités uniques, leurs options de personnalisation et leurs performances dans le traitement et la fiabilité du langage naturel.

Assistants d'écriture de l'IA pour augmenter votre création de contenu

Apr 02, 2025 pm 06:11 PM

Assistants d'écriture de l'IA pour augmenter votre création de contenu

Apr 02, 2025 pm 06:11 PM

L'article traite des meilleurs assistants d'écriture d'IA comme Grammarly, Jasper, Copy.ai, WireSonic et Rytr, en se concentrant sur leurs fonctionnalités uniques pour la création de contenu. Il soutient que Jasper excelle dans l'optimisation du référencement, tandis que les outils d'IA aident à maintenir le ton

Comment accéder à Falcon 3? - Analytique Vidhya

Mar 31, 2025 pm 04:41 PM

Comment accéder à Falcon 3? - Analytique Vidhya

Mar 31, 2025 pm 04:41 PM

Falcon 3: un modèle révolutionnaire de grande langue open source Falcon 3, la dernière itération de la célèbre série Falcon de LLMS, représente une progression importante de la technologie de l'IA. Développé par le Technology Innovation Institute (TII), cet ouvert

Choisir le meilleur générateur de voix d'IA: les meilleures options examinées

Apr 02, 2025 pm 06:12 PM

Choisir le meilleur générateur de voix d'IA: les meilleures options examinées

Apr 02, 2025 pm 06:12 PM

L'article examine les meilleurs générateurs de voix d'IA comme Google Cloud, Amazon Polly, Microsoft Azure, IBM Watson et Descript, en se concentrant sur leurs fonctionnalités, leur qualité vocale et leur aptitude à différents besoins.

Top 7 Système de chiffon agentique pour construire des agents d'IA

Mar 31, 2025 pm 04:25 PM

Top 7 Système de chiffon agentique pour construire des agents d'IA

Mar 31, 2025 pm 04:25 PM

2024 a été témoin d'un simple passage de l'utilisation des LLM pour la génération de contenu pour comprendre leur fonctionnement intérieur. Cette exploration a conduit à la découverte des agents de l'IA - les systèmes autonomes manipulant des tâches et des décisions avec une intervention humaine minimale. Construire