Périphériques technologiques

Périphériques technologiques

IA

IA

OpenAI renforce son équipe de sécurité, en lui permettant d'opposer son veto aux IA dangereuses

OpenAI renforce son équipe de sécurité, en lui permettant d'opposer son veto aux IA dangereuses

OpenAI renforce son équipe de sécurité, en lui permettant d'opposer son veto aux IA dangereuses

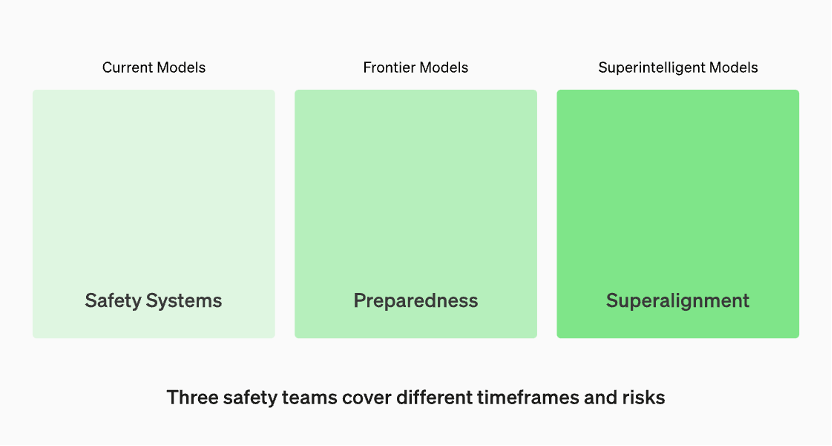

Les modèles en production sont gérés par l'équipe "Systèmes de Sécurité". Les modèles de pointe en développement disposent d’équipes de « préparation » qui identifient et quantifient les risques avant la publication du modèle. Ensuite, il y a l’équipe « Super Alignement », qui travaille sur des lignes directrices théoriques pour les modèles de « super intelligence »

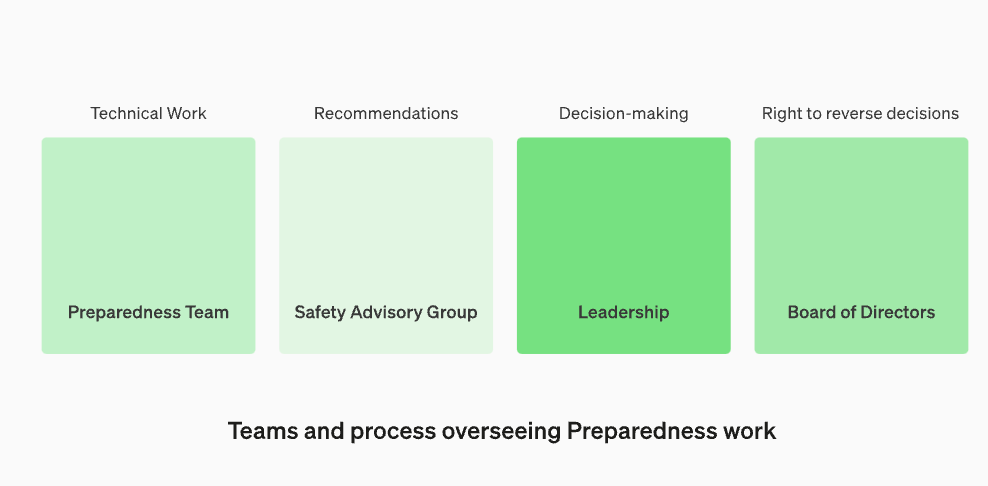

Restructurer le groupe consultatif sur la sécurité pour qu'il siège au-dessus de l'équipe technique afin de faire des recommandations à la direction et de donner au conseil d'administration un pouvoir de veto

OpenAI a annoncé que afin de se défendre contre la menace d'une intelligence artificielle nuisible, ils renforcent leurs processus de sécurité interne. Ils créeront un nouveau département appelé « Groupe consultatif sur la sécurité », qui siègera au-dessus de l'équipe technologique et fournira des conseils aux dirigeants et disposera d'un droit de veto au conseil d'administration. Cette décision a été annoncée le 18 décembre, heure locale

La mise à jour suscite des inquiétudes principalement parce que le PDG d'OpenAI, Sam Altman, a été licencié par le conseil d'administration, ce qui semble être lié à des problèmes de sécurité avec les grands modèles. Deux membres « ralentis » du conseil d’administration d’OpenAI, Ilya Sutskvi et Helen Toner, ont perdu leur siège au conseil d’administration à la suite d’un remaniement de haut niveau

Dans cet article, OpenAI discute de son dernier « Cadre de préparation », comment OpenAI suit, évalue, prédit et se protège contre les risques catastrophiques posés par des modèles de plus en plus puissants. Quelle est la définition du risque catastrophique ? OpenAI explique : « Ce que nous appelons les risques catastrophiques fait référence aux risques qui peuvent entraîner des centaines de milliards de dollars de pertes économiques ou causer des blessures graves, voire la mort de nombreuses personnes. Cela inclut également, mais sans s'y limiter, les risques existentiels. »

Selon le site officiel d'OpenAI, les modèles en production sont gérés par l'équipe "Security System". Durant la phase de développement, il existe une équipe appelée « préparation » qui identifie et évalue les risques avant la sortie du modèle. De plus, il existe une équipe appelée "superalignment" qui travaille sur des lignes directrices théoriques pour les modèles "superintelligents"

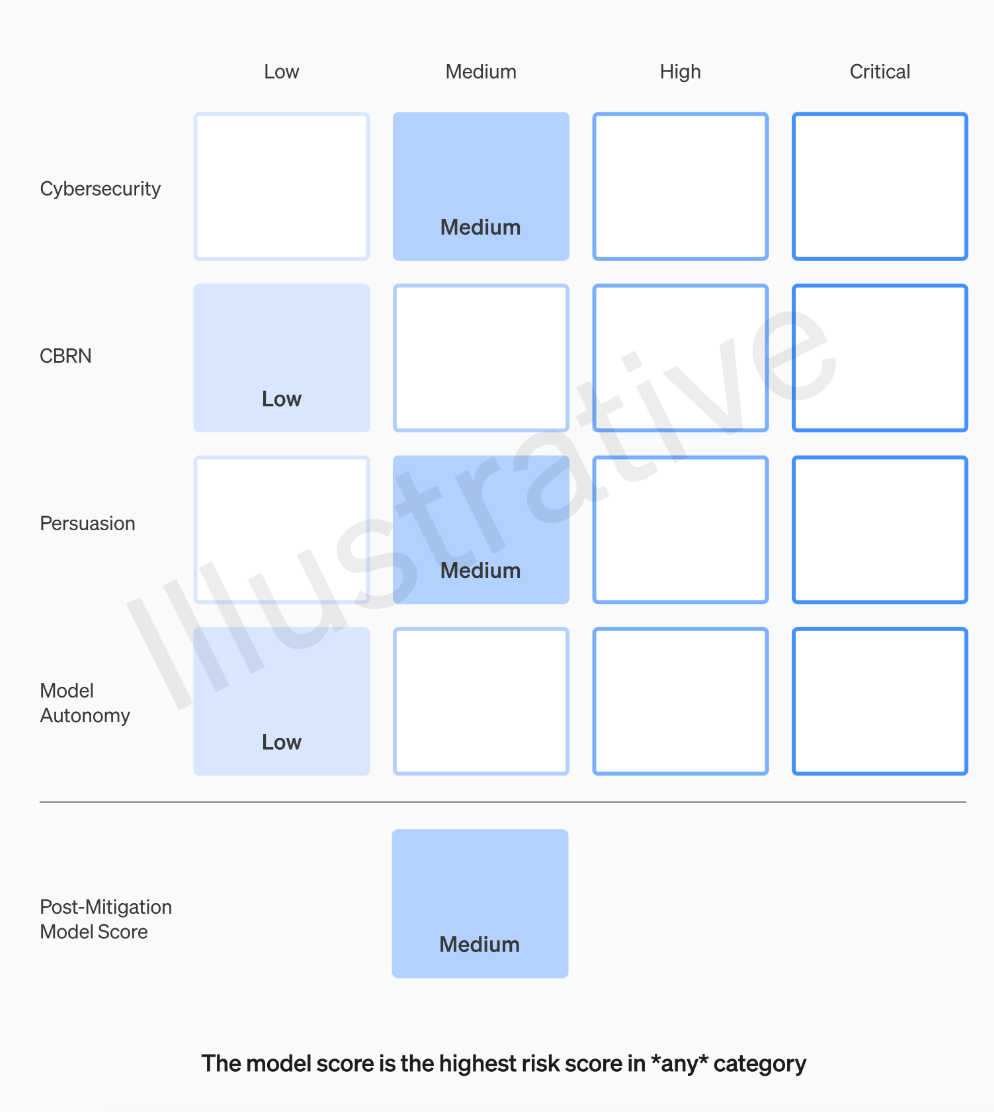

L'équipe OpenAI évaluera chaque modèle selon quatre catégories de risques : cybersécurité, pouvoir de persuasion (comme la désinformation), autonomie du modèle (la capacité d'agir de manière autonome) et CBRN (menaces chimiques, biologiques, radiologiques et nucléaires, comme la capacité de créer de nouveaux agents pathogènes)

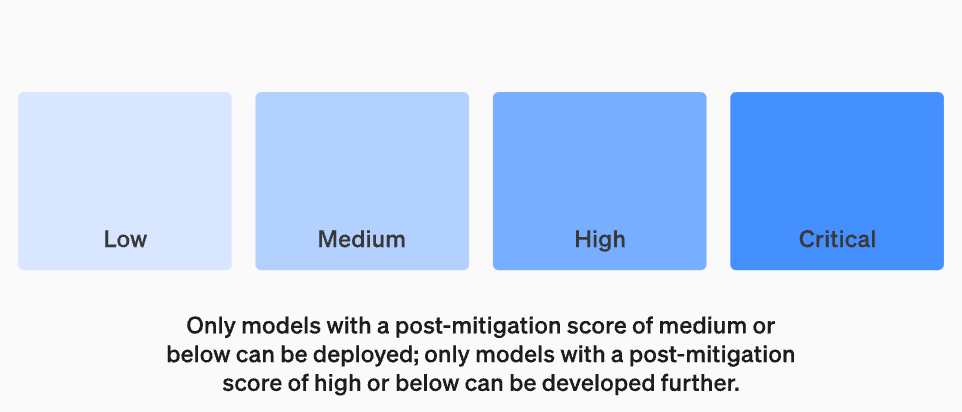

OpenAI prend en compte diverses atténuations dans ses hypothèses : par exemple, le modèle maintient des réserves raisonnables sur la description du processus de fabrication du napalm ou des bombes artisanales. Après prise en compte des atténuations connues, si un modèle est toujours évalué comme présentant un risque « élevé », il ne sera pas déployé, et si un modèle présente des risques « critiques », il ne sera pas développé davantage

Tous ceux qui créent un modèle ne sont pas les mieux placés pour l'évaluer et faire des recommandations. Pour cette raison, OpenAI crée une équipe appelée « Groupe consultatif de sécurité interfonctionnel » qui examinera les rapports des chercheurs d'un niveau technique et formulera des recommandations d'un point de vue plus élevé, dans l'espoir de découvrir des « inconnues inconnues »

.

Ce processus nécessite que ces recommandations soient envoyées à la fois au conseil d'administration et à la direction, qui décideront de poursuivre ou de cesser les activités, mais le conseil d'administration a le droit d'annuler ces décisions. Cela évite que des produits ou des processus à haut risque soient approuvés à l’insu du conseil d’administrationCependant, le monde extérieur s’inquiète toujours du fait que si le groupe d’experts fait des recommandations et que le PDG prend des décisions sur la base de ces informations, le conseil d’administration d’OpenAI a-t-il vraiment le droit de réfuter et d’agir ? S’ils le faisaient, le public en entendrait-il parler ? Actuellement, hormis la promesse d’OpenAI de solliciter des audits tiers indépendants, leurs problèmes de transparence n’ont pas vraiment été résolus

Le « cadre de préparation » d'OpenAI contient les cinq éléments clés suivants :

1. Évaluation et notationNous évaluerons notre modèle et mettrons continuellement à jour notre « scorecard ». Nous évaluerons tous les modèles de pointe, notamment en triplant le calcul efficace pendant la formation. Nous repousserons les limites du modèle. Ces résultats nous aideront à évaluer les risques des derniers modèles et à mesurer l’efficacité de toutes les mesures d’atténuation proposées. Notre objectif est de détecter les insécurités spécifiques à la périphérie afin d’atténuer efficacement les risques. Pour suivre le niveau de sécurité de nos modèles, nous produirons des « tableaux de bord » des risques et des rapports détaillés

Le but de la définition de seuils de risque est d'avoir une limite claire lors de la prise de décision et de la gestion des risques. Le seuil de risque fait référence au niveau maximum de risque qu'une organisation ou un individu est prêt à supporter dans des circonstances spécifiques. En définissant des seuils de risque, vous pouvez aider une organisation ou un individu à identifier quand une action est nécessaire pour atténuer ou éviter un risque. La définition des seuils de risque doit être basée sur les résultats de l’évaluation des risques, les réglementations et politiques pertinentes et la tolérance au risque de l’organisation ou de l’individu. Lors de la définition des seuils de risque, les caractéristiques et l’impact des différents types de risques doivent être pris en compte pour garantir l’efficacité et l’applicabilité des mesures de gestion des risques. Enfin, les seuils de risque fixés doivent être régulièrement évalués et ajustés pour rester cohérents avec les objectifs de gestion des risques de l’organisation ou de l’individu

Nous fixerons des seuils de risque qui déclenchent des mesures de sécurité. Nous fixons des seuils de niveaux de risque en fonction des catégories de suivi préliminaires suivantes : cybersécurité, CBRN (menaces chimiques, biologiques, radiologiques, nucléaires), persuasion et autonomie du modèle. Nous spécifions quatre niveaux de risque de sécurité, et seuls les modèles avec un score post-atténuation de « moyen » ou inférieur peuvent être déployés ; seuls les modèles avec un score post-atténuation « élevé » ou inférieur peuvent être développés davantage. Pour les modèles présentant des risques élevés ou graves (pré-atténuation), nous mettrons également en œuvre des mesures de sécurité supplémentaires

Niveau de danger

Réinitialiser la structure opérationnelle de suivi des travaux techniques et de prise de décision en matière de sécurité

Nous mettrons en place une équipe dédiée pour superviser le travail technique et la structure opérationnelle des décisions de sécurité. L’équipe de préparation dirigera le travail technique pour examiner les limites des capacités des modèles de pointe et réalisera des évaluations et des rapports complets. Ce travail technique est essentiel aux décisions de développement et de déploiement des modèles de sécurité OpenAI. Nous créons un groupe consultatif interfonctionnel sur la sécurité pour examiner tous les rapports et les envoyer à la direction et au conseil d'administration. Bien que la direction soit le décideur, le conseil d'administration a le pouvoir d'annuler les décisions

Superviser les nouveaux changements dans le travail technique et la structure opérationnelle de prise de décision en matière de sécurité

Améliorer la sécurité et renforcer la responsabilité externe

Nous élaborerons des protocoles pour améliorer la sécurité et la responsabilité externe. Nous organiserons régulièrement des exercices de sécurité pour tester notre entreprise et notre propre culture. Certains problèmes de sécurité peuvent survenir rapidement, nous avons donc la possibilité de signaler les problèmes urgents pour une réponse rapide. Nous pensons qu'il est utile d'obtenir des commentaires de personnes extérieures à OpenAI et de les faire examiner par un tiers qualifié et indépendant. Nous continuerons à demander à d'autres personnes de former des équipes rouges et d'évaluer nos modèles, et nous prévoyons de partager les mises à jour en externe

Réduire les autres risques de sécurité connus et inconnus :

Nous contribuerons à atténuer d’autres risques de sécurité connus et inconnus. Nous travaillerons en étroite collaboration avec des parties externes ainsi qu'en interne avec des équipes telles que les systèmes de sécurité pour suivre les abus dans le monde réel. Nous travaillerons également avec Super Alignment pour suivre les risques urgents de désalignement. Nous sommes également pionniers en matière de recherche pour mesurer l'évolution du risque à mesure que les modèles évoluent et aider à prédire le risque à l'avance, à l'instar de notre succès antérieur avec la loi d'échelle. Enfin, nous aurons un processus continu pour tenter de résoudre toute « inconnue » émergente

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

1659

1659

14

14

1415

1415

52

52

1310

1310

25

25

1258

1258

29

29

1232

1232

24

24

Un nouveau paradigme de programmation, quand Spring Boot rencontre OpenAI

Feb 01, 2024 pm 09:18 PM

Un nouveau paradigme de programmation, quand Spring Boot rencontre OpenAI

Feb 01, 2024 pm 09:18 PM

En 2023, la technologie de l’IA est devenue un sujet brûlant et a un impact énorme sur diverses industries, notamment dans le domaine de la programmation. Les gens sont de plus en plus conscients de l’importance de la technologie de l’IA, et la communauté Spring ne fait pas exception. Avec l’évolution continue de la technologie GenAI (Intelligence Artificielle Générale), il est devenu crucial et urgent de simplifier la création d’applications dotées de fonctions d’IA. Dans ce contexte, « SpringAI » a émergé, visant à simplifier le processus de développement d'applications fonctionnelles d'IA, en le rendant simple et intuitif et en évitant une complexité inutile. Grâce à « SpringAI », les développeurs peuvent plus facilement créer des applications dotées de fonctions d'IA, ce qui les rend plus faciles à utiliser et à exploiter.

Choisir le modèle d'intégration qui correspond le mieux à vos données : un test comparatif des intégrations multilingues OpenAI et open source

Feb 26, 2024 pm 06:10 PM

Choisir le modèle d'intégration qui correspond le mieux à vos données : un test comparatif des intégrations multilingues OpenAI et open source

Feb 26, 2024 pm 06:10 PM

OpenAI a récemment annoncé le lancement de son modèle d'intégration de dernière génération, embeddingv3, qui, selon eux, est le modèle d'intégration le plus performant avec des performances multilingues plus élevées. Ce lot de modèles est divisé en deux types : les plus petits text-embeddings-3-small et les plus puissants et plus grands text-embeddings-3-large. Peu d'informations sont divulguées sur la façon dont ces modèles sont conçus et formés, et les modèles ne sont accessibles que via des API payantes. Il existe donc de nombreux modèles d'intégration open source. Mais comment ces modèles open source se comparent-ils au modèle open source open source ? Cet article comparera empiriquement les performances de ces nouveaux modèles avec des modèles open source. Nous prévoyons de créer une donnée

L'éditeur Zed basé sur Rust est open source, avec prise en charge intégrée d'OpenAI et GitHub Copilot

Feb 01, 2024 pm 02:51 PM

L'éditeur Zed basé sur Rust est open source, avec prise en charge intégrée d'OpenAI et GitHub Copilot

Feb 01, 2024 pm 02:51 PM

Auteur丨Compilé par TimAnderson丨Produit par Noah|51CTO Technology Stack (WeChat ID : blog51cto) Le projet d'éditeur Zed est encore en phase de pré-version et a été open source sous licences AGPL, GPL et Apache. L'éditeur offre des performances élevées et plusieurs options assistées par l'IA, mais n'est actuellement disponible que sur la plate-forme Mac. Nathan Sobo a expliqué dans un article que dans la base de code du projet Zed sur GitHub, la partie éditeur est sous licence GPL, les composants côté serveur sont sous licence AGPL et la partie GPUI (GPU Accelerated User) l'interface) adopte la Licence Apache2.0. GPUI est un produit développé par l'équipe Zed

Travail posthume de l'équipe OpenAI Super Alignment : deux grands modèles jouent à un jeu et le résultat devient plus compréhensible

Jul 19, 2024 am 01:29 AM

Travail posthume de l'équipe OpenAI Super Alignment : deux grands modèles jouent à un jeu et le résultat devient plus compréhensible

Jul 19, 2024 am 01:29 AM

Si la réponse donnée par le modèle d’IA est incompréhensible du tout, oseriez-vous l’utiliser ? À mesure que les systèmes d’apprentissage automatique sont utilisés dans des domaines de plus en plus importants, il devient de plus en plus important de démontrer pourquoi nous pouvons faire confiance à leurs résultats, et quand ne pas leur faire confiance. Une façon possible de gagner confiance dans le résultat d'un système complexe est d'exiger que le système produise une interprétation de son résultat qui soit lisible par un humain ou un autre système de confiance, c'est-à-dire entièrement compréhensible au point que toute erreur possible puisse être trouvé. Par exemple, pour renforcer la confiance dans le système judiciaire, nous exigeons que les tribunaux fournissent des avis écrits clairs et lisibles qui expliquent et soutiennent leurs décisions. Pour les grands modèles de langage, nous pouvons également adopter une approche similaire. Cependant, lorsque vous adoptez cette approche, assurez-vous que le modèle de langage génère

Les performances d'exécution locale du service Embedding dépassent celles d'OpenAI Text-Embedding-Ada-002, ce qui est très pratique !

Apr 15, 2024 am 09:01 AM

Les performances d'exécution locale du service Embedding dépassent celles d'OpenAI Text-Embedding-Ada-002, ce qui est très pratique !

Apr 15, 2024 am 09:01 AM

Ollama est un outil super pratique qui vous permet d'exécuter facilement des modèles open source tels que Llama2, Mistral et Gemma localement. Dans cet article, je vais vous présenter comment utiliser Ollama pour vectoriser du texte. Si vous n'avez pas installé Ollama localement, vous pouvez lire cet article. Dans cet article, nous utiliserons le modèle nomic-embed-text[2]. Il s'agit d'un encodeur de texte qui surpasse OpenAI text-embedding-ada-002 et text-embedding-3-small sur les tâches à contexte court et à contexte long. Démarrez le service nomic-embed-text lorsque vous avez installé avec succès o

N'attendez pas OpenAI, attendez qu'Open-Sora soit entièrement open source

Mar 18, 2024 pm 08:40 PM

N'attendez pas OpenAI, attendez qu'Open-Sora soit entièrement open source

Mar 18, 2024 pm 08:40 PM

Il n'y a pas si longtemps, OpenAISora est rapidement devenu populaire grâce à ses étonnants effets de génération vidéo. Il s'est démarqué parmi la foule de modèles vidéo littéraires et est devenu le centre d'attention mondiale. Suite au lancement du processus de reproduction d'inférence de formation Sora avec une réduction des coûts de 46 % il y a 2 semaines, l'équipe Colossal-AI a entièrement open source le premier modèle de génération vidéo d'architecture de type Sora au monde "Open-Sora1.0", couvrant l'ensemble processus de formation, y compris le traitement des données, tous les détails de la formation et les poids des modèles, et joignez-vous aux passionnés mondiaux de l'IA pour promouvoir une nouvelle ère de création vidéo. Pour un aperçu, jetons un œil à une vidéo d'une ville animée générée par le modèle « Open-Sora1.0 » publié par l'équipe Colossal-AI. Ouvrir-Sora1.0

Microsoft et OpenAI prévoient d'investir 100 millions de dollars dans des robots humanoïdes ! Les internautes appellent Musk

Feb 01, 2024 am 11:18 AM

Microsoft et OpenAI prévoient d'investir 100 millions de dollars dans des robots humanoïdes ! Les internautes appellent Musk

Feb 01, 2024 am 11:18 AM

Il a été révélé que Microsoft et OpenAI investissaient de grosses sommes d’argent dans une start-up de robots humanoïdes au début de l’année. Parmi eux, Microsoft prévoit d'investir 95 millions de dollars et OpenAI investira 5 millions de dollars. Selon Bloomberg, la société devrait lever un total de 500 millions de dollars au cours de ce cycle, et sa valorisation pré-monétaire pourrait atteindre 1,9 milliard de dollars. Qu'est-ce qui les attire ? Jetons d’abord un coup d’œil aux réalisations de cette entreprise en matière de robotique. Ce robot est tout argenté et noir, et son apparence ressemble à l'image d'un robot dans un blockbuster de science-fiction hollywoodien : maintenant, il met une capsule de café dans la machine à café : si elle n'est pas placée correctement, elle s'ajustera sans aucun problème. télécommande humaine : Cependant, après un certain temps, une tasse de café peut être emportée et dégustée : Avez-vous des membres de votre famille qui l'ont reconnu ? Oui, ce robot a été créé il y a quelque temps.

Soudain! OpenAI licencie un allié d'Ilya pour fuite d'informations présumée

Apr 15, 2024 am 09:01 AM

Soudain! OpenAI licencie un allié d'Ilya pour fuite d'informations présumée

Apr 15, 2024 am 09:01 AM

Soudain! OpenAI a licencié des gens, la raison : une fuite d'informations suspectée. L’un d’eux est Léopold Aschenbrenner, un allié du scientifique en chef disparu Ilya et un membre principal de l’équipe Superalignment. L'autre personne n'est pas simple non plus : il s'agit de Pavel Izmailov, chercheur au sein de l'équipe d'inférence du LLM, qui a également travaillé dans l'équipe de super alignement. On ne sait pas exactement quelles informations les deux hommes ont divulguées. Après que la nouvelle ait été révélée, de nombreux internautes se sont dits « assez choqués » : j'ai vu le message d'Aschenbrenner il n'y a pas longtemps et j'ai senti qu'il était en pleine ascension dans sa carrière. Certains internautes sur la photo pensent : OpenAI a perdu Aschenbrenner, je