Périphériques technologiques

Périphériques technologiques

IA

IA

Expérience de capacité NPU pour ordinateurs portables Intel Ultra : la tendance de l'IA est imparable

Expérience de capacité NPU pour ordinateurs portables Intel Ultra : la tendance de l'IA est imparable

Expérience de capacité NPU pour ordinateurs portables Intel Ultra : la tendance de l'IA est imparable

Le futur objectif de travail pourrait être de déployer un assistant IA qui peut non seulement vous doubler, discuter et vous aider à dessiner. Cependant, chaque fois que nous utilisons des applications d'IA (telles que la coupure de l'IA, le remplacement de l'arrière-plan de l'IA), nous semblons facilement rencontrer le problème du « goulot d'étranglement » des ordinateurs portables : non seulement ils commenceront à geler, mais ils feront également du bruit, et même la batterie la vie diminuera considérablement

.

Par conséquent, Intel a annoncé son plan AI PC au milieu de cette année et a rapidement lancé le processeur Core Ultra à architecture Meteor Lake à la fin de l'année, qui est considéré comme la plus grande mise à niveau de processeur de génération de l'histoire. Les spécificités sont les suivantes :

1. Intel adopte une technologie à 4 processus pour améliorer les performances et l'efficacité énergétique de plus de 20 %

Nouvelle structure de base à trois niveaux, équipée d'une unité de calcul AI NPU

Performances graphiques intégrées doublées

Parmi eux, le plus accrocheur est le nouveau « NPU » (Neural Network Processor)

Nous pouvons le comparer à l'assistant IA dans le processeur, qui existe pour améliorer l'expérience des applications IA de l'utilisateur

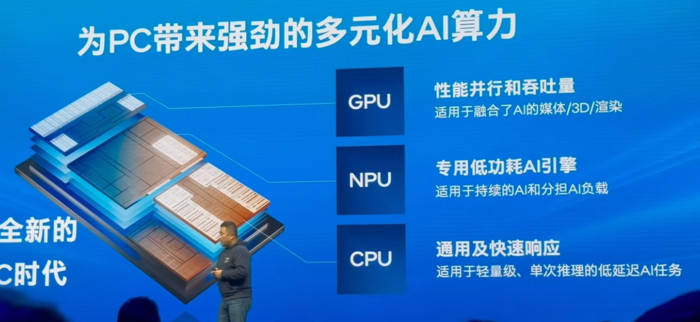

Lors de la conférence de presse, Intel a présenté le NPU du processeur Ultra, adapté à l'intelligence artificielle continue et au partage de la charge de l'intelligence artificielle

Il est concevable que les ordinateurs à intelligence artificielle dotés de NPU améliorent l'expérience utilisateur dans les aspects suivants :

1. Reconnaissance vocale et vitesse de réponse de l'assistant vocal plus rapides

2. Reconnaissance faciale et déverrouillage plus fluides

3. Améliorer la reconnaissance des images et l'efficacité du traitement

4. Fournit un embellissement d'arrière-plan et des effets vidéo plus intelligents

Permet même aux grands modèles d'IA de fonctionner sans problème

Récemment, nous avons reçu un ordinateur portable fin et léger ASUS Lingyao 142024, équipé d'un processeur Core Ultra 155H avec architecture Meteor Lake. Nous avons immédiatement effectué des tests de performances et d'applications de l'IA

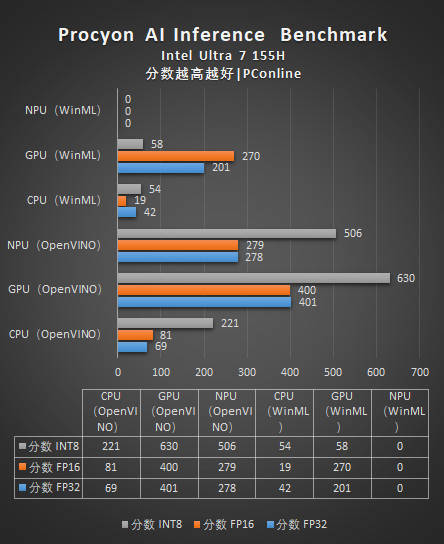

Lors de l'utilisation de UL Procyon AI Inference Benchmark pour les tests de référence des performances d'inférence, il a été constaté que la meilleure performance des capacités d'inférence IA de Meteor Lake était Arc iGPU (carte graphique principale), suivie par NPU, et la pire performance était le CPU. Ce benchmark couvre une variété de modèles de réseaux neuronaux tels que MobileNetV3, InceptionV4, YOLOV3, DeepLabV3, Real-ESRGAN et ResNet50

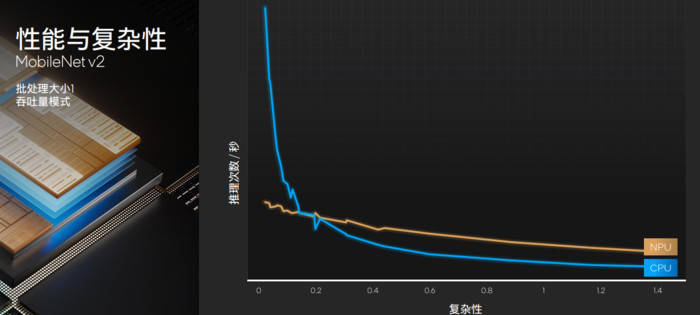

En testant la consommation électrique de l'ensemble de la machine, il a été constaté que les performances de calcul de l'IA du NPU sont bien supérieures à celles du CPU et supérieures à celles du GPU (Intel a déclaré que le taux de consommation d'énergie global de le NPU peut être augmenté jusqu'à 8 fois)

Cela montre que le NPU est très adapté aux appareils mobiles ayant des exigences d'efficacité énergétique extrêmement élevées, tels que les ordinateurs portables. Il peut être utilisé pour traiter des applications continues d'intelligence artificielle à faible calcul afin de réduire la consommation électrique globale de la machine et d'améliorer la durée de vie de la batterie.

Lorsque notre ordinateur portable est équipé d'une unité de traitement neuronal (NPU), nous pouvons avoir deux sentiments évidents :

1. Lorsque vous utilisez un programme capable d'effectuer des calculs d'IA, la durée de vie de la batterie ne s'effondrera pas facilement - le rapport d'efficacité énergétique du calcul d'IA du NPU est plus élevé.

2. La fluidité des applications d'IA prenant en charge les opérations d'IA a été améliorée - NPU peut réduire la pression de calcul sur le CPU et le GPU et exploiter pleinement leurs performances

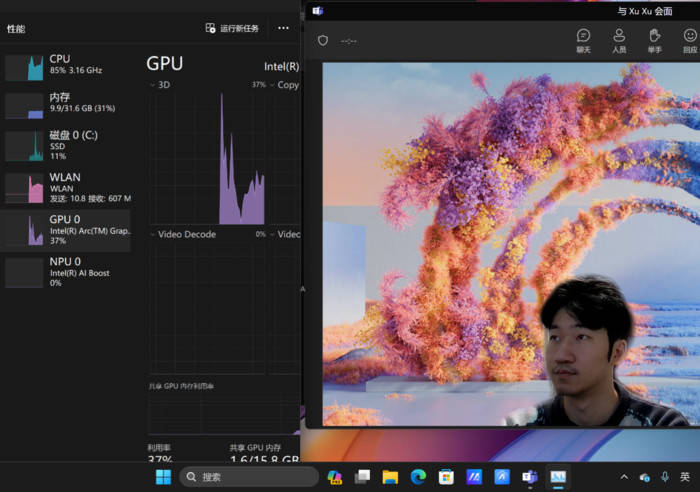

Cependant, en raison du besoin de confidentialité pendant la phase de test du produit, je n'ai pas pu tester avec succès l'application réelle de ce produit. La plupart des applications actuellement sur le marché (notamment Team, Cutting, SD, LLM, etc.) ne prennent pas encore en charge l'accélération matérielle NPU et s'appuient encore principalement sur les calculs CPU et GPU

Lorsque vous utilisez des arrière-plans virtuels dans la visioconférence Teams, vous comptez toujours sur l'accélération du CPU et du GPU sans activer NPU

Avec la popularité des processeurs NPU, nous pouvons prévoir que la plupart des applications d'IA seront rapidement adaptées, améliorant ainsi encore l'efficacité énergétique de l'ensemble de la machine. Cependant, à l’heure actuelle, nous pouvons seulement dire que « l’avenir est prévisible », et nous ne savons pas encore quels seront les résultats réels de l’adaptation

En résumé :

NPU est en principe plus adapté pour effectuer efficacement des calculs de faible précision en parallèle que les CPU ou GPU à usage général. De plus, NPU présente les caractéristiques d'une bande passante élevée et d'une capacité élevée en termes de stockage, d'un débit de données important et d'une faible latence de réponse. Par conséquent, NPU joue un rôle positif dans l’amélioration de l’efficacité des applications d’IA

NPU est comme un expert en informatique IA ultra-efficace. Il peut non seulement prolonger la durée de vie de votre ordinateur portable, mais également exécuter en douceur une variété d'applications IA intéressantes, telles que les arrière-plans virtuels et la beauté en temps réel. C'est le rôle le plus important que joue NPU dans l'équipement informatique personnel

Les appareils PC équipés d'unités de calcul NPU auront théoriquement des capacités informatiques d'intelligence artificielle plus puissantes, seront capables de traiter efficacement des modèles d'intelligence artificielle complexes et d'obtenir des calculs et des commentaires rapides

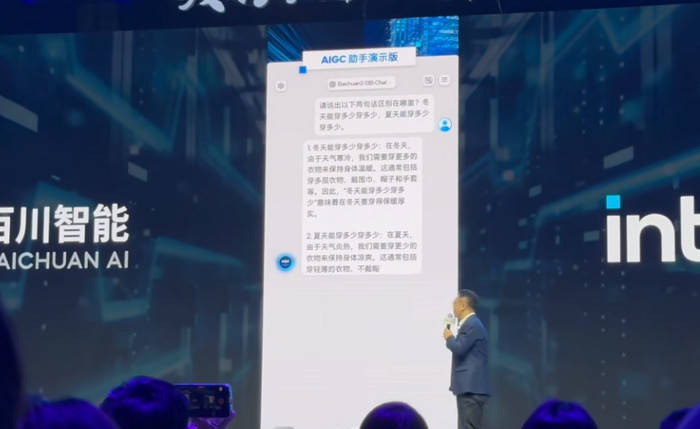

Lors de la conférence Ultra, Intel a déclaré que les processeurs Ultra ont déjà la capacité d'exécuter de grands modèles d'IA avec 20 milliards de paramètres, et a personnellement démontré des applications d'IA telles que de grands modèles de langage locaux et des graphiques vincentiens

Actuellement, la précision et la complexité des résultats générés par l'IA locale ne sont pas comparables au plus grand nombre de paramètres des applications d'IA générative basées sur le cloud

En regardant vers l'avenir, je pense qu'à mesure que de plus en plus d'applications d'IA prendront en charge NPU, la durée de vie de la batterie et les performances des ordinateurs portables seront considérablement améliorées (à condition que vous utilisiez souvent de telles applications informatiques d'IA)

Avec l'amélioration de la puissance de calcul de l'unité NPU et l'amélioration de la capacité de stockage des appareils PC, il sera possible à l'avenir de mettre en œuvre un grand modèle d'IA local puissant sur un ordinateur personnel, avec des centaines de milliards de paramètres, qui peuvent atteindre une intelligence comparable vers des fonctions d'IA cloud pour écrire ou générer des images. Ce n'est pas un objectif inaccessible

En fin de compte, nous continuerons à prêter attention à la mise en œuvre des applications d'accélération NPU sur le site officiel et évaluerons plus en détail l'évaluation détaillée des produits de processeur Core Ultra en termes de performances d'IA et de consommation d'énergie. Veuillez continuer à prêter attention au dernier contenu de PConline

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Conseils de configuration du pare-feu Debian Mail Server

Apr 13, 2025 am 11:42 AM

Conseils de configuration du pare-feu Debian Mail Server

Apr 13, 2025 am 11:42 AM

La configuration du pare-feu d'un serveur de courrier Debian est une étape importante pour assurer la sécurité du serveur. Voici plusieurs méthodes de configuration de pare-feu couramment utilisées, y compris l'utilisation d'iptables et de pare-feu. Utilisez les iptables pour configurer le pare-feu pour installer iptables (sinon déjà installé): Sudoapt-getUpDaSuDoapt-getinstalliptableView Règles actuelles iptables: Sudoiptable-L Configuration

Méthode d'installation du certificat de Debian Mail Server SSL

Apr 13, 2025 am 11:39 AM

Méthode d'installation du certificat de Debian Mail Server SSL

Apr 13, 2025 am 11:39 AM

Les étapes pour installer un certificat SSL sur le serveur de messagerie Debian sont les suivantes: 1. Installez d'abord la boîte à outils OpenSSL, assurez-vous que la boîte à outils OpenSSL est déjà installée sur votre système. Si ce n'est pas installé, vous pouvez utiliser la commande suivante pour installer: Sudoapt-getUpDaSuDoapt-getInstallOpenSSL2. Générer la clé privée et la demande de certificat Suivant, utilisez OpenSSL pour générer une clé privée RSA 2048 bits et une demande de certificat (RSE): OpenSS

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

La commande de fermeture CENTOS est arrêtée et la syntaxe est la fermeture de [options] le temps [informations]. Les options incluent: -H Arrêtez immédiatement le système; -P éteignez l'alimentation après l'arrêt; -r redémarrer; -t temps d'attente. Les temps peuvent être spécifiés comme immédiats (maintenant), minutes (minutes) ou une heure spécifique (HH: mm). Des informations supplémentaires peuvent être affichées dans les messages système.

Sony confirme la possibilité d'utiliser des GPU spéciaux sur PS5 Pro pour développer une IA avec AMD

Apr 13, 2025 pm 11:45 PM

Sony confirme la possibilité d'utiliser des GPU spéciaux sur PS5 Pro pour développer une IA avec AMD

Apr 13, 2025 pm 11:45 PM

Mark Cerny, architecte en chef de SonyInterActiveTeretment (SIE, Sony Interactive Entertainment), a publié plus de détails matériels de l'hôte de nouvelle génération PlayStation5Pro (PS5PRO), y compris un GPU AMDRDNA2.x architecture amélioré sur les performances, et un programme d'apprentissage de l'intelligence machine / artificielle "AmethylSt" avec AMD. L'amélioration des performances de PS5PRO est toujours sur trois piliers, y compris un GPU plus puissant, un traçage avancé des rayons et une fonction de super-résolution PSSR alimentée par AI. GPU adopte une architecture AMDRDNA2 personnalisée, que Sony a nommé RDNA2.x, et il a une architecture RDNA3.

Quelles sont les méthodes de sauvegarde pour Gitlab sur Centos

Apr 14, 2025 pm 05:33 PM

Quelles sont les méthodes de sauvegarde pour Gitlab sur Centos

Apr 14, 2025 pm 05:33 PM

La politique de sauvegarde et de récupération de GitLab dans le système CentOS afin d'assurer la sécurité et la récupérabilité des données, Gitlab on CentOS fournit une variété de méthodes de sauvegarde. Cet article introduira plusieurs méthodes de sauvegarde courantes, paramètres de configuration et processus de récupération en détail pour vous aider à établir une stratégie complète de sauvegarde et de récupération de GitLab. 1. MANUEL BACKUP Utilisez le Gitlab-RakegitLab: Backup: Créer la commande pour exécuter la sauvegarde manuelle. Cette commande sauvegarde des informations clés telles que le référentiel Gitlab, la base de données, les utilisateurs, les groupes d'utilisateurs, les clés et les autorisations. Le fichier de sauvegarde par défaut est stocké dans le répertoire / var / opt / gitlab / backups. Vous pouvez modifier / etc / gitlab

Quelles sont les méthodes de réglage des performances de Zookeeper sur Centos

Apr 14, 2025 pm 03:18 PM

Quelles sont les méthodes de réglage des performances de Zookeeper sur Centos

Apr 14, 2025 pm 03:18 PM

Le réglage des performances de Zookeeper sur CentOS peut commencer à partir de plusieurs aspects, notamment la configuration du matériel, l'optimisation du système d'exploitation, le réglage des paramètres de configuration, la surveillance et la maintenance, etc. Assez de mémoire: allouez suffisamment de ressources de mémoire à Zookeeper pour éviter la lecture et l'écriture de disques fréquents. CPU multi-core: utilisez un processeur multi-core pour vous assurer que Zookeeper peut le traiter en parallèle.

Enfin changé! La fonction de recherche Microsoft Windows inaugurera une nouvelle mise à jour

Apr 13, 2025 pm 11:42 PM

Enfin changé! La fonction de recherche Microsoft Windows inaugurera une nouvelle mise à jour

Apr 13, 2025 pm 11:42 PM

Les améliorations de Microsoft aux fonctions de recherche Windows ont été testées sur certains canaux d'initiés Windows dans l'UE. Auparavant, la fonction de recherche Windows intégrée a été critiquée par les utilisateurs et avait une mauvaise expérience. Cette mise à jour divise la fonction de recherche en deux parties: recherche locale et recherche Web basée sur Bing pour améliorer l'expérience utilisateur. La nouvelle version de l'interface de recherche effectue la recherche de fichiers locale par défaut. Si vous devez rechercher en ligne, vous devez cliquer sur l'onglet "Microsoft Bingwebsearch" pour changer. Après le changement, la barre de recherche affichera "Microsoft BingWebsearch:", où les utilisateurs peuvent entrer des mots clés. Ce mouvement évite efficacement le mélange des résultats de recherche locaux avec les résultats de recherche Bing

Comment entraîner le modèle Pytorch sur Centos

Apr 14, 2025 pm 03:03 PM

Comment entraîner le modèle Pytorch sur Centos

Apr 14, 2025 pm 03:03 PM

Une formation efficace des modèles Pytorch sur les systèmes CentOS nécessite des étapes, et cet article fournira des guides détaillés. 1. Préparation de l'environnement: Installation de Python et de dépendance: le système CentOS préinstalle généralement Python, mais la version peut être plus ancienne. Il est recommandé d'utiliser YUM ou DNF pour installer Python 3 et Mettez PIP: sudoyuMupDatePython3 (ou sudodnfupdatepython3), pip3install-upradepip. CUDA et CUDNN (accélération GPU): Si vous utilisez Nvidiagpu, vous devez installer Cudatool