Périphériques technologiques

Périphériques technologiques

IA

IA

Le modèle de génération vidéo de nouvelle génération de Byte rend l'effet de Hulk portant des lunettes VR meilleur que Gen-2 !

Le modèle de génération vidéo de nouvelle génération de Byte rend l'effet de Hulk portant des lunettes VR meilleur que Gen-2 !

Le modèle de génération vidéo de nouvelle génération de Byte rend l'effet de Hulk portant des lunettes VR meilleur que Gen-2 !

En une seule phrase, Hulk peut mettre des lunettes VR.

Qualité 4K.

Panda's Life of Fantasy~

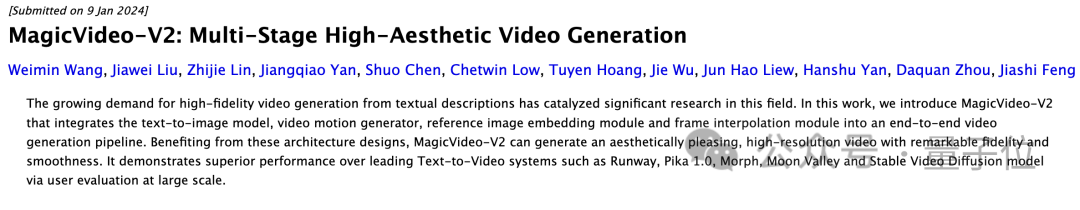

Il s'agit du dernier modèle de génération de vidéo IA de Byte MagicVideo-V2, toutes sortes d'idées fantastiques peuvent être réalisées. Il prend non seulement en charge les résolutions ultra-hautes 4K et 8K, mais peut facilement contenir différents styles de dessin.

△De gauche à droite : style de peinture à l'huile, style cyber, style de conception

L'effet d'évaluation dépasse Gen-2, Pika et les outils de génération vidéo AI existants.

En conséquence, dans les 24 heures suivant sa mise en ligne, il a attiré beaucoup d'attention. Par exemple, un tweet a été vu près de 200 000.

De nombreux internautes ont été surpris par son effet, et ont même dit sans détour : C'est mieux que la piste et le pika.

"Mieux que la piste et le pika"

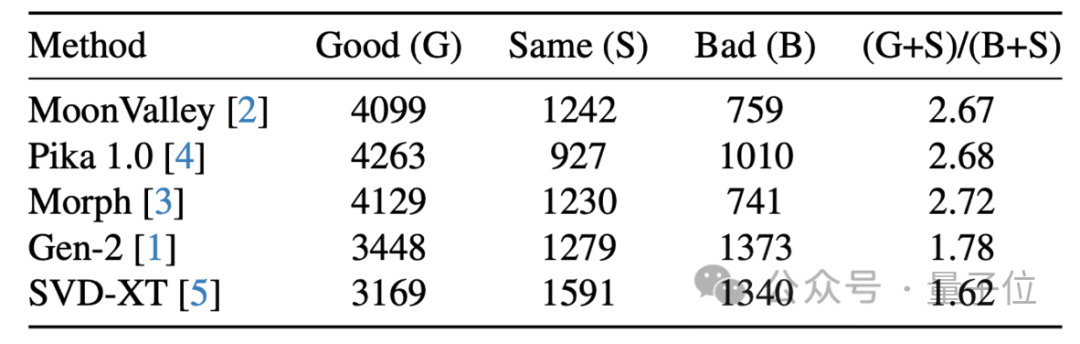

Les chercheurs ont procédé à une véritable comparaison des effets. Les concurrents sont : MagicVideo-V2, SVD-XT de StabilityAI, le nouveau joueur potentiel Pika1.0 et Gen-2 de Runway.

Tour 1 : Effets de lumière et d'ombre.

Au coucher du soleil, le voyageur se promène seul dans la forêt brumeuse.

(de gauche à droite : MagicVideo-V2, SVD-XT, Pika en haut à droite, Gen-2 en bas à droite, le même ci-dessous)

Vous pouvez voir que MagicVideo-V2, Gen-2 et Pika a une lumière et une ombre évidentes. Cependant, Pika ne peut pas être considéré comme destiné aux voyageurs, car MagicVideo-V2 a des tons plus riches.

Round 2 : Expression de l'intrigue situationnelle.

Une sitcom dans les années 1910, racontant la vie quotidienne et des sujets insignifiants de la société

Ce tour, MagicVideo-V2 et Gen-2 sont évidemment meilleurs. Bien que la composition milieu de gamme présentée par SVD-XT reflète l'âge, elle n'est pas assez expressive.

Tour 3 : Réaliste.

Le petit garçon faisait du vélo sur le chemin du parc, et les roues faisaient un bruit de craquement sur le gravier.

Cette fois, le contraste est encore plus évident. MagicVideo-V2 et SVD-XT reflètent pleinement le sens de la phrase, mais MagicVideo-V2 peut voir les détails des pieds clairement en mouvement de l'enfant.

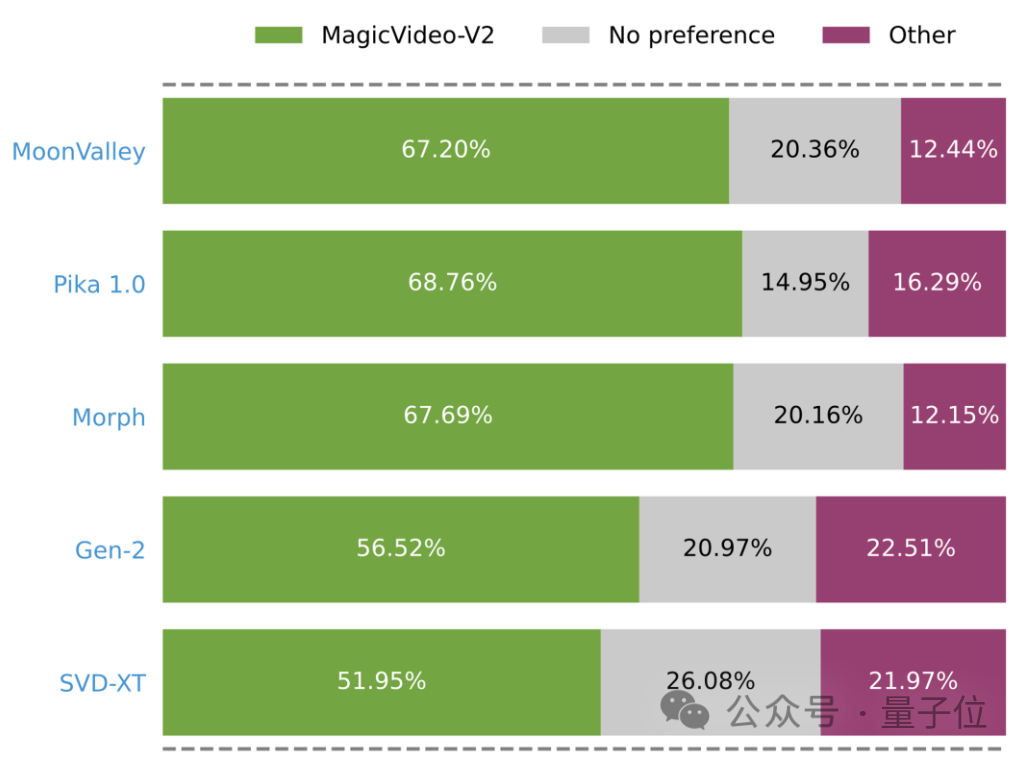

De plus, les chercheurs ont également mené des évaluations individuelles de MagicVideo-V2 par rapport aux méthodes de pointe.

Les résultats montrent que les gens pensent que MagicVideo-V2 fonctionne mieux que d'autres méthodes.

(Les barres vertes, grises et roses représentent les résultats expérimentaux où MagicVideo-V2 est noté respectivement meilleur, équivalent ou pire.)

Comment y parvenir ?

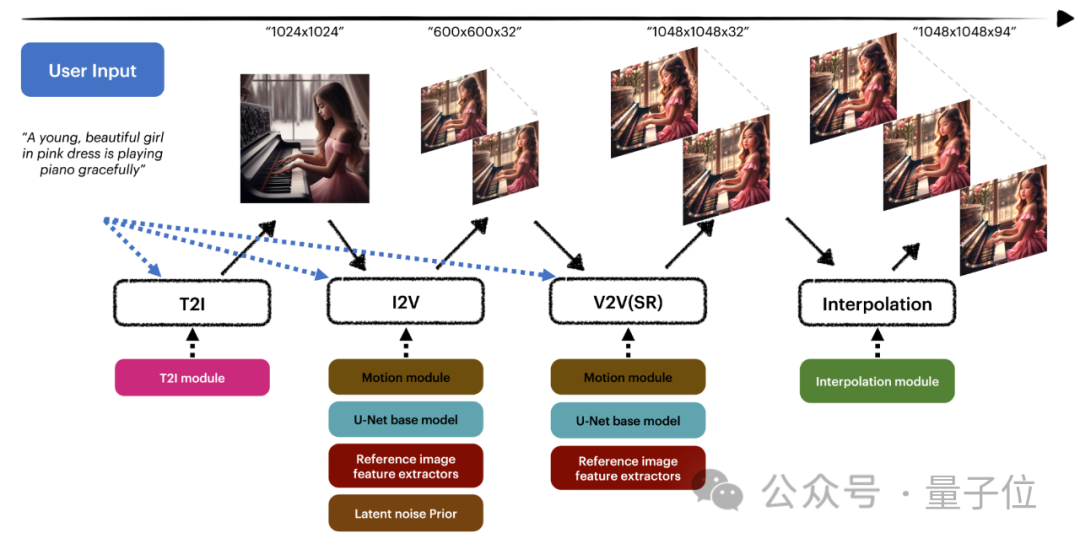

En termes simples, MagicVideo-V2 est un pipeline de génération vidéo qui intègre un modèle texte-image, un générateur de mouvement vidéo, un module d'intégration d'images de référence et un module d'interpolation.

Tout d'abord, le module T2I génère d'abord une image 1024×1024 basée sur le texte, puis le module I2V anime l'image statique pour générer une séquence d'images 600×600×32, puis utilise le module V2V pour améliorer et améliorer le contenu vidéo, et enfin utiliser le module d'interpolation pour étendre la séquence à 94 images.

De cette manière, la haute fidélité et la continuité dans le temps sont assurées.

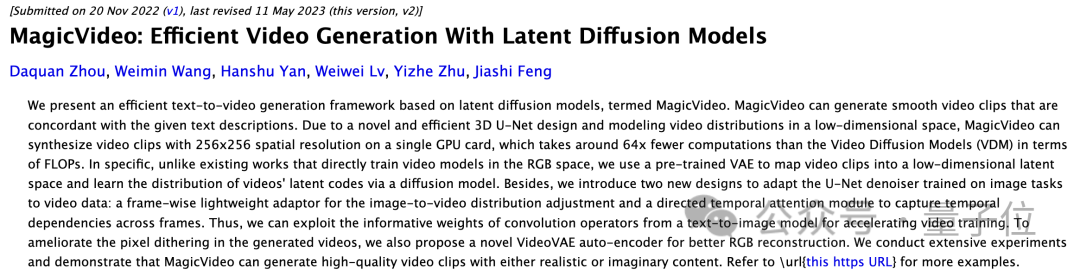

Mais dès novembre 2022, Byte a lancé la version MagicVideo V1.

Cependant, à cette époque, l'accent était davantage mis sur l'efficacité, qui pouvait générer une vidéo de résolution 256x256 sur une seule carte GPU.

Lien de référence :

https://twitter.com/arankomatsuzaki/status/1744918551415443768?s=20

Lien du projet :

https://magicvideov2.github.io/

Lien papier :

https://arxiv.org/abs/2401.04468

https://arxiv.org/abs/2211.11018

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

La commande de fermeture CENTOS est arrêtée et la syntaxe est la fermeture de [options] le temps [informations]. Les options incluent: -H Arrêtez immédiatement le système; -P éteignez l'alimentation après l'arrêt; -r redémarrer; -t temps d'attente. Les temps peuvent être spécifiés comme immédiats (maintenant), minutes (minutes) ou une heure spécifique (HH: mm). Des informations supplémentaires peuvent être affichées dans les messages système.

Quelles sont les méthodes de sauvegarde pour Gitlab sur Centos

Apr 14, 2025 pm 05:33 PM

Quelles sont les méthodes de sauvegarde pour Gitlab sur Centos

Apr 14, 2025 pm 05:33 PM

La politique de sauvegarde et de récupération de GitLab dans le système CentOS afin d'assurer la sécurité et la récupérabilité des données, Gitlab on CentOS fournit une variété de méthodes de sauvegarde. Cet article introduira plusieurs méthodes de sauvegarde courantes, paramètres de configuration et processus de récupération en détail pour vous aider à établir une stratégie complète de sauvegarde et de récupération de GitLab. 1. MANUEL BACKUP Utilisez le Gitlab-RakegitLab: Backup: Créer la commande pour exécuter la sauvegarde manuelle. Cette commande sauvegarde des informations clés telles que le référentiel Gitlab, la base de données, les utilisateurs, les groupes d'utilisateurs, les clés et les autorisations. Le fichier de sauvegarde par défaut est stocké dans le répertoire / var / opt / gitlab / backups. Vous pouvez modifier / etc / gitlab

Comment vérifier la configuration de CentOS HDFS

Apr 14, 2025 pm 07:21 PM

Comment vérifier la configuration de CentOS HDFS

Apr 14, 2025 pm 07:21 PM

Guide complet pour vérifier la configuration HDFS dans les systèmes CentOS Cet article vous guidera comment vérifier efficacement la configuration et l'état de l'exécution des HDF sur les systèmes CentOS. Les étapes suivantes vous aideront à bien comprendre la configuration et le fonctionnement des HDF. Vérifiez la variable d'environnement Hadoop: Tout d'abord, assurez-vous que la variable d'environnement Hadoop est correctement définie. Dans le terminal, exécutez la commande suivante pour vérifier que Hadoop est installé et configuré correctement: HadoopVersion Check HDFS Fichier de configuration: Le fichier de configuration de base de HDFS est situé dans le répertoire / etc / hadoop / conf / le répertoire, où Core-site.xml et hdfs-site.xml sont cruciaux. utiliser

Quelles sont les méthodes de réglage des performances de Zookeeper sur Centos

Apr 14, 2025 pm 03:18 PM

Quelles sont les méthodes de réglage des performances de Zookeeper sur Centos

Apr 14, 2025 pm 03:18 PM

Le réglage des performances de Zookeeper sur CentOS peut commencer à partir de plusieurs aspects, notamment la configuration du matériel, l'optimisation du système d'exploitation, le réglage des paramètres de configuration, la surveillance et la maintenance, etc. Assez de mémoire: allouez suffisamment de ressources de mémoire à Zookeeper pour éviter la lecture et l'écriture de disques fréquents. CPU multi-core: utilisez un processeur multi-core pour vous assurer que Zookeeper peut le traiter en parallèle.

Comment entraîner le modèle Pytorch sur Centos

Apr 14, 2025 pm 03:03 PM

Comment entraîner le modèle Pytorch sur Centos

Apr 14, 2025 pm 03:03 PM

Une formation efficace des modèles Pytorch sur les systèmes CentOS nécessite des étapes, et cet article fournira des guides détaillés. 1. Préparation de l'environnement: Installation de Python et de dépendance: le système CentOS préinstalle généralement Python, mais la version peut être plus ancienne. Il est recommandé d'utiliser YUM ou DNF pour installer Python 3 et Mettez PIP: sudoyuMupDatePython3 (ou sudodnfupdatepython3), pip3install-upradepip. CUDA et CUDNN (accélération GPU): Si vous utilisez Nvidiagpu, vous devez installer Cudatool

Comment est la prise en charge du GPU pour Pytorch sur Centos

Apr 14, 2025 pm 06:48 PM

Comment est la prise en charge du GPU pour Pytorch sur Centos

Apr 14, 2025 pm 06:48 PM

Activer l'accélération du GPU Pytorch sur le système CentOS nécessite l'installation de versions CUDA, CUDNN et GPU de Pytorch. Les étapes suivantes vous guideront tout au long du processus: CUDA et CUDNN Installation détermineront la compatibilité de la version CUDA: utilisez la commande NVIDIA-SMI pour afficher la version CUDA prise en charge par votre carte graphique NVIDIA. Par exemple, votre carte graphique MX450 peut prendre en charge CUDA11.1 ou plus. Téléchargez et installez Cudatoolkit: visitez le site officiel de Nvidiacudatoolkit et téléchargez et installez la version correspondante selon la version CUDA la plus élevée prise en charge par votre carte graphique. Installez la bibliothèque CUDNN:

Explication détaillée du principe docker

Apr 14, 2025 pm 11:57 PM

Explication détaillée du principe docker

Apr 14, 2025 pm 11:57 PM

Docker utilise les fonctionnalités du noyau Linux pour fournir un environnement de fonctionnement d'application efficace et isolé. Son principe de travail est le suivant: 1. Le miroir est utilisé comme modèle en lecture seule, qui contient tout ce dont vous avez besoin pour exécuter l'application; 2. Le Système de fichiers Union (UnionFS) empile plusieurs systèmes de fichiers, ne stockant que les différences, l'économie d'espace et l'accélération; 3. Le démon gère les miroirs et les conteneurs, et le client les utilise pour l'interaction; 4. Les espaces de noms et les CGROUP implémentent l'isolement des conteneurs et les limitations de ressources; 5. Modes de réseau multiples prennent en charge l'interconnexion du conteneur. Ce n'est qu'en comprenant ces concepts principaux que vous pouvez mieux utiliser Docker.

Comment choisir la version Pytorch sous Centos

Apr 14, 2025 pm 02:51 PM

Comment choisir la version Pytorch sous Centos

Apr 14, 2025 pm 02:51 PM

Lors de la sélection d'une version Pytorch sous CentOS, les facteurs clés suivants doivent être pris en compte: 1. CUDA Version Compatibilité GPU Prise en charge: si vous avez NVIDIA GPU et que vous souhaitez utiliser l'accélération GPU, vous devez choisir Pytorch qui prend en charge la version CUDA correspondante. Vous pouvez afficher la version CUDA prise en charge en exécutant la commande nvidia-SMI. Version CPU: Si vous n'avez pas de GPU ou que vous ne souhaitez pas utiliser de GPU, vous pouvez choisir une version CPU de Pytorch. 2. Version Python Pytorch