Périphériques technologiques

Périphériques technologiques

IA

IA

La technologie de bout en bout dans le domaine de la conduite autonome remplacera-t-elle des frameworks tels qu'Apollo et autoware ?

La technologie de bout en bout dans le domaine de la conduite autonome remplacera-t-elle des frameworks tels qu'Apollo et autoware ?

La technologie de bout en bout dans le domaine de la conduite autonome remplacera-t-elle des frameworks tels qu'Apollo et autoware ?

Repenser l'évaluation en boucle ouverte de la conduite autonome de bout en bout dans nuScenes

- Unité auteur : Baidu

- Auteur : Jiang-Tian Zhai, Ze Feng, Baidu Wang Jingdong Group

- Publié : arXiv

- Lien papier : https://arxiv.org/abs/2305.10430

- Lien de code : https://github.com/E2E-AD/AD-MLP

Mots clés : conduite autonome de bout en bout, évaluation en boucle ouverte nuScenes

1. Résumé

Les systèmes de conduite autonome existants sont généralement divisés en trois tâches principales : la perception, la prédiction et la planification ; la tâche de planification consiste à prédire la trajectoire du véhicule en fonction des intentions internes et de l'environnement externe, et à contrôler le véhicule. La plupart des solutions existantes évaluent leurs méthodes sur l'ensemble de données nuScenes, et les indicateurs d'évaluation sont l'erreur L2 et le taux de collision. Cet article réévalue les indicateurs d'évaluation existants pour déterminer s'ils peuvent mesurer avec précision la supériorité des différentes méthodes. Cet article a également conçu une méthode basée sur MLP qui prend en entrée les données brutes des capteurs (trajectoire historique, vitesse, etc.) et génère directement la trajectoire future du véhicule sans utiliser d'informations de perception et de prédiction, telles que des images de caméra ou LiDAR. Étonnamment : une méthode aussi simple permet d'obtenir des performances de planification SOTA sur l'ensemble de données nuScenes, réduisant ainsi l'erreur L2 de 30 %. Notre analyse plus approfondie fournit de nouvelles informations sur les facteurs importants pour la planification des tâches sur l'ensemble de données nuScenes. Nos observations suggèrent également que nous devons repenser le schéma d'évaluation en boucle ouverte de la conduite autonome de bout en bout dans nuScenes.

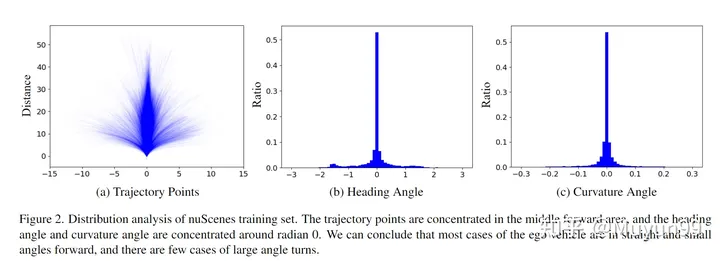

2. Le but, la contribution et la conclusion de l'articleCet article espère évaluer la solution d'évaluation en boucle ouverte de bout en bout pour la conduite autonome sur nuScenes sans utiliser la vision et le Lidar, uniquement l'état du véhicule et ; des commandes avancées sont utilisées (un total de 21 vecteurs dimensionnels) peuvent être utilisées comme entrée pour réaliser le SOTA de Planning sur nuScenes. L'auteur a ainsi souligné le manque de fiabilité de l'évaluation en boucle ouverte sur nuScenes et a donné deux analyses : la trajectoire du véhicule sur l'ensemble de données nuScenes a tendance à aller droit ou à avoir une très petite courbure, la détection du taux de collision est liée à la densité de la grille ; , et L'annotation des collisions de l'ensemble de données est également bruyante et la méthode actuelle d'évaluation du taux de collision n'est pas suffisamment robuste et précise

3 La méthode de l'article3.1 Introduction et brève description des travaux connexes ;

Les modèles de conduite autonome existants impliquent de nombreuses tâches indépendantes telles que la perception, la prédiction et la planification. Cette conception simplifie la difficulté de l'écriture entre équipes, mais elle entraîne également une perte d'informations et une accumulation d'erreurs dans l'ensemble du système en raison de l'indépendance de l'optimisation et de la formation de chaque tâche. Des méthodes de bout en bout sont proposées, qui bénéficient de l'apprentissage des caractéristiques spatio-temporelles du véhicule autonome et de son environnement.

Travail connexe: ST-P3[1] propose un système de bout en bout interprétable basé sur la vision qui unifie l'apprentissage des fonctionnalités pour la perception, la prédiction et la planification. UniAD[2] conçoit systématiquement les tâches de planification, utilise une conception basée sur des requêtes pour connecter plusieurs tâches intermédiaires et peut modéliser et coder la relation entre plusieurs tâches ; VAD[3] construit des scènes de manière entièrement vectorisée et ne nécessite pas de fonctionnalités denses. représentation et est plus efficace en termes de calcul. Cet article espère explorer si les mesures d'évaluation existantes peuvent mesurer avec précision les avantages et les inconvénients des différentes méthodes. Cet article utilise uniquement l’état physique du véhicule pendant la conduite (un sous-ensemble des informations utilisées par les méthodes existantes) pour mener des expériences, plutôt que d’utiliser les informations de perception et de prédiction fournies par les caméras et le lidar. En bref, le modèle présenté dans cet article n'utilise pas d'encodeurs visuels ou de nuages de points et encode directement les informations physiques du véhicule dans un vecteur unidimensionnel, qui est envoyé au MLP après concat. La formation utilise les trajectoires GT pour la supervision, et le modèle prédit directement les points de trajectoire du véhicule dans un certain temps dans le futur. Suivez les travaux précédents et utilisez l'erreur L2 et le taux de collision (taux de collision.) pour l'évaluation sur l'ensemble de données nuScenes

Bien que la conception du modèle soit simple, elle obtient les meilleurs résultats de planification. Cet article attribue cela aux lacunes de l'évaluation actuelle. indicateurs. En fait, en utilisant la trajectoire, la vitesse, l'accélération et la continuité temporelle passées du véhicule autonome, le mouvement futur du véhicule autonome peut être reflété dans une certaine mesure.

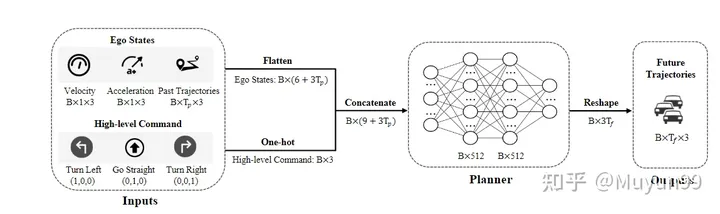

3.2 Structure du modèle Aperçu de la structure du modèle

Aperçu de la structure du modèle

Modèle L'entrée se compose de deux parties : l'état du véhicule autonome et les commandes de haut niveau représentant les futures tendances de mouvement à court terme.

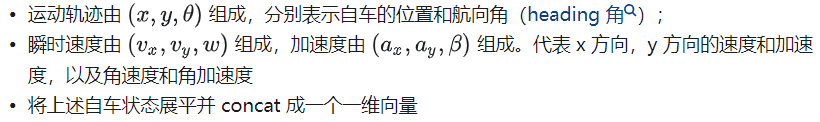

Statut du véhicule autonome : collecte du passé

=4 images de la trajectoire de mouvement du véhicule autonome, vitesse et accélération instantanées

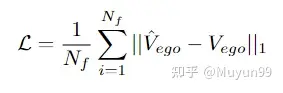

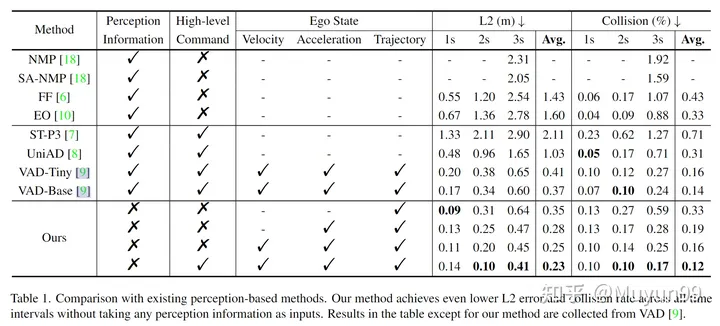

: étant donné que notre modèle n'utilise pas de cartes de haute précision, des commandes avancées sont nécessaires à la navigation. Conformément à la pratique courante, trois types de commandes sont définis : tourner à gauche, aller tout droit et tourner à droite. Plus précisément, lorsque votre propre véhicule se déplacera à gauche ou à droite de plus de 2 m dans les 3 secondes suivantes, réglez la commande correspondante pour tourner à gauche ou à droite, sinon il ira tout droit. Utilisez un encodage one-hot avec la dimension 1x3 pour représenter les commandes de haut niveau Structure du réseau : Le réseau est un simple MLP à trois couches (les dimensions d'entrée et de sortie sont respectivement de 21-512-512-18), le nombre final de trames de sortie = 6, chaque trame génère la position de trajectoire du véhicule. (coordonnées x, y) et angle de cap (angle de cap) Fonction de perte Fonction de perte : Utilisez la fonction de perte L1 pour la pénalité ensemble de données : Expériences sur l'ensemble de données nuScenes, composé de 1 000 scènes et d'environ 40 000 images clés, principalement collectées à Boston et à Singapour, à l'aide de véhicules équipés de LiDAR et de caméras circonférentielles. Les données collectées pour chaque image incluent des images Camear multi-vues, LiDAR, vitesse, accélération, etc. Erreur L2 : en mètres, calculée entre la trajectoire prédite du véhicule autonome et la trajectoire réelle dans les 1s, 2s et 3s suivantes plage respectivement Erreur L2 moyenne ; taux de collision : en pourcentage. Afin de déterminer la fréquence à laquelle le véhicule autonome entre en collision avec d'autres objets, les collisions sont calculées en plaçant un cadre représentant le véhicule autonome à chaque point de cheminement sur la trajectoire prévue, puis en détectant si une collision se produit avec les cadres englobants des véhicules et des piétons. dans la scène actuelle. Paramètres et matériel des hyperparamètres : framework PaddlePaddle et PyTorch, optimiseur AdamW (dégradation de poids 4e-6 lr et 1e-2), planificateur de cosinus, formé pour 6 époques, la taille du lot est de 4 et un V100 est utilisé Tableau 1 Comparaison avec les méthodes existantes basées sur la perception Certaines expériences d'ablation ont été réalisées dans le tableau 1. Analyser l'impact de la vitesse, de l'accélération, de la trajectoire et du commandement de haut niveau sur les performances du modèle de cet article. Étonnamment, en utilisant uniquement les trajectoires comme entrée et aucune information perceptuelle, notre modèle de base atteint déjà une erreur L2 moyenne inférieure à toutes les méthodes existantes. Lorsque nous ajoutons progressivement l'accélération, la vitesse et la commande de haut niveau à l'entrée, l'erreur L2 moyenne et le taux de collision diminuent de 0,35 m à 0,23 m et de 0,33 % à 0,12 %. Le modèle qui prend à la fois l'État du Moi et le Commandement de haut niveau en entrée atteint le taux d'erreur L2 et de collision le plus bas, surpassant toutes les méthodes basées sur la perception de pointe précédentes, comme le montre la dernière ligne. L'article analyse la répartition de l'état du véhicule autonome sur l'ensemble d'entraînement nuScenes sous deux angles : les points de trajectoire dans les 3 prochaines secondes ; l'angle de cap (angle de cap/angle de lacet) et les angles de courbure (angles de courbure) ; Analyse de distribution de l'ensemble d'entraînement nuScenes. Tous les futurs points de trajectoire 3s de l'ensemble d'entraînement sont tracés dans la figure 2(a). Comme le montre la figure, la trajectoire est principalement concentrée dans la partie médiane (droite), et la trajectoire est principalement une ligne droite, ou une courbe avec une très petite courbure. L'angle de cap représente la direction future du déplacement par rapport à l'heure actuelle, tandis que l'angle de courbure reflète la vitesse de rotation du véhicule. Comme le montrent les figures 2 (b) et (c), près de 70 % des angles de cap et de courbure se situent respectivement dans la plage de -0,2 à 0,2 et de -0,02 à 0,02 radians. Ce résultat est cohérent avec les conclusions tirées de la distribution des points de trajectoire. Sur la base de l'analyse ci-dessus de la répartition des points de trajectoire, des angles de cap et des angles de courbure, cet article estime que dans l'ensemble d'entraînement nuScenes, le véhicule autonome a tendance à avancer en ligne droite et selon un petit angle lorsqu'il se déplace à l'intérieur. un intervalle de temps court. Les différentes tailles de grille de la carte d'occupation provoqueront des collisions dans les trajectoires GT Lors du calcul du taux de collision, une pratique courante dans les méthodes existantes consiste à projeter des objets tels que des véhicules et des piétons dans la vue à vol d'oiseau (BEV ), puis convertissez-les en zones occupées dans le diagramme. Et c'est là que la précision est perdue, nous avons constaté qu'une petite partie des échantillons de trajectoire GT (environ 2 %) chevauchaient également des obstacles dans la grille d'occupation, mais la voiture autonome n'est en réalité entrée en collision avec rien d'autre lors de la collecte du data , ce qui entraîne une détection incorrecte des collisions. Provoquer des collisions incorrectes lorsque les véhicules ego sont proches de certains objets, par exemple plus petits que la taille d'un seul pixel de la carte d'occupation. La figure 3 montre un exemple de ce phénomène, ainsi que les résultats de détection de collision pour des trajectoires de vérité terrain avec deux tailles de grille différentes. Les oranges représentent les véhicules qui peuvent être faussement détectés comme des collisions. À la taille de grille plus petite (0,1 m) indiquée dans le coin inférieur droit, le système d'évaluation identifie correctement la trajectoire du GT comme étant non collisionnelle, mais à la taille de grille plus grande en bas à droite. coin (0,5 m), une détection de collision incorrecte se produira. Après avoir observé l'impact de la taille de la grille occupée sur la détection des collisions de trajectoire, nous avons testé une taille de grille de 0,6 m. L'ensemble d'entraînement nuScenes contient 4,8 % d'échantillons de collision, tandis que l'ensemble de validation en contient 3,0 %. Il convient de mentionner que lorsque nous utilisions auparavant une taille de grille de 0,5 m, seuls 2,0 % des échantillons de l'ensemble de validation ont été classés à tort comme collisions. Cela démontre une fois de plus que les méthodes actuelles d’estimation des taux de collision ne sont pas suffisamment robustes et précises. Résumé de l'auteur : L'objectif principal de cet article est de présenter nos observations plutôt que de proposer un nouveau modèle. Bien que notre modèle fonctionne bien sur l'ensemble de données nuScenes, nous reconnaissons qu'il s'agit d'un jouet peu pratique qui ne peut pas être utilisé dans le monde réel. Conduire sans statut de véhicule autonome est un défi insurmontable. Néanmoins, nous espérons que nos connaissances stimuleront de nouvelles recherches dans ce domaine et permettront une réévaluation des progrès en matière de conduite autonome de bout en bout. Cet article est un examen approfondi de la récente évaluation de la conduite autonome de bout en bout sur l'ensemble de données nuScenes. Qu'il s'agisse d'une sortie directe implicite de bout en bout des signaux de planification ou d'une sortie explicite de bout en bout avec des liens intermédiaires, beaucoup d'entre eux sont des indicateurs de planification évalués sur l'ensemble de données nuScenes, et l'article de Baidu souligne que ce type d'évaluation n'est pas fiable. Ce type d'article est en fait assez intéressant. Il gifle en fait de nombreux collègues lorsqu'il est publié, mais il encourage également activement l'industrie à aller de l'avant. Peut-être qu'une planification de bout en bout n'est pas nécessaire (la prédiction de la perception l'est). de bout en bout), peut-être que tout le monde. Faire davantage de tests en boucle fermée (simulateur CARLA, etc.) lors de l'évaluation des performances peut mieux promouvoir les progrès de la communauté de la conduite autonome et mettre en œuvre le document dans les véhicules réels. Le chemin vers la conduite autonome a encore un long chemin à parcourir ~ Lien original : https://mp.weixin.qq.com/s/skNDMk4B1rtvJ_o2CM9f8w

4 Expériences du papier

4.1 Paramètres expérimentaux.

Métriques d'évaluation : utilisez le code d'évaluation de l'article ST-P3 (https://github.com/OpenPerceptionX/ST-P3/blob/main/stp3/metrics.py). Évaluez les traces de sortie pour des plages de temps de 1 s, 2 s et 3 s. Afin d'évaluer la qualité de la trajectoire prédite du véhicule autonome, deux indicateurs couramment utilisés sont calculés : 4.2 Résultats expérimentaux

4.3 Analyse expérimentale

5. Évaluation de l'article

Référence

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

J'ai essayé le codage d'ambiance avec Cursor Ai et c'est incroyable!

Mar 20, 2025 pm 03:34 PM

J'ai essayé le codage d'ambiance avec Cursor Ai et c'est incroyable!

Mar 20, 2025 pm 03:34 PM

Le codage des ambiances est de remodeler le monde du développement de logiciels en nous permettant de créer des applications en utilisant le langage naturel au lieu de lignes de code sans fin. Inspirée par des visionnaires comme Andrej Karpathy, cette approche innovante permet de dev

Top 5 Genai Lunets de février 2025: GPT-4.5, Grok-3 et plus!

Mar 22, 2025 am 10:58 AM

Top 5 Genai Lunets de février 2025: GPT-4.5, Grok-3 et plus!

Mar 22, 2025 am 10:58 AM

Février 2025 a été un autre mois qui change la donne pour une IA générative, nous apportant certaines des mises à niveau des modèles les plus attendues et de nouvelles fonctionnalités révolutionnaires. De Xai's Grok 3 et Anthropic's Claude 3.7 Sonnet, à Openai's G

Comment utiliser YOLO V12 pour la détection d'objets?

Mar 22, 2025 am 11:07 AM

Comment utiliser YOLO V12 pour la détection d'objets?

Mar 22, 2025 am 11:07 AM

Yolo (vous ne regardez qu'une seule fois) a été un cadre de détection d'objets en temps réel de premier plan, chaque itération améliorant les versions précédentes. La dernière version Yolo V12 introduit des progrès qui améliorent considérablement la précision

Chatgpt 4 o est-il disponible?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4 o est-il disponible?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4 est actuellement disponible et largement utilisé, démontrant des améliorations significatives dans la compréhension du contexte et la génération de réponses cohérentes par rapport à ses prédécesseurs comme Chatgpt 3.5. Les développements futurs peuvent inclure un interg plus personnalisé

Google & # 039; s Gencast: Prévision météorologique avec Mini démo Gencast

Mar 16, 2025 pm 01:46 PM

Google & # 039; s Gencast: Prévision météorologique avec Mini démo Gencast

Mar 16, 2025 pm 01:46 PM

Gencast de Google Deepmind: une IA révolutionnaire pour les prévisions météorologiques Les prévisions météorologiques ont subi une transformation spectaculaire, passant des observations rudimentaires aux prédictions sophistiquées alimentées par l'IA. Gencast de Google Deepmind, un terreau

Quelle IA est la meilleure que Chatgpt?

Mar 18, 2025 pm 06:05 PM

Quelle IA est la meilleure que Chatgpt?

Mar 18, 2025 pm 06:05 PM

L'article traite des modèles d'IA dépassant Chatgpt, comme Lamda, Llama et Grok, mettant en évidence leurs avantages en matière de précision, de compréhension et d'impact de l'industrie. (159 caractères)

O1 vs GPT-4O: le nouveau modèle Openai est-il meilleur que GPT-4O?

Mar 16, 2025 am 11:47 AM

O1 vs GPT-4O: le nouveau modèle Openai est-il meilleur que GPT-4O?

Mar 16, 2025 am 11:47 AM

O1'S O1: Une vague de cadeaux de 12 jours commence par leur modèle le plus puissant à ce jour L'arrivée de décembre apporte un ralentissement mondial, les flocons de neige dans certaines parties du monde, mais Openai ne fait que commencer. Sam Altman et son équipe lancent un cadeau de don de 12 jours

Meilleurs générateurs d'art AI (gratuit & amp; payé) pour des projets créatifs

Apr 02, 2025 pm 06:10 PM

Meilleurs générateurs d'art AI (gratuit & amp; payé) pour des projets créatifs

Apr 02, 2025 pm 06:10 PM

L'article passe en revue les meilleurs générateurs d'art AI, discutant de leurs fonctionnalités, de leur aptitude aux projets créatifs et de la valeur. Il met en évidence MidJourney comme la meilleure valeur pour les professionnels et recommande Dall-E 2 pour un art personnalisable de haute qualité.