Périphériques technologiques

Périphériques technologiques

Industrie informatique

Industrie informatique

IBM présente un prototype de transistor à nanofeuilles optimisé avec un refroidissement à l'azote liquide qui fait plus que doubler les performances par rapport à la température ambiante

IBM présente un prototype de transistor à nanofeuilles optimisé avec un refroidissement à l'azote liquide qui fait plus que doubler les performances par rapport à la température ambiante

IBM présente un prototype de transistor à nanofeuilles optimisé avec un refroidissement à l'azote liquide qui fait plus que doubler les performances par rapport à la température ambiante

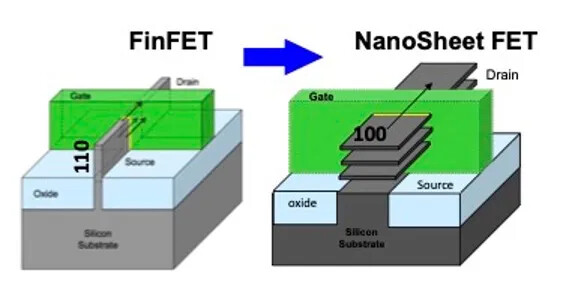

Lors du IEEE International Electronic Devices Meeting (IEDM) qui s'est tenu à San Francisco début décembre de cette année, les chercheurs d'IBM ont présenté le premier transistor CMOS avancé optimisé pour le refroidissement à l'azote liquide

Selon ce site, l'azote liquide bouillant Le point est très bas, seulement -196°C, ce qui est une température ultra-basse à laquelle les appareils électroniques grand public actuels ne peuvent pas résister. Cependant, dans un environnement aussi froid, la résistance et le courant de fuite du transistor sont considérablement réduits, améliorant ainsi les performances et réduisant la consommation d'énergie.

Le transistor nanofeuille développé par IBM utilise des canaux de silicium découpés en fines couches de nanofeuilles et une structure entièrement entourée de nanofeuilles. les portes permettent un contrôle plus efficace du champ électrique. Cette structure peut non seulement compresser 50 milliards de transistors dans une zone de la taille d'un ongle, mais aussi doubler étonnamment les performances sous refroidissement à l'azote liquide

Réécrire : Les environnements à basse température offrent deux avantages principaux : une diffusion réduite des porteurs de charge et une consommation d'énergie réduite. Une diffusion réduite signifie une résistance réduite, ce qui améliore la capacité des électrons à se déplacer dans l'appareil ; une consommation d'énergie réduite permet à l'appareil de générer un courant plus important à la même tension. De plus, le refroidissement à l'azote liquide peut également améliorer la sensibilité marche/arrêt du transistor, ne nécessitant que de plus petits changements de tension pour commuter les états, réduisant ainsi encore la consommation d'énergie.

Cependant, les basses températures apportent également de nouveaux défis : une tension de seuil accrue. La tension de seuil, la tension nécessaire pour activer un transistor, augmente à mesure que la température baisse, ce qui rend plus difficile la commutation de l'appareil. Il est difficile de réduire la tension de seuil avec les processus traditionnels, c'est pourquoi les chercheurs d'IBM ont utilisé une nouvelle technologie à double grille métallique et double dipôle. Ils ajoutent différentes impuretés métalliques à l'interface des transistors de type N et P pour former des dipôles, réduisant ainsi l'énergie nécessaire aux électrons pour traverser le bord de la bande de conduction et rendant les transistors plus efficaces

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Adoptez l'IA et licenciez 8 000 personnes ! Le « plan d'expansion de Guangzhou » du géant centenaire IBM a commencé

Mar 18, 2024 am 09:40 AM

Adoptez l'IA et licenciez 8 000 personnes ! Le « plan d'expansion de Guangzhou » du géant centenaire IBM a commencé

Mar 18, 2024 am 09:40 AM

IBM a soudainement annoncé une nouvelle vague de licenciements ! Le directeur des communications d'IBM a annoncé la nouvelle lors de la dernière réunion du personnel de sept minutes. Cette fois, il se concentrera principalement sur les départements marketing et communication. Bien qu'IBM n'ait pas publié de déclaration officielle sur l'ampleur des licenciements, pas plus tard qu'en janvier de cette année, ils ont annoncé qu'ils licencieraient 3 400 personnes. Le PDG de l'entreprise, Arvind Krishna, a déclaré plus tôt que l'entreprise remplacerait 8 000 emplois par l'intelligence artificielle au cours des cinq prochaines années. Toute cette opération soudaine a directement dérouté les employés... Ces 8 000 personnes ont-elles commencé à licencier des employés il y a longtemps△Source : One Acre Three Points Selon les statistiques des sites Web pertinents, environ 204 entreprises technologiques ont licencié des employés jusqu'à présent cette année. Près de 50 000 personnes. Y compris la société mère de Google, Alphabet, Amazon

IBM dévoile sa dernière suite d'outils pour déplacer le développement de l'intelligence artificielle de nouvelle génération vers les plates-formes mainframe

Sep 28, 2023 pm 07:37 PM

IBM dévoile sa dernière suite d'outils pour déplacer le développement de l'intelligence artificielle de nouvelle génération vers les plates-formes mainframe

Sep 28, 2023 pm 07:37 PM

IBM a récemment annoncé un nouvel ensemble de produits qui s'appuient sur les capacités de codage d'IA générative récemment lancées pour les développeurs mainframe afin de faciliter l'exécution de l'intelligence artificielle sur leur ancien matériel de centre de données. IBM a déclaré dans une mise à jour d'IBMZ qu'il était conçu pour aider les clients à améliorer leurs résultats commerciaux. en mettant en œuvre l'IA d'entreprise dans plusieurs secteurs et cas d'utilisation, il comprend un nouvel ensemble de kits d'outils de développement prenant en charge les cadres d'IA et le langage de programmation Python les plus largement utilisés, des améliorations du Machine Learning forz/OS et des améliorations des performances du système d'exploitation mainframe IBMz/OS. . IBM a déclaré que ces mises à jour permettront à ses clients d'améliorer l'exactitude des conseils politiques, d'améliorer la fiabilité et la rapidité des contrôles anti-blanchiment d'argent et de réduire

IBM lance l'assistant de programmation IA 'watsonx', dédié à pallier la pénurie de programmeurs COBOL

Oct 31, 2023 pm 02:13 PM

IBM lance l'assistant de programmation IA 'watsonx', dédié à pallier la pénurie de programmeurs COBOL

Oct 31, 2023 pm 02:13 PM

IT House a rapporté le 31 octobre qu'IBM avait récemment publié un communiqué de presse indiquant que, afin de pallier la pénurie actuelle de programmeurs maîtrisant COBOL (un langage de programmation conçu et développé en 1959), elle avait lancé l'assistant de programmation génératif d'IA « watsonx ». IBM a lancé un service appelé « IBMZ » en août de cette année, visant à convertir le COBOL en langage Java. Récemment, le service a été officiellement lancé sous le nom de « Watsonx ». Les fonctions principales de Watsonx simplifient la conversion du code COBOL en Java et sont conçues pour moderniser les grands ordinateurs. IBM a déclaré que l'assistant d'intelligence artificielle est extrêmement précis dans la traduction du code et peut réduire

IBM lance un fonds de capital-risque d'intelligence artificielle d'entreprise de 500 millions de dollars pour soutenir les startups

Nov 17, 2023 pm 03:54 PM

IBM lance un fonds de capital-risque d'intelligence artificielle d'entreprise de 500 millions de dollars pour soutenir les startups

Nov 17, 2023 pm 03:54 PM

IBM a récemment lancé un nouveau véhicule d'investissement d'entreprise, l'Enterprise Artificial Intelligence Venture Fund. Le fonds vise à soutenir les startups travaillant au développement de produits d'IA destinés aux entreprises. La décision d'IBM intervient alors que d'autres géants de la technologie augmentent également leurs investissements dans l'écosystème des startups d'IA. Il y a quelques semaines, AnthropicPBC, un important développeur de modèles de langage, a reçu un financement total pouvant atteindre 6 milliards de dollars d'Amazon et de Google. Récemment, Hewlett Packard Enterprise et SAPSE ont investi plus de 500 millions de dollars dans le fournisseur allemand d'intelligence artificielle AlephAlpha GmbH. IBM a l'intention de soutenir un certain nombre de startups « du stade précoce jusqu'à l'hyper-croissance » via son Enterprise Artificial Intelligence Venture Fund. Selon les médias, je

que veut dire IBM

Feb 08, 2021 pm 03:34 PM

que veut dire IBM

Feb 08, 2021 pm 03:34 PM

Le nom anglais complet d'IBM est « International Business Machines Corporation », qui fait référence à International Business Machines Corporation ou International Business Machines Corporation, dont le siège social est à Armonk, New York.

Rapport 2023 sur les brevets de semi-conducteurs : Samsung est loin devant, suivi par IBM, Qualcomm et TSMC

Jan 27, 2024 pm 01:03 PM

Rapport 2023 sur les brevets de semi-conducteurs : Samsung est loin devant, suivi par IBM, Qualcomm et TSMC

Jan 27, 2024 pm 01:03 PM

Selon une analyse statistique basée sur des données publiques de la société de gestion de propriété intellectuelle Anaqua, la région avec le plus grand nombre de brevets de semi-conducteurs au monde en 2023 sera les États-Unis. C’est la deuxième année consécutive que les États-Unis arrivent en tête de liste. La société utilise le logiciel avancé d'analyse des brevets AcclaimIP pour analyser les brevets liés aux semi-conducteurs publiés par l'Office américain des marques et des brevets. Les résultats montrent que le nombre de brevets de semi-conducteurs en 2023 a atteint 348 774, soit une légère augmentation par rapport aux 347 408 de 2022. Selon les pays et les régions, le nombre de brevets obtenus par les entreprises américaines s'élève à 162 557, ce qui le place au premier rang parmi tous les pays, soit une augmentation de 18 % par rapport à 2022. Les données montrent que le Japon arrive en deuxième position (40 960 cas), suivi de la Chine (2

IBM publie le modèle Granite AI pour la communauté open source

Jun 02, 2024 pm 01:46 PM

IBM publie le modèle Granite AI pour la communauté open source

Jun 02, 2024 pm 01:46 PM

IBM Research a récemment annoncé que son modèle de base de codage Granite était open source, dans le but de démocratiser les outils d'IA avancés et de promouvoir des changements complets dans la manière dont le code est écrit, maintenu et développé dans tous les secteurs. Cette décision permettra aux développeurs de créer, d'optimiser et de déployer des modèles d'IA plus efficacement, accélérant ainsi l'application de la technologie de l'intelligence artificielle. Granite est un outil de programmation d'IA avancé développé par IBM Research Institute avec des fonctions puissantes. À quel niveau est-il basé sur le modèle de codage IBM Granite standard ouvert ? Granite est né de l'ambition d'IBM de simplifier le processus de codage. Après avoir pris conscience de la complexité et des exigences de développement rapide inhérentes au développement de logiciels, IBM a utilisé ses solides capacités de recherche scientifique pour créer un ensemble d'outils basés sur l'IA destinés à

IBM développe le supercalculateur d'IA cloud natif Vela pour déployer et former de manière flexible des dizaines de milliards de modèles de paramètres

Apr 14, 2023 pm 01:46 PM

IBM développe le supercalculateur d'IA cloud natif Vela pour déployer et former de manière flexible des dizaines de milliards de modèles de paramètres

Apr 14, 2023 pm 01:46 PM

ChatGPT est populaire sur Internet et la formation sur le modèle d'IA qui la sous-tend a également attiré une large attention. IBM Research a récemment annoncé que le supercalculateur cloud natif Vela qu'il a développé pouvait être rapidement déployé et utilisé pour former des modèles d'IA de base. Depuis mai 2022, des dizaines de chercheurs de l’entreprise utilisent ce supercalculateur pour entraîner des modèles d’IA comportant des dizaines de milliards de paramètres. Les modèles de base sont des modèles d'IA entraînés sur de grandes quantités de données non étiquetées, et leur polyvalence signifie qu'ils peuvent être utilisés pour une gamme de tâches différentes avec juste un réglage fin. Leur ampleur est énorme et nécessite une puissance de calcul massive et coûteuse. Par conséquent, comme le disent les experts, la puissance de calcul deviendra le plus gros goulot d'étranglement dans le développement de la prochaine génération de modèles de base à grande échelle, et leur formation nécessitera beaucoup de puissance de calcul et de temps. Formation disponible