Périphériques technologiques

Périphériques technologiques

IA

IA

Brisez la barrière de l'information ! Un outil de visualisation 3D à grande échelle choquant est sorti !

Brisez la barrière de l'information ! Un outil de visualisation 3D à grande échelle choquant est sorti !

Brisez la barrière de l'information ! Un outil de visualisation 3D à grande échelle choquant est sorti !

Récemment, un Néo-Zélandais, Brendan Bycroft, a créé un engouement dans le cercle technologique. Un projet qu'il a créé, appelé Large Model 3D Visualization, est non seulement en tête de liste de Hacker News, mais son effet choquant est encore plus époustouflant. Grâce à ce projet, vous comprendrez parfaitement comment fonctionne le LLM (Large Language Model) en quelques secondes seulement.

Que vous soyez passionné de technologie ou non, ce projet vous apportera un festin visuel et un éclairage cognitif sans précédent. Explorons ensemble cette superbe création !

Introduction

Dans ce projet, Bycroft a analysé en détail un modèle GPT léger appelé Nano-GPT développé par le scientifique OpenAI Andrej Karpathy. En tant que version réduite du modèle GPT, le modèle ne comporte que 85 000 paramètres. Bien entendu, bien que ce modèle soit beaucoup plus petit que le GPT-3 ou le GPT-4 d'OpenAI, on peut dire qu'« un moineau est petit mais possède tous les organes internes ».

Nano-GPT GitHub : https://github.com/karpathy/nanoGPT

Afin de faciliter la démonstration de chaque couche du modèle Transformer, Bycroft a organisé une tâche cible très simple pour le modèle Nano-GPT : le modèle l'entrée est de 6 lettres "CBABBC", la sortie est une séquence classée par ordre alphabétique, par exemple, la sortie "ABBBCC".

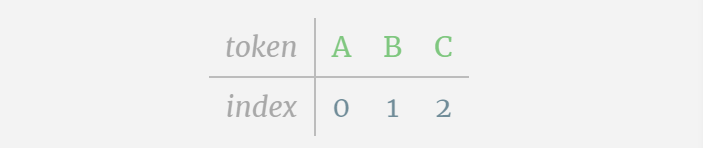

Nous appelons chaque lettre un jeton, et ces différentes lettres constituent le vocabulaire du vocabulaire :

Pour cela Pour un tableau, chaque lettre se voit attribuer un index de jeton d'indice. La séquence composée de ces indices peut être utilisée comme entrée du modèle : 2 1 0 1 1 2

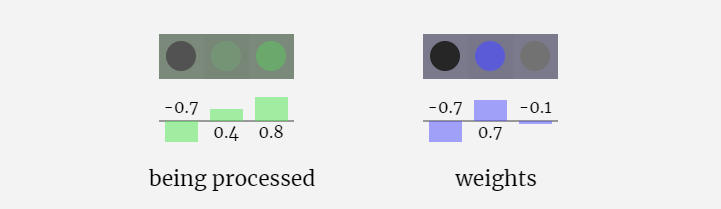

Dans la visualisation 3D, chaque cellule verte représente un nombre calculé, tandis que chaque cellule bleue représente le poids du modèle .

Dans le traitement de séquence, chaque nombre est d'abord converti en un vecteur de dimension C. Ce processus est appelé intégration. Dans Nano-GPT, la dimension de cette intégration est généralement de 48 dimensions. Grâce à cette opération d'intégration, chaque nombre est représenté sous forme de vecteur dans un espace à dimensions C, ce qui permet un meilleur traitement et analyse ultérieurs.

l'intégration est calculée à travers une série de couches de modèle intermédiaires, généralement appelées Transformers, et atteint finalement la couche inférieure.

"Alors, quelle est la sortie ?"

La sortie du modèle est le jeton suivant de la séquence. Donc à la fin, nous obtenons la valeur de probabilité que le prochain jeton soit A B C.

Dans cet exemple, le modèle de 6ème position génère A avec une forte probabilité. Nous pouvons maintenant transmettre A comme entrée au modèle et répéter tout le processus.

Les visualisations GPT-2 et GPT-3 sont également affichées.

- GPT-3 possède 175 milliards de paramètres et la couche modèle comporte 8 colonnes, couvrant densément tout l'écran.

- Différentes versions de paramètres du modèle GPT-2 montrent d'énormes différences architecturales. Nous prenons ici comme exemples les 15 milliards de paramètres de GPT-2 (XL) et les 124 millions de paramètres de GPT-2 (Small).

Il convient de noter que cette visualisation se concentre principalement sur l'inférence de modèle (inférence), et non sur la formation, ce n'est donc qu'une petite partie de l'ensemble du processus d'apprentissage automatique. De plus, on suppose ici que les poids du modèle ont été pré-entraînés, puis l'inférence du modèle est utilisée pour générer la sortie.

Intégration

Comme mentionné précédemment, comment utiliser une simple table de recherche pour mapper des jetons à une série d'entiers.

Ces entiers, l'index symbolique, sont la première et la seule fois où nous voyons des entiers dans le modèle. Après cela, les opérations seront effectuées à l'aide de nombres à virgule flottante (nombres décimaux).

Ici, prenons le 4ème jeton (index 3) comme exemple pour voir comment il est utilisé pour générer le 4ème vecteur colonne de l'intégration d'entrée.

Utilisez d'abord l'index de jeton (ici, prenez B=1 comme exemple) pour sélectionner la deuxième colonne de la matrice d'incorporation de jetons et obtenez un vecteur de colonne de taille C=48 (48 dimensions), appelé intégration de jetons. .

Sélectionnez ensuite la quatrième colonne de la matrice d'intégration de position ("Parce qu'ici nous regardons principalement le (t = 3) jeton B à la 4ème position"), de même, nous obtenons une taille de C=48 (48 dimensions) Vecteur de colonne, appelé intégration de position.

Il convient de noter que les intégrations de positions et les intégrations de jetons sont toutes deux obtenues par formation de modèle (indiquées en bleu). Maintenant que nous avons ces deux vecteurs, en les additionnant nous pouvons obtenir un nouveau vecteur colonne de taille C=48.

Ensuite, traitez tous les jetons de la séquence dans le même processus, en créant un ensemble de vecteurs contenant les valeurs des jetons et leurs positions.

Comme le montre la figure ci-dessus, l'exécution de ce processus sur tous les jetons de la séquence d'entrée produira une matrice de taille TxC. Parmi eux, T représente la longueur de la séquence. C signifie canal, mais est également appelé fonctionnalité ou dimension ou taille d'intégration, qui dans ce cas est 48. Cette longueur C est l'un des nombreux « hyperparamètres » du modèle, choisis par le concepteur pour fournir un compromis entre la taille du modèle et les performances.

Cette matrice de dimension TxC est l'intégration d'entrée et est transmise à travers le modèle.

Petite Astuce : N'hésitez pas à passer votre souris sur une seule cellule de l'intégration d'entrée pour voir le calcul et sa source.

Norme de couche

La matrice d'intégration d'entrée obtenue précédemment est l'entrée de la couche Transformer.

La première étape de la couche Transformer consiste à effectuer une normalisation de couche sur la matrice d'intégration d'entrée. Il s'agit d'une opération permettant de normaliser les valeurs de chaque colonne de la matrice d'entrée.

La normalisation est une étape importante dans la formation approfondie des réseaux neuronaux, qui contribue à améliorer la stabilité du modèle pendant le processus de formation.

Nous pouvons regarder les colonnes de la matrice séparément. La quatrième colonne est prise comme exemple ci-dessous.

Le but de la normalisation est de faire en sorte que la valeur de chaque colonne ait une moyenne de 0 et un écart type de 1. Pour y parvenir, calculez la moyenne et l’écart type de chaque colonne, puis soustrayez la moyenne correspondante et divisez par l’écart type correspondant pour chaque colonne.

Ici, E[x] est utilisé pour représenter la moyenne, et Var[x] est utilisé pour représenter la variance (le carré de l'écart type). epsilon(ε = 1×10^-5) sert à empêcher les erreurs de division par 0.

Calculez et stockez le résultat normalisé, puis multipliez-le par le poids d'apprentissage (γ) et ajoutez le biais (β) pour obtenir le résultat final normalisé.

Enfin, effectuez l'opération de normalisation sur chaque colonne de la matrice d'intégration d'entrée pour obtenir l'intégration d'entrée normalisée et transmettez-la à la couche d'auto-attention (auto-attention).

Self Attention

La couche Self Attention est probablement la partie centrale du Transformer. À ce stade, les colonnes de l'intégration d'entrée peuvent "communiquer" entre elles, tandis qu'à d'autres étapes, chaque colonne existe indépendamment.

La couche Self Attention se compose de plusieurs têtes d’auto-attention. Dans cet exemple, il y a trois têtes d’auto-attention. L'entrée de chaque en-tête représente 1/3 de l'intégration d'entrée, et nous nous concentrons uniquement sur l'un d'entre eux maintenant.

La première étape consiste à générer 3 vecteurs pour chaque colonne à partir de la colonne C de la matrice d'intégration d'entrée normalisée, qui sont QKV :

- Q : vecteur de requête

- K : vecteur clé Vecteur clé

- V : valeur vecteur Vecteur de valeur

Pour générer ces vecteurs, une multiplication matrice-vecteur est utilisée, plus un biais. Chaque unité de sortie est une combinaison linéaire de vecteurs d'entrée.

Par exemple, pour le vecteur de requête, il est complété par l'opération de produit scalaire entre une ligne de la matrice de poids Q et une colonne de la matrice d'entrée.

Le fonctionnement du produit scalaire est très simple, il suffit de multiplier les éléments correspondants puis de les ajouter.

Il s'agit d'un moyen général et simple de garantir que chaque élément de sortie est affecté par tous les éléments du vecteur d'entrée (cette influence est déterminée par le poids). C’est pourquoi il apparaît souvent dans les réseaux de neurones.

Dans les réseaux de neurones, ce mécanisme se produit souvent car il permet au modèle de prendre en compte chaque partie de la séquence d'entrée lors du traitement des données. Ce mécanisme d’attention complet est au cœur de nombreuses architectures de réseaux neuronaux modernes, en particulier lors du traitement de données séquentielles telles que du texte ou des séries chronologiques.

Nous répétons cela pour chaque unité de sortie dans les vecteurs Q, K, V :

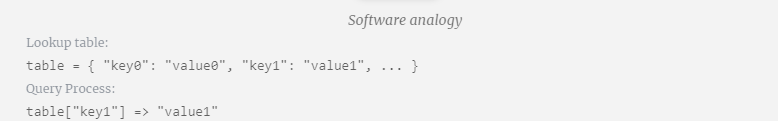

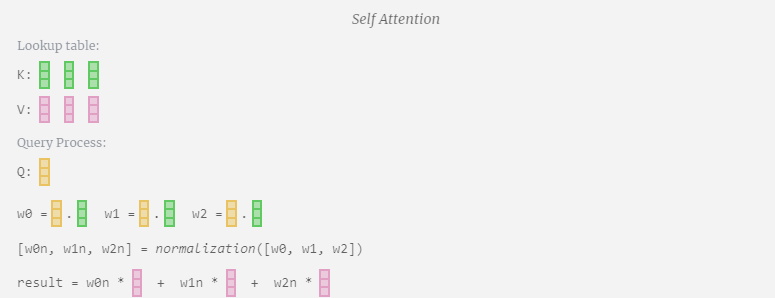

Comment utilisons-nous nos vecteurs Q (requête), K (clé) et V (valeur) ? Leur dénomination nous donne un indice : « clé » et « valeur » rappellent les types de dictionnaires, avec des clés mappées sur des valeurs. Ensuite, « requête » est ce que nous utilisons pour trouver la valeur.

Dans le cas de Self Attention, au lieu de renvoyer un seul vecteur (terme), nous renvoyons une combinaison pondérée de vecteurs (termes). Pour trouver ce poids, nous calculons le produit scalaire entre un vecteur Q et chaque vecteur K, le pondérons et le normalisons, et enfin le multiplions par le vecteur V correspondant et les additionnons.

En prenant comme exemple la 6ème colonne (t=5), la requête partira de cette colonne :

Du fait de l'existence d'une matrice d'attention, les 6 premières colonnes de KV peuvent être interrogées, et la valeur Q est l’heure actuelle.

Calculez d'abord le produit scalaire entre le vecteur Q de la colonne actuelle (t=5) et le vecteur K des colonnes précédentes (les 6 premières colonnes). Ceci est ensuite stocké dans la ligne correspondante (t=5) de la matrice d'attention.

La taille du produit scalaire mesure la similarité entre deux vecteurs. Plus le produit scalaire est grand, plus ils sont similaires.

Et seul le vecteur Q fonctionne avec le vecteur K passé, ce qui en fait une auto-attention causale. En d’autres termes, les jetons ne peuvent pas « voir les informations futures ».

Ainsi, après avoir trouvé le produit scalaire, divisez par sqrt(A), où A est la longueur du vecteur QKV, cette mise à l'échelle est effectuée pour empêcher de grandes valeurs de dominer la prochaine étape de normalisation (softmax).

Ensuite, l'opération softmax est effectuée pour réduire la plage de valeurs de 0 à 1.

Enfin, le vecteur de sortie de cette colonne (t=5) peut être obtenu. Regardez la ligne (t=5) de la matrice d'attention normalisée et multipliez chaque élément par le vecteur V correspondant de l'autre colonne.

Nous pouvons ensuite ajouter ces vecteurs pour obtenir le vecteur de sortie. Par conséquent, le vecteur de sortie sera dominé par le vecteur V à haute résolution.

Maintenant, nous l'appliquons à toutes les colonnes.

Il s'agit du processus de traitement d'un en-tête dans la couche Self Attention. "Ainsi, l'objectif principal de Self Attention est que chaque colonne souhaite trouver des informations pertinentes dans d'autres colonnes et en extraire sa valeur, et elle le fait en comparant son vecteur de requête avec les clés de ces autres colonnes. La limitation supplémentaire est qu'elle ne peut que regarder vers le passé. "

Projection

Après l'opération Self Attention, nous obtiendrons une sortie de chaque tête. Ces sorties sont des vecteurs V qui sont mélangés de manière appropriée, influencés par les vecteurs Q et K. Pour fusionner les vecteurs de sortie de chaque tête, nous les empilons simplement. Par conséquent, à t=4, nous superposerons 3 vecteurs de longueur A=16 pour former 1 vecteur de longueur C=48.

Il est à noter qu'en GPT, la longueur du vecteur à l'intérieur de la tête (A=16) est égale à C/num_heads. Cela garantit que lorsque nous les empilons ensemble, nous obtenons la longueur d'origine C.

Sur cette base, nous effectuons une projection et obtenons la sortie de cette couche. Il s'agit d'une simple multiplication matrice-vecteur, par colonne, plus un biais.

Nous avons maintenant la sortie de Self Attention.

Au lieu de transmettre cette sortie directement à l'étape suivante, nous l'ajoutons en tant qu'élément à l'intégration d'entrée. Ce processus, représenté par la flèche verticale verte, est appelé connexion résiduelle ou voie résiduelle.

Comme la normalisation des couches, les réseaux résiduels sont cruciaux pour parvenir à un apprentissage efficace des réseaux de neurones profonds.

Maintenant que nous avons le résultat de l'auto-attention, nous pouvons le transmettre à la couche suivante de Transformer : le réseau feedforward.

Multilayer Perceptron MLP

Après Self Attention, la partie suivante du module Transformer est MLP (Multilayer Perceptron), ici il s'agit d'un simple réseau de neurones à deux couches.

Comme pour Self Attention, avant que le vecteur n'entre dans le MLP, nous devons effectuer une normalisation des couches.

En même temps, dans MLP, le traitement suivant doit être effectué (indépendamment) pour chaque vecteur colonne de longueur C=48 :

- Ajouter une transformation linéaire avec biais (c'est-à-dire une multiplication matrice-vecteur plus une opération de biais) , converti en un vecteur de longueur 4 * C.

- Fonction d'activation GELU (appliquée par élément).

- Effectuez une transformation linéaire avec biais, puis retransformez-la en un vecteur de longueur C.

Traçons l'un des vecteurs :

Le processus MLP est le suivant :

Effectuez d'abord la multiplication matrice-vecteur et ajoutez des décalages pour développer le vecteur en une matrice de longueur 4*C. (Notez que la matrice de sortie ici est transposée pour la visualisation)

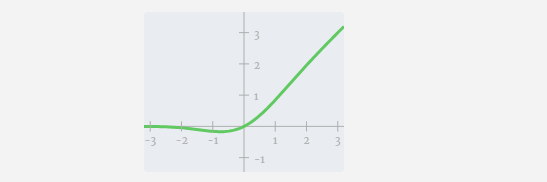

Ensuite, appliquez la fonction d'activation GELU à chaque élément du vecteur. Il s'agit d'un élément clé de tout réseau de neurones, nous devons introduire une certaine non-linéarité dans le modèle. La fonction spécifique utilisée, GELU, ressemble beaucoup à la fonction ReLU max(0, x), mais elle a une courbe douce au lieu de coins pointus.

Ensuite, projetez le vecteur à la longueur C via une autre multiplication matrice-vecteur biaisée.

Il y a aussi un réseau résiduel ici Comme pour la partie auto-attention + projection, nous ajoutons les résultats du MLP à l'entrée dans l'ordre des éléments.

Répétez ces opérations.

C'est la fin de la couche MLP, et on obtient enfin la sortie du transformateur.

Transformer

Il s'agit d'un module Transformer complet !

Ces plusieurs modules forment le corps principal de tout modèle GPT, et la sortie de chaque module est l'entrée du module suivant.

Comme c'est souvent le cas dans l'apprentissage profond, il est difficile de dire exactement ce que fait chacune de ces couches, mais nous avons quelques idées générales : les couches antérieures ont tendance à se concentrer sur l'apprentissage de fonctionnalités et de modèles de bas niveau, tandis que les couches ultérieures reconnaissent et comprennent les niveaux supérieurs. abstractions et relations au niveau supérieur. Dans le contexte du traitement du langage naturel, les couches inférieures peuvent apprendre la grammaire, la syntaxe et les associations lexicales simples, tandis que les couches supérieures peuvent capturer des relations sémantiques, des structures de discours et des significations dépendant du contexte plus complexes.

Softmax

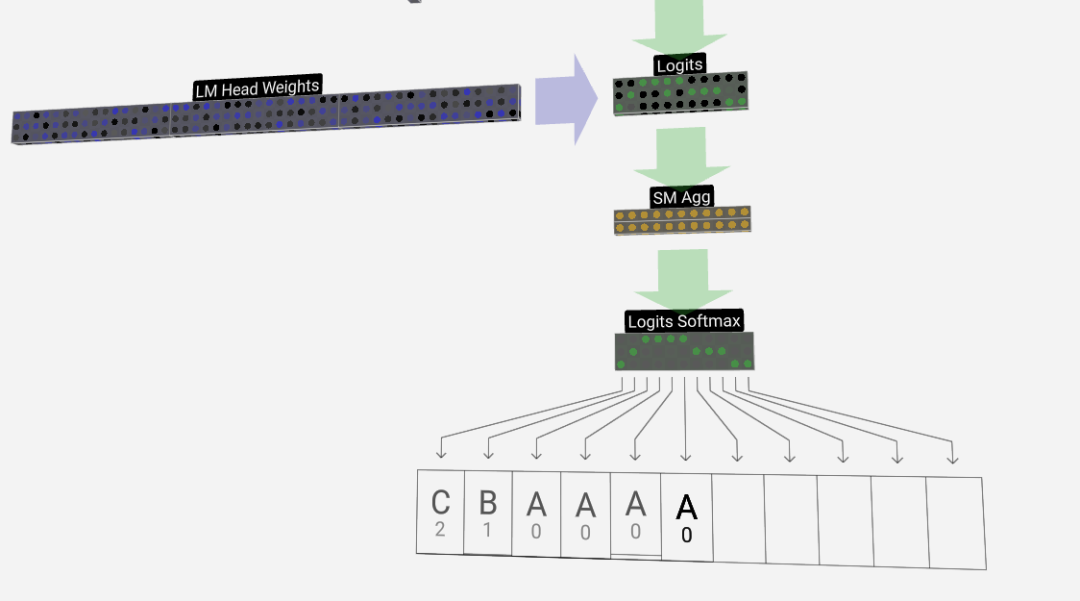

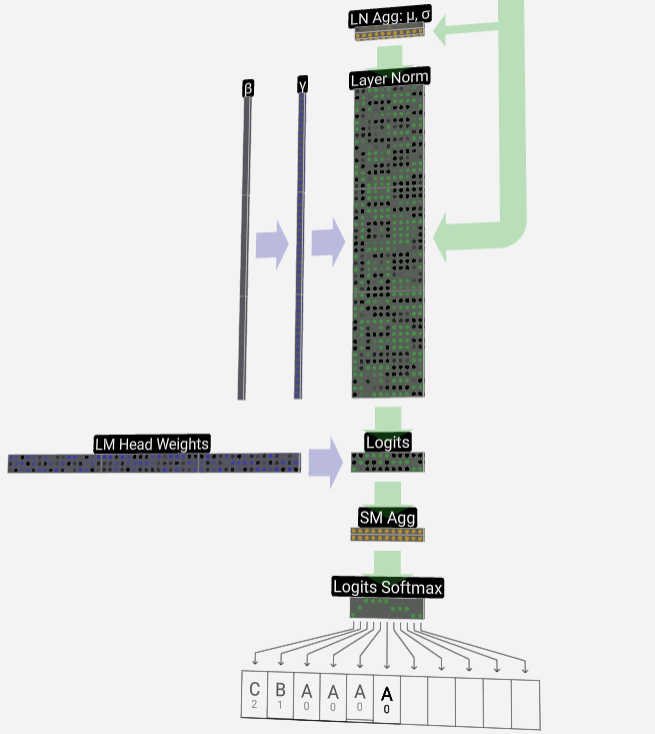

La dernière étape est l'opération softmax, qui génère la probabilité prédite de chaque jeton.

Sortie

Enfin, nous arrivons à la fin du modèle. La sortie du dernier Transformer subit une couche de régularisation, suivie d'une transformation linéaire impartiale.

Cette transformation finale convertit chacun de nos vecteurs colonnes de la longueur C en nvocab de longueur de la taille d'un vocabulaire. Il génère donc en fait un score logits pour chaque mot du vocabulaire.

Afin de convertir ces scores en valeurs de probabilité plus intuitives, ils doivent d'abord être traités via softmax. Ainsi, pour chaque colonne, nous obtenons la probabilité que le modèle attribue à chaque mot du vocabulaire.

Dans ce modèle particulier, il a en fait appris toutes les réponses sur la façon d'ordonner les trois lettres, de sorte que les probabilités penchent fortement vers la bonne réponse.

Lorsque nous laissons le modèle avancer dans le temps, nous devons utiliser la probabilité de la dernière colonne pour décider du prochain jeton ajouté dans la séquence. Par exemple, si nous saisissons six jetons dans le modèle, nous utiliserons les probabilités de sortie de la colonne six.

Le résultat de cette colonne est une série de valeurs de probabilité, et nous devons en fait sélectionner l'une d'entre elles comme prochain jeton de la séquence. Nous y parvenons en « échantillonnant à partir de la distribution », c'est-à-dire en sélectionnant au hasard un jeton en fonction de sa probabilité. Par exemple, un jeton avec une probabilité de 0,9 a une probabilité de 90 % d'être sélectionné. Cependant, nous avons également d’autres options, comme par exemple toujours choisir le jeton ayant la probabilité la plus élevée.

On peut également contrôler la « douceur » de la distribution en utilisant le paramètre température. Des températures plus élevées rendront la distribution plus uniforme, tandis que des températures plus basses la concentreront davantage sur les jetons ayant la probabilité la plus élevée.

Nous ajustons les logits (la sortie de la transformation linéaire) en utilisant le paramètre de température avant d'appliquer softmax, car l'exponentiation dans softmax a un effet amplificateur significatif sur les valeurs plus grandes, et rapprocher toutes les valeurs réduira cet effet.

Photos

Photos

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Rexas Finance (RXS) peut dépasser Solana (Sol), Cardano (ADA), XRP et Dogecoin (DOGE) en 2025

Apr 21, 2025 pm 02:30 PM

Rexas Finance (RXS) peut dépasser Solana (Sol), Cardano (ADA), XRP et Dogecoin (DOGE) en 2025

Apr 21, 2025 pm 02:30 PM

Sur le marché volatil des crypto-monnaies, les investisseurs recherchent des alternatives qui vont au-delà des devises populaires. Bien que les crypto-monnaies bien connues telles que Solana (Sol), Cardano (ADA), XRP et Dogecoin (DOGE) sont également confrontées à des défis tels que le sentiment du marché, l'incertitude réglementaire et l'évolutivité. Cependant, un nouveau projet émergent, la rexasfinance (RXS), est en émergence. Il ne s'appuie pas sur les effets de célébrités ou le battage médiatique, mais se concentre sur la combinaison des actifs du monde réel (RWA) avec la technologie de la blockchain pour offrir aux investisseurs une façon innovante d'investir. Cette stratégie le fait espérer être l'un des projets les plus réussis de 2025. Rexasfi

Global Asset lance un nouveau système de trading intelligent axé sur l'IA pour améliorer l'efficacité du trading mondial

Apr 20, 2025 pm 09:06 PM

Global Asset lance un nouveau système de trading intelligent axé sur l'IA pour améliorer l'efficacité du trading mondial

Apr 20, 2025 pm 09:06 PM

Global Assets lance un nouveau système de trading intelligent d'IA pour diriger la nouvelle ère de l'efficacité des échanges! La plate-forme de trading complète bien connue Global Assets a officiellement lancé son système de trading intelligent AI, visant à utiliser l'innovation technologique pour améliorer l'efficacité commerciale mondiale, optimiser l'expérience utilisateur et contribuer à la construction d'une plate-forme de trading mondiale sûre et fiable. Cette décision marque une étape clé pour les actifs mondiaux dans le domaine de la finance intelligente, consolidant davantage son leadership mondial du marché. Ouverture d'une nouvelle ère de négociation intelligente axée sur la technologie et ouverte. Dans le contexte du développement approfondi de la numérisation et de l'intelligence, la dépendance du marché commercial à l'égard de la technologie augmente. Le système de trading intelligent AI lancé par Global Assets intègre des technologies de pointe telles que l'analyse des mégadonnées, l'apprentissage automatique et la blockchain, et s'engage à fournir aux utilisateurs des services de trading intelligents et automatisés pour réduire efficacement les facteurs humains.

Pourquoi la hausse ou la baisse des prix de monnaie virtuelle? Pourquoi la hausse ou la baisse des prix de monnaie virtuelle?

Apr 21, 2025 am 08:57 AM

Pourquoi la hausse ou la baisse des prix de monnaie virtuelle? Pourquoi la hausse ou la baisse des prix de monnaie virtuelle?

Apr 21, 2025 am 08:57 AM

Les facteurs de la hausse des prix des devises virtuels comprennent: 1. Une augmentation de la demande du marché, 2. Daisser l'offre, 3. Stimulé de nouvelles positives, 4. Sentiment du marché optimiste, 5. Environnement macroéconomique; Les facteurs de déclin comprennent: 1. Daissement de la demande du marché, 2. AUGMENT DE L'OFFICATION, 3. Strike of Negative News, 4. Pespimiste Market Sentiment, 5. Environnement macroéconomique.

Le marché mondial des jetons unkillable a commencé la nouvelle lune en avril 2025 sain et fort

Apr 20, 2025 pm 06:21 PM

Le marché mondial des jetons unkillable a commencé la nouvelle lune en avril 2025 sain et fort

Apr 20, 2025 pm 06:21 PM

Defidungeons, une série NFT dans un jeu de RPG de placement fantastique propulsé par la blockchain Solana, a montré de solides performances sur le marché début avril 2025. Le marché mondial de la NFT a commencé fortement en avril après des semaines de croissance du volume commercial. Au cours des dernières 24 heures, le volume total des transactions NFT a atteint 14 millions de dollars US, le volume de négociation en flèche de 46% par rapport à la veille. Voici la série NFT la plus chaude de la première semaine d'avril: Defidungeonsnft Series: Ce jeu RPG de placement fantastique NFT sur la blockchain Solana est devenu la série NFT la plus vendue au cours de la première semaine d'avril. Au cours des dernières 24 heures, le volume des transactions a atteint 1,5 million de dollars américains, avec une valeur marchande totale de plus de 5 millions de dollars américains.

La liste des licences de conformité pour les dix premiers échanges de blockchain. Quelles sont les plateformes de sélection de supervision stricte?

Apr 21, 2025 am 08:12 AM

La liste des licences de conformité pour les dix premiers échanges de blockchain. Quelles sont les plateformes de sélection de supervision stricte?

Apr 21, 2025 am 08:12 AM

Binance, Okx, Coinbase, Kraken, Huobi, Gate.io, Gemini, Xbit, Bitget et Mexc sont toutes des plateformes strictement sélectionnées pour la sélection réglementaire. 1. Binance s'adapte à la supervision en créant une sous-plate-forme de conformité. 2. OKX renforce la gestion de la conformité grâce à la vérification KYB. 3.Coinbase est connu pour sa conformité et sa convivialité. 4.Kraken fournit de puissantes mesures KYC et anti-blanchiment d'argent. 5. Huobi opère conformément au marché asiatique. 6.gate.io se concentre sur la sécurité et la conformité des transactions. 7. Gemini se concentre sur la sécurité et la transparence. 8.xbit est un modèle de conformité de transaction décentralisée. 9.Bitget continue de travailler dans les opérations de conformité. 10.Mexc a réussi

Suivez le rythme de Coinjie.com: Quelle est la perspective d'investissement de la finance cryptographique et des affaires AAAS

Apr 21, 2025 am 10:42 AM

Suivez le rythme de Coinjie.com: Quelle est la perspective d'investissement de la finance cryptographique et des affaires AAAS

Apr 21, 2025 am 10:42 AM

Les perspectives d'investissement des entreprises de financement cryptographique et AAAS sont analysées comme suit: 1. Les opportunités de financement cryptographique comprennent la croissance de la taille du marché, la réglementation claire progressive et l'expansion des scénarios d'application, mais les défis de la volatilité du marché et de la sécurité technique sont confrontés. 2. Les opportunités des activités AAAS résident dans la promotion de l'innovation technologique, de l'exploration de données et des scénarios d'applications riches, mais les défis incluent la complexité technique et l'acceptation du marché.

WEB3 Trading Platform Ranking_Web3 Global Exchanges Top Ten Résumé

Apr 21, 2025 am 10:45 AM

WEB3 Trading Platform Ranking_Web3 Global Exchanges Top Ten Résumé

Apr 21, 2025 am 10:45 AM

Binance est le suzerain de l'écosystème mondial de trading d'actifs numériques, et ses caractéristiques comprennent: 1. Le volume de négociation quotidien moyen dépasse 150 milliards de dollars, prend en charge 500 paires de négociation, couvrant 98% des monnaies grand public; 2. La matrice d'innovation couvre le marché des dérivés, la mise en page Web3 et le système éducatif; 3. Les avantages techniques sont des moteurs de correspondance d'une milliseconde, avec des volumes de traitement de pointe de 1,4 million de transactions par seconde; 4. Conformité Progress détient des licences de 15 pays et établit des entités conformes en Europe et aux États-Unis.

Déverrouiller Binance Kernel AirDrop, nouveau gameplay pour les positions de maintien BNB

Apr 21, 2025 pm 01:06 PM

Déverrouiller Binance Kernel AirDrop, nouveau gameplay pour les positions de maintien BNB

Apr 21, 2025 pm 01:06 PM

Dans la vague des crypto-monnaies, de nouvelles opportunités et projets continuent d'émerger. Récemment, le projet Kerneldao (Kernel) lancé par Binance a attiré beaucoup d'attention, apportant un nouveau gameplay et des avantages aux détenteurs de BNB.