Une brève analyse de l'observabilité du LLM

Bonjour à tous, je m'appelle Luga. Aujourd'hui, nous continuons à explorer un sujet lié à la technologie dans l'écosystème de l'intelligence artificielle : l'observabilité du LLM (Large Language Model). Cet article continuera d'analyser l'observabilité du LLM en profondeur pour aider chacun à comprendre son importance et ses connaissances fondamentales sur l'écosystème.

1. Pourquoi le LLM a-t-il besoin d'observabilité ?

Dans le monde connecté numériquement d'aujourd'hui, les grands modèles de langage (LLM) sont comme un magicien doté de super pouvoirs qui peuvent rapidement générer du texte, traduire des langues et créer de la musique, de la poésie et de la programmation. , etc. ont apporté une grande commodité à la vie des gens. Cependant, en raison de la complexité du LLM, sa gestion et son utilisation sont également confrontées à certains défis.

LLM contient généralement des centaines de millions, voire des milliards de paramètres, et les interactions entre ces paramètres sont très complexes. Par conséquent, il n’est pas facile de prédire avec précision le résultat du LLM. De plus, les données de formation utilisées par LLM proviennent généralement du monde réel, ce qui peut contenir des biais ou des informations erronées. Ces biais et erreurs peuvent amener LLM à générer du texte contenant des erreurs ou des biais.

Par conséquent, l'observabilité LLM (Large Language Model Observability) est la clé pour résoudre les défis ci-dessus. Il peut aider les utilisateurs à comprendre l'état d'exécution, les performances et la sécurité de LLM. Plus précisément, l'observabilité fournit les informations suivantes : données d'exploitation en temps réel de LLM, utilisation des ressources, temps de réponse aux demandes, taux d'erreur, journalisation, etc. Ces informations peuvent aider les utilisateurs à découvrir et à résoudre les problèmes en temps opportun, à optimiser les performances de LLM et à garantir son fonctionnement en toute sécurité. En fournissant une observabilité complète, LLM Observability permet aux utilisateurs de mieux comprendre et gérer les opérations LLM.

- Résultats de sortie LLM

- Modifications des paramètres LLM

- Utilisation des ressources LLM

- Risques de sécurité LLM

Sur la base des informations associées ci-dessus, les utilisateurs peuvent gérer et utiliser efficacement LLM pour garantir que LLM peut être sûr, fonctionner de manière stable et efficace .

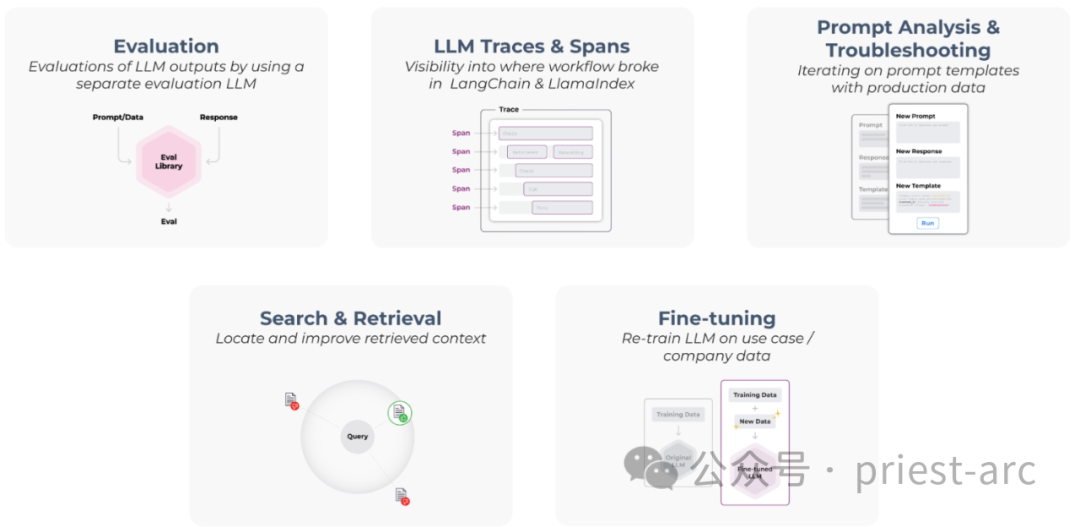

2. Analyse des cinq piliers de l'observabilité LLM

Figure : Les cinq piliers de l'observabilité LLM

De manière générale, les cinq piliers de l'observabilité LLM (grand modèle) comprennent principalement les éléments suivants :

1. - Évaluation

L'"évaluation" est un pilier important de l'observabilité LLM, utilisée pour comprendre et valider les performances des modèles LLM, et capturer des problèmes tels que des hallucinations potentielles ou des questions-réponses. L'évaluation des performances des LLM est essentielle pour garantir la qualité et la fiabilité du modèle. Nous pouvons effectuer une évaluation de plausibilité grâce à des méthodes et techniques d'évaluation courantes telles que des ensembles de données de test, des tests A/B, des mesures et des critères d'évaluation, des commentaires des utilisateurs et une évaluation subjective, ainsi qu'une évaluation interprétative du modèle. Ces méthodes d'évaluation peuvent nous aider à comprendre l'exactitude, la robustesse, la capacité de généralisation et l'interprétabilité du modèle, ainsi que les performances du modèle dans différentes tâches et scénarios. Grâce à une évaluation et une amélioration continues, nous pouvons améliorer les performances et l'efficacité des modèles LLM pour mieux répondre aux besoins des utilisateurs.

En évaluant les performances du LLM, nous pouvons découvrir ses problèmes potentiels et les possibilités d'amélioration. Ces résultats d’évaluation peuvent guider les efforts ultérieurs d’optimisation et d’amélioration pour améliorer la qualité et la fiabilité du LLM.

Dans les scénarios réels, il convient de noter que l'évaluation LLM est un processus itératif continu. À mesure que le modèle est utilisé et que l'environnement change, il peut être nécessaire de l'évaluer et de le mettre à jour régulièrement. Cela garantit que LLM maintient des performances et une précision élevées dans des conditions changeantes.

2. Traces et étendues LLM : traces et étendues LLM

La caractéristique unique des applications LLM est leur capacité à capturer et à tracer des informations à partir de cadres d'applications LLM courants tels que LangChain et LlamaIndex. Ces frameworks fournissent des outils et des fonctionnalités puissants pour aider les développeurs à surveiller et documenter efficacement l'étendue et les chemins d'exécution des applications LLM.

En utilisant ces frameworks d'applications LLM courants, les développeurs peuvent tirer pleinement parti des capacités d'étendue et de trace qu'ils fournissent et obtenir des informations sur le comportement et les performances des applications LLM. Cela permet de surveiller et d'optimiser le fonctionnement des applications LLM et fournit des informations précieuses pour améliorer et augmenter les performances et la fiabilité de LLM.

3. Analyse rapide et dépannage - Analyse rapide et localisation des défauts

Afin de suivre les problèmes de performances LLM, nous pouvons utiliser des évaluations ou des indicateurs traditionnels comme indicateurs pour mesurer les performances. Ces mesures peuvent nous aider à évaluer les aspects critiques tels que la précision, le temps de réponse, l'utilisation des ressources, etc. du LLM. En surveillant ces mesures, nous pouvons rapidement identifier les problèmes de performances potentiels et prendre les mesures appropriées pour les améliorer.

De plus, afin de reproduire fidèlement le problème, je pense que nous pouvons utiliser des données de production en temps réel. En utilisant les données d'environnements de production réels, nous pouvons simuler des exécutions LLM dans des scénarios réels et effectuer des opérations spécifiques à plusieurs reprises pour reproduire avec précision les problèmes de performances. De telles reproductions peuvent nous aider à mieux comprendre la cause profonde du problème et à mettre en œuvre des solutions appropriées pour le résoudre.

4. Recherche et récupération - Recherche et récupération

Normalement, nous pouvons ajouter nos données propriétaires à LLM en utilisant RAG (Retrieval-Augmented Generation). RAG est une architecture de modèle puissante qui combine des capacités de récupération et de génération pour combiner nos données propriétaires avec LLM. Cette combinaison permet à LLM d'exploiter nos données exclusives pour une inférence et une génération plus précises et ciblées.

Cependant, afin de garantir que les performances de LLM sont optimisées au maximum, il est crucial de dépanner et d'évaluer RAG. Le dépannage de RAG nous permet d'identifier et de résoudre les problèmes pouvant entraîner une dégradation des performances LLM ou la génération d'erreurs. Dans le même temps, l'évaluation de RAG peut nous aider à comprendre ses performances sur des tâches ou des ensembles de données spécifiques et ainsi à sélectionner la configuration et les paramètres les plus appropriés.

Par conséquent, le dépannage et l'évaluation de RAG sont des étapes critiques pour garantir l'optimisation des performances LLM. Après tout, cela nous aide à garantir une intégration fluide de LLM avec nos données propriétaires, augmentant ainsi la qualité et la fiabilité de LLM.

5. Fine-Tunig - Fine-tuning

La capacité de généralisation du modèle dépend de la qualité et de la quantité des données d'entraînement qu'il reçoit. Par conséquent, de grandes quantités de données réelles ou générées artificiellement doivent être collectées et divisées en exemples de données ou en groupes de problèmes.

Un exemple de données peut être un seul point de données ou une combinaison de plusieurs points de données. Les clusters de problèmes peuvent être des clusters basés sur des types ou des domaines de problèmes spécifiques. Le format des points de données doit être cohérent avec les exigences du flux de travail de réglage fin.

3. Analyse des éléments centraux de l'observabilité LLM

De manière générale, les éléments centraux de l'observabilité LLM (grand modèle) impliquent le suivi des performances, une compréhension approfondie, l'assurance de la fiabilité et de la précision, etc., comme suit :

1 . Suivi des performances

L'observabilité est la pierre angulaire du LLM (Large Model Language), et le composant le plus critique est un « suivi des performances » cohérent. Ce processus implique la collecte de mesures clés liées aux capacités LLM, telles que les prédictions de précision, les temps de réponse, les types d'erreurs et les biais, etc. Ces mesures nous aident non seulement à identifier et à résoudre les problèmes de performances, mais fournissent également des informations sur l'état opérationnel du LLM et les problèmes potentiels.

Dans des scénarios réels de suivi des performances, nous pouvons utiliser diverses techniques. De manière générale, des mesures telles que l’exactitude, la précision et le rappel restent des choix populaires. La précision mesure la proportion de prédictions correctes, la précision mesure la pertinence de ces prédictions et le rappel mesure le nombre de résultats pertinents capturés par le modèle. Bien entendu, en plus de ce qui précède, nous pouvons également utiliser d’autres mesures, telles que la latence, le débit, l’utilisation des ressources et la sécurité.

Dans les scénarios commerciaux réels, la « journalisation » est une autre méthode essentielle de suivi des performances. Il fournit des journaux détaillés sur le comportement du modèle, y compris les entrées, les sorties, les erreurs et autres anomalies. Ces détails aident à diagnostiquer les problèmes LLM tels que les préjugés, la discrimination et d'autres problèmes de sécurité.

2. Compréhension approfondie

En plus du suivi des performances mentionné ci-dessus, une compréhension approfondie du LLM (Large Model Language) est également un élément clé de l'observabilité. Cela nécessite un examen attentif des données de formation, l'articulation de l'algorithme de prise de décision, l'identification de toutes les limites et une solide compréhension des limites du modèle.

(1)Données d'entraînement

Comprendre la distribution des données d'entraînement est crucial car les biais dans les données peuvent se traduire par des biais dans le modèle. Par exemple, si l'ensemble de données d'entraînement contient principalement des voix masculines, le modèle peut être plus sensible aux voix masculines, ce qui entraînera un biais au détriment des voix féminines.

En plus des biais, le bruit et les incohérences dans les données d'entraînement peuvent également affecter les performances du modèle. Par conséquent, avant d’utiliser les données de formation, nous devons vérifier soigneusement la qualité et la fiabilité des données.

(2) Algorithme de prise de décision

L'analyse du mécanisme de prise de décision permet d'identifier d'éventuels biais ou inexactitudes dans le modèle. Par exemple, si un modèle se comporte anormalement lors du traitement d’un type spécifique d’entrée, cela peut indiquer une faille dans l’algorithme de prise de décision. Par conséquent, en comprenant les mécanismes de prise de décision, nous pouvons plus facilement identifier et corriger les problèmes potentiels du modèle.

(3) Limitations

Reconnaître les limites du LLM est inestimable. Bien que ces modèles soient avancés, ils ne sont pas parfaits. Ils peuvent présenter des biais, générer des erreurs et être sensibles à certaines entrées inhabituelles.

Par exemple, les LLM peuvent produire des résultats biaisés car ils sont formés sur des ensembles de données contenant des biais. De plus, les LLM peuvent générer des erreurs car ils sont basés sur des modèles probabilistes et comportent donc un certain degré d’incertitude. Enfin, LLM peut être affecté par certaines entrées anormales, telles que des entrées contenant des erreurs ou du contenu malveillant.

3. Garantie de fiabilité

Assurer la fiabilité du LLM est un autre élément essentiel de l'observabilité. Un LLM fiable est capable de fonctionner de manière stable dans une variété de scénarios d'entrée sans planter ni produire de sortie erronée, même dans des conditions difficiles ou anormales.

La stratégie la plus courante est le test de résistance, en tant que méthode courante pour vérifier la fiabilité du LLM en fournissant diverses entrées au LLM, y compris des entrées conçues pour remettre en question le modèle afin de le pousser dans ses limites. Un LLM fiable sera capable de gérer ces entrées sans planter ni produire de sortie erronée.

La tolérance aux pannes est une autre stratégie courante pour garantir la fiabilité du LLM. La conception tolérante aux pannes permet à LLM de continuer à fonctionner lorsque certains composants tombent en panne. Par exemple, si une couche du LLM échoue, le modèle tolérant aux pannes devrait toujours être capable de générer des prédictions précises.

4. Précision

Le dernier objectif clé de l'observabilité LLM est d'améliorer la « précision » du modèle, ce qui nécessite d'identifier et d'atténuer les biais et les erreurs. Les biais et les erreurs sont deux facteurs clés qui affectent la précision du modèle.

L'écart fait généralement référence à la différence entre les résultats de prédiction du modèle et la situation réelle. Les biais peuvent provenir de facteurs tels que l'ensemble de données, la conception du modèle ou le processus de formation. Les biais peuvent amener un modèle à produire des résultats injustes ou inexacts.

Une erreur signifie généralement que les résultats de prédiction du modèle ne correspondent pas à la situation réelle. Les erreurs peuvent provenir du caractère aléatoire du modèle, du bruit ou d’autres facteurs. Les erreurs peuvent amener les modèles à produire des résultats inexacts.

La détection des écarts et la détection des erreurs sont deux techniques courantes pour identifier et atténuer les biais et les erreurs. La détection des biais identifie les écarts systématiques dans les prédictions du modèle, tandis que la détection des erreurs identifie toute inexactitude dans les résultats du modèle.

Une fois les écarts et les erreurs identifiés, nous pouvons les corriger grâce à diverses mesures. Dans les scénarios commerciaux réels, les mesures correctives comprennent principalement les éléments suivants :

- Nettoyage des données : supprimez les écarts dans l'ensemble de données.

- Conception du modèle : améliorez la conception du modèle et réduisez les écarts.

- Formation du modèle : utilisez un ensemble de données plus représentatif ou des méthodes de formation plus avancées pour entraîner le modèle.

Les mesures de correction d'erreurs couramment utilisées impliquent principalement les niveaux suivants :

- Réentraîner le modèle : utilisez un ensemble de données plus précis ou des méthodes de formation plus avancées pour recycler le modèle.

- Affinez les paramètres du modèle : ajustez les paramètres du modèle pour réduire les erreurs.

- Utilisez des techniques de post-traitement : post-traitez la sortie du modèle pour améliorer la précision.

Ainsi, avec ce qui précède, l'observabilité LLM peut contribuer à améliorer la fiabilité et la fiabilité du LLM uniquement en suivant attentivement la conception des performances, en améliorant la compréhension du LLM, en optimisant la précision et en garantissant la fiabilité.

En résumé, lors de l'utilisation de LLM, garantir son observabilité est une pratique clé, qui permet de garantir la fiabilité et la fiabilité de l'utilisation de LLM. En surveillant les mesures de performance et le comportement des LLM, en obtenant des informations sur leur fonctionnement interne et en garantissant l'exactitude et la fiabilité des LLM, les organisations peuvent réduire efficacement les risques associés à ces puissants modèles d'IA.

Référence : [1] https://docs.arize.com/arize/what-is-llm-observability

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Conseils de configuration du pare-feu Debian Mail Server

Apr 13, 2025 am 11:42 AM

Conseils de configuration du pare-feu Debian Mail Server

Apr 13, 2025 am 11:42 AM

La configuration du pare-feu d'un serveur de courrier Debian est une étape importante pour assurer la sécurité du serveur. Voici plusieurs méthodes de configuration de pare-feu couramment utilisées, y compris l'utilisation d'iptables et de pare-feu. Utilisez les iptables pour configurer le pare-feu pour installer iptables (sinon déjà installé): Sudoapt-getUpDaSuDoapt-getinstalliptableView Règles actuelles iptables: Sudoiptable-L Configuration

Comment optimiser les performances de Debian Readdir

Apr 13, 2025 am 08:48 AM

Comment optimiser les performances de Debian Readdir

Apr 13, 2025 am 08:48 AM

Dans Debian Systems, les appels du système ReadDir sont utilisés pour lire le contenu des répertoires. Si ses performances ne sont pas bonnes, essayez la stratégie d'optimisation suivante: simplifiez le nombre de fichiers d'annuaire: divisez les grands répertoires en plusieurs petits répertoires autant que possible, en réduisant le nombre d'éléments traités par appel ReadDir. Activer la mise en cache de contenu du répertoire: construire un mécanisme de cache, mettre à jour le cache régulièrement ou lorsque le contenu du répertoire change et réduire les appels fréquents à Readdir. Les caches de mémoire (telles que Memcached ou Redis) ou les caches locales (telles que les fichiers ou les bases de données) peuvent être prises en compte. Adoptez une structure de données efficace: si vous implémentez vous-même la traversée du répertoire, sélectionnez des structures de données plus efficaces (telles que les tables de hachage au lieu de la recherche linéaire) pour stocker et accéder aux informations du répertoire

Comment implémenter le tri des fichiers par Debian Readdir

Apr 13, 2025 am 09:06 AM

Comment implémenter le tri des fichiers par Debian Readdir

Apr 13, 2025 am 09:06 AM

Dans Debian Systems, la fonction ReadDir est utilisée pour lire le contenu du répertoire, mais l'ordre dans lequel il revient n'est pas prédéfini. Pour trier les fichiers dans un répertoire, vous devez d'abord lire tous les fichiers, puis les trier à l'aide de la fonction QSORT. Le code suivant montre comment trier les fichiers de répertoire à l'aide de ReadDir et QSort dans Debian System: # include # include # include # include # include // Fonction de comparaison personnalisée, utilisée pour qsortintCompare (constvoid * a, constvoid * b) {returnstrcmp (* (

Comment définir le niveau de journal Debian Apache

Apr 13, 2025 am 08:33 AM

Comment définir le niveau de journal Debian Apache

Apr 13, 2025 am 08:33 AM

Cet article décrit comment ajuster le niveau de journalisation du serveur Apacheweb dans le système Debian. En modifiant le fichier de configuration, vous pouvez contrôler le niveau verbeux des informations de journal enregistrées par Apache. Méthode 1: Modifiez le fichier de configuration principal pour localiser le fichier de configuration: le fichier de configuration d'Apache2.x est généralement situé dans le répertoire / etc / apache2 /. Le nom de fichier peut être apache2.conf ou httpd.conf, selon votre méthode d'installation. Modifier le fichier de configuration: Ouvrez le fichier de configuration avec les autorisations racine à l'aide d'un éditeur de texte (comme Nano): Sutonano / etc / apache2 / apache2.conf

Méthode d'installation du certificat de Debian Mail Server SSL

Apr 13, 2025 am 11:39 AM

Méthode d'installation du certificat de Debian Mail Server SSL

Apr 13, 2025 am 11:39 AM

Les étapes pour installer un certificat SSL sur le serveur de messagerie Debian sont les suivantes: 1. Installez d'abord la boîte à outils OpenSSL, assurez-vous que la boîte à outils OpenSSL est déjà installée sur votre système. Si ce n'est pas installé, vous pouvez utiliser la commande suivante pour installer: Sudoapt-getUpDaSuDoapt-getInstallOpenSSL2. Générer la clé privée et la demande de certificat Suivant, utilisez OpenSSL pour générer une clé privée RSA 2048 bits et une demande de certificat (RSE): OpenSS

Comment Debian Readdir s'intègre à d'autres outils

Apr 13, 2025 am 09:42 AM

Comment Debian Readdir s'intègre à d'autres outils

Apr 13, 2025 am 09:42 AM

La fonction ReadDir dans le système Debian est un appel système utilisé pour lire le contenu des répertoires et est souvent utilisé dans la programmation C. Cet article expliquera comment intégrer ReadDir avec d'autres outils pour améliorer sa fonctionnalité. Méthode 1: combinant d'abord le programme de langue C et le pipeline, écrivez un programme C pour appeler la fonction readdir et sortir le résultat: # include # include # include # includeIntmain (intargc, char * argv []) {dir * dir; structDirent * entrée; if (argc! = 2) {

Comment Debian OpenSSL empêche les attaques de l'homme au milieu

Apr 13, 2025 am 10:30 AM

Comment Debian OpenSSL empêche les attaques de l'homme au milieu

Apr 13, 2025 am 10:30 AM

Dans Debian Systems, OpenSSL est une bibliothèque importante pour le chiffrement, le décryptage et la gestion des certificats. Pour empêcher une attaque d'homme dans le milieu (MITM), les mesures suivantes peuvent être prises: utilisez HTTPS: assurez-vous que toutes les demandes de réseau utilisent le protocole HTTPS au lieu de HTTP. HTTPS utilise TLS (Protocole de sécurité de la couche de transport) pour chiffrer les données de communication pour garantir que les données ne sont pas volées ou falsifiées pendant la transmission. Vérifiez le certificat de serveur: vérifiez manuellement le certificat de serveur sur le client pour vous assurer qu'il est digne de confiance. Le serveur peut être vérifié manuellement via la méthode du délégué d'URLSession

Comment faire Debian Hadoop Log Management

Apr 13, 2025 am 10:45 AM

Comment faire Debian Hadoop Log Management

Apr 13, 2025 am 10:45 AM

Gérer les journaux Hadoop sur Debian, vous pouvez suivre les étapes et les meilleures pratiques suivantes: l'agrégation de journal Activer l'agrégation de journaux: définir yarn.log-aggregation-inable à true dans le fichier yarn-site.xml pour activer l'agrégation de journaux. Configurer la stratégie de rétention du journal: Définissez Yarn.log-agregation.retain-secondes pour définir le temps de rétention du journal, tel que 172800 secondes (2 jours). Spécifiez le chemin de stockage des journaux: via yarn.n