Périphériques technologiques

Périphériques technologiques

IA

IA

Mise en place d'un système de recommandation personnalisé basé sur le modèle Transformer

Mise en place d'un système de recommandation personnalisé basé sur le modèle Transformer

Mise en place d'un système de recommandation personnalisé basé sur le modèle Transformer

La recommandation personnalisée basée sur Transformer est une méthode de recommandation personnalisée mise en œuvre à l'aide du modèle Transformer. Transformer est un modèle de réseau neuronal basé sur le mécanisme d'attention, largement utilisé dans les tâches de traitement du langage naturel, telles que la traduction automatique et la génération de texte. Dans les recommandations personnalisées, Transformer peut connaître les intérêts et les préférences de l'utilisateur et recommander un contenu pertinent à l'utilisateur sur la base de ces informations. Grâce au mécanisme d'attention, Transformer est capable de capturer la relation entre les intérêts de l'utilisateur et le contenu associé, améliorant ainsi la précision et l'efficacité des recommandations. En utilisant le modèle Transformer, le système de recommandation personnalisé peut mieux comprendre les besoins des utilisateurs et fournir aux utilisateurs des services de recommandation plus personnalisés et plus précis.

Dans les recommandations personnalisées, vous devez d'abord établir une matrice d'interaction entre les utilisateurs et les éléments. Cette matrice enregistre le comportement des utilisateurs à l'égard d'éléments tels que les notes, les clics ou les achats. Ensuite, nous devons convertir ces informations d'interaction sous forme vectorielle et les saisir dans le modèle Transformer pour la formation. De cette manière, le modèle peut apprendre la relation entre les utilisateurs et les éléments et générer des résultats de recommandation personnalisés. De cette façon, nous pouvons améliorer la précision et la satisfaction des utilisateurs du système de recommandation.

Le modèle Transformer en recommandations personnalisées comprend généralement un encodeur et un décodeur. L'encodeur est utilisé pour apprendre les représentations vectorielles des utilisateurs et des éléments, et le décodeur est utilisé pour prédire l'intérêt de l'utilisateur pour d'autres éléments. Cette architecture peut capturer efficacement les relations complexes entre les utilisateurs et les éléments, améliorant ainsi la précision et la personnalisation des recommandations.

Dans l'encodeur, un mécanisme d'auto-attention multicouche est d'abord utilisé pour interagir avec les représentations vectorielles des utilisateurs et des éléments. Le mécanisme d'auto-attention permet au modèle d'apprendre des représentations vectorielles plus efficaces en les pondérant en fonction de l'importance des différentes positions dans la séquence d'entrée. Ensuite, la sortie du mécanisme d’attention est traitée via un réseau neuronal à action directe pour obtenir la représentation vectorielle finale. Cette méthode peut aider le modèle à mieux capturer les informations de corrélation entre les utilisateurs et les éléments et à améliorer les performances du système de recommandation.

Dans le décodeur, nous pouvons utiliser le vecteur utilisateur et le vecteur élément pour prédire l'intérêt de l'utilisateur pour d'autres éléments. Pour calculer la similarité entre les utilisateurs et les éléments, nous pouvons utiliser le mécanisme d'attention des produits scalaires. En calculant le score d'attention, nous pouvons évaluer la corrélation entre l'utilisateur et l'élément et l'utiliser comme base pour prédire le niveau d'intérêt. Enfin, nous pouvons classer les éléments en fonction de leur intérêt prévu et les recommander aux utilisateurs. Cette approche peut améliorer la précision et la personnalisation des systèmes de recommandation.

Pour mettre en œuvre des recommandations personnalisées basées sur Transformer, vous devez prêter attention aux points suivants :

1. Préparation des données : Collectez les données d'interaction entre les utilisateurs et les éléments et construisez une matrice d'interaction. Cette matrice enregistre l'interaction entre les utilisateurs et les articles, qui peut inclure des informations telles que les notes, les clics et les achats.

2. Représentation des fonctionnalités : convertissez les utilisateurs et les éléments de la matrice d'interaction en représentations vectorielles. La technologie d'intégration peut être utilisée pour mapper les utilisateurs et les éléments dans un espace de faible dimension et servir d'entrée au modèle.

3. Construction du modèle : créez un modèle d'encodeur-décodeur basé sur un transformateur. L'encodeur apprend les représentations vectorielles des utilisateurs et des éléments grâce à un mécanisme d'auto-attention multicouche, et le décodeur utilise des vecteurs d'utilisateur et d'élément pour prédire l'intérêt de l'utilisateur pour d'autres éléments.

4. Formation du modèle : utilisez les données d'interaction entre les utilisateurs et les éléments comme ensemble de formation pour entraîner le modèle en minimisant l'écart entre les résultats prédits et les notes réelles. Des algorithmes d'optimisation tels que la descente de gradient peuvent être utilisés pour mettre à jour les paramètres du modèle.

5. Génération de recommandations : sur la base du modèle entraîné, prédisez et classez les éléments avec lesquels l'utilisateur n'a pas interagi, et recommandez les éléments présentant un grand intérêt pour l'utilisateur.

Dans les applications pratiques, les recommandations personnalisées basées sur Transformer présentent les avantages suivants :

- Le modèle peut pleinement prendre en compte la relation interactive entre les utilisateurs et les éléments, et peut capturer des informations sémantiques plus riches.

- Le modèle Transformer a une bonne évolutivité et un bon parallélisme et peut gérer des ensembles de données à grande échelle et des requêtes simultanées élevées.

- Le modèle peut apprendre automatiquement les représentations des fonctionnalités, réduisant ainsi le besoin d'ingénierie manuelle des fonctionnalités.

Cependant, les recommandations personnalisées basées sur Transformer sont également confrontées à certains défis :

- Rareté des données : dans des scénarios réels, les données d'interaction entre les utilisateurs et les éléments sont souvent rares. Étant donné que les utilisateurs n’ont interagi qu’avec un petit nombre d’éléments, il existe un grand nombre de valeurs manquantes dans les données, ce qui rend l’apprentissage et la prédiction du modèle difficiles.

- Problème de démarrage à froid : lorsque de nouveaux utilisateurs ou de nouveaux éléments rejoignent le système, leurs intérêts et préférences ne peuvent pas être capturés avec précision en raison du manque de données d'interaction suffisantes. Cela nécessite de résoudre le problème du démarrage à froid et de fournir des recommandations pour les nouveaux utilisateurs et les nouveaux éléments via d'autres méthodes (telles que les recommandations basées sur le contenu, le filtrage collaboratif, etc.).

- Diversité et problèmes de longue traîne : les recommandations personnalisées sont souvent confrontées au problème de la recherche d'articles populaires, ce qui entraîne un manque de diversité dans les résultats des recommandations et l'ignorance des éléments de longue traîne. Le modèle Transformer est peut-être plus susceptible de capturer la corrélation entre les éléments populaires au cours du processus d'apprentissage, mais l'effet de recommandation pour les éléments à longue traîne est faible.

- Interprétabilité et interprétabilité : en tant que modèle de boîte noire, les résultats de prédiction du modèle Transformer sont souvent difficiles à expliquer. Dans certains scénarios d'application, les utilisateurs souhaitent comprendre pourquoi de tels résultats de recommandation sont obtenus, et le modèle doit disposer de certaines capacités d'explication.

- Temps réel et efficacité : les modèles basés sur des transformateurs ont généralement de grandes structures de réseau et de grandes quantités de paramètres, et nécessitent des ressources informatiques élevées. Dans les scénarios de recommandation en temps réel, les résultats de recommandation personnalisés doivent être générés rapidement, et le modèle Transformer traditionnel peut présenter une complexité et une latence de calcul élevées.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Explorez les concepts, les différences, les avantages et les inconvénients de RNN, LSTM et GRU

Jan 22, 2024 pm 07:51 PM

Explorez les concepts, les différences, les avantages et les inconvénients de RNN, LSTM et GRU

Jan 22, 2024 pm 07:51 PM

Dans les données de séries chronologiques, il existe des dépendances entre les observations, elles ne sont donc pas indépendantes les unes des autres. Cependant, les réseaux de neurones traditionnels traitent chaque observation comme indépendante, ce qui limite la capacité du modèle à modéliser des données de séries chronologiques. Pour résoudre ce problème, le réseau neuronal récurrent (RNN) a été introduit, qui a introduit le concept de mémoire pour capturer les caractéristiques dynamiques des données de séries chronologiques en établissant des dépendances entre les points de données du réseau. Grâce à des connexions récurrentes, RNN peut transmettre des informations antérieures à l'observation actuelle pour mieux prédire les valeurs futures. Cela fait de RNN un outil puissant pour les tâches impliquant des données de séries chronologiques. Mais comment RNN parvient-il à obtenir ce type de mémoire ? RNN réalise la mémoire via la boucle de rétroaction dans le réseau neuronal. C'est la différence entre RNN et le réseau neuronal traditionnel.

Calcul des opérandes à virgule flottante (FLOPS) pour les réseaux de neurones

Jan 22, 2024 pm 07:21 PM

Calcul des opérandes à virgule flottante (FLOPS) pour les réseaux de neurones

Jan 22, 2024 pm 07:21 PM

FLOPS est l'une des normes d'évaluation des performances informatiques, utilisée pour mesurer le nombre d'opérations en virgule flottante par seconde. Dans les réseaux de neurones, FLOPS est souvent utilisé pour évaluer la complexité informatique du modèle et l'utilisation des ressources informatiques. C'est un indicateur important utilisé pour mesurer la puissance de calcul et l'efficacité d'un ordinateur. Un réseau de neurones est un modèle complexe composé de plusieurs couches de neurones utilisées pour des tâches telles que la classification, la régression et le clustering des données. La formation et l'inférence des réseaux de neurones nécessitent un grand nombre de multiplications matricielles, de convolutions et d'autres opérations de calcul, la complexité de calcul est donc très élevée. FLOPS (FloatingPointOperationsperSecond) peut être utilisé pour mesurer la complexité de calcul des réseaux de neurones afin d'évaluer l'efficacité d'utilisation des ressources de calcul du modèle. FIASCO

Définition et analyse structurelle du réseau neuronal flou

Jan 22, 2024 pm 09:09 PM

Définition et analyse structurelle du réseau neuronal flou

Jan 22, 2024 pm 09:09 PM

Le réseau de neurones flous est un modèle hybride qui combine la logique floue et les réseaux de neurones pour résoudre des problèmes flous ou incertains difficiles à gérer avec les réseaux de neurones traditionnels. Sa conception s'inspire du flou et de l'incertitude de la cognition humaine, c'est pourquoi il est largement utilisé dans les systèmes de contrôle, la reconnaissance de formes, l'exploration de données et d'autres domaines. L'architecture de base du réseau neuronal flou se compose d'un sous-système flou et d'un sous-système neuronal. Le sous-système flou utilise la logique floue pour traiter les données d'entrée et les convertir en ensembles flous pour exprimer le flou et l'incertitude des données d'entrée. Le sous-système neuronal utilise des réseaux de neurones pour traiter des ensembles flous pour des tâches telles que la classification, la régression ou le clustering. L'interaction entre le sous-système flou et le sous-système neuronal confère au réseau neuronal flou des capacités de traitement plus puissantes et peut

Une étude de cas sur l'utilisation du modèle LSTM bidirectionnel pour la classification de texte

Jan 24, 2024 am 10:36 AM

Une étude de cas sur l'utilisation du modèle LSTM bidirectionnel pour la classification de texte

Jan 24, 2024 am 10:36 AM

Le modèle LSTM bidirectionnel est un réseau neuronal utilisé pour la classification de texte. Vous trouverez ci-dessous un exemple simple montrant comment utiliser le LSTM bidirectionnel pour les tâches de classification de texte. Tout d'abord, nous devons importer les bibliothèques et modules requis : importosimportnumpyasnpfromkeras.preprocessing.textimportTokenizerfromkeras.preprocessing.sequenceimportpad_sequencesfromkeras.modelsimportSequentialfromkeras.layersimportDense,Em

Débruitage d'image à l'aide de réseaux de neurones convolutifs

Jan 23, 2024 pm 11:48 PM

Débruitage d'image à l'aide de réseaux de neurones convolutifs

Jan 23, 2024 pm 11:48 PM

Les réseaux de neurones convolutifs fonctionnent bien dans les tâches de débruitage d'images. Il utilise les filtres appris pour filtrer le bruit et restaurer ainsi l'image originale. Cet article présente en détail la méthode de débruitage d'image basée sur un réseau neuronal convolutif. 1. Présentation du réseau neuronal convolutif Le réseau neuronal convolutif est un algorithme d'apprentissage en profondeur qui utilise une combinaison de plusieurs couches convolutives, des couches de regroupement et des couches entièrement connectées pour apprendre et classer les caractéristiques de l'image. Dans la couche convolutive, les caractéristiques locales de l'image sont extraites via des opérations de convolution, capturant ainsi la corrélation spatiale dans l'image. La couche de pooling réduit la quantité de calcul en réduisant la dimension des fonctionnalités et conserve les principales fonctionnalités. La couche entièrement connectée est responsable du mappage des fonctionnalités et des étiquettes apprises pour mettre en œuvre la classification des images ou d'autres tâches. La conception de cette structure de réseau rend les réseaux de neurones convolutifs utiles dans le traitement et la reconnaissance d'images.

Réseau de neurones jumeaux : analyse des principes et des applications

Jan 24, 2024 pm 04:18 PM

Réseau de neurones jumeaux : analyse des principes et des applications

Jan 24, 2024 pm 04:18 PM

Le réseau neuronal siamois est une structure de réseau neuronal artificiel unique. Il se compose de deux réseaux de neurones identiques partageant les mêmes paramètres et poids. Dans le même temps, les deux réseaux partagent également les mêmes données d’entrée. Cette conception a été inspirée par des jumeaux, car les deux réseaux de neurones sont structurellement identiques. Le principe du réseau neuronal siamois est d'accomplir des tâches spécifiques, telles que la correspondance d'images, la correspondance de textes et la reconnaissance de visages, en comparant la similitude ou la distance entre deux données d'entrée. Pendant la formation, le réseau tente de mapper des données similaires vers des régions adjacentes et des données différentes vers des régions distantes. De cette manière, le réseau peut apprendre à classer ou à faire correspondre différentes données pour obtenir des résultats correspondants.

Introduction à SqueezeNet et ses caractéristiques

Jan 22, 2024 pm 07:15 PM

Introduction à SqueezeNet et ses caractéristiques

Jan 22, 2024 pm 07:15 PM

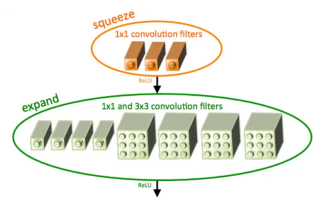

SqueezeNet est un algorithme petit et précis qui établit un bon équilibre entre haute précision et faible complexité, ce qui le rend idéal pour les systèmes mobiles et embarqués aux ressources limitées. En 2016, des chercheurs de DeepScale, de l'Université de Californie à Berkeley et de l'Université de Stanford ont proposé SqueezeNet, un réseau neuronal convolutif (CNN) compact et efficace. Ces dernières années, les chercheurs ont apporté plusieurs améliorations à SqueezeNet, notamment SqueezeNetv1.1 et SqueezeNetv2.0. Les améliorations apportées aux deux versions augmentent non seulement la précision, mais réduisent également les coûts de calcul. Précision de SqueezeNetv1.1 sur l'ensemble de données ImageNet

réseau neuronal convolutif causal

Jan 24, 2024 pm 12:42 PM

réseau neuronal convolutif causal

Jan 24, 2024 pm 12:42 PM

Le réseau neuronal convolutif causal est un réseau neuronal convolutif spécial conçu pour les problèmes de causalité dans les données de séries chronologiques. Par rapport aux réseaux de neurones convolutifs conventionnels, les réseaux de neurones convolutifs causals présentent des avantages uniques en ce qu'ils conservent la relation causale des séries chronologiques et sont largement utilisés dans la prédiction et l'analyse des données de séries chronologiques. L'idée centrale du réseau neuronal convolutionnel causal est d'introduire la causalité dans l'opération de convolution. Les réseaux neuronaux convolutifs traditionnels peuvent percevoir simultanément les données avant et après le point temporel actuel, mais dans la prévision des séries chronologiques, cela peut entraîner des problèmes de fuite d'informations. Parce que le résultat de la prédiction à l’heure actuelle sera affecté par les données à l’heure future. Le réseau neuronal convolutionnel causal résout ce problème. Il ne peut percevoir que le point temporel actuel et les données précédentes, mais ne peut pas percevoir les données futures.