Périphériques technologiques

Périphériques technologiques

IA

IA

Analyse approfondie des concepts et des applications des modèles de régression linéaire multiple

Analyse approfondie des concepts et des applications des modèles de régression linéaire multiple

Analyse approfondie des concepts et des applications des modèles de régression linéaire multiple

La régression linéaire multiple est la forme la plus courante de régression linéaire et est utilisée pour décrire comment une variable à réponse unique Y présente une relation linéaire avec plusieurs variables prédictives.

Exemples d'applications où la régression multiple peut être utilisée :

Le prix de vente d'une maison peut être affecté par des facteurs tels que l'emplacement, le nombre de chambres et de salles de bains, l'année de construction, la taille du terrain, etc.

2. La taille d'un enfant dépend de la taille de la mère, de la taille du père, de la nutrition et des facteurs environnementaux.

Paramètres du modèle de régression linéaire multiple

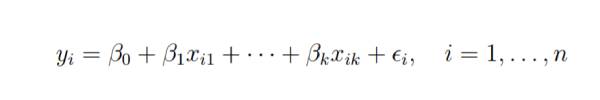

Considérons un modèle de régression linéaire multiple avec k variables prédictives indépendantes x1, x2..., xk et une variable de réponse y.

Supposons que nous ayons n observations pour k+1 variables et que n variables doivent être supérieures à k.

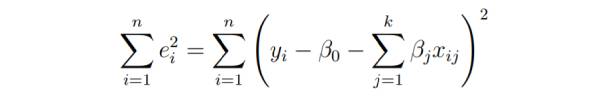

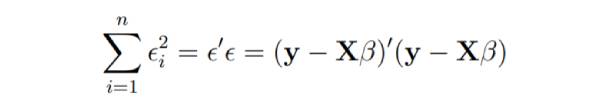

L'objectif fondamental de la régression des moindres carrés est d'ajuster l'hyperplan dans l'espace dimensionnel (k+1) pour minimiser la somme des carrés résiduels.

Avant de dériver les paramètres du modèle, mettez-les à zéro et dérivez l'équation normale des moindres carrés que les paramètres doivent satisfaire.

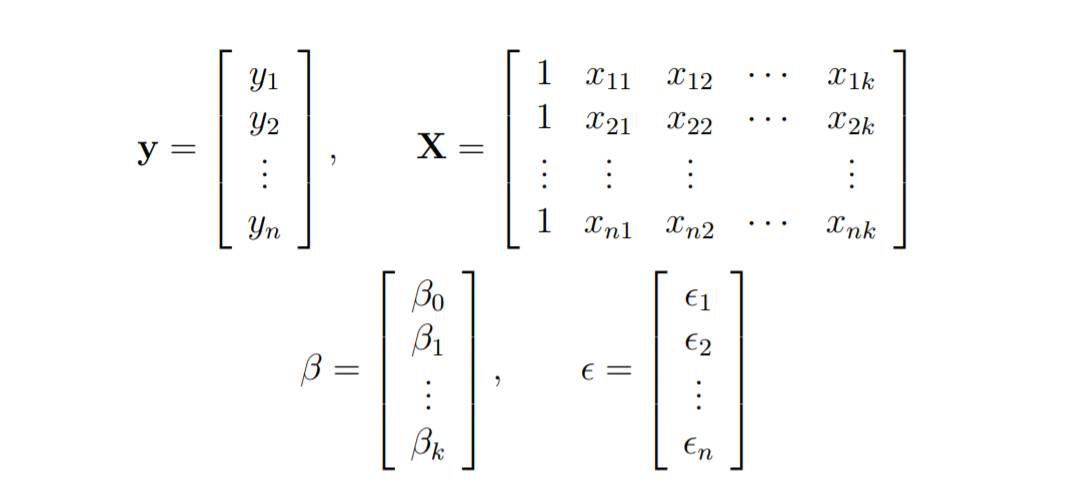

Ces équations sont formulées à l'aide de vecteurs et de matrices.

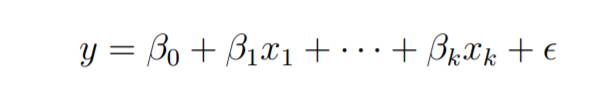

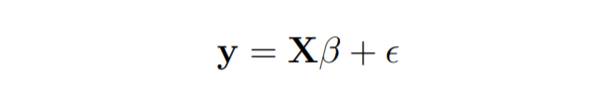

Un modèle de régression linéaire s'écrit comme suit :

Dans la régression linéaire, le paramètre des moindres carrés estime b

Imaginez que les colonnes des données du problème , et disons que b est variable. Nous souhaitons trouver le « meilleur » b qui minimise la somme des carrés des résidus.

La plus petite somme de carrés possible est zéro.

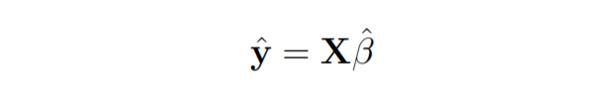

Voici le vecteur de réponse estimé.

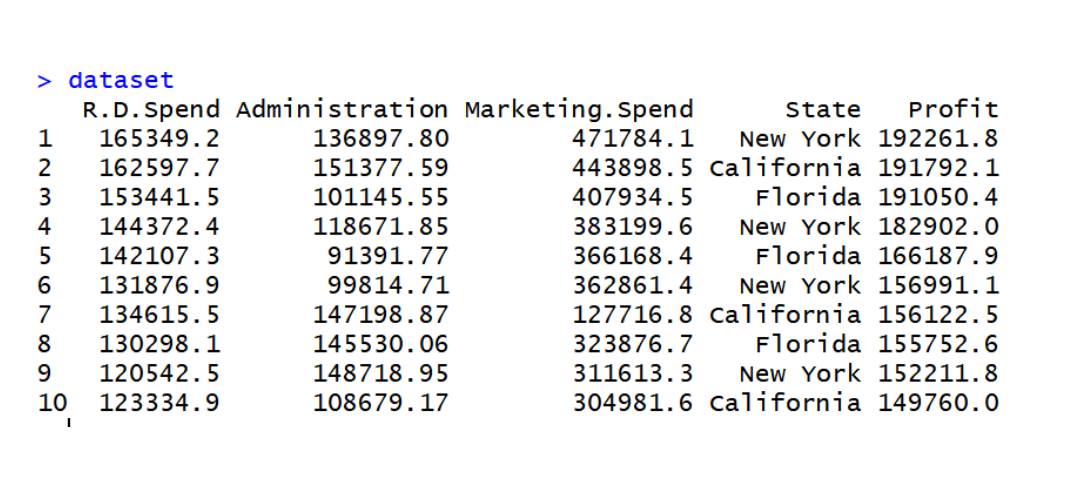

Le code implémente une régression linéaire multiple sur l'ensemble de données data2

data2 data set

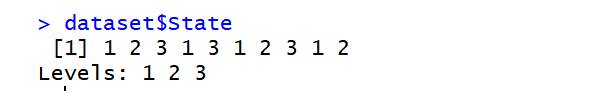

dataset=read.csv('data2.csv') dataset$State=factor(dataset$State, levels=c('New York','California','Florida'), labels=c(1,2,3)) dataset$State

library(caTools) set.seed(123) split=sample.split(dataset$Profit,SplitRatio=0.8) training_set=subset(dataset,split==TRUE) test_set=subset(dataset,split==FALSE) regressor=lm(formula=Profit~., data=training_set) y_pred=predict(regressor,newdata=test_set)

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

1663

1663

14

14

1419

1419

52

52

1313

1313

25

25

1264

1264

29

29

1237

1237

24

24

Analyse approfondie des concepts et des applications des modèles de régression linéaire multiple

Jan 22, 2024 pm 06:30 PM

Analyse approfondie des concepts et des applications des modèles de régression linéaire multiple

Jan 22, 2024 pm 06:30 PM

La régression linéaire multiple est la forme la plus courante de régression linéaire et est utilisée pour décrire comment une variable à réponse unique Y présente une relation linéaire avec plusieurs variables prédictives. Exemples d'applications où la régression multiple peut être utilisée : Le prix de vente d'une maison peut être affecté par des facteurs tels que l'emplacement, le nombre de chambres et de salles de bains, l'année de construction, la taille du terrain, etc. 2. La taille d'un enfant dépend de la taille de la mère, de la taille du père, de la nutrition et de facteurs environnementaux. Paramètres du modèle de régression linéaire multiple Considérons un modèle de régression linéaire multiple avec k variables prédictives indépendantes x1, x2..., xk et une variable de réponse y. Supposons que nous ayons n observations pour k+1 variables et que n variables soient supérieures à k. L'objectif fondamental de la régression des moindres carrés est d'ajuster l'hyperplan dans l'espace dimensionnel (k+1) afin de minimiser la somme des carrés résiduels. sur modèle

Explication détaillée du modèle de régression linéaire en Python

Jun 10, 2023 pm 12:28 PM

Explication détaillée du modèle de régression linéaire en Python

Jun 10, 2023 pm 12:28 PM

Explication détaillée du modèle de régression linéaire en Python La régression linéaire est un modèle statistique classique et un algorithme d'apprentissage automatique. Il est largement utilisé dans les domaines de la prévision et de la modélisation, tels que la prévision boursière, la prévision météorologique, la prévision des prix de l'immobilier, etc. En tant que langage de programmation efficace, Python fournit une riche bibliothèque d'apprentissage automatique, comprenant des modèles de régression linéaire. Cet article présentera en détail le modèle de régression linéaire en Python, y compris les principes du modèle, les scénarios d'application et l'implémentation du code. Principe de régression linéaire Le modèle de régression linéaire est basé sur la relation linéaire entre variables.

Les dix meilleurs algorithmes que vous devez connaître et connaître sur le machine learning !

Apr 12, 2023 am 09:34 AM

Les dix meilleurs algorithmes que vous devez connaître et connaître sur le machine learning !

Apr 12, 2023 am 09:34 AM

1. Régression linéaire La régression linéaire est probablement l'algorithme d'apprentissage automatique le plus populaire. La régression linéaire consiste à trouver une ligne droite et à faire en sorte que cette ligne droite s'adapte le plus étroitement possible aux points de données du nuage de points. Il tente de représenter les variables indépendantes (valeurs x) et les résultats numériques (valeurs y) en ajustant une équation en ligne droite à ces données. Cette ligne peut ensuite être utilisée pour prédire les valeurs futures ! La technique la plus couramment utilisée pour cet algorithme est la méthode des moindres carrés. Cette méthode calcule une ligne de meilleur ajustement qui minimise la distance perpendiculaire à partir de chaque point de données sur la ligne. La distance totale est la somme des carrés des distances verticales (ligne verte) de tous les points de données. L'idée est d'ajuster le modèle en minimisant cette erreur quadratique ou cette distance. Par exemple

Régularisation Tikhonov

Jan 23, 2024 am 09:33 AM

Régularisation Tikhonov

Jan 23, 2024 am 09:33 AM

La régularisation de Tikhonov, également connue sous le nom de régression de crête ou régularisation L2, est une méthode de régularisation utilisée pour la régression linéaire. Il contrôle la complexité et la capacité de généralisation du modèle en ajoutant un terme de pénalité de norme L2 à la fonction objectif du modèle. Ce terme de pénalité pénalise le poids du modèle par la somme des carrés pour éviter un poids excessif, atténuant ainsi le problème de surajustement. Cette méthode introduit un terme de régularisation dans la fonction de perte et ajuste le coefficient de régularisation pour équilibrer la capacité d'ajustement et la capacité de généralisation du modèle. La régularisation de Tikhonov a un large éventail d'applications pratiques et peut améliorer efficacement les performances et la stabilité du modèle. Avant régularisation, la fonction objectif de la régression linéaire peut être exprimée comme suit : J(w)=\frac{1}{2m}\sum_{i=1}^{m}(h_

Propriétés de régression polynomiale de l'analyse linéaire et non linéaire

Jan 22, 2024 pm 03:03 PM

Propriétés de régression polynomiale de l'analyse linéaire et non linéaire

Jan 22, 2024 pm 03:03 PM

La régression polynomiale est une méthode d'analyse de régression adaptée aux relations de données non linéaires. Contrairement aux modèles de régression linéaire simples qui ne peuvent s'adapter qu'à des relations en ligne droite, les modèles de régression polynomiale peuvent s'adapter avec plus de précision à des relations curvilignes complexes. Il introduit des fonctionnalités polynomiales et ajoute des termes de variables d'ordre élevé au modèle pour mieux s'adapter aux changements non linéaires des données. Cette approche améliore la flexibilité et l'ajustement du modèle, permettant des prédictions et une interprétation plus précises des données. La forme de base du modèle de régression polynomiale est la suivante : y=β0+β1x+β2x^2+…+βn*x^n+ε Dans ce modèle, y est la variable dépendante que nous voulons prédire et x est la variable indépendante. . β0~βn sont les coefficients du modèle qui déterminent le degré d'influence des variables indépendantes sur les variables dépendantes. ε représente le terme d'erreur du modèle, qui est déterminé par l'incapacité de

Explication détaillée de la définition, de la signification et du calcul de la valeur OR dans la régression logistique

Jan 23, 2024 pm 12:48 PM

Explication détaillée de la définition, de la signification et du calcul de la valeur OR dans la régression logistique

Jan 23, 2024 pm 12:48 PM

La régression logistique est un modèle linéaire utilisé pour les problèmes de classification, principalement utilisé pour prédire les valeurs de probabilité dans les problèmes de classification binaire. Il convertit les valeurs de prédiction linéaire en valeurs de probabilité en utilisant la fonction sigmoïde et prend des décisions de classification basées sur des seuils. Dans la régression logistique, la valeur OR est un indicateur important utilisé pour mesurer l'impact des différentes variables du modèle sur les résultats. La valeur OU représente le changement multiple de la probabilité que la variable dépendante se produise pour un changement unitaire de la variable indépendante. En calculant la valeur OR, nous pouvons déterminer la contribution d'une certaine variable au modèle. La méthode de calcul de la valeur OR consiste à prendre le coefficient du logarithme népérien (ln) de la fonction exponentielle (exp), c'est-à-dire OR=exp(β), où β est le coefficient de la variable indépendante dans la régression logistique modèle. Outil

Modèle d'analyse de régression logistique

Jan 22, 2024 pm 04:09 PM

Modèle d'analyse de régression logistique

Jan 22, 2024 pm 04:09 PM

Le modèle de régression logistique est un modèle de classification utilisé pour prédire la probabilité de variables binaires. Il est basé sur un modèle de régression linéaire et met en œuvre des tâches de classification en convertissant le résultat de la régression linéaire en probabilités prédites. Les modèles de régression logistique jouent un rôle important dans la prédiction de la probabilité des variables binaires. Il est largement utilisé dans divers problèmes de classification, tels que la prévision de la hausse et de la baisse du marché boursier, la question de savoir si les titulaires de cartes de crédit feront défaut, etc. De plus, le modèle de régression logistique peut également être utilisé pour la sélection de fonctionnalités, c'est-à-dire pour sélectionner des fonctionnalités qui ont un impact significatif sur les résultats de prédiction. De plus, le modèle de régression logistique peut également être utilisé pour la visualisation en traçant des courbes ROC pour évaluer les performances du modèle. De cette manière, nous pouvons comprendre intuitivement le pouvoir prédictif du modèle. Régression logistique

Comprendre la définition d'un modèle linéaire généralisé

Jan 23, 2024 pm 05:21 PM

Comprendre la définition d'un modèle linéaire généralisé

Jan 23, 2024 pm 05:21 PM

Le modèle linéaire généralisé (GLM) est une méthode d'apprentissage statistique utilisée pour décrire et analyser la relation entre les variables dépendantes et les variables indépendantes. Les modèles de régression linéaire traditionnels ne peuvent gérer que des variables numériques continues, tandis que GLM peut être étendu pour gérer davantage de types de variables, notamment des variables binaires, multivariées, de nombre ou catégorielles. L'idée principale de GLM est de relier la valeur attendue de la variable dépendante à la combinaison linéaire des variables indépendantes via une fonction de lien appropriée, tout en utilisant une distribution d'erreur appropriée pour décrire la variabilité de la variable dépendante. De cette manière, GLM peut s'adapter à différents types de données, améliorant encore la flexibilité et le pouvoir prédictif du modèle. En choisissant des fonctions de lien et des distributions d'erreurs appropriées, GLM peut être adapté à