Périphériques technologiques

Périphériques technologiques

IA

IA

Grand modèle de langage LLM et génération d'améliorations de récupération

Grand modèle de langage LLM et génération d'améliorations de récupération

Grand modèle de langage LLM et génération d'améliorations de récupération

Les grands modèles de langage LLM sont généralement formés à l'aide de l'architecture Transformer pour améliorer la capacité à comprendre et à générer un langage naturel à travers de grandes quantités de données textuelles. Ces modèles sont largement utilisés dans les chatbots, la synthèse de texte, la traduction automatique et d'autres domaines. Certains grands modèles de langage LLM bien connus incluent la série GPT d'OpenAI et le BERT de Google.

Dans le domaine du traitement du langage naturel, la génération améliorée par récupération est une technologie qui combine récupération et génération. Il génère un texte qui répond aux exigences en récupérant les informations pertinentes à partir de corpus de textes à grande échelle et en utilisant des modèles génératifs pour recombiner et organiser ces informations. Cette technique a un large éventail d'applications, notamment le résumé de texte, la traduction automatique, la génération de dialogues et d'autres tâches. En tirant parti de la récupération et de la génération, la génération améliorée par la récupération peut améliorer la qualité et la précision de la génération de texte, jouant ainsi un rôle important dans le domaine du traitement du langage naturel.

Dans le grand modèle de langage LLM, la génération d'améliorations de récupération est considérée comme un moyen technique important pour améliorer les performances du modèle. En intégrant la récupération et la génération, LLM peut obtenir plus efficacement des informations pertinentes à partir de textes volumineux et générer des textes en langage naturel de haute qualité. Ces moyens techniques peuvent améliorer considérablement l'effet de génération et la précision du modèle et mieux répondre aux besoins de diverses applications de traitement du langage naturel. En combinant récupération et génération, les grands modèles de langage LLM sont capables de surmonter certaines limitations des modèles génératifs traditionnels, telles que la cohérence et la pertinence du contenu généré. Par conséquent, la génération augmentée par récupération présente un grand potentiel pour améliorer les performances des modèles et devrait jouer un rôle important dans les futures recherches sur le traitement du langage naturel.

Étapes pour utiliser la technologie de génération d'amélioration de récupération pour personnaliser un grand modèle de langage LLM pour un cas d'utilisation spécifique

Pour utiliser la génération d'amélioration de récupération pour personnaliser un grand modèle de langage LLM pour un cas d'utilisation spécifique, vous pouvez suivre les étapes ci-dessous :

1. Préparer les données

Tout d'abord, préparer une grande quantité de données textuelles est une étape clé dans la construction d'un grand modèle de langage LLM. Ces données comprennent des données d'entraînement et des données de récupération. Les données d'entraînement sont utilisées pour entraîner le modèle, tandis que les données de récupération sont utilisées pour en récupérer les informations pertinentes. Pour répondre aux besoins d'un cas d'utilisation spécifique, des données textuelles pertinentes peuvent être sélectionnées selon les besoins. Ces données peuvent être obtenues sur Internet, telles que des articles pertinents, des actualités, des messages de forum, etc. Choisir la bonne source de données est crucial pour former un modèle de haute qualité. Afin de garantir la qualité des données de formation, les données doivent être prétraitées et nettoyées. Cela inclut la suppression du bruit, la normalisation des formats de texte, la gestion des valeurs manquantes, etc. Les données nettoyées peuvent être mieux utilisées pour entraîner le modèle et améliorer la précision et les performances du modèle. De plus

2. Entraînez le grand modèle de langage LLM

Utilisez le cadre de modèle de grand langage LLM existant, tel que la série GPT d'OpenAI ou le BERT de Google, pour vous entraîner sur les données de formation préparées. Au cours du processus de formation, des ajustements peuvent être effectués pour améliorer les performances du modèle pour des cas d'utilisation spécifiques.

3. Construire un système de récupération

Afin de parvenir à une génération d'amélioration de la récupération, il est nécessaire de construire un système de récupération pour récupérer des informations pertinentes à partir de corpus de textes à grande échelle. Les technologies de moteurs de recherche existantes peuvent être utilisées, telles que la récupération basée sur des mots clés ou sur le contenu. En outre, des technologies d'apprentissage profond plus avancées, telles que les modèles de récupération basés sur Transformer, peuvent également être utilisées pour améliorer les résultats de récupération. Ces technologies peuvent mieux comprendre l'intention de requête de l'utilisateur en analysant les informations sémantiques et contextuelles, et renvoyer avec précision des résultats pertinents. Grâce à une optimisation et une itération continues, le système de récupération peut récupérer efficacement les informations liées aux besoins des utilisateurs dans des corpus de textes à grande échelle.

4. Combinez le système de récupération et le grand modèle de langage LLM

Combinez le système de récupération et le grand modèle de langage LLM pour obtenir une génération de récupération améliorée. Premièrement, un système de récupération est utilisé pour récupérer des informations pertinentes à partir d’un corpus de textes à grande échelle. Ensuite, le grand modèle de langage LLM est utilisé pour réorganiser et combiner ces informations afin de générer un texte qui répond aux exigences. De cette manière, la précision et la diversité du texte généré peuvent être améliorées pour mieux répondre aux besoins des utilisateurs.

5. Optimisation et évaluation

Pour répondre aux besoins de cas d'utilisation spécifiques, nous pouvons optimiser et évaluer de grands modèles de langage LLM personnalisés. Pour évaluer les performances du modèle, vous pouvez utiliser des indicateurs d'évaluation tels que la précision, le rappel et le score F1. De plus, nous pouvons également utiliser les données de scénarios d’application réels pour tester le caractère pratique du modèle.

Exemple 1 : grand modèle de langage LLM pour les critiques de films

Supposons que nous souhaitions personnaliser un grand modèle de langage LLM pour les critiques de films, laisser l'utilisateur saisir un nom de film, puis le modèle peut générer des commentaires sur le film.

Tout d'abord, nous devons préparer les données d'entraînement et récupérer les données. Des articles de critiques de films, des actualités, des messages de forum, etc. pertinents peuvent être obtenus sur Internet sous forme de données de formation et de données de récupération.

Ensuite, nous pouvons utiliser le framework de la série GPT d'OpenAI pour former le grand modèle de langage LLM. Au cours du processus de formation, le modèle peut être affiné pour la tâche de critique de film, comme l'ajustement du vocabulaire, du corpus, etc.

Ensuite, nous pouvons créer un système de récupération basé sur des mots-clés pour récupérer des informations pertinentes à partir de corpus de textes à grande échelle. Dans cet exemple, nous pouvons utiliser le titre du film comme mot-clé pour récupérer les critiques pertinentes à partir des données d'entraînement et des données de récupération.

Enfin, nous combinons le système de récupération avec le grand modèle de langage LLM pour obtenir une génération de récupération améliorée. Plus précisément, vous pouvez d'abord utiliser un système de récupération pour récupérer les commentaires liés aux titres de films à partir d'un corpus de texte à grande échelle, puis utiliser le grand modèle de langage LLM pour réorganiser et combiner ces commentaires afin de générer un texte répondant aux exigences.

Ce qui suit est un exemple de code pour implémenter le processus ci-dessus à l'aide de Python et de la bibliothèque GPT :

1 |

|

Exemple 2 : Aidez les utilisateurs à répondre aux questions sur la programmation

Tout d'abord, nous avons besoin d'un système de récupération simple, tel que l'utilisation d'Elasticsearch. Nous pouvons ensuite écrire du code en utilisant Python pour connecter le modèle LLM à Elasticsearch et l'affiner. Voici un exemple de code simple :

1 |

|

Cet exemple de code Python montre comment utiliser un modèle GPT-2 en conjonction avec Elasticsearch pour obtenir une génération améliorée par récupération. Dans cet exemple, nous supposons qu'il existe un index appelé « knowledge_base » qui stocke les informations liées à la programmation. Dans la fonction retrieve_information, nous exécutons une simple requête Elasticsearch, puis dans la fonction generate_text_with_retrieval, nous intégrons les informations récupérées et générons la réponse à l'aide du modèle GPT-2.

Lorsqu'un utilisateur pose une question sur une fonction Python, le code récupère les informations pertinentes d'Elasticsearch, les intègre dans la requête de l'utilisateur, puis utilise le modèle GPT-2 pour générer une réponse.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Explorez les concepts, les différences, les avantages et les inconvénients de RNN, LSTM et GRU

Jan 22, 2024 pm 07:51 PM

Explorez les concepts, les différences, les avantages et les inconvénients de RNN, LSTM et GRU

Jan 22, 2024 pm 07:51 PM

Dans les données de séries chronologiques, il existe des dépendances entre les observations, elles ne sont donc pas indépendantes les unes des autres. Cependant, les réseaux de neurones traditionnels traitent chaque observation comme indépendante, ce qui limite la capacité du modèle à modéliser des données de séries chronologiques. Pour résoudre ce problème, le réseau neuronal récurrent (RNN) a été introduit, qui a introduit le concept de mémoire pour capturer les caractéristiques dynamiques des données de séries chronologiques en établissant des dépendances entre les points de données du réseau. Grâce à des connexions récurrentes, RNN peut transmettre des informations antérieures à l'observation actuelle pour mieux prédire les valeurs futures. Cela fait de RNN un outil puissant pour les tâches impliquant des données de séries chronologiques. Mais comment RNN parvient-il à obtenir ce type de mémoire ? RNN réalise la mémoire via la boucle de rétroaction dans le réseau neuronal. C'est la différence entre RNN et le réseau neuronal traditionnel.

Calcul des opérandes à virgule flottante (FLOPS) pour les réseaux de neurones

Jan 22, 2024 pm 07:21 PM

Calcul des opérandes à virgule flottante (FLOPS) pour les réseaux de neurones

Jan 22, 2024 pm 07:21 PM

FLOPS est l'une des normes d'évaluation des performances informatiques, utilisée pour mesurer le nombre d'opérations en virgule flottante par seconde. Dans les réseaux de neurones, FLOPS est souvent utilisé pour évaluer la complexité informatique du modèle et l'utilisation des ressources informatiques. C'est un indicateur important utilisé pour mesurer la puissance de calcul et l'efficacité d'un ordinateur. Un réseau de neurones est un modèle complexe composé de plusieurs couches de neurones utilisées pour des tâches telles que la classification, la régression et le clustering des données. La formation et l'inférence des réseaux de neurones nécessitent un grand nombre de multiplications matricielles, de convolutions et d'autres opérations de calcul, la complexité de calcul est donc très élevée. FLOPS (FloatingPointOperationsperSecond) peut être utilisé pour mesurer la complexité de calcul des réseaux de neurones afin d'évaluer l'efficacité d'utilisation des ressources de calcul du modèle. FIASCO

Une étude de cas sur l'utilisation du modèle LSTM bidirectionnel pour la classification de texte

Jan 24, 2024 am 10:36 AM

Une étude de cas sur l'utilisation du modèle LSTM bidirectionnel pour la classification de texte

Jan 24, 2024 am 10:36 AM

Le modèle LSTM bidirectionnel est un réseau neuronal utilisé pour la classification de texte. Vous trouverez ci-dessous un exemple simple montrant comment utiliser le LSTM bidirectionnel pour les tâches de classification de texte. Tout d'abord, nous devons importer les bibliothèques et modules requis : importosimportnumpyasnpfromkeras.preprocessing.textimportTokenizerfromkeras.preprocessing.sequenceimportpad_sequencesfromkeras.modelsimportSequentialfromkeras.layersimportDense,Em

Définition et analyse structurelle du réseau neuronal flou

Jan 22, 2024 pm 09:09 PM

Définition et analyse structurelle du réseau neuronal flou

Jan 22, 2024 pm 09:09 PM

Le réseau de neurones flous est un modèle hybride qui combine la logique floue et les réseaux de neurones pour résoudre des problèmes flous ou incertains difficiles à gérer avec les réseaux de neurones traditionnels. Sa conception s'inspire du flou et de l'incertitude de la cognition humaine, c'est pourquoi il est largement utilisé dans les systèmes de contrôle, la reconnaissance de formes, l'exploration de données et d'autres domaines. L'architecture de base du réseau neuronal flou se compose d'un sous-système flou et d'un sous-système neuronal. Le sous-système flou utilise la logique floue pour traiter les données d'entrée et les convertir en ensembles flous pour exprimer le flou et l'incertitude des données d'entrée. Le sous-système neuronal utilise des réseaux de neurones pour traiter des ensembles flous pour des tâches telles que la classification, la régression ou le clustering. L'interaction entre le sous-système flou et le sous-système neuronal confère au réseau neuronal flou des capacités de traitement plus puissantes et peut

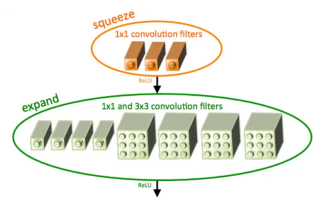

Introduction à SqueezeNet et ses caractéristiques

Jan 22, 2024 pm 07:15 PM

Introduction à SqueezeNet et ses caractéristiques

Jan 22, 2024 pm 07:15 PM

SqueezeNet est un algorithme petit et précis qui établit un bon équilibre entre haute précision et faible complexité, ce qui le rend idéal pour les systèmes mobiles et embarqués aux ressources limitées. En 2016, des chercheurs de DeepScale, de l'Université de Californie à Berkeley et de l'Université de Stanford ont proposé SqueezeNet, un réseau neuronal convolutif (CNN) compact et efficace. Ces dernières années, les chercheurs ont apporté plusieurs améliorations à SqueezeNet, notamment SqueezeNetv1.1 et SqueezeNetv2.0. Les améliorations apportées aux deux versions augmentent non seulement la précision, mais réduisent également les coûts de calcul. Précision de SqueezeNetv1.1 sur l'ensemble de données ImageNet

Débruitage d'image à l'aide de réseaux de neurones convolutifs

Jan 23, 2024 pm 11:48 PM

Débruitage d'image à l'aide de réseaux de neurones convolutifs

Jan 23, 2024 pm 11:48 PM

Les réseaux de neurones convolutifs fonctionnent bien dans les tâches de débruitage d'images. Il utilise les filtres appris pour filtrer le bruit et restaurer ainsi l'image originale. Cet article présente en détail la méthode de débruitage d'image basée sur un réseau neuronal convolutif. 1. Présentation du réseau neuronal convolutif Le réseau neuronal convolutif est un algorithme d'apprentissage en profondeur qui utilise une combinaison de plusieurs couches convolutives, des couches de regroupement et des couches entièrement connectées pour apprendre et classer les caractéristiques de l'image. Dans la couche convolutive, les caractéristiques locales de l'image sont extraites via des opérations de convolution, capturant ainsi la corrélation spatiale dans l'image. La couche de pooling réduit la quantité de calcul en réduisant la dimension des fonctionnalités et conserve les principales fonctionnalités. La couche entièrement connectée est responsable du mappage des fonctionnalités et des étiquettes apprises pour mettre en œuvre la classification des images ou d'autres tâches. La conception de cette structure de réseau rend les réseaux de neurones convolutifs utiles dans le traitement et la reconnaissance d'images.

Étapes pour écrire un réseau neuronal simple à l'aide de Rust

Jan 23, 2024 am 10:45 AM

Étapes pour écrire un réseau neuronal simple à l'aide de Rust

Jan 23, 2024 am 10:45 AM

Rust est un langage de programmation au niveau système axé sur la sécurité, les performances et la concurrence. Il vise à fournir un langage de programmation sûr et fiable adapté à des scénarios tels que les systèmes d'exploitation, les applications réseau et les systèmes embarqués. La sécurité de Rust vient principalement de deux aspects : le système de propriété et le vérificateur d'emprunt. Le système de propriété permet au compilateur de vérifier le code pour détecter les erreurs de mémoire au moment de la compilation, évitant ainsi les problèmes courants de sécurité de la mémoire. En forçant la vérification des transferts de propriété des variables au moment de la compilation, Rust garantit que les ressources mémoire sont correctement gérées et libérées. Le vérificateur d'emprunt analyse le cycle de vie de la variable pour garantir que la même variable ne sera pas accédée par plusieurs threads en même temps, évitant ainsi les problèmes de sécurité de concurrence courants. En combinant ces deux mécanismes, Rust est capable de fournir

Réseau de neurones jumeaux : analyse des principes et des applications

Jan 24, 2024 pm 04:18 PM

Réseau de neurones jumeaux : analyse des principes et des applications

Jan 24, 2024 pm 04:18 PM

Le réseau neuronal siamois est une structure de réseau neuronal artificiel unique. Il se compose de deux réseaux de neurones identiques partageant les mêmes paramètres et poids. Dans le même temps, les deux réseaux partagent également les mêmes données d’entrée. Cette conception a été inspirée par des jumeaux, car les deux réseaux de neurones sont structurellement identiques. Le principe du réseau neuronal siamois est d'accomplir des tâches spécifiques, telles que la correspondance d'images, la correspondance de textes et la reconnaissance de visages, en comparant la similitude ou la distance entre deux données d'entrée. Pendant la formation, le réseau tente de mapper des données similaires vers des régions adjacentes et des données différentes vers des régions distantes. De cette manière, le réseau peut apprendre à classer ou à faire correspondre différentes données pour obtenir des résultats correspondants.