L'algorithme Random Forest est une technique d'ensemble capable d'effectuer des tâches de régression et de classification en utilisant plusieurs arbres de décision et une technique appelée Bootstrap et agrégation. L’idée de base est de combiner plusieurs arbres de décision pour déterminer le résultat final, plutôt que de s’appuyer sur un seul arbre de décision.

La forêt aléatoire produit un grand nombre d'arbres de classification. Placez le vecteur d'entrée sous chaque arbre de la forêt pour classer les nouveaux objets en fonction du vecteur d'entrée. Chaque arbre se voit attribuer une classe, que nous pouvons appeler un « vote », et la classe ayant obtenu le plus grand nombre de votes est finalement choisie.

Les étapes suivantes nous aideront à comprendre le fonctionnement de l'algorithme de forêt aléatoire.

Étape 1 : Sélectionnez d'abord un échantillon aléatoire dans l'ensemble de données.

Étape 2 : Pour chaque échantillon, l'algorithme créera un arbre de décision. Les résultats de prédiction pour chaque arbre de décision seront ensuite obtenus.

Étape 3 : Chaque résultat attendu dans cette étape sera voté.

Étape 4 : Enfin, sélectionnez le résultat de la prédiction avec le plus de votes comme résultat de la prédiction finale.

Voici les principales caractéristiques de l'algorithme Random Forest :

La forêt aléatoire a plusieurs arbres de décision comme modèle d'apprentissage de base. Nous effectuons de manière aléatoire un échantillonnage de lignes et un échantillonnage de caractéristiques à partir de l'ensemble de données pour former un échantillon d'ensemble de données pour chaque modèle. Cette partie s'appelle le bootstrap.

Étape 1 : Importez les bibliothèques requises.

import numpy as np import matplotlib.pyplot as plt import pandas as pd

Étape 2 : Importez et imprimez l'ensemble de données

ata=pd.read_csv('Salaries.csv') print(data)

Étape 3 : Sélectionnez toutes les lignes et la colonne 1 de l'ensemble de données vers x, sélectionnez toutes les lignes et la colonne 2 comme y

x=df.iloc[: ,:-1] #": signifie qu'il sélectionnera toutes les lignes, ":-1" signifie qu'il ignorera la dernière colonne

y=df.iloc[:,-1:]#": signifie qu'il sélectionnera toutes les lignes, "- 1:" signifie qu'il ignorera toutes les colonnes sauf la dernière colonne

#La fonction "iloc()" nous permet de sélectionner des cellules spécifiques de l'ensemble de données, c'est-à-dire qu'elle nous aide à sélectionner les cellules spécifiques de l'ensemble de données à partir du bloc de données ou un ensemble de données Sélectionne la valeur appartenant à une ligne ou une colonne spécifique parmi un ensemble de valeurs.

Étape 4 : Ajuster un régresseur forestier aléatoire à l'ensemble de données

from sklearn.ensemble import RandomForestRegressor regressor=RandomForestRegressor(n_estimators=100,random_state=0) regressor.fit(x,y)

Étape 5 : Prédire de nouveaux résultats

Y_pred=regressor.predict(np.array([6.5]).reshape(1,1))

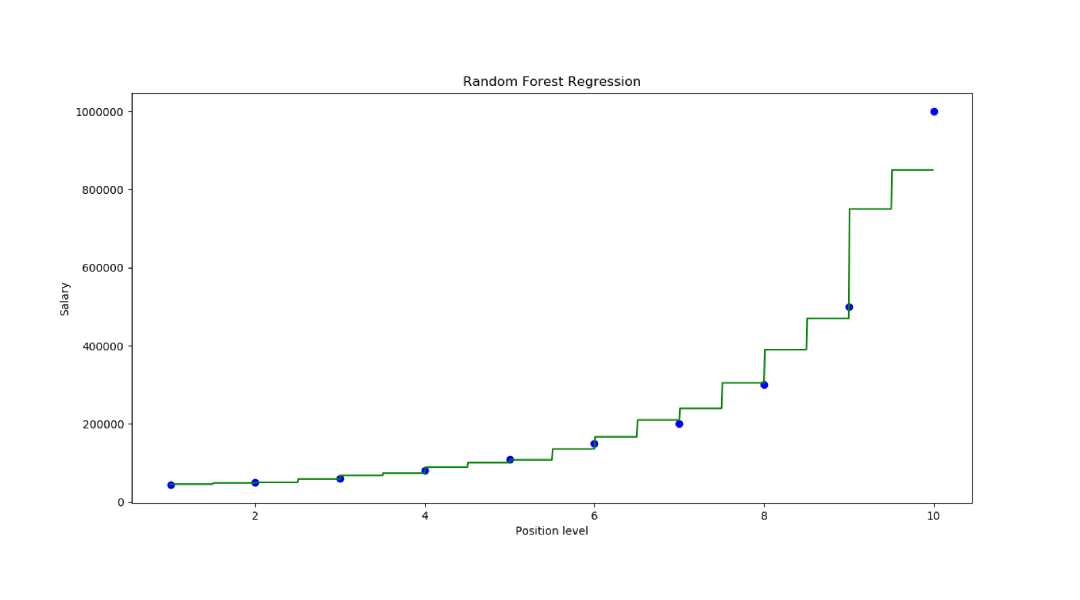

Étape 6 : Visualiser les résultats

X_grid=np.arrange(min(x),max(x),0.01) X_grid=X_grid.reshape((len(X_grid),1)) plt.scatter(x,y,color='blue') plt.plot(X_grid,regressor.predict(X_grid), color='green') plt.title('Random Forest Regression') plt.xlabel('Position level') plt.ylabel('Salary') plt.show()

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Que dois-je faire si le fichier chm ne peut pas être ouvert ?

Que dois-je faire si le fichier chm ne peut pas être ouvert ?

Étapes WeChat

Étapes WeChat

Utilisation de base de FTP

Utilisation de base de FTP

ps supprimer la zone sélectionnée

ps supprimer la zone sélectionnée

Tri des tableaux JS : méthode sort()

Tri des tableaux JS : méthode sort()

Que signifie l'URL ?

Que signifie l'URL ?

Comment définir la transparence de la couleur de la police HTML

Comment définir la transparence de la couleur de la police HTML

Méthode d'ouverture de l'autorisation de portée

Méthode d'ouverture de l'autorisation de portée

exigences de configuration matérielle du serveur Web

exigences de configuration matérielle du serveur Web