Périphériques technologiques

Périphériques technologiques

IA

IA

TimePillars : Où peut-on étendre la voie de détection 3D pure LiDAR ? Couverture directe de 200m !

TimePillars : Où peut-on étendre la voie de détection 3D pure LiDAR ? Couverture directe de 200m !

TimePillars : Où peut-on étendre la voie de détection 3D pure LiDAR ? Couverture directe de 200m !

La détection d'objets 3D basée sur un nuage de points LiDAR est un problème très classique. Le monde universitaire et l'industrie ont proposé divers modèles pour améliorer la précision, la vitesse et la robustesse. Cependant, en raison de l'environnement extérieur complexe, les performances de la détection d'objets pour les nuages de points extérieurs ne sont pas très bonnes. Les nuages de points LiDAR sont de nature clairsemée. Comment résoudre ce problème de manière ciblée ? L'article donne sa propre réponse : extraire des informations sur la base de l'agrégation d'informations de séries chronologiques.

Écrit avant

Cet article aborde principalement un défi important auquel est confrontée la conduite autonome : comment établir avec précision une représentation tridimensionnelle de l'environnement environnant. Ceci est essentiel pour garantir la fiabilité et la sécurité des véhicules autonomes. En particulier, les véhicules autonomes doivent être capables de reconnaître les objets environnants, tels que les véhicules et les piétons, et de déterminer avec précision leur emplacement, leur taille et leur orientation. En règle générale, les gens utilisent des réseaux de neurones profonds pour traiter les données LiDAR afin d'accomplir cette tâche.

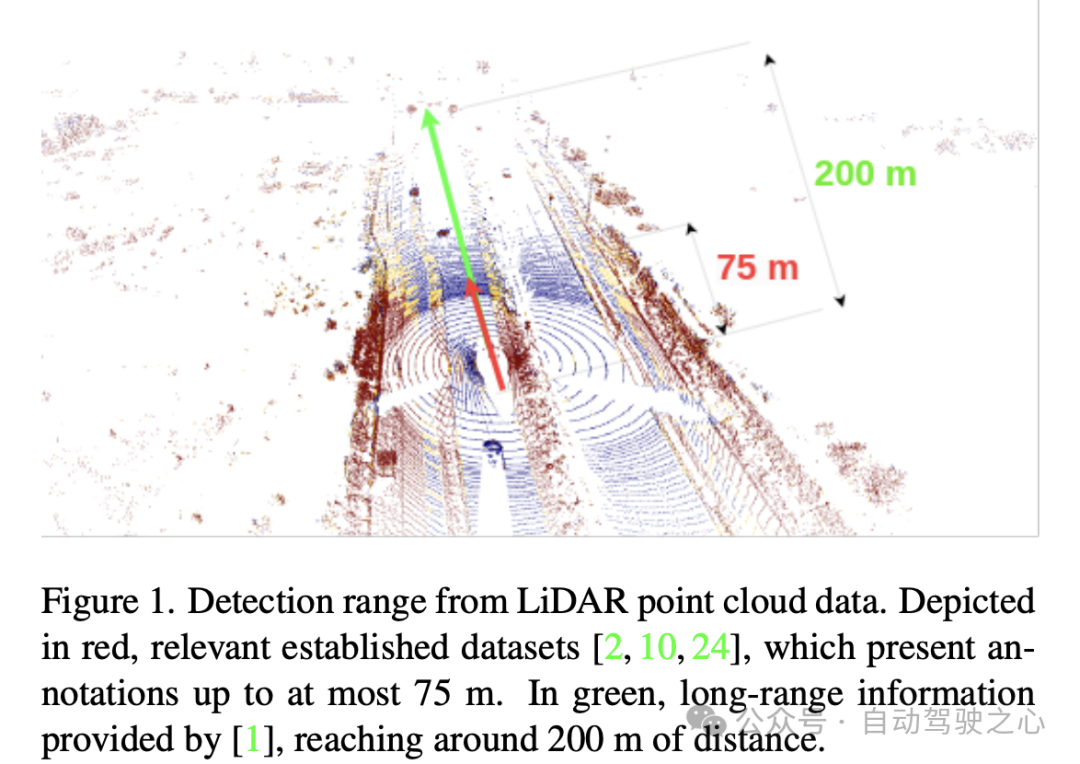

Les recherches actuelles se concentrent principalement sur les méthodes à image unique, c'est-à-dire utilisant les données d'un seul balayage de capteur à la fois. Cette méthode fonctionne bien sur les benchmarks classiques, détectant des objets à des distances allant jusqu'à 75 mètres. Cependant, la rareté des nuages de points lidar est particulièrement évidente à longue distance. Par conséquent, les chercheurs estiment qu’il ne suffit pas de se fier uniquement à un seul scan pour une détection à longue distance, par exemple jusqu’à une distance de 200 mètres. Par conséquent, les recherches futures doivent se concentrer sur la résolution de ce défi.

Pour résoudre ce problème, une solution consiste à utiliser l'agrégation de nuages de points, qui consiste à concaténer une série de données d'analyse lidar pour obtenir une entrée plus dense. Cependant, cette approche est coûteuse en termes de calcul et ne tire pas pleinement parti de l’agrégation au sein du réseau. Pour réduire les coûts de calcul et mieux utiliser les informations, envisagez d'utiliser des méthodes récursives. Les méthodes récursives accumulent des informations au fil du temps et produisent des résultats plus précis en fusionnant de manière itérative l'entrée actuelle avec les résultats agrégés précédents. Cette méthode peut non seulement améliorer l'efficacité des calculs, mais également utiliser efficacement les informations historiques pour améliorer la précision des prévisions. Les méthodes récursives ont de nombreuses applications dans les problèmes d'agrégation de nuages de points et ont obtenu des résultats satisfaisants.

L'article mentionne également que afin d'augmenter la plage de détection, certaines opérations avancées peuvent être utilisées, telles que la convolution clairsemée, le module d'attention et la convolution 3D. Cependant, ces opérations ignorent généralement les problèmes de compatibilité du matériel cible. Lors du déploiement et de la formation de réseaux neuronaux, le matériel utilisé diffère souvent considérablement en termes d'opérations prises en charge et de latence. Par exemple, le matériel cible tel que Nvidia Orin DLA ne prend souvent pas en charge des opérations telles que la convolution ou l'attention éparse. De plus, l’utilisation de couches telles que les convolutions 3D n’est souvent pas réalisable en raison des exigences de latence en temps réel. Cela souligne la nécessité d’utiliser des opérations simples telles que la convolution 2D.

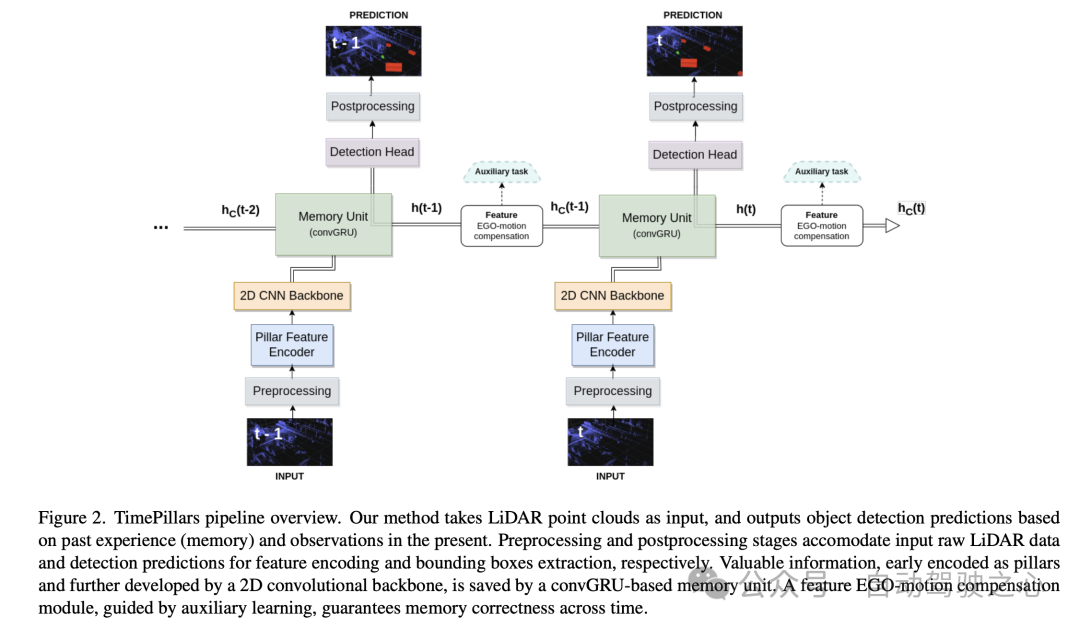

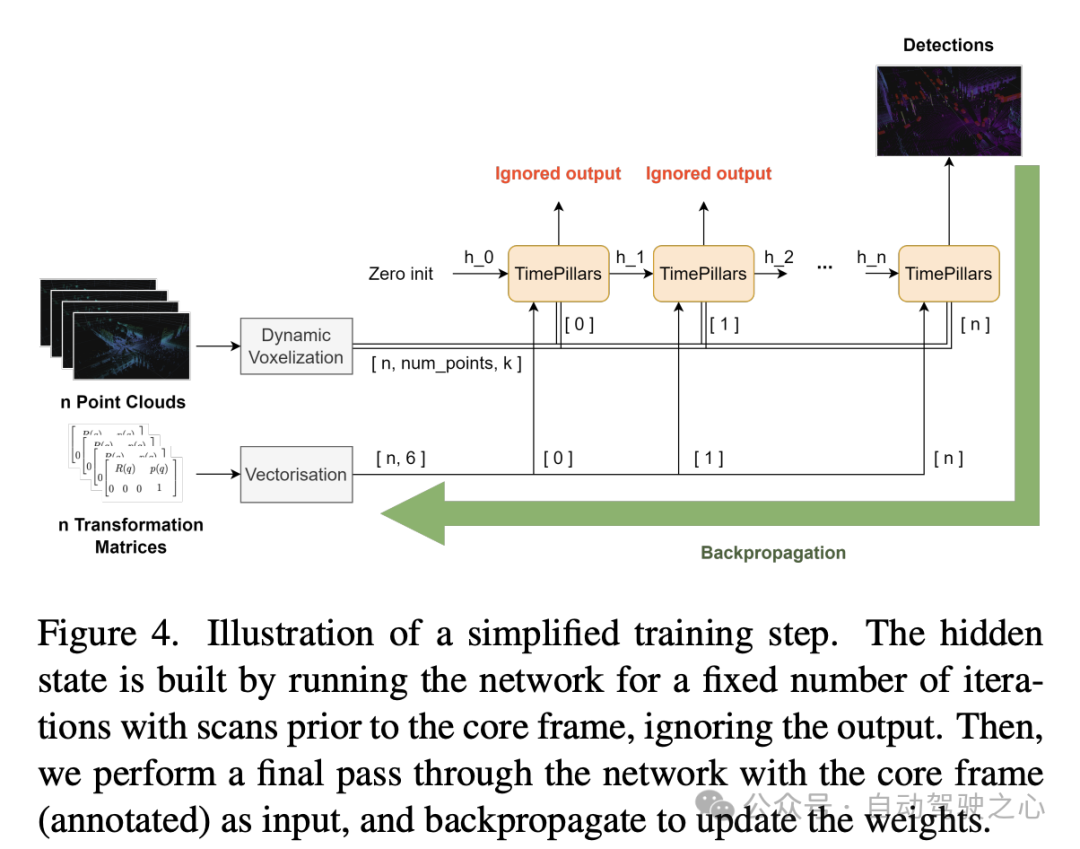

L'article propose un nouveau modèle récursif temporel, TimePillars, qui respecte l'ensemble des opérations prises en charge sur le matériel cible commun, s'appuie sur la convolution 2D, est basé sur une représentation d'entrée point-pilier (Pillar) et une unité récursive convolutive. La compensation du mouvement automatique est appliquée à l'état caché de l'unité récurrente à l'aide d'une convolution unique et d'un apprentissage auxiliaire. Des études d'ablation ont montré que l'utilisation de tâches auxiliaires pour garantir l'exactitude de cette manipulation est appropriée. L'article étudie également le placement optimal du module récursif dans le pipeline et montre clairement que le placer entre l'épine dorsale du réseau et la tête de détection permet d'obtenir les meilleures performances. Sur le nouveau Zenseact Open Dataset (ZOD), l'article démontre l'efficacité de la méthode TimePillars. Par rapport aux lignes de base point et pilier à image unique et multi-images, TimePillars permet d'obtenir des améliorations significatives des performances d'évaluation, en particulier pour la détection à longue portée (jusqu'à 200 mètres) dans les catégories importantes de cyclistes et de piétons. Enfin, les TimePillars ont une latence nettement inférieure à celle des piliers multi-trames, ce qui les rend adaptés aux systèmes en temps réel.

Cet article propose un nouveau modèle récursif temporel appelé TimePillars pour résoudre la tâche de détection d'objets lidar 3D et considère l'ensemble des opérations prises en charge par le matériel cible commun. Des expériences ont prouvé que TimePillars atteint des performances nettement meilleures que les lignes de base à piliers ponctuels à image unique et multi-images dans la détection longue distance. En outre, l’article compare également pour la première fois un modèle de détection d’objets lidar 3D sur l’ensemble de données ouvertes Zenseact. Cependant, les limites de l'article sont qu'il se concentre uniquement sur les données LiDAR, ne prend pas en compte les autres entrées de capteurs et fonde son approche sur une seule base de référence de pointe. Néanmoins, les auteurs estiment que leur cadre est général, c'est-à-dire que les améliorations futures de la base de référence se traduiront par des améliorations globales des performances.

Explication détaillée de TimePillars

Prétraitement d'entrée

Dans la section « Prétraitement d'entrée » de cet article, l'auteur utilise une technique appelée « pilarisation » pour traiter les données du nuage de points d'entrée. Différente de la voxélisation conventionnelle, cette méthode segmente le nuage de points en structures en colonnes verticales, segmentant uniquement dans la direction horizontale (axes x et y) tout en conservant une hauteur fixe dans la direction verticale (axe z). L'avantage de cette méthode de traitement est qu'elle peut maintenir la cohérence de la taille d'entrée du réseau et utiliser la convolution 2D pour un traitement efficace. De cette manière, les données des nuages de points peuvent être traitées efficacement, fournissant ainsi une entrée plus précise et plus fiable pour les tâches ultérieures.

Cependant, un problème avec la pilarisation est qu'elle produit de nombreuses colonnes vides, ce qui entraîne des données très clairsemées. Pour résoudre ce problème, l'article propose l'utilisation de la technologie de voxélisation dynamique. Cette technique évite d'avoir un nombre prédéfini de points pour chaque colonne, éliminant ainsi le besoin d'opérations de troncature ou de remplissage sur chaque colonne. Au lieu de cela, l'intégralité des données du nuage de points est traitée dans son ensemble pour correspondre au nombre total de points requis, fixé ici à 200 000 points. L'avantage de cette méthode de prétraitement est qu'elle minimise la perte d'informations et rend la représentation des données générées plus stable et cohérente.

Architecture du modèle

Puis pour l'architecture du modèle, l'auteur présente en détail une architecture de réseau neuronal composée d'un encodeur de fonctionnalités pilier (Pillar Feature Encoder), d'un squelette de réseau neuronal convolutionnel (CNN) 2D et d'une tête de détection.

- Pillar Feature Encoder : cette partie mappe le tenseur d'entrée prétraité dans une pseudo-image Bird's Eye View (BEV). Après avoir utilisé la voxélisation dynamique, le PointNet simplifié est ajusté en conséquence. L'entrée est traitée par convolution 1D, normalisation par lots et fonction d'activation ReLU, ce qui donne un tenseur de forme , où représente le nombre de canaux. Avant la couche finale de dispersion maximale, une mise en commun maximale est appliquée aux canaux, formant un espace de forme latent . Puisque le tenseur initial est codé comme , qui devient après la couche précédente, l'opération de pooling maximum est supprimée.

- Backbone : Utilisation de l'architecture de base CNN 2D proposée dans l'article en colonnes original en raison de son efficacité en profondeur supérieure. L'espace latent est réduit à l'aide de trois blocs de sous-échantillonnage (Conv2D-BN-ReLU) et restauré à l'aide de trois blocs de suréchantillonnage et d'une convolution transposée, avec une forme de sortie de .

- Memory Unit : modélisez la mémoire du système comme un réseau neuronal récurrent (RNN), en utilisant spécifiquement le GRU convolutif (convGRU), qui est la version convolutive de Gated Recurrent Unit. L’avantage du GRU convolutif est qu’il évite le problème du gradient de disparition et améliore l’efficacité tout en conservant les caractéristiques des données spatiales. Comparé à d'autres options telles que LSTM, GRU a moins de paramètres entraînables en raison de son plus petit nombre de portes et peut être considéré comme une technique de régularisation de la mémoire (réduisant la complexité des états cachés). En fusionnant des opérations de nature similaire, le nombre de couches convolutives requises est réduit, ce qui rend l'unité plus efficace.

- Tête de détection : Une simple modification du SSD (Single Shot MultiBox Detector). Le concept de base du SSD est conservé, c'est-à-dire un passage unique sans proposition de région, mais l'utilisation de boîtes d'ancrage est éliminée. La production directe de prédictions pour chaque cellule de la grille, bien que perdant la capacité de détection multi-objets des cellules, évite les ajustements fastidieux et souvent imprécis des paramètres de la boîte d'ancrage et simplifie le processus d'inférence. La couche linéaire gère les sorties respectives de la régression de classification et de localisation (position, taille et angle). Seule la taille utilise une fonction d'activation (ReLU) pour éviter de prendre des valeurs négatives. De plus, contrairement à la littérature connexe, cet article évite le problème de la régression angulaire directe en prédisant indépendamment les composantes sinus et cosinus de la direction de conduite du véhicule et en en extrayant les angles.

Feature Ego-Motion Compensation

Dans cette partie de l'article, l'auteur explique comment traiter les caractéristiques d'état caché sorties par le GRU convolutionnel, qui sont représentées par le système de coordonnées de la trame précédente. S'il est stocké directement et utilisé pour calculer la prochaine prédiction, une inadéquation spatiale se produira en raison du mouvement de l'ego.

Pour la conversion, différentes techniques peuvent être appliquées. Idéalement, les données corrigées seraient introduites dans le réseau plutôt que transformées au sein du réseau. Cependant, ce n’est pas l’approche proposée dans l’article, car elle nécessite de réinitialiser les états cachés à chaque étape du processus d’inférence, de transformer les nuages de points précédents et de les propager à travers le réseau. Non seulement cela est inefficace, mais cela va à l’encontre de l’objectif de l’utilisation des RNN. Par conséquent, dans un contexte de boucle, la compensation doit être effectuée au niveau des fonctionnalités. Cela rend la solution hypothétique plus efficace, mais rend également le problème plus complexe. Les méthodes d'interpolation traditionnelles peuvent être utilisées pour obtenir des caractéristiques dans des systèmes de coordonnées transformés.

En revanche, inspiré des travaux de Chen et al., l'article propose d'utiliser des opérations de convolution et des tâches auxiliaires pour effectuer des transformations. Compte tenu des détails limités des travaux susmentionnés, l'article propose une solution personnalisée à ce problème.

L'approche adoptée par le document consiste à fournir au réseau les informations nécessaires pour effectuer la transformation des fonctionnalités via une couche convolutive supplémentaire. La matrice de transformation relative entre deux images consécutives est d'abord calculée, c'est-à-dire les opérations nécessaires pour réussir la transformation des caractéristiques. Ensuite, extrayez-en les informations 2D (partie rotation et translation) :

Cette simplification évite les principales constantes matricielles et fonctionne dans le domaine 2D (pseudo-image), réduisant 16 valeurs à 6. La matrice est ensuite aplatie et agrandie pour épouser la forme des éléments cachés à compenser. La première dimension représente le nombre d'images à convertir. Cette représentation permet de concaténer chaque pilier potentiel dans la dimension canal de l'entité cachée.

Enfin, les caractéristiques de l'état caché sont introduites dans une couche convolutive 2D, adaptée au processus de transformation. Un aspect clé à noter est que réaliser une convolution ne garantit pas que la transformation aura lieu. La concaténation des canaux fournit simplement au réseau des informations supplémentaires sur la manière dont la transformation peut être effectuée. Dans ce cas, le recours à l’apprentissage assisté est approprié. Lors de la formation, un objectif d'apprentissage supplémentaire (transformation de coordonnées) est ajouté en parallèle à l'objectif principal (détection d'objets). Une tâche auxiliaire est conçue dont le but est de guider le réseau à travers le processus de transformation sous supervision pour garantir l'exactitude de la compensation. La tâche auxiliaire est limitée au processus de formation. Une fois que le réseau apprend à transformer correctement les fonctionnalités, il perd son applicabilité. Par conséquent, cette tâche n’est pas prise en compte lors de l’inférence. Dans la section suivante, d’autres expériences seront menées pour comparer l’impact.

Expériences

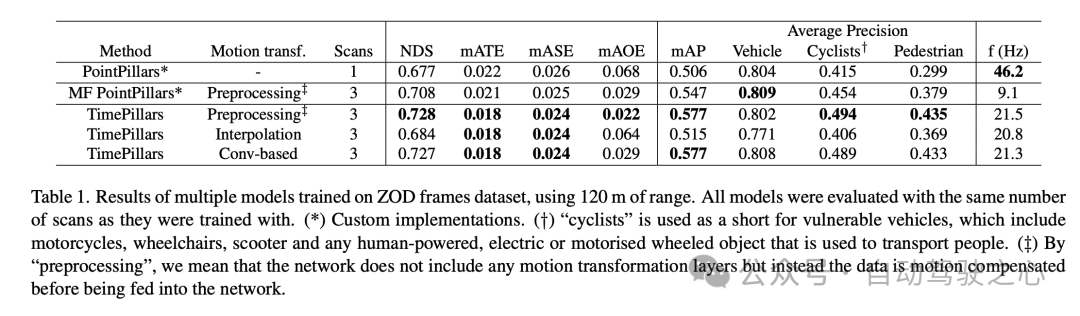

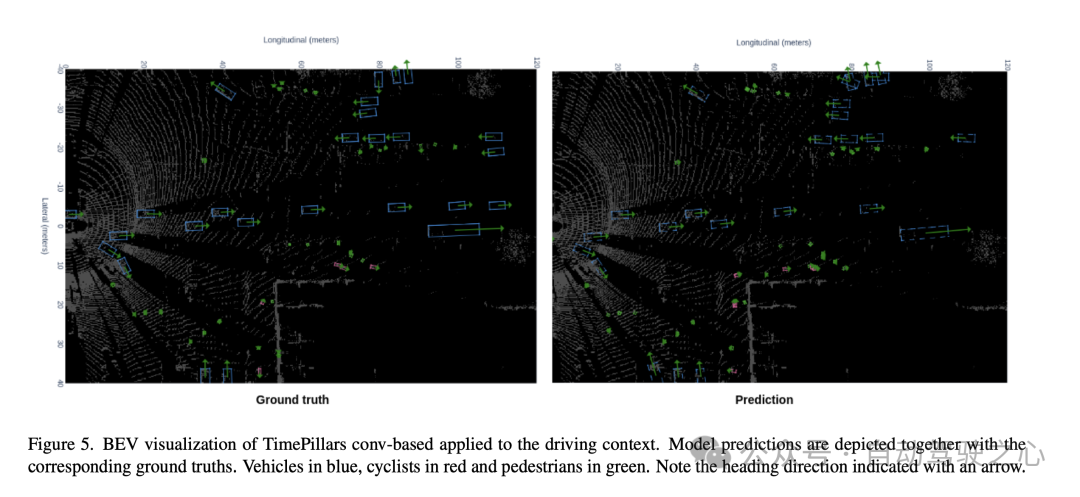

Les résultats expérimentaux montrent que le modèle TimePillars fonctionne bien lors du traitement de l'ensemble de données de trame Zenseact Open Dataset (ZOD), en particulier lors du traitement de plages allant jusqu'à 120 mètres. Ces résultats mettent en évidence les différences de performances de TimePillars selon différentes méthodes de transformation de mouvement et les comparent avec d'autres méthodes.

Après avoir comparé le modèle de base PointPillars et les PointPillars multi-frame (MF), on peut constater que TimePillars a obtenu des améliorations significatives dans plusieurs indicateurs de performance clés. En particulier sur le score de détection NuScenes (NDS), TimePillars affiche un score global plus élevé, reflétant ses avantages en termes de performances de détection et de précision de positionnement. De plus, TimePillars a également atteint des valeurs inférieures en termes d'erreur de conversion moyenne (mATE), d'erreur d'échelle moyenne (mASE) et d'erreur d'orientation moyenne (mAOE), ce qui indique qu'il est plus précis dans la précision de positionnement et l'estimation de l'orientation. Il convient de noter en particulier que les différentes implémentations de TimePillars en termes de conversion de mouvement ont un impact significatif sur les performances. Lors de l'utilisation d'une transformation de mouvement basée sur la convolution (Conv-based), TimePillars fonctionne particulièrement bien sur NDS, mATE, mASE et mAOE, prouvant l'efficacité de cette méthode en matière de compensation de mouvement et d'amélioration de la précision de détection. En revanche, TimePillars utilisant la méthode d'interpolation surpasse également le modèle de base, mais est inférieur à la méthode de convolution pour certains indicateurs. Les résultats de précision moyenne (mAP) montrent que TimePillars fonctionne bien dans la détection des catégories de véhicules, de cyclistes et de piétons, en particulier lorsqu'il s'agit de catégories plus difficiles telles que les cyclistes et les piétons, son amélioration des performances est plus significative. Du point de vue de la fréquence de traitement (f (Hz)), bien que les TimePillars ne soient pas aussi rapides que les PointPillars à image unique, ils sont plus rapides que les PointPillars à images multiples tout en conservant des performances de détection élevées. Cela montre que TimePillars peut effectuer efficacement une détection longue distance et une compensation de mouvement tout en maintenant un traitement en temps réel. En d’autres termes, le modèle TimePillars présente des avantages significatifs en matière de détection longue distance, de compensation de mouvement et de vitesse de traitement, en particulier lors du traitement de données multi-images et de l’utilisation d’une technologie de conversion de mouvement basée sur la convolution. Ces résultats mettent en évidence le potentiel d’application de TimePillars dans le domaine de la détection d’objets lidar 3D pour les véhicules autonomes.

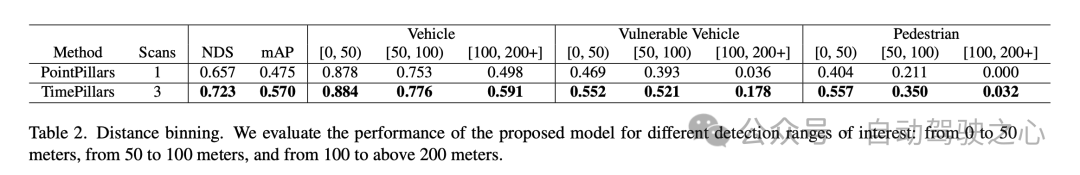

Les résultats expérimentaux ci-dessus montrent que le modèle TimePillars fonctionne parfaitement en termes de performances de détection d'objets dans différentes plages de distance, en particulier par rapport au modèle de référence PointPillars. Ces résultats sont répartis en trois plages de détection principales : 0 à 50 mètres, 50 à 100 mètres et au-dessus de 100 mètres.

Tout d'abord, le score de détection NuScenes (NDS) et la précision moyenne (mAP) sont les indicateurs de performance globaux. TimePillars surpasse PointPillars sur les deux mesures, affichant des capacités de détection et une précision de positionnement globalement supérieures. Plus précisément, le NDS de TimePillars est de 0,723, ce qui est beaucoup plus élevé que le 0,657 de PointPillars en termes de mAP, TimePillars dépasse également de manière significative le 0,475 de PointPillars avec 0,570 ;

Dans la comparaison des performances dans différentes plages de distance, on peut voir que TimePillars est plus performant dans chaque plage. Pour la catégorie des véhicules, la précision de détection de TimePillars dans les plages de 0 à 50 mètres, de 50 à 100 mètres et de plus de 100 mètres est respectivement de 0,884, 0,776 et 0,591, qui sont toutes supérieures aux performances de PointPillars dans la même plage. Cela montre que TimePillars a une plus grande précision dans la détection des véhicules, à la fois à courte et à longue distance. TimePillars a également démontré de meilleures performances de détection lorsqu'il s'agit de véhicules vulnérables (tels que les motos, les fauteuils roulants, les scooters électriques, etc.). Surtout dans une portée de plus de 100 mètres, la précision de détection de TimePillars est de 0,178, tandis que PointPillars n'est que de 0,036, ce qui montre des avantages significatifs dans la détection longue distance. Pour la détection des piétons, TimePillars a également montré de meilleures performances, notamment dans la plage de 50 à 100 mètres, avec une précision de détection de 0,350, tandis que PointPillars n'était que de 0,211. Même à des distances plus longues (plus de 100 mètres), TimePillars atteint toujours un certain niveau de détection (précision de 0,032), tandis que PointPillars effectue zéro à cette distance.

Ces résultats expérimentaux mettent en évidence les performances supérieures de TimePillars dans la gestion des tâches de détection d'objets dans différentes plages de distance. Que ce soit à courte distance ou à longue distance, plus difficile, les TimePillars fournissent des résultats de détection plus précis et plus fiables, essentiels à la sécurité et à l'efficacité des véhicules autonomes.

Discussion

Tout d'abord, le principal avantage du modèle TimePillars est son efficacité pour la détection d'objets à longue distance. En utilisant la voxélisation dynamique et les structures GRU convolutives, le modèle est mieux à même de gérer des données lidar clairsemées, en particulier dans la détection d'objets à longue portée. Ceci est essentiel pour l’exploitation sûre des véhicules autonomes dans des environnements routiers complexes et changeants. De plus, le modèle affiche également de bonnes performances en termes de vitesse de traitement, essentielle pour les applications temps réel. D'autre part, TimePillars adopte une méthode basée sur la convolution pour la compensation de mouvement, ce qui constitue une amélioration majeure par rapport aux méthodes traditionnelles. Cette approche garantit l'exactitude de la transformation grâce à des tâches auxiliaires lors de la formation, améliorant ainsi la précision du modèle lors de la manipulation d'objets en mouvement.

Cependant, la recherche de cet article présente également certaines limites. Premièrement, même si TimePillars gère bien la détection d'objets distants, cette augmentation des performances peut se faire au détriment d'une certaine vitesse de traitement. Bien que la vitesse du modèle soit toujours adaptée aux applications en temps réel, elle reste néanmoins inférieure à celle des méthodes à image unique. De plus, l’article se concentre principalement sur les données LiDAR et ne prend pas en compte d’autres entrées de capteurs, telles que les caméras ou les radars, ce qui peut limiter l’application du modèle dans des environnements multi-capteurs plus complexes.

C'est-à-dire que TimePillars a montré des avantages significatifs dans la détection d'objets lidar 3D pour les véhicules autonomes, notamment dans la détection longue distance et la compensation de mouvement. Malgré le léger compromis en termes de vitesse de traitement et les limites du traitement des données multi-capteurs, TimePillars représente toujours une avancée importante dans ce domaine.

Conclusion

Ce travail montre qu'il est préférable de prendre en compte les données passées des capteurs plutôt que de simplement exploiter les informations actuelles. L’accès aux informations précédentes sur l’environnement de conduite peut faire face à la nature clairsemée des nuages de points lidar et conduire à des prédictions plus précises. Nous démontrons que les réseaux récurrents sont un moyen approprié pour atteindre ce dernier objectif. Donner de la mémoire au système conduit à une solution plus robuste par rapport aux méthodes d'agrégation de nuages de points qui créent des représentations de données plus denses grâce à un traitement approfondi. La méthode que nous avons proposée, TimePillars, implémente une manière de résoudre le problème récursif. En ajoutant simplement trois couches convolutives supplémentaires au processus d'inférence, nous démontrons que les éléments de base du réseau sont suffisants pour obtenir des résultats significatifs et garantir que les spécifications existantes en matière d'efficacité et d'intégration matérielle sont respectées. Au meilleur de nos connaissances, ce travail fournit les premiers résultats de référence pour la tâche de détection d'objets 3D sur le nouvel ensemble de données ouvert Zenseact. Nous espérons que notre travail pourra contribuer à des routes plus sûres et plus durables à l’avenir.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment résoudre le problème de la longue traîne dans les scénarios de conduite autonome ?

Jun 02, 2024 pm 02:44 PM

Comment résoudre le problème de la longue traîne dans les scénarios de conduite autonome ?

Jun 02, 2024 pm 02:44 PM

Hier, lors de l'entretien, on m'a demandé si j'avais posé des questions à longue traîne, j'ai donc pensé faire un bref résumé. Le problème à longue traîne de la conduite autonome fait référence aux cas extrêmes dans les véhicules autonomes, c'est-à-dire à des scénarios possibles avec une faible probabilité d'occurrence. Le problème perçu de la longue traîne est l’une des principales raisons limitant actuellement le domaine de conception opérationnelle des véhicules autonomes intelligents à véhicule unique. L'architecture sous-jacente et la plupart des problèmes techniques de la conduite autonome ont été résolus, et les 5 % restants des problèmes à longue traîne sont progressivement devenus la clé pour restreindre le développement de la conduite autonome. Ces problèmes incluent une variété de scénarios fragmentés, de situations extrêmes et de comportements humains imprévisibles. La « longue traîne » des scénarios limites dans la conduite autonome fait référence aux cas limites dans les véhicules autonomes (VA). Les cas limites sont des scénarios possibles avec une faible probabilité d'occurrence. ces événements rares

NuScenes dernier SOTA SparseAD : les requêtes clairsemées contribuent à une conduite autonome efficace de bout en bout !

Apr 17, 2024 pm 06:22 PM

NuScenes dernier SOTA SparseAD : les requêtes clairsemées contribuent à une conduite autonome efficace de bout en bout !

Apr 17, 2024 pm 06:22 PM

Écrit à l'avant et point de départ Le paradigme de bout en bout utilise un cadre unifié pour réaliser plusieurs tâches dans les systèmes de conduite autonome. Malgré la simplicité et la clarté de ce paradigme, les performances des méthodes de conduite autonome de bout en bout sur les sous-tâches sont encore loin derrière les méthodes à tâche unique. Dans le même temps, les fonctionnalités de vue à vol d'oiseau (BEV) denses, largement utilisées dans les méthodes de bout en bout précédentes, rendent difficile l'adaptation à davantage de modalités ou de tâches. Un paradigme de conduite autonome de bout en bout (SparseAD) centré sur la recherche clairsemée est proposé ici, dans lequel la recherche clairsemée représente entièrement l'ensemble du scénario de conduite, y compris l'espace, le temps et les tâches, sans aucune représentation BEV dense. Plus précisément, une architecture clairsemée unifiée est conçue pour la connaissance des tâches, notamment la détection, le suivi et la cartographie en ligne. De plus, lourd

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

La détection de cibles est un problème relativement mature dans les systèmes de conduite autonome, parmi lesquels la détection des piétons est l'un des premiers algorithmes à être déployés. Des recherches très complètes ont été menées dans la plupart des articles. Cependant, la perception de la distance à l’aide de caméras fisheye pour une vue panoramique est relativement moins étudiée. En raison de la distorsion radiale importante, la représentation standard du cadre de délimitation est difficile à mettre en œuvre dans les caméras fisheye. Pour alléger la description ci-dessus, nous explorons les conceptions étendues de boîtes englobantes, d'ellipses et de polygones généraux dans des représentations polaires/angulaires et définissons une métrique de segmentation d'instance mIOU pour analyser ces représentations. Le modèle fisheyeDetNet proposé avec une forme polygonale surpasse les autres modèles et atteint simultanément 49,5 % de mAP sur l'ensemble de données de la caméra fisheye Valeo pour la conduite autonome.

La première reconstruction purement visuelle et statique de la conduite autonome

Jun 02, 2024 pm 03:24 PM

La première reconstruction purement visuelle et statique de la conduite autonome

Jun 02, 2024 pm 03:24 PM

Une solution d'annotation purement visuelle utilise principalement la vision ainsi que certaines données du GPS, de l'IMU et des capteurs de vitesse de roue pour l'annotation dynamique. Bien entendu, pour les scénarios de production de masse, il n’est pas nécessaire qu’il s’agisse d’une vision pure. Certains véhicules produits en série seront équipés de capteurs comme le radar à semi-conducteurs (AT128). Si nous créons une boucle fermée de données dans la perspective d'une production de masse et utilisons tous ces capteurs, nous pouvons résoudre efficacement le problème de l'étiquetage des objets dynamiques. Mais notre plan ne prévoit pas de radar à semi-conducteurs. Par conséquent, nous présenterons cette solution d’étiquetage de production de masse la plus courante. Le cœur d’une solution d’annotation purement visuelle réside dans la reconstruction de pose de haute précision. Nous utilisons le schéma de reconstruction de pose de Structure from Motion (SFM) pour garantir la précision de la reconstruction. Mais passe

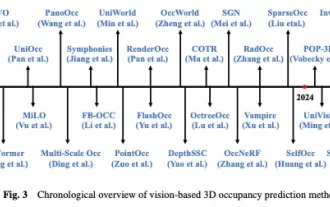

Jetez un œil au passé et au présent de l'Occ et de la conduite autonome ! La première revue résume de manière exhaustive les trois thèmes majeurs de l'amélioration des fonctionnalités/déploiement en production de masse/annotation efficace.

May 08, 2024 am 11:40 AM

Jetez un œil au passé et au présent de l'Occ et de la conduite autonome ! La première revue résume de manière exhaustive les trois thèmes majeurs de l'amélioration des fonctionnalités/déploiement en production de masse/annotation efficace.

May 08, 2024 am 11:40 AM

Écrit ci-dessus et compréhension personnelle de l'auteur Ces dernières années, la conduite autonome a reçu une attention croissante en raison de son potentiel à réduire la charge du conducteur et à améliorer la sécurité de conduite. La prédiction d'occupation tridimensionnelle basée sur la vision est une tâche de perception émergente adaptée à une enquête rentable et complète sur la sécurité de la conduite autonome. Bien que de nombreuses études aient démontré la supériorité des outils de prédiction d’occupation 3D par rapport aux tâches de perception centrée sur les objets, il existe encore des revues dédiées à ce domaine en développement rapide. Cet article présente d'abord le contexte de la prédiction d'occupation 3D basée sur la vision et discute des défis rencontrés dans cette tâche. Ensuite, nous discutons de manière approfondie de l'état actuel et des tendances de développement des méthodes actuelles de prévision d'occupation 3D sous trois aspects : l'amélioration des fonctionnalités, la convivialité du déploiement et l'efficacité de l'étiquetage. enfin

Le LLM est terminé ! OmniDrive : Intégration de la perception 3D et de la planification du raisonnement (la dernière version de NVIDIA)

May 09, 2024 pm 04:55 PM

Le LLM est terminé ! OmniDrive : Intégration de la perception 3D et de la planification du raisonnement (la dernière version de NVIDIA)

May 09, 2024 pm 04:55 PM

Écrit ci-dessus et compréhension personnelle de l'auteur : cet article est dédié à la résolution des principaux défis des grands modèles de langage multimodaux (MLLM) actuels dans les applications de conduite autonome, c'est-à-dire le problème de l'extension des MLLM de la compréhension 2D à l'espace 3D. Cette expansion est particulièrement importante car les véhicules autonomes (VA) doivent prendre des décisions précises concernant les environnements 3D. La compréhension spatiale 3D est essentielle pour les véhicules utilitaires car elle a un impact direct sur la capacité du véhicule à prendre des décisions éclairées, à prédire les états futurs et à interagir en toute sécurité avec l’environnement. Les modèles de langage multimodaux actuels (tels que LLaVA-1.5) ne peuvent souvent gérer que des entrées d'images de résolution inférieure (par exemple) en raison des limitations de résolution de l'encodeur visuel et des limitations de la longueur de la séquence LLM. Cependant, les applications de conduite autonome nécessitent

Vers la « boucle fermée » | PlanAgent : nouveau SOTA pour la planification en boucle fermée de la conduite autonome basée sur MLLM !

Jun 08, 2024 pm 09:30 PM

Vers la « boucle fermée » | PlanAgent : nouveau SOTA pour la planification en boucle fermée de la conduite autonome basée sur MLLM !

Jun 08, 2024 pm 09:30 PM

L'équipe d'apprentissage par renforcement profond de l'Institut d'automatisation de l'Académie chinoise des sciences, en collaboration avec Li Auto et d'autres, a proposé un nouveau cadre de planification en boucle fermée pour la conduite autonome basé sur le modèle multimodal à grand langage MLLM - PlanAgent. Cette méthode prend une vue d'ensemble de la scène et des invites de texte basées sur des graphiques comme entrée, et utilise la compréhension multimodale et les capacités de raisonnement de bon sens du grand modèle de langage multimodal pour effectuer un raisonnement hiérarchique depuis la compréhension de la scène jusqu'à la génération. d'instructions de mouvement horizontal et vertical, et générer en outre les instructions requises par le planificateur. La méthode est testée sur le benchmark nuPlan à grande échelle et exigeant, et les expériences montrent que PlanAgent atteint des performances de pointe (SOTA) dans les scénarios réguliers et à longue traîne. Par rapport aux méthodes conventionnelles de grand modèle de langage (LLM), PlanAgent

Au-delà de BEVFusion ! DifFUSER : Le modèle Diffusion entre dans la conduite autonome multi-tâches (segmentation BEV + détection double SOTA)

Apr 22, 2024 pm 05:49 PM

Au-delà de BEVFusion ! DifFUSER : Le modèle Diffusion entre dans la conduite autonome multi-tâches (segmentation BEV + détection double SOTA)

Apr 22, 2024 pm 05:49 PM

Écrit ci-dessus et compréhension personnelle de l'auteur À l'heure actuelle, alors que la technologie de conduite autonome devient plus mature et que la demande de tâches de perception de conduite autonome augmente, l'industrie et le monde universitaire espèrent beaucoup un modèle d'algorithme de perception idéal qui puisse simultanément compléter la détection de cibles tridimensionnelles et basé sur la tâche de segmentation sémantique dans l'espace BEV. Pour un véhicule capable de conduire de manière autonome, il est généralement équipé de capteurs de caméra à vision panoramique, de capteurs lidar et de capteurs radar à ondes millimétriques pour collecter des données selon différentes modalités. De cette manière, les avantages complémentaires entre les différentes données modales peuvent être pleinement exploités, de sorte que les avantages complémentaires des données entre les différentes modalités puissent être obtenus. Par exemple, les données de nuages de points 3D peuvent fournir des informations pour les tâches de détection de cibles 3D, tandis que les données d'images couleur. peut fournir plus d'informations pour les tâches de segmentation sémantique. Aiguille