La diffusion stable revient ?

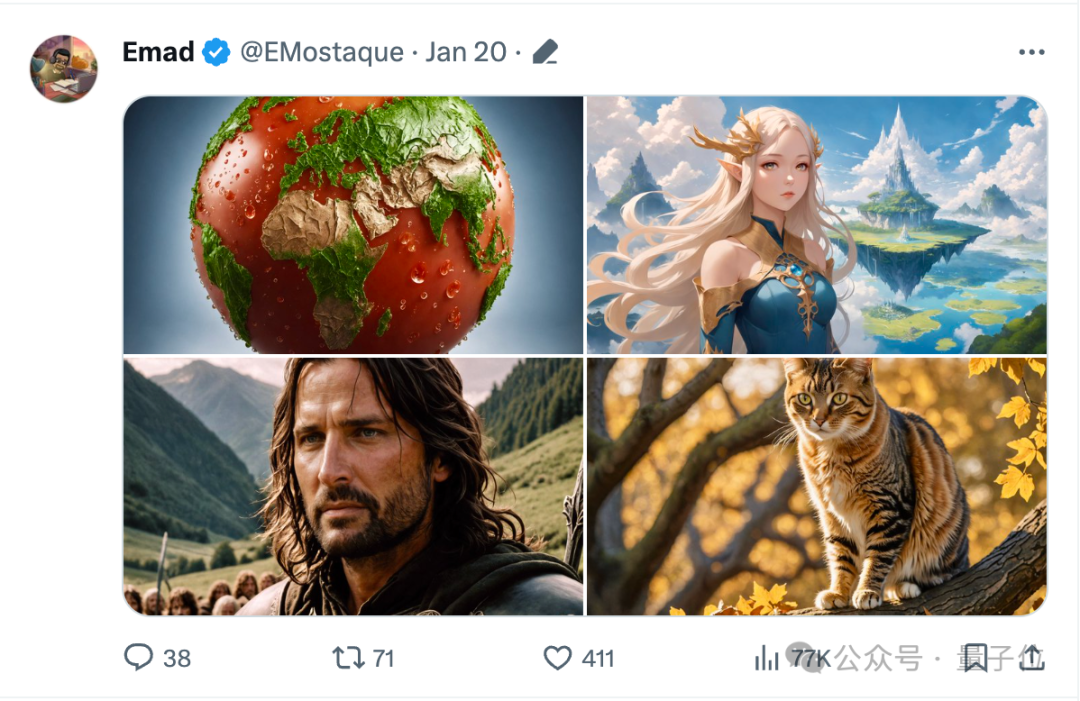

Les derniers tweets et quatre vidéos du PDG de Stability AI, Emad Mostaque, ont suscité d'innombrables réflexions.

De nombreux internautes soupçonnent qu'il s'agit d'une démo de la nouvelle version de Stable Video Diffusion.

Parce que du point de vue des effets, la clarté, la cohérence et la douceur de l'image sont toutes étonnantes.

Par exemple, cet ours en peluche plonge avec des lunettes de natation.

L'ours en peluche bouge très facilement et cligne même des yeux. Il y a aussi de riches détails sur l’eau de mer derrière.

De plus, Emad Mostaque lui-même a disparu depuis plusieurs semaines depuis le 1er janvier de cette année et n'est jamais apparu sur les réseaux sociaux.

Les internautes estiment que cette vague revient plutôt à retenir de grandes nouvelles. L'IA de stabilité est de retour ?

(Je pensais un jour que Stability AI avait pris du retard par rapport à la concurrence)

À en juger par la démo de quatre secondes publiée, il devrait s'agir d'une mise à niveau de la fonction de génération vidéo SVD.

Cependant, il n'est pas encore clair s'il sera généré à partir de texte ou d'images. Ressentons directement l'effet.

Il y a aussi cette rue nocturne de style anime.

En novembre de l'année dernière, Stable Video Diffusion (SVD) a été officiellement lancé. À cette époque, en plus de prendre en charge les images et le texte en vidéo, il prenait également en charge la synthèse 3D d'objets.

Selon le plan révélé à l'époque, SVD n'était utilisé que comme modèle de base, et il continuera à s'étendre pour établir l'ensemble de l'écosystème de diffusion stable.

Les commentaires des internautes sur la démo à cette époque incluaient un éclairage et des ombres incorrects, ainsi qu'une incohérence générale (les images vidéo vacillaient entre les images).

En regardant la démo actuelle, comparons-la avec une vidéo similaire : Le robot vert est allongé sur le lit.

Vous pouvez voir que les détails du robot, les tasses et les lampes à côté, et même les plis du lit, de la couette et des oreillers sont plus riches.

Et il y a aussi une cartographie évidente de la lumière et des ombres sur le visage du robot.

Cependant, plus d'informations sur la mise à jour devront attendre la sortie de la version officielle.

Il est à noter qu'après ce tweet, Emad Mostaque en a également posté un similaire.

Pas de texte, juste quatre images fixes.

Les internautes ont exprimé leurs attentes. "J'espère que ce modèle pourra surpasser le SDXL dans tous les aspects et mieux itérer dans le temps." "Est-ce du SD3 ?"

Mais qu'est-ce que c'est que cette tomate de terre ? ? ?

Le même jour, leur StableLM2 1.6B est sorti, un petit modèle de langage avec seulement 1,6 milliard de paramètres. Il est multilingue et formé en anglais, espagnol, allemand, français, portugais et néerlandais.

Il y a quelques jours, ils viennent de publier Stable Code 3B, le premier grand modèle de langage depuis la nouvelle année.

Avec des progrès aussi fréquents, Stability AI est-elle vraiment sur le point de se redresser ?

La raison pour laquelle je veux parler d'un revirement est que Stability AI a en effet attiré beaucoup d'attention lors de la dernière vague de la piste Wenshengtu. La popularité de Stable Diffusion en a fait autrefois la licorne IA la plus regardée au monde. .

Cependant, avec l'émergence de Midjourney et les progrès fréquents d'OpenAI et de Google, il y a également eu des troubles internes, notamment le PDG soupçonné de plagier les réalisations, de détournement de fonds publics, le modèle commercial de l'entreprise n'était pas clair et les salaires étaient dus à Stability AI. a été une fois pris dans une tempête parmi.

En novembre de l'année dernière, il a été officiellement annoncé qu'il entrerait dans la piste de génération vidéo. À cette époque, des acteurs populaires tels que runway et pika étaient déjà apparus.

On soupçonne maintenant qu'une nouvelle version de SVD a été dévoilée. La raison pour laquelle elle a attiré l'attention de tous est qu'en plus de sa propre société, elle est également étroitement liée à la piste actuelle de génération vidéo à haute énergie.

De nombreux internautes ont dit sans détour : c'est vraiment une vague de boucles, les unes après les autres.

Soit il s'agit d'une version itérative, soit de la sortie de la version. Au cours de cette période, de nouveaux développements tels qu'Alibaba Byte, un important fabricant national, sont apparus fréquemment. Que ce soit par l'effet de génération, la clarté et la douceur, Moonvalley est sorti et a choqué de nombreuses personnes.

Ou vous pouvez le faire rouler en termes de contrôlabilité...

Il y a quelques jours à peine, le Gen-2 de Runway a encore évolué -

Seulement 5 pinceaux sont nécessaires pour faire face à une image Après un brossage rapide, les oiseaux qui étaient à l'origine stationnaires ont commencé à bouger.

Donc, dans le domaine de la génération vidéo, êtes-vous optimiste quant à la stabilité de l'IA ?

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

conversion RVB en hexadécimal

conversion RVB en hexadécimal

Quels sont les systèmes d'exploitation mobiles ?

Quels sont les systèmes d'exploitation mobiles ?

Comment ouvrir le fichier bac

Comment ouvrir le fichier bac

Le rôle de l'enregistrement d'un serveur cloud

Le rôle de l'enregistrement d'un serveur cloud

Le lot de script BAT modifie les noms de fichiers

Le lot de script BAT modifie les noms de fichiers

Frais de location de serveur

Frais de location de serveur

Quels sont les serveurs exemptés d'enregistrement ?

Quels sont les serveurs exemptés d'enregistrement ?

Comment fermer la bibliothèque de ressources d'application

Comment fermer la bibliothèque de ressources d'application

Requête de temps Internet

Requête de temps Internet