Périphériques technologiques

Périphériques technologiques

IA

IA

Pourquoi l'ICLR n'a-t-elle pas accepté l'article de Mamba ? La communauté IA a déclenché une grande discussion

Pourquoi l'ICLR n'a-t-elle pas accepté l'article de Mamba ? La communauté IA a déclenché une grande discussion

Pourquoi l'ICLR n'a-t-elle pas accepté l'article de Mamba ? La communauté IA a déclenché une grande discussion

En 2023, le statut de Transformer, acteur dominant dans le domaine des grands modèles d'IA, commencera à être remis en cause. Une nouvelle architecture appelée « Mamba » est apparue. Il s'agit d'un modèle d'espace d'état sélectif qui est comparable à Transformer en termes de modélisation du langage, et pourrait même le surpasser. Dans le même temps, Mamba peut atteindre une mise à l'échelle linéaire à mesure que la longueur du contexte augmente, ce qui lui permet de gérer des séquences d'un million de mots et d'améliorer de 5 fois le débit d'inférence lors du traitement de données réelles. Cette amélioration révolutionnaire des performances est accrocheuse et apporte de nouvelles possibilités au développement du domaine de l'IA.

Plus d'un mois après sa sortie, Mamba a commencé à montrer progressivement son influence et a donné naissance à de nombreux projets tels que MoE-Mamba, Vision Mamba, VMamba, U-Mamba, MambaByte, etc. Mamba a montré un grand potentiel en surmontant continuellement les lacunes de Transformer. Ces développements démontrent le développement et les progrès continus de Mamba, ouvrant de nouvelles possibilités dans le domaine de l’intelligence artificielle.

Cependant, cette « étoile » montante a rencontré un revers lors de la réunion ICLR 2024. Les derniers résultats publics montrent que l’article de Mamba est toujours en attente. Nous ne pouvons voir que son nom dans la colonne des décisions en attente, et nous ne pouvons pas déterminer s’il a été retardé ou rejeté.

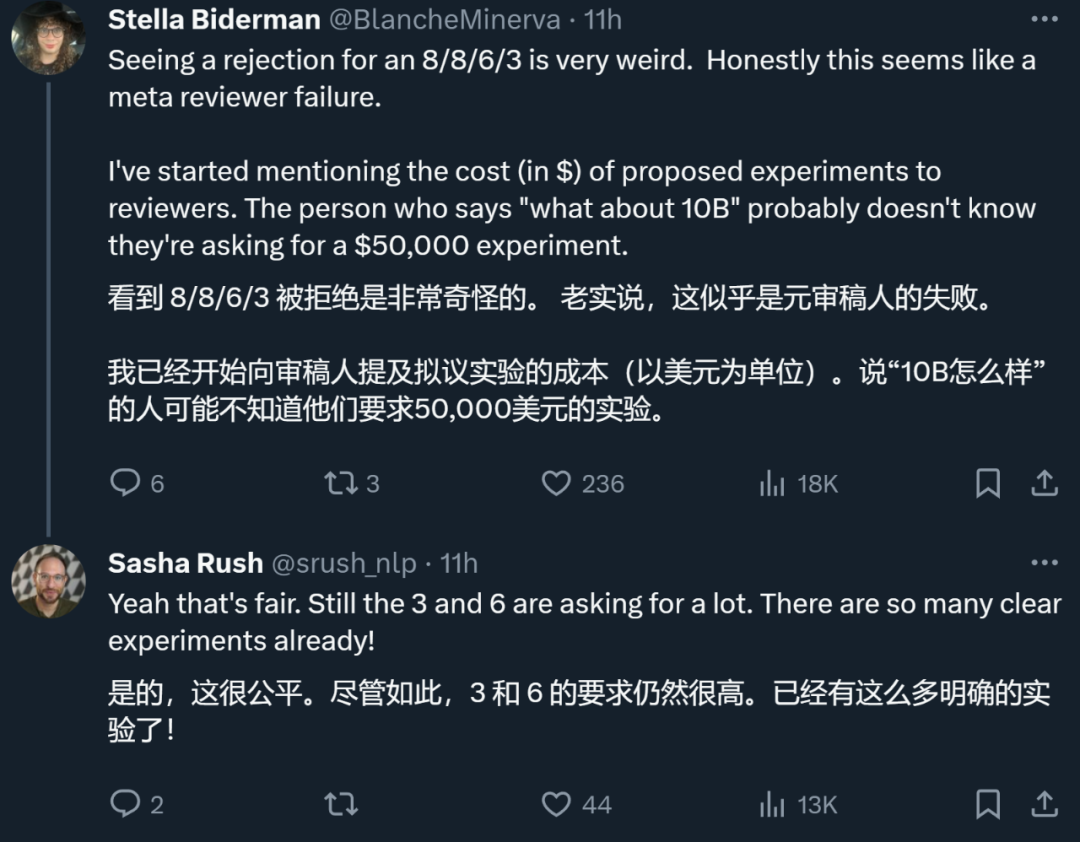

Dans l'ensemble, Mamba a reçu des notes de quatre évaluateurs, qui étaient respectivement de 8/8/6/3. Certaines personnes ont dit qu'il était vraiment déroutant d'être encore rejeté après avoir reçu une telle note.

Pour comprendre la raison, nous devons regarder ce que disent les évaluateurs qui ont donné des notes faibles.

Page de révision de l'article : https://openreview.net/forum?id=AL1fq05o7H

Pourquoi « pas assez bon » ?

Dans les commentaires de l'évaluation, l'évaluateur qui a donné une note de « 3 : rejeté, pas assez bon » a expliqué plusieurs opinions sur Mamba :

Réflexions sur la conception du modèle :

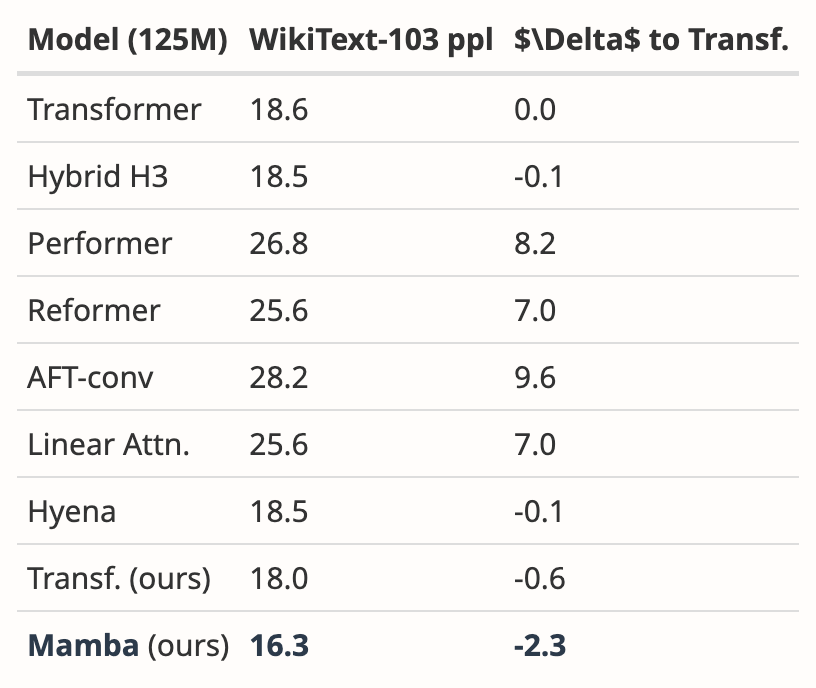

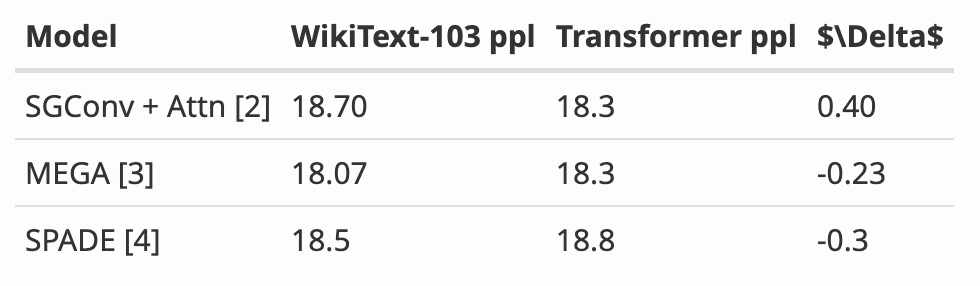

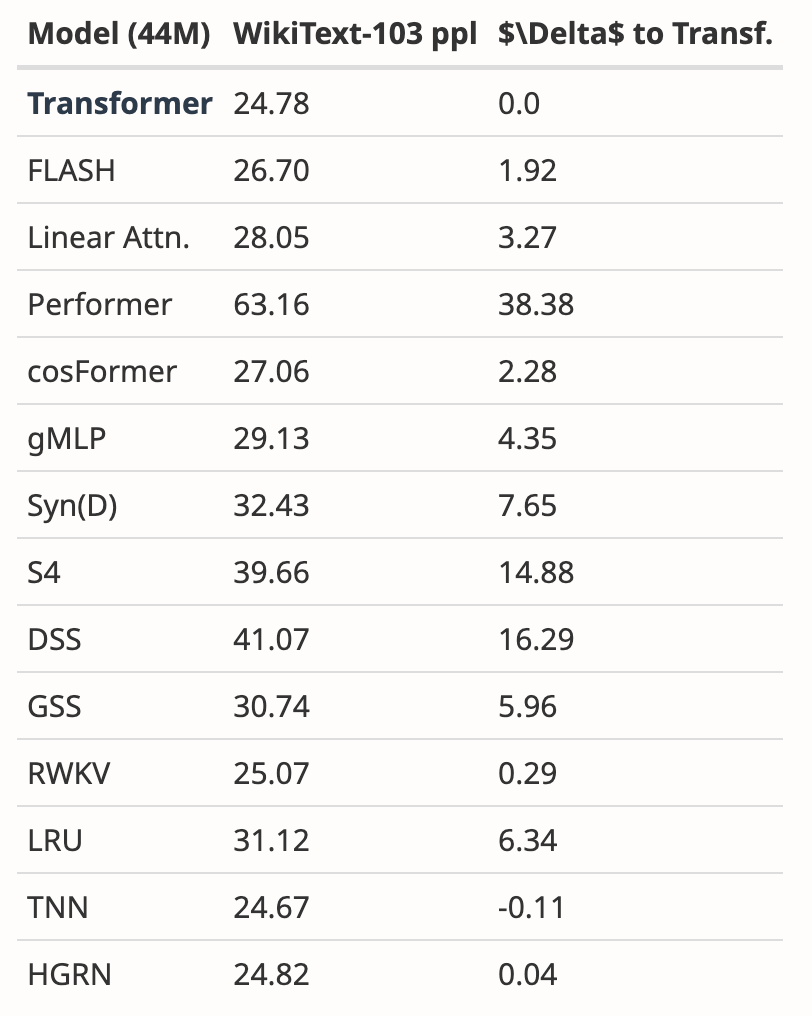

- La motivation de Mamba est de répondre les défauts des modèles récursifs tout en améliorant l’efficacité des modèles basés sur l’attention. Il existe de nombreuses études allant dans ce sens : S4-diagonal [1], SGConv [2], MEGA [3], SPADE [4] et de nombreux modèles de transformateurs efficaces (par exemple [5]). Tous ces modèles atteignent une complexité quasi linéaire et les auteurs doivent comparer Mamba avec ces travaux en termes de performances et d'efficacité des modèles. Concernant les performances du modèle, quelques expériences simples (telles que la modélisation du langage Wikitext-103) suffisent.

- De nombreux modèles Transformer basés sur l'attention montrent une capacité de généralisation de longueur, c'est-à-dire que le modèle peut être entraîné sur des longueurs de séquence plus courtes et testé sur des longueurs de séquence plus longues. Les exemples incluent le codage de position relative (T5) et l'alibi [6]. Puisque SSM est généralement continu, Mamba a-t-il cette capacité de généralisation de longueur ?

Réflexions sur l'expérience :

- Les auteurs doivent comparer avec une base de référence plus solide. Les auteurs ont déclaré que H3 était utilisé comme motivation pour l'architecture du modèle, mais ils n'ont pas fait de comparaison avec H3 dans les expériences. Selon le tableau 4 de [7], sur l'ensemble de données Pile, les ppl de H3 sont respectivement de 8,8 (1,25 M), 7,1 (3,55 M) et 6,0 (1,3B), ce qui est nettement meilleur que celui de Mamba. Les auteurs doivent montrer une comparaison avec H3.

- Pour le modèle pré-entraîné, l'auteur ne montre que les résultats de l'inférence à échantillon nul. Cette configuration est plutôt limitée et les résultats ne soutiennent pas bien l'efficacité de Mamba. Je recommande aux auteurs de mener davantage d'expériences avec de longues séquences, telles que le résumé de documents, où les séquences d'entrée sont naturellement très longues (par exemple, la longueur moyenne des séquences de l'ensemble de données arXiv est > 8 000).

- L'auteur affirme que l'une de ses principales contributions est la modélisation de séquences longues. Les auteurs devraient comparer avec davantage de références sur LRA (Long Range Arena), qui est fondamentalement la référence standard pour la compréhension des séquences longues.

- Repère de mémoire manquant. Bien que la section 4.5 soit intitulée « Benchmarks de vitesse et de mémoire », seules des comparaisons de vitesse sont présentées. De plus, les auteurs doivent fournir des paramètres plus détaillés sur le côté gauche de la figure 8, tels que les couches du modèle, la taille du modèle, les détails de convolution, etc. Les auteurs peuvent-ils expliquer pourquoi FlashAttention est le plus lent lorsque la longueur de la séquence est très grande (Figure 8 à gauche) ?

De plus, un autre critique a également souligné une lacune de Mamba : le modèle a encore des besoins en mémoire secondaire lors de l'entraînement comme Transformers.

Auteur : Révisé, veuillez réviser

Après avoir résumé les opinions de tous les évaluateurs, l'équipe d'auteurs a également révisé et amélioré le contenu de l'article et ajouté de nouveaux résultats expérimentaux et analyses :

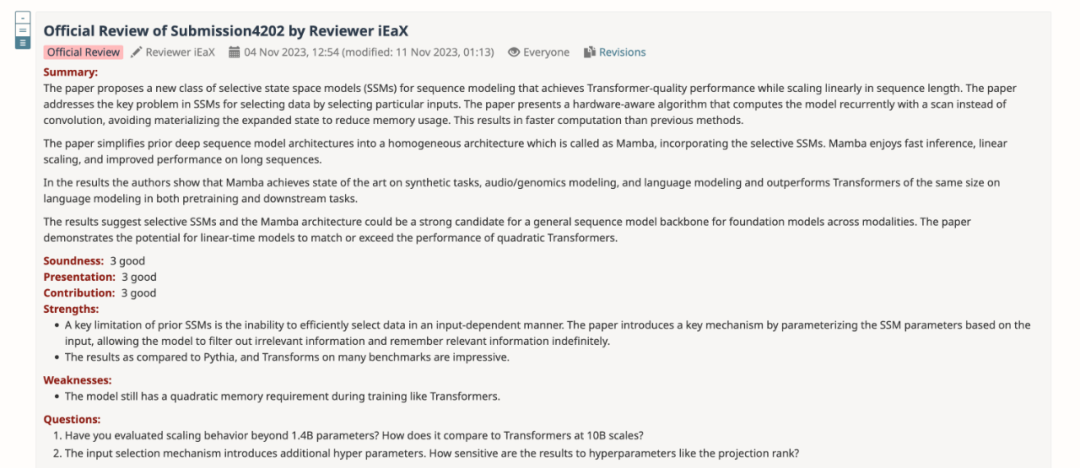

- Ajout des résultats d'évaluation de Modèle H3

L'auteur a téléchargé le modèle H3 pré-entraîné d'une taille de paramètres 125M-2,7B et a mené une série d'évaluations. Mamba est nettement meilleur dans toutes les évaluations de langage. Il convient de noter que ces modèles H3 sont des modèles hybrides utilisant une attention quadratique, tandis que le modèle pur de l'auteur utilisant uniquement la couche Mamba en temps linéaire est nettement meilleur dans tous les indicateurs.

La comparaison d'évaluation avec le modèle H3 pré-entraîné est la suivante :

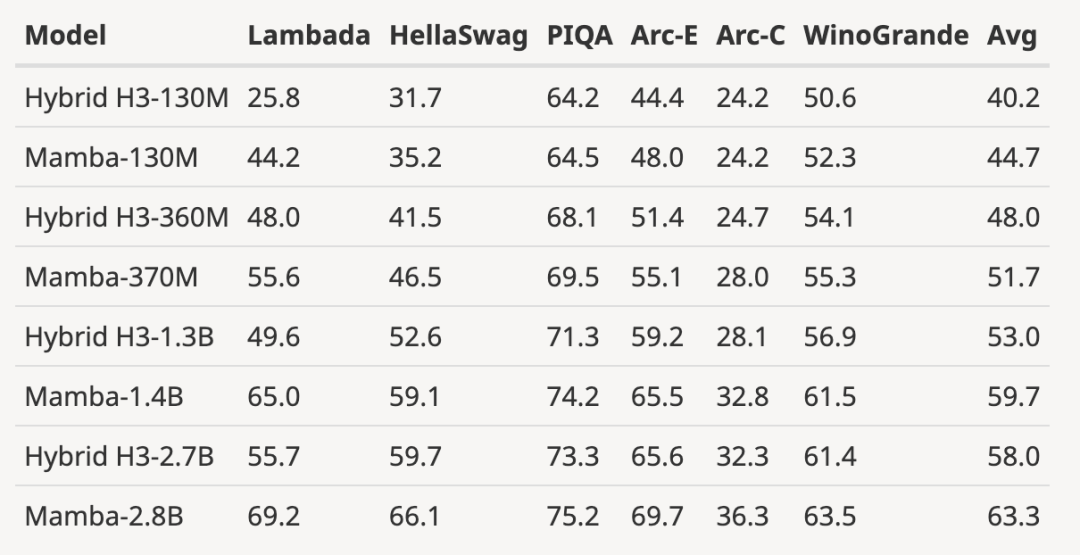

- Mise à l'échelle du modèle entièrement entraîné vers une taille de modèle plus grande

comme indiqué dans la figure ci-dessous , comparé à Par rapport au modèle open source 3B formé avec le même nombre de jetons (300B), Mamba est supérieur dans chaque résultat d'évaluation. Il est même comparable aux modèles à l'échelle 7B : en comparant Mamba (2,8B) avec OPT, Pythia et RWKV (7B), Mamba obtient le meilleur score moyen et le meilleur/deuxième meilleur sur chaque score de référence.

- montrant les résultats de l'extrapolation de longueur au-delà de la longueur d'entraînement

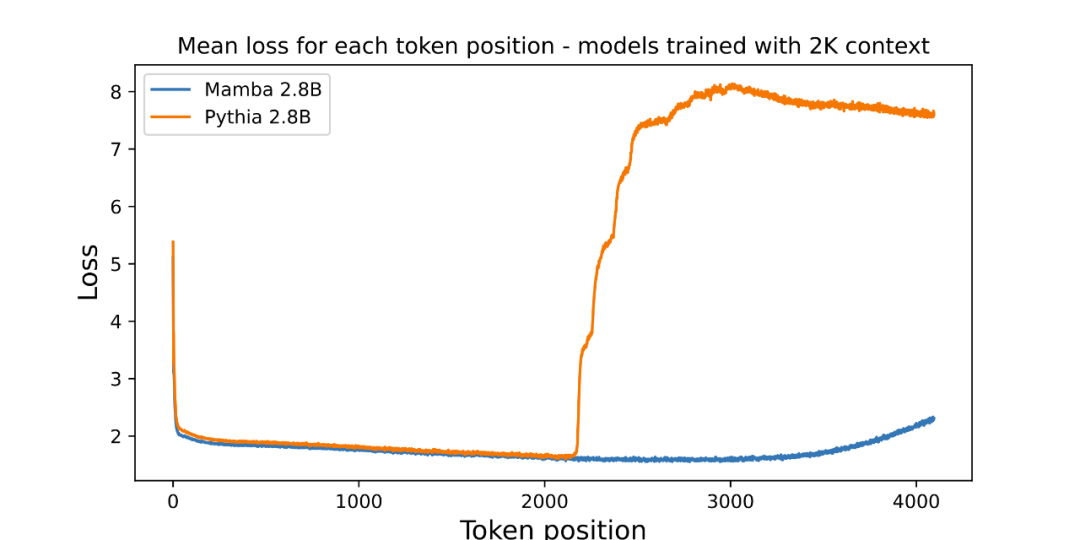

L'auteur a joint une figure évaluant l'extrapolation de longueur du modèle de langage paramétrique 3B pré-entraîné :

Le graphique trace la perte moyenne par position (lisibilité du journal). La perplexité du premier jeton est élevée car il n'a pas de contexte, tandis que la perplexité de Mamba et du Transformer de base (Pythia) augmente avant la longueur du contexte d'entraînement (2048). Il est intéressant de noter que la solvabilité de Mamba s'améliore considérablement au-delà de son contexte d'entraînement, jusqu'à une durée d'environ 3 000.

L'auteur souligne que l'extrapolation de longueur n'est pas la motivation directe du modèle dans cet article, mais la traite comme une fonctionnalité supplémentaire :

- Le modèle de base (Pythia) ici ne prend pas en compte l'extrapolation de longueur lors de l'entraînement, Il peut exister d'autres variantes de Transformer plus polyvalentes (telles que l'encodage de position relative T5 ou Alibi).

- Je n'ai trouvé aucun modèle 3B open source formé sur Pile à l'aide de l'encodage de position relative, cette comparaison ne peut donc pas être faite.

- Mamba, comme Pythia, ne prend pas en compte l'extrapolation de longueur lors de l'entraînement, ce n'est donc pas comparable. Tout comme les transformateurs disposent de nombreuses techniques (telles que différentes intégrations de position) pour améliorer leurs capacités en matière d'isométrie de généralisation de longueur, il pourrait être intéressant dans les travaux futurs de dériver des techniques spécifiques au SSM pour des capacités similaires.

- Complété par de nouveaux résultats sur WikiText-103

L'auteur a analysé les résultats de plusieurs articles, montrant que Mamba fonctionne nettement mieux sur WikiText-103 que les autres plus de 20 derniers modèles de séquences sous-quadratiques.

Malgré cela, deux mois se sont écoulés, et ce document est toujours dans le processus "Décision en attente", sans résultat clair d'"acceptation" ou de "rejet".

Ces articles rejetés par les meilleures conférences

Dans les grandes conférences sur l'IA, « l'explosion du nombre de soumissions » est un problème gênant, donc les évaluateurs avec une énergie limitée feront inévitablement des erreurs. Cela a conduit au rejet de nombreux articles célèbres de l'histoire, notamment YOLO, Transformer XL, Dropout, Support Vector Machine (SVM), Knowledge Distillation, SIFT et l'algorithme de classement des pages Web du moteur de recherche Google, PageRank (voir : "Les célèbres YOLO et PageRank des recherches influentes ont été rejetées par la plus haute conférence CS").

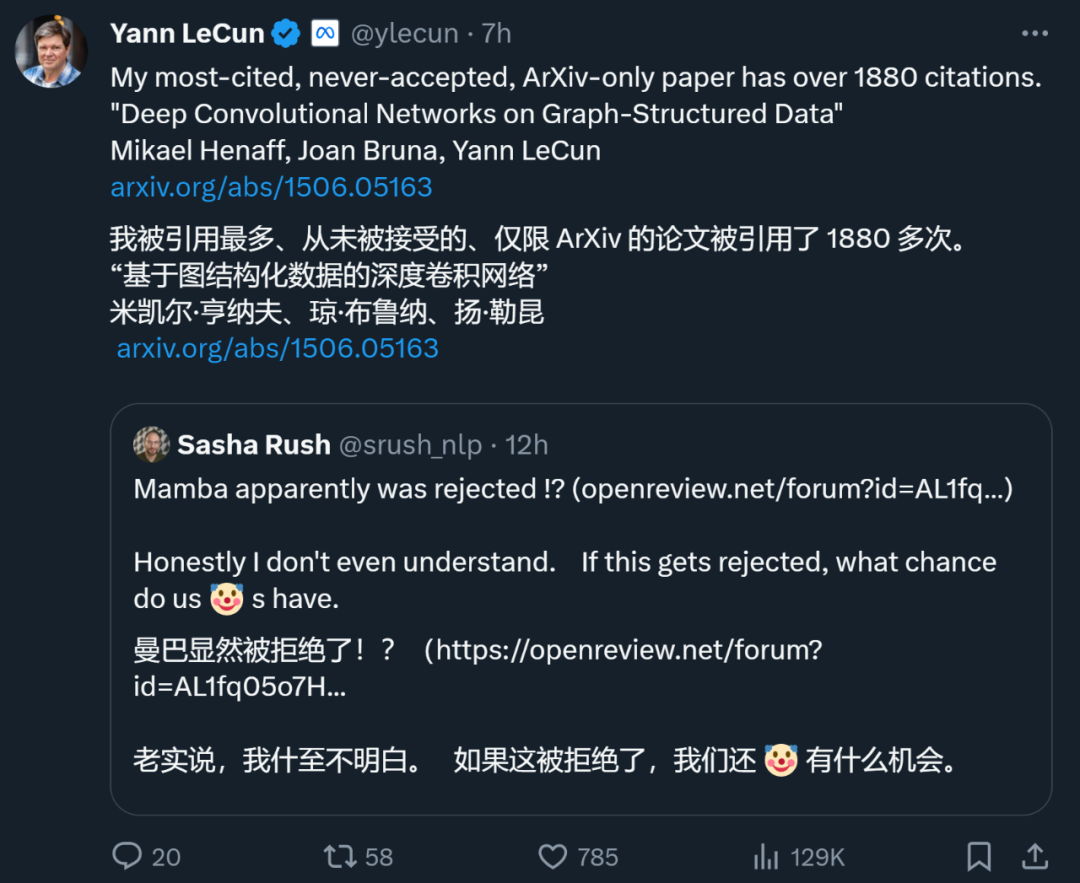

Même Yann LeCun, l'un des trois géants du deep learning, est aussi un papetier majeur qui est souvent rejeté. Tout à l'heure, il a tweeté que son article « Deep Convolutional Networks on Graph-Structured Data », qui a été cité 1 887 fois, avait également été rejeté par la plus haute conférence.

Lors de l'ICML 2022, il a même "soumis trois articles et trois ont été rejetés".

Donc, ce n'est pas parce que l'article est rejeté par une certaine grande conférence qu'il n'a aucune valeur. Parmi les articles rejetés mentionnés ci-dessus, beaucoup ont choisi d'être transférés à d'autres conférences et ont finalement été acceptés. Par conséquent, les internautes ont suggéré que Mamba passe au COLM, qui a été créé par de jeunes universitaires tels que Chen Danqi. COLM est un lieu universitaire dédié à la recherche sur la modélisation du langage, axé sur la compréhension, l'amélioration et les commentaires sur le développement de la technologie des modèles de langage, et peut constituer un meilleur choix pour des articles comme celui de Mamba.

Cependant, que Mamba puisse éventuellement être accepté par l'ICLR, il est devenu une œuvre influente et a également donné à la communauté l'espoir de briser les chaînes de Transformer, en injectant une exploration au-delà du modèle Transformer traditionnel. .Nouvelle énergie.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

La commande de fermeture CENTOS est arrêtée et la syntaxe est la fermeture de [options] le temps [informations]. Les options incluent: -H Arrêtez immédiatement le système; -P éteignez l'alimentation après l'arrêt; -r redémarrer; -t temps d'attente. Les temps peuvent être spécifiés comme immédiats (maintenant), minutes (minutes) ou une heure spécifique (HH: mm). Des informations supplémentaires peuvent être affichées dans les messages système.

Quelles sont les méthodes de sauvegarde pour Gitlab sur Centos

Apr 14, 2025 pm 05:33 PM

Quelles sont les méthodes de sauvegarde pour Gitlab sur Centos

Apr 14, 2025 pm 05:33 PM

La politique de sauvegarde et de récupération de GitLab dans le système CentOS afin d'assurer la sécurité et la récupérabilité des données, Gitlab on CentOS fournit une variété de méthodes de sauvegarde. Cet article introduira plusieurs méthodes de sauvegarde courantes, paramètres de configuration et processus de récupération en détail pour vous aider à établir une stratégie complète de sauvegarde et de récupération de GitLab. 1. MANUEL BACKUP Utilisez le Gitlab-RakegitLab: Backup: Créer la commande pour exécuter la sauvegarde manuelle. Cette commande sauvegarde des informations clés telles que le référentiel Gitlab, la base de données, les utilisateurs, les groupes d'utilisateurs, les clés et les autorisations. Le fichier de sauvegarde par défaut est stocké dans le répertoire / var / opt / gitlab / backups. Vous pouvez modifier / etc / gitlab

Comment vérifier la configuration de CentOS HDFS

Apr 14, 2025 pm 07:21 PM

Comment vérifier la configuration de CentOS HDFS

Apr 14, 2025 pm 07:21 PM

Guide complet pour vérifier la configuration HDFS dans les systèmes CentOS Cet article vous guidera comment vérifier efficacement la configuration et l'état de l'exécution des HDF sur les systèmes CentOS. Les étapes suivantes vous aideront à bien comprendre la configuration et le fonctionnement des HDF. Vérifiez la variable d'environnement Hadoop: Tout d'abord, assurez-vous que la variable d'environnement Hadoop est correctement définie. Dans le terminal, exécutez la commande suivante pour vérifier que Hadoop est installé et configuré correctement: HadoopVersion Check HDFS Fichier de configuration: Le fichier de configuration de base de HDFS est situé dans le répertoire / etc / hadoop / conf / le répertoire, où Core-site.xml et hdfs-site.xml sont cruciaux. utiliser

Comment est la prise en charge du GPU pour Pytorch sur Centos

Apr 14, 2025 pm 06:48 PM

Comment est la prise en charge du GPU pour Pytorch sur Centos

Apr 14, 2025 pm 06:48 PM

Activer l'accélération du GPU Pytorch sur le système CentOS nécessite l'installation de versions CUDA, CUDNN et GPU de Pytorch. Les étapes suivantes vous guideront tout au long du processus: CUDA et CUDNN Installation détermineront la compatibilité de la version CUDA: utilisez la commande NVIDIA-SMI pour afficher la version CUDA prise en charge par votre carte graphique NVIDIA. Par exemple, votre carte graphique MX450 peut prendre en charge CUDA11.1 ou plus. Téléchargez et installez Cudatoolkit: visitez le site officiel de Nvidiacudatoolkit et téléchargez et installez la version correspondante selon la version CUDA la plus élevée prise en charge par votre carte graphique. Installez la bibliothèque CUDNN:

Explication détaillée du principe docker

Apr 14, 2025 pm 11:57 PM

Explication détaillée du principe docker

Apr 14, 2025 pm 11:57 PM

Docker utilise les fonctionnalités du noyau Linux pour fournir un environnement de fonctionnement d'application efficace et isolé. Son principe de travail est le suivant: 1. Le miroir est utilisé comme modèle en lecture seule, qui contient tout ce dont vous avez besoin pour exécuter l'application; 2. Le Système de fichiers Union (UnionFS) empile plusieurs systèmes de fichiers, ne stockant que les différences, l'économie d'espace et l'accélération; 3. Le démon gère les miroirs et les conteneurs, et le client les utilise pour l'interaction; 4. Les espaces de noms et les CGROUP implémentent l'isolement des conteneurs et les limitations de ressources; 5. Modes de réseau multiples prennent en charge l'interconnexion du conteneur. Ce n'est qu'en comprenant ces concepts principaux que vous pouvez mieux utiliser Docker.

CentOS installe MySQL

Apr 14, 2025 pm 08:09 PM

CentOS installe MySQL

Apr 14, 2025 pm 08:09 PM

L'installation de MySQL sur CENTOS implique les étapes suivantes: Ajout de la source MySQL YUM appropriée. Exécutez la commande YUM Install MySQL-Server pour installer le serveur MySQL. Utilisez la commande mysql_secure_installation pour créer des paramètres de sécurité, tels que la définition du mot de passe de l'utilisateur racine. Personnalisez le fichier de configuration MySQL selon les besoins. Écoutez les paramètres MySQL et optimisez les bases de données pour les performances.

CentOS8 redémarre SSH

Apr 14, 2025 pm 09:00 PM

CentOS8 redémarre SSH

Apr 14, 2025 pm 09:00 PM

La commande pour redémarrer le service SSH est: SystemCTL Redémarrer SSHD. Étapes détaillées: 1. Accédez au terminal et connectez-vous au serveur; 2. Entrez la commande: SystemCTL Restart SSHD; 3. Vérifiez l'état du service: SystemCTL Status Sshd.

Comment faire fonctionner la formation distribuée de Pytorch sur CentOS

Apr 14, 2025 pm 06:36 PM

Comment faire fonctionner la formation distribuée de Pytorch sur CentOS

Apr 14, 2025 pm 06:36 PM

La formation distribuée par Pytorch sur le système CentOS nécessite les étapes suivantes: Installation de Pytorch: La prémisse est que Python et PIP sont installés dans le système CentOS. Selon votre version CUDA, obtenez la commande d'installation appropriée sur le site officiel de Pytorch. Pour la formation du processeur uniquement, vous pouvez utiliser la commande suivante: pipinstalltorchtorchVisionTorChaudio Si vous avez besoin d'une prise en charge du GPU, assurez-vous que la version correspondante de CUDA et CUDNN est installée et utilise la version Pytorch correspondante pour l'installation. Configuration de l'environnement distribué: la formation distribuée nécessite généralement plusieurs machines ou des GPU multiples uniques. Lieu