Java

Java

javaDidacticiel

javaDidacticiel

Partir de zéro : guide Springboot pour créer rapidement un environnement intégré Kafka

Partir de zéro : guide Springboot pour créer rapidement un environnement intégré Kafka

Partir de zéro : guide Springboot pour créer rapidement un environnement intégré Kafka

Présentation de Kafka intégré à Springboot

Apache Kafka est un service de streaming distribué qui vous permet de produire, consommer et stocker des données avec un débit extrêmement élevé. Il est largement utilisé pour créer une grande variété d'applications telles que l'agrégation de journaux, la collecte de métriques, la surveillance et les pipelines de données transactionnelles.

Springboot est un framework permettant de simplifier le développement d'applications Spring. Il fournit un câblage automatique et des conventions prêts à l'emploi pour intégrer facilement Kafka dans les applications Spring.

Créez l'environnement requis pour que Kafka intègre Springboot

1 Installez Apache Kafka

- Téléchargez la distribution Apache Kafka.

- Décompressez la distribution et démarrez le service Kafka.

- Vérifiez le journal du service Kafka pour vous assurer qu'il fonctionne correctement.

2. Installez Springboot

- Téléchargez la distribution Springboot.

- Extrayez la distribution et ajoutez-la au chemin de votre système.

- Créez une application Springboot.

Exemple de code

1. Créez une application Springboot

public class SpringbootKafkaApplication {

public static void main(String[] args) {

SpringApplication.run(SpringbootKafkaApplication.class, args);

}

}2. Ajoutez une dépendance Kafka

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-kafka</artifactId>

</dependency>3. Configurez le producteur Kafka

@Bean

public ProducerFactory<String, String> senderFactory() {

Map<String, Object> config = new LinkedHashMap<>();

config.put(ProducerConfig.BOOTSTRAP_ certification_URL_setConfig, "kafka://127.0.0.1:9092");

config.put(ProducerConfig.KEY_SERIALIZER_setClass_Config, StringDeserializer.class);

config.put(ProducerConfig.KEY_SERIALIZER_setClass_Config, StringDeserializer.class);

return new SimpleKafkaProducerFactory<>(config);

}4. 6. Créez le service consommateur Kafka

@Bean

public ConcurrentKafkaListenerContainerFactory<String, String> kafkaListenerContainerFactory() {

ConcurrentKafkaListenerContainerFactory<String, String> factory = new ConcurrentKafkaListenerContainerFactory<>();

factory.setBrokerAddresses("127.0.0.1:9092");

factory.setKeyDeserializer(new StringDeserializer());

factory.setKeyDeserializer(new StringDeserializer());

return factory;

}Test

Démarrez le service Kafka. Démarrez l'application Springboot.- Utilisez ProducerService pour envoyer un message.

- Vérifiez le journal du service Kafka pour vous assurer qu'il a reçu correctement les informations.

- Vérifiez le journal de l'application Springboot pour vous assurer qu'il a correctement consommé les informations.

- Résumé

- Cet article montre comment intégrer Kafka dans une application Spring à l'aide de Springboot. Nous avons d'abord donné un aperçu de Kafka et Springboot, et expliqué comment créer l'environnement requis pour que Kafka intègre Springboot. Ensuite, nous fournissons un exemple détaillé d'application Springboot qui montre comment utiliser Springboot pour produire et consommer des informations Kafka.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment mettre en œuvre une analyse boursière en temps réel à l'aide de PHP et Kafka

Jun 28, 2023 am 10:04 AM

Comment mettre en œuvre une analyse boursière en temps réel à l'aide de PHP et Kafka

Jun 28, 2023 am 10:04 AM

Avec le développement d’Internet et de la technologie, l’investissement numérique est devenu un sujet de préoccupation croissant. De nombreux investisseurs continuent d’explorer et d’étudier des stratégies d’investissement, dans l’espoir d’obtenir un retour sur investissement plus élevé. Dans le domaine du trading d'actions, l'analyse boursière en temps réel est très importante pour la prise de décision, et l'utilisation de la file d'attente de messages en temps réel Kafka et de la technologie PHP constitue un moyen efficace et pratique. 1. Introduction à Kafka Kafka est un système de messagerie distribué de publication et d'abonnement à haut débit développé par LinkedIn. Les principales fonctionnalités de Kafka sont

Comment spécifier dynamiquement plusieurs sujets à l'aide de @KafkaListener dans springboot+kafka

May 20, 2023 pm 08:58 PM

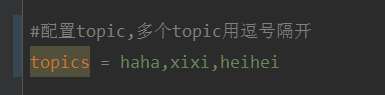

Comment spécifier dynamiquement plusieurs sujets à l'aide de @KafkaListener dans springboot+kafka

May 20, 2023 pm 08:58 PM

Expliquez que ce projet est un projet d'intégration springboot+kafak, il utilise donc l'annotation de consommation kafak @KafkaListener dans springboot. Tout d'abord, configurez plusieurs sujets séparés par des virgules dans application.properties. Méthode : utilisez l'expression SpEl de Spring pour configurer les sujets comme : @KafkaListener(topics="#{’${topics}’.split(’,’)}") pour exécuter le programme. L'effet d'impression de la console est le suivant.

Comment SpringBoot intègre la classe d'outils de configuration Kafka

May 12, 2023 pm 09:58 PM

Comment SpringBoot intègre la classe d'outils de configuration Kafka

May 12, 2023 pm 09:58 PM

spring-kafka est basé sur l'intégration de la version java de kafkaclient et spring. Il fournit KafkaTemplate, qui encapsule diverses méthodes pour une utilisation facile. Il encapsule le client kafka d'Apache, et il n'est pas nécessaire d'importer le client pour dépendre de l'organisation. .springframework.kafkaspring-kafkaYML configuration kafka:#bootstrap-servers:server1:9092,server2:9093#adresse de développement de kafka,#producteur de configuration du producteur:#clé de classe de sérialisation et de désérialisation fournie par Kafka.

Comment créer des applications de traitement de données en temps réel à l'aide de React et Apache Kafka

Sep 27, 2023 pm 02:25 PM

Comment créer des applications de traitement de données en temps réel à l'aide de React et Apache Kafka

Sep 27, 2023 pm 02:25 PM

Comment utiliser React et Apache Kafka pour créer des applications de traitement de données en temps réel Introduction : Avec l'essor du Big Data et du traitement de données en temps réel, la création d'applications de traitement de données en temps réel est devenue la priorité de nombreux développeurs. La combinaison de React, un framework front-end populaire, et d'Apache Kafka, un système de messagerie distribué hautes performances, peut nous aider à créer des applications de traitement de données en temps réel. Cet article expliquera comment utiliser React et Apache Kafka pour créer des applications de traitement de données en temps réel, et

Cinq sélections d'outils de visualisation pour explorer Kafka

Feb 01, 2024 am 08:03 AM

Cinq sélections d'outils de visualisation pour explorer Kafka

Feb 01, 2024 am 08:03 AM

Cinq options pour les outils de visualisation Kafka ApacheKafka est une plateforme de traitement de flux distribué capable de traiter de grandes quantités de données en temps réel. Il est largement utilisé pour créer des pipelines de données en temps réel, des files d'attente de messages et des applications basées sur des événements. Les outils de visualisation de Kafka peuvent aider les utilisateurs à surveiller et gérer les clusters Kafka et à mieux comprendre les flux de données Kafka. Ce qui suit est une introduction à cinq outils de visualisation Kafka populaires : ConfluentControlCenterConfluent

Analyse comparative des outils de visualisation kafka : Comment choisir l'outil le plus approprié ?

Jan 05, 2024 pm 12:15 PM

Analyse comparative des outils de visualisation kafka : Comment choisir l'outil le plus approprié ?

Jan 05, 2024 pm 12:15 PM

Comment choisir le bon outil de visualisation Kafka ? Analyse comparative de cinq outils Introduction : Kafka est un système de file d'attente de messages distribué à haute performance et à haut débit, largement utilisé dans le domaine du Big Data. Avec la popularité de Kafka, de plus en plus d'entreprises et de développeurs ont besoin d'un outil visuel pour surveiller et gérer facilement les clusters Kafka. Cet article présentera cinq outils de visualisation Kafka couramment utilisés et comparera leurs caractéristiques et fonctions pour aider les lecteurs à choisir l'outil qui répond à leurs besoins. 1. KafkaManager

Exemple de code pour le projet Springboot pour configurer plusieurs kafka

May 14, 2023 pm 12:28 PM

Exemple de code pour le projet Springboot pour configurer plusieurs kafka

May 14, 2023 pm 12:28 PM

1.spring-kafkaorg.springframework.kafkaspring-kafka1.3.5.RELEASE2. Informations relatives au fichier de configuration kafka.bootstrap-servers=localhost:9092kafka.consumer.group.id=20230321#Le nombre de threads pouvant être consommés simultanément (généralement cohérent avec le nombre de partitions )kafka.consumer.concurrency=10kafka.consumer.enable.auto.commit=falsekafka.boo

Comment installer Apache Kafka sur Rocky Linux ?

Mar 01, 2024 pm 10:37 PM

Comment installer Apache Kafka sur Rocky Linux ?

Mar 01, 2024 pm 10:37 PM

Pour installer ApacheKafka sur RockyLinux, vous pouvez suivre les étapes suivantes : Mettre à jour le système : Tout d'abord, assurez-vous que votre système RockyLinux est à jour, exécutez la commande suivante pour mettre à jour les packages système : sudoyumupdate Installer Java : ApacheKafka dépend de Java, vous vous devez d'abord installer JavaDevelopmentKit (JDK). OpenJDK peut être installé via la commande suivante : sudoyuminstalljava-1.8.0-openjdk-devel Télécharger et décompresser : Visitez le site officiel d'ApacheKafka () pour télécharger le dernier package binaire. Choisissez une version stable