kafka-server-stop.sh

zookeeper-server-stop.sh

Java

Java

javaDidacticiel

javaDidacticiel

Analyse approfondie des commandes de démarrage de Kafka pour maîtriser rapidement Kafka

Analyse approfondie des commandes de démarrage de Kafka pour maîtriser rapidement Kafka

Analyse approfondie des commandes de démarrage de Kafka pour maîtriser rapidement Kafka

Explication détaillée de la commande de démarrage de Kafka

1. Démarrez un seul courtier

kafka-server-start.sh config/server.properties

Cette commande démarrera un courtier Kafka et utilisera config/server.properties comme fichier de configuration. config/server.properties作为配置文件。

2. 启动多个Broker

kafka-server-start.sh config/server-1.properties kafka-server-start.sh config/server-2.properties kafka-server-start.sh config/server-3.properties

该命令将启动三个Kafka Broker,并使用config/server-1.properties、config/server-2.properties和config/server-3.properties作为配置文件。

3. 启动ZooKeeper

zookeeper-server-start.sh config/zookeeper.properties

该命令将启动一个ZooKeeper服务器,并使用config/zookeeper.properties作为配置文件。

4. 创建Topic

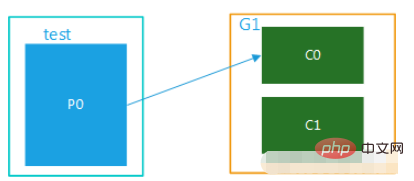

kafka-topics.sh --create --topic test --partitions 3 --replication-factor 2

该命令将创建一个名为test的Topic,该Topic具有3个分区和2个副本因子。

5. 生产数据

kafka-console-producer.sh --topic test

该命令将启动一个控制台生产者,该生产者将数据发送到test Topic。

6. 消费数据

kafka-console-consumer.sh --topic test --from-beginning

该命令将启动一个控制台消费者,该消费者将从test

kafka-server-stop.sh

Copier après la connexion

Cette commande démarrera trois courtiers Kafka et utilisera kafka-server-stop.sh

config/server-1.properties, config/server-2.properties</code > et < code>config/server-3.properties comme fichiers de configuration. 3. Démarrez ZooKeeperzookeeper-server-stop.sh

Copier après la connexion

Cette commande démarrera un serveur ZooKeeper et utilisera zookeeper-server-stop.sh

config/zookeeper.properties comme fichier de configuration. 4. Créer un sujet# 启动ZooKeeper

zookeeper-server-start.sh config/zookeeper.properties

# 启动Kafka Broker

kafka-server-start.sh config/server-1.properties

kafka-server-start.sh config/server-2.properties

kafka-server-start.sh config/server-3.properties

# 创建Topic

kafka-topics.sh --create --topic test --partitions 3 --replication-factor 2

# 生产数据

kafka-console-producer.sh --topic test

# 消费数据

kafka-console-consumer.sh --topic test --from-beginning

# 停止Kafka

kafka-server-stop.sh

# 停止ZooKeeper

zookeeper-server-stop.sh

Copier après la connexionCette commande créera un sujet nommé test, qui comporte 3 partitions et 2 facteurs de réplication.

5. Produire des données# 启动ZooKeeper zookeeper-server-start.sh config/zookeeper.properties # 启动Kafka Broker kafka-server-start.sh config/server-1.properties kafka-server-start.sh config/server-2.properties kafka-server-start.sh config/server-3.properties # 创建Topic kafka-topics.sh --create --topic test --partitions 3 --replication-factor 2 # 生产数据 kafka-console-producer.sh --topic test # 消费数据 kafka-console-consumer.sh --topic test --from-beginning # 停止Kafka kafka-server-stop.sh # 停止ZooKeeper zookeeper-server-stop.sh

rrreee

Cette commande démarrera un producteur de console qui envoie des données au sujettest. - 6. Consume data rrreee

- Cette commande démarrera un consommateur de console, qui consommera les données depuis le début du sujet

test. - 7. Arrêtez Kafka rrreee

- Cette commande arrêtera tous les courtiers Kafka en cours d'exécution.

- 8. Arrêtez ZooKeeper rrreee

- Cette commande arrêtera le serveur ZooKeeper.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment mettre en œuvre une analyse boursière en temps réel à l'aide de PHP et Kafka

Jun 28, 2023 am 10:04 AM

Comment mettre en œuvre une analyse boursière en temps réel à l'aide de PHP et Kafka

Jun 28, 2023 am 10:04 AM

Avec le développement d’Internet et de la technologie, l’investissement numérique est devenu un sujet de préoccupation croissant. De nombreux investisseurs continuent d’explorer et d’étudier des stratégies d’investissement, dans l’espoir d’obtenir un retour sur investissement plus élevé. Dans le domaine du trading d'actions, l'analyse boursière en temps réel est très importante pour la prise de décision, et l'utilisation de la file d'attente de messages en temps réel Kafka et de la technologie PHP constitue un moyen efficace et pratique. 1. Introduction à Kafka Kafka est un système de messagerie distribué de publication et d'abonnement à haut débit développé par LinkedIn. Les principales fonctionnalités de Kafka sont

Comment spécifier dynamiquement plusieurs sujets à l'aide de @KafkaListener dans springboot+kafka

May 20, 2023 pm 08:58 PM

Comment spécifier dynamiquement plusieurs sujets à l'aide de @KafkaListener dans springboot+kafka

May 20, 2023 pm 08:58 PM

Expliquez que ce projet est un projet d'intégration springboot+kafak, il utilise donc l'annotation de consommation kafak @KafkaListener dans springboot. Tout d'abord, configurez plusieurs sujets séparés par des virgules dans application.properties. Méthode : utilisez l'expression SpEl de Spring pour configurer les sujets comme : @KafkaListener(topics="#{’${topics}’.split(’,’)}") pour exécuter le programme. L'effet d'impression de la console est le suivant.

Comment SpringBoot intègre la classe d'outils de configuration Kafka

May 12, 2023 pm 09:58 PM

Comment SpringBoot intègre la classe d'outils de configuration Kafka

May 12, 2023 pm 09:58 PM

spring-kafka est basé sur l'intégration de la version java de kafkaclient et spring. Il fournit KafkaTemplate, qui encapsule diverses méthodes pour une utilisation facile. Il encapsule le client kafka d'Apache, et il n'est pas nécessaire d'importer le client pour dépendre de l'organisation. .springframework.kafkaspring-kafkaYML configuration kafka:#bootstrap-servers:server1:9092,server2:9093#adresse de développement de kafka,#producteur de configuration du producteur:#clé de classe de sérialisation et de désérialisation fournie par Kafka.

Comment créer des applications de traitement de données en temps réel à l'aide de React et Apache Kafka

Sep 27, 2023 pm 02:25 PM

Comment créer des applications de traitement de données en temps réel à l'aide de React et Apache Kafka

Sep 27, 2023 pm 02:25 PM

Comment utiliser React et Apache Kafka pour créer des applications de traitement de données en temps réel Introduction : Avec l'essor du Big Data et du traitement de données en temps réel, la création d'applications de traitement de données en temps réel est devenue la priorité de nombreux développeurs. La combinaison de React, un framework front-end populaire, et d'Apache Kafka, un système de messagerie distribué hautes performances, peut nous aider à créer des applications de traitement de données en temps réel. Cet article expliquera comment utiliser React et Apache Kafka pour créer des applications de traitement de données en temps réel, et

Cinq sélections d'outils de visualisation pour explorer Kafka

Feb 01, 2024 am 08:03 AM

Cinq sélections d'outils de visualisation pour explorer Kafka

Feb 01, 2024 am 08:03 AM

Cinq options pour les outils de visualisation Kafka ApacheKafka est une plateforme de traitement de flux distribué capable de traiter de grandes quantités de données en temps réel. Il est largement utilisé pour créer des pipelines de données en temps réel, des files d'attente de messages et des applications basées sur des événements. Les outils de visualisation de Kafka peuvent aider les utilisateurs à surveiller et gérer les clusters Kafka et à mieux comprendre les flux de données Kafka. Ce qui suit est une introduction à cinq outils de visualisation Kafka populaires : ConfluentControlCenterConfluent

Analyse comparative des outils de visualisation kafka : Comment choisir l'outil le plus approprié ?

Jan 05, 2024 pm 12:15 PM

Analyse comparative des outils de visualisation kafka : Comment choisir l'outil le plus approprié ?

Jan 05, 2024 pm 12:15 PM

Comment choisir le bon outil de visualisation Kafka ? Analyse comparative de cinq outils Introduction : Kafka est un système de file d'attente de messages distribué à haute performance et à haut débit, largement utilisé dans le domaine du Big Data. Avec la popularité de Kafka, de plus en plus d'entreprises et de développeurs ont besoin d'un outil visuel pour surveiller et gérer facilement les clusters Kafka. Cet article présentera cinq outils de visualisation Kafka couramment utilisés et comparera leurs caractéristiques et fonctions pour aider les lecteurs à choisir l'outil qui répond à leurs besoins. 1. KafkaManager

Exemple de code pour le projet Springboot pour configurer plusieurs kafka

May 14, 2023 pm 12:28 PM

Exemple de code pour le projet Springboot pour configurer plusieurs kafka

May 14, 2023 pm 12:28 PM

1.spring-kafkaorg.springframework.kafkaspring-kafka1.3.5.RELEASE2. Informations relatives au fichier de configuration kafka.bootstrap-servers=localhost:9092kafka.consumer.group.id=20230321#Le nombre de threads pouvant être consommés simultanément (généralement cohérent avec le nombre de partitions )kafka.consumer.concurrency=10kafka.consumer.enable.auto.commit=falsekafka.boo

La pratique du go-zero et Kafka+Avro : construire un système de traitement de données interactif performant

Jun 23, 2023 am 09:04 AM

La pratique du go-zero et Kafka+Avro : construire un système de traitement de données interactif performant

Jun 23, 2023 am 09:04 AM

Ces dernières années, avec l'essor du Big Data et des communautés open source actives, de plus en plus d'entreprises ont commencé à rechercher des systèmes de traitement de données interactifs hautes performances pour répondre aux besoins croissants en matière de données. Dans cette vague de mises à niveau technologiques, le go-zero et Kafka+Avro suscitent l’attention et sont adoptés par de plus en plus d’entreprises. go-zero est un framework de microservices développé sur la base du langage Golang. Il présente les caractéristiques de hautes performances, de facilité d'utilisation, d'extension facile et de maintenance facile. Il est conçu pour aider les entreprises à créer rapidement des systèmes d'applications de microservices efficaces. sa croissance rapide