Périphériques technologiques

Périphériques technologiques

IA

IA

Les performances des paramètres 2B dépassent celles de Mistral-7B : modèle open source multimodal intelligent d'extrémité côté mur

Les performances des paramètres 2B dépassent celles de Mistral-7B : modèle open source multimodal intelligent d'extrémité côté mur

Les performances des paramètres 2B dépassent celles de Mistral-7B : modèle open source multimodal intelligent d'extrémité côté mur

Qianyuan Machine peut également être exécutée localement.

Récemment, les gens ont obtenu des résultats en matière d'optimisation et de déploiement, avec l'évolution des grands modèles vers les gros volumes.

Le 1er février, Wall-Facing Intelligence et le laboratoire Tsinghua NLP ont officiellement lancé le modèle phare à grande échelle de bout en bout « Wall-Facing MiniCPM » à Pékin. Cette nouvelle génération de grands modèles est connue sous le nom de « petit canon en acier performant ». Elle peut non seulement être déployée directement sur le terminal, mais possède également les capacités multimodales les plus puissantes au même niveau. Cela offrira aux utilisateurs une expérience d’application intelligente plus rapide et plus efficace.

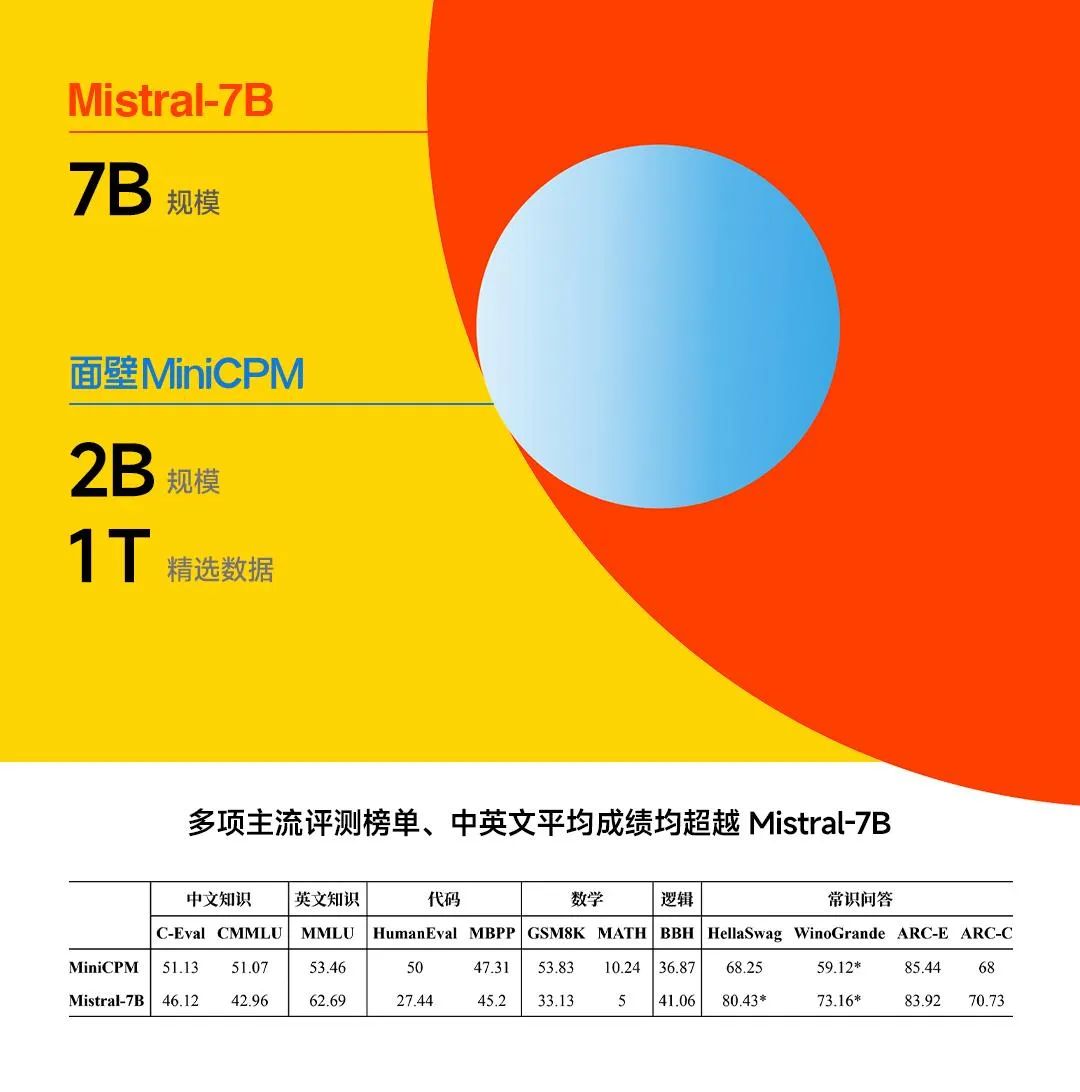

Le dernier modèle MiniCPM 2B lancé par Face Wall Intelligence ne comporte que 2 milliards de paramètres et est formé en utilisant les données sélectionnées du jeton 1T. Par rapport au modèle BERT publié en 2018, ce modèle a le même nombre de paramètres, mais Wall-Facing Intelligence a fait des efforts extrêmes en matière d'optimisation des performances et de contrôle des coûts, permettant à ce modèle d'obtenir l'effet de « sauter et tuer des monstres » en termes de performances.

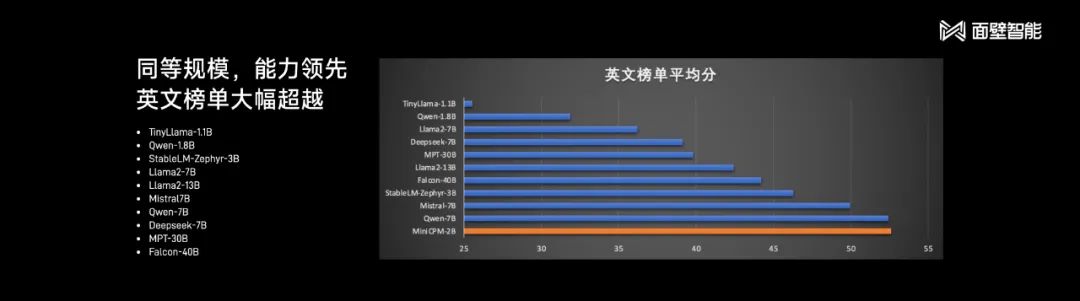

Li Dahai, co-fondateur et PDG de Wall-Facing Intelligence, a comparé le nouveau modèle avec Mistral-7B, un grand modèle open source bien connu dans l'industrie. Le MiniCPM 2B a surpassé ce dernier en termes de performances lors de plusieurs évaluations grand public. listes.

Par rapport au « petit modèle » Phi-2 récemment proposé par Microsoft, le MiniCPM présente également de grands avantages.

Li Dahai a souligné que le nouveau modèle d'intelligence face aux murs a le potentiel de réaliser une mise en œuvre avancée en termes de capacités et peut atteindre les capacités des modèles 13B, 30B ou même 40B. Lorsqu'il est évalué à l'aide de MT-Bench, la liste d'évaluation la plus proche de l'expérience utilisateur, MiniCPM a obtenu 7 points (en comparaison, GPT-4-Turbo a obtenu 9 points).

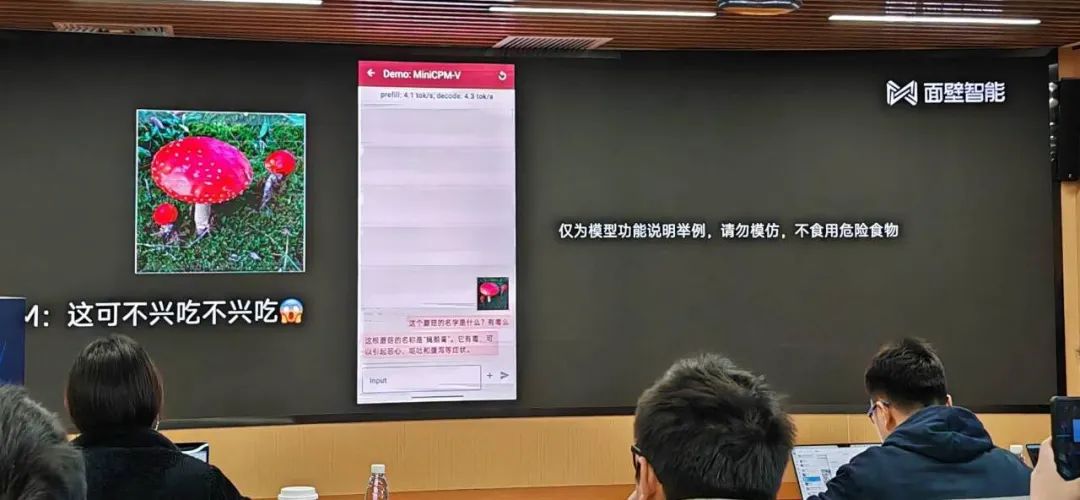

Sur place, Wall-Facing Intelligence a également démontré l'effet d'application pratique du MiniCPM. Bien que le nombre de paramètres soit faible, le modèle possède de nombreuses fonctionnalités telles que la traduction de texte et le jeu de rôle qu'un grand modèle devrait avoir, et il possède des connaissances riches. Le modèle peut gérer même des tâches d’interprétation de code difficiles.

Parce qu'il peut être déployé côté appareil, MiniCPM peut également fournir une aide rapide aux personnes confrontées à certaines urgences :

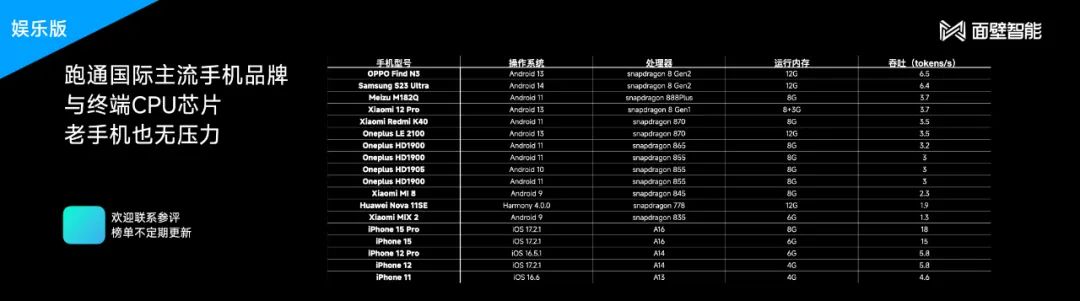

Récemment, divers fabricants de téléphones mobiles ont proposé des modèles côté client à grande échelle. le grand modèle de langage est compressé dans une taille plus petite, nous pouvons l'utiliser pour nous connecter à plus de scénarios et obtenir un degré d'intelligence plus élevé malgré une puissance de calcul et une mémoire limitées. En revanche, la nouvelle technologie proposée par Wall-Facing Intelligence est plus légère et peut être appliquée à des téléphones mobiles de configuration inférieure ou à des modèles antérieurs.

Selon Face Wall Intelligence, le modèle final MiniCPM a subi une quantification Int4 et a été compressé de 75 % en taille, n'occupant que 2 Go de mémoire. En même temps, il n'y a presque aucune perte de performances, il a donc été compressé. été mis en œuvre sur divers modèles courants de téléphones mobiles.

Parce qu'il prend en charge l'inférence du processeur mobile, MiniCPM peut réduire considérablement les coûts d'utilisation. Face Wall Intelligence a calculé pour nous : un téléphone mobile équipé de Snapdragon 855 utilisant MiniCPM peut traiter 1,7 million de tokens pour un dollar d'électricité. Ce prix ne représente que 1% du Mistral-Medium fonctionnant dans le cloud.

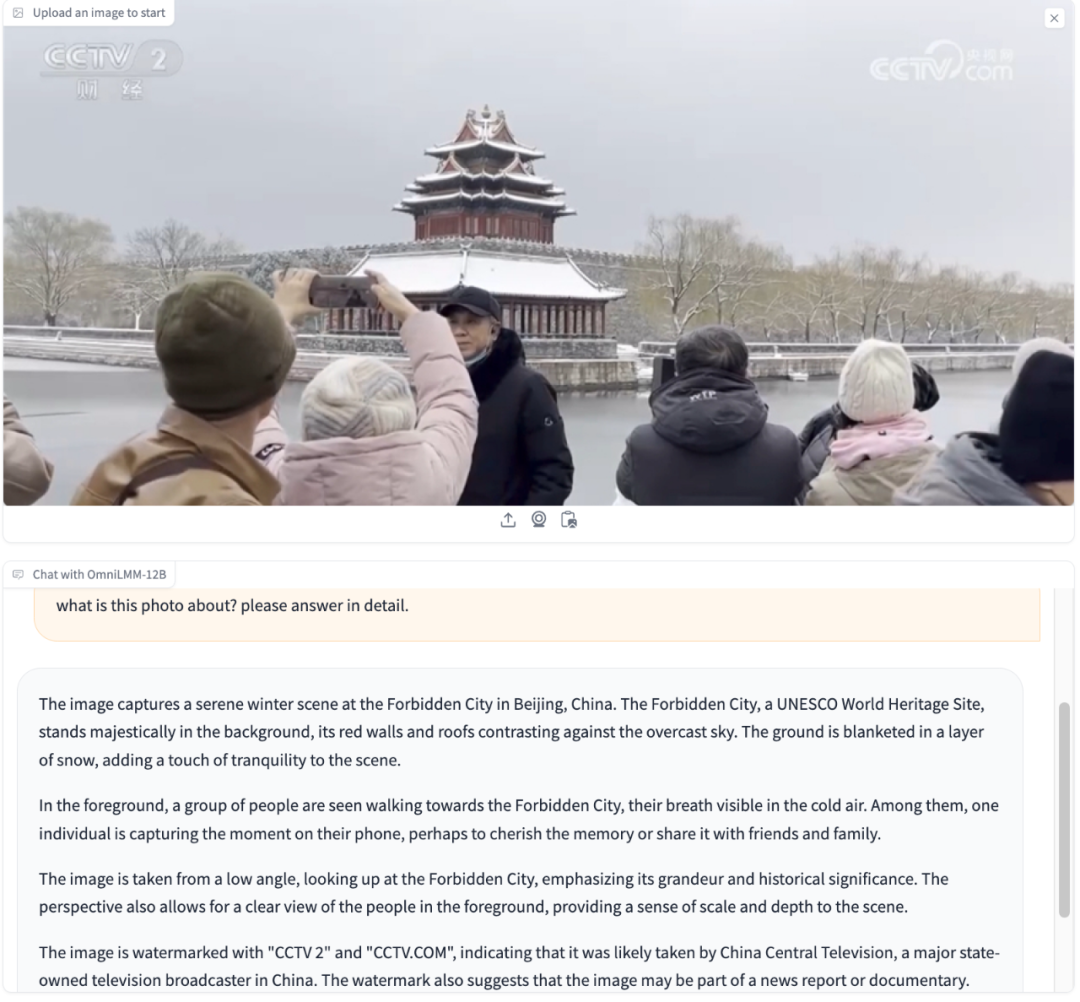

En plus des modèles end-side, Wall Intelligence a également démontré son exploration des grands modèles multimodaux et l'open source du paramètre 12B OmniLMM. Lors de la conférence de presse, Face Wall Intelligence a présenté la même démonstration pierre-papier-ciseaux lors de la sortie de Gemini. Demandez à l'IA en anglais : à quel jeu je joue ? Le grand modèle répondrait : pierre, papier, ciseaux.

En même temps, OmniLMM peut également reconnaître les gestes humains et vous dire quoi jouer si vous voulez gagner.

OmniLMM peut également comprendre et raisonner sur les informations contenues dans de nombreuses images, telles que des bâtiments emblématiques, des logos de chaînes de télévision, des activités organisées par des personnes, etc.

Il semble que nous ne soyons pas loin de grands modèles véritablement multimodaux et de l'application de nouvelles formes.

La performance ultime du grand modèle intelligent mural vient de l’accumulation technologique à long terme de l’entreprise. Depuis 2021, Wallface Intelligence a construit une pile technologique efficace, en se concentrant sur les trois directions de l'Infra, des algorithmes et de la méthodologie des données. Parmi eux, le cadre de formation efficace développé par BMTrain est crucial.

Au niveau des algorithmes, Wall-Facing Intelligence a également accumulé un système de bac à sable de modèles, qui a élevé les grands modèles de l'alchimie au niveau de la science expérimentale. En théorie, elle est constamment à la recherche de solutions optimales pour les hyperparamètres et l'échelle. , comme la taille optimale du lot, la configuration des hyperparamètres commune à toutes les tailles de modèles.

Actuellement, Wall-Facing Intelligence a accumulé une grande quantité de données de haute qualité. Après la sortie d'hier, Face Wall Intelligence a open source sa nouvelle génération de grandes séries de modèles (y compris MiniCPM-SFT / DPOMiniCPM-V & MiniCPM-SFT / DPO-int4), ainsi que les recettes de données pour les deux étapes de formation MiniCPM pour référence de l'industrie. .

Adresse Open source (y compris le rapport technique) :

MiniCPM GitHub : https://github.com/OpenBMB/MiniCPM

OmniLMM GitHub : https://github.com/OpenBMB/OmniLMM

L'intelligence face au mur est originaire de Tsinghua NLP Le laboratoire est l'une des premières équipes à mener des recherches sur de grands modèles en Chine. En 2018, il a publié le premier modèle de pré-formation ERNIE au monde basé sur des conseils de connaissances. Face Wall Intelligence, qui a démarré ses activités en août 2022, a connu deux cycles de financement l'année dernière, et son application « Mian Wall Luka » a également reçu le deuxième lot d'enregistrements de grands modèles de l'Administration chinoise du cyberespace.

Actuellement, Wall-Facing Intelligence a constitué une équipe de recherche scientifique de plus de 100 personnes, dont 80 % sont originaires de Qingbei, avec une moyenne d'âge de 28 ans.

Wall-face Intelligence construit une stratégie double moteur grand modèle + agent, dans l'espoir de créer une solution à plus petite échelle, plus rapide et moins coûteuse.

Cette année, Wall-Facing Intelligence accélérera également l’itération des nouvelles technologies. « Nous continuerons à publier de nouvelles versions de MiniCPM après la Fête du Printemps, et les performances seront encore améliorées. Nous voulons donner à tout le monde une pause pendant la Fête du Printemps », a déclaré Liu Zhiyuan.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Le robot DeepMind joue au tennis de table, et son coup droit et son revers glissent dans les airs, battant complètement les débutants humains

Aug 09, 2024 pm 04:01 PM

Le robot DeepMind joue au tennis de table, et son coup droit et son revers glissent dans les airs, battant complètement les débutants humains

Aug 09, 2024 pm 04:01 PM

Mais peut-être qu’il ne pourra pas vaincre le vieil homme dans le parc ? Les Jeux Olympiques de Paris battent leur plein et le tennis de table suscite beaucoup d'intérêt. Dans le même temps, les robots ont également réalisé de nouvelles avancées dans le domaine du tennis de table. DeepMind vient tout juste de proposer le premier agent robot apprenant capable d'atteindre le niveau des joueurs amateurs humains de tennis de table de compétition. Adresse papier : https://arxiv.org/pdf/2408.03906 Quelle est la capacité du robot DeepMind à jouer au tennis de table ? Probablement à égalité avec les joueurs amateurs humains : tant en coup droit qu'en revers : l'adversaire utilise une variété de styles de jeu, et le robot peut également résister : recevoir des services avec des tours différents : Cependant, l'intensité du jeu ne semble pas aussi intense que le vieil homme dans le parc. Pour les robots, le tennis de table

La première griffe mécanique ! Yuanluobao est apparu à la World Robot Conference 2024 et a lancé le premier robot d'échecs pouvant entrer dans la maison

Aug 21, 2024 pm 07:33 PM

La première griffe mécanique ! Yuanluobao est apparu à la World Robot Conference 2024 et a lancé le premier robot d'échecs pouvant entrer dans la maison

Aug 21, 2024 pm 07:33 PM

Le 21 août, la Conférence mondiale sur les robots 2024 s'est tenue en grande pompe à Pékin. La marque de robots domestiques de SenseTime, "Yuanluobot SenseRobot", a dévoilé toute sa famille de produits et a récemment lancé le robot de jeu d'échecs Yuanluobot AI - Chess Professional Edition (ci-après dénommé "Yuanluobot SenseRobot"), devenant ainsi le premier robot d'échecs au monde pour le maison. En tant que troisième produit robot jouant aux échecs de Yuanluobo, le nouveau robot Guoxiang a subi un grand nombre de mises à niveau techniques spéciales et d'innovations en matière d'IA et de machines d'ingénierie. Pour la première fois, il a réalisé la capacité de ramasser des pièces d'échecs en trois dimensions. grâce à des griffes mécaniques sur un robot domestique et effectuer des fonctions homme-machine telles que jouer aux échecs, tout le monde joue aux échecs, réviser la notation, etc.

Claude aussi est devenu paresseux ! Internaute : apprenez à vous accorder des vacances

Sep 02, 2024 pm 01:56 PM

Claude aussi est devenu paresseux ! Internaute : apprenez à vous accorder des vacances

Sep 02, 2024 pm 01:56 PM

La rentrée scolaire est sur le point de commencer, et ce ne sont pas seulement les étudiants qui sont sur le point de commencer le nouveau semestre qui doivent prendre soin d’eux-mêmes, mais aussi les grands modèles d’IA. Il y a quelque temps, Reddit était rempli d'internautes se plaignant de la paresse de Claude. « Son niveau a beaucoup baissé, il fait souvent des pauses et même la sortie devient très courte. Au cours de la première semaine de sortie, il pouvait traduire un document complet de 4 pages à la fois, mais maintenant il ne peut même plus produire une demi-page. !" https://www.reddit.com/r/ClaudeAI/comments/1by8rw8/something_just_feels_wrong_with_claude_in_the/ dans un post intitulé "Totalement déçu par Claude", plein de

Lors de la World Robot Conference, ce robot domestique porteur de « l'espoir des futurs soins aux personnes âgées » a été entouré

Aug 22, 2024 pm 10:35 PM

Lors de la World Robot Conference, ce robot domestique porteur de « l'espoir des futurs soins aux personnes âgées » a été entouré

Aug 22, 2024 pm 10:35 PM

Lors de la World Robot Conference qui se tient à Pékin, l'exposition de robots humanoïdes est devenue le centre absolu de la scène. Sur le stand Stardust Intelligent, l'assistant robot IA S1 a réalisé trois performances majeures de dulcimer, d'arts martiaux et de calligraphie. un espace d'exposition, capable à la fois d'arts littéraires et martiaux, a attiré un grand nombre de publics professionnels et de médias. Le jeu élégant sur les cordes élastiques permet au S1 de démontrer un fonctionnement fin et un contrôle absolu avec vitesse, force et précision. CCTV News a réalisé un reportage spécial sur l'apprentissage par imitation et le contrôle intelligent derrière "Calligraphy". Le fondateur de la société, Lai Jie, a expliqué que derrière les mouvements soyeux, le côté matériel recherche le meilleur contrôle de la force et les indicateurs corporels les plus humains (vitesse, charge). etc.), mais du côté de l'IA, les données réelles de mouvement des personnes sont collectées, permettant au robot de devenir plus fort lorsqu'il rencontre une situation forte et d'apprendre à évoluer rapidement. Et agile

Annonce des prix ACL 2024 : l'un des meilleurs articles sur le déchiffrement Oracle par HuaTech, GloVe Time Test Award

Aug 15, 2024 pm 04:37 PM

Annonce des prix ACL 2024 : l'un des meilleurs articles sur le déchiffrement Oracle par HuaTech, GloVe Time Test Award

Aug 15, 2024 pm 04:37 PM

Les contributeurs ont beaucoup gagné de cette conférence ACL. L'ACL2024, d'une durée de six jours, se tient à Bangkok, en Thaïlande. ACL est la plus grande conférence internationale dans le domaine de la linguistique informatique et du traitement du langage naturel. Elle est organisée par l'Association internationale pour la linguistique informatique et a lieu chaque année. L'ACL s'est toujours classée première en termes d'influence académique dans le domaine de la PNL, et c'est également une conférence recommandée par le CCF-A. La conférence ACL de cette année est la 62e et a reçu plus de 400 travaux de pointe dans le domaine de la PNL. Hier après-midi, la conférence a annoncé le meilleur article et d'autres récompenses. Cette fois, il y a 7 Best Paper Awards (deux inédits), 1 Best Theme Paper Award et 35 Outstanding Paper Awards. La conférence a également décerné 3 Resource Paper Awards (ResourceAward) et Social Impact Award (

Hongmeng Smart Travel S9 et conférence de lancement de nouveaux produits avec scénario complet, un certain nombre de nouveaux produits à succès ont été lancés ensemble

Aug 08, 2024 am 07:02 AM

Hongmeng Smart Travel S9 et conférence de lancement de nouveaux produits avec scénario complet, un certain nombre de nouveaux produits à succès ont été lancés ensemble

Aug 08, 2024 am 07:02 AM

Cet après-midi, Hongmeng Zhixing a officiellement accueilli de nouvelles marques et de nouvelles voitures. Le 6 août, Huawei a organisé la conférence de lancement de nouveaux produits Hongmeng Smart Xingxing S9 et Huawei, réunissant la berline phare intelligente panoramique Xiangjie S9, le nouveau M7Pro et Huawei novaFlip, MatePad Pro 12,2 pouces, le nouveau MatePad Air, Huawei Bisheng With de nombreux nouveaux produits intelligents tous scénarios, notamment la série d'imprimantes laser X1, FreeBuds6i, WATCHFIT3 et l'écran intelligent S5Pro, des voyages intelligents, du bureau intelligent aux vêtements intelligents, Huawei continue de construire un écosystème intelligent complet pour offrir aux consommateurs une expérience intelligente du Internet de tout. Hongmeng Zhixing : Autonomisation approfondie pour promouvoir la modernisation de l'industrie automobile intelligente Huawei s'associe à ses partenaires de l'industrie automobile chinoise pour fournir

L'équipe de Li Feifei a proposé ReKep pour donner aux robots une intelligence spatiale et intégrer GPT-4o

Sep 03, 2024 pm 05:18 PM

L'équipe de Li Feifei a proposé ReKep pour donner aux robots une intelligence spatiale et intégrer GPT-4o

Sep 03, 2024 pm 05:18 PM

Intégration profonde de la vision et de l'apprentissage des robots. Lorsque deux mains de robot travaillent ensemble en douceur pour plier des vêtements, verser du thé et emballer des chaussures, associées au robot humanoïde 1X NEO qui a fait la une des journaux récemment, vous pouvez avoir le sentiment : nous semblons entrer dans l'ère des robots. En fait, ces mouvements soyeux sont le produit d’une technologie robotique avancée + d’une conception de cadre exquise + de grands modèles multimodaux. Nous savons que les robots utiles nécessitent souvent des interactions complexes et exquises avec l’environnement, et que l’environnement peut être représenté comme des contraintes dans les domaines spatial et temporel. Par exemple, si vous souhaitez qu'un robot verse du thé, le robot doit d'abord saisir la poignée de la théière et la maintenir verticalement sans renverser le thé, puis la déplacer doucement jusqu'à ce que l'embouchure de la théière soit alignée avec l'embouchure de la tasse. , puis inclinez la théière selon un certain angle. ce

Testé 7 artefacts de génération vidéo « de niveau Sora ». Qui a la capacité de monter sur le « Trône de fer » ?

Aug 05, 2024 pm 07:19 PM

Testé 7 artefacts de génération vidéo « de niveau Sora ». Qui a la capacité de monter sur le « Trône de fer » ?

Aug 05, 2024 pm 07:19 PM

Editeur du Machine Power Report : Yang Wen Qui peut devenir le roi du cercle vidéo de l'IA ? Dans la série télévisée américaine "Game of Thrones", il y a un "Trône de Fer". La légende raconte qu'il a été fabriqué par le dragon géant « Black Death » qui a fait fondre des milliers d'épées abandonnées par les ennemis, symbolisant l'autorité suprême. Pour s'asseoir sur cette chaise de fer, les grandes familles ont commencé à se battre et à se battre. Depuis l'émergence de Sora, un vigoureux "Game of Thrones" a été lancé dans le cercle vidéo de l'IA. Les principaux acteurs de ce jeu incluent RunwayGen-3 et Luma de l'autre côté de l'océan, ainsi que Kuaishou Keling, ByteDream, national. et Zhimo. Spectre Qingying, Vidu, PixVerseV2, etc. Aujourd'hui, nous allons évaluer et voir qui est qualifié pour siéger sur le « Trône de fer » du cercle vidéo IA. -1-Vincent Vidéo