Périphériques technologiques

Périphériques technologiques

IA

IA

La technologie de lecture des pensées de l'IA a été améliorée ! Une paire de lunettes contrôle directement le chien robot Boston, faisant des robots contrôlés par le cerveau une réalité

La technologie de lecture des pensées de l'IA a été améliorée ! Une paire de lunettes contrôle directement le chien robot Boston, faisant des robots contrôlés par le cerveau une réalité

La technologie de lecture des pensées de l'IA a été améliorée ! Une paire de lunettes contrôle directement le chien robot Boston, faisant des robots contrôlés par le cerveau une réalité

Vous souvenez-vous encore des compétences de lecture dans les pensées de l'IA d'avant ? Récemment, la capacité de « réaliser tous vos souhaits » a encore évolué,

- les humains peuvent contrôler directement les robots par leurs propres pensées !

Les chercheurs du MIT ont publié le projet Ddog. Ils ont développé indépendamment un dispositif d'interface cerveau-ordinateur (BCI) pour contrôler le chien robot Spot de Boston Dynamics.

Les chiens peuvent se déplacer vers des zones spécifiques, aider les gens à obtenir des objets ou prendre des photos selon les pensées humaines.

Par rapport au casque précédent qui nécessitait l'utilisation de nombreux capteurs pour "lire dans les pensées", cette fois le dispositif d'interface cerveau-ordinateur se présente sous la forme de lunettes sans fil (AttentivU).

Bien que le comportement montré dans la vidéo soit simple, le but de ce système est de transformer Spot en un outil de communication de base pour aider les personnes atteintes de maladies telles que la SLA, la paralysie cérébrale ou les lésions de la moelle épinière.

Deux iPhones et une paire de lunettes peuvent apporter une aide et des soins pratiques aux personnes désespérées.

Et, comme nous le verrons dans des articles connexes, ce système repose en fait sur une ingénierie très complexe.

Adresse papier : https://doi.org/10.3390/s24010080

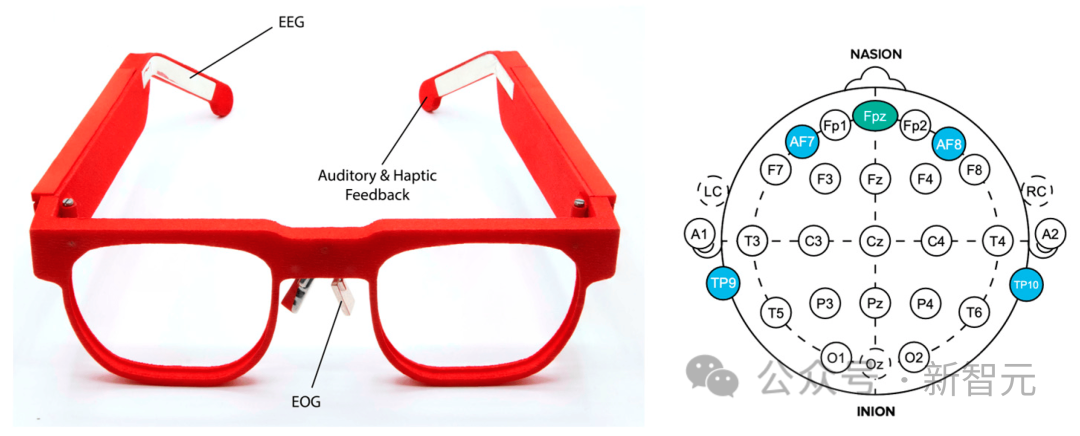

Le système Ddog utilise AttentivU comme système d'interface cerveau-ordinateur, et le capteur est intégré dans le cadre pour mesurer l'électroencéphalogramme d'une personne. (EEG) ou activité cérébrale, et électrooculogramme ou mouvements oculaires.

Le fondement de cette recherche est le Brain Switch du MIT, un BCI en boucle fermée en temps réel qui permet aux utilisateurs de communiquer de manière non verbale et en temps réel avec les soignants.

Le système Ddog a un taux de réussite de 83,4 %, et c'est la première fois qu'un système BCI sans fil et non visuel est intégré à Spot dans un cas d'utilisation d'assistant personnel.

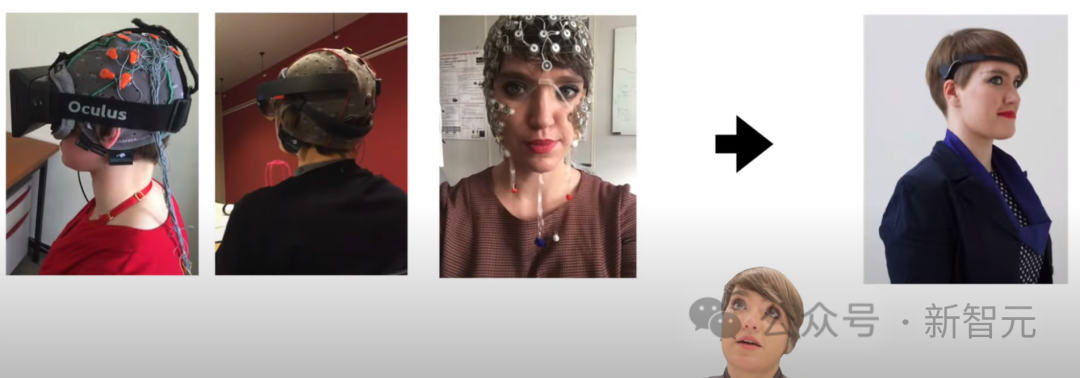

Dans la vidéo, nous pouvons voir l'évolution des dispositifs d'interface cérébrale et certaines des réflexions des développeurs.

Avant cela, l'équipe de recherche a terminé l'interaction entre l'interface cerveau-ordinateur et la maison intelligente, et a maintenant terminé le contrôle d'un robot capable de se déplacer et de fonctionner.

Ces études ont donné à des personnes spéciales une lueur de lumière, leur donnant l'espoir de survivre et même de vivre mieux à l'avenir.

Par rapport au casque à capteur de type poulpe, les lunettes ci-dessous sont en effet beaucoup plus cool.

Selon l'Organisation nationale pour les maladies rares, il y a actuellement 30 000 patients atteints de SLA aux États-Unis et environ 5 000 nouveaux cas sont diagnostiqués chaque année. De plus, environ 1 million d'Américains souffrent de paralysie cérébrale, selon le Cerebral Palsy Guide.

Beaucoup de ces personnes ont ou finiront par perdre la capacité de marcher, de s'habiller, de parler, d'écrire et même de respirer.

Bien que des aides à la communication existent, la plupart sont des appareils oculaires qui permettent aux utilisateurs de communiquer à l'aide d'un ordinateur. Il n’existe pas beaucoup de systèmes permettant aux utilisateurs d’interagir avec le monde qui les entoure.

Ce système robotique quadrupède BCI sert de premier prototype, ouvrant la voie au développement futur de robots assistants personnels modernes.

J'espère que nous pourrons voir des capacités encore plus étonnantes dans les futures itérations.

Robot quadrupède contrôlé par le cerveau

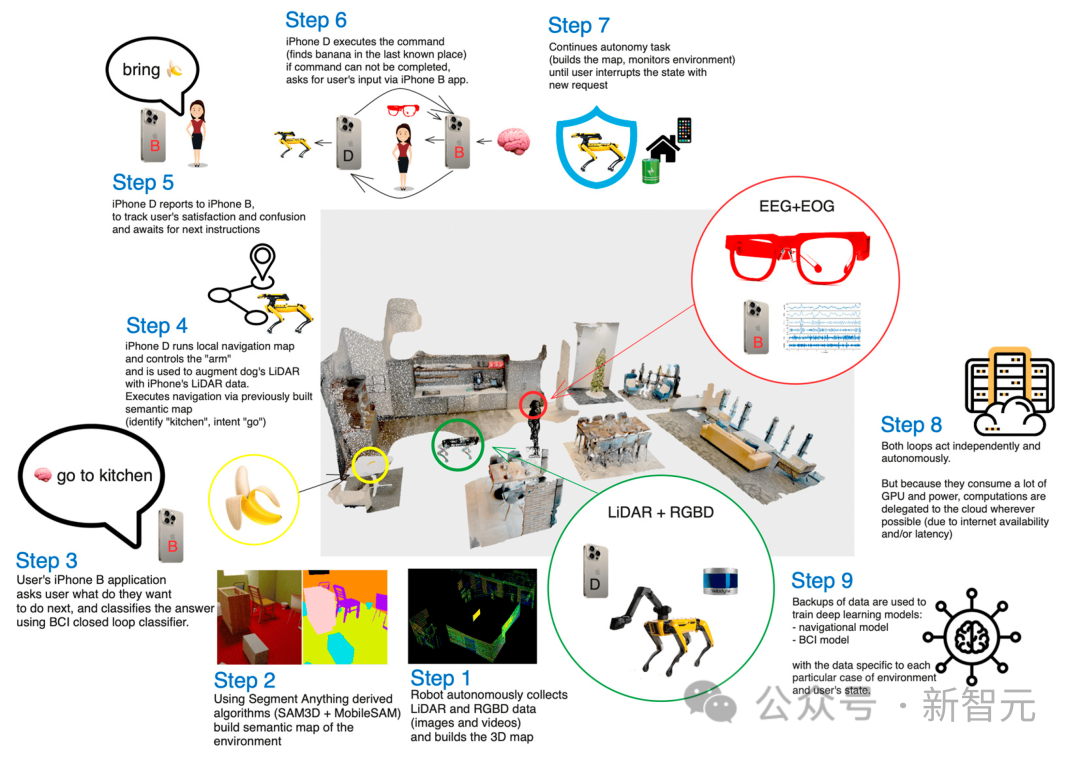

Dans ce travail, les chercheurs explorent comment les appareils BCI sans fil et portables peuvent contrôler un robot quadrupède - Spot de Boston Dynamics.

L'appareil développé par les chercheurs mesure l'activité de l'électroencéphalogramme (EEG) et de l'électrooculogramme (EOG) de l'utilisateur grâce à des électrodes intégrées dans la monture des lunettes.

Les utilisateurs répondent à une série de questions dans leur esprit ("oui" ou "non"), et chaque question correspond à un ensemble d'opérations Spot prédéfinies.

Par exemple, invitez Spot à traverser une pièce, à ramasser un objet (comme une bouteille d'eau), puis à le récupérer pour l'utilisateur.

Robots et BCI

À ce jour, l'EEG reste l'une des méthodes d'interface cerveau-ordinateur non invasives les plus pratiques et les plus applicables.

Les systèmes BCI peuvent être contrôlés à l'aide de signaux endogènes (spontanés) ou exogènes (évoqués).

Dans les interfaces cerveau-ordinateur exogènes, les signaux évoqués se produisent lorsqu'une personne prête attention à des stimuli externes, tels que des signaux visuels ou auditifs.

Les avantages de cette méthode incluent un entraînement minimaliste et des débits élevés allant jusqu'à 60 bits/min, mais cela oblige l'utilisateur à toujours se concentrer sur le stimulus, limitant ainsi son applicabilité dans la vie réelle. De plus, les utilisateurs se fatiguent rapidement lorsqu’ils utilisent des BCI exogènes.

Dans les interfaces cerveau-ordinateur endogènes, les signaux de contrôle sont générés indépendamment de tout stimulus externe et peuvent être entièrement exécutés par l'utilisateur à la demande. Pour les utilisateurs souffrant de déficiences sensorielles, cela offre une manière d'interagir plus naturelle et intuitive, permettant aux utilisateurs d'émettre spontanément des commandes au système.

Cependant, cette méthode nécessite généralement un temps de formation plus long et a un débit binaire plus faible.

Les applications robotiques utilisant des interfaces cerveau-ordinateur conviennent souvent aux personnes ayant besoin d'assistance et incluent souvent des fauteuils roulants et des exosquelettes.

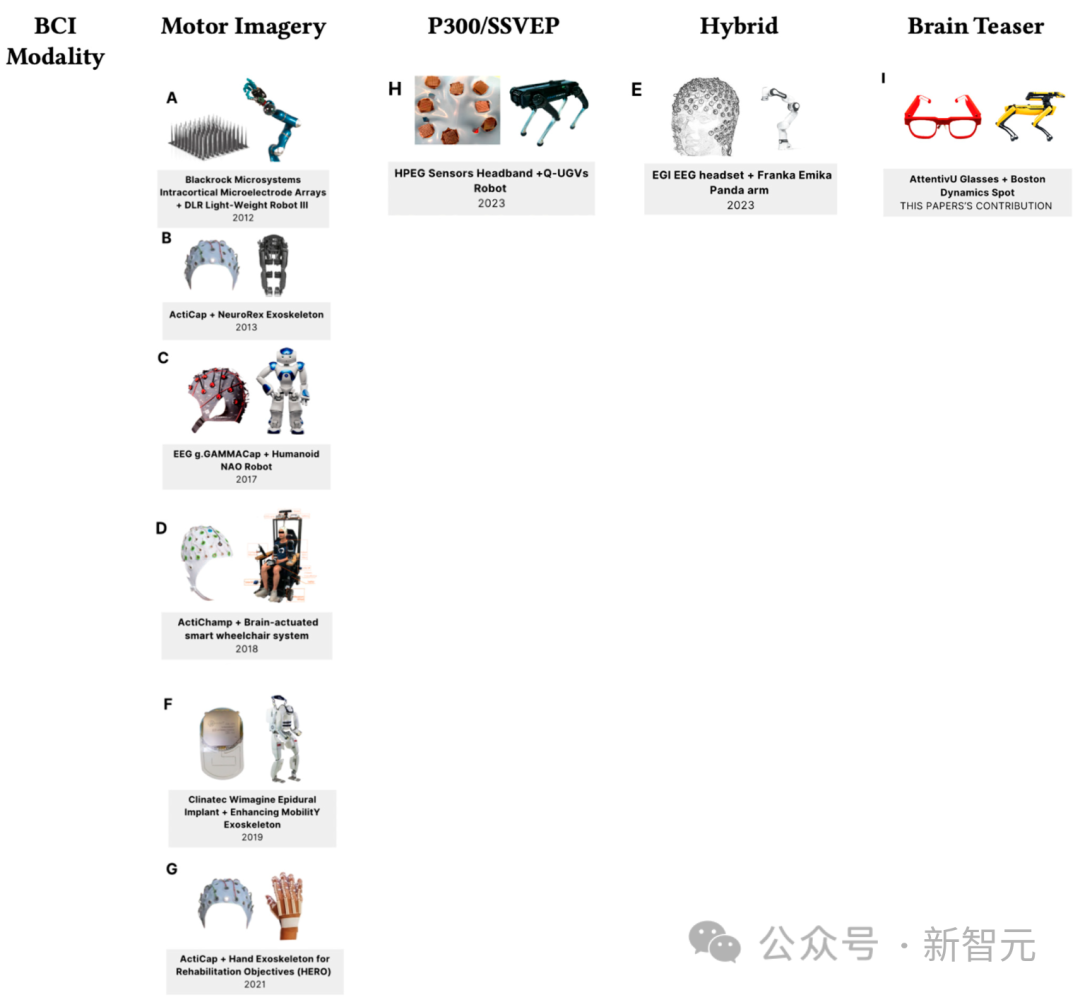

La figure ci-dessous montre les derniers progrès en matière d'interface cerveau-ordinateur et de technologie robotique à partir de 2023.

Les robots quadrupèdes sont souvent utilisés pour assister les utilisateurs dans des environnements de travail complexes ou des applications de défense.

L'un des robots quadrupèdes les plus célèbres est le Spot de Boston Dynamics, qui peut transporter jusqu'à 15 kg de charge utile et cartographier de manière itérative les sites de maintenance tels que les tunnels. Les secteurs de l'immobilier et des mines adoptent également des robots à quatre pattes comme Spot pour aider à surveiller les chantiers à la logistique complexe.

Cet article utilise le robot Spot contrôlé par la solution mobile BCI et est basé sur des tâches de calcul mental. L'architecture globale s'appelle Ddog.

Architecture Ddog

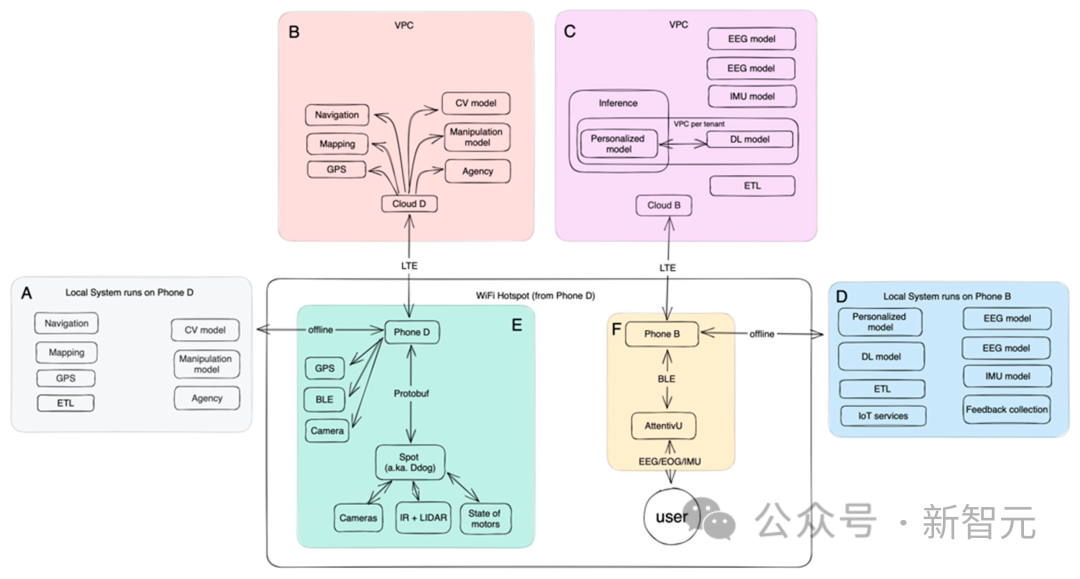

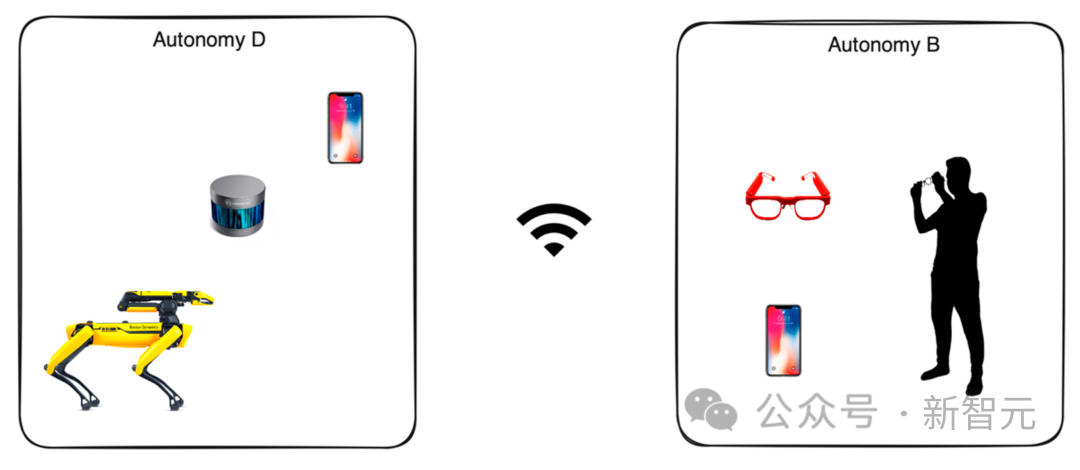

La figure suivante montre la structure globale de Ddog :

Ddog est une application autonome qui permet aux utilisateurs de contrôler le robot Spot via l'entrée de BCI, et l'application utilise la voix. Fournit des commentaires aux utilisateurs et à leurs soignants.

Le système est conçu pour fonctionner complètement hors ligne ou entièrement en ligne. La version en ligne dispose d'un ensemble plus avancé de modèles d'apprentissage automatique, ainsi que de modèles mieux ajustés, et est plus économe en énergie pour les appareils locaux.

L'ensemble du système est conçu pour des scénarios réels et permet une itération rapide sur la plupart des pièces.

Côté client, l'utilisateur interagit avec le dispositif d'interface cerveau-ordinateur (AttentivU) via une application mobile, qui utilise le protocole Bluetooth Low Energy (BLE) pour communiquer avec l'appareil.

L'appareil mobile de l'utilisateur communique avec un autre téléphone contrôlant le robot Spot pour permettre l'action, la manipulation, la navigation et finalement l'assistance à l'utilisateur.

La communication entre les téléphones peut se faire via Wi-Fi ou réseau mobile. Le téléphone mobile contrôlé établit un point d'accès Wi-Fi, et Ddog ainsi que le téléphone mobile de l'utilisateur sont connectés à ce point d'accès. Lorsque vous utilisez le mode en ligne, vous pouvez également vous connecter à des modèles exécutés sur le cloud.

Côté serveur

Le côté serveur utilise des clusters Kubernetes (K8S), et chaque cluster est déployé dans son propre cloud privé virtuel (VPC).

Le cloud fonctionne au sein d'un VPC dédié, généralement déployé dans la même zone de disponibilité, plus proche des utilisateurs finaux, minimisant ainsi la latence de réponse pour chaque service.

Chaque conteneur du cluster est conçu dans un seul but (architecture de microservices), chaque service est un modèle d'IA en cours d'exécution, leurs tâches incluent : la navigation, la cartographie, la vision par ordinateur, la manipulation, le positionnement et l'agence.

Mapping : Un service qui collecte des informations sur l’environnement du robot à partir de différentes sources. Il cartographie des données statiques et immobiles (un arbre, un bâtiment, un mur) mais collecte également des données dynamiques qui évoluent dans le temps (une voiture, une personne).

Navigation : Sur la base des données cartographiques collectées et augmentées dans les services précédents, le service de navigation est chargé de construire le chemin entre le point A et le point B dans l'espace et le temps. Il est également chargé de construire des itinéraires alternatifs, ainsi que d'estimer le temps nécessaire.

Vision par ordinateur : collectez des données visuelles à partir de caméras de robots et augmentez-les avec les données de votre téléphone pour générer des représentations spatiales et temporelles. Ce service tente également de segmenter chaque point visuel et d'identifier les objets.

Le cloud est responsable de la formation des modèles liés au BCI, notamment l'électroencéphalogramme (EEG), l'électrooculogramme (EOG) et l'unité de mesure inertielle (IMU).

Les modèles hors ligne déployés sur les téléphones mobiles effectuent la collecte et l'agrégation de données, tout en utilisant également les modèles mobiles de TensorFlow (optimisés pour les petites RAM et les processeurs ARM) pour l'inférence en temps réel.

Vision et opérations

La version originale utilisée pour déployer le modèle de segmentation était un modèle 3D TensorFlow unique exploitant les données LIDAR. Les auteurs ont ensuite étendu cela à un modèle à quelques plans et l'ont amélioré en exécutant des modèles complémentaires sur les données Neural Radiation Field (NeRF) et RGBD.

Les données brutes collectées par Ddog sont regroupées à partir de cinq caméras. Chaque caméra fournit des données en niveaux de gris, fisheye, profondeur et infrarouge. Il y a également une sixième caméra à l'intérieur de la pince du bras, avec une résolution 4K et des capacités LED, qui fonctionne avec un modèle TensorFlow pré-entraîné pour détecter des objets.

Les nuages de points sont générés à partir des données lidar et des données RGBD de Ddog et des téléphones mobiles. Une fois l’acquisition des données terminée, elles sont normalisées via un système de coordonnées unique et adaptées à un état global qui rassemble toutes les données d’imagerie et de positionnement 3D.

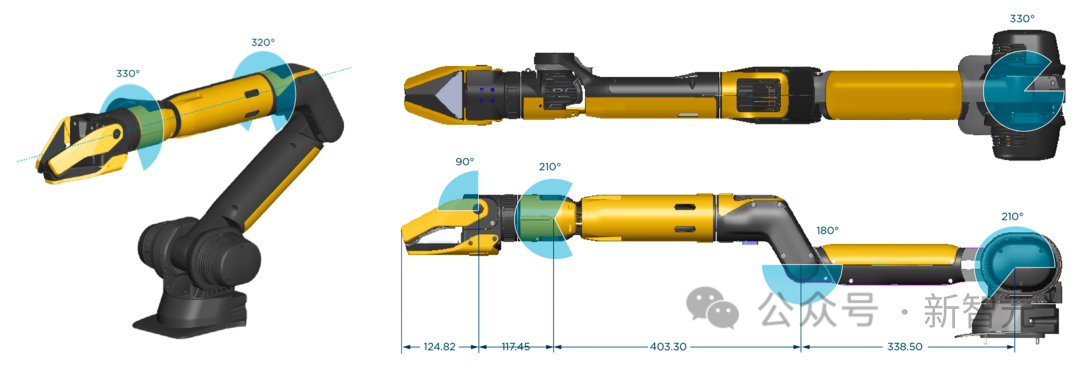

Le fonctionnement dépend entièrement de la qualité de la pince du bras robotique installée sur le Ddog. La pince sur la photo ci-dessous est fabriquée par Boston Dynamics.

Limitez vos cas d'utilisation aux interactions de base avec des objets dans des emplacements prédéfinis.

L'auteur a dessiné un grand espace laboratoire et l'a aménagé comme un "appartement", qui contient un espace "cuisine" (avec un plateau avec différentes tasses et bouteilles), un espace "salon" (avec oreillers) petit canapé et petite table basse), et un espace "salon fenêtre".

Le nombre de cas d'utilisation est en constante augmentation, la seule façon de couvrir la plupart d'entre eux est donc de déployer un système qui fonctionnera en continu pendant un certain temps et d'utiliser les données pour optimiser ces séquences et expériences.

AttentivU

Les données EEG sont collectées à partir de l'appareil AttentivU. Les électrodes des lunettes AttentivU sont en argent naturel et sont situées aux niveaux TP9 et TP10 selon le système international de placement des électrodes 10-20. Les lunettes comprennent également deux électrodes EOG situées sur les plaquettes nasales et une électrode de référence EEG située au niveau Fpz.

Ces capteurs peuvent fournir les informations nécessaires et permettre une intervention en temps réel en boucle fermée en cas de besoin.

L'appareil dispose de deux modes, EEG et EOG, qui peuvent être utilisés pour capturer les signaux d'attention, d'engagement, de fatigue et de charge cognitive en temps réel. L'EEG a été utilisé comme indicateur neurophysiologique de la transition entre l'éveil et le sommeil,

tandis que l'EOG est basé sur la mesure des signaux bioélectriques induits lors des mouvements oculaires en raison des propriétés dipolaires cornéennes-rétiniennes. La recherche montre que les mouvements oculaires sont en corrélation avec le type d’accès à la mémoire nécessaire pour effectuer certaines tâches et constituent une bonne mesure de l’engagement visuel, de l’attention et de la somnolence.

Expérience

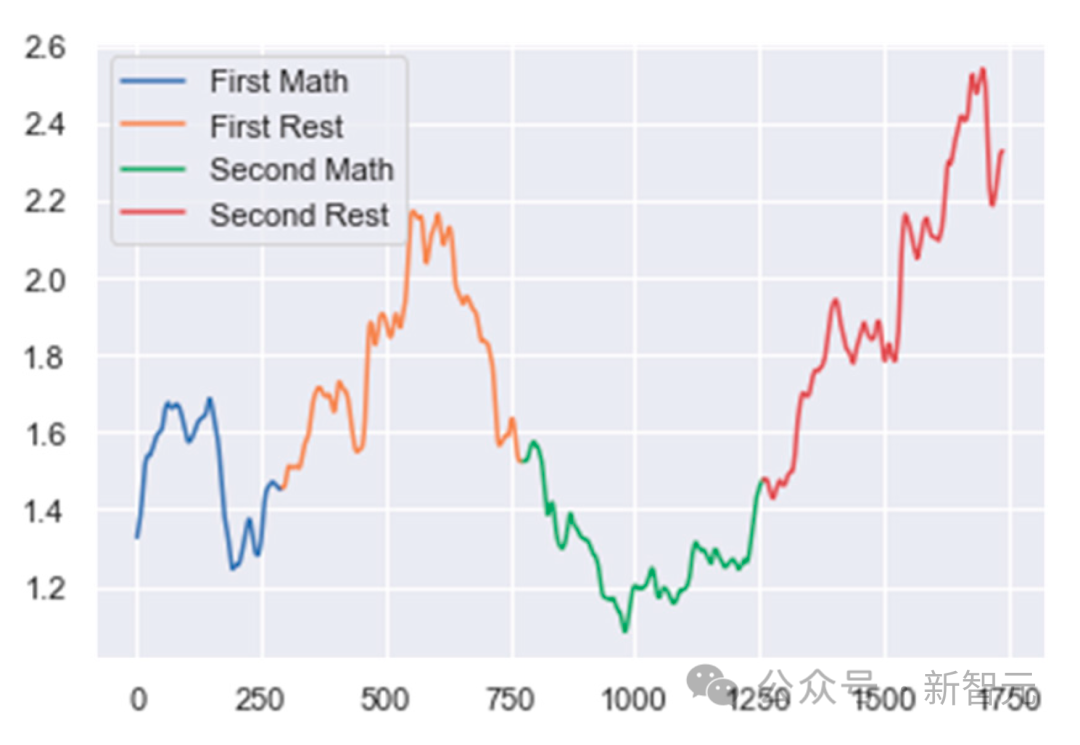

Divisez d'abord les données EEG en plusieurs fenêtres. Définissez chaque fenêtre comme une durée de 1 seconde de données EEG avec un chevauchement de 75 % avec la fenêtre précédente.

Vient ensuite le prétraitement et le nettoyage des données. Les données ont été filtrées à l'aide d'une combinaison d'un filtre coupe-bande de 50 Hz et d'un filtre passe-bande avec une bande passante de 0,5 Hz à 40 Hz pour garantir l'élimination du bruit des lignes électriques et des hautes fréquences indésirables.

Ensuite, l'auteur a créé un algorithme de rejet d'artefacts. Une époque est rejetée si la différence de puissance absolue entre deux époques consécutives est supérieure à un seuil prédéfini.

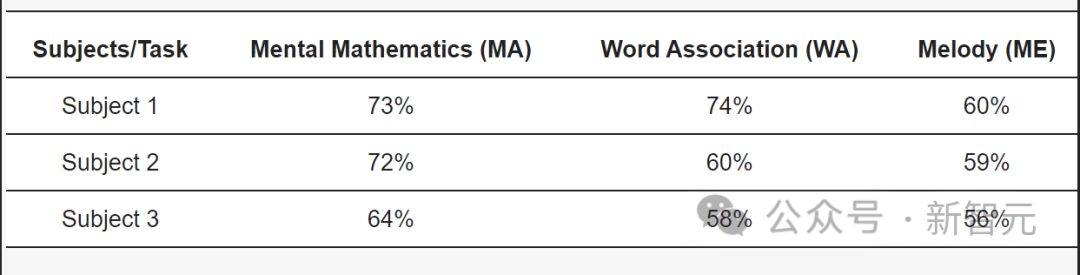

Dans la dernière étape de classification, les auteurs ont mélangé différents rapports de puissance de bande spectrale pour suivre l'activité mentale basée sur la tâche de chaque sujet. Pour MA, le rapport est (alpha/delta). Pour WA, le rapport est (delta/bêta faible) et pour ME, le rapport est (delta/alpha).

Ensuite, utilisez un algorithme de détection de points de changement pour suivre les modifications de ces ratios. Des augmentations ou des diminutions soudaines de ces ratios indiquent un changement dans l'état mental de l'utilisateur.

Pour les sujets atteints de SLA, notre modèle a atteint 73 % de précision dans la tâche MA, 74 % de précision dans la tâche WA et 60 % dans la tâche ME.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Quelle méthode est utilisée pour convertir les chaînes en objets dans vue.js?

Apr 07, 2025 pm 09:39 PM

Quelle méthode est utilisée pour convertir les chaînes en objets dans vue.js?

Apr 07, 2025 pm 09:39 PM

Lors de la conversion des chaînes en objets dans vue.js, JSON.Parse () est préféré pour les chaînes JSON standard. Pour les chaînes JSON non standard, la chaîne peut être traitée en utilisant des expressions régulières et réduisez les méthodes en fonction du format ou du codé décodé par URL. Sélectionnez la méthode appropriée en fonction du format de chaîne et faites attention aux problèmes de sécurité et d'encodage pour éviter les bogues.

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

L'article présente le fonctionnement de la base de données MySQL. Tout d'abord, vous devez installer un client MySQL, tel que MySQLWorkBench ou le client de ligne de commande. 1. Utilisez la commande MySQL-UROot-P pour vous connecter au serveur et connecter avec le mot de passe du compte racine; 2. Utilisez Createdatabase pour créer une base de données et utilisez Sélectionner une base de données; 3. Utilisez CreateTable pour créer une table, définissez des champs et des types de données; 4. Utilisez InsertInto pour insérer des données, remettre en question les données, mettre à jour les données par mise à jour et supprimer les données par Supprimer. Ce n'est qu'en maîtrisant ces étapes, en apprenant à faire face à des problèmes courants et à l'optimisation des performances de la base de données que vous pouvez utiliser efficacement MySQL.

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Il existe de nombreuses raisons pour lesquelles la startup MySQL échoue, et elle peut être diagnostiquée en vérifiant le journal des erreurs. Les causes courantes incluent les conflits de port (vérifier l'occupation du port et la configuration de modification), les problèmes d'autorisation (vérifier le service exécutant les autorisations des utilisateurs), les erreurs de fichier de configuration (vérifier les paramètres des paramètres), la corruption du répertoire de données (restaurer les données ou reconstruire l'espace de la table), les problèmes d'espace de la table InNODB (vérifier les fichiers IBDATA1), la défaillance du chargement du plug-in (vérification du journal des erreurs). Lors de la résolution de problèmes, vous devez les analyser en fonction du journal d'erreur, trouver la cause profonde du problème et développer l'habitude de sauvegarder régulièrement les données pour prévenir et résoudre des problèmes.

Vue.js Comment convertir un tableau de type de chaîne en un tableau d'objets?

Apr 07, 2025 pm 09:36 PM

Vue.js Comment convertir un tableau de type de chaîne en un tableau d'objets?

Apr 07, 2025 pm 09:36 PM

Résumé: Il existe les méthodes suivantes pour convertir les tableaux de chaîne Vue.js en tableaux d'objets: Méthode de base: utilisez la fonction de carte pour convenir à des données formatées régulières. Gameplay avancé: l'utilisation d'expressions régulières peut gérer des formats complexes, mais ils doivent être soigneusement écrits et considérés. Optimisation des performances: Considérant la grande quantité de données, des opérations asynchrones ou des bibliothèques efficaces de traitement des données peuvent être utilisées. MEILLEUR PRATIQUE: Effacer le style de code, utilisez des noms de variables significatifs et des commentaires pour garder le code concis.

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Traiter efficacement 7 millions d'enregistrements et créer des cartes interactives avec la technologie géospatiale. Cet article explore comment traiter efficacement plus de 7 millions d'enregistrements en utilisant Laravel et MySQL et les convertir en visualisations de cartes interactives. Exigences initiales du projet de défi: extraire des informations précieuses en utilisant 7 millions d'enregistrements dans la base de données MySQL. Beaucoup de gens considèrent d'abord les langages de programmation, mais ignorent la base de données elle-même: peut-il répondre aux besoins? La migration des données ou l'ajustement structurel est-il requis? MySQL peut-il résister à une charge de données aussi importante? Analyse préliminaire: les filtres et les propriétés clés doivent être identifiés. Après analyse, il a été constaté que seuls quelques attributs étaient liés à la solution. Nous avons vérifié la faisabilité du filtre et établi certaines restrictions pour optimiser la recherche. Recherche de cartes basée sur la ville

Comment définir le délai de Vue Axios

Apr 07, 2025 pm 10:03 PM

Comment définir le délai de Vue Axios

Apr 07, 2025 pm 10:03 PM

Afin de définir le délai d'expiration de Vue Axios, nous pouvons créer une instance AxiOS et spécifier l'option Timeout: dans les paramètres globaux: vue.prototype. $ Axios = axios.create ({timeout: 5000}); Dans une seule demande: ce. $ axios.get ('/ api / utilisateurs', {timeout: 10000}).

Comment optimiser les performances de la base de données après l'installation de MySQL

Apr 08, 2025 am 11:36 AM

Comment optimiser les performances de la base de données après l'installation de MySQL

Apr 08, 2025 am 11:36 AM

L'optimisation des performances MySQL doit commencer à partir de trois aspects: configuration d'installation, indexation et optimisation des requêtes, surveillance et réglage. 1. Après l'installation, vous devez ajuster le fichier my.cnf en fonction de la configuration du serveur, tel que le paramètre innodb_buffer_pool_size, et fermer query_cache_size; 2. Créez un index approprié pour éviter les index excessifs et optimiser les instructions de requête, telles que l'utilisation de la commande Explication pour analyser le plan d'exécution; 3. Utilisez le propre outil de surveillance de MySQL (ShowProcessList, Showstatus) pour surveiller la santé de la base de données, et sauvegarde régulièrement et organisez la base de données. Ce n'est qu'en optimisant en continu ces étapes que les performances de la base de données MySQL peuvent être améliorées.

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Ingénieur backend à distance Emploi Vacant Société: Emplacement du cercle: Bureau à distance Type d'emploi: Salaire à temps plein: 130 000 $ - 140 000 $ Description du poste Participez à la recherche et au développement des applications mobiles Circle et des fonctionnalités publiques liées à l'API couvrant l'intégralité du cycle de vie de développement logiciel. Les principales responsabilités complètent indépendamment les travaux de développement basés sur RubyOnRails et collaborent avec l'équipe frontale React / Redux / Relay. Créez les fonctionnalités de base et les améliorations des applications Web et travaillez en étroite collaboration avec les concepteurs et le leadership tout au long du processus de conception fonctionnelle. Promouvoir les processus de développement positifs et hiérarchiser la vitesse d'itération. Nécessite plus de 6 ans de backend d'applications Web complexe