Périphériques technologiques

Périphériques technologiques

IA

IA

Le modèle mathématique open source 7B bat des milliards de GPT-4, produit par une équipe chinoise

Le modèle mathématique open source 7B bat des milliards de GPT-4, produit par une équipe chinoise

Le modèle mathématique open source 7B bat des milliards de GPT-4, produit par une équipe chinoise

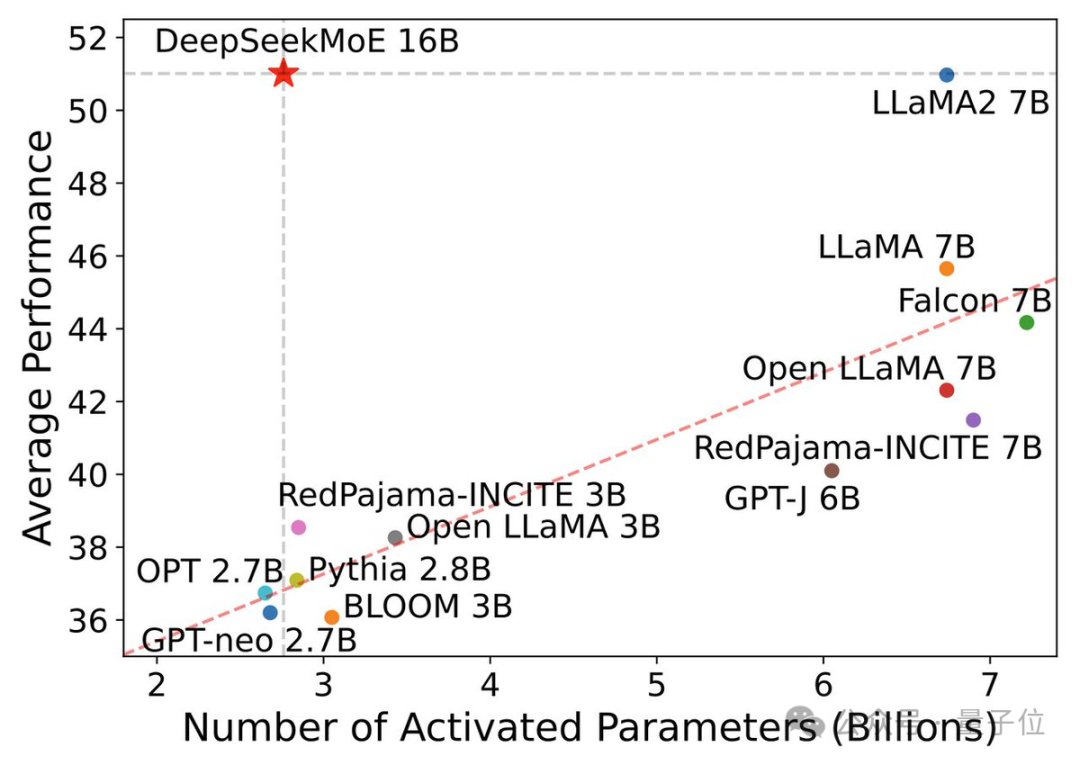

Modèle open source 7B, la puissance mathématique dépasse le GPT-4 à l'échelle de 100 milliards !

On peut dire que ses performances ont dépassé les limites du modèle open source. Même les chercheurs d'Alibaba Tongyi ont déploré l'échec de la loi de mise à l'échelle.

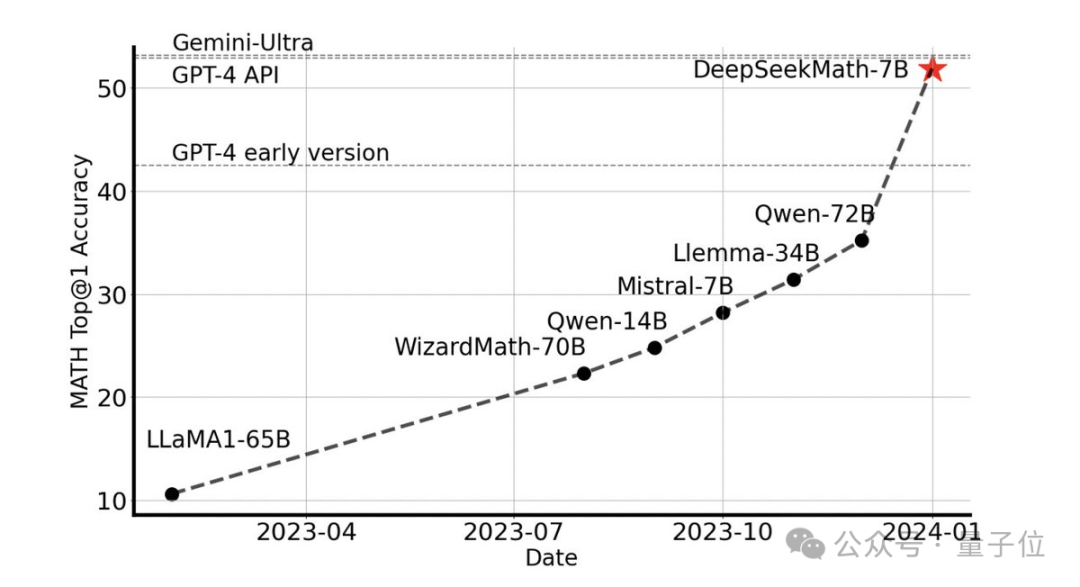

Sans aucun outil externe, il peut atteindre une précision de 51,7 % sur l'ensemble de données MATH de niveau compétition.

Parmi les modèles open source, il est le premier à atteindre la moitié de la précision sur cet ensemble de données, surpassant même les premières versions API de GPT-4.

Cette performance a choqué toute la communauté open source Emad Mostaque, le fondateur de Stability AI, a salué l'équipe R&D comme étant impressionnante et au potentiel sous-estimé.

Il s'agit du dernier grand modèle mathématique open source 7B de l'équipe Deep Search, DeepSeekMath.

Le modèle 7B bat les autres

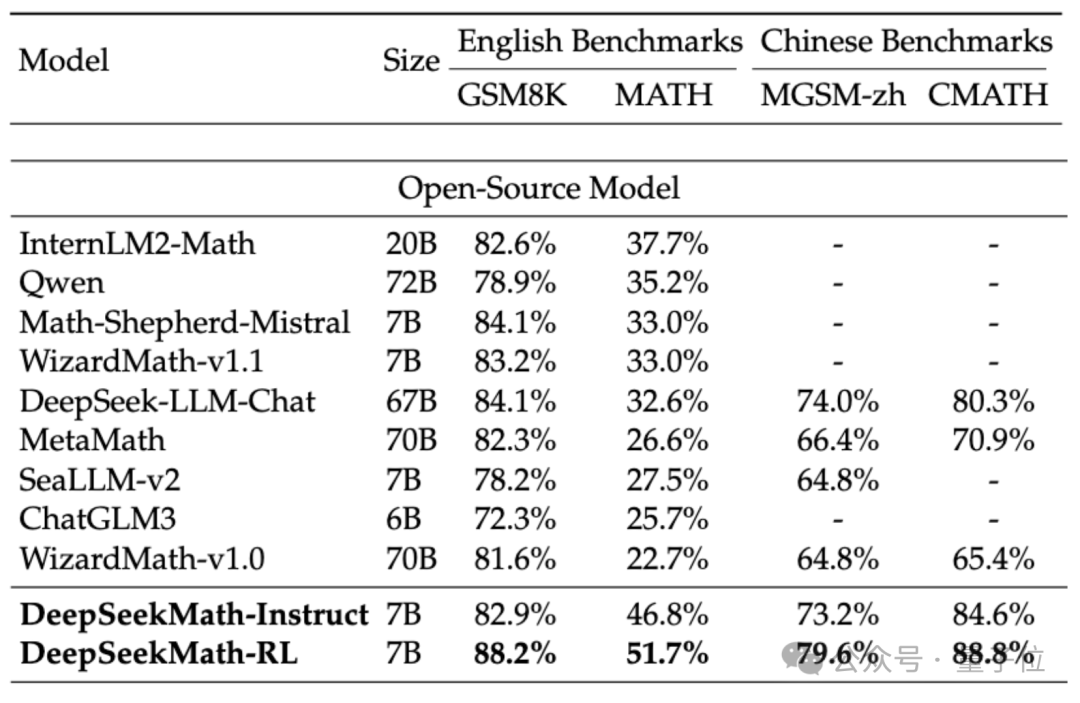

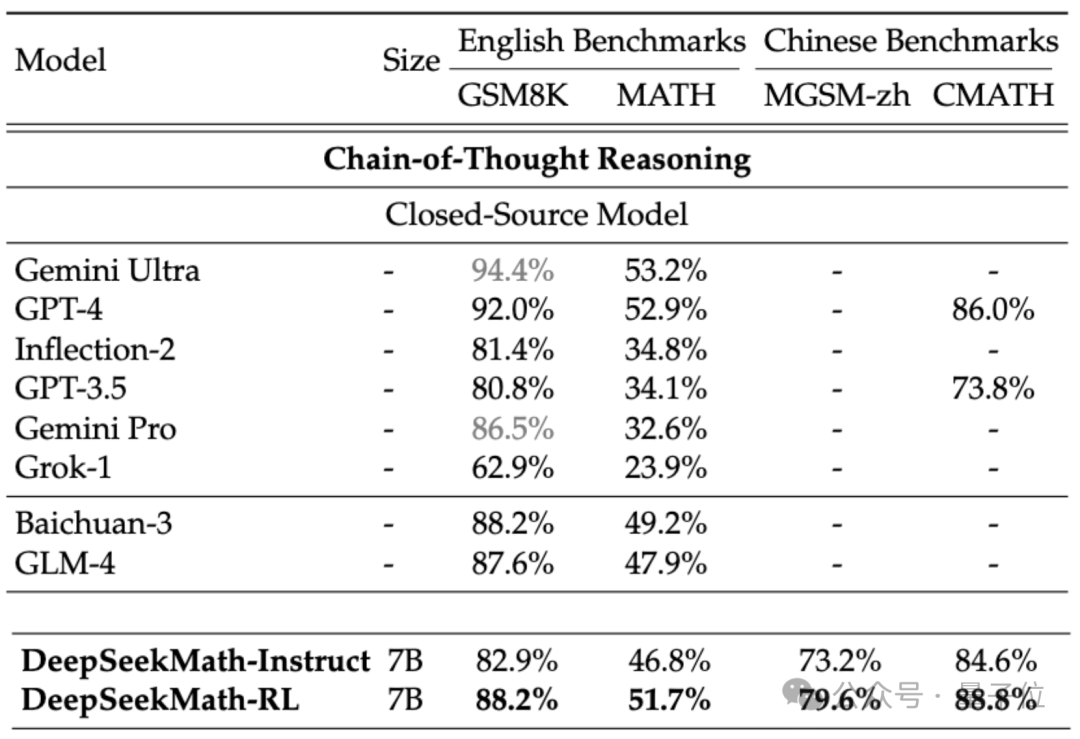

Afin d'évaluer la capacité mathématique de DeepSeekMath, l'équipe de recherche a utilisé des ensembles de données bilingues chinois (MGSM-zh, CMATH) anglais (GSM8K, MATH) pour les tests.

Sans utiliser d'outils auxiliaires et en s'appuyant uniquement sur les invites de la chaîne de pensée(CoT), DeepSeekMath a surpassé les autres modèles open source, y compris le grand modèle mathématique 70B MetaMATH.

Par rapport au grand modèle universel 67B auto-lancé, les résultats de DeepSeekMath ont également été considérablement améliorés.

Si l'on considère le modèle source fermée, DeepSeekMath surpasse également Gemini Pro et GPT-3.5 sur plusieurs ensembles de données, dépasse GPT-4 sur CMATH chinois, et ses performances sur MATH en sont également proches.

Mais il convient de noter que GPT-4 est un monstre avec des centaines de milliards de paramètres selon les spécifications divulguées, alors que DeepSeekMath n'a que 7B de paramètres.

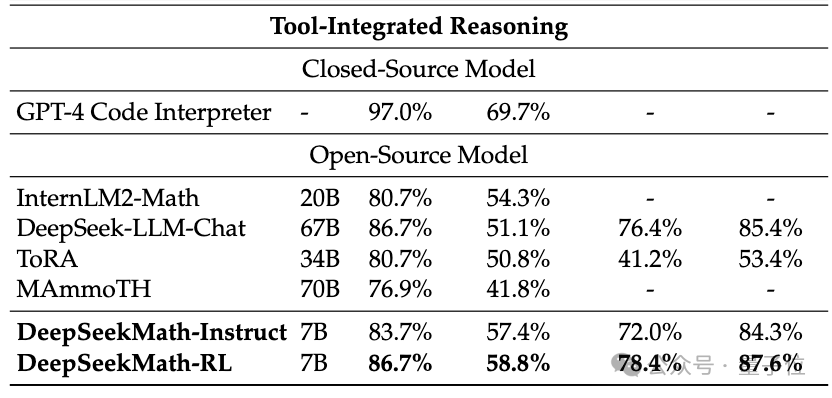

Si l'outil (Python) est autorisé à être utilisé à des fins d'assistance, les performances de DeepSeekMath sur l'ensemble de données de difficulté compétition (MATH) peuvent être améliorées de 7 points de pourcentage supplémentaires.

Alors, quelles technologies sont appliquées derrière les excellentes performances de DeepSeekMath ?

Construit sur la base d'un modèle de code

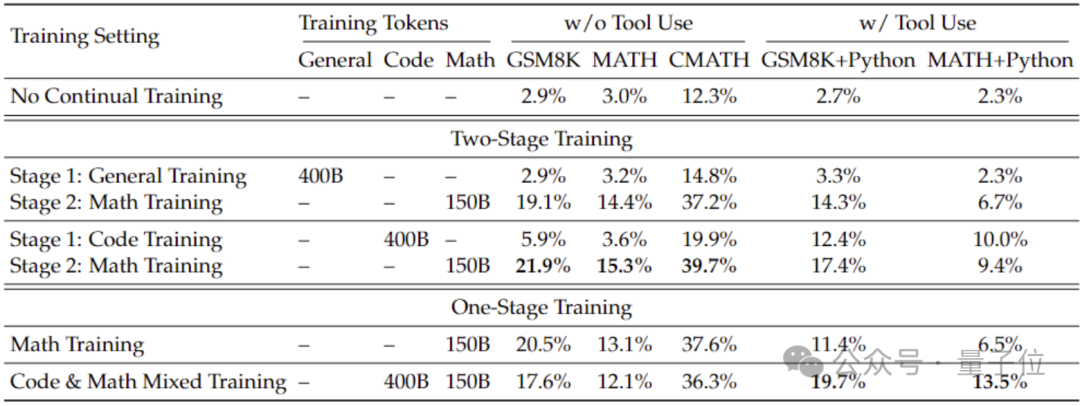

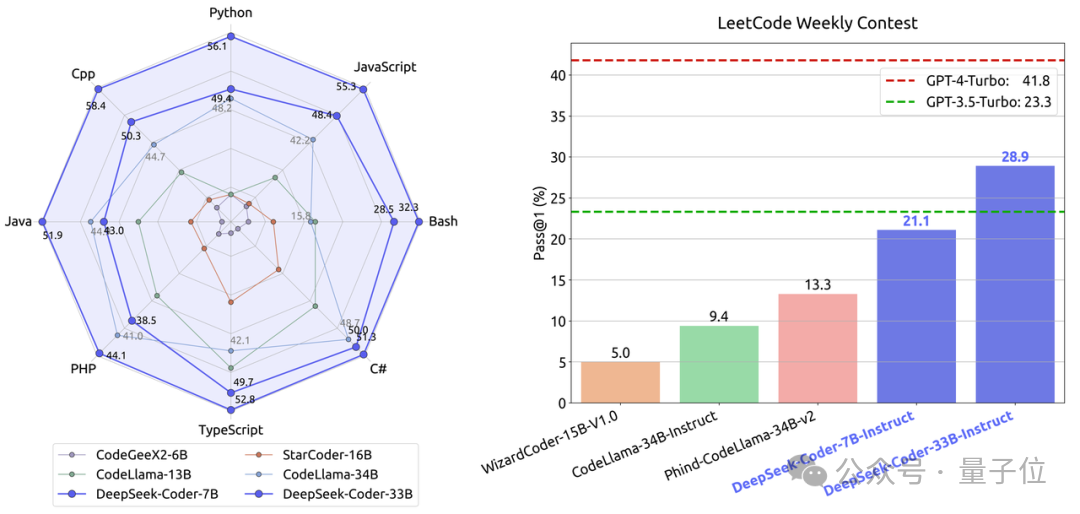

Afin d'obtenir de meilleures capacités mathématiques que celles du modèle général, l'équipe de recherche a utilisé le modèle de code DeepSeek-Coder-v1.5 pour l'initialiser.

Parce que l'équipe a découvert que la formation au code peut améliorer les capacités mathématiques du modèle par rapport à la formation générale sur les données, que ce soit dans une formation en deux étapes ou en une seule étape.

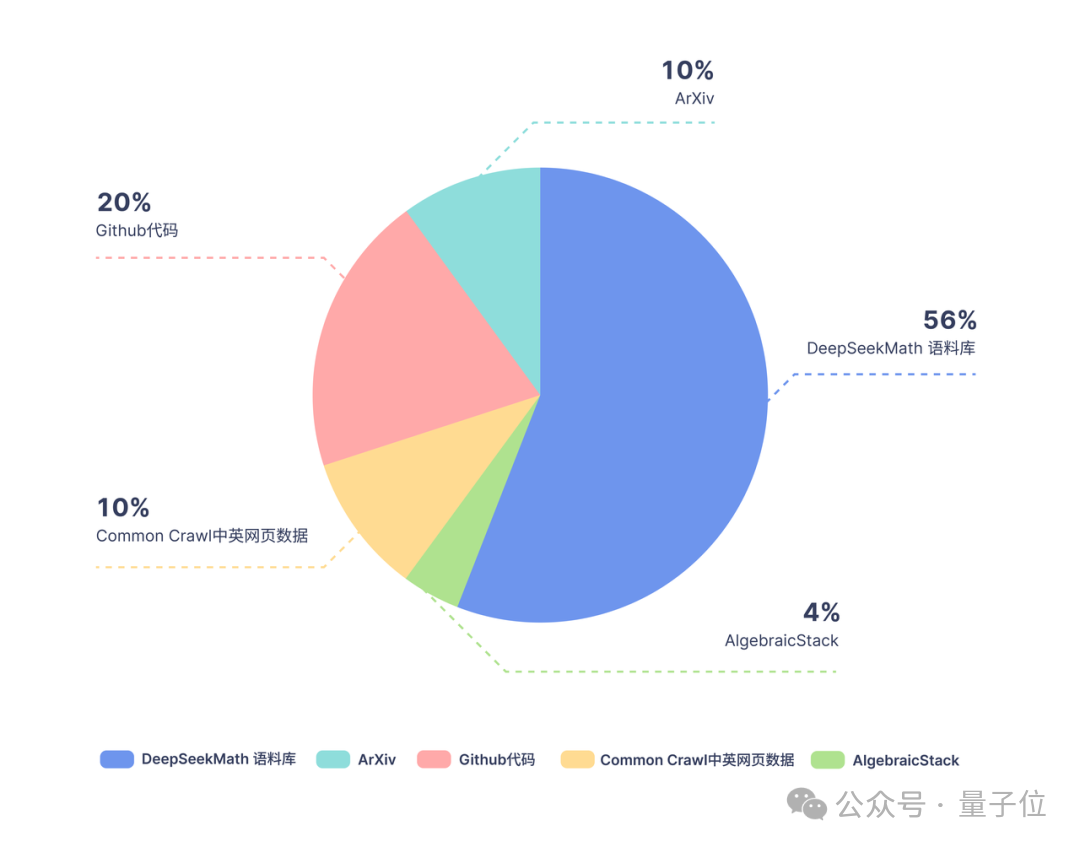

Sur la base de Coder, l'équipe de recherche a continué à former 500 milliards de jetons. La répartition des données est la suivante :

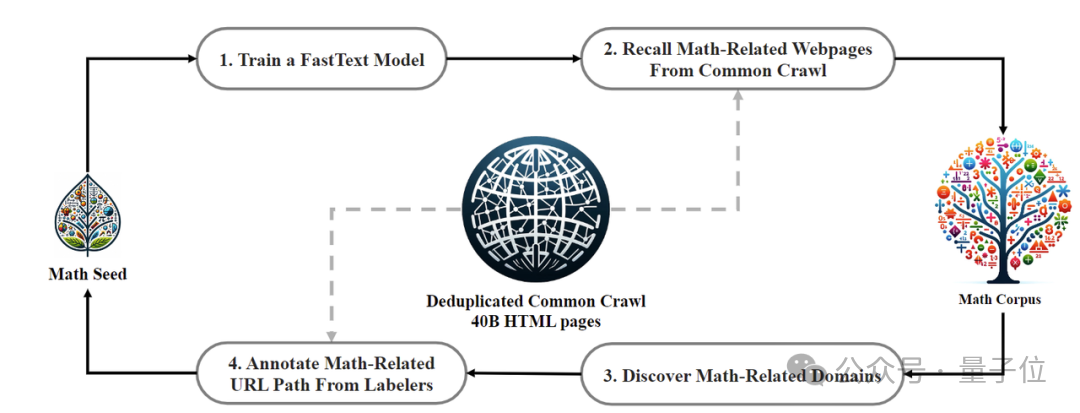

En termes de données de formation, DeepSeekMath utilise 120 milliards de données de pages Web mathématiques de haute qualité extraites de Common Crawl. Le corpus DeepSeekMath a été obtenu et le volume total de données est 9 fois supérieur à celui de l'ensemble de données open source OpenWebMath.

Le processus de collecte de données est effectué de manière itérative. Après quatre itérations, l'équipe de recherche a collecté plus de 35 millions de pages Web mathématiques et le nombre de jetons a atteint 120 milliards.

Afin de s'assurer que les données d'entraînement ne contiennent pas le contenu de l'ensemble de test (car le contenu en GSM8K et MATH existe en grande quantité sur Internet), l'équipe de recherche a également effectué un filtrage spécial.

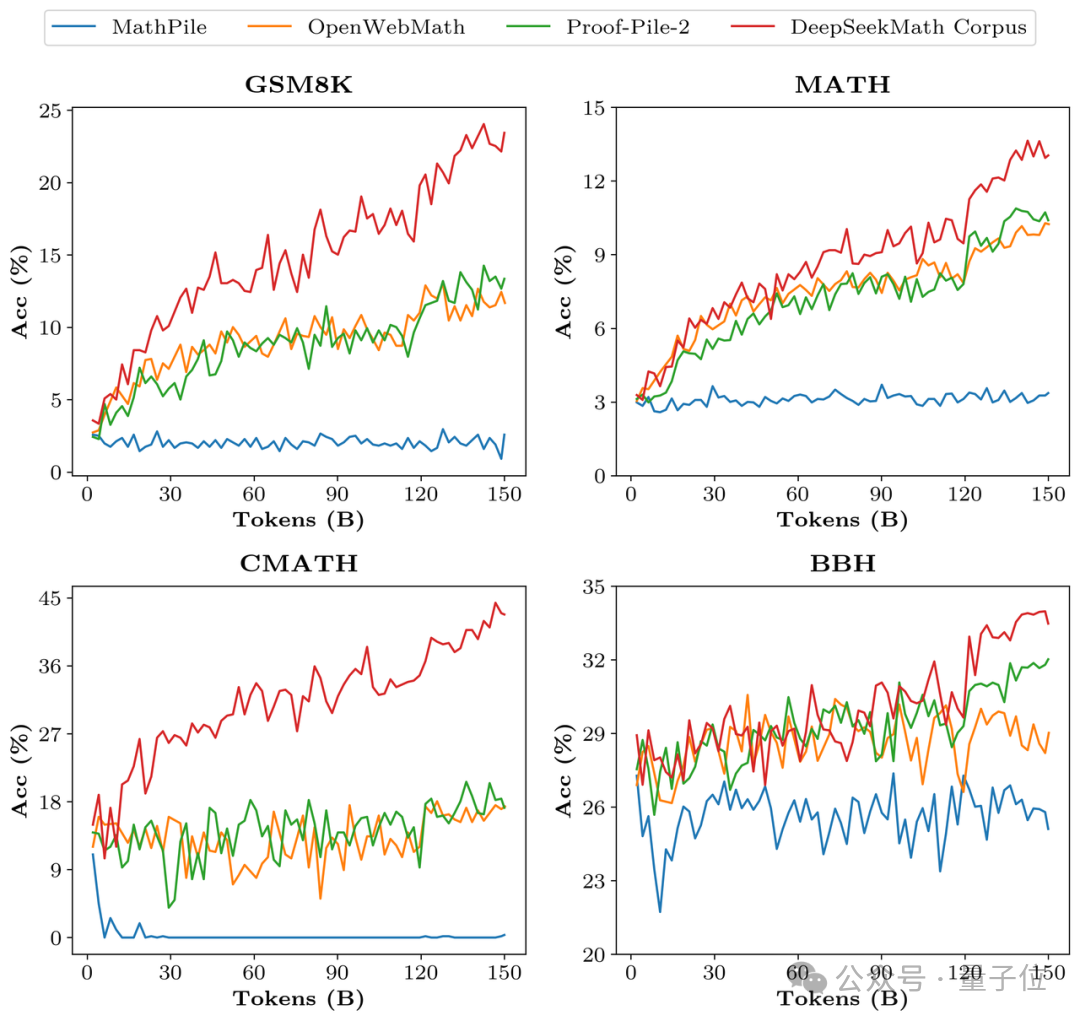

Afin de vérifier la qualité des données de DeepSeekMath Corpus, l'équipe de recherche a formé 150 milliards de jetons à l'aide de plusieurs ensembles de données tels que MathPile. En conséquence, Corpus était nettement en avance dans plusieurs benchmarks mathématiques.

Au cours de la phase d'alignement, l'équipe de recherche a d'abord construit un échantillon de 776 000 données mathématiques chinoises et anglaises à réglage fin supervisé guidé (SFT) , qui comprend trois formats : CoT, PoT et inférence intégrée aux outils.

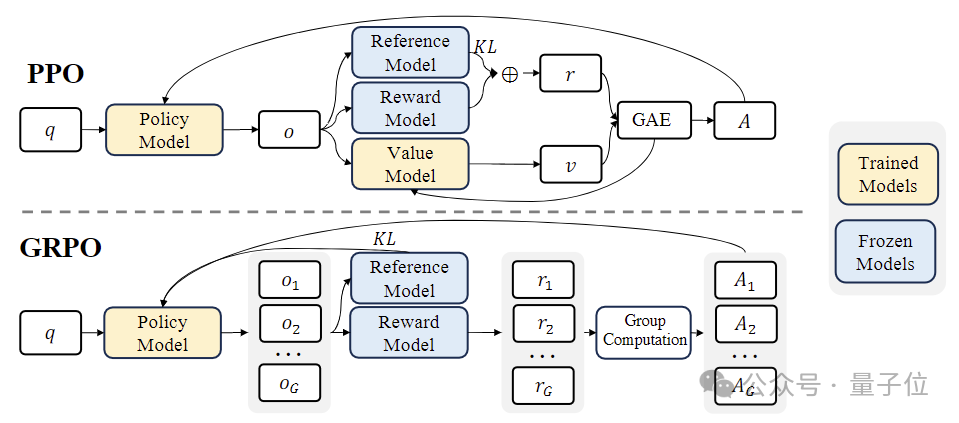

Au stade de l'apprentissage par renforcement (RL) , l'équipe de recherche a utilisé un algorithme efficace appelé « Group Relative Policy Optimization (GRPO) ».

GRPO est une variante de Proximal Policy Optimization(PPO) , dans laquelle la fonction de valeur traditionnelle est remplacée par une estimation de récompense relative basée sur le groupe, ce qui peut réduire les besoins en calcul et en mémoire pendant l'entraînement.

Dans le même temps, GRPO est formé selon un processus itératif et le modèle de récompense est continuellement mis à jour en fonction des résultats du modèle de politique pour garantir une amélioration continue de la politique.

Adresse papier : https://arxiv.org/abs/2402.03300

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

La commande de fermeture CENTOS est arrêtée et la syntaxe est la fermeture de [options] le temps [informations]. Les options incluent: -H Arrêtez immédiatement le système; -P éteignez l'alimentation après l'arrêt; -r redémarrer; -t temps d'attente. Les temps peuvent être spécifiés comme immédiats (maintenant), minutes (minutes) ou une heure spécifique (HH: mm). Des informations supplémentaires peuvent être affichées dans les messages système.

Quelles sont les méthodes de sauvegarde pour Gitlab sur Centos

Apr 14, 2025 pm 05:33 PM

Quelles sont les méthodes de sauvegarde pour Gitlab sur Centos

Apr 14, 2025 pm 05:33 PM

La politique de sauvegarde et de récupération de GitLab dans le système CentOS afin d'assurer la sécurité et la récupérabilité des données, Gitlab on CentOS fournit une variété de méthodes de sauvegarde. Cet article introduira plusieurs méthodes de sauvegarde courantes, paramètres de configuration et processus de récupération en détail pour vous aider à établir une stratégie complète de sauvegarde et de récupération de GitLab. 1. MANUEL BACKUP Utilisez le Gitlab-RakegitLab: Backup: Créer la commande pour exécuter la sauvegarde manuelle. Cette commande sauvegarde des informations clés telles que le référentiel Gitlab, la base de données, les utilisateurs, les groupes d'utilisateurs, les clés et les autorisations. Le fichier de sauvegarde par défaut est stocké dans le répertoire / var / opt / gitlab / backups. Vous pouvez modifier / etc / gitlab

Comment vérifier la configuration de CentOS HDFS

Apr 14, 2025 pm 07:21 PM

Comment vérifier la configuration de CentOS HDFS

Apr 14, 2025 pm 07:21 PM

Guide complet pour vérifier la configuration HDFS dans les systèmes CentOS Cet article vous guidera comment vérifier efficacement la configuration et l'état de l'exécution des HDF sur les systèmes CentOS. Les étapes suivantes vous aideront à bien comprendre la configuration et le fonctionnement des HDF. Vérifiez la variable d'environnement Hadoop: Tout d'abord, assurez-vous que la variable d'environnement Hadoop est correctement définie. Dans le terminal, exécutez la commande suivante pour vérifier que Hadoop est installé et configuré correctement: HadoopVersion Check HDFS Fichier de configuration: Le fichier de configuration de base de HDFS est situé dans le répertoire / etc / hadoop / conf / le répertoire, où Core-site.xml et hdfs-site.xml sont cruciaux. utiliser

Quelles sont les méthodes de réglage des performances de Zookeeper sur Centos

Apr 14, 2025 pm 03:18 PM

Quelles sont les méthodes de réglage des performances de Zookeeper sur Centos

Apr 14, 2025 pm 03:18 PM

Le réglage des performances de Zookeeper sur CentOS peut commencer à partir de plusieurs aspects, notamment la configuration du matériel, l'optimisation du système d'exploitation, le réglage des paramètres de configuration, la surveillance et la maintenance, etc. Assez de mémoire: allouez suffisamment de ressources de mémoire à Zookeeper pour éviter la lecture et l'écriture de disques fréquents. CPU multi-core: utilisez un processeur multi-core pour vous assurer que Zookeeper peut le traiter en parallèle.

Comment est la prise en charge du GPU pour Pytorch sur Centos

Apr 14, 2025 pm 06:48 PM

Comment est la prise en charge du GPU pour Pytorch sur Centos

Apr 14, 2025 pm 06:48 PM

Activer l'accélération du GPU Pytorch sur le système CentOS nécessite l'installation de versions CUDA, CUDNN et GPU de Pytorch. Les étapes suivantes vous guideront tout au long du processus: CUDA et CUDNN Installation détermineront la compatibilité de la version CUDA: utilisez la commande NVIDIA-SMI pour afficher la version CUDA prise en charge par votre carte graphique NVIDIA. Par exemple, votre carte graphique MX450 peut prendre en charge CUDA11.1 ou plus. Téléchargez et installez Cudatoolkit: visitez le site officiel de Nvidiacudatoolkit et téléchargez et installez la version correspondante selon la version CUDA la plus élevée prise en charge par votre carte graphique. Installez la bibliothèque CUDNN:

Explication détaillée du principe docker

Apr 14, 2025 pm 11:57 PM

Explication détaillée du principe docker

Apr 14, 2025 pm 11:57 PM

Docker utilise les fonctionnalités du noyau Linux pour fournir un environnement de fonctionnement d'application efficace et isolé. Son principe de travail est le suivant: 1. Le miroir est utilisé comme modèle en lecture seule, qui contient tout ce dont vous avez besoin pour exécuter l'application; 2. Le Système de fichiers Union (UnionFS) empile plusieurs systèmes de fichiers, ne stockant que les différences, l'économie d'espace et l'accélération; 3. Le démon gère les miroirs et les conteneurs, et le client les utilise pour l'interaction; 4. Les espaces de noms et les CGROUP implémentent l'isolement des conteneurs et les limitations de ressources; 5. Modes de réseau multiples prennent en charge l'interconnexion du conteneur. Ce n'est qu'en comprenant ces concepts principaux que vous pouvez mieux utiliser Docker.

CentOS installe MySQL

Apr 14, 2025 pm 08:09 PM

CentOS installe MySQL

Apr 14, 2025 pm 08:09 PM

L'installation de MySQL sur CENTOS implique les étapes suivantes: Ajout de la source MySQL YUM appropriée. Exécutez la commande YUM Install MySQL-Server pour installer le serveur MySQL. Utilisez la commande mysql_secure_installation pour créer des paramètres de sécurité, tels que la définition du mot de passe de l'utilisateur racine. Personnalisez le fichier de configuration MySQL selon les besoins. Écoutez les paramètres MySQL et optimisez les bases de données pour les performances.

CentOS8 redémarre SSH

Apr 14, 2025 pm 09:00 PM

CentOS8 redémarre SSH

Apr 14, 2025 pm 09:00 PM

La commande pour redémarrer le service SSH est: SystemCTL Redémarrer SSHD. Étapes détaillées: 1. Accédez au terminal et connectez-vous au serveur; 2. Entrez la commande: SystemCTL Restart SSHD; 3. Vérifiez l'état du service: SystemCTL Status Sshd.