développement back-end

développement back-end

Tutoriel Python

Tutoriel Python

Création d'un environnement de robot d'exploration : guide d'installation de Scrapy étape par étape

Création d'un environnement de robot d'exploration : guide d'installation de Scrapy étape par étape

Création d'un environnement de robot d'exploration : guide d'installation de Scrapy étape par étape

Tutoriel d'installation de Scrapy : vous apprend étape par étape à créer un environnement de robot d'exploration, des exemples de code spécifiques sont nécessaires

Introduction :

Avec le développement rapide d'Internet, la demande d'exploration de données et de collecte d'informations augmente également. En tant qu’outil puissant de collecte de données, les robots d’exploration sont largement utilisés dans divers domaines. Scrapy, en tant que framework d'exploration puissant et flexible, est favorisé par de nombreux développeurs. Cet article vous apprendra étape par étape comment configurer un environnement de robot Scrapy et joindra des exemples de code spécifiques.

Étape 1 : Installer les outils Python et PIP

Scrapy est écrit en langage Python, donc avant d'utiliser Scrapy, nous devons d'abord installer l'environnement Python. La version Python pour votre système d'exploitation peut être téléchargée et installée à partir du site Web officiel de Python (https://www.python.org). Une fois l'installation terminée, vous devez également configurer les variables d'environnement de Python pour faciliter l'exécution de Python directement sur la ligne de commande.

Après avoir installé Python, nous devons installer PIP (l'outil de gestion de packages de Python) pour installer ensuite Scrapy et ses bibliothèques dépendantes associées. Entrez la commande suivante sur la ligne de commande pour installer l'outil PIP :

$ python get-pip.py

Étape 2 : Installer Scrapy

Avant d'installer Scrapy, nous devons installer certaines bibliothèques de dépendances Scrapy. Entrez la commande suivante sur la ligne de commande pour installer ces bibliothèques dépendantes :

$ pip install twisted $ pip install cryptography $ pip install pyOpenSSL $ pip install queuelib $ pip install lxml

Après avoir installé ces bibliothèques dépendantes, nous pouvons utiliser PIP pour installer Scrapy. Entrez la commande suivante sur la ligne de commande pour installer Scrapy :

$ pip install scrapy

Étape 3 : Créer un nouveau projet Scrapy

Après avoir installé Scrapy, nous pouvons créer un nouveau projet Scrapy. Entrez la commande suivante sur la ligne de commande pour créer un nouveau projet Scrapy :

$ scrapy startproject myproject

Cela créera un répertoire appelé "monprojet" dans le répertoire actuel qui contient une structure de base du projet Scrapy.

Étape 4 : Écrire un robot d'exploration

Dans le nouveau projet Scrapy, nous devons écrire un robot d'exploration pour implémenter des fonctions spécifiques de collecte de données. Allez dans le répertoire « monprojet » sur la ligne de commande et entrez la commande suivante pour créer un nouveau robot :

$ scrapy genspider example example.com

Cela créera un fichier de robot nommé « exemple » dans le répertoire « monprojet/spiders/ ».

Dans le fichier du robot, nous pouvons écrire un code de collecte de données spécifique. Voici un exemple simple :

import scrapy

class MySpider(scrapy.Spider):

name = 'example'

allowed_domains = ['example.com']

start_urls = ['http://www.example.com']

def parse(self, response):

# 在这里编写你的数据采集逻辑

passDans l'exemple ci-dessus, nous avons défini une classe de robot d'exploration nommée "exemple" et spécifié le site Web cible et l'URL de départ à collecter. Dans la méthode parse, nous pouvons écrire une logique de collecte spécifique et utiliser diverses fonctions fournies par Scrapy pour analyser des pages Web, extraire des données, etc.

Étape 5 : Exécuter le robot d'exploration

Après avoir écrit le robot d'exploration, nous pouvons exécuter le robot d'exploration sur la ligne de commande. Allez dans le répertoire "myproject" et entrez la commande suivante pour exécuter le robot :

$ scrapy crawl example

Où "exemple" est le nom du robot à exécuter. Scrapy téléchargera des pages Web et extraira des données en fonction de la logique définie par le robot d'exploration. Dans le même temps, il gérera également automatiquement une série d'opérations telles que la redirection, la connexion de l'utilisateur et les cookies, simplifiant considérablement le processus de collecte de données.

Conclusion :

Grâce aux étapes ci-dessus, nous pouvons créer un environnement d'exploration simple mais puissant et utiliser Scrapy pour mettre en œuvre diverses tâches de collecte de données. Bien sûr, Scrapy a plus de fonctions et de fonctionnalités, telles que les robots d'exploration distribués, l'exploration dynamique du Web, etc., qui méritent un apprentissage et une exploration plus approfondis. J'espère que cet article vous sera utile et je vous souhaite bonne chance dans votre voyage sur les robots !

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Installez rapidement le guide d'étude OpenCV à l'aide du gestionnaire de packages pip

Jan 18, 2024 am 09:55 AM

Installez rapidement le guide d'étude OpenCV à l'aide du gestionnaire de packages pip

Jan 18, 2024 am 09:55 AM

Utilisez la commande pip pour installer facilement le didacticiel OpenCV, qui nécessite des exemples de code spécifiques. OpenCV (OpenSource Computer Vision Library) est une bibliothèque de vision par ordinateur open source. Elle contient un grand nombre d'algorithmes et de fonctions de vision par ordinateur, qui peuvent aider les développeurs à créer rapidement des images. et applications liées au traitement vidéo. Avant d'utiliser OpenCV, nous devons d'abord l'installer. Heureusement, Python fournit un outil puissant pour gérer les bibliothèques tierces.

Apprenez à installer Selenium facilement à l'aide de PyCharm : guide d'installation et de configuration de PyCharm

Jan 04, 2024 pm 09:48 PM

Apprenez à installer Selenium facilement à l'aide de PyCharm : guide d'installation et de configuration de PyCharm

Jan 04, 2024 pm 09:48 PM

Tutoriel d'installation de PyCharm : apprenez facilement à installer Selenium, des exemples de code spécifiques sont nécessaires. En tant que développeurs Python, nous devons souvent utiliser diverses bibliothèques et outils tiers pour terminer le développement de projets. Parmi eux, Selenium est une bibliothèque très couramment utilisée pour les tests automatisés et les tests d'interface utilisateur des applications Web. En tant qu'environnement de développement intégré (IDE) pour le développement Python, PyCharm nous offre un moyen pratique et rapide de développer du code Python, alors comment

Guide d'installation de PyCharm Community Edition : maîtrisez rapidement toutes les étapes

Jan 27, 2024 am 09:10 AM

Guide d'installation de PyCharm Community Edition : maîtrisez rapidement toutes les étapes

Jan 27, 2024 am 09:10 AM

Démarrage rapide avec PyCharm Community Edition : Tutoriel d'installation détaillé Analyse complète Introduction : PyCharm est un puissant environnement de développement intégré (IDE) Python qui fournit un ensemble complet d'outils pour aider les développeurs à écrire du code Python plus efficacement. Cet article présentera en détail comment installer PyCharm Community Edition et fournira des exemples de code spécifiques pour aider les débutants à démarrer rapidement. Étape 1 : Téléchargez et installez PyCharm Community Edition Pour utiliser PyCharm, vous devez d'abord le télécharger depuis son site officiel

Une lecture incontournable pour les débutants en Python : un guide d'installation de pip concis et facile à comprendre

Jan 16, 2024 am 10:34 AM

Une lecture incontournable pour les débutants en Python : un guide d'installation de pip concis et facile à comprendre

Jan 16, 2024 am 10:34 AM

Essentiel pour les novices Python : Tutoriel d'installation de pip simple et facile à comprendre Introduction : En programmation Python, l'installation de bibliothèques externes est une étape très importante. En tant qu'outil de gestion de packages officiellement recommandé pour Python, pip est facile à comprendre et puissant, ce qui en fait l'une des compétences essentielles pour les novices en Python. Cet article vous présentera la méthode d'installation de pip et des exemples de code spécifiques pour vous aider à démarrer facilement. 1. Installation de pip Avant de commencer à utiliser pip, vous devez d'abord l'installer. Voici comment installer pip : Tout d’abord,

Tutoriel d'installation d'Ubuntu et tutoriel d'installation d'Ubuntu 20.04

Feb 14, 2024 pm 05:09 PM

Tutoriel d'installation d'Ubuntu et tutoriel d'installation d'Ubuntu 20.04

Feb 14, 2024 pm 05:09 PM

LINUX est un système d'exploitation open source connu pour sa stabilité, sa sécurité et sa flexibilité. Ubuntu est l'une des distributions les plus populaires du système LINUX. Cet article vous présentera le processus d'installation d'Ubuntu et fournira des instructions sur la façon d'installer Ubuntu20. Version .04. Préparation du didacticiel d'installation d'Ubuntu Avant de commencer à installer Ubuntu, vous devez préparer le matériel suivant : 1. Un ordinateur inactif 2. Un CD d'installation Ubuntu ou une clé USB 3. Assurez-vous que l'ordinateur répond à la configuration système minimale requise pour le support d'installation Ubuntu Create 1. Téléchargez le fichier image Ubuntu20.04 et enregistrez-le sur votre ordinateur. 2. Si vous utilisez un CD, laissez vide

Comment installer l'embellissement du bureau NeXus - Tutoriel d'installation de l'embellissement du bureau NeXus

Mar 04, 2024 am 11:30 AM

Comment installer l'embellissement du bureau NeXus - Tutoriel d'installation de l'embellissement du bureau NeXus

Mar 04, 2024 am 11:30 AM

Amis, savez-vous comment installer l'embellissement du bureau NeXus ? Aujourd'hui, je vais vous expliquer le tutoriel d'installation de l'embellissement du bureau NeXus. Si vous êtes intéressé, venez jeter un œil avec moi, j'espère que cela pourra vous aider. 1. Téléchargez la dernière version du plug-in logiciel d'embellissement du bureau Nexus à partir de ce site (comme indiqué sur l'image). 2. Décompressez le logiciel plug-in d'embellissement du bureau Nexus et exécutez le fichier (comme indiqué sur l'image). 3. Double-cliquez pour ouvrir et accéder à l'interface du logiciel du plug-in d'embellissement du bureau Nexus. Veuillez lire attentivement le contrat de licence d'installation ci-dessous pour voir si vous acceptez tous les termes du contrat de licence ci-dessus. Cliquez sur J'accepte et cliquez sur Suivant (comme indiqué). sur la photo). 4. Sélectionnez l'emplacement de destination. Le logiciel sera installé dans le dossier répertorié ci-dessous. Pour sélectionner un autre emplacement et créer un nouveau chemin, cliquez sur Suivant.

Comment installer le didacticiel d'installation solidworks2016-solidworks2016

Mar 05, 2024 am 11:25 AM

Comment installer le didacticiel d'installation solidworks2016-solidworks2016

Mar 05, 2024 am 11:25 AM

Récemment, de nombreux amis m'ont demandé comment installer solidworks2016. Apprenons ensuite le didacticiel d'installation de solidworks2016. J'espère qu'il pourra aider tout le monde. 1. Tout d’abord, quittez le logiciel antivirus et assurez-vous de vous déconnecter du réseau (comme indiqué sur l’image). 2. Cliquez ensuite avec le bouton droit sur le package d'installation et sélectionnez l'extraction vers le package d'installation SW2016 (comme indiqué dans l'image). 3. Double-cliquez pour accéder au dossier décompressé. Cliquez avec le bouton droit sur setup.exe et cliquez sur Exécuter en tant qu'administrateur (comme indiqué dans l'image). 4. Cliquez ensuite sur OK (comme indiqué sur l'image). 5. Cochez ensuite [Installation sur une seule machine (sur cet ordinateur)] et cliquez sur [Suivant] (comme indiqué dans l'image). 6. Entrez ensuite le numéro de série et cliquez sur [Suivant] (comme indiqué sur l'image). 7.

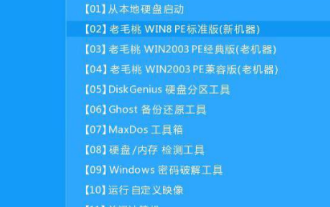

Guide d'installation du système Win10

Dec 24, 2023 am 09:04 AM

Guide d'installation du système Win10

Dec 24, 2023 am 09:04 AM

Récemment, certains amis ont signalé avoir téléchargé le fichier image win10, mais ils ne savent pas comment l'installer. En fait, nous pouvons créer un disque de démarrage du disque U et utiliser le disque U pour l'installer aujourd'hui. , l'éditeur a apporté des informations détaillées. Jetons un coup d'œil aux étapes spécifiques de la solution. Tutoriel d'installation de l'image win10 1. Créez un disque de démarrage du disque U 2. Téléchargez le fichier image système Win10 et copiez-le sur le disque de démarrage du disque U 3. Après avoir créé le disque de démarrage du disque U, appuyez rapidement sur F12 (certains modèles sont F8) Sélectionnez le Disque U pour démarrer, entrez dans le système PE, sélectionnez la deuxième option et appuyez sur Entrée pour entrer comme indiqué ci-dessous : 4. Après quelques minutes, entrez dans le système PE, cliquez sur l'outil d'installation PE sur le bureau, puis cliquez sur le bouton " Bouton Parcourir" dans la fenêtre principale de l'outil. Comme le montre la figure ci-dessous : 5.