Périphériques technologiques

Périphériques technologiques

IA

IA

Princeton DeepMind a utilisé les mathématiques pour prouver : LLM n'est pas un perroquet aléatoire ! 'Plus l'échelle est grande, plus la capacité est forte' a une base théorique

Princeton DeepMind a utilisé les mathématiques pour prouver : LLM n'est pas un perroquet aléatoire ! 'Plus l'échelle est grande, plus la capacité est forte' a une base théorique

Princeton DeepMind a utilisé les mathématiques pour prouver : LLM n'est pas un perroquet aléatoire ! 'Plus l'échelle est grande, plus la capacité est forte' a une base théorique

Les protagonistes de l’histoire d’aujourd’hui sont deux scientifiques, Sanjeev Arora et Anirudh Goyal.

Arora est de l'Université de Princeton et Goyal est de Google DeepMind.

Ils se sont réunis et voulaient juste explorer une question.

Autrement dit, LLM est-il un perroquet aléatoire qui ne fait que bavarder, ou a-t-il vraiment appris quelque chose et s'est-il transformé en un agent intelligent doté de capacités émergentes ?

Les pionniers de l'IA Hinton et Ng Enda ont également parlé de cette question, mais ils ne sont pas parvenus à une conclusion claire à ce moment-là.

Hinton a souligné que si un consensus ne peut être atteint sur cette question, il sera également difficile de parvenir à un consensus sur les dommages potentiels que l'IA peut apporter.

Arora et Goyal pensent que le LLM ne consiste pas seulement à imiter l'apprentissage répétitif mécanique. Ils ont souligné que le contenu de sortie de LLM n’est pas simplement généré de manière aléatoire à partir d’une grande quantité de données de formation, et que ce point mérite une exploration plus approfondie.

Deux personnes ont co-écrit un article à ce sujet.

Adresse papier : https://arxiv.org/abs/2307.15936

La vérité est qu'après beaucoup de formation, l'échelle des LLM devient de plus en plus grande, et leurs capacités associées seront amélioration améliorée et développement de nouvelles capacités.

Ce n'est pas quelque chose que des permutations et des combinaisons ordinaires peuvent faire.

Le "grand" des grands modèles

Comme nous le savons tous, LLM est un immense réseau de neurones artificiels, reliant les "neurones" un à un.

fait en fait référence aux paramètres du modèle. Plus il y a de paramètres, plus le LLM est grand.

Commençons par comprendre le mécanisme et les liens de la formation LLM.

Le processus de formation comprendra ce lien : fournissez à LLM une seule phrase, masquez le dernier mot, puis laissez LLM prédire à qui devrait appartenir le vocabulaire vacant en fonction de la probabilité.

Si LLM connaît 1000 mots, alors il générera 1000 probabilités. Enfin, choisissez celui avec la probabilité la plus élevée et remplissez-le.

Au début, LLM peut ne pas être en mesure de sélectionner le bon mot, et l'algorithme donnera une valeur de perte, qui est la "distance" entre la réponse initiale donnée par LLM et la réponse correcte à la phrase originale dans un certain espace mathématique de grande dimension. "(distance), puis utilisez cette valeur pour affiner les paramètres. Après

, pour la même phrase, LLM peut calculer une distribution de probabilité plus correcte, et la valeur de perte ci-dessus sera légèrement réduite.

De cette façon, ce processus est exécuté sur des milliards de phrases dans les données d'entraînement, jusqu'à ce que la valeur de perte globale de LLM soit réduite à un assez bon niveau.

De même, les tests LLM suivront également ce processus, et les résultats des tests seront obtenus en fonction de la valeur de perte (bien sûr, les phrases utilisées pour les tests ne doivent pas être dans les données d'entraînement, sinon ce ne serait pas de la triche) .

Après la formation et les tests, LLM est très susceptible de générer le mot le plus correct lorsqu'il rencontre une nouvelle invite de texte. Lorsqu'un mot sort, il est lancé dans l'invite et le mot suivant est généré.

Générée lentement, une réponse apparemment cohérente est apparue sur le papier.

Cependant, dans ce processus, rien n'indique que le plus grand LLM sera plus performant sur les questions qui nécessitent un raisonnement.

Faites attention à suivre la réflexion. Il n'y a aucune indication, ce qui signifie qu'il n'y a aucune preuve empirique qui puisse indiquer ce résultat, mais à en juger par les faits superficiels, cette conclusion est correcte.

En d'autres termes, un LLM à plus grande échelle sera plus performant qu'un modèle à petite échelle en termes de capacités de raisonnement. Bien qu'il n'y ait pas de différence dans les méthodes de formation entre les deux, la seule différence réside dans l'échelle.

Arora est confuse, d'où vient cette capacité ?

C'est le point de départ des recherches d'Arora et Goyal : tenter de construire un cadre théorique pour analyser comment ces nouvelles capacités émergent.

Alors, ils ont tourné leur attention vers le domaine des mathématiques et se sont attaqués à ce qu'on appelle un graphe aléatoire. En termes simples, ce terme se situe à l’intersection de la théorie des graphes et de la théorie des probabilités.

Dans un graphique aléatoire, le fait qu'il y ait une arête les reliant entre deux nœuds est aléatoire, tout comme lancer une pièce de monnaie.

Si la pièce est lancée face, il y a un avantage avec une probabilité p. Lorsque la valeur de

p change, les propriétés de l'ensemble du graphe aléatoire peuvent soudainement changer. Par exemple, si la valeur p dépasse un certain seuil, certains nœuds isolés (c'est-à-dire des points qui ne sont pas connectés à d'autres nœuds) disparaîtront soudainement.

Deux scientifiques ont réalisé que cette fonctionnalité des graphiques aléatoires pouvait être un moyen intuitif de simuler de grands modèles de langage.

Bien que la complexité des réseaux de neurones soit indescriptible et presque difficile à analyser, le concept de graphes aléatoires est étudié par les mathématiciens depuis longtemps, et divers outils ont été développés pour l'analyse.

Peut-être, grâce aux théories connexes des graphes aléatoires, les chercheurs en réseaux neuronaux peuvent essayer de comprendre et d'analyser certaines caractéristiques des grands modèles de langage.

Ici, les deux chercheurs se sont concentrés sur le graphe biparti, qui contient deux types de nœuds.

Dans leur modèle, un type de nœud représente un fragment de texte. Notez que le fragment ici doit avoir au moins un paragraphe en termes de longueur, et peut même comporter plusieurs pages, plutôt qu'un seul mot.

De tels nœuds forment une ligne droite.

Le deuxième type de nœud représente les compétences requises pour comprendre le texte donné ci-dessus. Par exemple, la compréhension des relations logiques, ou la capacité de calculer, ou plus précisément, la capacité de comprendre le sarcasme.

Le but de donner ces exemples est de montrer clairement que ce deuxième type de nœud représente une variété de capacités, et que chacune des capacités ci-dessus sera prise en compte.

Arora a déclaré que si LLM peut voir qu'un certain texte contient de l'ironie, la compréhension globale peut changer de manière significative.

Cependant, comme nous l'avons mentionné ci-dessus, les capacités représentées par le deuxième type de nœuds ne signifient pas que le but du LLM pendant le processus de formation est d'atteindre ces capacités. En d’autres termes, LLM entraîne uniquement la capacité de prédire le prochain mot possible pendant la formation.

En d'autres termes, les capacités représentées par le deuxième type de nœuds ont été conçues par Arora et Goyal dans une perspective de résultats, afin de mieux comprendre les capacités affichées par LLM.

Maintenant que le paramétrage est terminé, les deux types de nœuds commenceront à se connecter l'un à l'autre. La connexion représente les capacités dont LLM a besoin pour comprendre un certain paragraphe de texte. Cela peut être un à un, un à plusieurs ou plusieurs à un.

Prenons également comme exemple la lecture de l'ironie. Ce point de compétence établira une connexion avec tous les textes contenant des éléments ironiques.

La connexion n'est pas si simple. Vous savez, les grandes entreprises comme OpenAI et DeepMind ne divulgueront pas de données de formation ou de tests. Les deux chercheurs ne peuvent donc pas s’appuyer sur ceux-ci.

De plus, ce qu'ils veulent comprendre, c'est la relation entre l'échelle, le comportement et la capacité.

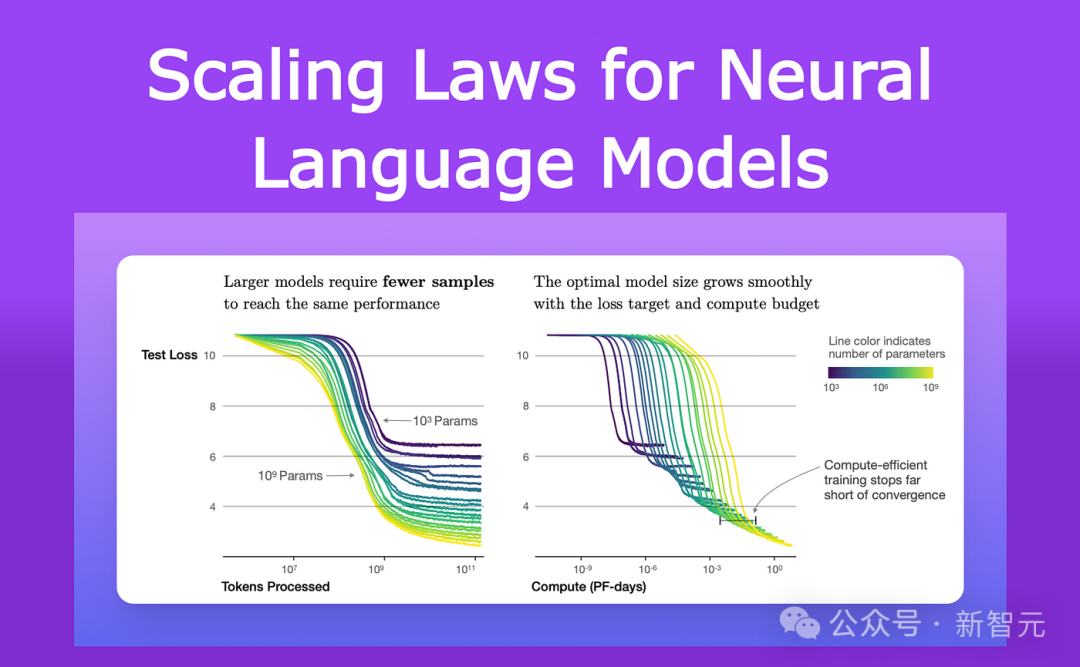

Depuis 2021, les chercheurs étudiant les performances des LLM et autres réseaux de neurones ont observé une caractéristique commune.

Ils ont remarqué qu'à mesure que le modèle grandissait, à la fois en taille et en quantité de données d'entraînement, il perdait des données de test (la différence entre les prédictions et les réponses correctes pour un nouveau texte après l'entraînement) réduites d'une manière très spécifique.

Ces observations ont été codées dans une équation appelée loi d'échelle neuronale.

Par conséquent, Arora et Goyal ont déclaré que leur théorie ne dépend pas du cas d'un seul LLM, ni d'un ensemble spécifique de données de formation et de test, mais plutôt d'une sorte de loi universelle : la perte prédite par le loi d'échelle.

La clé de leurs recherches ultérieures est la relation entre la loi d'échelle neuronale et le graphe biparti présenté ci-dessus.

Emprunt de graphe biparti

Dans un premier temps, le chercheur suppose qu'il existe un graphe biparti correspondant au comportement de LLM sur les données de test.

Afin de profiter des changements de perte de LLM sur les données de test, ils ont imaginé une manière comme suit pour décrire comment LLM acquiert des compétences.

Prenons comme exemple la capacité de comprendre l'ironie -

Ce concept est représenté par un nœud de compétence, les chercheurs ont donc examiné à quels nœuds de texte ce nœud de compétence était connecté.

Si presque tous ces nœuds de texte connectés réussissent - ce qui signifie que la prédiction par LLM du texte représenté par cette compétence spécifique est très précise - alors LLM est compétent pour cette compétence spécifique.

Mais si plus d'une certaine proportion de nœuds de compétences sont connectés à des nœuds de texte défaillants, alors LLM échouera sur cette compétence.

Les connexions entre ces graphes bipartis et les LLM permettent à Arora et Goyal d'exploiter les outils de la théorie des graphes aléatoires pour analyser le comportement des LLM.

L'étude de ces graphiques révèle certaines relations entre les nœuds. Ces relations sont ensuite transformées en une méthode logique et testable pour expliquer comment les grands modèles de langage acquièrent des capacités inattendues.

Ici, Arora et Goyal expliquent d'abord un comportement clé : pourquoi les grands LLM maîtrisent mieux les compétences individuelles que les modèles relativement plus petits.

Ils commencent avec des pertes de tests plus faibles prédites par les lois de mise à l'échelle neuronale.

S'il y a moins de nœuds de test ayant échoué, cela signifie qu'il y a moins de connexions entre les nœuds de test ayant échoué et les nœuds de compétences. Par conséquent, davantage de nœuds de compétences sont connectés aux nœuds de test réussis, ce qui indique que le modèle possède des capacités accrues en termes de compétences.

Ensuite, les deux chercheurs ont trouvé un moyen d'expliquer la puissance acquise par les modèles plus grands : à mesure que la taille du LLM augmente et que la perte de test diminue, des combinaisons aléatoires de nœuds de compétences commencent à être connectées à des nœuds de textes individuels.

Cela montre que LLM est également devenu meilleur dans l'utilisation simultanée de plusieurs compétences et a commencé à générer du texte en utilisant plusieurs compétences, même si ces combinaisons exactes de compétences n'apparaissaient dans aucun texte des données de formation.

Par exemple, un LLM peut déjà générer du texte en utilisant une compétence, alors si nous augmentons le nombre de paramètres ou de données d'entraînement du LLM d'un ordre de grandeur, il sera tout aussi efficace pour générer du texte nécessitant les deux compétences.

Par analogie et par un autre ordre de grandeur, LLM peut désormais réaliser des tâches qui nécessitent quatre compétences en même temps ! De plus, le niveau de compétence dans chaque capacité est également le même.

Par conséquent, les grands LLM disposent de plus de moyens de combiner les compétences, ce qui conduit à une amélioration significative des performances du LLM lui-même.

À mesure que le LLM évolue, la probabilité qu'il rencontre toutes ces combinaisons de compétences dans les données de formation devient de plus en plus petite, jusqu'à 0.

Selon les règles de la théorie des graphes aléatoires, chaque combinaison provient d'un échantillonnage aléatoire de compétences possibles. Donc, s'il y a environ un millier de nœuds de compétences de base dans le graphique, et disons que nous voulons combiner quatre compétences, il y en a environ 1 000 à la puissance quatre - cela représente un billion de combinaisons possibles.

En d'autres termes, si un LLM peut réellement effectuer ces tâches en combinant quatre des 1 000 compétences, cela signifie que le modèle doit avoir des capacités de généralisation. De plus, ce modèle n'est probablement plus un perroquet aléatoire.

Mais Arora et Goyal voulaient aller au-delà de la théorie et tester leur idée selon laquelle les LLM deviennent meilleurs dans la combinaison de plus de compétences à mesure que leur taille et leurs données de formation augmentent, et sont donc plus performants en généralisation.

Avec le reste de l'équipe, ils ont conçu une méthode appelée mélange de compétences pour évaluer la capacité de LLM à générer du texte en utilisant plusieurs compétences.

Pour tester LLM, l'équipe de recherche lui a demandé de générer trois phrases sur des sujets sélectionnés au hasard. La génération de ces phrases a d'abord démontré les points de compétence de LLM sélectionnés au hasard.

Par exemple, ils ont demandé à GPT-4 d'écrire un article sur la maîtrise de l'épée, puis ils ont demandé au modèle de démontrer des compétences dans quatre domaines : l'auto-participation, la métaphore, les statistiques et la maîtrise des tentatives de physique.

Le résultat de GPT-4 est le suivant :

Dans cette danse avec l'acier, ma victoire (en utilisant la métaphore) est aussi certaine que la chute libre des objets (en utilisant la physique).

Et en tant que duelliste célèbre, je suis naturellement flexible, comme la plupart des gens me connaissent (d'après les statistiques). échouer? Cela ne peut être dû qu’au fait que le champ de bataille est orienté vers l’ennemi, et non à cause de mes défauts (auto-préjugé).

Le résultat réel, comme le prédisent les mathématiques, est que GPT-4 surpasse de loin GPT-3.5.

Arora fait une supposition audacieuse : y aura-t-il un modèle qui surpassera de loin le GPT-4 dans un an ?

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Quelles sont les dix principales plateformes de trading de devises virtuelles?

Feb 20, 2025 pm 02:15 PM

Quelles sont les dix principales plateformes de trading de devises virtuelles?

Feb 20, 2025 pm 02:15 PM

Avec la popularité des crypto-monnaies, des plateformes de trading de devises virtuelles ont émergé. Les dix principales plateformes de trading de devises virtuelles au monde sont classées comme suit selon le volume des transactions et la part de marché: Binance, Coinbase, FTX, Kucoin, Crypto.com, Kraken, Huobi, Gate.io, Bitfinex, Gemini. Ces plateformes offrent un large éventail de services, allant d'un large éventail de choix de crypto-monnaie à la négociation des dérivés, adapté aux commerçants de niveaux différents.

Comment ajuster l'échange ouvert en sésame en chinois

Mar 04, 2025 pm 11:51 PM

Comment ajuster l'échange ouvert en sésame en chinois

Mar 04, 2025 pm 11:51 PM

Comment ajuster l'échange ouvert en sésame en chinois? Ce didacticiel couvre des étapes détaillées sur les ordinateurs et les téléphones mobiles Android, de la préparation préliminaire aux processus opérationnels, puis à la résolution de problèmes communs, vous aidant à changer facilement l'interface d'échange Open Sesame aux chinois et à démarrer rapidement avec la plate-forme de trading.

Quelles sont les plates-formes de monnaie numérique sûres et fiables?

Mar 17, 2025 pm 05:42 PM

Quelles sont les plates-formes de monnaie numérique sûres et fiables?

Mar 17, 2025 pm 05:42 PM

Une plate-forme de monnaie numérique sûre et fiable: 1. Okx, 2. Binance, 3. Gate.io, 4. Kraken, 5. Huobi, 6. Coinbase, 7. Kucoin, 8. Crypto.com, 9. Bitfinex, 10. Gemini. La sécurité, la liquidité, les frais de traitement, la sélection des devises, l'interface utilisateur et le support client doivent être pris en compte lors du choix d'une plate-forme.

Top 10 des plates-formes de trading de devises virtuelles 2025 Applications de trading de crypto-monnaie classée top dix

Mar 17, 2025 pm 05:54 PM

Top 10 des plates-formes de trading de devises virtuelles 2025 Applications de trading de crypto-monnaie classée top dix

Mar 17, 2025 pm 05:54 PM

Top dix plates-formes de trading de devises virtuelles 2025: 1. Okx, 2. Binance, 3. Gate.io, 4. Kraken, 5. Huobi, 6. Coinbase, 7. Kucoin, 8. Crypto.com, 9. BitFinex, 10. Gemini. La sécurité, la liquidité, les frais de traitement, la sélection des devises, l'interface utilisateur et le support client doivent être pris en compte lors du choix d'une plate-forme.

Top 10 des plates-formes de trading de crypto-monnaie, les dix principales applications de plate-forme de trading de devises recommandées

Mar 17, 2025 pm 06:03 PM

Top 10 des plates-formes de trading de crypto-monnaie, les dix principales applications de plate-forme de trading de devises recommandées

Mar 17, 2025 pm 06:03 PM

Les dix principales plates-formes de trading de crypto-monnaie comprennent: 1. Okx, 2. Binance, 3. Gate.io, 4. Kraken, 5. Huobi, 6. Coinbase, 7. Kucoin, 8. Crypto.com, 9. BitFinex, 10. Gemini. La sécurité, la liquidité, les frais de traitement, la sélection des devises, l'interface utilisateur et le support client doivent être pris en compte lors du choix d'une plate-forme.

Laquelle des dix principales applications de trading de devises virtuelles est la meilleure?

Mar 19, 2025 pm 05:00 PM

Laquelle des dix principales applications de trading de devises virtuelles est la meilleure?

Mar 19, 2025 pm 05:00 PM

Top 10 des classements de trading de devises virtuels: 1. Okx, 2. Binance, 3. Gate.io, 4. Kraken, 5. Huobi, 6. Coinbase, 7. Kucoin, 8. Crypto.com, 9. BitFinex, 10. Gemini. La sécurité, la liquidité, les frais de traitement, la sélection des devises, l'interface utilisateur et le support client doivent être pris en compte lors du choix d'une plate-forme.

Applications de logiciels de monnaie virtuels sûrs recommandés Top 10 des applications de trading de devises numériques classement 2025

Mar 17, 2025 pm 05:48 PM

Applications de logiciels de monnaie virtuels sûrs recommandés Top 10 des applications de trading de devises numériques classement 2025

Mar 17, 2025 pm 05:48 PM

Recommandés Applications logicielles de monnaie virtuelle recommandées: 1. Okx, 2. Binance, 3. Gate.io, 4. Kraken, 5. Huobi, 6. Coinbase, 7. Kucoin, 8. Crypto.com, 9. Bitfinex, 10. Gemini. La sécurité, la liquidité, les frais de traitement, la sélection des devises, l'interface utilisateur et le support client doivent être pris en compte lors du choix d'une plate-forme.

Comment calculer C-SUBScript 3 Indice 5 C-SUBScript 3 Indice Indice 5 Tutoriel d'algorithme

Apr 03, 2025 pm 10:33 PM

Comment calculer C-SUBScript 3 Indice 5 C-SUBScript 3 Indice Indice 5 Tutoriel d'algorithme

Apr 03, 2025 pm 10:33 PM

Le calcul de C35 est essentiellement des mathématiques combinatoires, représentant le nombre de combinaisons sélectionnées parmi 3 des 5 éléments. La formule de calcul est C53 = 5! / (3! * 2!), Qui peut être directement calculé par des boucles pour améliorer l'efficacité et éviter le débordement. De plus, la compréhension de la nature des combinaisons et la maîtrise des méthodes de calcul efficaces est cruciale pour résoudre de nombreux problèmes dans les domaines des statistiques de probabilité, de la cryptographie, de la conception d'algorithmes, etc.